基于Stacking集成學習的注塑件尺寸預測方法

宋建 王文龍 李東 梁家睿

(1.華南理工大學 廣東省高分子先進制造技術及裝備重點實驗室/聚合物成型加工工程教育部重點實驗室,廣東 廣州 510640;2.金發科技股份有限公司 企業技術中心,廣東 廣州 510663)

注塑成型作為最常見的一種塑料制品加工工藝,其所加工的產品在生活中隨處可見,例如電子產品、汽車配件、玩具以及其他眾多消費品[1]。由于注塑成型過程較為復雜且對環境比較敏感,加工過程中的不穩定因素會導致不良品的產生,造成經濟損失[2]。同時,現有的注塑件質量檢測大多采用人工,存在效率低和用工成本高等問題[3]。因此,相關研究通過建立注塑成型大數據,運用機器學習方法分析建模,對注塑件質量進行在線預測,以解決甚至避免現場痛點問題。

文獻[4]通過構建多棵回歸樹,對每棵回歸樹的預測值取平均,組合所有的回歸樹即構成隨機森林,來預測汽車注塑件的成型質量。文獻[5]通過建立三層反向傳播(BP)神經網絡,利用Moldflow正交試驗所得工藝參數與翹曲量的數據作為訓練樣本對神經網絡進行訓練,建立預測薄殼注塑件翹曲量的模型。文獻[6]通過BP神經網絡和徑向基函數(RBF)神經網絡建立預測注塑產品翹曲量的模型,并將兩者的預測精度進行比較,從而得到有效的預測模型。文獻[7]利用提取的故障特征數據與極端梯度提升樹(XGB)集成算法訓練出注塑機注射油缸內泄漏故障的智能診斷模型,并利用粒子群優化算法完成超參數的尋優。文獻[8]利用加工過程中獲得的數控系統內部指令域大數據,基于LM-BP神經網絡與RBF神經網絡學習實現零件尺寸的預測。

上述預測方法中,大部分只使用了傳統的單一機器學習模型,或是簡單模型的線性融合,模型整體預測精度較低,未能達到工業生產的要求。為此,本文提出了一種基于Stacking集成學習的融合模型,通過集成不同類型的學習器來提升模型的預測效果,并根據基學習器XGB提供的特征重要性排序方法,獲得對注塑件尺寸影響程度較大的特征及其重要性排序,以期為制造工藝和工序的優化提供決策指導。

1 Stacking介紹

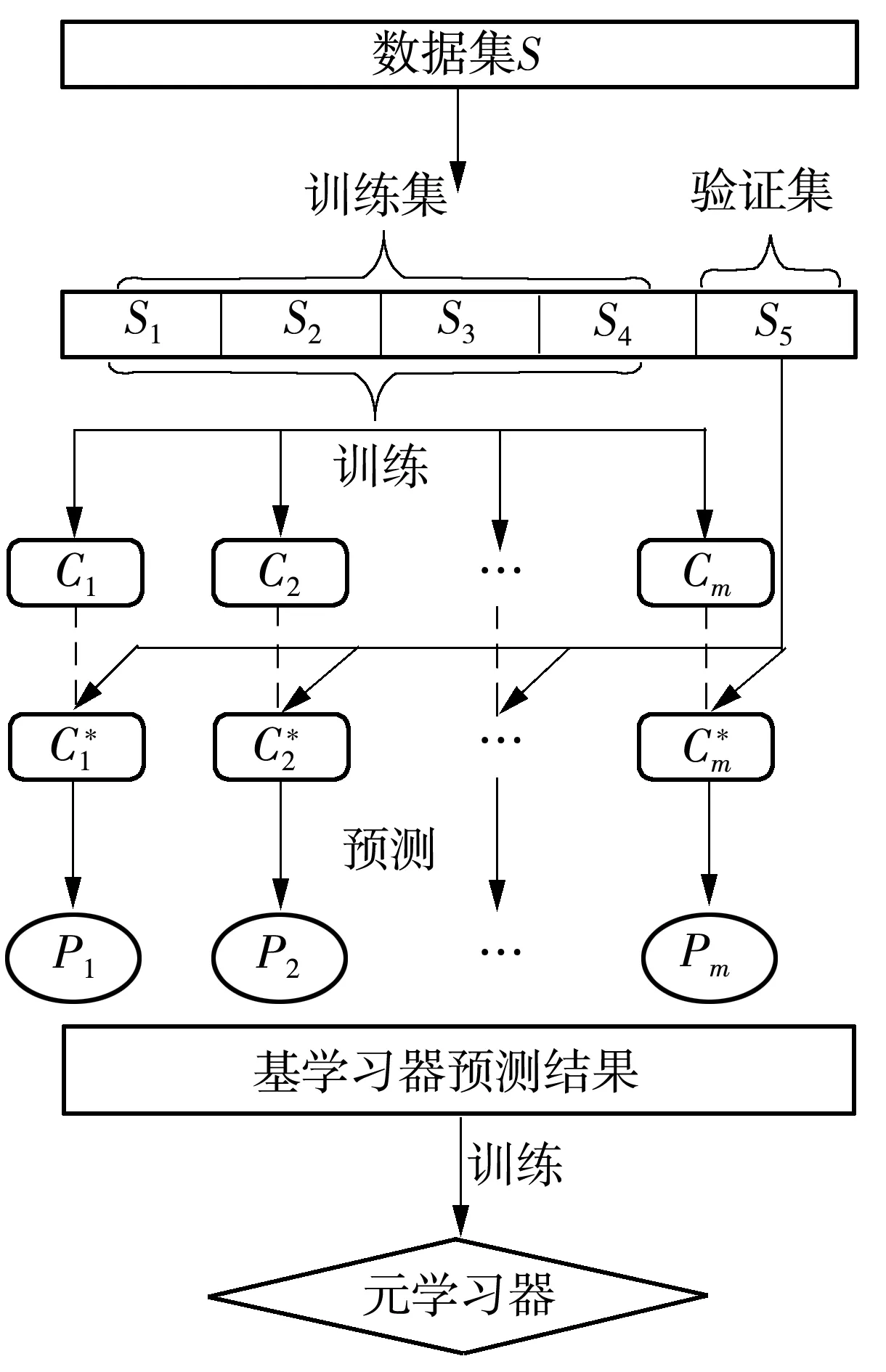

Stacking集成學習方法最初由Wolpert[9]于1992年提出,經不斷優化和改進,目前最完善的Stacking算法流程如圖1所示。

圖1 Stacking算法流程圖Fig.1 Flow chart of Stacking algorithm

對于數據集S={(Xi,Yi),i=1,2,…,n},其中Xi為第i個樣本的特征向量,Yi為第i個樣本對應的標簽值,j為每個特征向量中的特征個數,即每一個特征向量Xi=(Xi1,Xi2,…,Xij)。選取m個基學習器(C1,C2,…,Cm),采用K折交叉驗證方法。

Stacking算法的偽代碼如下:

{輸入數據集S={(Xi,Yi)|i=1,2,…,n};

輸出Stacking集成學習模型。

(1)將數據集均分為K個子集S1,S2,…,SK,默認情況下取K=5。

(3)返回步驟(2)K-1次,得到全部預測結果,形式為n行×m列數據。

(4)將步驟(3)得到的結果作為元學習器的輸入,訓練元學習器,輸出結果為n行×1列數據,標簽數據依舊是Yi,在這個過程中實現對元學習器的參數優化。至此得到完整的訓練完畢的Stacking集成學習模型。}

與傳統的Boosting和Bagging集成學習方法相比,Stacking集成學習方法在步驟(4)中將基學習器的輸出作為元學習器的輸入,使元學習器能夠整合全部基學習器的預測結果,并能減少第一層基學習器的預測偏差。通過這種方式集成不同類型的學習器,能結合不同學習器的優勢,得到的信息更加全面,Stacking集成學習方法也因此有著更廣泛的適用性[10]。

本文擬通過使用Stacking方法集成不同類型的學習器來提升模型的整體預測性能,從而使集成模型能達到更好的預測效果。

2 數據處理與評價指標

2.1 數據集描述

本文選用的數據集來源于第四屆工業大數據創新競賽決賽數據集,總計包含16 600條數據,由成型機狀態數據集和傳感器高頻采樣數據集兩個文件構成。成型機狀態數據集來自成型機機臺,均為表征成型過程中的一些狀態數據,主要包括最小射膠位置、熔膠時間、熔膠背壓、注射/保壓切換壓力、切換時間、切換位置、模具溫度、充模時間、熔膠結束后冷卻時間等。每一行對應一個模次,數據維度為86維。傳感器高頻采樣數據集來自模溫機及模具傳感器采集的數據,主要包括模溫機回水溫度、射嘴壓力、模溫機水流量、模腔壓力、模溫機熱水溫度、模溫機冷水溫度等。文件夾內每一個模次對應一個csv文件,單個模次時長為40~43 s,含有24個傳感器采集的數據。

2.2 數據預處理

對于成型機狀態數據集,特征維度總計86維,其中缺失值特征7維,由于缺失值特征均為全部缺失,因此對缺失值進行刪除操作。同時成型機狀態數據集中存在3個特征(模次號Id、記錄時間spcTime和備注Remark)對模型預測沒有幫助,故將其刪除,留下76維特征。

對于傳感器高頻采樣數據集,總計24維特征,存在兩個特征(采樣時間SampleTime和階段Phase)對模型預測沒有幫助,故作刪除處理,留下22維特征。嘗試運用多種方式提取同一模次中的特征,包括提取中位數、最大值、最小值、眾數等,選取相同的機器學習模型并參數調優后發現,提取均值得到的預測準確度最高。將預處理后的成型機狀態數據集與傳感器高頻采樣數據集組合,得到98維16 600條數據的數據集,隨機選取其中10 000條數據用來訓練和驗證模型,6 600條數據作為測試集。

2.3 特征選擇

特征選擇和特征提取有著些許的相似點,這兩者達到的效果是一樣的,即試圖減少特征數據集中特征的數目。但兩者所采用的方法不同:特征提取主要是通過屬性間的關系,如組合不同的屬性得到新的屬性,這樣就改變了原來的特征空間;而特征選擇是從原始特征數據集中選擇出子集,是一種包含的關系,沒有更改原始的特征空間。因此通過特征選擇方法建立的模型具有良好的解釋性,可以通過特征解釋回溯到生產工序中。

本文選用過濾型特征選擇方法中應用較為廣泛的SelectKBest方法,SelectKBest方法有特征數量k和打分函數Score兩個參數。Score的作用是給特征進行打分,然后從高到低選取特征,效果是移除得分前k名以外的所有特征。注塑件尺寸預測問題屬于回歸問題,因此Score函數選用f_regression回歸函數。

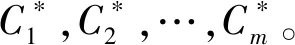

選用輕量級梯度提升樹(LGB)模型,使用5折交叉驗證方法評估模型的預測精度,模型預測偏差(均方誤差,MSE)隨特征數量k變化的折線圖如圖2所示。由圖中可得,特征數量為14時,模型預測偏差最低,因此SelectKBest特征選擇方法將特征維度降至14維。

圖2 LGB模型預測偏差隨特征數量的變化Fig.2 Change of predictions deviation of LGB model with the number of features

2.4 評價指標

回歸模型的預測性能通過預測尺寸與實際尺寸的偏差來評估,最常用的評價指標有平均絕對誤差(MAE,EMA)、均方誤差(MSE,EMS)和均方根誤差(RMSE,ERMS),計算公式如下:

(1)

(2)

式中,yi為實際值,fi為預測值。

RMSE是MSE的算術平方根,RMSE和目標實際值的量綱相同,具有更好的解釋性。

3 Stacking模型的構建與優化

為了使得 Stacking模型的預測性能達到最優,既要選擇合適的基學習器,又要選擇恰當的元學習器,同時不同學習器之間的組合方式也至關重要。因此在建立Stacking模型時,需要立足于各個模型的預測能力與各模型之間的相關度展開分析,選擇合適的基學習器、元學習器及其組合方式,才能建立有效的Stacking模型。

3.1 基學習器的選擇

3.1.1 初步篩選

Stacking方法中基學習器的選擇和組合方式至關重要,影響整個模型最終的預測性能。

本文初步選擇的基學習器有樹(Tree)、隨機森林(RF)、梯度提升決策樹(GBDT)、XGB、LGB、彈性網絡回歸(ENet)、核嶺回歸(KRR)、支持向量機(SVM)。其中,Tree有著良好的預測性能和成熟的理論支撐,在很多領域得到了較好的應用。RF和GBDT分別使用Bagging和Boosting的集成方法對Tree進行改進,在預測性能方面有了較大的提升。XGB模型有最強機器學習算法之稱,LGB模型對XGB模型的生長策略和過擬合問題進行了優化[11]。XGB和LGB模型在對Tree使用Boosting集成的基礎上,又借鑒了Bagging集成方法進行隨機采樣,是融合使用Boosting和Bagging集成方法的典范。ENet和KRR模型是針對線性模型添加L1和L2正則化的改進模型,有嚴謹的理論支撐和出色的實踐應用效果。SVM模型對于解決小樣本、非線性及高維度的問題有獨特的優勢,在工業領域已經得到了十分廣泛的應用。

在進一步選擇第一層的基學習器時,要綜合考慮兩個方面:一是因為Stacking模型的有效性主要來自于特征抽取[12],而不同的算法是從不同的數據空間角度來抽取特征的,因此要盡量選擇差異度較大的模型作為基學習器,才能最大程度地綜合不同算法的優勢[13];二是學習能力強的基模型有助于整體預測效果的提升[14],單獨預測性能非常好的基模型能在很大程度上提升融合模型的最終預測性能,因此要盡量選擇學習能力強的基模型。

2) 毛竹毛料收入。在合作社成立之前,農戶的毛竹毛料無償送給毛料加工商,毛料收入幾乎為零。在合作社成立之后,當年合作社請人鉤梢,除去成本毛料收入5.4萬元。2017年,合作社買了2臺毛料加工機器,租賃0.27 hm2土地,自己加工毛料,除去加工成本,當年毛料、竹梢、竹葉3項利潤為13.7萬元。

3.1.2 各模型的關聯度分析

模型之間的差異可以用各模型預測結果的關聯度來表示。本文使用Pearson相關系數分析不同模型的關聯程度,計算式如下:

(3)

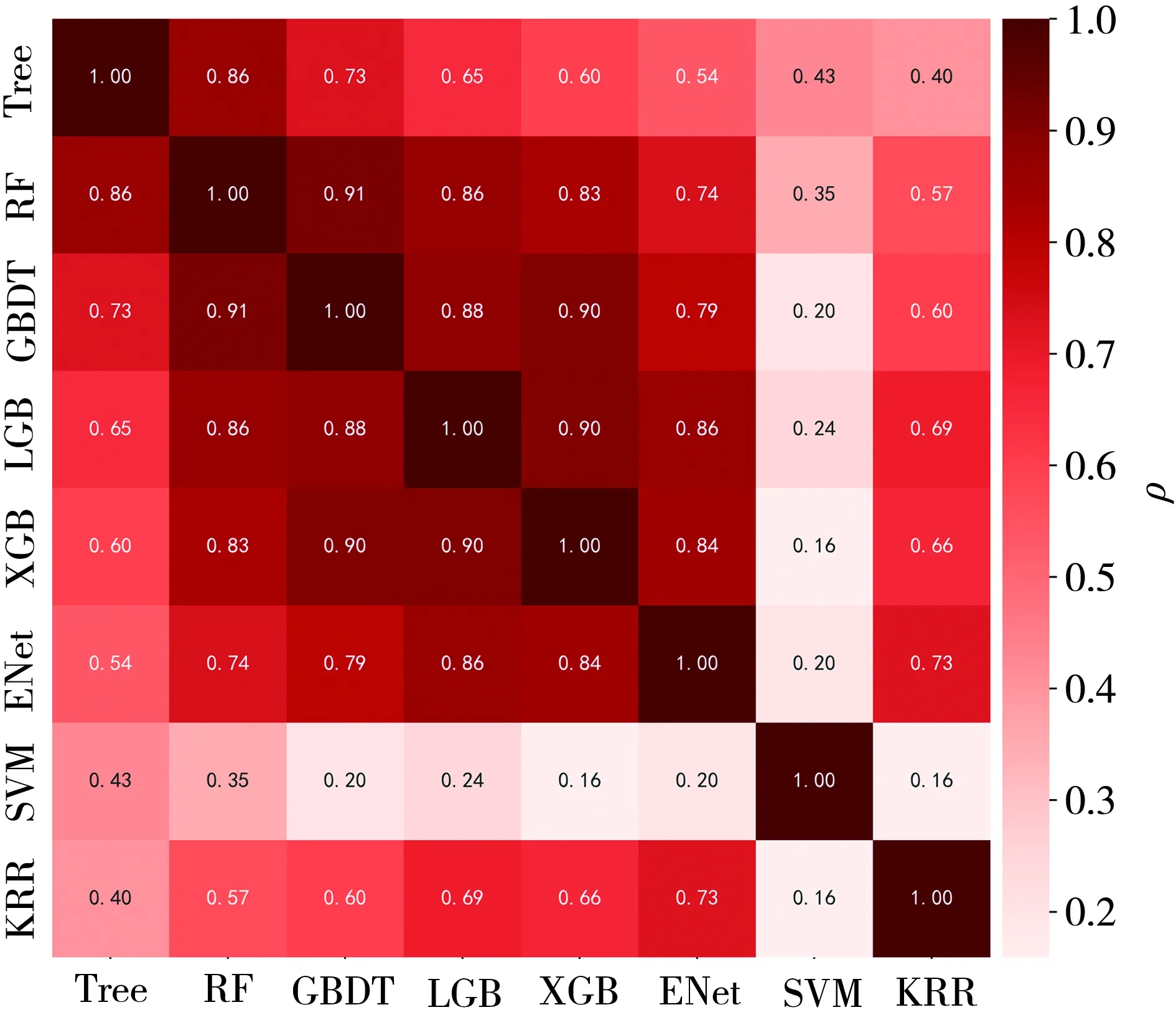

式中,μx和μy分別為模型x和模型y的預測均值。根據式(3)計算得到的結果,畫出各模型之間的相關性矩陣熱力圖,如圖3所示。熱力圖中顏色越深,模型之間的相關系數越接近1,相關程度越強;反之,模型之間的相關系數越接近0,相關程度越弱。

圖3 各模型預測結果的相關性分析Fig.3 Correlation analysis of the models’ predicted results

從圖3中可知:Tree、RF、GBDT、LGB、XGB模型兩兩之間的相關度都很高,因為這幾個模型雖然在訓練機理上有些不同,但本質都是基于決策樹的優化算法,算法觀測數據空間的角度差異很小;KRR模型是基于線性模型的改進模型,與樹模型的關聯度較低;SVM與上述模型的原理有著較大的差異,因此跟其他模型的預測結果相關度也很低。Stacking方法中往往模型相差越大且模型表現都不錯的前提下,模型融合后預測結果會有大幅提升[15]。

3.1.3 各模型的預測效果分析

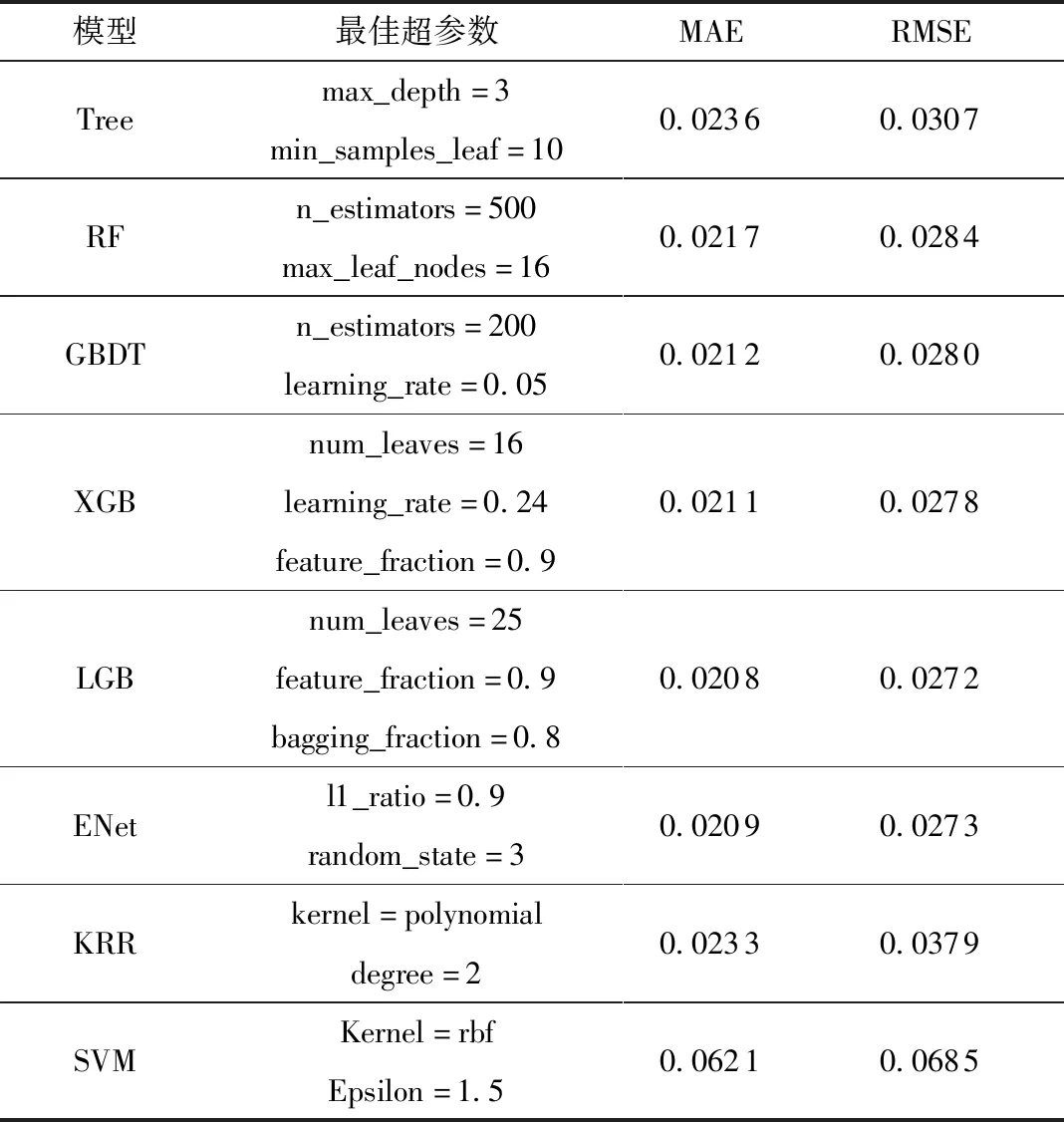

為了得到學習能力較強的基學習器,需要觀測各個模型單獨預測的效果。這個過程需要使每個模型的超參數達到最優,模型調參過程采取應用最廣泛的K折交叉驗證(取K=5),結合交叉驗證法使用GridSearchCV(網格調參方法)確定最佳超參數。各模型的最佳超參數及預測誤差如表1所示。

表1 各模型的最佳超參數及預測結果Table 1 The best hyperparameters and prediction results of the models

由表1可得,經超參數調優后,樹模型優化算法XGB、LGB和線性模型優化算法ENet的表現是單模型中較為出色的。從前面的關聯度分析中可知,SVM和KRR與樹模型的關聯度較低。因此,本文選取XGB、LGB、ENet、SVM、KRR作為候選基學習器。

3.2 元學習器的選擇

第二層的元學習器一般選擇泛化能力較強的模型或較為簡單的模型,以降低過擬合[16]。上述學習器中RF通過降低方差來提高模型預測性能,是泛化能力較強的模型;ENet作為線性回歸的優化模型,是較為簡單的模型。因此,本文對比使用RF、ENet作為候選元學習器,且后續結合使用K折交叉驗證方法降低過擬合。

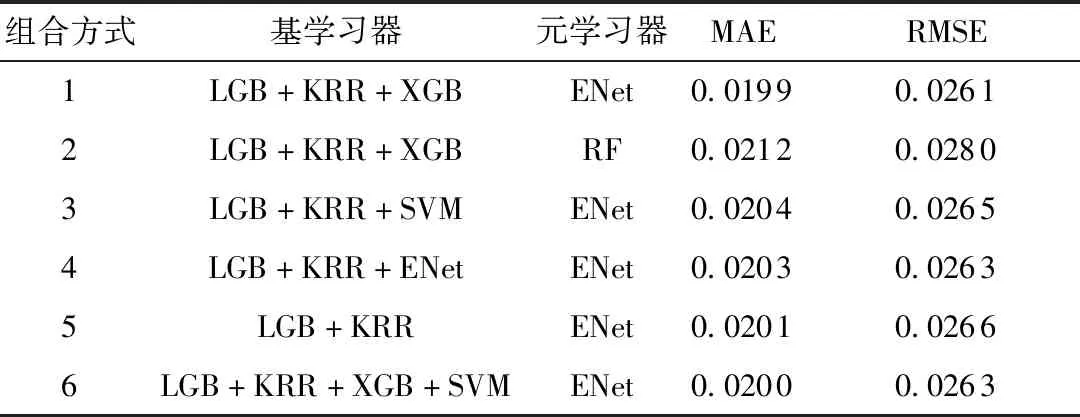

3.3 Stacking中不同學習器組合方式對比

表2 不同模型組合后的預測效果Table 2 Predictive effect of different model combinations

根據表2,不同組合方式下Stacking模型的預測效果有著明顯的差異。組合方式1的預測效果優于組合方式2,說明ENet作為元學習器比RF性能更好,更有利于提高模型的泛化能力。組合方式1的預測效果優于組合方式3,雖然組合方式3中各個基模型的相關度最低,但因為SVM本身的預測性能比較差,所以加入融合模型中,并未能提高模型整體的預測性能。組合方式1的預測效果優于組合方式4,這是因為組合方式4中,第一層基學習器已經存在ENet模型,第二層元學習器也是ENet模型,導致數據被反復訓練,增加了過擬合的風險,降低了模型的泛化能力。對比組合方式1、5、6可得,基學習器的數量選擇要適當,就本實驗而言,3個基學習器的預測性能最好,增加或者減少都會降低模型的預測性能。

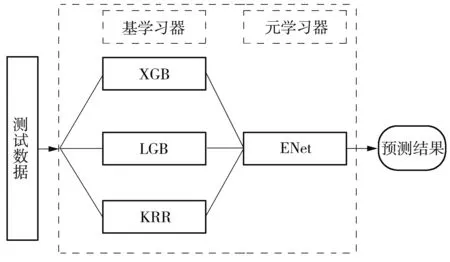

3.4 注塑件尺寸預測Stacking模型及其性能分析

綜合分析表1和表2可知,組合方式1不但比所有單一模型的預測效果好,而且在所有Stacking組合方式中的預測效果最佳,因此本文采用組合方式1進行模型融合,最終得到的注塑件尺寸預測Stacking模型如圖4所示。實際應用中,將i行×j列的測試數據輸入到融合模型中,首先經過基學習器XGB、LGB、KRR,輸出i行×3列的結果數據;然后將此結果數據輸入到元學習器ENet中,輸出最終的i行×1列預測結果。

圖4 注塑件尺寸預測Stacking模型Fig.4 Stacking model for injection part size prediction

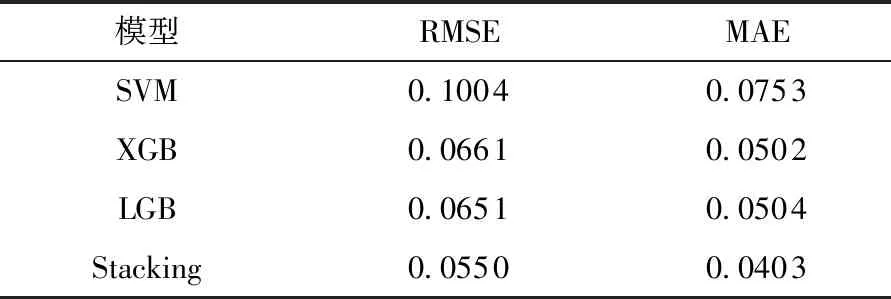

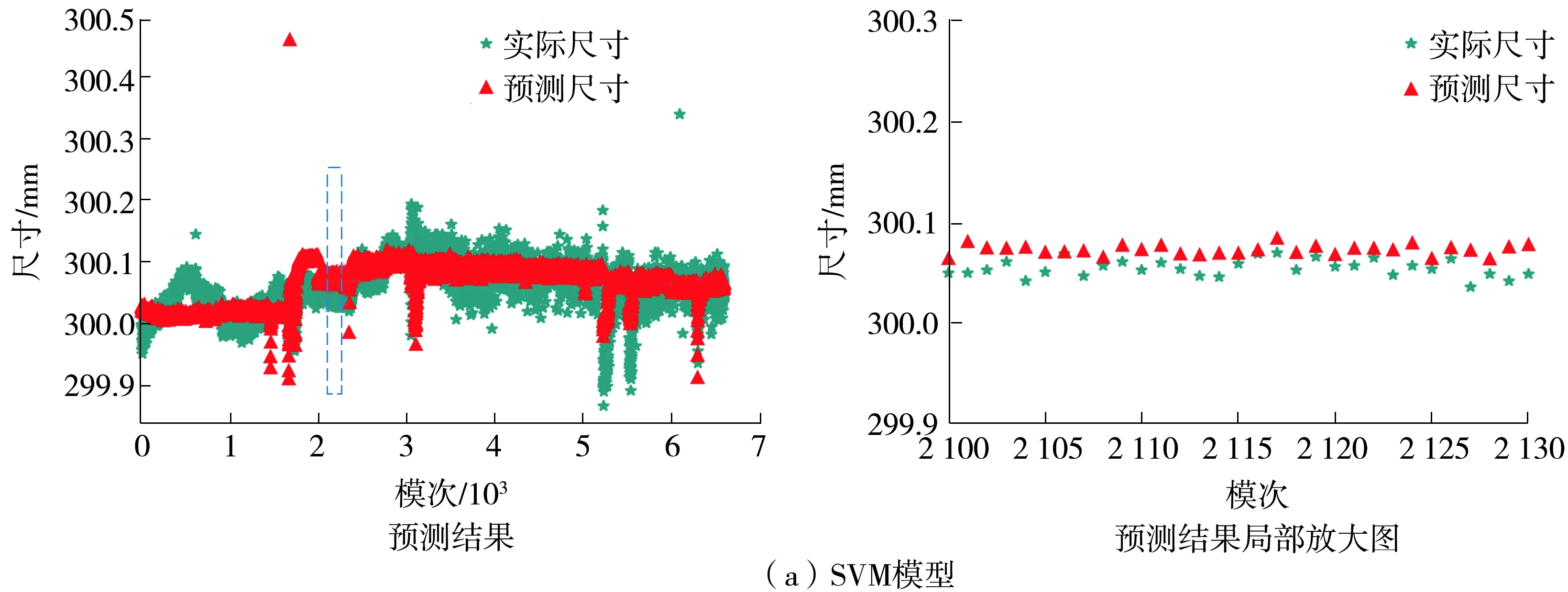

為了進一步檢驗注塑件尺寸預測Stacking模型的性能,使用測試集對比分析工業界最常用的單一模型SVM以及融合使用Boosting和Bagging方法的代表性模型XGB、LGB的測試結果,RMSE和MAE值如表3所示,模型測試效果比較如圖5所示。

表3 4種模型測試結果的RMSE和MAE對比Table 3 RMSE and MAE comparison of test results among four models

由表3可知,注塑件尺寸預測Stacking模型的RMSE和MAE較LGB模型分別降低了15.51%、20.04%,較XGB模型分別降低了16.79%、19.72%,較傳統SVM模型分別降低了45.22%、46.48%,性能提升明顯。

從圖5中可以發現:SVM模型對注塑件尺寸的變化趨勢不夠敏感;XGB模型和LGB模型能較好地跟蹤注塑件尺寸的變化趨勢,但其預測誤差偏大;Stacking模型在注塑件尺寸大幅變化和平穩變化階段能更準確地捕捉到其變化規律,預測準確性和魯棒性更高。

圖5 4種模型的測試效果對比Fig.5 Comparison of test effects among four models

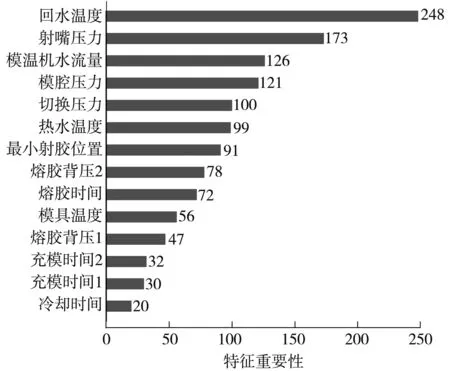

此外,根據集成的基學習器XGB提供的特征重要性排序方法,可以獲得對注塑件尺寸影響程度較大的特征及其重要性排序,如圖6所示。

圖6 特征重要性排序圖Fig.6 A sort chart of the importance of features

由圖6可得,回水溫度、射嘴壓力、模溫機水流量、模腔壓力是得分較高的重要特征。企業工程師可以從這些重要特征入手進行工藝優化,使這些特征變量更穩定,從而提升產品質量。

4 結語

針對注塑件尺寸預測問題,本文提出了一種基于Stacking集成學習的融合模型。首先,通過優化的特征選擇方法得到最佳的特征數量;然后,通過分析單一模型的關聯度和預測效果、對比不同學習器的組合方式,構建出預測性能最佳的Stacking模型,該模型的基學習器為XGB、LGB、KRR,元學習器為ENet。測試結果表明,本文構建的注塑件尺寸預測Stacking模型的RMSE和MAE較XGB和LGB模型分別降低了16%和20%左右,較傳統SVM模型分別降低了45.22%和46.48%。另外,本文模型能同步回溯出影響注塑件尺寸的重要特征與排序,可為制造工藝優化提供決策指導。