水聲信號(hào)調(diào)制方式智能識(shí)別技術(shù)*

張威龍,王景景

(青島科技大學(xué)信息科學(xué)技術(shù)學(xué)院,山東 青島 266000)

0 引言

隨著第五代移動(dòng)通信技術(shù)(5G)完全成熟并進(jìn)入全面應(yīng)用階段,各國(guó)逐步開(kāi)展新一代通信技術(shù)研究[1]。我國(guó)于2018 年3 月開(kāi)始著手研究第六代移動(dòng)通信技術(shù)(6G),2021 年11 月國(guó)家工信部發(fā)布《“十四五”信息通信行業(yè)發(fā)展規(guī)劃》,將開(kāi)展6G 基礎(chǔ)理論及關(guān)鍵技術(shù)研發(fā)列為移動(dòng)通信核心技術(shù)演進(jìn)和產(chǎn)業(yè)推進(jìn)工程,提出構(gòu)建6G 愿景、典型應(yīng)用場(chǎng)景和關(guān)鍵能力指標(biāo)體系。6G 的終極目標(biāo)是統(tǒng)一整合海陸空通信資源進(jìn)行信息資源共享,實(shí)現(xiàn)萬(wàn)物互聯(lián)互通。

水聲通信技術(shù)是6G 海洋通信資源的關(guān)鍵組成,水聲通信的工作方式分為協(xié)作式與非協(xié)作式兩種。在協(xié)作式水聲通信系統(tǒng)中,調(diào)制方式智能識(shí)別技術(shù)使接收端自動(dòng)識(shí)別接收信號(hào)的調(diào)制方式,確保采用正確的解調(diào)方式恢復(fù)數(shù)據(jù),提高水聲通信系統(tǒng)數(shù)據(jù)傳輸?shù)母咝院涂煽啃裕辉诜菂f(xié)作式水聲通信系統(tǒng)中,調(diào)制方式智能識(shí)別技術(shù)能夠提高識(shí)別速度與準(zhǔn)確率,滿足各個(gè)領(lǐng)域?qū)π盘?hào)調(diào)制方式識(shí)別實(shí)時(shí)性與準(zhǔn)確性的需求。

然而,由于水下環(huán)境復(fù)雜、通信收發(fā)端性能有限以及水聲信號(hào)不充足,使得水聲通信調(diào)制方式智能識(shí)別方法的發(fā)展面臨巨大挑戰(zhàn),具體包括:第一,調(diào)制方式識(shí)別算法性能取決于特征提取的有效性,復(fù)雜的海洋環(huán)境會(huì)嚴(yán)重干擾水聲信號(hào)特征;第二,復(fù)雜度高的水聲信號(hào)調(diào)制方式識(shí)別算法難以部署在算力受限、能量有限的水下通信節(jié)點(diǎn);第三,基于仿真數(shù)據(jù)或仿真信道研究設(shè)計(jì)的水聲信號(hào)調(diào)制方式識(shí)別算法不適用于實(shí)際海洋通信場(chǎng)景。針對(duì)上述問(wèn)題,本文提出一種基于深度融合神經(jīng)網(wǎng)絡(luò)的水聲信號(hào)調(diào)制識(shí)別方法,可提取水聲信號(hào)的有效特征,并通過(guò)優(yōu)化模型的網(wǎng)絡(luò)結(jié)構(gòu)降低算法的復(fù)雜度,基于實(shí)測(cè)水聲信號(hào)數(shù)據(jù)集驗(yàn)證算法的性能優(yōu)勢(shì)。

1 調(diào)制方式識(shí)別技術(shù)

上世紀(jì)六十年代末發(fā)表了首篇信號(hào)調(diào)制方式自動(dòng)識(shí)別研究的論文,標(biāo)志著調(diào)制方式智能識(shí)別技術(shù)的首次問(wèn)世[2]。調(diào)制方式智能識(shí)別的方法分為基于最大似然比假設(shè)檢驗(yàn)的調(diào)制方式識(shí)別方法和基于特征提取的調(diào)制方式識(shí)別方法。雖然基于最大似然比假設(shè)檢驗(yàn)算法的調(diào)制方式識(shí)別技術(shù)理論依據(jù)完善,但該方法需要信號(hào)的先驗(yàn)信息,其泛化性與魯棒性不足,且計(jì)算復(fù)雜度高,難以推廣于工程領(lǐng)域[3]。而基于特征提取的調(diào)制方式識(shí)別方法由于技術(shù)思路簡(jiǎn)單清晰,在低信噪比條件下?lián)碛锌捎^的識(shí)別準(zhǔn)確率,因此是目前調(diào)制方式智能識(shí)別的研究熱點(diǎn)[4-7]。目前,基于特征的調(diào)制方式識(shí)別方法共分為兩類:一類為基于機(jī)器學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別;另一類為基于深度學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別。

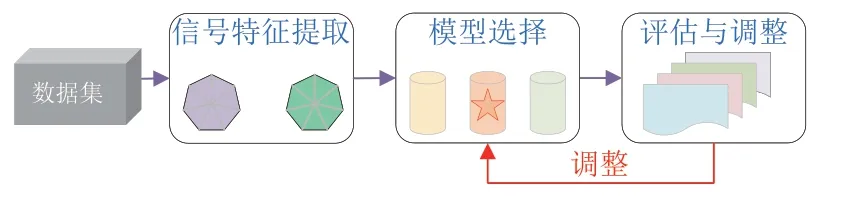

基于機(jī)器學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別方法首先提取信號(hào)的某些特征,然后使用機(jī)器學(xué)習(xí)分類器算法根據(jù)信號(hào)特征的差異判別信號(hào)調(diào)制方式,識(shí)別流程具體如圖1 所示:

圖1 基于機(jī)器學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別流程圖

2009 年,Orlic[8]等人提取信號(hào)的歸一化六階累積量作為特征,利用一種城市多徑傳播統(tǒng)計(jì)模型進(jìn)行調(diào)制方式識(shí)別的試驗(yàn)仿真,當(dāng)信噪比大于10 dB 時(shí),該方法對(duì)BPSK(Binary Phase Shift Keying,二進(jìn)制相移鍵控)及QPSK(Quadrature Phase Shift Keying,正交相移鍵控)的識(shí)別準(zhǔn)確率可達(dá)90%以上,但對(duì)16QAM 及64QAM 的識(shí)別率較差,僅為50%左右。2010 年,Tabatabaei[9]等人提取信號(hào)的瑞利熵、頻率跨度、頻譜偏斜度以及過(guò)零率作為特征,使用支持向量機(jī)作為分類器,當(dāng)信噪比為20 dB 時(shí),對(duì)4ASK、8FSK 和8PSK 信號(hào)的識(shí)別準(zhǔn)確率僅為79%。2015 年,童峰等人通過(guò)支持向量機(jī)分類器,利用信號(hào)功率譜特征識(shí)別出了MPSK(Multiple Phase Shift Keying,多進(jìn)制相移鍵控)與MFSK(Multiple Frequency Shift Keying,多進(jìn)制頻移鍵控)信號(hào)、利用平方譜特征識(shí)別出了BPSK 與QPSK 信號(hào),并對(duì)海上實(shí)測(cè)數(shù)據(jù)進(jìn)行了驗(yàn)證[10],而且還通過(guò)水聲信號(hào)功率譜和循環(huán)前綴的相關(guān)性提取特征參數(shù),設(shè)計(jì)了一種基于模糊系統(tǒng)的水聲通信信號(hào)MPSK、MFSK、OFDM(Orthogonal Frequency Division Multiplexing,正交頻分復(fù)用)調(diào)制方式識(shí)別器[11]。2016 年,鞏克現(xiàn)[12]等人利用自回歸模型的極點(diǎn)提取信號(hào)的短時(shí)頻率峰值,應(yīng)用改進(jìn)的聚類算法對(duì)峰值序列進(jìn)行聚類處理,根據(jù)不同階數(shù)FSK(Frequency Shift Keying,頻移鍵控)信號(hào)不同聚類中心的局部密度與距離乘積的不同,利用支持向量機(jī)進(jìn)行分類,完成了MFSK 的調(diào)制識(shí)別。

然而,由于基于機(jī)器學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別方法是人工設(shè)計(jì)準(zhǔn)則,然后根據(jù)上述準(zhǔn)則選擇特征,特征提取與最終預(yù)測(cè)模型的學(xué)習(xí)分開(kāi)進(jìn)行,因此學(xué)習(xí)的特征不一定會(huì)提高最終模型的性能、保證模型的泛化能力。

基于深度學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別方法利用深度神經(jīng)網(wǎng)絡(luò)自動(dòng)提取信號(hào)的抽象特征,并借由合適的分類網(wǎng)絡(luò)識(shí)別信號(hào)的調(diào)制方式。

2019 年,Nihat Daldal[13]等人將接收的數(shù)字信號(hào)直接輸入其提出的深度長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)模型進(jìn)行識(shí)別,該方法在5 dB 信噪比以上可較好地識(shí)別出ASK(Amplitude Shift Keying,振幅鍵控)、FSK 等多種調(diào)制方式。同年,彭華[14]等人將信號(hào)時(shí)域波形轉(zhuǎn)化為眼圖和矢量圖,利用卷積神經(jīng)網(wǎng)絡(luò)識(shí)別淺層特征,獲得了較好的識(shí)別準(zhǔn)確度;同時(shí)還通過(guò)門控循環(huán)單元提取信號(hào)時(shí)序特征,特征輸入全連接神經(jīng)網(wǎng)絡(luò)識(shí)別信號(hào)調(diào)制方式,當(dāng)信號(hào)信噪比為6 dB 時(shí),能夠正確識(shí)別98%的信號(hào)調(diào)制方式[15],但算法的時(shí)間復(fù)雜度較高。楊潔[16]等人結(jié)合兩個(gè)在不同數(shù)據(jù)集上訓(xùn)練的CNN(Convolutional Neural Network,卷積神經(jīng)網(wǎng)絡(luò))對(duì)輸入的信號(hào)進(jìn)行識(shí)別,在低信噪比下可有效識(shí)別QAM(Quadrature Amplitude Modulation,正交幅度調(diào)制)的調(diào)制階數(shù)。方世良[17]等人根據(jù)MPSK 信號(hào)M次方譜在M倍載頻處存在線譜特征的基本原理,針對(duì)直接估計(jì)高次譜抑制小信號(hào)能力不足的問(wèn)題,采用解析信號(hào)構(gòu)造高次譜以提高處理增益,基于仿真數(shù)據(jù)的試驗(yàn)結(jié)果表明該方法能有效降低在低信噪比下的小信號(hào)抑制影響,提高低信噪比下的PSK(Phase Shift Keying,相移鍵控)信號(hào)類內(nèi)識(shí)別性能。2020 年,劉亞博[18]等人通過(guò)特征提取卷積神經(jīng)網(wǎng)絡(luò)和圖映射卷積神經(jīng)網(wǎng)絡(luò),分別提取信號(hào)特征和映射子集到圖中,然后利用圖卷積網(wǎng)絡(luò)識(shí)別調(diào)制方式,在低信噪比的情況下取得較好的識(shí)別精度,但算法復(fù)雜度較高。同年,加濟(jì)安泰普大學(xué)的Ahmed.K.Ali[19]等人在高斯信道環(huán)境下,提取高階譜特征輸入多層感知器進(jìn)行調(diào)制識(shí)別,該方法可識(shí)別16APSK(16 Amplitude Phase Shift Keying,16 振幅移相鍵控)、32APSK 及64APSK 調(diào)制方式,但識(shí)別信號(hào)調(diào)制方式種類較少。

但是,目前上述基于深度學(xué)習(xí)的信號(hào)調(diào)制方式識(shí)別算法多采用仿真數(shù)據(jù)構(gòu)建,仿真環(huán)境與實(shí)際環(huán)境不同,基于仿真數(shù)據(jù)的設(shè)計(jì)算法難以適用于實(shí)際數(shù)據(jù)。而且基于深度學(xué)習(xí)的調(diào)制識(shí)別算法通常僅采用加深網(wǎng)絡(luò)層數(shù)的方法來(lái)增強(qiáng)網(wǎng)絡(luò)學(xué)習(xí)能力,致使算法復(fù)雜度極高,且識(shí)別信號(hào)調(diào)制方式的種類較少。由于上述算法并未考慮最終在水下通信節(jié)點(diǎn)的有限功率和能量下部署,也未曾考慮根據(jù)水聲信號(hào)的特點(diǎn)設(shè)計(jì)適合于處理水下聲信號(hào)的端到端神經(jīng)網(wǎng)絡(luò),因此難以應(yīng)用于實(shí)際水下通信。

2 基于深度融合神經(jīng)網(wǎng)絡(luò)的水聲信號(hào)調(diào)制方式識(shí)別

深度學(xué)習(xí)方法多采用單一特征提取結(jié)構(gòu)且未考慮水聲信號(hào)時(shí)序特點(diǎn),基于實(shí)測(cè)數(shù)據(jù)驗(yàn)證時(shí)算法準(zhǔn)確率低;未充分改進(jìn)網(wǎng)絡(luò)模型結(jié)構(gòu),致使算法復(fù)雜度高。針對(duì)上述問(wèn)題,本文提出了一種適合水聲信號(hào)調(diào)制方式識(shí)別的深度融合神經(jīng)網(wǎng)絡(luò)模型——R&CNN(Recurrent &Convolutional Neural Network,循環(huán)卷積神經(jīng)網(wǎng)絡(luò)),如圖2 所示。基于黃海數(shù)據(jù)集展開(kāi)試驗(yàn),結(jié)果表明該模型識(shí)別準(zhǔn)確率高且時(shí)間復(fù)雜度低,能夠滿足通信實(shí)時(shí)性要求。

圖2 循環(huán)卷積神經(jīng)網(wǎng)絡(luò)模型

2.1 循環(huán)層模設(shè)計(jì)

循環(huán)卷積神經(jīng)網(wǎng)絡(luò)的循環(huán)層部分共有兩層,每一層的基本結(jié)構(gòu)如圖3 所示。其中,Q為輸入層的權(quán)重矩陣;P為當(dāng)前時(shí)刻隱含層輸出傳遞給下一時(shí)刻隱含層的權(quán)重矩陣;O為輸出層的權(quán)重矩陣。

圖3 循環(huán)卷積神經(jīng)網(wǎng)絡(luò)的循環(huán)層基本結(jié)構(gòu)

循環(huán)層的結(jié)構(gòu)使得隱含層神經(jīng)元輸出能夠在下一個(gè)時(shí)刻直接作用于自身。隨著時(shí)間的推進(jìn),上一個(gè)時(shí)刻的輸出將影響下一時(shí)刻的輸出結(jié)果,充分利用了數(shù)據(jù)的歷史信息。因此,循環(huán)層的特性有利于提取時(shí)間序列的特征,適合提取時(shí)序特性明顯的水聲信號(hào)。此外,由于水聲通信過(guò)程多普勒效應(yīng)影響,信號(hào)數(shù)據(jù)序列會(huì)產(chǎn)生相互干擾。因此,本文使用GRU(Gated Recurrent Unit,門控循環(huán)單元)構(gòu)造循環(huán)層,GRU 可以通過(guò)記憶和處理信號(hào)序列的方式緩解多普勒效應(yīng)的干擾[20]。GRU 結(jié)構(gòu)示意圖如圖4 所示:

圖4 GRU結(jié)構(gòu)示意圖

GRU 的邏輯結(jié)構(gòu)描述如下:

其中,* 表示矩陣點(diǎn)乘運(yùn)算;tanh與σ分別表示Tangent函數(shù)、Sigmoid 函數(shù);Int為t時(shí)刻輸入;ht-1為t-1 時(shí)刻隱含層輸出;ht為t時(shí)刻隱含層輸出;Wz、Wr與Wh是經(jīng)過(guò)學(xué)習(xí)的權(quán)重矩陣;Zt為更新門,它決定前一時(shí)刻記憶信息更新到當(dāng)前時(shí)刻的量;rt為重置門,它控制記憶信息與當(dāng)前時(shí)刻輸入的結(jié)合;為候選態(tài)。GRU 的更新門與重置門能夠記憶長(zhǎng)信號(hào)序列中的信息,確保有效信息不會(huì)因時(shí)間推移或預(yù)測(cè)不相關(guān)而消除。

本文將循環(huán)層部分的第一層GRU 輸出維數(shù)設(shè)置為640,第二層GRU 輸出維數(shù)設(shè)置為320,每層循環(huán)層都輸出完整序列。

2.2 卷積層設(shè)計(jì)

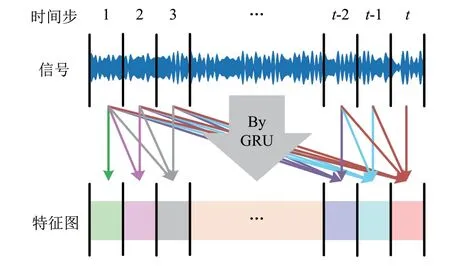

由循環(huán)層提取的特征圖作為卷積層輸入,如圖5 所示,循環(huán)層第t時(shí)間步特征映射僅與從第1 時(shí)間步到第t時(shí)間步的信號(hào)相關(guān),而與第t時(shí)間步之后的信號(hào)無(wú)關(guān)。因此,只有最后一個(gè)時(shí)間步的輸出特征映射包含完整信號(hào),而其他時(shí)間步的輸出特征映射僅包含不完整信號(hào)。傳統(tǒng)的做法是僅保留最后一個(gè)時(shí)間步的輸出特征映射,丟棄其他時(shí)間步的輸出特征映射,該做法會(huì)產(chǎn)生信息的丟失問(wèn)題。為了充分利用信息,本文保留了所有時(shí)間步的輸出特征圖,并使用卷積層實(shí)現(xiàn)跨時(shí)間步信息的交互和集成,有助于提高網(wǎng)絡(luò)的特征提取能力。

圖5 循環(huán)層提取特征

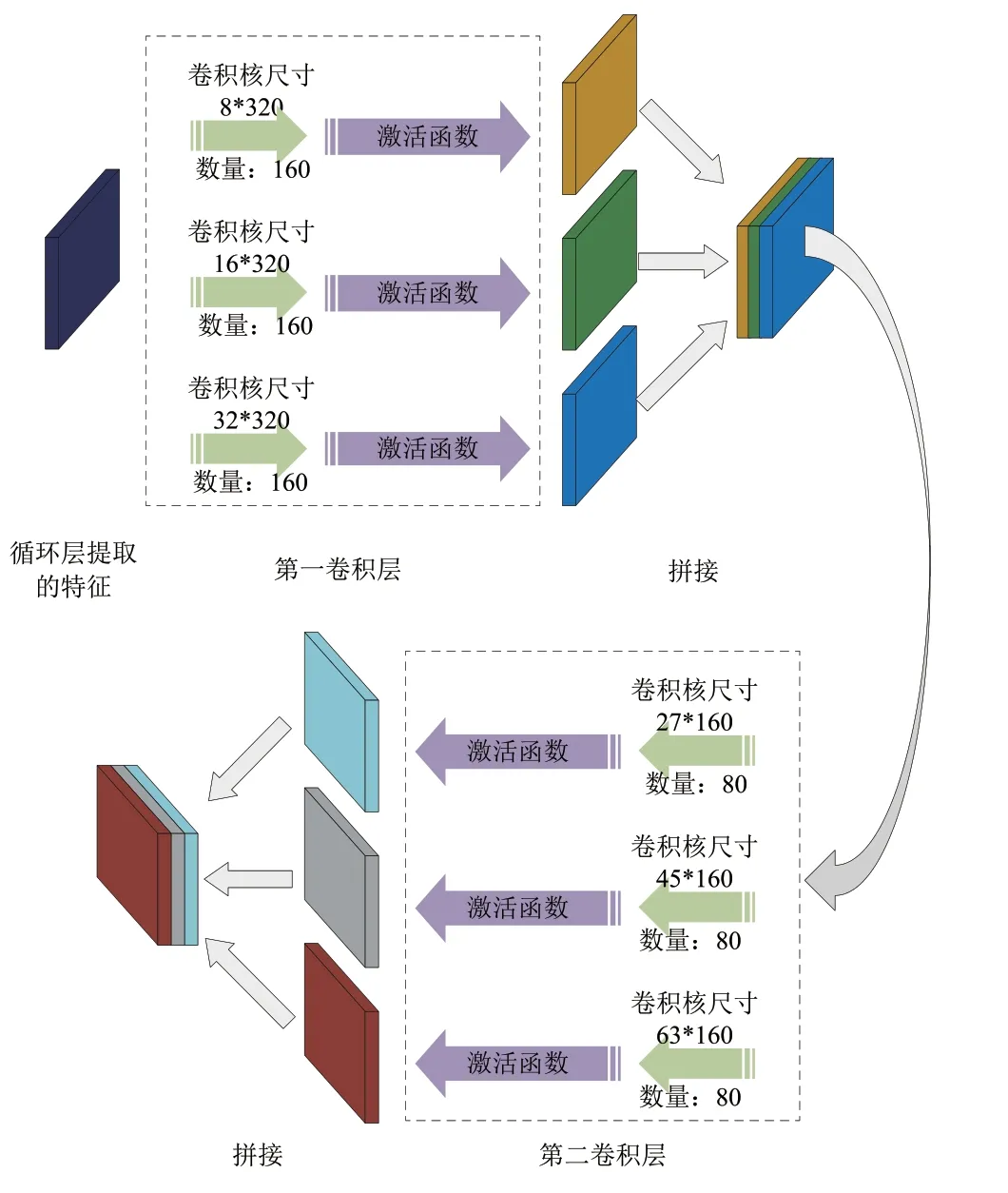

此外,由于第二循環(huán)層輸出特征映射的形狀和信號(hào)的時(shí)間特性,本文改進(jìn)了卷積層的設(shè)計(jì),通過(guò)使用一維卷積核而不是二維卷積核設(shè)計(jì)卷積層。在此基礎(chǔ)上,本文整合了Inception v1 網(wǎng)絡(luò)[21],增加了網(wǎng)絡(luò)寬度,并提高了學(xué)習(xí)能力。同時(shí),基于較少的信號(hào)特征(與圖像特征相比),本文移除池化層,避免信號(hào)特征因池化層的池化作用而丟失。雖然移除池化層會(huì)略微增加計(jì)算量,但使用簡(jiǎn)單的一維卷積核替換相對(duì)復(fù)雜的二維卷積核,總體上降低了網(wǎng)絡(luò)的復(fù)雜度。

R&CNN 共有兩層卷積層,每層卷積層都含有尺寸不一的卷積核,卷積層部分結(jié)構(gòu)如圖6 所示:

圖6 卷積層部分結(jié)構(gòu)

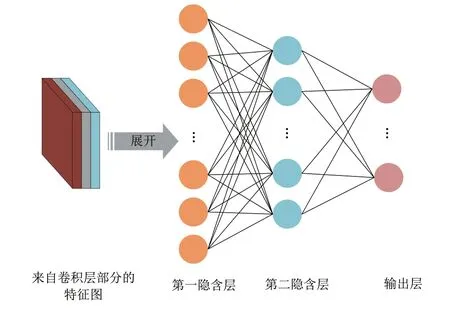

2.3 全連接層設(shè)計(jì)

R&CNN 最深層為全連接層部分,全連接層部分由兩層隱含層與輸出層構(gòu)成。兩層隱含層神經(jīng)元個(gè)數(shù)分別為120與84,輸出層共有8 個(gè)神經(jīng)元,對(duì)應(yīng)可能的調(diào)制方式包括BPSK、QPSK、BFSK、QFSK(Quadrature Phase Shift Keying,正交相移鍵控)、16QAM、64QAM、OFDM 與DSSS(Direct Sequence Spread Spectrum,直接序列展頻)。由卷積層部分得到的特征圖經(jīng)展開(kāi)后輸入全連接層部分,輸出層輸出識(shí)別結(jié)果。全連接層部分的結(jié)構(gòu)圖如7 所示:

圖7 全連接層部分的結(jié)構(gòu)圖

2.4 試驗(yàn)結(jié)果

2020 年8 月13 日于東經(jīng)120°32′04.984″北緯36°05′8.507″中國(guó)黃海淺海海域,通過(guò)筆者團(tuán)隊(duì)搭建的水聲通信系統(tǒng)獲得水聲信號(hào)數(shù)據(jù)集——黃海數(shù)據(jù)集(包含BPSK、QPSK、BFSK、QFSK、16QAM、64QAM、OFDM 這7 種調(diào)制方式信號(hào),共計(jì)1 400 組信號(hào)數(shù)據(jù),以3:1 的比例劃分訓(xùn)練集與驗(yàn)證集),并基于黃海數(shù)據(jù)集開(kāi)展試驗(yàn)。本文選取了3 種常用神經(jīng)網(wǎng)絡(luò)用于對(duì)比,包括:CNN-LSTM(Convolutional Neural Network-Long Short Term Memory,卷積長(zhǎng)短時(shí)神經(jīng)網(wǎng)絡(luò))[22]、AlexNet8[23]與LSTM(Long Short Term Memory,長(zhǎng)短期記憶網(wǎng)絡(luò))[24]。表1、表2 給出了基于黃海數(shù)據(jù)集4 種神經(jīng)網(wǎng)絡(luò)的實(shí)驗(yàn)結(jié)果:

表1 基于黃海數(shù)據(jù)集4種神經(jīng)網(wǎng)絡(luò)的識(shí)別結(jié)果

表2 基于黃海數(shù)據(jù)集4種神經(jīng)網(wǎng)絡(luò)的平均識(shí)別時(shí)間

由表1、表2 可以得出,基于黃海數(shù)據(jù)集,AlexNet8訓(xùn)練集準(zhǔn)確率為98.75%、驗(yàn)證集準(zhǔn)確率為92.14%,準(zhǔn)確率相差6.61%,這表明了AlexNet8 確實(shí)可以較好地學(xué)習(xí)信號(hào)數(shù)據(jù),但是AlexNet8 的結(jié)構(gòu)決定了它只能像學(xué)習(xí)圖片一樣學(xué)習(xí)數(shù)據(jù)局部聯(lián)系(空間特征學(xué)習(xí)),無(wú)法像LSTM、R&CNN 學(xué)習(xí)信號(hào)時(shí)序特征,而水聲信號(hào)的時(shí)序特征比局部特征更能反映信號(hào)的特性,因此AlexNet8 的訓(xùn)練集識(shí)別精度與驗(yàn)證集識(shí)別精度難以保持一致。基于黃海數(shù)據(jù)集,LSTM 訓(xùn)練集準(zhǔn)確率為92.77%、驗(yàn)證集準(zhǔn)確率為93.57%,準(zhǔn)確率相差0.8%。上述現(xiàn)象表明LSTM提取的信號(hào)特征有較好的描述性,能夠較為充分地反映水聲信號(hào)調(diào)制方式的特性。此外,LSTM 識(shí)別單個(gè)信號(hào)的平均時(shí)間為7.167 ms,僅次于R&CNN,側(cè)面反映基于時(shí)序的神經(jīng)網(wǎng)絡(luò)處理信號(hào)的優(yōu)越性。基于黃海數(shù)據(jù)集,與R&CNN 模型同為融合特征提取結(jié)構(gòu)的CNN-LSTM 的訓(xùn)練集準(zhǔn)確率為90.09%、驗(yàn)證集準(zhǔn)確率為41.43%,準(zhǔn)確率相差48.66%。上述結(jié)果表明,采用CNN 作為淺層的CNN-LSTM 不具備從實(shí)際水聲信號(hào)中穩(wěn)定有效提取特征的能力,在時(shí)間復(fù)雜度方面,CNN-LSTM 識(shí)別信號(hào)的平均時(shí)間為688.161 ms,在所有算法中時(shí)間復(fù)雜度最高。基于黃海數(shù)據(jù)集,R&CNN 模型的訓(xùn)練集、驗(yàn)證集準(zhǔn)確率最高,且準(zhǔn)確率相差0.9%,這表明R&CNN 對(duì)水聲信號(hào)有最好的學(xué)習(xí)能力。在時(shí)間復(fù)雜度方面,R&CNN 識(shí)別單個(gè)信號(hào)的平均時(shí)間僅為7.164 ms,該模型在保證識(shí)別精度的同時(shí)還具有較低的時(shí)間復(fù)雜度。

3 結(jié)束語(yǔ)

本文提出了一種可高效、準(zhǔn)確識(shí)別水聲信號(hào)調(diào)制方式的神經(jīng)網(wǎng)絡(luò)模型——R&CNN。與傳統(tǒng)自動(dòng)調(diào)制識(shí)別方法相比,該神經(jīng)網(wǎng)絡(luò)模型無(wú)需預(yù)先提取信號(hào)特征,避免了基于仿真條件下設(shè)計(jì)的信號(hào)特征提取算法難以應(yīng)用于實(shí)際海域的問(wèn)題。與常規(guī)深度學(xué)習(xí)算法相比,R&CNN神經(jīng)網(wǎng)絡(luò)模型綜合了RNN 中的循環(huán)層處理時(shí)序數(shù)據(jù)的巨大優(yōu)勢(shì),又利用CNN 卷積層的空間學(xué)習(xí)能力彌補(bǔ)循環(huán)層提取特征的不足,并根據(jù)信號(hào)特征特點(diǎn)改進(jìn)了卷積層,降低了模型復(fù)雜度。基于黃海的水聲數(shù)據(jù)集展開(kāi)試驗(yàn)測(cè)試,結(jié)果表明R&CNN 比傳統(tǒng)AlexNet8、LSTM 和CNN-LSTM 有更好的識(shí)別準(zhǔn)確率,可有效識(shí)別BFSK、QFSK、BPSK、QPSK、16QAM、64QAM、OFDM 這7類調(diào)制信號(hào)。同時(shí),對(duì)網(wǎng)絡(luò)結(jié)構(gòu)的改進(jìn)有效地減少了模型復(fù)雜度,單個(gè)信號(hào)的平均識(shí)別時(shí)間僅為7.164 ms,可滿足水聲通信的實(shí)時(shí)性需求。