深度學習的人工智能應用處理系統設計研究

安 婷 郭 輝

(山西晉中理工學院,晉中 030600)

建立和模擬人腦進行分析學習的神經網絡即深度學習。該方法是機器學習研究中的創新技術,通過模仿人腦機制讀取和分析數據。人工智能的機器學習方法是在深度學習背景基礎上可與之相媲美的方法,在實現圖像、聲音和文本識別及機器翻譯的智能化方向上大力邁進。下面針對深度學習的人工智能應用處理系統進行相關設計。

1 設計目的

基于神經網絡、深度學習等的設計,可通過融合生物學、數學和電子信息等技術,以發揮其在應用領域的成效。三次工業革命后,基于深度學習的人工智能應用處理系統設計對生產結構和生產關系產生了顛覆性改變。

2 設計構建要訣

2.1 人工神經網絡之仿生人腦

通過深度學習以獲得算法并賦予電子元件(如CPU),最終在電子元件與傳感器、輸入設備鏈接及其模擬人腦的樹突、細胞體、軸突等人腦神經元(神經細胞)中,實現對相關信息的有效處理,并經由內部信息處理和輸出結果等神經元刺激,在各電子元件、傳感器、輸入設備、鏈接以外的神經網絡中獲得有效的幫助。由此組成的關系網絡識別層面,更好地融合了神經網絡的效應,在圖像物體識別和解釋問題層面獲得了良好效果。深度思維團隊測驗了該神經網絡的變量關系問題,與多數人工智能(Artificial Intelligence,AI)算式相比,在推理問題方面的表現尤為出色。如圖1所示,人工智能神經網絡可以像人類一樣推理。

圖1 人工智能神經網絡人腦仿生圖

2.2 深度學習開展環節對學習的仿生

21世紀,人工智能以人腦對外界刺激的識別,更能發揮其抽象和迭代效應。對比單個神經網絡,基于多個神經元的信息輸入/輸出“層次”均歸屬同一層級,通過使用淺層神經網絡實現對信息管理和數據的挖掘。深度信念網絡(Deep Belief Network,DBN)的提出,實現了人腦多層神經網絡信息處理、分析和學習模擬。深度學習在深層神經網絡上開展,多層級數量囊括輸入層、中間層和輸出層等。例如,微信中有超過上百億條消息,包括圖片、鏈接及數據等,后臺數據分析、廣告匹配采用了人工智能技術后端服務。

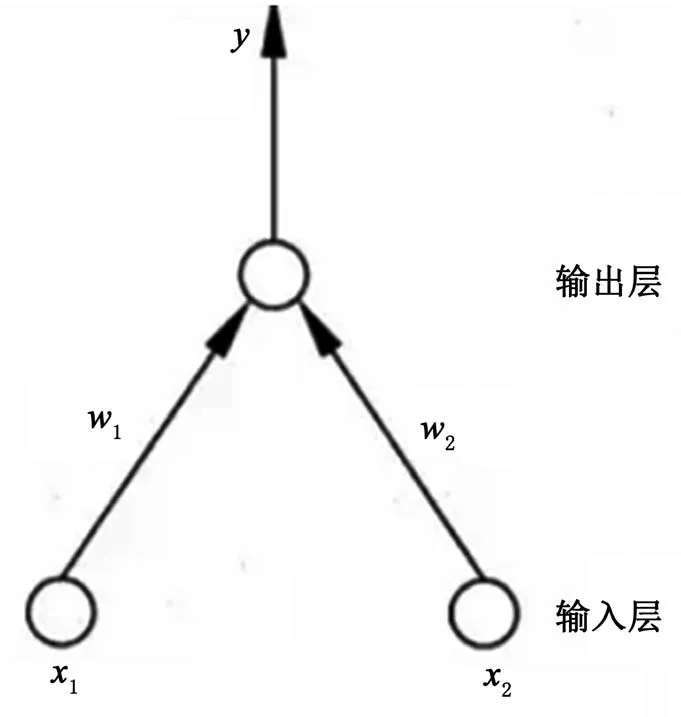

基于人腦設計的深層神經網絡處理中,深度展開多層級人工神經網絡。在信息判定上,借助不斷優化輸入信息權重方法,使得判斷效果整體上更準確。輸入層接收外界輸入信號后傳遞給輸出層,輸出層是M-P神經元,感知機能輕松實現邏輯與或非的運算(與或非實際上是線性可分問題,存在一個超平面將其分開)。其中,感知機和多層網絡結構如圖2所示。

圖2 感知機和多層網絡結構

圖像識別、聲音識別或AlphaGo圍棋學習中,更注重學習過程和算法。多智能、會學習的機器,在實現對字符、人臉、地標等進行幾乎精確的識別中應用預測價值更高。該學習作為深度學習的新浪潮,打造了人工智能新的里程碑,在其他方面具有突出的應用功效。

基于深度學習的圖像識別原理,對遴選的樣本進行數據標注,并為后續數據建模服務提供數據標注依據。在數據標注細節上,通過一定量的已標注數據,在深度學習的大腦中建立模型。模型建成后,一旦再次遇到相似的圖像,深度學習就能根據圖片的一般情況做好相關模型相似度的對比。在建立模型的過程中,以海量大數據為基礎,對其進行精準控制。

2.3 人工智能應用處理系統設計

人工智能技術對電氣設備的優化設計,順利優化了更多、更復雜的計算及模擬,并在傳統手工設計向計算機輔助設計轉型發展的新時期,獲得了更精準、更快速、更迅捷的體驗,也能在產品效率、成本控制方面滿足電氣設備運行設計要求,使得基于深度學習的人工智能技術兼顧經濟效益和社會效益。

以電氣設備優化設計為例,計算機輔助設計可提高對電氣設備設計涉及的電機電器、電磁場、電路等技術手段的效率和質量。永磁直流電動機設計采用等效磁路法,將電機空間內存在的不均勻分布的磁場轉化成等效的多段磁路,并近似認為在每段磁路中磁通沿截面和長度均勻分布,將磁場的計算轉化為磁路計算,然后用各種系數進行修正,使各段磁路的磁位差等于磁場中對應點之間的磁位差。通過積累一定的經驗,取得各種實際的修正系數后,計算精度可以滿足工程實際的需要,然后初步確定磁路結構,酌情選擇表貼凸出式轉子磁路結構和表貼插入式轉子磁路結構。

電氣設備故障診斷中和電氣設備智能控制中,涵蓋神經網絡控制專家、系統控制及模糊控制。學習內容上,自編碼器、卷積神經網絡(Convolutional Neural Networks,CNN)、循環神經網絡(Recurrent Neural Network,RNN)、DBN都涉及很多技術細節,同時模型復雜程度從原來的線性堆疊變成了可以任意堆疊。

深度學習可借助數據中心、臺式電腦、筆記本電腦以及云端等,為世界上速度超快的超級計算機深度學習奠定了基礎。GPU加速數據中心可憑借更少的服務器提供突破性性能,以降低成本。在維護操作安全方面,數據存儲、處理和分析敏感數據更精準。云計算通過實現數據中心的大眾化和轉變企業的運作方式,已經成為各行各業實現變革的關鍵。還可利用全球各大云服務提供商,使用NVIDIA GPU,在存儲于云端的數據中獲取有用的信息。

2.4 應用可行性分析

人工智能應用處理系統可借助視聽覺、味觸覺、平衡感及存儲器等,賦予學習者多樣化選擇,尋求一種合乎邏輯的推測、預演和推演,設計智能生命模型,即獲取外界信息感知系統、選擇性存儲信息的信息處理系統、表達感知的反饋系統(語言反饋、肢體動作反饋……)、清除記憶的遺忘系統、對記憶系統數據進行歸納和總結系統。

3 研究綜述

基于樹莓派平臺,借助Intel的視頻處理器(Video Processing Unit,VPU)低功耗加速模塊,設計并實現了基于殘差特征提取模塊CNN模型的實時人臉檢測系統。對比單純使用樹莓派中央處理器(Central Processing Unit,CPU)進行計算,文中方法在視頻流中檢測人臉和人臉關鍵點提取的實驗中分別實現了18.62倍和17.46倍的加速,使得在便攜式設備中實現快速、實時、在線的人臉檢測和特征點提取成為現實,同時為使用便攜式、低功耗設備運行深度學習算法提供了一種可行的方案[1]。在復合地形下的長期演進(Long Term Evolution,LTE)網絡數據和其他典型數據集下,與傳統的經驗模型和現有的智能無線傳播模型相比,所提模型對各種傳播場景均具有適用性,且進一步減小了路徑損耗的預測誤差。借鑒經驗模型,利用一些修正項,使用頻率覆蓋范圍為1 500~2 000 MHz,得到COST231-Hata模型。與Okumura-Hata模型一樣,COST231-Hata模型以Okumura等人的測試結果為依據,通過對較高頻段的Okumura傳播曲線進行分析求解,在頻段f(1 500~2 000 MHz)、基站天線有效高度hb為30~200 m、移動臺天線高度hm為1~10 m、通信距離為1~20 km等參數設定上取得了顯著效果。智能無線傳播模型進行重新訓練,并部署該智能無線傳播模型,以預測該區域的路徑損耗[2]。一種使用Ray框架來處理自動駕駛任務的遠程分布式計算系統設計方案,克服單一計算平臺的算力限制,為更高級別的自動駕駛提供支持。應用設計后,它可大幅減少自動駕駛任務的處理時間,提高系統吞吐量,保證自動駕駛任務的實時性[3]。利用PYNQ-Z2的處理系統(Processing System, PS)和可編程邏輯(Progarmmable Logic,PL)交互式數據傳輸處理效應,盡可能發揮ARM(Advanced RISC Machines)和現場可編程邏輯門陣列(Field-Programmable Gate Array,FPGA)的優勢,從而實時進行人臉檢測。搭建Linux環境并運行Jupyter Notebook交互式在線編譯器,調用IPython內核和PYNQ的硬件庫,導入OpenCV庫編寫并且編譯執行Python程序,可實現在線控制PYNQ-Z2來獲得視頻流輸入并對視頻數據進行傳輸和處理,從而實現人臉圖像的分析與檢測[4]。基于ROS下的gmapping和move_base等算法,實現巡檢機器人自動建圖及自主導航功能,設計并實現了ROS系統和Node.js之間的通信架構,并基于Vue.js前端框架進行Web監控系統的設計開發,能夠實時查看巡檢機器人的檢測目標,獲取環境信息,并遠程控制巡檢機器人的移動[5]。

4 結語

深度學習的訓練和推理均依賴于圖形處理器(Graphics Processing Unit,GPU)加速,而NVIDIA能夠在任何平臺帶來所需的強勁加速性能。無論是圖像識別還是自然語言處理,性能和效率對于深度學習推理而言都至關重要。在維護操作安全性的同時,它可存儲、處理和分析敏感數據。