融合注意力機(jī)制與混合CNN模型的高光譜圖像分類

王立國,于 佳,石 瑤,楊京輝

(1.哈爾濱工程大學(xué) 信息與通信工程學(xué)院, 黑龍江 哈爾濱 150001; 2. 大連民族大學(xué) 信息與通信工程學(xué)院, 遼寧 大連 116605; 3. 中國地質(zhì)大學(xué)(北京) 信息工程學(xué)院, 北京 100083)

隨著空間遙感技術(shù)地不斷發(fā)展,獲取遙感數(shù)據(jù)的空間分辨率和光譜分辨率不斷提升,隨之產(chǎn)生了高光譜遙感技術(shù)。高光譜遙感又叫成像光譜遙感,是將成像技術(shù)和光譜技術(shù)相結(jié)合的多維信息獲取技術(shù)[1]。自20世紀(jì)80年代以來,高光譜遙感技術(shù)顯現(xiàn)出越來越多的優(yōu)勢(shì),目前已成為對(duì)地觀測(cè)的重要組成部分,也是國際對(duì)地觀測(cè)技術(shù)研究的前沿?zé)狳c(diǎn)。高光譜圖像能夠獲取地表物體上百個(gè)連續(xù)譜段的光譜信息,其譜范圍包含著紫外、可見光、近紅外及中紅外等波段,具有較高的光譜分辨率。隨著遙感技術(shù)的飛速發(fā)展,高光譜圖像的空間分辨率也得到了極大的提升,高光譜數(shù)據(jù)對(duì)于地物的表達(dá)能力也得到增強(qiáng)。利用高光譜數(shù)據(jù)圖譜合一且波段覆蓋范圍廣的特性,能夠大大地提高其地物類別的分辨識(shí)別能力[2],使得高光譜遙感技術(shù)被廣泛地應(yīng)用到精細(xì)化農(nóng)業(yè)[3-4]、軍事[5]、環(huán)境監(jiān)控[6]等方面。

過去30年間,高光譜遙感技術(shù)自提出以來得到了迅猛的發(fā)展,同時(shí)高光譜圖像處理與信息提取技術(shù)也在不斷取得新的突破。高光譜圖像處理與信息提取技術(shù)的研究主要包括數(shù)據(jù)降維、圖像分類、混合像元分解和目標(biāo)探測(cè)等方向[7]。分類是高光譜遙感影像處理和應(yīng)用的一項(xiàng)重要內(nèi)容,其最終目標(biāo)是給影像中的每個(gè)像元賦以唯一的類別標(biāo)識(shí)。然而,高光譜遙感影像的高維特性、波段間高度相關(guān)性、光譜混合等使得高光譜遙感影像分類面臨巨大挑戰(zhàn)[8]。

針對(duì)高光譜圖像分類,從原始的目視解譯方法到根據(jù)海量遙感影像分類問題引入的模式識(shí)別方法如最大似然法、最小距離、KNN算法等,再到后來針對(duì)大量細(xì)節(jié)信息和光譜復(fù)雜化引入的ANN、SVM[9]、遺傳算法和面向?qū)ο蟮人惴ǎ梢钥闯雠c日俱增的海量遙感影像推動(dòng)著遙感圖像處理算法的進(jìn)步。近年來,深度學(xué)習(xí)作為一種強(qiáng)大的特征提取技術(shù),在許多領(lǐng)域都取得了重大突破[10],很多深度學(xué)習(xí)的模型,包括卷積神經(jīng)網(wǎng)絡(luò)、棧式自編碼網(wǎng)絡(luò)以及深度置信網(wǎng)絡(luò)等也被逐漸引入高光譜圖像分類領(lǐng)域[11],眾多研究都取得不小的成果。

在基于深度學(xué)習(xí)的高光譜圖像分類算法研究中,有一些網(wǎng)絡(luò)使用二維卷積(2D-CNN),有一些網(wǎng)絡(luò)使用三維卷積(3D-CNN)。二維卷積(2D-CNN)可以有效提取高光譜圖像的空間特征。文獻(xiàn)[12] 通過消除特征間的相關(guān)性并降低特征維數(shù)來獲得清晰的空間結(jié)構(gòu),然后利用二維卷積神經(jīng)網(wǎng)絡(luò)對(duì)輸入的樣本進(jìn)行空間特征提取,取得了不錯(cuò)的高光譜圖像分類效果,其優(yōu)點(diǎn)是模型比較簡(jiǎn)單,需要的運(yùn)算量較低,但不能提取高光譜圖像的光譜特征。相比之下,三維卷積(3D-CNN)可以同時(shí)提取高光譜圖像的光譜特征和空間特征。文獻(xiàn) [13] 基于3D-CNN設(shè)計(jì)了三種FE(Feature Extraction) 結(jié)構(gòu),能夠有效提取空-譜特征,提高了高光譜圖象的分類效果,其優(yōu)點(diǎn)在于捕獲光譜特征后可以提升圖像分類的準(zhǔn)確率,但是其數(shù)據(jù)計(jì)算量更大更復(fù)雜,且對(duì)特征的表現(xiàn)能力較差。

針對(duì)現(xiàn)有2D-CNN和3D-CNN分類方法的不足,本文提出一種新的分類算法,將高光譜圖像中的空間和光譜的互補(bǔ)信息分別以3D-CNN和2D-CNN層組合到一起,從而充分利用了光譜和空間特征圖,且避免了模型過于復(fù)雜的缺點(diǎn);同時(shí)還在算法中引入注意力機(jī)制,進(jìn)一步提升算法的分類性能。

1 混合CNN模型

1.1 三維卷積(3D-CNN)模型

(1)

式中:φ是激活函數(shù);是第j個(gè)特征圖的i層的偏差參數(shù);是第(l-1)層特征圖的數(shù)量和第i層j個(gè)特征圖的數(shù)量;2γ+ 1是卷積核的寬度;2δ+1 是卷積核的高度;2η+1為卷積核沿光譜維數(shù)的深度wi,j為第i層j個(gè)特征圖權(quán)重指數(shù)的值。

1.2 二維卷積(2D-CNN)模型

1.3 混合CNN模型

本文提出一種混合CNN模型,在網(wǎng)絡(luò)結(jié)構(gòu)中先使用三維卷積,再堆疊二維卷積,最后連接分類器,因此既發(fā)揮三維卷積的優(yōu)勢(shì),充分提取光譜-空間特征,也避免了完全使用三維卷積而導(dǎo)致的模型復(fù)雜的情況,其結(jié)構(gòu)圖如圖1。

圖1 混合CNN模型示意圖

2 注意力機(jī)制模塊

2.1 注意力機(jī)制模塊

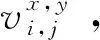

本文算法融合混合CNN模型與注意力機(jī)制,通過改變?cè)继卣鞯臋?quán)重,加強(qiáng)核心貢獻(xiàn)減弱次要貢獻(xiàn)。在三維卷積和二維卷積之后,結(jié)合空間和通道的注意力機(jī)制模塊,可以同時(shí)調(diào)整通道維度和空間維度的注意力。利用殘差網(wǎng)絡(luò)的思想,將原始特征與經(jīng)過注意力機(jī)制處理后的特征進(jìn)行卷積,從而進(jìn)一步提升算法的分類性能,其結(jié)構(gòu)圖如圖2。

圖2 注意力機(jī)制模塊示意圖

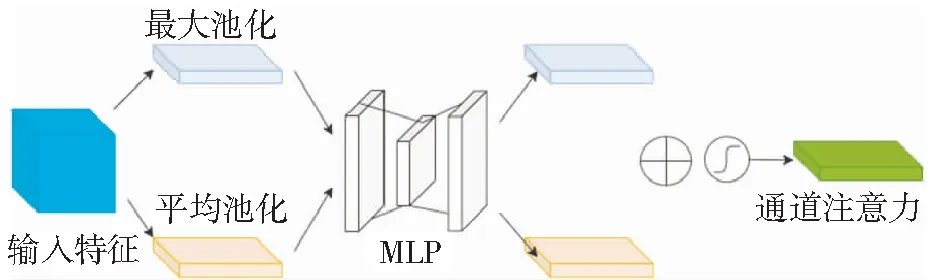

2.2 通道注意力模塊

為了有效計(jì)算通道注意力,需要對(duì)輸入特征圖的空間維度進(jìn)行壓縮,模塊中同時(shí)使用平均池化與最大池化操作,其公式為

Mc(F)=σ(MLP(AvgPool(F))+MLP(MaxPool(F)))

(3)

圖3 通道注意力模塊示意圖

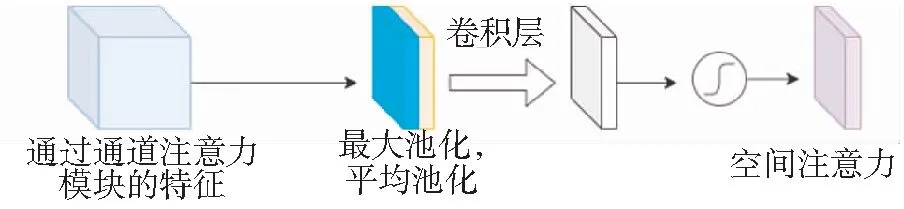

2.3 空間注意力模塊

將通道注意力模塊輸出的特征圖作為本模塊的輸入特征圖。首先做一個(gè)基于通道的最大池化和平均池化,然后將產(chǎn)生的兩個(gè)結(jié)果經(jīng)過一個(gè)卷積操作,降維為1個(gè)通道。再經(jīng)過sigmoid函數(shù)生成空間注意力特征圖。最后將該特征和該模塊的輸入特征做乘法,得到最終生成的特征。其公式為

Ms(F)=σ(f7×7([AvgPool(F);MaxPool(F)]))

(4)

其結(jié)構(gòu)圖如圖4。

圖4 空間注意力模塊示意圖

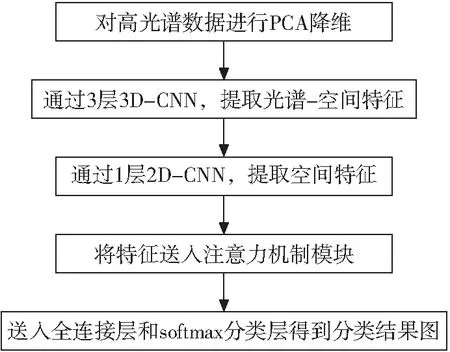

3 本文分類方法

首先利用主成分分析(PCA)進(jìn)行降維,減少三維數(shù)據(jù)的一些光譜波段,只保留了對(duì)識(shí)別物體重要的空間信息;隨后將數(shù)據(jù)劃分為重疊的三維小塊;之后將數(shù)據(jù)通過3層3D-CNN,獲取光譜維度和圖像間的特征;再通過1層2D-CNN,獲取圖像本身的特征;將上述獲得的特征通過注意力機(jī)制模塊,最后送入全連接層和softmax層進(jìn)行分類。本方法利用混合CNN模型結(jié)合注意力機(jī)制,既發(fā)揮較好的分類效果,又避免了模型過于復(fù)雜的情況,提高模型訓(xùn)練速度,具體流程如圖5。

圖5 本文分類方法流程

4 實(shí)驗(yàn)仿真與分析

4.1 實(shí)驗(yàn)數(shù)據(jù)

實(shí)驗(yàn)采用2個(gè)數(shù)據(jù)集驗(yàn)證算法的有效性,分別為Indiana Pines數(shù)據(jù)集和Salinas Scene數(shù)據(jù)集。Indiana Pines數(shù)據(jù)集的圖像像素為145×145,光譜波段個(gè)數(shù)為224個(gè),波長(zhǎng)范圍為450~2500 nm;Salinas Scene數(shù)據(jù)集的圖像像素為512×217,光譜波段個(gè)數(shù)為224個(gè),波長(zhǎng)范圍為360~2500 nm。

4.2 實(shí)驗(yàn)條件及評(píng)價(jià)指標(biāo)

本文實(shí)驗(yàn)的計(jì)算機(jī)具體配置為Intel(R) Core(TM) i5-9300H CPU、16GB運(yùn)行內(nèi)存、NVIDIA Geforce GTX 1660Ti顯卡,6GB顯存。軟件環(huán)境為在64位Windows10操作系統(tǒng)下的Python 3.7和pytorch-gpu-1.8.1。評(píng)價(jià)指標(biāo)選取為總體分類精度OA、平均分類精度AA和Kappa系數(shù)。

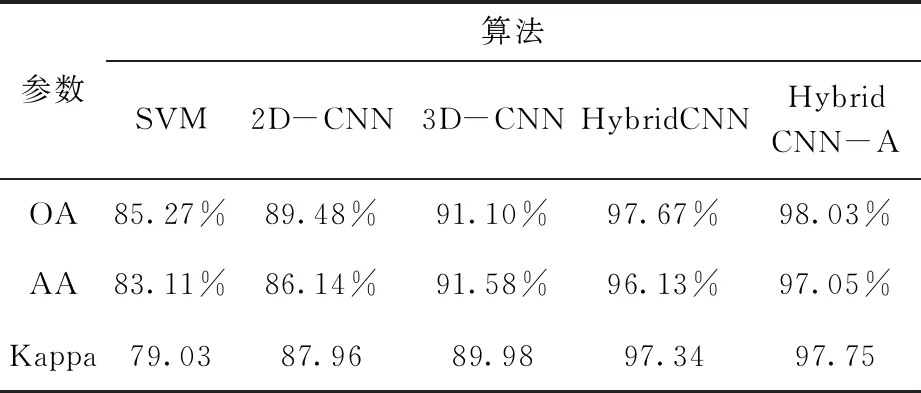

將本文算法與其他方法進(jìn)行對(duì)比,以證明本方法的有效性和可行性。第一種方法是利用標(biāo)準(zhǔn)支持向量機(jī)算法SVM進(jìn)行分類;第二種方法是僅采用二維卷積算法進(jìn)行分類,稱其為2D-CNN算法;第三種算法是僅采用三維卷積算法進(jìn)行分類,稱其為3D-CNN算法;第四種方法是采用融合卷積算法進(jìn)行分類,稱其為HybridCNN算法;第五種方法即為利用本文所述,融合二維卷積和三維卷積后,再級(jí)聯(lián)注意力機(jī)制的方法,稱其為HybridCNN-A算法。評(píng)價(jià)指標(biāo)選取為總體分類精度OA、平均分類精度AA和Kappa系數(shù)。

4.3 實(shí)驗(yàn)結(jié)果及分析

在Indian pines數(shù)據(jù)集上進(jìn)行試驗(yàn)驗(yàn)證本文算法,每類訓(xùn)練樣本與測(cè)試樣本的選擇策略為選擇15個(gè)已知類別的有標(biāo)記樣本,訓(xùn)練樣本數(shù)目是總樣本數(shù)目的5%,其他樣本均為未標(biāo)記樣本即測(cè)試樣本。

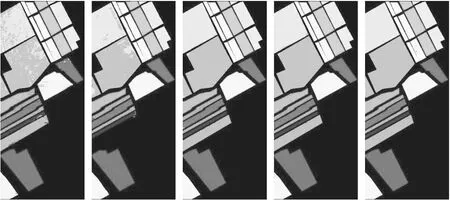

圖6以視覺圖的形式直觀展示出Indian pines數(shù)據(jù)集上,SVM、2D-CNN、3D-CNN、HybridCNN和HybridCNN-A算法的實(shí)驗(yàn)分類結(jié)果。從幾種算法的分類結(jié)果可看出,本文方法相較于其他4種對(duì)比算法,輪廓更為規(guī)整,分類效果更明顯。

a)SVM b)2D-CNN c)3D-CNN d)HybridCNN e)HybridCNN-A

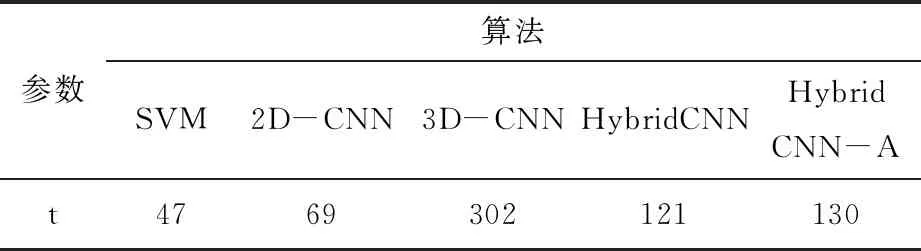

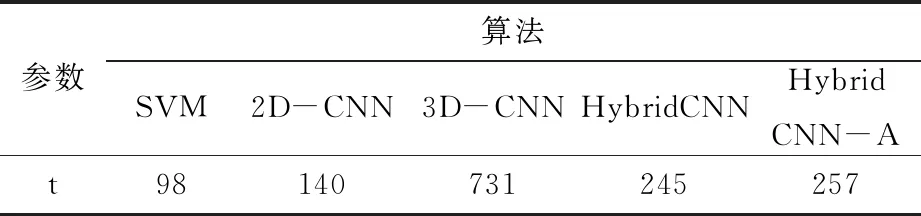

5種不同算法在Indian pines數(shù)據(jù)集的分類性能優(yōu)越性可由表1展示的評(píng)判參數(shù)(總體分類精度OA、平均分類精度AA和Kappa系數(shù))對(duì)比得出。不同算法的運(yùn)行時(shí)間見表2。從橫向比較可以得出,HybridCNN和HybridCNN-A算法的分類效果明顯優(yōu)于其他三種算法,且運(yùn)算速率相較于3D-CNN算法有了明顯的提升。此外,從表1和表2觀察得出,HybridCNN-A算法雖然在時(shí)間上略遜于HybridCNN算法,但無論是在OA還是AA、Kappa系數(shù)都比其他4種算法要好。本文提出的算法融合二維卷積和三維卷積后,進(jìn)一步級(jí)聯(lián)注意力模塊,改變?cè)继卣鞯臋?quán)重,加強(qiáng)核心貢獻(xiàn)減弱次要貢獻(xiàn)以提升分類效果。由此可見,本文算法與其他4種對(duì)比算法相比較,展示了更好的分類效能同時(shí)保證了優(yōu)秀的運(yùn)算效率。

表1 Indian pines 高光譜圖像分類結(jié)果

表2 Indian pines 不同算法的運(yùn)算速度比較

在Salinas scene數(shù)據(jù)集上進(jìn)行試驗(yàn)驗(yàn)證本文算法,每類訓(xùn)練樣本與測(cè)試樣本的選擇策略為選擇15個(gè)已知類別的有標(biāo)記樣本,訓(xùn)練樣本數(shù)目是總樣本數(shù)目的5%,其他樣本均為未標(biāo)記樣本即測(cè)試樣本。

以視覺圖的形式直觀展示出Salinas scene數(shù)據(jù)集上,SVM、2D-CNN、3D-CNN、HybridCNN和HybridCNN-A算法的實(shí)驗(yàn)分類結(jié)果如圖7。

a)SVM b)2D-CNN c)3D-CNN d)Hybrid CNN e)Hybrid CNN-A

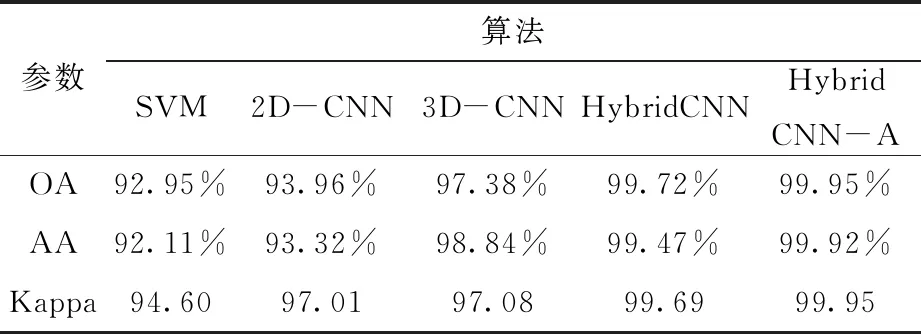

5種不同算法在Salinas scene數(shù)據(jù)集的分類性能優(yōu)越性可由表3展示的評(píng)判參數(shù)(總體分類精度OA、平均分類精度AA和Kappa系數(shù))對(duì)比得出。不同算法的運(yùn)行時(shí)間見表4。

表3 Salinas scene高光譜圖像分類結(jié)果

表4 Salinas scene不同算法的運(yùn)算速度比較

5 結(jié) 語

本文提出了一種融合注意力機(jī)制與混合CNN模型的高光譜圖像分類算法。融合了三維卷積和二維卷積,在保證分類效果的同時(shí),提升了算法的運(yùn)算效率,并且本文算法結(jié)合了注意力模塊,通過改變?cè)继卣鞯臋?quán)重,加強(qiáng)核心貢獻(xiàn)減弱次要貢獻(xiàn),進(jìn)一步提升高光譜圖像的分類效果。實(shí)驗(yàn)結(jié)果顯示,本文算法在兩個(gè)開源數(shù)據(jù)集Indian pines和Salina scene上,總體分類精度OA、平均分類精度AA以及Kappa系數(shù),都取得了幾種對(duì)比算法中最佳的結(jié)果,證明了本文算法的可行性和有效性。

本文算法雖然有效結(jié)合了二維卷積和三維卷積,并通過引入注意力機(jī)制的方式有效提升了高光譜圖像的分類精度,但因目前僅在二維卷積層后增加基于空間和通道的注意力機(jī)制,因此如何進(jìn)一步提升分類準(zhǔn)確率,并優(yōu)化分類圖的視覺效果,仍需要進(jìn)一步的研究。