基于CNN 的乳腺癌病理圖像分類研究

易才鍵, 陳 俊, 王師瑋

(福州大學 物理與信息工程學院, 福州 350108)

0 引 言

據世界衛生組織國際癌癥研究機構(IARC)2020 年發布的研究數據顯示,乳腺癌正式取代肺癌,成為全球第一大癌癥。 其中,女性癌癥患者中乳腺癌的占比最高,遠超其他癌癥類型。 目前對乳腺癌的診斷主要是依靠組織病理學分析,乳腺癌的最終診斷,包括分級和分期,大都由病理學家對組織病理圖像進行分析得到,因此這是診斷乳腺癌的金標準。

隨著計算機技術的發展,已有許多學者嘗試將計算機輔助診斷(CAD)應用在乳腺癌病理圖像的自動分類中,并取得了一系列的研究進展。 在傳統機器學習領域中,自動診斷的方法主要是基于人工的特征提取,結合分類器實現的。 Roy 等人設計了特征提取器,提取了紋理和統計特征,將這些特征組合起來,生成一個包含782 個特征的數據集,通過使用多種分類器進行訓練和分類,得到的最優識別率為92.55%;Spanhol 等人公開了BreakHis 數據集,并基于此數據集,使用了6 種不同的特征提取器,并為每個特征提取器結合了4 種分類器,最終的識別準確率為80%-85%。 但基于人工的特征提取不僅需要耗費大量的時間和精力,還要求特征提取人員具有相應的專業領域知識。 此外,特征提取人員的經驗和精神狀態都會影響到特征提取的質量,嚴重影響了計算機輔助診斷技術在實際中的應用。

近年來,隨著計算機運算能力和人工智能的快速發展,深度學習技術在許多領域得以應用,尤其在圖像處理方面取得了很大的進展。 利用深度學習技術可以自動的從圖像中提取特征,避免了傳統機器學習中人工提取特征的局限性,節省了人力。如今已有很多的學者將深度學習技術應用在乳腺癌診斷中,在一定程度上提高了乳腺癌診斷的準確性。Spanhol 等人在BreaKHis 數據集上應用AlexNet網絡,得到的識別率比傳統機器學習算法高出6%;Nawaz 等人使用DenseNet CNN 模型對乳腺腫瘤的亞型進行預測,準確率達到95.4%;鄒文凱等人對GoogleNet 中的Inception 結構進行調整,并采用所有放大倍數統一訓練、獨立測試的方法,以患者級別作為評價標準,其準確率為87%-90%。 上述方法雖然已經具有一定的準確率,但還需進一步提高識別的準確率和模型的魯棒性。

針對上述問題,本文以VGG16 網絡為基礎,對網絡結構進行調整,同時結合數據增強和遷移學習策略,在公開的BreakHis 數據集上進行訓練,訓練得到的模型將用作于乳腺癌病理圖像的良惡性分類;為解決數據集存在的樣本不均衡問題,本文使用焦點損失函數(Focal Loss)作為實驗的損失函數,能在一定程度上緩解樣本不均衡問題;對4 種不同放大倍數的圖像統一訓練,讓網絡能夠學習到更深層次、更復雜的特征,提高模型的魯棒性,在測試時則對不同放大倍數的圖像進行獨立測試,更好地模擬實際應用場景中的乳腺癌病理圖像分類。

1 本文方法

1.1 卷積神經網絡

在2012 年的ImageNet 圖像分類競賽上,AlexNet 網絡強勢奪冠,該網絡的分類效果遠超當時的其他模型,深度學習技術從此受到廣泛的關注。與傳統的機器學習方法相比,深度學習的優勢在于不需要人為的提取特征,而是依靠神經網絡本身去學習樣本的特征,提高了特征提取的便利和準確性。

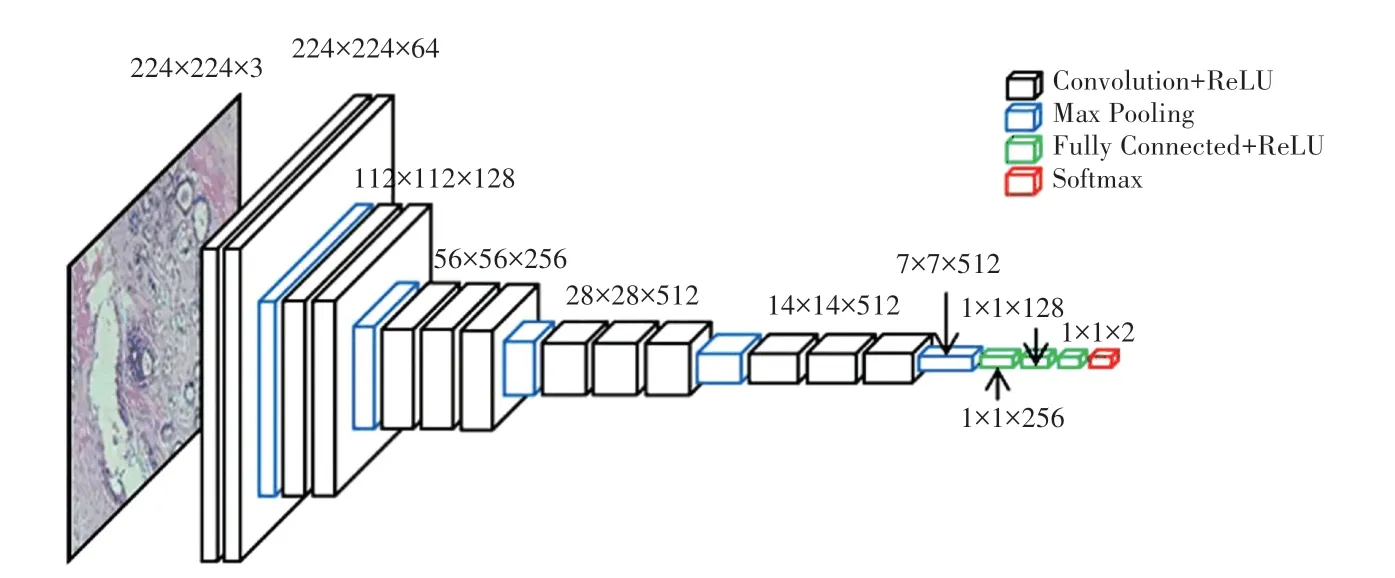

卷積神經網絡(Convolutional Neural Network,CNN)作為最常用的深度學習模型之一,在圖像處理領域表現優異,本文使用CNN 來構造圖像分類模型。 CNN 通常由輸入層、卷積層、池化層和全連接層組成,如圖1 所示。 將2D 或3D 圖像輸入,由卷積層提取圖像的特征,池化層對提取到的特征進行降維、壓縮數據和參數的數量。 經過一系列的卷積和池化操作,CNN 可以同時學習到數據的低層特征和高層特征,在全連接層得到易被網絡區分的特征,便于后續的分類。

相較于傳統的神經網絡,CNN 具有兩大優勢:局部連接和權值共享。 局部連接是相對于全連接而言的,全連接是指網絡中的每個結點都相連,而局部連接則是部分結點相連。 實際處理過程中,圖像的像素點通常與臨近的像素點關聯較大,與遠處的像素點關聯較小,局部連接可以形成具有高區分性的局部特征。 權值共享是指使用同一卷積核對整幅圖像進行卷積運算,可以減少運算時的參數量,加快運算速度。

圖1 卷積神經網絡典型結構Fig. 1 Typical structure of convolutional neural network

1.2 遷移學習

遷移學習是將從一個任務訓練得到的模型移植到其他任務上。 目前,遷移學習方法主要有實例遷移、特征遷移、共享參數遷移和關系知識遷移。本文采用參數遷移方法,用已經在其他數據集(源域)上訓練好的模型來初始化本文的網絡,之后在本文使用的數據集(目標域)上重新訓練,對網絡的參數進行調整。 卷積神經網絡在開始訓練時,是隨機初始化每個參數的,如果此時訓練的數據量較小,容易導致模型無法學習到數據的規律,進而影響模型的性能。 借助遷移學習技術,可以在一定程度上縮短訓練時間,有效的抑制欠擬合和過擬合現象,提高模型的泛化性能。

ImageNet 數據集是一個用于計算機視覺的大型可視化數據集,該數據集有超過1 000 萬幅的自然圖像,共1 000 個類別的手動標注。 本文將ImageNet 數據集作為源域,先將網絡模型在該數據集上訓練,訓練得到的模型參數用作本文數據集訓練時網絡的初始化。 考慮到自然圖像和醫學圖像存在的差異,本文僅將源域的模型參數用作網絡初始化,且構造新的全連接層,在BreakHis 數據集上對網絡層的所有參數進行新的訓練和調整。

1.3 VGG16 網絡

VGG 網絡是由牛津大學計算機視覺組(Visual Geometry Group)和Google DeepMind 公司的研究員一起研發的,該網絡取得了ILSVRC2014 比賽分類項目的第二名,具有良好的特征提取能力。 本文以經典的VGG16 網絡為基礎,對網絡的全連接層進行調整,調整后的網絡結構如圖2 所示。

圖2 調整后的VGG 網絡結構Fig. 2 Adjusted structure of VGG network

網絡的輸入采用224×224 的RGB 彩色圖像,共包含13 個卷積層,5 個最大池化層以及3 個全連接層。 3 個全連接層對應的神經元節點個數調整為256,128,2,原網絡的全連接層神經元節點個數為4 096,4 096,1 000。 調整后的VGG16 網絡具有以下特點:

(1)使用小尺寸的卷積核,以3×3 大小的卷積核為主。 相較于5×5 或7×7 的大尺寸卷積核,小尺寸的卷積核不但計算量小,而且更能提取到圖像的細節信息;

(2)全連接層神經元的個數較少,由于卷積神經網絡的大部分參數量都集中在全連接層,對全連接層的維度進行壓縮,可以輕量化模型,降低過擬合的風險。

深度學習算法的缺點是網絡訓練困難,通常要消耗較多的時間,且利用梯度下降法容易陷入到局部最優解。 為了解決這些問題,本文將批量歸一化(BN)算法加入到網絡中,來縮小每個訓練批次間的分布差距,加快網絡訓練速度。 BN 算法的公式(1)和公式(2):

綜上所述,本文使用網絡參數量少,訓練速度快,分類性能優秀,用該網絡對BreakHis 乳腺癌組織病理圖像數據集進行訓練和分類,取得了良好的效果。

2 數據集

2.1 數據集來源

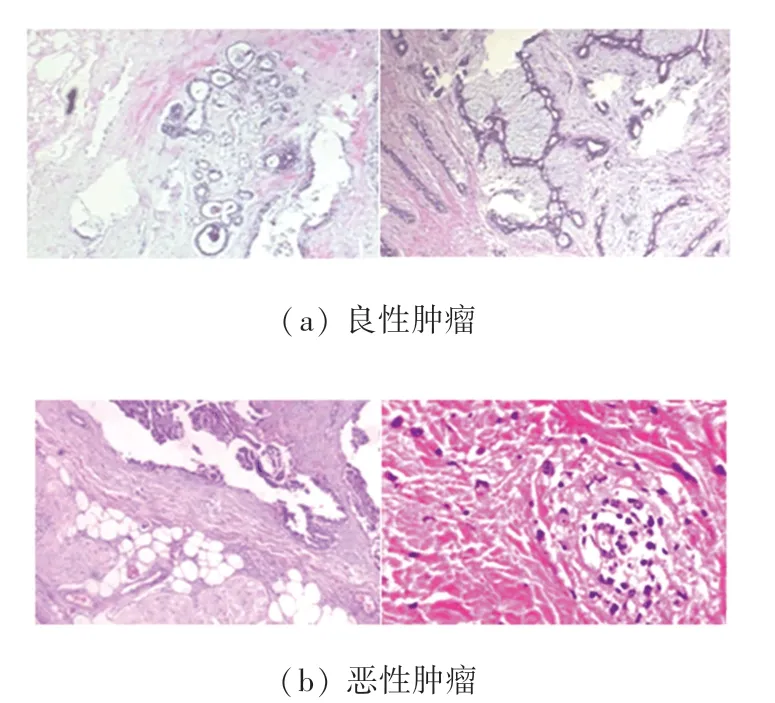

本文采用公開的數據集BreakHis,該數據集包含來自于82 位患者的7 909 幅已標注的乳腺癌組織病理圖像,其中良性腫瘤圖像2 480 幅,惡性腫瘤圖像5 429 幅。 每幅病理圖像均采用4 種不同的放大倍數(40X、100X、200X、400X),大小均為700×460的R、G、B 三通道圖像。 BreakHis 數據集的部分圖像如圖3 所示;該數據集的具體分布情況見表1。

圖3 數據集部分圖像Fig. 3 Partial image of data set

表1 不同放大倍數的良、惡性腫瘤圖像分布Tab. 1 Image distribution of benign and malignant tumors with different magnification

2.2 數據增強

BreakHis 數據集僅有7 909 幅乳腺癌病理圖像,這對于神經網絡的訓練來說是遠遠不夠的,因此需要利用數據增強來增加訓練數據,降低模型過擬合的風險,提高模型的泛化性能。 常用的數據增強方法包括:翻轉、旋轉、裁剪、平移、高斯噪聲,模糊等。

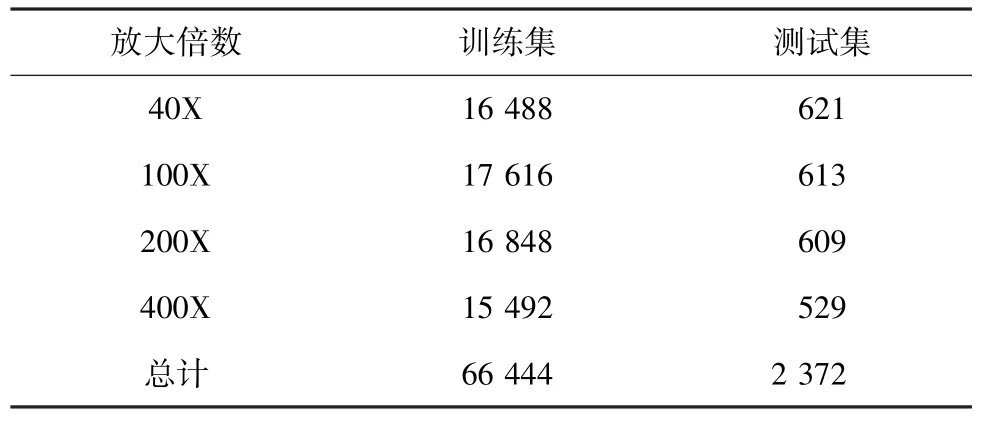

本文按照7:3 的比例將原數據集劃分為訓練集和測試集,且僅對訓練集的數據進行6 種方式的數據增強。 首先,將訓練集數據進行水平翻轉、垂直翻轉、逆時針旋轉90°、180°、270°共5 種操作,將數據擴充至原來的6 倍;再對上述圖像按照0.8 的比例縮放。 經過這6 種方式的變換,訓練集數據擴充至原來的12 倍,其中訓練集圖像66 444 張,測試集圖像2 372 張。 擴充后的數據集的分布情況見表2。

表2 數據增強后的圖像分布情況Tab. 2 Image distribution after data enhancement

3 實驗及結果分析

本文的實驗基于開源的深度學習框架Pytorch,CPU 型號為IntelCore i7-9000K,內存為16 GB,顯卡型號為NVIDIA GeForce RTX 2080 Ti。

3.1 訓練策略

為了更好地訓練分類模型,本文模型的參數通過遷移學習策略進行初始化。 在實驗過程中,將所有訓練數據的尺寸統一為224×224×3,然后分為小批次訓練,每個小批次包含32 幅圖像。 采用Adam 作為本次實驗的優化器,在訓練過程中自動調整學習率,提高模型分類的準確率,本次Adam 優化器的參數均采用默認參數,使用函數作為激活函數。

3.2 焦點損失函數

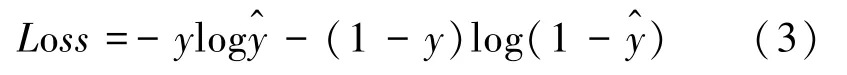

通常在分類任務中,會使用交叉熵函數作為損失函數,以二分類為例,二分類交叉熵(Binary CrossEntropy,BCE)的公式(3)為:

其中,代表損失值;為病理標簽,=0 代表良性,=1 為惡性;^∈(0,1)為神經網絡輸出的預測值。

交叉熵函數雖然有著廣泛的應用,但也存在明顯的缺陷,即交叉熵函數會受到簡單易分類樣本的影響,導致訓練過程中偏離正確的優化方向,對分類效果產生一定的影響。 從表1 可知,BreakHis 數據集存在樣本類別不均衡問題,經過數據增強后,訓練集中的良、惡性腫瘤圖像數量分別為20 856 和45 588張,兩種類別的圖像數量差距明顯,故采用焦點損失函數代替二分類交叉熵函數,其公式(4)為:

實驗結果表明,引入焦點損失函數能夠在一定程度上緩解類別不均衡問題,提高模型的分類效果。

3.3 評價標準

醫學圖像的分類通常可以從兩個方面評價模型的分類性能:患者級別和圖像級別。

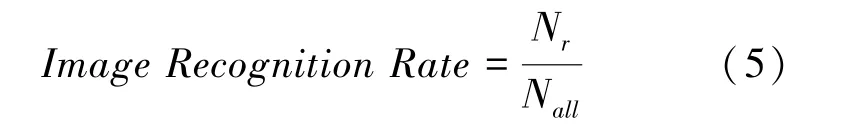

本文不考慮患者級別,僅從圖像級別來計算識別準確率,則圖像級別的識別率可表示為公式(5):

其中,N代表測試集中病理圖像總的數量,N代表被正確分類的圖像數量。

3.4 實驗對比分析

3.4.1 不同損失函數下的準確率對比

2) 配置連接核心交換機CS6509的端口屬性Switch Port Configuration→Port Groping Parameters,設置所屬的端口組為student1,啟用端口聚合協議PAgP(Port Aggregation Protocol),端口模式采用desirable模式[15].

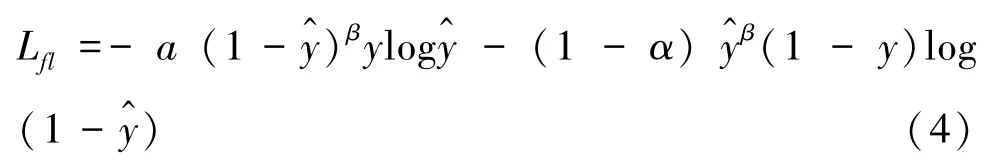

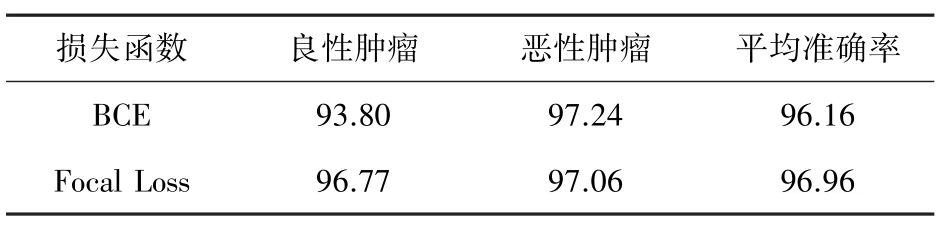

本次實驗將焦點損失函數(Focal Loss)與分類任務中應用廣泛的二分類交叉熵(BCE)對比,分別使用這兩種函數作為訓練過程中的損失函數,實驗結果見表3。 從表3 可以看出:

(1)Focal Loss 作為損失函數時,良惡性腫瘤的分類準確率僅相差0.29%;而使用BCE 的情況下,相差3.44%,此時模型對于較多樣本(惡性腫瘤)產生了傾向性,不利于對腫瘤的診斷;

(2)使用Focal Loss 時,雖然對惡性腫瘤的分類準確率略低于使用BCE 的情況,但對于良性腫瘤的分類準確率卻得到了很大的提升,這樣的模型更接近實際生活,具有更強的魯棒性;

(3)模型的平均準確率有所提高。

表3 不同損失函數下的準確率對比Tab. 3 Comparison of accuracy with different loss functions

3.4.2 不同訓練策略下的準確率對比

使用不同的訓練策略,共進行4 次實驗,實驗均采用Focal Loss 作為損失函數。 這4 種策略分別是數據增強結合遷移學習策略、數據增強策略、遷移學習策略、無數據增強和遷移學習策略,結果為網絡迭代10 000次過程中的最佳模型在測試集上的準確率,如圖4 所示。

圖4 4 種訓練策略下的準確率Fig. 4 Accuracy under four training strategies

由圖4 可知,采用遷移學習策略,無論是否進行數據增強,準確率都得到了大幅度的提升(圖4 中紅色和藍色曲線對比),證實了遷移學習策略的有效性;采用數據增強策略后,無論是否使用遷移學習對網絡進行初始化,訓練的準確率都得到了一些提升(見圖4 中紅色和綠色曲線對比),證實了數據增強策略的有效性。 實驗表明,本文采用有效的訓練策略防止了訓練過程中過擬合的現象,并大大的提高了模型的泛化能力,在BreakHis 數據集上的識別率為94%-98%。

3.4.3 與其他的分類方法對比

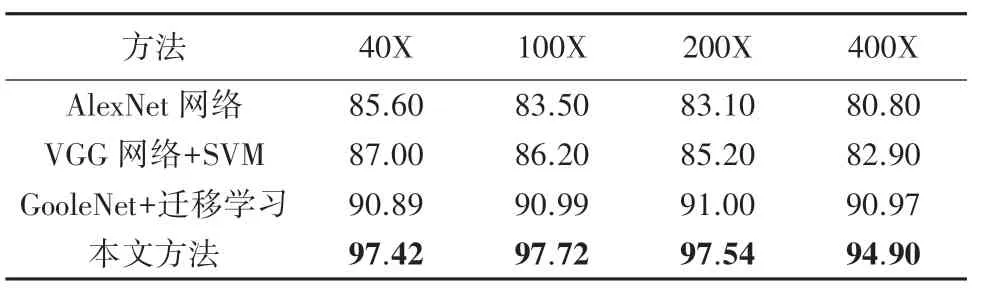

為了更好的評價本文的模型,本文選擇與應用在同一數據集BreakHis 上的其他分類方法進行對比,這些方法采用與本文相同的評價標準,即以圖像級別的識別率作為評價標準,見表4。 通過與其他分類方法的對比可知,本文方法在4 種不同放大倍數下的識別準確率均高于其他的分類方法,表明了本文訓練策略的有效性及本文深度學習模型的魯棒性。

表4 不同放大倍數下各方法識別準確率的對比Tab. 4 Comparison of recognition accuracy of various methods with different magnifications

4 結束語

為解決傳統機器學習在病理圖像分類任務中存在的不足,提高乳腺癌病理圖像的分類準確率,本文提出了基于CNN 的乳腺癌病理圖像分類模型。 在公開的BreakHis 數據集上進行訓練與參數優化,最終在4 種放大倍數下的平均識別率達到96.96%,其中40X、100X 和200X 倍數下的識別率均超過97%,展現出了優秀的分類能力;為解決醫學圖像數據集較少的問題,本文采用遷移學習和數據增強策略,利用遷移學習初始化網絡,同時將數據集擴充至原有的12 倍,避免了過擬合現象的發生;為解決BreakHis 數據集存在的類別不均衡問題,本文采用焦點損失函數代替傳統的交叉熵函數。 通過多個對比實驗,驗證了本文模型的優異性和訓練策略的有效性,能夠為早期發現和診斷乳腺癌提供有力指導。