結合頭部和整體信息的多特征融合行人檢測

陳 勇 謝文陽 劉煥淋 汪 波 黃美永

①(重慶郵電大學工業物聯網與網絡化控制教育部重點實驗室 重慶 400065)

②(重慶郵電大學通信與信息工程學院 重慶 400065)

1 引言

行人檢測與行人重識別技術、目標跟蹤技術等相結合在自動駕駛、視頻監控等領域中有廣泛的應用[1–4]。然而實際檢測中行人容易產生遮擋、重疊等問題,并且行人距離的遠近會導致行人尺度產生較大變化,這些問題嚴重影響了行人檢測的準確率[5]。

目前卷積神經網絡廣泛應用于行人檢測,其中以Faster R-CNN[6]為代表的兩階段檢測器和以RetinaNet[7]為代表的單階段檢測器取得了較好的效果。李春偉等人[8]采用多個卷積層的輸出進行檢測從而降低尺度造成的影響;Lin等人[9]提出特征金字塔的概念并構建了FPN (Feature Pyramid Network),該方法逐漸成為解決尺度變化問題的主要手段[10,11]。針對行人檢測中的遮擋問題,Zhang等人[12]提出聚合損失函數使候選框靠近真實邊界框以此降低類內遮擋造成的影響;Du等人[13]通過在網絡中添加額外的行人特征掩模減少背景像素的干擾;Fei等人[14]通過引入更豐富的上下文信息減少遮擋造成的干擾;Liu等人[15]考慮行人的標注方式,使用預測目標中心點及尺度的方式有效提升了檢測準確性,同時該方法可有效減少類內遮擋造成的漏檢。Liu等人[16]通過添加密集程度檢測模塊為非極大值抑制提供更合理的篩選條件,有效提升了密集場景下行人檢測的準確性。綜上所述,上述方法從多個角度入手解決目標遮擋與尺度過小造成的檢測準確性降低的問題,但卻忽視了一個重要的方面,即行人的頭部往往不易產生類內遮擋,即使軀干部分由于部分遮擋而無法被檢測,但此時行人的頭部特征依然明顯,而該信息對于行人而言尤為重要,如Xu等人[17]便利用頭部信息提升行人跟蹤的準確性。此外,大多數方法僅使用主干網絡最后3層卷積層的輸出進行特征融合,而小尺度目標往往在卷積層的較淺層擁有較高激活程度。

針對以上問題,本文構建了一種結合頭部和整體信息的行人檢測模型。受文獻[18]的啟發在行人檢測的基礎上添加行人頭部檢測分支,并利用CrowdHuman[19]數據集自帶的行人頭部標簽對模型進行訓練;考慮到使用矩形邊界框標注行人會引入大量背景像素,因此本文參照文獻[15]采用中心點對行人頭部和整體進行標注;兩個檢測分支采用不同深度卷積層的輸出進行特征融合,從而提供有針對性的特征信息;同時,本文對非極大值抑制算法進行改進,通過添加行人頭部的相關判斷條件,使行人頭部信息和行人整體信息能較好的結合。

2 算法原理設計

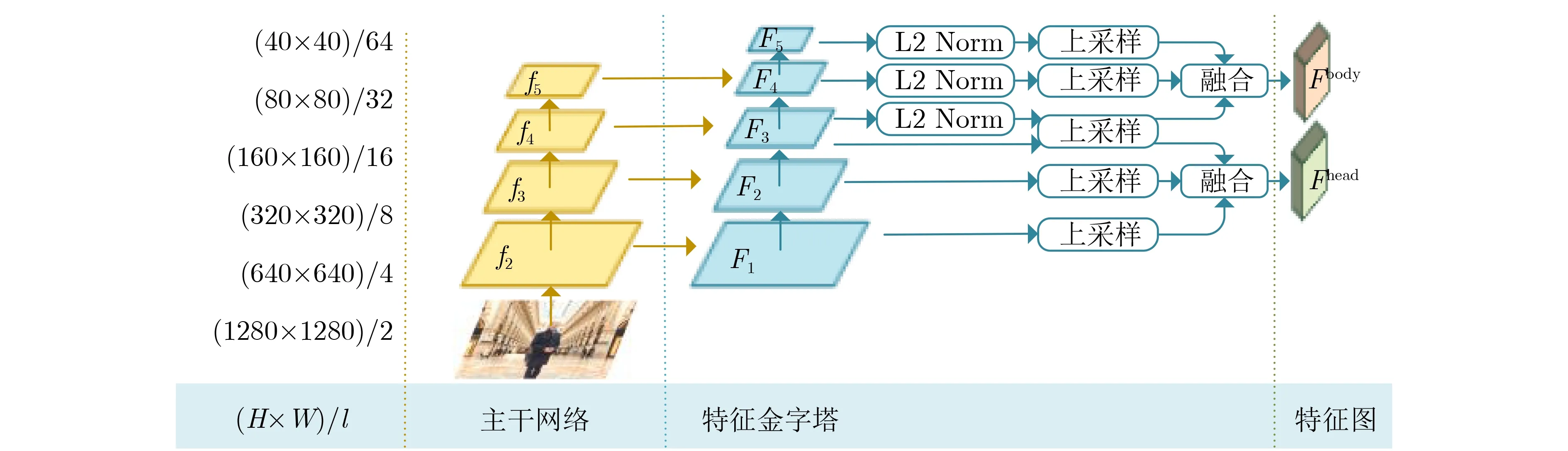

圖1為本文提出的網絡模型結構,該模型由特征提取模塊及檢測模塊組成。特征提取模塊除主干網絡外還包含5層結構的特征金字塔。對于行人頭部和整體,使用該特征金字塔的不同子結構并融合輸出的特征;檢測模塊包含頭部檢測和整體檢測兩個分支,以此為基礎本文設計了一種融合策略,通過對非極大值抑制算法進行改進使其能較好地融合兩個檢測分支輸出的檢測結果。

圖1 模型總體結構

2.1 特征提取模塊

特征提取模塊的主干網絡采用ResNet50[20],隨著網絡層數加深輸出特征圖的分辨率逐層縮小為上一層的1/2。目前大多數方法僅使用主干網絡最后3層的輸出構建特征金字塔,這種做法將導致大量小尺度目標信息丟失,對此本文構建了具有5層結構的特征金字塔。同時使用該特征金字塔不同子結構的輸出進行特征融合,從而為行人頭部和整體提供有針對性的特征信息。

圖2為本文設計的特征提取模塊結構。原始輸入圖片的大小為H×W,下采樣率為l且逐層翻倍,主干網絡輸出的特征圖記為f2-f5,對這4張特征圖使用1×1的卷積運算得到特征圖F1-F4,對F4使用相同的卷積運算得到特征圖F5。其中,特征圖F1的通道數為256,后續特征圖的通道數逐層翻倍,但保持特征圖F4和F5的通道數同為2048,最終形成具有5層結構的特征金字塔。頭部檢測分支使用特征圖F1-F3,對F2和F3進行上采樣使其大小與F1一致,融合這3張特征圖從而得到用于頭部檢測的特征圖Fhead;整體檢測分支使用特征圖F3-F5,之后采取的操作與上述類似,但在融合之前采用文獻[21]提出的方法對特征圖進行歸一化,最后得到用于行人整體檢測的特征圖Fbody。

圖2 特征提取模塊結構

2.2 行人檢測模塊

對于由信息主導的深度學習方法而言,引入更豐富的信息能有效提升檢測準確性。文獻[18]在行人矩形邊界框中劃定一部分區域,將其視作行人頭部區域并嘗試利用這部分信息,但因無法進行準確標注而只能大概確定頭部位置,導致頭部信息無法得到有效利用,但這依然為我們提供了新的思路。CrowdHuman[19]是針對密集場景的行人檢測數據集,它不僅包含行人整體邊界框,還包含對應的行人頭部邊界框。為有效利用該數據集中的行人頭部標簽信息,本文在行人檢測的基礎上添加行人頭部檢測并構建如圖3所示的檢測模型。

圖3 檢測模塊結構

對于特征提取模塊輸出的行人整體特征圖Fbody,分別使用3個1×1的卷積計算得到3張特征圖,對應于行人中心Cbody、行人高度Hbody以及偏移量Obody。行人邊界框的寬度采用文獻[22]的生成方式,將高度乘以比例因子ε=0.41后得到;對于行人頭部特征圖Fhead,采用相同方式分別生成頭部中心Chead、高度Hhead以及偏移量Ohead,并設置比例因子ε=1得到頭部寬度。對于每一個可能存在目標的位置,網絡輸出6 維的數組{xc,yc,?h,xo,yo,s},其中(xc,yc)為目標中心點位置,h?為預測目標高度,(xo,yo)為中心點偏移量,s為置信度。

2.3 信息融合策略

測試階段只保留置信度>0.1的邊界框,然后使用非極大值抑制對結果進行篩選。對于每一個行人邊界框,判斷其頭部區域是否存在頭部邊界框,若存在則選取位于該區域中置信度最高的頭部邊界框與之配對,如果行人邊界框的得分較低但存在頭部邊界框,且頭部邊界框的置信度較高,則依然保留該行人整體邊界框。

2.4 損失函數設計

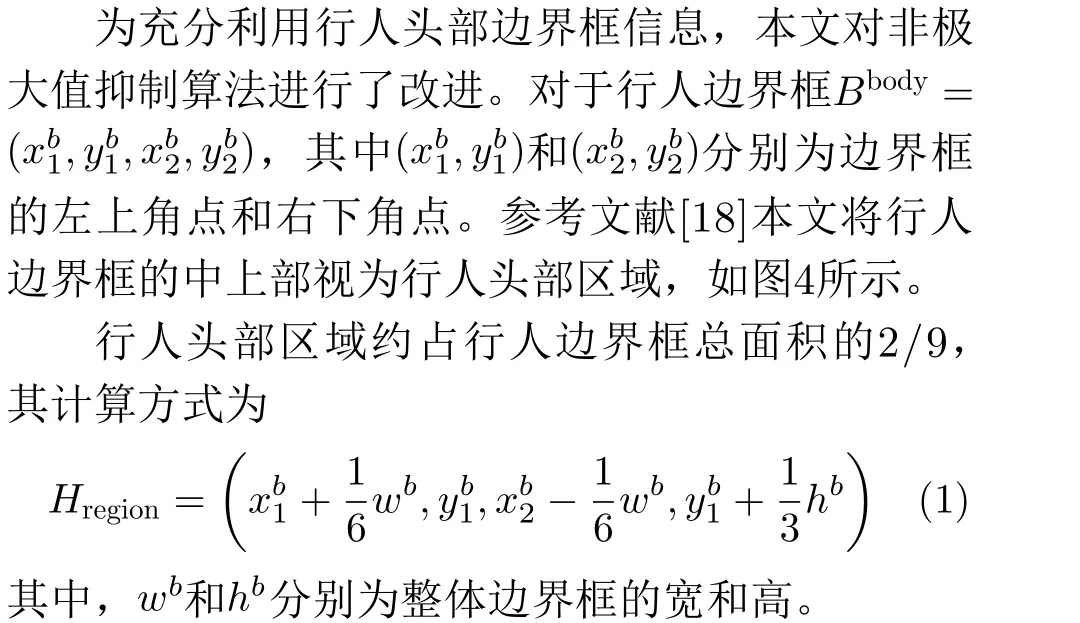

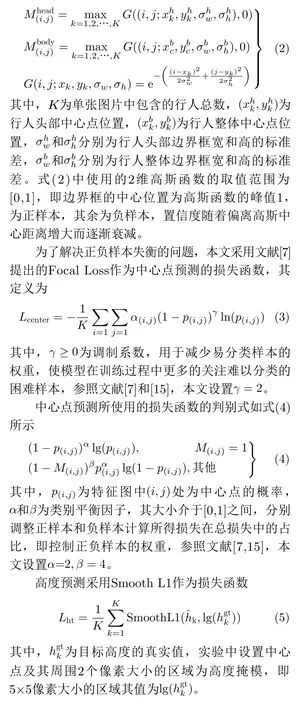

本文將中心點預測視作二分類任務并使用交叉熵損失作為損失函數。對位于(i,j)處的第k個行人,參考文獻[15]的方式,使用高斯函數G(·)分別生成行人頭部高斯掩模Mhead和行人整體高斯掩模Mbody

圖4 行人頭部區域

將特征圖中預測的中心點映射至原圖像時存在一定的位置偏差,該偏差對小尺度目標的影響較大,因此本文添加偏移量預測修正該誤差,該部分使用Smooth L1作為損失函數,如式(6)所示

3 實驗與分析

3.1 實驗平臺

本文所提算法基于PyTorch深度學習框架實現,軟件版本為:PyTorch 1.5.0, CUDA 10.1,Python 3.6和Numpy 1.15.4;硬件平臺配置為:Intel Xeon E5 CPU、64 GB內存和4張NVIDIA GTX1080Ti GPU。

3.2 數據集選擇

本文選用CrowdHuman[19]、CityPersons[22]及Caltech[23]數據集驗證所提算法的有效性。CityPersons數據集包含德國18個城市、3種天氣狀況下行車采集的共5000張圖片,其中2975張用于訓練,500張用于驗證,1525張用于測試,這些圖片共包含約35000個行人,分辨率為2048×1024。Caltech數據集使用車載攝像頭拍攝了10 h左右的行車視頻,分辨率為640×480,共包含6個訓練集(共42782幀)和5個測試集(共4024幀),約有2300個行人并標注了350000個邊界框。CrowdHuman是新發布的針對密集場景下人物實例檢測的數據集,共包含24370張圖片,其中訓練集15000張,驗證集4370張,測試集5000張,整個數據集共包含470個人物實例,平均單張圖片包含約23個人物實例。

3.3 評估標準

對于CrowdHuman數據集,采用平均準確率(Average Precision, AP)、漏檢率(Miss Rate, MR)和召回率(Recall)作為評價指標。其中,準確率指正樣本被預測為正樣本的數目占所有被預測為正樣本的樣本數目的比例,該指標也稱為查準率,值越高說明檢測性能越好;漏檢率指正樣本被預測為負樣本的數目與所有正樣本的比例,該指標也是較為常用且能代表檢測性能的指標,該數值越低說明檢測性能越好;召回率指有多少的正樣本預測正確,即網絡檢測出正樣本的性能,該數值越高越好。對于CityPersons數據集以及Caltech數據集,采用官方評價標準對算法進行評估,主要采用漏檢率指標驗證本文算法對不同遮擋程度以及不同尺度目標的檢測有效性,同時也對算法的泛化性能以及運行時間進行評估。根據CityPersons數據集和Caltech數據集官方提供的劃分標準,這兩個數據集可劃分為多個子集,劃分標準為行人高度和行人被遮擋程度,如表1和表2所示。

表1 Caltech數據集中部分子集劃分標準

表2 CityPersons數據集中部分子集劃分標準

3.4 訓練設置

本文模型使用CrowdHuman數據集進行訓練,并在全部3個數據集上進行測試。訓練階段通過縮放、裁剪、填充和水平翻轉等方式對訓練集圖片進行處理,分辨率設置為1280×1280,每個訓練批次大小為4張圖片,訓練時使用全部的4張顯卡,即每次輸入16張圖片,迭代次數設置為150。模型訓練使用Adam優化器,初始學習率為2×10–4。

測試階段僅使用一張顯卡,對于CrowdHuman數據集,圖像分辨率與訓練時保持一致,但僅使用縮放的方式對圖像進行處理。對于CityPersons數據集和Caltech數據集,測試圖像分辨率分別設置為2048×1024和640×480。非極大值抑制閾值與頭部邊界框保留閾值均設置為0.5,置信度閾值設置為0.1。

3.5 實驗設計

3.5.1 對比實驗

為驗證本文所提方法的有效性,本文選取了在CrowdHuman數據集上有較好表現且具有代表性的RetinaNet[7], FPN[9], Adaptive NMS[16]和JED[24]等4種對比算法進行訓練和測試。其中RetinaNet和FPN基于特征金字塔結構能較好解決尺度變化的問題,同時對困難樣本有較高的檢測準確率;JED為聯合行人頭部檢測和整體檢測的方法,通過在兩階段檢測器Faster R-CNN的基礎上添加新模塊實現。實驗結果如表3所示。

從表3可以看出,所提算法在CrowdHuman數據集上的檢測準確率為87.31%,漏檢率為50.16%,與對比算法相比有一定的提升。召回率為93.55%稍低于RetinaNet和Adaptive NMS,但本文算法的準確率和漏檢率要優于這兩種算法。對比較新的算法JED,本文算法在準確率和漏檢率上分別提升約1.4%和2.5%,可見所提方法具有一定優越性。

表3 CrowdHuman數據集實驗結果(%)

3.5.2 泛化性實驗

為驗證所提方法的泛化性能以及對不同遮擋程度和不同尺度目標的檢測性能,本文在CityPersons數據集上進行對比實驗并依據官方標準劃分子集,采用漏檢率作為評價指標。同時,按照目標所占區域的大小,以像素面積322和962為界將CityPersons數據集劃分為Small, Medium和Large3個子集,分別驗證算法對小尺度、中等尺度和大尺度行人的檢測性能。本文選取了8種對比算法,包含Faster R-CNN[6]等常用方法和ALFNet[25]等主流方法,以及較新的LBST[10]和CAFL[14]方法作為對比,實驗結果如表4所示。

從表4可以看出本文算法在大部分子集上取得了較好的檢測效果,分別在Reasonable和Partial子集上實現了10.1%和9.8%的漏檢率,但在Bare子集和Heavy子集上,本文算法的漏檢率要略高于OR-CNN和CSP。分析發現對于Bare子集中的一些行人實例,由于存在行人頭部邊界框并且其置信度較高,從而導致冗余的行人整體邊界框被保留。而嚴重遮擋的行人幾乎無法檢測出頭部邊界框,從而使得本文所使用的頭部檢測分支無法較好地發揮作用,這可能是本文方法在這兩個子集上檢測效果不是最優的原因。但注意到其性能并未出現大幅下降,相較于最優結果只差了1%左右。同時算法對小尺度和中等尺度行人的漏檢率分別為14.3%和3.5%為最優,表明本文算法對小尺度目標有較好的檢測效果。為了進一步驗證所提方法的正確性,本文與CSP進行對比并將檢測結果可視化,以驗證添加頭部檢測對遮擋問題的改善效果,如圖5所示。

表4 CityPersons數據集漏檢率(MR)的實驗結果(%)

從圖5可以發現,與只使用行人整體中心點進行檢測的CSP相比,本文方法對于遮擋行人的檢測效果有一定改善。如圖中身著黃色上衣的兒童和白色上衣的女士存在較為嚴重的遮擋。多次檢測實驗中CSP方法約有一半的概率無法準確檢測出這兩個目標,而該情況下行人頭部較為分明,本文所提方法由于添加了頭部檢測因此能準確檢測出此類行人。

圖5 檢測效果對比

3.5.3 運行時間

為測試所提方法的運行時間,在相同的實驗條件下,本文在Caltech數據集上進行對比實驗,并選取F-DNN[13], F-DNN+SS[13], Faster R-CNN+ATT[26]和MS-CNN[27]作為對比算法。依據Caltech數據集的官方劃分標準在各個子集上進行實驗,實驗結果如表5所示。

從表5可以看出,本文方法在大部分情況下取得了較好的檢測效果,對于Reasonable, Partial和Heavy子集分別取得了7.73%, 14.55%和48.31%的漏檢率,并在Reasonable和Partial子集上取得了最佳效果,在Heavy子集上的表現要稍低于文獻[26]所提出的方法,大致與MS-CNN一致,而后者為兩階段檢測器。由于本文方法在特征融合部分的上采樣使用了反卷積增加了計算時間,如果將其替換為雙線性插值,能將速度提升至約0.3 s/幀,但漏檢率會稍微增加。在降低漏檢率的同時縮短運行時間,是下一步需要繼續開展的工作。

表5 Caltech數據集漏檢率MR和速度的實驗結果

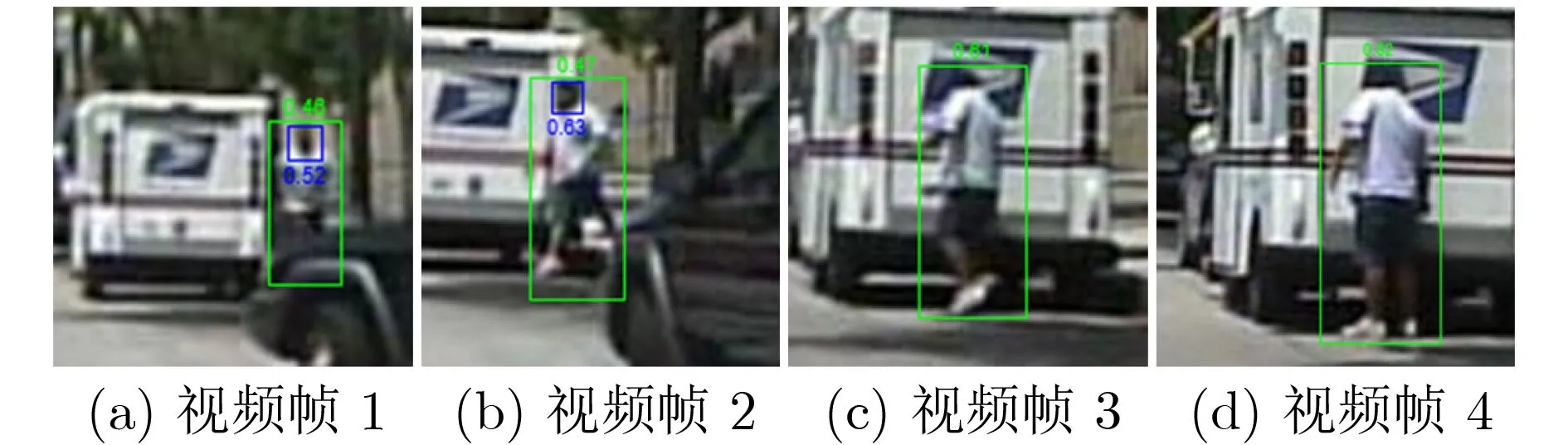

為驗證所提方法在視頻中的表現,本文選取連續的4幀視頻圖像作可視化處理,如圖6所示。邊界框上的數字表示其置信度且取值范圍為[0,1],該值越高表示邊界框為所需邊界框的概率越大。

從圖6可以看出,本文所提方法對連續視頻幀有較好的檢測效果。觀察圖6(a)即視頻幀1可以發現,雖然行人的尺寸較小且存在約30%的遮擋,但本文方法依然準確檢測出其頭部和整體。而對于圖6(b),行人上身衣服顏色與背景相似,這種情況容易產生漏檢,然而此時其頭部邊界框的置信度較高,因此該行人整體邊界框被保留下來。對于圖6(c)和圖6(d),行人頭部特征近乎消失,但本文方法依靠整體檢測分支依然準確地將其檢測出來,從而可見所提方法具有一定的有效性和穩定性。

圖6 實際檢測效果

4 結束語

本文設計了一種結合頭部和整體信息的行人檢測器框架,通過在行人檢測的基礎上添加頭部檢測分支并提供針對性的特征信息,對于所獲得的行人頭部邊界框,設定了行人頭部區域并利用該區域內的頭部信息為非極大值抑制提供更合理的依據。多個數據集上的對比實驗表明本文算法具有一定的優勢。下一步將著力設計更合理的匹配方式,將每個行人的頭部以及身體視為一對進行檢測,以增強頭部和整體之間的聯系,從而實現單分支且有效的行人檢測。