社交媒體用戶關切的人工智能技術倫理向度分析

謝亞可

摘要:人工智能技術的嵌入已然引發了諸多倫理爭議。本文以今日頭條用戶對于“2020年全球十大人工智能事件”的評論為樣本,使用共詞分析法對用戶關切的人工智能倫理向度進行實證研究。研究發現,“人本主義”是用戶最為關切的核心倫理向度,“算法透明”為用戶關切的倫理向度盲區,“審慎和節制”成為用戶倫理關切的新向度。社交媒體用戶對人工智能的關切向度在應然與實然層面上存在一定偏差,我國用戶的人工智能倫理觀需要從技術、社會治理、法律、文化等多方面進行引領。

關鍵詞:社交媒體 用戶關切 人工智能 倫理

近年來,伴隨無人駕駛、人臉識別、智能語音等人工智能技術的廣泛應用,人工智能倫理再次被社會各界廣泛提及,并引發諸多倫理爭議。面對人工智能倫理評價呈現越來越復雜的局面,筆者以今日頭條為研究場景,探討用戶關注的人工智能倫理的向度問題。

筆者將從學理層面和業界訴求兩方面綜合確定討論度較高的人工智能倫理維度。從倫理學角度看,“一線倫理”是能夠讓所有人都認可的共同價值基準。某種意義上說,人權原則就是應用倫理學下的一線倫理。盡管當前有關人權的確立和內涵外延上仍存在一些論爭,但在“自主、平等、公正、尊嚴、關愛”等基本人權價值上所達成的共識,則具有明確性和不可動搖性。

人工智能技術正在深刻改變著人們的生產生活方式,但在不同領域與行業中,人工智能技術大規模應用也會帶來如算法偏見、算法黑盒等諸多問題,給人類社會帶來了巨大的困擾與不安。據2019年普華永道調查顯示,人工智能技術的安全、責任、透明、隱私問題是企業目前面臨的最大難題。為應對這些困擾,歐盟委員會于2019年4月8日發布了《人工智能倫理準則》,該準則要求人工智能技術應尊重基本人權且必須安全可靠。隨后,我國也提出了和諧友好、公平公正、包容共享、尊重隱私、安全可控、共擔責任、開放協作、敏捷治理的人工智能治理八項原則。基于此,筆者綜合國內外對人工智能倫理的學理分析,再圍繞近年來對新興技術治理機制的討論,將人工智能倫理理論框架確定為“自主”、“公平”、“尊嚴”、“關愛”、“安全”、“責任”、“透明”、“隱私保護”、“可持續發展”共九個維度,九個倫理維度是理論上人工智能的倫理維度,實際上也是人類基本倫理價值標準在人工智能技術中的具體呈現。

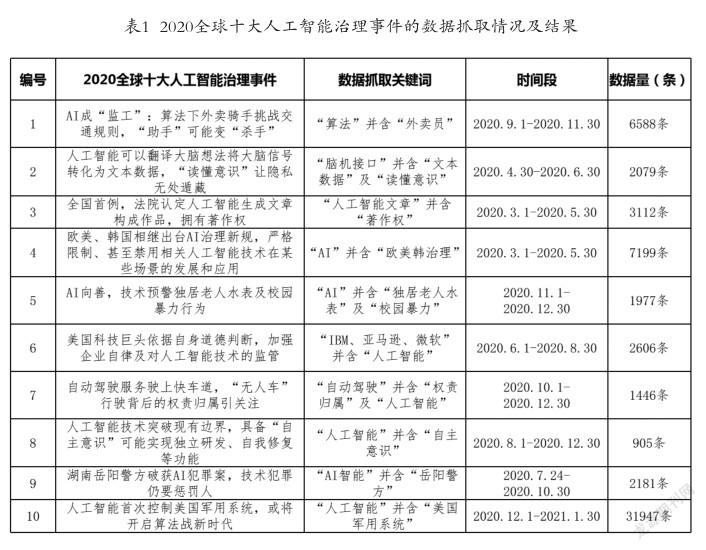

在研究方法上,筆者以人民智庫和曠視AI治理研究院評選出的“2020年度全球十大人工治理事件”為焦點事件進行分析。十大事件是在綜合了各領域的資料數據、10萬以上網友票選以及專家們的意見評選得出,事件樣本具有典型代表性,能真實反映出用戶的關切程度。如表1所示,筆者采用共詞分析法,首先通過事件關鍵詞在指定日期內對事件下的用戶評論進行搜索,共獲取相關數據60040萬條;其次對獲取的數據進行預處理和分詞處理;最后對用戶評論的高頻詞進行聚類分析與統計分析,以此推斷出今日頭條用戶對人工智能技術倫理的關切向度。

筆者將十大事件從AI與公眾福祉、AI與公平正義、AI政府(企業)治理、AI系統安全性與數據隱私安全四個方面進行分類探討,通過對用戶評論高頻詞的統計分析,揭示同一類型事件中今日頭條用戶對人工智能倫理的關切程度。

1.涉及人工智能與公共福祉事件。第一,AI成“監工”事件中,共有6588條用戶評論參與高頻詞提取,高頻詞關涉到的倫理向度為安全、尊嚴、關愛、責任、自主、公平六個倫理維度。通過分析發現,用戶對外賣員的工作和生活狀況、安全和社會保障都給予高度關注,認為企業逐利的本質、算法的不公平使得外賣員在工作中面臨安全威脅;也有用戶認為外賣員缺少自主申訴途徑,無法明確責任主體,難以追責;還有用戶提出要關愛勞動者,算法應更具人情味,但鮮有用戶關注到“算法透明”等相關問題。

第二,AI向善事件中,共有1977條用戶評論參與高頻詞提取,高頻詞關涉到的倫理向度為關愛、隱私保護、可持續發展、公平四個方面。通過分析發現,多數用戶認為“技術向善”的利民舉措能夠惠及老幼人群,充分體現了技術公平,可持續推廣使用;部分用戶認為應關愛老人并積極推動智能社會的適老化;還有用戶擔憂技術使用可能產生個人隱私和信息泄露問題,要謹慎使用。然而極少有用戶提出對老年人技術“自主性”的要求。

2.涉及人工智能與公平正義的事件。第一,湖南岳陽警方破獲AI犯罪案事件中,共有2181條用戶評論參與高頻詞提取,高頻詞涉及的倫理向度主要為安全、隱私和責任三個方面。分析發現,大部分用戶擔心在享受人工智能技術帶來紅利的同時,隱私會受到侵害;部分用戶肯定了“人”在“AI犯罪”中的主導作用,認為技術本無善惡,人利用技術實施的犯罪行為要承擔全部責任,僅少部分用戶認為人與機器都應該有明確的責任分擔。

第二,人工智能擁有著作權事件中,共有3112條用戶評論參與高頻詞提取,高頻詞關涉的倫理向度為尊嚴、公平、關愛三個維度。分析發現,大部分用戶認為人工智能生成物的真正貢獻者應是人工智能設計者、軟件開發者或程序設定者;有用戶認為人類研發人工智能是為了更好地輔助人類,而不是制造出與人類競爭的權利主體;部分用戶認為評定人工智能生成物擁有著作權是對人類尊嚴的侵犯,有損公平正義;也有用戶擔憂人工智能可能使諸多產業發生革命性變革,導致部分人失業。

3.涉及人工智能系統安全性與數據隱私安全的事件。

第一,人工智能“讀懂意識”事件中,共有2079條用戶評論參與高頻詞提取,高頻詞關涉的倫理向度有安全、隱私、自主、尊嚴四個方面。通過分析發現,用戶爭議聲較大的是關于腦機結構翻譯大腦想法會對人們隱私和安全構成巨大威脅的問題;部分用戶認為“機器意識”直追人類意識,人的獨立性、尊嚴、自主性均受到一定程度的挑戰;對于人工智能的可持續發展問題卻鮮有用戶關注到。

第二,“無人車”權責歸屬事件中,共有1466條用戶評論參與高頻詞提取,高頻詞關涉的倫理向度有關愛、安全、責任三個方面。大部分用戶都聚焦在無人駕駛車輛安全問題上;少數用戶認為自動駕駛車輛投入可能讓大量的駕駛員失業;也有極少部分用戶認為無人駕駛是未來智能交通的發展方向;但較少有用戶關注到“無人車”可能對用戶隱私產生侵害等問題。

第三,人工智能技術具備“自主意識”事件中,共有905條用戶評論參與了高頻詞提取,高詞頻關涉的倫理向度有自主、尊嚴、安全三個維度。通過分析發現,大部分用戶認為一旦人工智能產生了“自主意識”,會對人類尊嚴和安全產生威脅;還有用戶認識到人工智能的發展是一把“雙刃劍”,要謹慎使用。對于涉及人工智能責任和法律人格尊嚴認定的問題,用戶們并未提及。

第四,在人工智能首次控制美國軍用系統事件中,高頻詞提取的用戶評論共計31947條,說明用戶對此事高度關注。高頻詞關涉的倫理向度主要有安全、自主和尊嚴三個維度。有關分析發現,智能時代的兩國爭鋒或演變成兩國算法戰,因此用戶們對算法的安全性深表擔憂;也有部分用戶認為人工智能模型還存在設計缺陷,無法抵御復雜多變的戰場環境;少部分用戶認為人工智能技術的快速發展會導致很多工作如飛行員、司機職位等被其取代,進而有損人類尊嚴;但事件中關于算法公平和人工智能責任的問題用戶極少談及。

4.涉及人工智能政府(企業)治理的事件。第一,在歐美、韓國相繼出臺AI治理新規事件中,高頻詞抓取的用戶評論共有7199條,高頻詞關涉的倫理向度有隱私、尊嚴、自主、安全、公平五個方面。通過分析發現,大多數用戶理解且贊同歐美、韓國出臺政策的做法,擔憂“人臉識別”的潛在風險;也有用戶提出人臉信息識別有損“人格尊嚴”;還有用戶認為使用人臉信息的前提是充分知情,信息主體有對個人信息自主決定的權利;少數用戶提到人臉識別還會引發種族偏見和性別歧視等不公正問題;也有極少數用戶不贊同歐美、韓國禁止使用“人臉識別”的做法,認為不能因噎廢食,需要建設性的解決問題。

第二,在美國科技巨頭企業對人工智能技術監管事件中,共有2606條用戶評論參加高頻詞的抓取,高頻詞關涉到的倫理向度有隱私保護、責任、可持續發展、安全四個方面。大多數用戶贊同美國科技巨頭對人工智能技術的監管,認為人工智能技術的發展會產生安全、隱私和權責不明等問題,需要謹慎對待;少數部分用戶關注到人工智能準則的制定是為了更好促進人工智能的可持續發展。

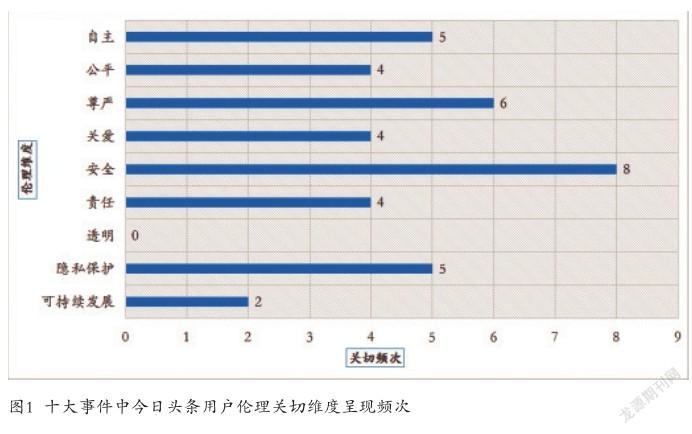

筆者進一步對今日頭條用戶在十個事件中倫理關切向度出現頻次進行統計,結果如圖1所示,在十大事件中,用戶對“安全”、“尊嚴”的關注頻次相對較高,對“自主”、“隱私保護”、“關愛”、“責任”和“公平”的關注頻次次之,對“可持續發展”關切頻次較少,而“透明”向度未能被用戶所關切。由此可以看出,用戶更關心與自身生活產生直接相關的倫理風險,對其倫理訴求也更加迫切。

1.“人本主義至上”:今日頭條用戶關切的核心倫理向度。筆者研究發現,用戶關切頻次較高的倫理向度是“尊嚴”、“安全”、“自主”、“隱私保護”、“關愛”、“責任”、“公平”方面,這些倫理向度恰恰與社會核心價值體系保持一致。人工智能的發展應以人類價值為核心,以人類福祉獲取為目標,研發者應以“人本主義”倫理原則為基本遵循,尊重和保護人權,重視人工智能技術的公平與正義。此外還發現,社交媒體用戶更關切人在技術中的主體性問題,當人工智能產品可能獲得自主性或人工智能技術可能造成大面積失業時,用戶傾向認為在人工智能技術發展中必須堅持人的尊嚴,不能將人變成純粹的、操縱化的工具或手段。

2.“透明性”:今日頭條用戶關切的倫理向度盲區。當前用戶較少對人工智能技術“透明性”倫理有所關注,這是今日頭條用戶對人工智能技術關切向度在應然與實然層面上存在偏差的集中體現。“透明性”原則能應對“算法技術黑箱”所造成的信息不對稱問題,以實現風險的防控與監管。以算法為主要代表的人工智能技術已成為“看不見的手”,盡管能清楚感受其存在,但卻無法對其內部一窺究竟。算法在本質上具有非透明性,其決策標準隱藏在用戶不易覺察的代碼中,特別是算法能依據不同的數據模式產生動態變化。由此導致的結果是,用戶僅關注算法所帶來的結果,不關心算法的具體操作,沒有透明性的制度設計與安排最終將導致算法缺乏公眾的監管和信任。

3.“審慎與節制”:今日頭條用戶關切的倫理新向度。史蒂芬·霍金曾預言,“人工智能的出現可能是‘人類文明史上最糟糕的事件’,除非人類社會能找到控制方法。”隨著人們技術素養的不斷提升,普通用戶對人工智能的發展也有了更深層次的認識。筆者研究發現,用戶對于人工智能技術不再是一味接受與享用,也開始進行深入反思,譬如在“人工智能無人駕駛”和“人工智能可實現自主意識”等事件中,“審慎”、“節制”、“安全”、“負責”等詞成為用戶關注的高頻詞匯,表現出用戶對人工智能發展的擔憂,認為對技術的革新要保持必要的謹慎,需對風險進行評估和規避。

同一事件中用戶對人工智能倫理的認知、態度和倫理判斷存在差異性和一致性。因此,倫理觀的引領必定是一個多元且復雜的問題,需要從技術、社會治理、法律、文化等方面開展對我國用戶人工智能倫理觀的引領。

首先,人工智能設計應遵循“以人為本”的最高原則,尊重人的尊嚴、自由及文化多樣性,正視人工智能可能產生的倫理問題,積極了解并回應用戶的主要關切。在法律層面,應完善法律法規以確保人的尊嚴和自主性;在社會治理層面,應響應用戶關于公平、正義、安全等與社會和諧發展緊密相關的訴求;在信息傳播層面,需要媒體充分發揮正面引領作用,及時為用戶提供全面、客觀的信息,與用戶展開理性的溝通與對話,并促進政府和企業的重視;在文化教育層面,應對用戶開展因地制宜的智能技術教育,消除因技術鴻溝產生的知識壁壘,譬如建立智能技術倫理教育試點,借助平臺加大對人工智能的解釋和風險告知等。

其次,以公眾關注的話題為切入點,對人工智能技術進行系統性與針對性的科普。從當前社交媒體用戶較少關注“算法透明性”倫理問題可以看出,盡管人工智能技術成了社交媒體上的熱門話題,但有關人工智能技術的科學問題、相關科普類信息的內容仍有所欠缺。媒體普遍關注人工智能政策落地和技術應用方面,尤其更關注人工智能技術的娛樂性和商業性。因此,對用戶進行人工智能技術方面的科普不僅有助于提升公眾的人工智能認知水平,還能夠減少用戶對人工智能技術的擔憂,讓用戶以理性的態度看待人工智能技術應用對社會的影響,為我國人工智能領域的健康發展營造良好的社會氛圍。

再次,倡導用戶深入參與人工智能的研發與應用。從當前社交媒體用戶對人工智能技術保持審慎態度來看,用戶對其已具備了一定的風險感知能力。然而,用戶對人工智能技術過度謹慎與節制反而會抑制其正常發展。因此,倡導用戶深入參與人工智能的研發與應用能幫助破除技術鴻溝帶來的知識壁壘,促進理性溝通與對話。譬如采取用戶反饋、用戶控制和用戶選擇等方式,同時包括利用人工智能技術的能力促進用戶參與及公平賦能。另外,用戶參與也可以通過行使個人權利來實現。尊重用戶的隱私權、信息自由權與保護權、信息公平等個人權利,相關部門應提供相應的異議和申訴平臺,以確保用戶能及時維護權益;對于人工智能造成的損害,能為用戶提供相應的救濟渠道并追究參與者的法律責任。

在未來用戶人工智能倫理觀研究層面,可以進一步關注不同用戶在不同事件中的認知偏向和倫理取向的共性和差異性,推動人工智能技術平臺合力打造良性的人工智能倫理觀生態體系。

作者系湖南第一師范學院文學與新聞傳播學院副教授

本文系湖南省教育廳科學研究優秀青年項目“融媒體背景下數據新聞的生產與倫理研究”(項目編號:19B120)的研究成果。

參考文獻

[1]李倫.中國科技倫理研究范式回歸契機——“當代科技倫理前沿問題學術研討會”綜述[J].倫理學研究,2005(11).

[2]人民日報.歐盟發布人工智能倫理準則[EB/OL].(2019-04-11)[2021-12-13].http://www.xinhuanet.com/tech/2019-04/11/ c_1124350837.htm.

[3]中國新聞網.新一代人工智能治理原則[EB/OL].(2019-06-17)[2021-12-13].https://www.chinanews.com/gn/2019/06-17/8866913.shtml.

[4]人民論壇網.2020年度全球人工智能十大事件[EB/OL].(2021-01-15)[2021-12-13].http://www.rmlt.com.cn/2021/0115/605251. shtml.

[5]Maayan Perel,Niva Elkin-Koren,Black box tinkering:beyond disclosure in algorithmic enforcement[J].Florida Law Review,2017(69).

【編輯:朱垚穎】

3515500338217