融合YOLO v5n與通道剪枝算法的輕量化奶牛發情行為識別

王 政,許興時,華志新,尚鈺瑩,段援朝,宋懷波

融合YOLO v5n與通道剪枝算法的輕量化奶牛發情行為識別

王 政,許興時,華志新,尚鈺瑩,段援朝,宋懷波※

(1. 西北農林科技大學機械與電子工程學院,楊凌 712100;2. 農業農村部農業物聯網重點實驗室,楊凌 712100;3. 陜西省農業信息感知與智能服務重點實驗室,楊凌 712100)

及時、準確地監測奶牛發情行為是現代化奶牛養殖的必然要求。針對人工監測奶牛發情不及時、效率低等問題,該研究提出了一種融合YOLO v5n與通道剪枝算法的輕量化奶牛發情行為識別方法。在保證模型檢測精度的基礎上,基于通道剪枝算法,對包括CSPDarknet53主干特征提取網絡等在內的模塊進行了修剪,以期壓縮模型結構與參數量并提高檢測速度。為了驗證算法的有效性,在2 239幅奶牛爬跨行為數據集上進行測試,并與Faster R-CNN、SSD、YOLOX-Nano和YOLOv5-Nano模型進行了對比。試驗結果表明,剪枝后模型均值平均精度(mean Average Precision, mAP)為97.70%,參數量(Params)為0.72 M,浮點計算量(Floating Point operations, FLOPs)為0.68 G,檢測速度為50.26 幀/s,與原始模型YOLOv5-Nano相比,剪枝后模型mAP不變的情況下,參數量和計算量分別減少了59.32%和49.63%,檢測速度提高了33.71%,表明該剪枝操作可有效提升模型性能。與Faster R-CNN、SSD、YOLOX-Nano模型相比,該研究模型的mAP在與之相近的基礎上,參數量分別減少了135.97、22.89和0.18 M,FLOPs分別減少了153.69、86.73和0.14 G,檢測速度分別提高了36.04、13.22和23.02 幀/s。此外,對模型在不同光照、不同遮擋、多尺度目標等復雜環境以及新環境下的檢測結果表明,夜間環境下mAP為99.50%,輕度、中度、重度3種遮擋情況下平均mAP為93.53%,中等尺寸目標和小目標情況下平均mAP為98.77%,泛化性試驗中奶牛爬跨行為檢出率為84.62%,誤檢率為7.69%。綜上,該模型具有輕量化、高精度、實時性、魯棒性強、泛化性高等優點,可為復雜養殖環境、全天候條件下奶牛發情行為的準確、實時監測提供借鑒。

圖像識別;行為;模型;發情檢測;通道剪枝;YOLO v5n;奶牛爬跨行為;復雜環境

0 引 言

及時、準確地監測奶牛發情信息,有利于在合適的時間對奶牛進行配種,降低產犢間隔,提高牛場效益[1]。人工監測方法因效率低下、準確率難以保證等原因已無法滿足養殖要求[2]。奶牛發情期僅持續4~26 h,平均為14 h[3],爬跨行為作為其顯著的外部表現,卻往往因爬跨次數較少、持續時間較短等原因難以被及時發現,導致發情奶牛無法及時配種[4]。因此,研究奶牛發情行為的實時、準確監測對現代化奶牛養殖具有重要意義。

針對奶牛發情行為的多種特征,研究者提出了基于多類別傳感器及大數據挖掘技術的奶牛發情行為監測方法[5-6]。田富洋等[7]根據奶牛發情期間活動量增加、體溫升高和躺臥時間變短等生理特征變化情況,建立了學習矢量量化神經網絡預測模型,對奶牛發情行為預測的準確率在70%以上。尹令等[8]在奶牛頸部安裝三維加速度傳感器,通過K-Means聚類算法對奶牛各方向運動加速度輸出值進行分類,可有效判定奶牛發情期。

隨著計算機視覺技術的發展,諸多學者開始研究基于視頻圖像分析的奶牛發情行為監測方法,早期奶牛發情行為監測方法以傳統圖像分析方法為主。Tsai等[9]基于奶牛爬跨過程中包圍2頭牛的邊界框長度發生的規律性變化,提出了一種視頻監測奶牛爬跨行為的方法,假陽性率為0.33%。顧靜秋等[10]利用圖像熵方法對奶牛目標進行識別,針對奶牛爬跨時兩頭奶牛最小包圍盒之間的相交面積判斷是否發情,識別準確率超過80%,漏檢率最低為3.28%。Guo等[11]采用基于顏色和紋理特征的背景減除法檢測奶牛區域,提取目標區域幾何和光流特征,利用支持向量機(Support Vector Machine, SVM)識別奶牛爬跨行為,平均識別準確率和假陽性率分別為90.9%和4.2%。謝忠紅等[12]采集奶牛爬跨行為側面視頻,根據兩頭奶牛最小外接矩形連通域隨爬跨過程的規律性變化,利用K-最近鄰算法對奶牛爬跨行為進行識別,準確率為99.21%。

近年來,大數據及硬件加速設備迅速發展,一些學者將深度學習技術應用于奶牛發情行為識別任務。王少華[13]提出了一種基于改進YOLOv3模型的奶牛發情行為識別方法,模型準確率為99.15%,召回率為97.62%。劉忠超[14]采集了包括爬跨行為在內的奶牛日常活動視頻,將爬跨行為視頻作為正樣本,其余視頻作為負樣本,在LeNet-5網絡基礎上,構建卷積神經網絡(Convolutional Neural Networks, CNN)進行訓練,該模型對奶牛爬跨行為識別準確率為98.25%,單幅圖像平均識別時間為0.257 s。Wang等[15]對YOLOv5l模型增加空洞空間金字塔池化、通道注意力機制以及深度非對稱瓶頸等模塊,并利用 K-Means聚類得到新的錨框,對自然場景下奶牛發情行為進行檢測,模型均值平均精度為94.3%。

上述方法雖能有效對奶牛發情行為進行識別,但也存在如下問題:1)基于穿戴式設備的奶牛發情行為監測方法準確率高,但使用復雜、易損壞,且對奶牛具有一定的應激作用;2)傳統視頻圖像分析方法需要手工進行特征提取,效率較低;3)部分基于深度學習的方法其模型較大,耗費大量計算資源,難以滿足實時性及模型部署等要求[16-17]。

為解決上述問題,本研究擬利用YOLO v5n(You Only Look Once v5 nano)模型[18-19]檢測精度高、對多尺度目標檢測效果好的優點,提出一種基于YOLO v5n的奶牛發情行為檢測方法,并采用通道剪枝算法[20]進行輕量化處理,解決YOLO v5n模型對單類別目標檢測時冗余通道較多、檢測速度不高等缺點,以期構建一種輕量化、高精度、實時性、魯棒性強、泛化性高的奶牛發情行為識別方法。

1 材料與方法

1.1 材料

1.1.1 數據來源

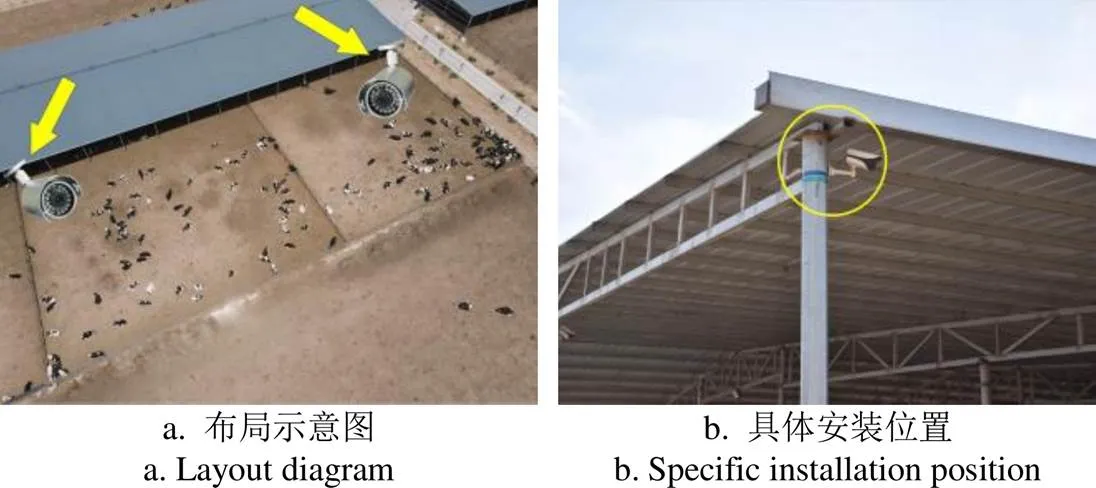

本研究視頻數據采集自寧夏回族自治區臻牛牧業奶牛養殖場和五里牛園牧業奶牛養殖場,通過實地考察,發現奶牛爬跨行為主要發生在養殖區的室外運動場,故本研究選擇對室外運動場進行視頻采集。單個奶牛運動場長約60 m,寬約20 m,每個運動場的棚舍角落位置各安裝2個網絡攝像機(DS-2CD3626FWD-LPTZ(2.7~12 mm),杭州海康威視有限公司),攝像機安裝高度約3.6 m,向下傾斜角度約25°,攝像機安裝位置如圖1所示。視頻記錄時間為2021年10月至2022年10月,對6個奶牛運動場的視頻進行采集。

圖1 攝像機安裝示意圖

1.1.2 樣本集構建

人工篩選包含奶牛爬跨行為的視頻片段199段,其中采集自臻牛牧業奶牛養殖場186段,五里牛園牧業奶牛養殖場13段,每段時長3~15 s不等,幀率25 幀/s,本研究對采集自臻牛牧業奶牛養殖場的186段視頻利用視頻分幀技術,每5幀取1幀,得到視頻圖像3 681幅,采集自五里牛園牧業奶牛養殖場的13段視頻用于驗證模型的泛化性,為減少訓練時間,將圖像分辨率調整為1 280 像素(水平)×720像素(垂直)。

為避免相鄰幀圖像相似,本研究采用結構相似性(Structural Similarity, SSIM)算法[21],將奶牛爬跨片段中每幅爬跨圖像與后續的圖像進行差異比較,剔除冗余圖像,計算式如式(1)所示。

式中SSIM為度量圖像的相似度指標,μ,μ分別表示圖像、的均值,δ,δ為其標準差,δ為其協方差,1,2為任意常數。

去除冗余圖像后,由西北農林科技大學獸醫專家辨認篩選,最終得到2 239幅包含奶牛爬跨行為的圖像。為避免劃分訓練集、測試集時測試集的樣本圖像與訓練集的樣本圖像屬于同一爬跨片段,導致模型過擬合,因此隨機選取總視頻片段的1/5,即37段不同運動場、不同環境下的奶牛爬跨片段作為測試集樣本,按上述方法得到518幅圖像構建測試集,其余圖像作為訓練集,最終得到訓練集樣本1 721幅、測試集樣本518幅,訓練集與測試集之比約為3∶1,各類樣本集間無數據重疊。通過LabelImg 標注工具對數據集進行標注,標注框為兩頭奶牛爬跨行為的最小外接矩形,標記標簽為“Mounting”,標注文件保存為視覺目標分類(Visual Object Classes, VOC)格式。

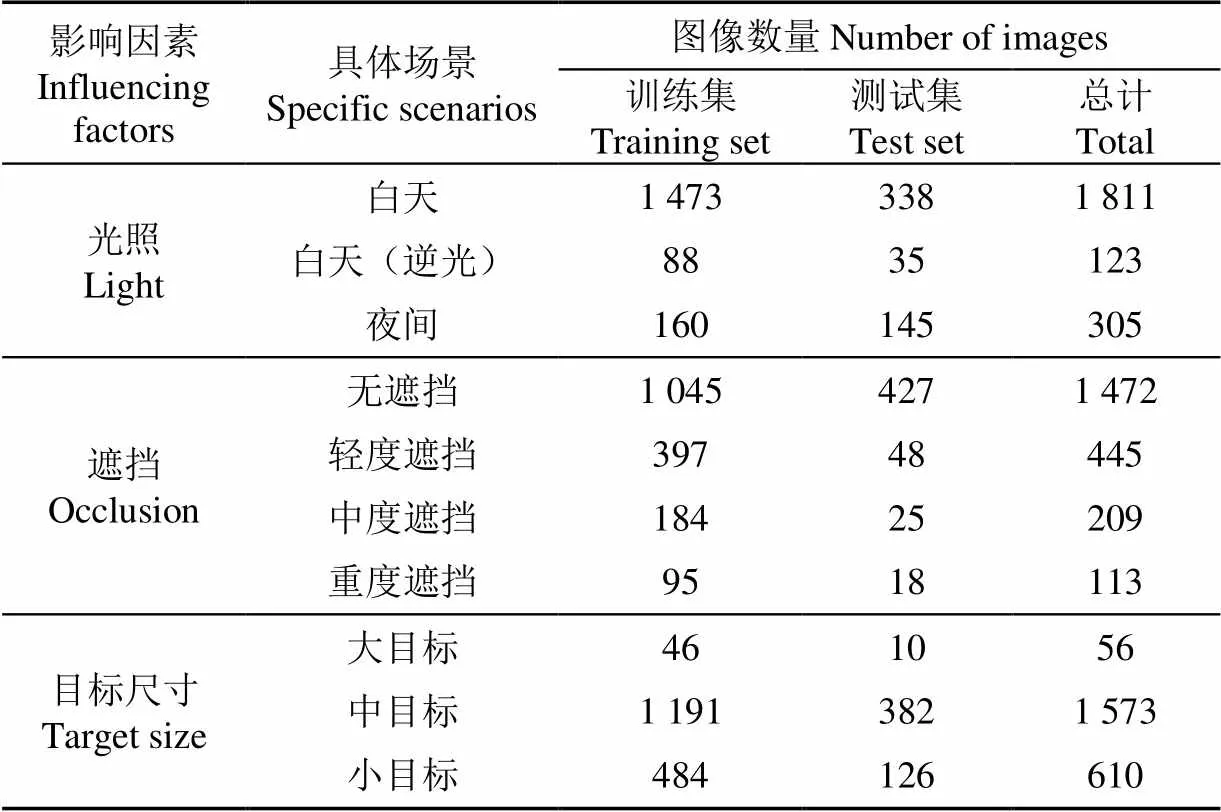

由于奶牛養殖場環境復雜多樣,存在光線復雜、天氣惡劣等影響;此外也存在牛只遮擋、背景相似等問題。本研究按光照情況、遮擋情況、目標尺寸情況對所有數據進行分類。如圖2所示,光照情況分為白天及夜間,其中包括逆光等影響因素。

圖2 不同光照示意圖

圖3為奶牛爬跨時不同遮擋程度示意圖。如圖3所示,藍色區域為奶牛爬跨行為被前景遮擋區域,根據遮擋比例劃分為無遮擋(0),輕度遮擋(0~20%),中度遮擋(>20%~45%)和重度遮擋(45%以上)。

圖3 不同遮擋示意圖

圖4為奶牛爬跨時不同尺寸目標示意圖。如圖4所示,根據2頭奶牛爬跨行為最小外接矩形在圖像中所占比例,分為小目標(寬:0~100像素,高:0~80像素),中目標(寬:100~300像素,高:80~150像素)和大目標(寬:300~800像素,高:150~500像素)。

圖4 不同尺寸目標示例圖

數據集圖像具體信息如表1所示,可以看出:訓練集和測試集中均包含了光照、遮擋和目標尺寸3種影響因素下各個場景的奶牛爬跨圖像;各影響因素下不同場景的圖像數量與實際觀察經驗相符;訓練集和測試集的比例在各場景下基本保持一致。說明本研究數據集樣本采集充分,訓練集和測試集劃分合理。

表1 拍攝圖像詳細信息

1.1.3 試驗平臺

試驗過程在Win10操作系統下進行,處理器型號為Intel(R) Core(TM) i7-10700K CPU @ 3.80GHz 3.79 GHz,顯卡型號為Nvidia GeForce RTX 2080Ti。深度學習框架為PyTorch1.7,編程平臺為PyCharm,編程語言為Python3.7,所有對比算法均在相同環境下運行。

1.1.4 評價指標

為驗證該剪枝模型性能,本研究采用均值平均精度(mean Average Precision, mAP),精確率(Precision,),召回率(Recall,),參數量(Params),浮點計算量(Floating Point operations, FLOPs)共5個指標對模型進行評價,考慮到實際應用需求,對檢測速度(幀/s)也進行評價,模型經非極大值抑制(NMS)后,選取置信度大于 0.6的預測框為正例,反之為負例。其中、和mAP的計算如式(2)~(4)所示。

式中TP表示實際為正例且被劃分為正例的個數,FP表示實際為負例但被劃分為正例的個數,FN表示實際為正例但被劃分為負例的個數,表示檢測類別數,本研究中=1。

在對模型泛化性進行分析時,以視頻片段為單位,SD表示檢測出奶牛爬跨行為的視頻個數,MD表示漏檢奶牛爬跨行為的視頻個數,FD表示將其他目標誤檢為奶牛爬跨行為的視頻個數。檢出率DR和誤檢率FDR計算公式如式(5)~(6)所示。

1.2 基于YOLO v5n通道剪枝算法的奶牛發情行為檢測

1.2.1 總體技術路線

本研究算法總體技術路線如圖5所示。將標注完成的奶牛爬跨行為圖像送入YOLO v5n網絡模型中進行訓練,實現對奶牛爬跨行為的準確檢測;利用通道剪枝算法對模型中冗余的通道和權重參數進行修剪,在保證精度的情況下對模型結構、參數量進行壓縮,從而獲得精度高、體積小、速度快、魯棒性高、泛化性強的奶牛爬跨行為檢測模型[22-23]。

1.2.2 基于YOLO v5n的奶牛發情行為檢測

YOLO v5系列模型兼顧識別精度與檢測速度,是一種實時高效的單階段目標檢測算法。Nano版本是YOLO v5系列中結構較小,精度較高的目標檢測模型,相比YOLO v5系列其他模型,其在保證一定識別精度的前提下極大地減少了模型參數量與計算量,適用于類別較少、特征簡單的目標檢測任務。本研究所使用的YOLO v5n v6.0模型主要由以下模塊構成:

1)Input:包含Mosaic數據增強、自適應錨框計算及自適應圖像縮放三部分。Mosaic數據增強采用隨機縮放、裁剪、排布等方式進行拼接;自適應錨框計算可根據訓練集目標大小自動調整至最佳錨框值,確保對多尺度目標的準確預測;自適應圖像縮放可對原始圖像填充最少的黑邊,提高推理速度。

2)Backbone:主干特征提取網絡采用CSPDarknet53結構,可以在網絡加深的情況下有效解決梯度消失等問題;將空間金字塔池化(Spatial Pyramid Pooling, SPP)替換為快速空間金字塔池化(Spatial Pyramid Pooling-Fast, SPPF),SPPF結構將輸入串行通過多個大小為5×5的MaxPool層,可顯著提高推理速度。

3)Neck:采用特征金字塔網絡(Feature Pyramid Networks, FPN)+路徑聚合網絡(Path Aggregation Network, PAN)結構,并在PAN結構引入CSP結構,加強網絡特征融合能力。

4)Head:包括3個不同尺寸的檢測分支,通過加權非極大值抑制獲得最優目標框。

本研究設定模型圖像輸入大小為512像素×512像素,為加快收斂速度,采用模型在VOC數據集上的預訓練權重,初始學習率為0.003 2,權重衰減系數為0.000 36,共訓練200輪次。

YOLO v5n模型的損失值由置信度損失obj、邊界框位置損失box和類別損失cls組成,本研究中類別只有“Mounting”一類,故cls=0,式(7)為損失值計算公式。

=obj+box(7)

圖6為訓練過程損失函數變化,在模型訓練初期,學習率較高,Loss曲線在前35輪迅速收斂,隨著迭代的進行,Loss曲線逐漸變緩并于150輪次左右達到收斂,Loss值在0.02附近波動,模型達到穩定狀態。

注:CBS為Conv2d+BN+SiLU,Conv2d為卷積操作,BN為批歸一化操作,SiLU為非線性激活函數,Upsample為上采樣操作,Concat為通道堆疊操作,add為特征圖相加操作, MaxPool為最大池化操作,SPPF為快速空間金字塔池化操作,Bottleneck為2個CBS模塊堆疊后與輸入融合操作,Bottleneck_F為2個CBS模塊堆疊操作,C3_x為包含x個Bottleneck結構的卷積模塊,C3_x_F為包含x個Bottleneck_F結構的卷積模塊,Cin為網絡第i層中第n個通道的輸出。

圖6 模型訓練損失值變化曲線

本文所采用的YOLO v5n模型的檢測效果如圖7所示,可以看出,該模型在夜間環境、欄桿遮擋、小目標及背景相似等多種復雜環境下均可準確識別奶牛爬跨行為,可以有效完成本研究識別任務,為模型剪枝提供基礎。

1.2.3 基于YOLO v5n通道剪枝的奶牛發情行為檢測

本文所建立的YOLO v5n模型雖能實現奶牛發情行為的高效檢測,但其計算耗時較長,模型的結構和參數量未達到最優效果,占用較多計算資源,為提高模型的實用性、降低計算量,有必要對模型進行修剪。

1)剪枝原理

大多數現代卷積神經網絡均采用批歸一化(Batch Normalization, BN)作為標準方法,以實現快速收斂及更好的泛化性能[24]。如式(8)~(9)所示,通道剪枝時,in和out表示BN層的輸入和輸出,μ和σ表示每個批次的均值和標準差,為避免除數為0而使用的微小正數,并為每個通道的BN層引入縮放因子和偏置,對通道數據進行歸一化處理。

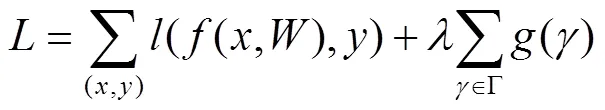

在訓練過程中,縮放因子作為通道選擇的代理,利用L1正則化對其進行稀疏,損失函數如式(10)所示:

式中第一項為正常訓練損失函數,和表示訓練的輸入與輸出,表示可訓練權重,第二項為正則化項,()是對縮放因子的懲罰函數,本文選擇L1范數:()= ||,權重系數是兩項的平衡因子[20]。

如圖5所示,稀疏化后接近于0的因子所代表的通道對模型的貢獻率較低,因此可以對這些通道及其輸入、輸出進行修剪,在不影響模型性能的前提下達到壓縮模型結構、提高運算速度的效果。

注:“Mounting”為兩頭奶牛之間爬跨行為;“Mounting”后數值為置信度。

2)模型剪枝步驟

① 稀疏化訓練

稀疏訓練通過設置不同的稀疏率對通道進行選擇,若值過小,稀疏過程太慢,區分不出通道重要性;若值過大,往往會造成精度下降過快。為確定最佳稀疏率,結合文獻[20,22-23]的參數設置及預試驗數據,將值分別設置為0.000 1,0.001,0.005及0.01后對原始模型進行稀疏化訓練。圖8為不同稀疏率對應的系數變化趨勢圖,可以看出,系數隨著訓練的進行逐漸趨近于0,并且稀疏率越大,系數趨近于0的速度越快。對稀疏訓練后的模型均進行50%的剪枝[20],表2為剪枝后模型的參數對比,可見當稀疏率為0.005時,剪枝后模型mAP最高,因此本研究稀疏率取0.005。

圖8 不同稀疏率(sr)下BN層γ系數

表2 不同稀疏率下模型性能

② 剪枝及微調處理

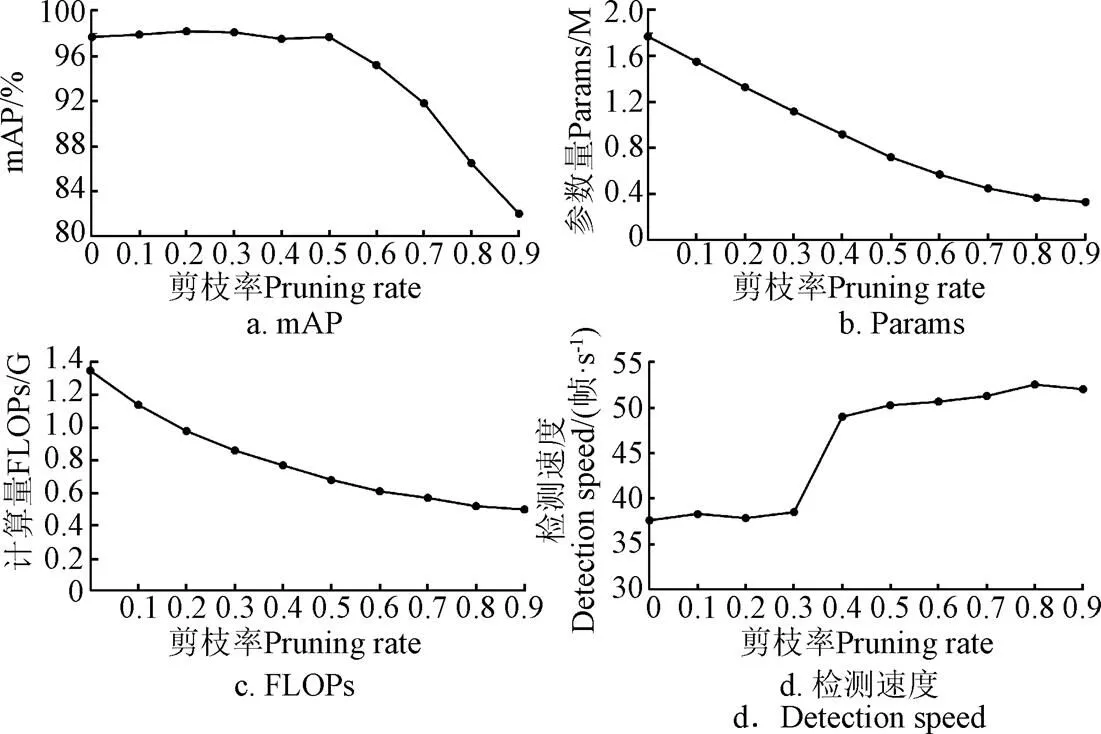

在確定稀疏率后,本文對YOLO v5n模型進行不同比例的剪枝,通過模型效果選擇最佳剪枝率。圖9為稀疏率為0.005時,以不同剪枝率進行剪枝并進行微調后的模型參數變化。

圖9 不同剪枝率下模型參數變化趨勢

由圖9可知,通過不同比例的剪枝,YOLO v5n模型的參數量和計算量均有不同程度的下降。模型性能方面,當剪枝率在0.5以下時,模型的mAP變化趨勢不大,當剪枝率大于0.5時,mAP下降較快;檢測速度方面,原始模型的檢測速度為37.59幀/s,當剪枝率大于0.3時,模型的檢測速度有較大提升。綜合以上方面,在保證檢測精度的前提下,選擇剪枝率為0.5,可有效壓縮模型參數、減少計算量,并較大幅度提高檢測速度。

以0.5剪枝率進行剪枝后,模型各卷積層通道數變化如圖10所示,可以看出,多數卷積層通道數量大幅降低,平均每層被剪枝約32通道,表明該剪枝算法有效。

圖10 剪枝前后通道數量對比

2 結果與分析

2.1 訓練結果

本研究對YOLO v5n模型以0.005的稀疏率訓練200輪次,對稀疏后的模型剪枝50%后進行微調,將剪枝、微調后的模型命名為YOLOv5n-Pruned,該模型在測試集中mAP為97.70%,值為97.80%,值為95.80%,參數量為0.72 M,計算量為0.68 G,檢測速度為50.26幀/s。

2.2 檢測效果

本研究對多種場景下的奶牛爬跨圖像進行了檢測,測試集共包含37段不同場景下的奶牛爬跨視頻,YOLOv5n-Pruned模型成功檢測出其中35段視頻中的奶牛爬跨行為,奶牛爬跨行為檢出率為94.59%。檢測效果如圖11所示,可以看出,該模型對夜間光照較弱、牛只遮擋、目標尺寸較小及干擾因素疊加等各種復雜場景下的奶牛爬跨行為均有較好的識別效果。

圖11 YOLOv5n-Pruned模型檢測效果

2.3 不同目標檢測算法的比較

為評價本文模型對奶牛爬跨行為的檢測效果,本文在與YOLOv5n-Pruned模型相同的訓練集及測試集上對Faster R-CNN[25]、SSD[26]、YOLOX-Nano[27]以及YOLOv5-Nano[18]4種模型進行性能評估,結果如表3所示。由表3可知,與剪枝前原始模型YOLOv5-Nano相比,YOLOv5n-Pruned模型在mAP保持不變的情況下,值提高0.3個百分點,值降低0.7個百分點,參數量和計算量在原始模型的基礎上分別減少59.32%和49.63%,檢測速度提高33.71%。與其余3種模型相比,YOLOv5n-Pruned模型的mAP分別高于Faster R-CNN和YOLOX-Nano模型 2.43和1.62個百分點,雖然比SSD低1.68個百分點,但在參數量、計算量和檢測速度方面YOLOv5n-Pruned模型在5種模型中表現效果最佳,其參數量分別比Faster R-CNN、SSD和YOLOX-Nano減少135.97、22.89和0.18 M,計算量分別減少153.69、86.73和0.14 G,檢測速度分別提高36.04、13.22和23.02幀/s。綜上所述,YOLOv5n-Pruned模型在mAP與其他4種模型相近的情況下,表現出在參數量、計算量以及檢測速度等方面的優勢,證明本研究模型切實可行,在占用較小硬件及計算資源的前提下,為養殖場奶牛發情行為的實時、準確監測及移動端部署提供了技術支持。

表3 5種目標檢測模型的試驗結果

3 討 論

3.1 奶牛爬跨行為漏檢、誤檢分析

本研究模型雖能較好地識別奶牛發情爬跨行為,但由于養殖場環境復雜多樣,常有逆光、遮擋、沙塵和小目標等干擾因素疊加,導致部分圖像出現漏檢、誤檢等情況。

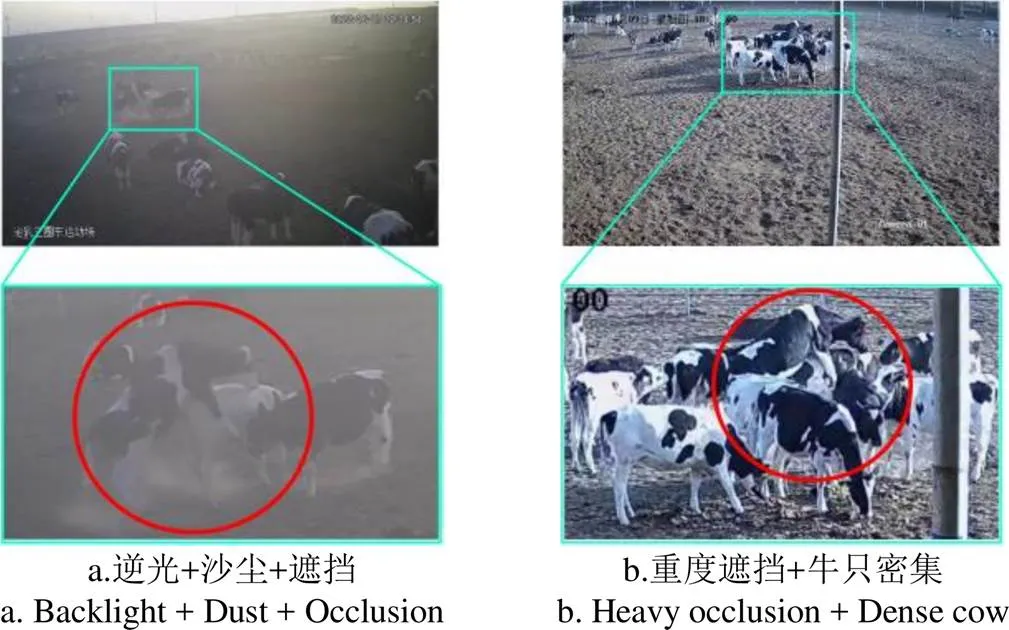

如圖12a所示,此時奶牛處于逆光環境,背景區域過度曝光,目標奶牛區域較暗,且在沙塵天氣下與背景顏色較為接近,干擾了模型的判斷,加之存在牛只遮擋,減少了模型提取到的奶牛爬跨行為特征,以上干擾因素疊加導致了模型漏檢;如圖12b所示,發情奶牛處于牛群中間,存在重度遮擋,且奶牛花斑黑白相間,在牛只密集時模型難以準確區分牛只個體,從而無法檢測出爬跨行為。

圖12 漏檢示例

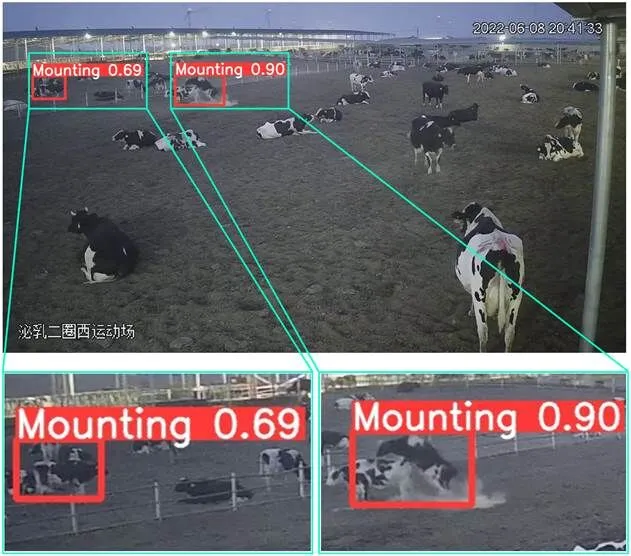

如圖13所示,模型共輸出2個檢測框,其中左側檢測框為誤檢,分析其原因:此時光照較弱,牛只距離攝像機較遠,且空間上異面的兩頭奶牛在平面圖像上相互重疊,與爬跨動作相似,多種因素疊加導致了模型誤檢。但從置信度分析,誤檢框的置信度為0.69,正確檢測框的置信度為0.90,可以看出模型對于干擾情況下的誤檢目標仍具有一定的區分度。

圖13 誤檢示例

為定量分析干擾因素對檢測模型的影響,本研究將測試集中的518幅圖像按照光照情況、遮擋情況和目標尺寸情況進行分類,利用上述5種算法分別對不同場景下奶牛爬跨圖像進行測試,并以1值和mAP作為評價指標,其中1值計算式如式(11)所示。

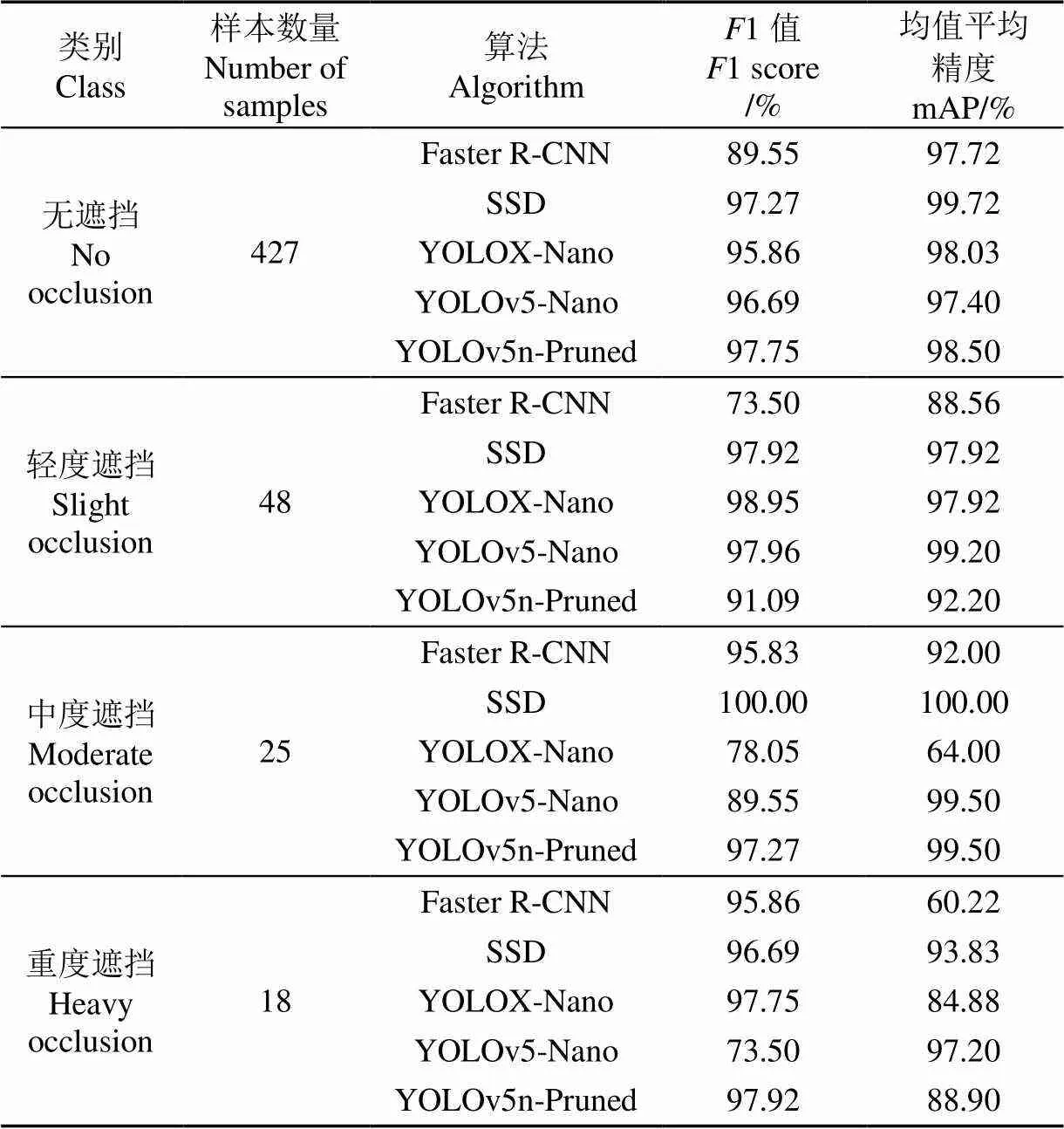

3.1.1 遮擋程度對模型效果的影響

由于奶牛是群居動物,喜聚群[28],奶牛爬跨行為常被其余牛只遮擋,模型獲取到的奶牛爬跨行為特征減少,導致無法準確識別出奶牛爬跨行為。表4為不同遮擋程度下5種模型的試驗結果。無遮擋情況下YOLOv5n-Pruned模型1值為97.75%,在5種模型中最高,其mAP為98.50%,分別比Faster R-CNN、YOLOX-Nano和YOLOv5-Nano高0.78、0.47和1.1個百分點,比SSD低1.22個百分點;輕度、中度、重度3種遮擋情況下YOLOv5n-Pruned模型平均mAP為93.53%,其中輕度遮擋情況下,YOLOv5n-Pruned模型的1值和mAP低于SSD、YOLOv5-Nano和YOLOX-Nano,但高于Faster R-CNN;中度遮擋情況下,YOLOv5n-Pruned模型的1值分別比Faster R-CNN、YOLOX-Nano和YOLOv5-Nano高1.44、19.22和7.72個百分點,低于SSD模型2.73個百分點,其mAP分別高于Faster R-CNN和YOLOX-Nano模型7.5和35.5個百分點,低于SSD模型0.5個百分點,與YOLOv5-Nano相等;重度遮擋情況下,YOLOv5n-Pruned模型的1值為97.92%,在5種模型中最高,其mAP分別比SSD和YOLOv5-Nano低4.93和8.30個百分點,但比Faster R-CNN和YOLOX-Nano分別高28.68和4.02個百分點。同時,在重度遮擋環境下,5種模型的識別效果均有所下降。

表4 不同遮擋程度下5種模型試驗結果

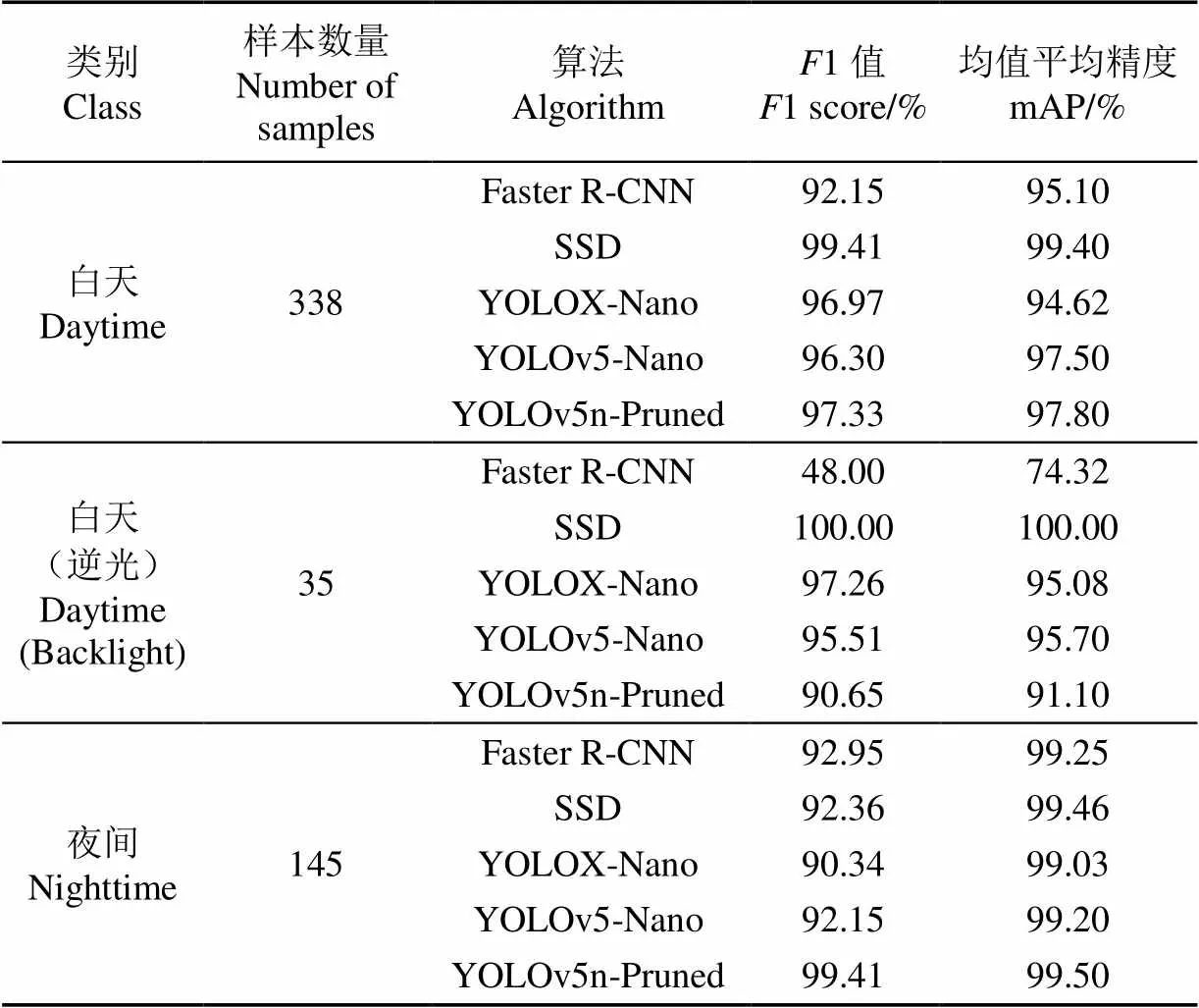

3.1.2 光照條件對模型效果的影響

奶牛夜間發情比例達62.1%[29],因此夜間低光照環境下奶牛發情行為監測效果是衡量模型的重要指標。表5為不同光照條件下5種模型試驗結果。

表5 不同光照條件下5種模型試驗結果

可以看出,白天環境下,YOLOv5n-Pruned模型的1值為97.33%,分別比Faster R-CNN、YOLOX-Nano和YOLOv5-Nano高5.18、0.36和1.03個百分點,比SSD低2.08個百分點,其mAP值為97.80%,分別比Faster R-CNN、YOLOX-Nano和YOLOv5-Nano高2.7、3.18和0.3個百分點,比SSD低1.6個百分點;白天(逆光)環境下,YOLOv5n-Pruned模型的1值和mAP值低于SSD、YOLOX-Nano和YOLOv5-Nano,但高于Faster R-CNN;夜間環境下,YOLOv5n-Pruned模型的1值為99.41%,mAP為99.50%,在5種模型中表現最優。

3.1.3 目標尺寸對模型效果的影響

由于奶牛運動場大小不一,攝像頭安裝角度不一,因此奶牛爬跨行為的目標尺寸也存在較大差異。為進一步分析不同模型對不同尺寸目標的檢測性能,本研究對5種算法進行了對比,結果如表6所示。

表6 不同目標尺寸下5種模型試驗結果

試驗結果表明,得益于模型輸入端采用自適應錨框計算,使得網絡具有較強的多尺度目標檢測能力,YOLOv5n-Pruned模型對3種尺寸目標均有較好的檢測效果。對于大目標,SSD、YOLOX-Nano、YOLOv5-Nano和YOLOv5n-Pruned 共4種模型性能相當,1值均為100%,mAP均為99.50%以上,Faster R-CNN模型出現粗大誤差,數據不予討論;中等尺寸目標和小目標情況下YOLOv5n-Pruned模型平均mAP為98.77%,對于中等尺寸目標,YOLOv5n-Pruned模型1值和mAP分別為98.12%和98.23%,均高于Faster R-CNN、YOLOX-Nano和YOLOv5-Nano,分別比SSD低1.62和1.5個百分點;對于小目標,YOLOv5n-Pruned模型1值和mAP分別為100.00%和99.30%,在5種模型中均表現最佳。

綜上所述,本研究所提出的YOLOv5n-Pruned目標檢測模型可以實現奶牛發情爬跨行為的快速、準確檢測,在各場景下1值和mAP均高于Faster R-CNN,雖然SSD、YOLOX-Nano和YOLOv5-Nano的1值和mAP在部分場景略高于本研究模型,但YOLOv5n-Pruned模型在參數量、計算量及檢測速度等方面具有絕對優勢,更有利于模型的部署應用。

3.2 泛化性分析

泛化性是衡量模型性能的標準之一,也是模型落地的必然要求。為驗證YOLOv5n-Pruned模型的泛化性能,本研究對采集自寧夏五里牛園牧業奶牛養殖場的13段不同場景下的奶牛爬跨視頻片段進行測試,該養殖場奶牛運動場較小,牛只更為密集且背景更為復雜,識別難度有所提高。經過測試,最終成功檢測出其中11段視頻中的奶牛爬跨行為,檢出率84.62%,檢測效果如圖14所示,本模型在其他牛場的不同場景下,對奶牛爬跨行為也具有較好的檢測效果,為模型的實際應用及遷移學習提供了基礎。

圖14 YOLOv5n-Pruned模型泛化性試驗效果

表7為5種模型的泛化性試驗結果,Faster R-CNN共檢測出12段視頻中的奶牛爬跨行為,SSD和YOLOv5n-Pruned均檢測出11段,YOLOX-Nano和YOLOv5-Nano分別檢測出9段和8段。從誤檢情況分析,Faster R-CNN檢出率雖較高,但其誤檢數量為9段,誤檢率達69.23%,而YOLOv5n-Pruned僅誤檢1段,誤檢率為7.69%,其余模型誤檢數量從3到6段不等。

表7 5種模型泛化性試驗結果

圖15為5種模型檢測效果,Faster R-CNN和SSD雖檢測出奶牛爬跨行為,但出現誤檢情況,YOLOv5-Nano未檢測出爬跨行為,YOLOX-Nano和YOLOv5n-Pruned正確檢測爬跨行為且未出現誤檢。綜上可得,YOLOv5n-Pruned在檢出率較高的情況下,誤檢率低于其余4種模型,因此其泛化性能在5種模型中最好。

圖15 不同模型泛化性檢測效果

4 結 論

1)本研究將YOLOv5-Nano算法與通道剪枝算法融合,提出了一種輕量化奶牛發情行為檢測模型,在保證較高mAP的基礎上,減少了模型參數量、計算量,提高了檢測速度,實現了奶牛發情爬跨行為的準確、實時檢測,為模型部署于邊緣計算設備提供了技術基礎。

2)通過探究不同稀疏率及剪枝率對模型性能的影響,發現當稀疏率為0.005,剪枝率為0.5時,剪枝后模型性能最佳,模型mAP為97.70%,參數量為0.72 M,計算量為0.68 G,檢測速度為50.26 幀/s。與Faster R-CNN、SSD、YOLOX-Nano和YOLOv5-Nano共4種模型相比,該研究模型的mAP在與之相近的基礎上,參數量、計算量大幅降低,檢測速度顯著提高,表明該剪枝操作可有效提升模型性能。

本研究模型在逆光、遮擋、沙塵天氣、小目標等干擾因素疊加情況下會對奶牛爬跨行為存在漏檢和誤檢,后續可考慮采用紅外相機、利用圖像增強算法進行預處理、融合時空上下文信息等方法,以期提高復雜環境下奶牛爬跨行為的檢測效果。

[1] Van Vliet J H, Van Eerdenburg F. Sexual activities and oestrus detection in lactating Holstein cows[J]. Applied Animal Behaviour Science, 1996, 50(1): 57-69.

[2] Reith S, Hoy S. Behavioral signs of estrus and the potential of fully automated systems for detection of estrus in dairy cattle[J]. Animal, 2018, 12(2): 398-407.

[3] Silper B F, Robles I, Madureira A M L, et al. Automated and visual measurements of estrous behavior and their sources of variation in Holstein heifers. I: Walking activity and behavior frequency[J]. Theriogenology, 2015, 84(2): 312-320.

[4] Roelofs J, Lopez-Gatius F, Hunter R H F, et al. When is a cow in estrus? Clinical and practical aspects[J]. Theriogenology, 2010, 74(3): 327-344.

[5] Stevenson J S. A review of oestrous behaviour and detection in dairy cows[J]. BSAP Occasional Publication, 2001, 26(1): 43-62.

[6] 汪開英,趙曉洋,何勇. 畜禽行為及生理信息的無損監測技術研究進展[J]. 農業工程學報,2017,33(20):197-209.

Wang Kaiying, Zhao Xiaoyang, He Yong. Review on noninvasive monitoring technology of poultry behavior and physiological information[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(20): 197-209. (in Chinese with English abstract)

[7] 田富洋,王冉冉,劉莫塵,等. 基于神經網絡的奶牛發情行為辨識與預測研究[J]. 農業機械學報,2013(S1):277-281.

Tian Fuyang, Wang Ranran, Liu Mochen, et al. Oestrus detection and prediction in dairy cows based on neural networks[J]. Transactions of the Chinese Society for Agricultural Machinery, 2013(S1): 277-281. (in Chinese with English abstract)

[8] 尹令,劉財興,洪添勝,等. 基于無線傳感器網絡的奶牛行為特征監測系統設計[J]. 農業工程學報,2010,26(3):203-208.

Yin Ling, Liu Caixing, Hong Tiansheng, et al. Design of system for monitoring dairy cattle's behavioral features based on wireless sensor networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(3): 203-208. (in Chinese with English abstract)

[9] Tsai D M, Huang C Y. A motion and image analysis method for automatic detection of estrus and mating behavior in cattle[J]. Computers and Electronics in Agriculture, 2014, 104: 25-31.

[10] 顧靜秋,王志海,高榮華,等. 基于融合圖像與運動量的奶牛行為識別方法[J]. 農業機械學報,2017,48(6):145-151.

Gu Jingqiu, Wang Zhihai, Gao Ronghua, et al. Recognition method of cow behavior based on combination of image and activities[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(6): 145-151. (in Chinese with English abstract)

[11] Guo Y, Zhang Z, He D, et al. Detection of cow mounting behavior using region geometry and optical flow characteristics[J]. Computers and Electronics in Agriculture, 2019, 163: 104828.

[12] 謝忠紅,劉悅怡,宋子陽,等. 基于時序運動特征的奶牛爬跨行為識別研究[J]. 南京農業大學學報,2021,44(1):194-200.

Xie Zhonghong, Liu Yueyi, Song Ziyang, et al. Research on recognition of crawling behavior of cows based on temporal motion features[J]. Journal of Nanjing Agricultural University, 2021, 44(1): 194-200. (in Chinese with English abstract)

[13] 王少華. 基于視頻分析和深度學習的奶牛爬跨行為檢測方法研究[D]. 楊凌:西北農林科技大學,2021.

Wang Shaohua. Detection Methods of Cow Mounting Behavior Based on Video Analysis and Deep Learning[D]. Yangling: Northwest A&F University, 2021. (in Chinese with English abstract)

[14] 劉忠超. 奶牛發情體征及行為智能檢測技術研究[D]. 楊凌:西北農林科技大學,2019.

Liu Zhongchao. Intelligent Detection Technology of Estrus Signs and Behavior in Dairy Cows[D]. Yangling: Northwest A&F University, 2019. (in Chinese with English abstract)

[15] Wang R, Gao Z, Li Q, et al. Detection method of cow estrus behavior in natural scenes based on improved YOLOv5[J]. Agriculture, 2022, 12(9): 1339.

[16] Wu D, Wang Y, Han M, et al. Using a CNN-LSTM for basic behaviors detection of a single dairy cow in a complex environment[J]. Computers and Electronics in Agriculture, 2021, 182: 106016.

[17] 王政,宋懷波,王云飛,等. 奶牛運動行為智能監測研究進展與技術趨勢[J]. 智慧農業(中英文),2022,4(2):36-52.

Wang Zheng, Song Huaibo, Wang Yunfei, et al. Research progress and technology trend of intelligent morning of dairy cow motion behavior[J]. Smart Agriculture, 2022, 4(2): 36-52. (in Chinese with English abstract)

[18] Jocher G. YOLOv5 release v6.0[EB/OL]. 2021-10-12 [2022-08-10]. https://github.com/ultralytics/yolov5/releases/ tag/v6.0.

[19] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 779-788.

[20] Liu Z, Li J, Shen Z, et al. Learning efficient convolutional networks through network slimming[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 2017: 2736-2744.

[21] Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: From error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[22] Wu D, Lv S, Jiang M, et al. Using channel pruning-based YOLO v4 deep learning algorithm for the real-time and accurate detection of apple flowers in natural environments[J]. Computers and Electronics in Agriculture, 2020, 178: 105742.

[23] 梁曉婷,龐琦,楊一,等. 基于YOLOv4模型剪枝的番茄缺陷在線檢測[J]. 農業工程學報,2022,38(6):283-292.

Liang Xiaoting, Pang Qi, Yang Yi, et al. Online detection of tomato defects based on YOLOv4 model pruning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(6): 283-292. (in Chinese with English abstract)

[24] Bjorck J, Gomes C, Selman B, et al. Understanding Batch Normalization[C]//Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montreal, Canada: MIT Press, 2018: 7705-7716.

[25] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(6): 1137-1149.

[26] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multiBox detector[C]//European Conference on Computer Vision. Amsterdam, Netherlands: Springer, 2016: 21-37.

[27] Ge Z, Liu S, Wang F, et al. YOLOX: Exceeding YOLO series in 2021[EB/OL]. 2021-07-18[2022-08-04]. https://arxiv.org/abs/2107.08430.

[28] 趙新明,魏國華. 奶牛標準化健康養殖的研究[J]. 中國乳業,2021(6):53-57.

Zhao Xinming, Wei Guohua. Standardized healthy breeding of dairy cows[J]. China Dairy, 2021(6): 53-57.

[29] Mwaanga E S, Janowski T. Anoestrus in dairy cows: Causes, prevalence and clinical forms[J]. Reproduction in Domestic Animals, 2000, 35(5): 193-200.

Lightweight recognition for the oestrus behavior of dairy cows combining YOLO v5n and channel pruning

Wang Zheng, Xu Xingshi, Hua Zhixin, Shang Yuying, Duan Yuanchao, Song Huaibo※

(1.,,712100,;2.,712100; 3.,712100,)

An accurate and timely monitoring is a high demand for the oestrus behavior of dairy cows in modern dairy farming. In this research, a lightweight recognition was proposed to detect the oestrus behavior of cows using the combined YOLO v5n and channel pruning. The high precision of the network was established before that. Firstly, the model was sparsely trained, according to different sparsity rates. The best sparsity effect of the model was obtained at the sparsity rate of 0.005. Then, the channel pruning was utilized to prune the modules, including the CSPDarknet53 backbone feature extraction network, in order to compress the model structure and parameters for the high detection speed. 2 239 images of cows’ mounting behavior were also collected, including 1 473 images in the daytime, 88 images in the daytime (backlight), and 160 images in the nighttime. Four occlusion situations were considered, including 1 045 images without occlusion, as well as 397, 184, and 95 images with the slight, moderate, and heavy occlusion, respectively. Three target sizes were also considered, including 46, 1 191, and 484 images with the large, medium, and small targets, respectively. The pruned model was veried on the test set, and then to compare with the Faster R-CNN, SSD, YOLOX-Nano, and YOLOv5-Nano. The test results showed that the mean average precision (mAP) of the model after pruning was 97.70%, the Params were 0.72 M, the Floating Point operations (FLOPs) were 0.68 G, and the detection speed was 50.26 fps. Furthermore, the Params and FLOPs were reduced by 59.32%, and 49.63%, respectively, under the condition of constant mAP, and the detection speed increased by 33.71%, compared with the original model YOLOv5-Nano. Consequently, the pruning operation was effectively improved the performance of the model. The mAP of the model was close to the Faster R-CNN, SSD, YOLOX-Nano, but the Params were reduced by 135.97, 22.89, and 0.18 M, respectively, the FLOPs were reduced by 153.69, 86.73, and 0.14 G, respectively, and the detection speed increased by 36.04, 13.22, and 23.02 fps, respectively. In addition, the detection performance of the model was tested in the complex environments, such as different lighting, different occlusion, multi-scale targets, and new environments. The results showed that the mAP was 99.50% in the nighttime environment, the average mAP was 93.53% under the three occlusion conditions, the average mAP was 98.77% under the medium and small targets, the detection rate was 84.62% in the generalization test, and the false detection rate was 7.69%. To sum up, the improved model can fully meet the high requirements for the accurate and real-time monitoring of cows' oestrus behavior under complex breeding environments and all-weather conditions, due to the lightweight, high precision, robust, and high generalization.

image recognition; behavior; model; oestrus detection; channel pruning; YOLO v5n; cows’ mounting behavior; complex environment

10.11975/j.issn.1002-6819.2022.23.014

TP391.4

A

1002-6819(2022)-23-0130-11

王政,許興時,華志新,等. 融合YOLO v5n與通道剪枝算法的輕量化奶牛發情行為識別[J]. 農業工程學報,2022,38(23):130-140.doi:10.11975/j.issn.1002-6819.2022.23.014 http://www.tcsae.org

Wang Zheng, Xu Xingshi, Hua Zhixin, et al. Lightweight recognition for the oestrus behavior of dairy cows combining YOLO v5n and channel pruning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(23): 130-140. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.23.014 http://www.tcsae.org

2022-09-28

2022-11-07

國家自然科學基金項目(32272931);陜西省技術創新引導計劃(2022QFY11-02)

王政,研究方向為智能化檢測與技術。Email:wang_zheng@nwafu.edu.cn

宋懷波,博士,教授,研究方向為圖像處理。Email:songhuaibo@nwafu.edu.cn

農業工程學會高級會員:宋懷波(E041201025S)