風險情景下人工智能技術信任機制建構與解析

孫麗文,李少帥

(河北工業大學經濟管理學院,天津 300401)

0 引言

在移動互聯網、云計算等新興理論和技術共同驅動下,人工智能跨越應用紅線,與實體經濟深度融合,對社會經濟發展和產業轉型升級產生深刻影響[1]。但是人工智能的數據依賴性、算法黑箱性、自主決策性及高度開放性技術特征使其在為人類社會帶來好處和便利、推動社會經濟持續發展同時,也引發了數據安全、隱私保護、算法歧視等風險問題[2],給社會、企業和個人層面均帶來嚴重風險挑戰。這些風險問題多與技術信任密切相關、相互交織,在很大程度上可歸結為技術信任挑戰,如由于算法運行存在 “黑箱”,可能連設計者也難以完全理解其具體過程,更無從知曉算法運行最終結果以及潛在風險性,導致對人工智能技術置信鏈條斷裂,迫切需要通過技術信任修復和重構置信鏈條。

當前學界對人工智能風險及技術信任探討可歸結為兩個方面:①以風險為分析重點,討論人工智能如何引發技術風險、社會風險、道德風險及法律風險等[3-4]。②以技術信任為分析重點,探討人工智能對信任的沖擊。如Marcus等[5]認為隨著越來越多決策權力逐漸向不可靠的機器轉移,人類無法充分相信狹義的AI系統。孟筱筱[6]從風險理論出發,認為人工智能信任問題與它所蘊含的技術風險、社會風險、道德風險和法律風險密切相關,因此需要加強人工智能風險治理和信用體系建設。整體看,現有研究依然呈現碎片化并缺乏深度性,且鮮有將技術信任置于風險情景下的詳細探討。人工智能作為最具變革性的新興技術,其獨特的技術信任機制尚未形成。關于人工智能技術信任機制該如何建構?應涵蓋哪些具體內容?又該如何解析該技術信任機制及運行規律?以上問題都亟待深入研究。

可見,無論是實踐運用還是理論研究,人工智能風險都與技術信任共生依存,鑒于其強烈的系統破壞性和長期影響性,探索風險情景下人工智能技術信任機制顯得更加緊迫和必要。基于此,本文對人工智能技術信任這個極具前沿性和重要研究價值的問題進行探討,嘗試建構人工智能技術信任機制,并進一步對該技術信任機制深度解析,以回應上述問題。

1 文獻研究與述評

1.1 技術信任內涵

技術信任文獻研究表明其內涵要視技術創新發展和實際應用情景而定。一方面,以McKnight等[7]為代表的學者認為技術信任指對技術本身或者技術功能的信賴。Paul[8]認為技術信任具有多維結構,包括機密性、身份認證性等7個維度。袁勇等[9]進一步將技術信任從技術本身拓展至技術功能,認為技術信任體現為技術創新發展使人們對特定領域或者事物所形成的更高程度信賴,如區塊鏈技術能夠為保障信息不被刪除和篡改提供解決方案。

另一方面,不同情景下的技術信任都有具體含義。Markus等[10]認為共享經濟情境下,技術信任是消費者對共享平臺的技術設施與控制機制在支撐溝通、交易和協作中重要意義的高度認可。技術信任源于消費者與技術的交互過程,本質上屬于依賴關系。而在電子商務情景下,技術信任與控制信任類似,都屬于非雙方信任形式,但與控制信任以提供治理結構為根本保證不同,技術信任主要提供情景規范和促進條件,更加關注技術溝通平臺的安全性。嚴中華等[11]認為技術信任是主體相信能夠通過技術設施安全和控制機制實現交易的信念。風險情景下,技術信任既是化解特定風險的戰略導向和具體方法,也是對風險外部因素的內心估量。實際上技術信任不僅體現為與風險緊密相連性,且更體現為技術安全可控和科技向善性。基于以上分析,本文將風險情景下技術信任界定為 “技術透明度較高、可解釋性較強,技術風險責任明確,符合人類倫理道德,及由此獲得的社會公眾對技術的肯定和認同。”

1.2 技術信任影響因素

探索技術信任影響因素是建構技術信任機制的前提和基礎。本文通過對相關研究成果梳理和核心觀點提煉,發現技術信任主要受技術進步和環境規制兩大因素影響。①雖然人工智能風險愈演愈烈,但同時風險治理技術手段也在不斷突破創新。作為精準高效的治理工具,技術的嵌入使風險治理更加安全透明[12],同時在該過程中正向反饋不斷積累,置信鏈條得以重構, “需求-基礎-效果”的正向循環持續強化[13]。此外,人工智能本身也是重塑技術信任的利器,領先企業開始通過數據篩選、算法設計及模型優化等方式著力解決隱私泄露、算法偏見等問題,以切實發展可信任人工智能。可見,技術作為相對穩定的 “著力點”,能夠匹配技術信任內在需求,成為影響技術信任的重要因素;②倫理道德、行業共識和法律規范等成為環境規制體系的有機構成,將技術信任深深烙印于人工智能,持續調試和矯正人工智能技術演進方向[6],同時環境規制體系還明確了風險治理失效后的責任主體及懲處措施,以確保相關主體為其行為承擔責任,從而進一步強化社會公眾的心理認同。

對技術信任影響因素的相關探討為人工智能技術信任機制構建與解析提供了思路,即技術信任建立不僅需要設定明確的性能指標,努力提升技術安全性、透明性等,且需要外部環境的有效監管。當然僅從現有文獻出發難以獲得技術信任的完整理論解釋,還要進一步結合人工智能的技術屬性和實際發展情況予以具體考慮。

2 人工智能技術信任機制建構

縱觀現有技術信任研究并考慮人工智能風險深刻而長遠的影響,本文認為人工智能技術信任機制構建屬于復雜的系統性工程,既需要明確主導范式、厘清重要參與者,又要落實提升技術性能的目標,同時也要建立切實有效的規制體系。但已有研究尚不能全面深刻地詮釋人工智能技術信任機制的本質,對于技術信任范式如何選擇?技術信任參與主體如何構成?技術信任目標是什么?技術信任環境體系如何建立等問題缺乏研究。因此,本文圍繞以上問題,在梳理和凝練既有技術信任相關文獻基礎上,擬從主導范式、能動主體、核心愿景和規制體系4個維度構建人工智能技術信任機制模型。

2.1 確立技術信任的主導范式

技術信任主導范式主要回應 “根據什么實施技術信任”的問題。人工智能技術在與社會生態系統交互過程中引發了嚴峻的風險挑戰,加劇了雙方的矛盾。傳統創新更多聚焦于技術先進性、可行性,以及由技術商業化帶來的巨額收益和效率提高,市場成功被視為重要評價標準,但由于對創新過程中的人身危害、倫理道德沖突等風險的忽視,無法滿足創新可持續發展和社會公共價值實現。不同于傳統創新范式將技術創新驅動經濟發展的正向推演邏輯為基本假定,責任式創新認為在創新初期就應引入有關風險及其危害的批判性探討,并在深入推進技術商業化過程中實現風險治理和對技術的信任[14]。因此,風險情景下人工智能技術信任迫切需要以責任式創新為 “羅盤”,讓技術接受價值引導。

責任式創新首次在國家層面提出源于對納米科學領域的風險管控和信任需求[15],并由歐盟委員會在 “地平線2020框架計劃”中將其確定為 “責任式創新”[15]。針對新興技術引發的風險,責任式創新以科技創新活動雙重性、結果不確定性為基本假定[16],在關注技術先進性、可行性和經濟效益基礎上,更加重視對新興技術的風險防范,同時承認創新主體能力局限并主張更廣泛利益相關者的共同參與[17]。責任式創新作為構建人工智能技術信任機制的起點,為應對化解風險,加快實現人類對人工智能的技術信任提供了方向性指引。

2.2 明確技術信任的能動主體

技術信任能動主體主要回應 “人工智能技術信任機制的參與主體是誰”的問題。首先,技術信任機制需要頂層制度框架搭建。國家和政府具有最強權威和公信力,不僅從國家層面統領人工智能技術研發與治理框架搭建,而且通過設立專業管理機構,政策發布和法律規制等進行防控[2],在人工智能技術信任機制構建過程中具有領導和監管作用;其次,技術信任機制需要行業組織的推動和協調。行業組織能夠參與到多方服務、促進溝通、關系協調等諸多環節,發揮橋梁作用;再次,技術信任機制需要行業相關企業自律。企業以聯盟、行業規范等方式履行行業自律,綜合實力強大的科技型企業更以強烈使命感投身信任機制構建,成為人工智能技術信任機制建立的中堅力量;第四,技術信任機制需要學界的支持。作為教育者和反思者,學界在在承擔知識生產和傳播同時,積極倡導 “責任式創新”,更加關注廣泛情景下的新興技術風險治理[17],為人工智能技術信任提供智力支持;最后,技術信任建立還需要社會公眾的廣泛參與。通過多種正式和非正式渠道對人工智能技術信任具體內容進行監督、討論和反饋。

2.3 聚焦技術信任的核心愿景

技術信任核心愿景主要回應 “技術信任目標是什么”的問題。人工智能技術信任核心愿景直接決定了技術能力提升的施力方向。基于技術信任對技術能力從低級到高級的需求邏輯,即技術蘊含的經濟價值得到充分釋放[18],技術具備較強魯棒性,即使在異常和危險情況下,依然能夠安全平穩運行[19],技術及運行原理能夠被認知和理解[20],人類能夠在較大程度上掌控技術創新與應用發展趨勢[21],人類有能力明確技術責任主體并予以督促和監管[22]。本文提出人工智能技術信任的5個核心愿景,即技術可用性、技術可靠性、技術可知性、技術可控性和技術可追責。

(1)技術可用。人工智能首要目的是增加人類社會福祉。因此,一方面,技術可用性意味著人工智能技術發展及應用要體現人類根本利益至上的原則,其研發和應用應維護人類尊嚴、保障人類權利及自由,促進技術紅利得到合理分配,縮小數字鴻溝,同時也要降低技術風險和對社會的負向影響,以及提倡和平使用人工智能,避免致命性智能武器的軍備競賽[23];另一方面,技術可用性意味著人工智能與人類應是和諧共生關系,人工智能應以保障和改善民生為根本出發點,創造出更大數字福祉,使人類更加健康、快樂和幸福。此外,技術可用性還意味著包容性和公平正義性。即需要賦能予人,讓弱勢群體也能共享人工智能技術帶來的巨大紅利。

(2)技術可靠性。人工智能技術可靠性體現為在模擬和實際應用情景都能夠抵御惡意網絡攻擊等突發因素,實現運行的安全與穩定。模擬測試情景下,需要足夠多的硬件系統測試和算法風險測試,尤其針對醫療等可能造成人身傷害的行業領域,不僅必須通過極端的器械可靠性測試,而且要通過對可能的算法特征引起風險的針對性測試;實際應用情景下,不僅要考慮正常算法和數據輸入情形,也要考慮異常情形下人工智能是否具有較強的容錯能力,確保數字網絡安全、生命財產安全及社會秩序穩定。

美國國際互聯網安全系統公司在20世紀曾經提出了P2DR (Policy Protection Detection Response)、P2DR2 (P2DR + Restore)等安全模型,把信息系統安全解釋為在安全策略引導下,打造以防護、檢測、響應及恢復為一體的動態循環。這些模型能夠為技術可靠性提供很好的思路借鑒,本文將P2DR模型引入人工智能技術可靠性分析,結合人工智能特點對各要素內涵進行了重新界定并構建適用于人工智能的技術可靠性模型,如圖1所示。①安全策略是人工智能技術可靠性的核心,是所有防護、檢測和響應實施的根本依據。安全策略的最終目的在于實現自主性決策和風險治理的平衡,找到兩者的最優動態解。②安全檢測是人工智能技術系統動態響應和增強防護的依據,能夠洞察技術危險和漏洞并通過循環反饋進行響應。③安全防護通過定期檢查、訪問控制、監視等手段發現人工智能技術存在的系統脆弱性等潛在風險,常用手段包括數據加密、VPN、安全掃描等。④安全響應,即當人工智能算法決策超出人類理解范圍甚至可能產生失控時,需要人類及時且有效地介入和接管,當風險程度極高甚至有可能導致不可逆后果時必須設置 “切斷開關”,以迅速終止人工智能算法。

(3)技術可知性。人們對技術的信任在很大程度上源于對技術本身的理解。然而新一代人工智能屬于多層神經網絡,不同變量之間關系千絲萬縷,算法呈現涌現性和自主性的復雜特征,有時連研發人員都無法理解其運行方式,導致 “黑箱”現象。 《Science》雜志也認為算法 “黑箱”可能會導致嚴重的系統性風險并將破解 “黑箱”視為人工智能領域的重大難題[24]。

提升技術可知性需要兼顧不同主體對于認知性的需求差異。其中研發人員對人工智能技術原理有著最為深層和強烈的認知需求,需要深耕可理解、可解釋的算法模型并借助技術手段將 “機器理解層次”降維至 “人類理解層次”,使人工智能重回 “人類尺度”,從技術層面部分解決 “黑箱”問題。其他主體對技術可知性需求集中體現為對人工智能技術關鍵環節的理解,為此需要政府、學界及領先企業共同探索制定技術操作和解釋標準,同時也應為社會公眾參與創造機會,確保社會公眾切實成為提升技術可知性的積極參與者。此外,提升技術可知性也需要對可能產生較大風險的環節提供必要且適當的說明或解釋 (包括背后的邏輯和數據),但同時應避免因過渡透明化或片面強調技術的完全可知性,影響甚至阻礙人工智能技術創新和社會進步,即遵循適度的公開透明性原則。

(4)技術可控性。技術可控意味著人工智能創新及規模化應用應置于人類合理控制之下,能夠根據技術及其對社會經濟發展的影響衡量或評估風險性,并及時采取技術管控措施,防止因人工智能對社會經濟結構的深度嵌入而無法被有效治理,即出現 “科林格里奇”困境[25]。在技術層面,技術可控性要求勇闖科技前沿的 “無人區”、攻克由人工智能高度開放性、自主決策性等形成的 “卡脖子”技術難關,構建技術風險評估框架,把風險指標化、定量化,為技術風險測度及方案制定提供借鑒。同時,要通過技術手段對高風險人工智能技術實施最高等級管控,如在人工智能技術系統中嵌入具有可中斷性能力的程序命令或技術模塊等。在實踐層面,技術可控性要求提前制定完備的技術應對方案和響應策略,在最短時間內精準鎖定風險的技術根源,將風險損失降至最低。雖然,目前還無法預測強人工智能能否實現以及如何實現,但依然不能掉以輕心,應謹慎對待和預防,因此技術可控還意味著建立風險警示體系,超前布局對未來可能形成的強人工智能風險的防范。

(5)技術可追責。技術追責不僅作為風險治理失敗時的懲罰機制,更重要意義在于通過技術追責追溯隱患原因并明確責任,尤其當風險侵害導致倫理與法律產生較大沖突時,能通過技術對相關責任主體實施問責并且建立賠償體系,促進風險治理的公平合理性并完善技術信任機制。 《人工智能白皮書-通往卓越與信任的歐洲之路》中明確指出 “技術追責是高風險人工智能監管的重要措施,同時也是構建可信任生態系統的必要環節”[26]。實際中需要政府秉持 “權責一致性”的原則,塑造 “成果共享、責權同擔”的責權體系[27]。這意味著權利覆蓋范圍即是風險責任范疇,如設計者需要對開發階段的風險隱患擔責,使用者需要對使用階段的風險隱患負責,同時也意味著即使無法解釋人工智能產生的結果,使用該人工智能技術的主體同樣需要對此負責。此外,歐盟 《人工智能白皮書》和國家人工智能標準化總體組 《人工智能倫理風險分析報告》都要求責任主體在合理期限內留存人工智能設計和使用的算法、數據等信息,以利于在形成侵害時審查和明確責任歸屬[28]。

2.4 完善技術信任的規制體系

技術信任規制體系主要回應技術信任的外部環境如何監管的問題。監管方式囊括社會習俗、倫理道德、行業共識、法律規范 (公司法、刑法等)及國際公約等。根據作用性質差異可分為柔性規則和剛性規則兩種約束體系,倫理和法律分別成為柔性規則和剛性規則的核心內容。 “柔性的倫理”和 “剛性的法律”共同構成人工智能技術信任規制體系兩大支柱。同時,因法律和倫理均存在缺陷,因此需要持續完善和暢通現有規制體系,切實發揮其風險防范和管控的應有作用。

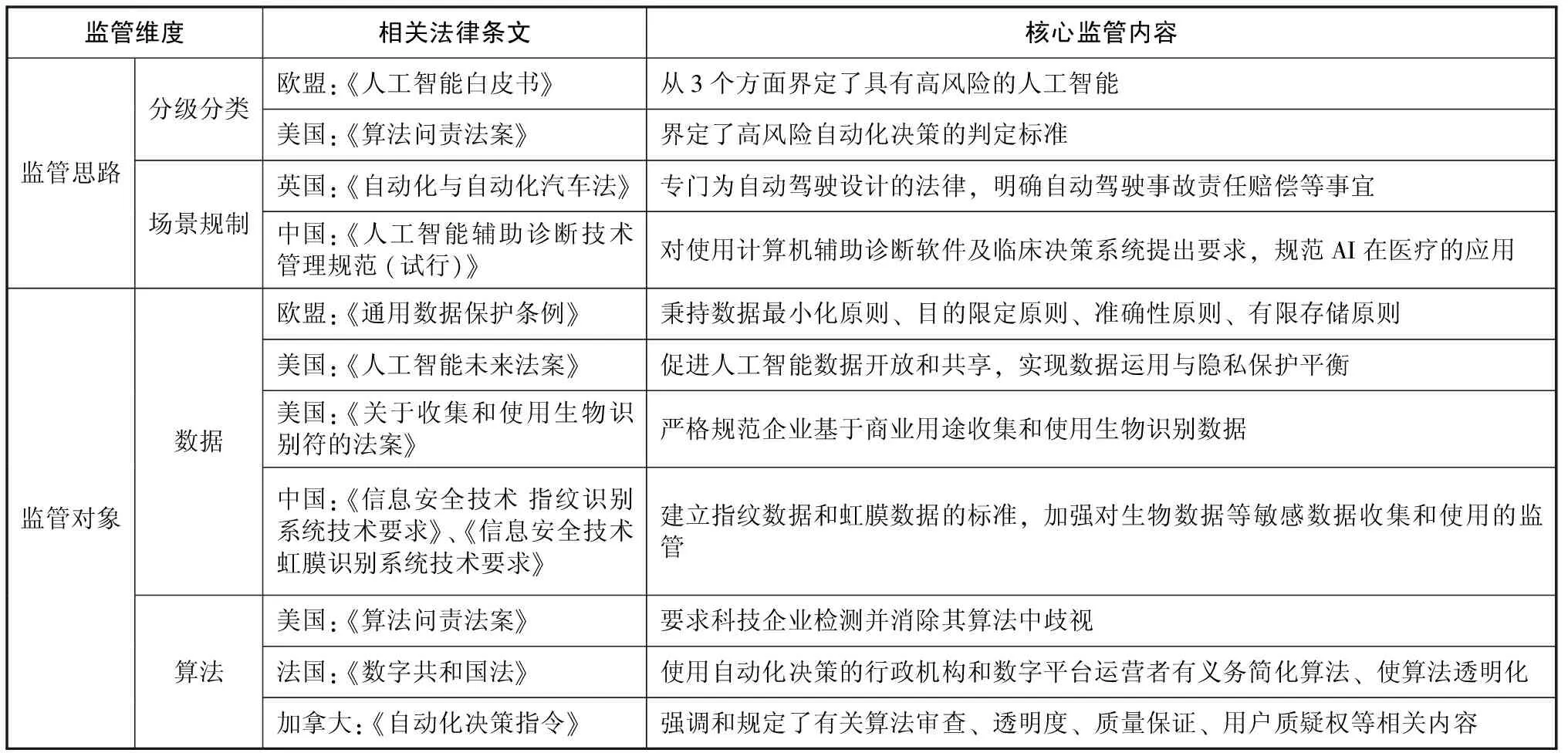

(1)以法律為保障的風險防控體系。法律以國家強制力劃定底線,在大力破除人工智能發展現實障礙同時,進一步聚焦對人工智能風險的化解,推動發展負責任的人工智能。以法律為保障的風險防控體系需要充分考慮國際競爭、社會經濟價值等因素,保證技術紅利最大化釋放,以形成較強的人工智能產業競爭力,避免因偶發性的負面問題而采取激進監管。由于法律以風險為導向,其監管力度與風險危害等級相匹配,同時將人工智能在具體領域 (自動駕駛、醫療等)的風險特征視為技術溯源依據和法律制定之根本。因此,采取 “分級分類”和 “場景規制”相結合的監管思路成為實施法律約束、推動技術信任的最佳拍檔。

數據和算法既是推動人工智能技術蓬勃發展的關鍵 “燃料”,也是引發風險的 “導火索”,因此數據和算法成為立法監管重點對象,而算力的純技術性使其較少受到法律關注。數據立法與監管方面,新興技術的運用使數據富含價值越來越大,但同時海量數據的收集、深度分析及應用觸動了人類隱私權、知情權等根本利益,為此歐盟于2018年頒布 《通用數據保護條例》,不僅直接推動人工智能數據風險治理的立法進程,而且成為美國、印度等國家制定數據保護法律的重要范本。同時,鑒于生物數據的特殊性及戰略意義,包括中國、美國等在內的許多國家尤其重視針對生物數據的監管和風險防范,中國信息安全標準化技術委員會頒布 《信息安全技術 指紋識別系統技術要求》[29]和 《信息安全技術 虹膜識別系統技術要求》[30]。算法立法與監管方面,透明和責任成為關鍵內容,美國、法國和加拿大分別制定法律對算法透明性和問責性等內容予以規范。

本文根據中國信息通信研究院與中國人工智能產業發展聯盟發布的 《人工智能治理白皮書》[31],從監管維度、法律條文和監管內容3個方面歸納人工智能法律監管框架,見表1。由于人工智能風險法律風險防控體系初步形成,存在法律條例沖突、違法行為難認定、量刑分歧及整體立法進程緩慢等問題,需持續修訂與改進。

表1 人工智能的法律監管框架

(2)以倫理為導向的社會規范體系。由于人工智能具有數據依賴性、算法黑箱性及自主決策性等特征[31],加之法律滯后性、 “一刀切”的極端性、作用范圍有限等局限,使技術信任規制體系建立不能僅依靠法律規范,而需要法律和倫理的同心戮力。人工智能本身雖沒有倫理道德品質,但技術研發者可通過算法設計、數據選擇、模型優化等方式賦予其倫理價值,因此人工智能技術并非中立,其中飽含人類對于現在和未來的思考及決定,非常有必要通過充分發揮倫理道德作用使其接受價值引導,使技術從誕生便承載一定價值傾向,讓倫理道德內化于人工智能技術結構之中,釋放向善潛力。

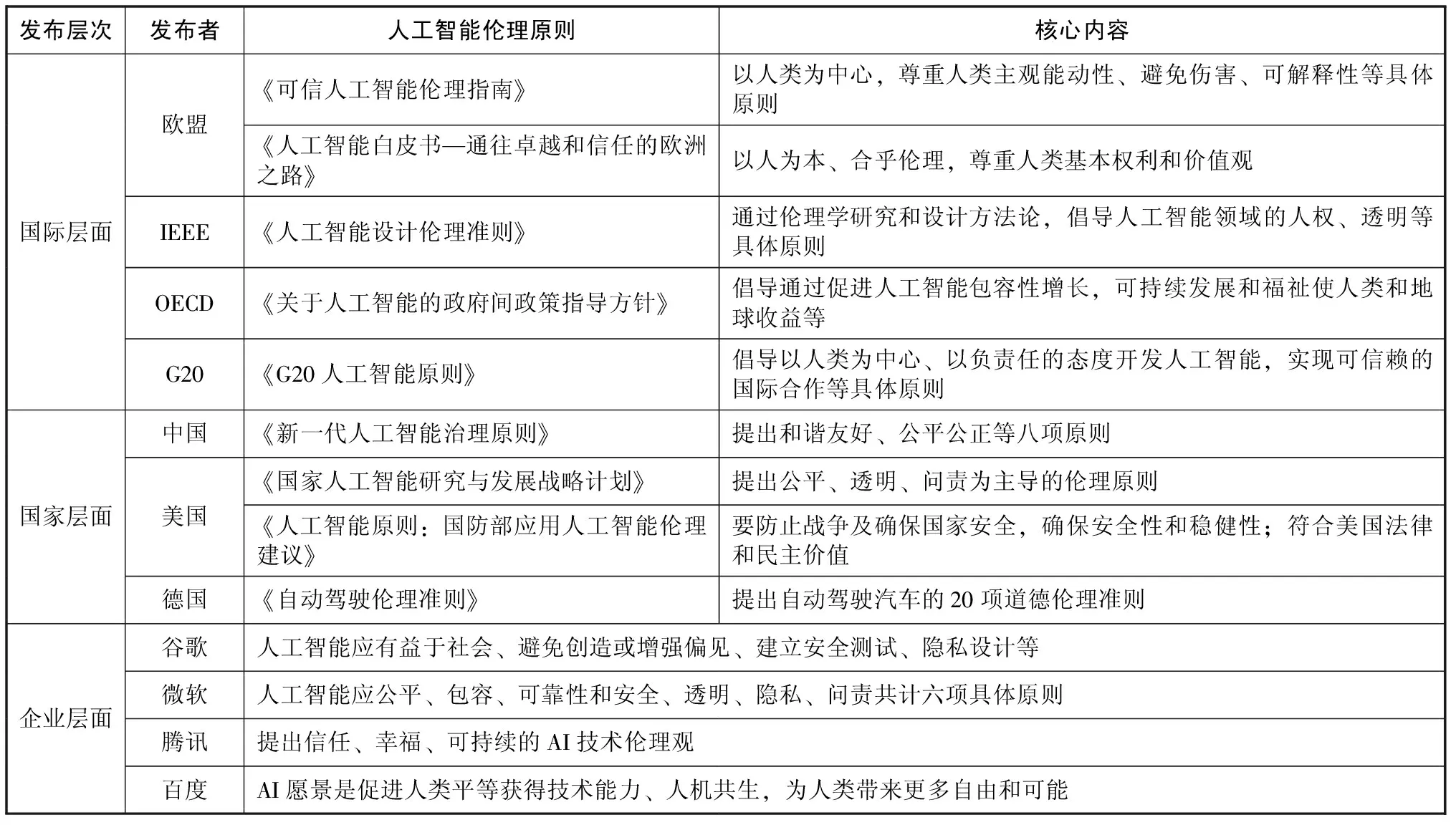

目前,人工智能數據安全、算法歧視等風險已成為國際社會的焦點問題,引發對風險治理和技術信任的倫理反思和討論[32]。國際組織、國家機構及領先企業紛紛提出倫理原則或框架,以促進知識共享和可信AI構建。在國際層面,為確保歐盟具有與人工智能發展相適應的倫理框架,起草了人工智能倫理指南 (AI Ethics Guidelines)[33];在國家層面,英國已經成立數據倫理和創新中心 (CDEI),視倫理為人工智能創新管理的核心之一并考慮制定普適的倫理體系。中國頂層設計政策也要求制定促進人工智能發展的倫理規范,并于2019年6月份頒布 《新一代人工智能治理原則》,發展負責任的人工智能[34];在企業層面,Google、騰訊等領先企業針對人工智能負外部性影響,紛紛提出各自的AI價值觀,并通過設立內部監管機構、履行倫理使命,竭盡全力贏得社會公眾對人工智能和企業的信任。本文同樣在 《人工智能治理白皮書》基礎上,從倫理發布層次、發布者、倫理原則名稱及核心內容4個方面歸納人工智能倫理規范體系,見表2。與風險防控體系相比,社會規范體系更加靈活,但仍需在打通多層面的倫理認知、強化倫理共識、注重倫理實際效能等方面付出努力。

表2 人工智能多層次倫理規范體系

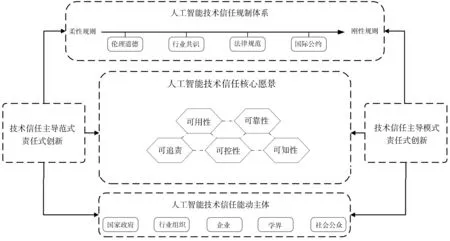

人工智能技術信任機制需要以 “責任式創新”為主導范式,以國家政府、行業組織、企業、學界及社會公眾為能動主體,將可用、可靠、可知、可控和可追責作為人工智能技術信任的核心愿景,同時充分發揮法律規范和倫理約束的功能。本文歸納構建了人工智能技術信任機制模型,如圖2所示。

圖2 人工智能技術信任機制——1P3W模型

3 人工智能技術信任機制解析

以貝克[35]和吉登斯[36]為代表的風險社會理論認為風險和信任相互交織,技術信任的實現得益于主體、技術、環境3個要素的共同發力,但人工智能引致的風險破壞了人與機器之間的置信鏈條,現有主體、技術和環境的 “三重奏”既不能為風險情景下人工智能技術信任重建提供明確且合適的范式依據,亦不能滿足技術信任機制研究的細化與深化,而必須從宏觀層面的要素構成深入微觀層面的內在交互。為此,需要以責任式創新為首要導向,充分激活能動主體、核心愿景和規制體系的內在交互屬性,釋放科技向善潛能。責任式創新范式滲透于能動主體、核心愿景和規制體系,促進能動主體通過協同克服自身局限,并引導愿景目標的相互聯結和規則體系融合。

3.1 通過多元主體協同,塑造值得信賴的治理群落

風險情景下人工智能技術信任要在治理過程中實現,但由于人工智能屬于綜合性和交叉性極強的復合型前沿學科,涉及領域極為廣泛,需要計算機科學、神經科學、社會科學等多學科的深度融合[37]。同時,技術信任也更加依賴于多元化主體的相互協同。責任式創新范式為探索多元主體參與的協同共治提供了關鍵性行為準則:基于主體功能局限性和治理需求 (專業化、多元化、敏捷化)的多元主體密切合作。

盡管目前許多國家都設立了相應的政府監管機構,但這些監管機構本質上屬于政治實體,難以全面和深刻理解人工智能風險及治理的復雜性,因此國家政府需要與具備專業知識的共同體形成有效聯動,打造專業治理團隊,以促進技術信任和提升公信力。同樣地,行業組織、企業、學界以及社會公眾由于知識儲備、思維方式等方面的局限,也難以憑借一己之力力挽狂瀾,而唯有通過相互協同,在風險治理過程中深化交流與合作,進一步鞏固和拓展既有知識體系,才能克服自身局限性并滿足人工智能專業化、多元化和敏捷化的風險治理需求,從而形成可信賴的治理群落,通過信任于人增強技術信任。

3.2 通過實施目標聯結,形成安全負責的人工智能技術體系

從純技術創新和技術功能升級而言,由于人工智能技術創新和功能升級的內在聯系性,各愿景目標并不是孤立存在,而是本質上相聯結。風險情景下更需要將責任式創新范式作為實施愿景目標聯結的方向,以明晰其內在邏輯關系,形成安全負責的人工智能技術體系。①可用性是其他目標實現的首要前提,唯有可用才能創造價值,即責任式創新范式所強調的技術領先可行和經濟效益增加[17]。技術特征、應用領域和實施路徑都對可靠性、可知性、可控性及追責產生深刻影響;②可靠性是其他目標實現的安全屏障。一方面從技術層面防范惡意網絡攻擊等風險,確保人工智能在可用性的基礎上更加安全穩定[38];另一方面可靠性往往需要通過足夠多的、嚴格的、多情景的軟硬件測試以建立相應安全模型,同時其實施過程也為可知性和可控性奠定了操作基礎;③可知性是其他目標實現的關鍵環節。可知性和其他愿景目標均存在聯系,對技術信任具有全局性影響,很大程度決定了人類對AI的整體信任;④可控性是其他目標實現的應有之意。與可知性更多聚焦技術層面的論述不同,可控性不僅體現在對人工智能的技術控制能力,而且體現在對其風險具有較強的防范治理能力[21]。提升可控性有助于優化技術安全模型、增加可靠性,同時可控性屬于高級認知性,該過程也必然伴隨認知能力的顯著提升;⑤可追責是其他目標實現的補充和完善。追責機制能夠在風險治理失敗時明確責任和賠償,迫使各利益相關者重新審視自身責任與使命[22],反思如何更好實現可用、可靠、可知和可控,從而持續完善技術信任機制。

3.3 通過規則體系融合,提供剛柔并濟的環境保障

風險情景下,以法律為保障的風險防控體系和以倫理為導向的社會規范體系作為技術信任規制體系的架海金梁,本質上代表著以法律為中心的 “剛性規則”和以倫理為中心的 “柔性規則”。責任式創新認為新興技術的治理和信任獲取需要法律規范的約束與道德倫理的認同[39]。在此基礎上,本文進一步認為這兩種規則都有各自的適用范圍和獨特的作用方式,并在推動技術信任形成的過程中互相配合、促進和補充。

一方面,在人工智能技術發展的關鍵要素 (數據和算法)和發展較充分、風險相對確定的領域 (如自動駕駛和醫療)形成了以法律為主導的融合路徑。法律通過將某些倫理道德法律化,并使之規范化、制度化,并以國家強制力為背書,運用國家強制力來保障規則體系融合的內容能夠順利實施。如歐盟 《通用數據保護條例》第35條就明確要求數據使用者在應用人工智能進行自動化決策處理時,必須評估數據可能帶來的風險影響;另一方面,在人工智能技術尚不充分、風險錯綜復雜的領域形成了以倫理為主導的融合路徑。倫理將遵守法律作為倫理道德要求來倡導,對違法亂紀的行為加以譴責,如包括歐盟委員會高級專家組發布的 《可信人工智能倫理指南》、IEEE發布的 《人工智能設計倫理準則》及 《G20人工智能原則》等許多現行AI倫理都明確指出法律對倫理作用的充分發揮有極強的催化效應。此外,脫離法律局限性的倫理更易引發能動主體對風險情景下技術信任的共鳴與深刻探討,不僅有助于形成發展負責任人工智能的倫理環境,而且為實驗性規范立法的起草積攢經驗[40]。

4 結論與貢獻

(1)從主導范式、能動主體、核心愿景和規制體系4個維度構建人工智能技術信任機制模型,為風險情景下深入開展人工智能技術信任研究提供分析框架。由于人工智能技術信任涉及范圍較廣且高度復雜,現有研究難以全面深刻反映其邊界和關鍵構成,本文所建立的1P3W模型以責任式創新為主導范式,在充分借鑒現有責任式創新研究成果基礎上[15-17],進一步把技術引發的風險治理納入分析范疇。以國家政府、企業等為能動主體,在明確各自職能的同時,更注重能動主體的共同參與及整體效能;以對技術能力從低級到高級的需求邏輯為依據,將技術信任的核心愿景歸結為可用性、可靠性、可知性、可控性和可追責;以環境監管的作用性質為依據,將技術信任規制體系分為以法律為保障的風險防控體系和以倫理為導向的社會規范體系。本文所構建的技術信任模型從多個維度厘清技術信任邊界,突出技術信任關鍵構成,為人工智能技術信任提供評估準則和分析框架,有效彌補現有研究的不足,為實現人工智能技術信任提供方向性指引。

(2)解析人工智能技術信任機制的運行過程,揭示技術信任內在交互規律,對于豐富和細化人工智能技術信任的現有研究成果,促進人工智能技術信任的深入研究具有重要意義。雖然現有研究已經涉足人工智能技術信任的主體、技術和環境要素[2,16,32],但是尚未深入探索各維度的內在交互性,同時也缺乏將各要素納入整體分析范疇的相關研究。本文將責任式創新范式引入人工智能技術信任研究,并詳細探討各維度如何通過內部互動推動人工智能技術信任實現,研究發現:責任式創新范式貫穿整個技術信任機制運行過程,滲透于能動主體、核心愿景和規制體系,可充分激活主體、愿景和規制體系內在交互屬性,釋放科技向善潛能。多元主體之間通過相互協同,共同塑造值得信賴的風險治理群落;五大核心愿景通過相互聯結,形成安全負責的技術體系;以法律為核心的 “剛性規則”和以倫理為核心的 “柔性規則”相互配合、促進和補充,通過規則體系融合為人工智能技術信任提供剛柔并濟的環境保障。