基于雙判別器加權生成對抗網絡的圖像去模糊方法

黃夢濤,高 娜,劉 寶

基于雙判別器加權生成對抗網絡的圖像去模糊方法

黃夢濤,高 娜,劉 寶

(西安科技大學 電氣與控制工程學院,陜西 西安 710054)

原始生成對抗網絡(generative adversarial network, GAN)在訓練過程中容易產生梯度消失及模式崩潰的問題,去模糊效果不佳。由此本文提出雙判別器加權生成對抗網絡(dual discriminator weighted generative adversarial network, D2WGAN)的圖像去模糊方法,在GAN的基礎上增加了一個判別器網絡,將正向和反向KL(Kullback-Leibler)散度組合成一個目標函數,引入加權的思想調整正向和反向KL散度的比例,利用兩個散度的互補特性,在學習清晰圖片過程中避免不良模式的形成。實驗結果表明,與現有方法相比,本文方法能更真實地恢復圖像細節部分,且在評價指標峰值信噪比和圖像結構相似度上有更好的表現。

生成對抗網絡;加權;雙判別器;圖像去模糊;

0 引言

圖像去模糊技術是指將得到的模糊圖像通過一定技術恢復出它所對應的清晰圖像。目前圖像去模糊在智能監控[1-2]、無人機[3]、遙感影像[4-5]以及醫療圖像[6]等領域具有很重要的作用。由于拍攝設備晃動或者目標物體的運動,難免會獲得模糊的圖片,不利于后續的處理。因此,對圖像去模糊技術的研究具有一定的現實意義。

傳統的圖像去模糊方法一般假設模糊核已知,利用模糊核與模糊圖像進行反卷積得到清晰圖像。此類方法為非機器學習的方法,其中起源較早、應用最為廣泛的經典圖像去模糊方法之一為LR(Lucy-Richardson)算法[7-8],它假設模糊圖像服從泊松分布,通過最大似然估計迭代求解得到復原圖像。在簡單圖像中,LR算法可以有效還原出清晰圖像,但圖像較復雜時,復原的圖像容易產生振鈴效應,隨著迭代次數的增加,振鈴效應趨于嚴重。

隨著機器學習與圖像處理技術的快速發展,尤其是2014年生成對抗網絡[9](Generative Adversarial Networks,GAN)的出現,使得圖像去模糊應用不再需要假設模糊核信息,因此,機器學習方法為圖像去模糊的發展開闊了思路。GAN主要應用在圖像超分辨率重建、遷移學習、圖像修復等領域[10-13]。GAN中生成器所定義的損失函數等價于真實分布data與生成器生成分布G之間的JS(Jensen-Shannon)散度,優化過程中會產生梯度消失和模式崩潰的問題,導致訓練不穩定,影響去模糊效果。Kupyn等人將條件生成對抗網絡[14]應用到圖像去模糊中,對Isola等人提出的Pix2Pix網絡框架做出適當修改,提出Deblur GAN網絡[15],是目前圖像去模糊領域效果好的方法之一。相比傳統GAN,用此方法去模糊后有更好的視覺體驗,但在實驗中發現,使用Deblur GAN復原圖像時,會丟失部分細節信息。

針對上述問題,本文提出一種基于雙判別器加權生成對抗網絡(D2WGAN)的圖像去模糊方法,在原始生成對抗網絡的基礎上,額外加入一個判別器,將KL(Kullback-Leibler)散度與反向KL散度進行結合,并引入加權的思想重構目標函數,期望通過調節權值系數來平衡正向和反向KL散度的占比,更好地復原出清晰圖像。

1 本文方法

1.1 D2WGAN網絡結構

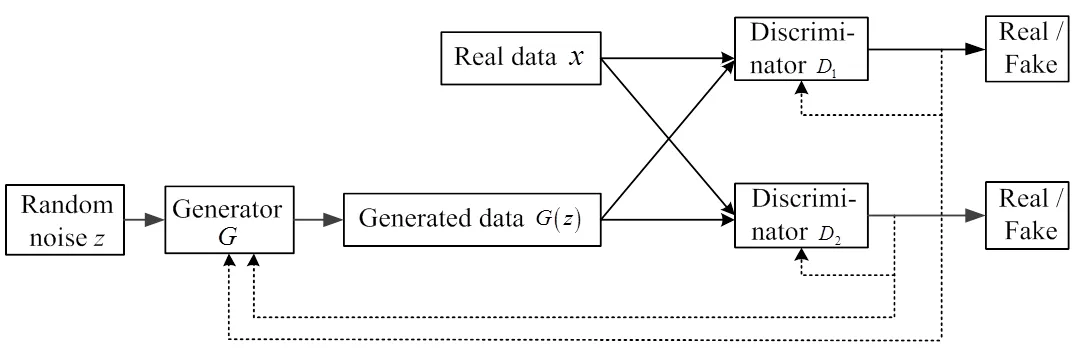

為提升圖像去模糊的性能,本文提出基于雙判別器加權生成對抗網絡(D2WGAN)的圖像去模糊方法,將真實分布data與生成分布G之間的KL散度和生成分布G與真實分布data之間的KL散度,即反向KL散度組合成一個目標函數。利用KL散度生成的數據會涵蓋真實數據的多種模式,然而,也會產生一些真實數據中不存在的樣本;而利用反向KL散度,生成的數據更傾向于真實數據的單一模式,會忽略其他模式,產生模式崩潰的問題[16]。因此,兩者相互補充,具有互補特性。理論證明,反向KL散度與JS散度具有相同的性質[17],因此本文在引入新的判別器后,在正向KL散度權值為0,反向KL散度權值為1時,理應和GAN具有相似的結果。如若將KL散度與反向KL散度結合,其互補特性會緩解GAN中的模式崩潰問題,因此,圖像去模糊的性能也必然會提升。

D2WGAN的模型結構如圖1所示,其輸入不再是原始GAN的噪聲數據,而是模糊圖片。生成器會依據輸入生成自己學習到的較為清晰的圖像(),隨后將生成器生成的圖像()以及模糊圖像所對應的清晰圖像輸入判別器1、2中。判別器1對清晰圖像得高分,對生成器生成的圖像()得低分;判別器2對生成器生成的圖像()得高分,對清晰圖像得低分。生成器的目的是使生成的()圖像同時欺騙判別器1、2,三者進行互相博弈,直到達到三者的平衡。、1和2都為多層感知器,整個模型通過反向傳播進行訓練。

圖1 D2WGAN網絡模型結構

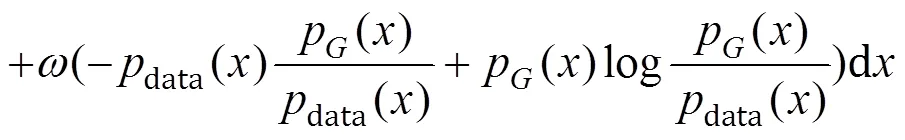

本質上,D2WGAN將與()之間的KL散度和反向KL散度進行加權融合,通過調節權值系數,從而達到更好的去模糊的效果。本文受雙判別器生成對抗網絡[16]的啟發,構建D2WGAN損失函數如下:

D2WGAN引入了兩個超參數和,其中+=1,0≤,≤1,引入加權思想,結合正向KL散度和反向KL散度的優勢,使生成的模式多樣化。

接下來驗證D2WGAN算法在最優判別器下,通過最小化模型與真實數據之間的KL散度和反向KL散度,生成器可以恢復出真實數據。

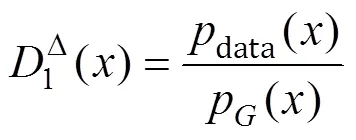

首先在固定生成器時,最優的判別器1D()和2D()為:

其次在最優判別器基礎上,最優生成器為:

因+=1,

理論證明在生成器能學習到最優判別器時,當且僅當P=data時,KL散度和反向KL散度為0,(,1D,2D)=-1,得到全局最小值,即生成模型學習到了真實數據分布。此時判別器無法區分生成分布與真實分布,對兩分布都返回相同的得分為1。

1.2 生成器模型搭建

本文研究的生成器模型如圖2所示,主要任務是在輸入模糊圖像時,學習清晰圖像的分布,生成的近似分布()。生成器模型具體搭建步驟如下:

1)對輸入的3×256×256的模糊圖片進行一次卷積核大小為7×7,卷積核數量為64,步長為1的卷積;一次實例正則化層和修正線性單元(Rectified Linear Unit,ReLU)激活函數。

2)兩個卷積核數量分別為128、256對應的卷積核大小為3×3,步長為2的二維卷積,實例正則化和ReLU激活函數。

3)9個由一個卷積核大小為3×3,卷積核數量為256,步長為1的卷積層,一個標準化層和一個ReLU激活層,一個Dropout層隨機失活比例為0.5組成的ResBlock塊。

4)兩個卷積核數量分別為128、64對應的卷積核大小為3×3,步長為1的反卷積,實例正則化和ReLU激活函數。目的是將卷積后的小尺寸高維度特征圖恢復到原始的尺寸。

5)為提高運算速度,本文生成網絡為全卷積網絡,不使用全連接層和pooling層,最后一層經過一次卷積核大小為7×7,卷積核數量分別為3,步長為1的反卷積,使用Tanh作為激活函數。

因使用Batch Normalization[18]進行標準化訓練可能會導致生成的圖像有偽陰影,而且在圖像去模糊中,去模糊效果依賴于模糊圖像對應的清晰圖像,本文使用Instance Normalization[19]進行歸一化操作可以加速模型收斂,并且保持每個圖像實例之間的獨立。

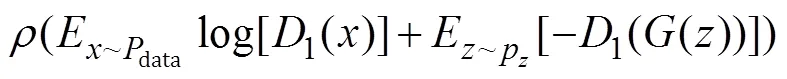

1.3 判別器模型搭建

普通的判別器最后一層為全連接層,輸出為輸入樣本來自真實數據的概率,即結果為一個實數。本文將普通的判別器換成了全卷積網絡,采用PatchGAN[20]判別器,將輸入映射為×的patch矩陣塊,將得到的patch塊求均值,為判別器最后的輸出,這樣在訓練的時候能更好的恢復細節。其中每一個patch塊代表了一個感受野,可以追溯到原圖的某一個位置。文中兩個判別器使用同一個網絡模型,因損失函數不同,其優化方向也不同。判別器模型結構如圖3所示,網絡結構如表1所示,輸入為256×256的三通道圖像,經過5層卷積網絡,卷積核大小均為4×4,輸出為一個30×30的矩陣,代表著圖像中一個比較大的感受野,相比于輸出單個值的鑒別器效果更好。非線性激活函數使用帶泄露修正線性單元(Leaky ReLU)[21],斜率設為0.2。

1.4 損失函數

本文使用對抗性損失和內容損失結合的損失函數,其中對抗損失著重于恢復圖像的紋理細節,感知損失著重于恢復圖像的內容。損失函數表達式如下:

=GAN+*X(6)

式中:GAN為對抗性損失;X為內容損失;為比重參數,文中設置為100。

對抗損失函數使用兩個判別器,這兩個判別器的模型結構基本相同,因其訓練時損失函數不同,所以這兩個判別器會朝著不同的方向優化。第一個判別器損失函數為:

式中:0≤r≤1,該判別器主要側重于真實數據。第二個判別器損失函數為:

圖3 判別器模型結構

表1 判別器網絡結構

式中:0≤≤1,該判別器主要側重于生成器生成的數據。兩個判別器之間通過加權連接,兩個參數之間關系為:+=1。

內容損失函數:采用Johnson等人提出的感知損失[22],該損失函數嚴格來說也是一種L2損失,多用在圖像風格轉換中。將清晰圖像和修復的模糊圖像分別輸入訓練好的VGG-19網絡[23],計算每一層特征圖之間的誤差,最終的累計誤差就是感知損失,計算公式如下所示:

式中:,j是VGG19網絡在第個最大池化層之前通過第個卷積之后產生的特征圖;w,j和H,j是特征圖的維度;I是輸入的模糊圖像;I是經過生成器模型產生的清晰圖像。

2 實驗

2.1 數據集與訓練細節

本文所使用的數據集為Nah等人提出的GOPRO數據集[24],由GOPRO相機拍攝的33段不同場景的清晰視頻而來,其中的22段場景視頻作為訓練集,11段場景視頻作為測試集。對每段視頻相鄰的7~13幀圖像取平均值得到模糊圖像,一共生成了3214對模糊-清晰圖像,分辨率為1280×720。其中,訓練數據有2103對,測試數據有1111對。

為了將每張模糊圖像與清晰圖像各個像素一一對應,在輸入數據集前,首先將模糊圖片與清晰圖片合并為一張圖片,如圖4所示。其次將輸入的合并后的圖片裁剪為1280×360,最后在裁剪后的圖片上隨機選取256×256大小的模糊圖像與對應的清晰圖像進行訓練。

圖4 合并后的圖片

此次實驗在Windows 10操作系統下進行,處理器為Inter Xeon E5-2620 v4,顯卡為NVIDIA GeForce RTX 2080Ti,使用pycharm編輯器,使用PyTorch深度學習框架。訓練迭代300次,初始學習率為0.0001,前150次迭代的學習率采用初始值,后150次迭代的學習率按線性衰減至0,選擇Adam[25]優化算法,批量大小設置為8。

2.2 實驗結果

GOPRO數據集中測試集為GoPro攝像機拍攝的11段視頻,共1111張圖像組成。本文在經過多次訓練后,發現權值在=0.1,=0.9時去模糊效果最好,實驗結果如圖5所示,本文方法的去模糊效果較明顯,可以有效地恢復圖像的細節部分。

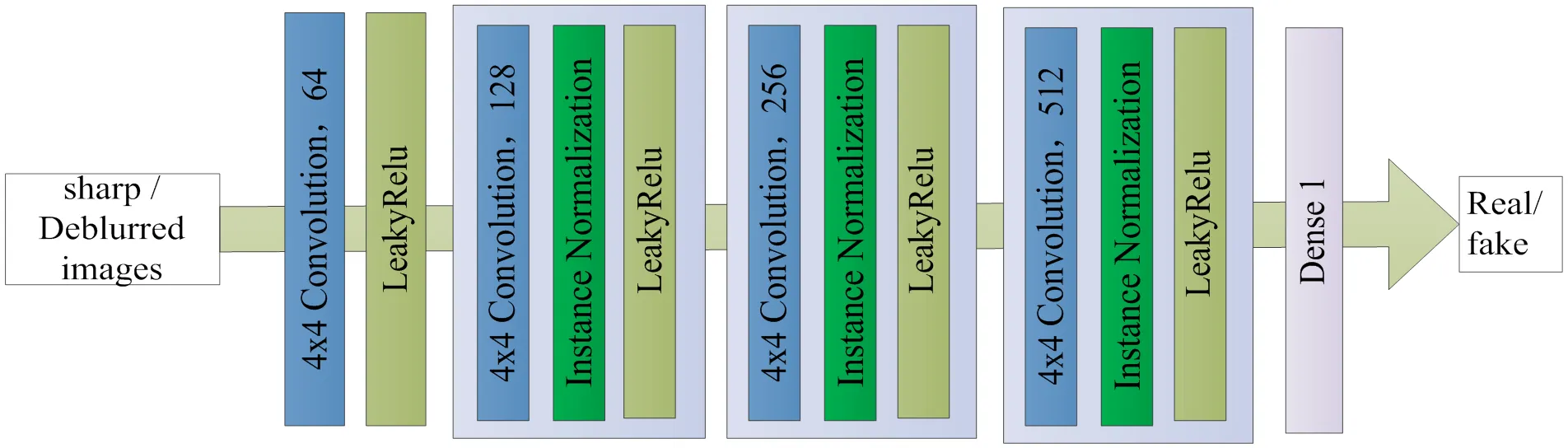

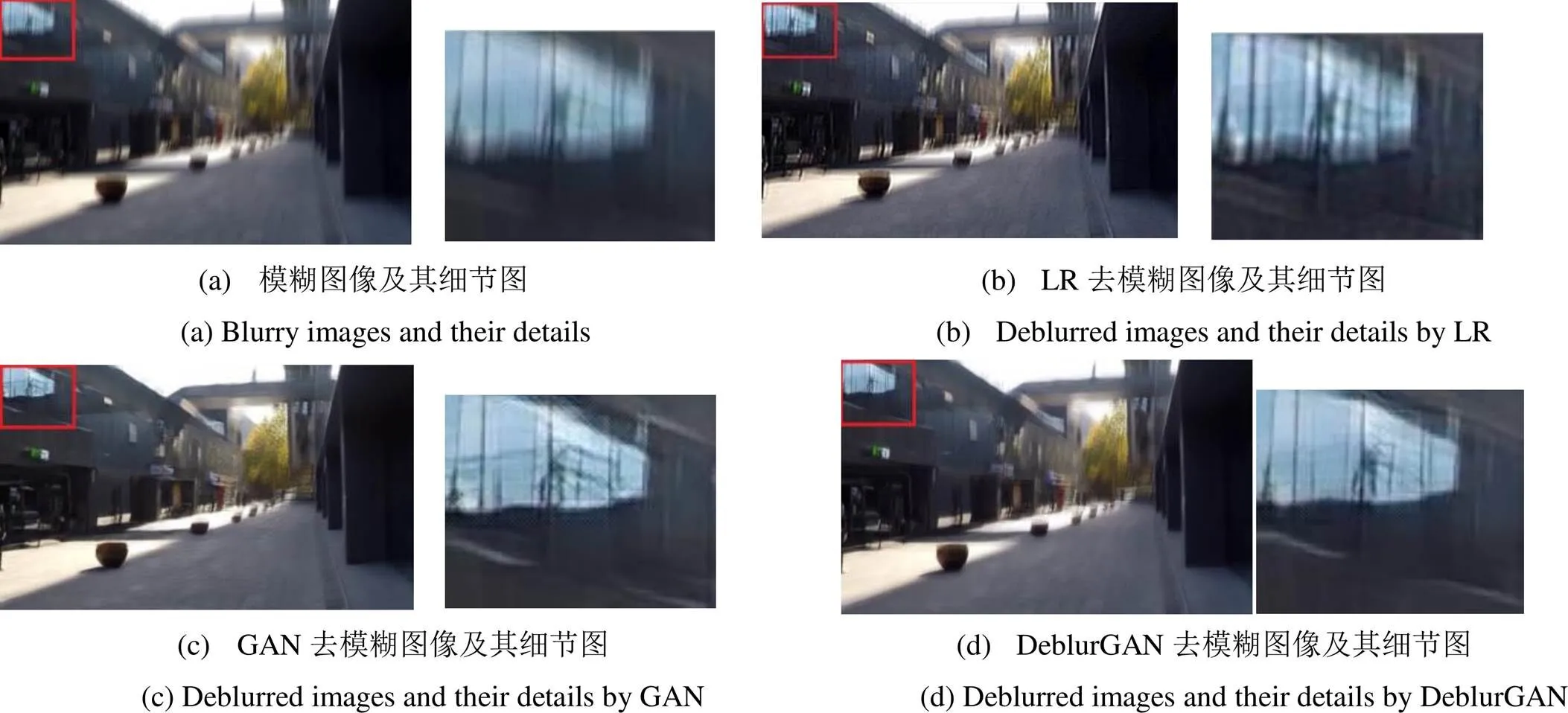

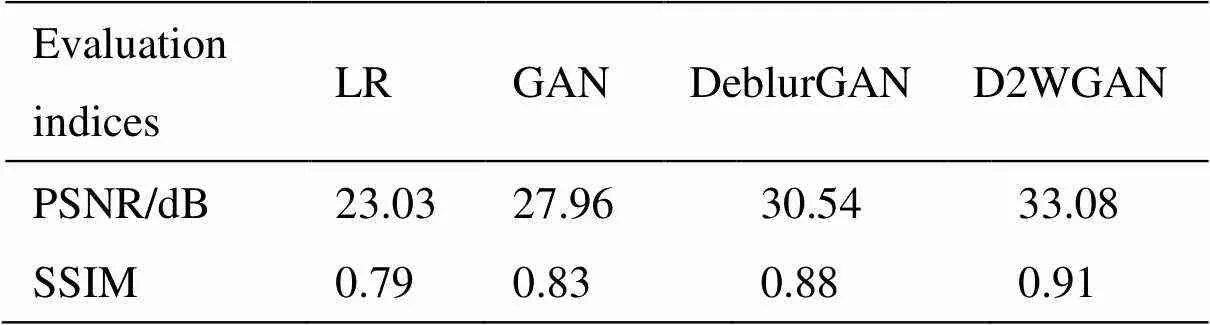

本文將D2WGAN算法與原始GAN、LR濾波及DeblurGAN方法的圖像去模糊效果進行對比,結果如圖6所示。表2為圖6中不同方法的峰值信噪比(peak signal to noise ratio,PSNR)與圖像結構相似度(structural similarity,SSIM)。

圖6(b)中LR算法進行去模糊時,邊緣的高頻信息有所改善,但整體會出現銳化的現象,視覺體驗一般;圖6(c)中GAN在復原圖像時會出現棋盤偽影的現象;圖6(d)中DeblurGAN方法整體復原效果較好,但仍有部分細節沒有復原出來。圖6(e)中本文方法去模糊的細節恢復較好,基本沒有棋盤偽影、銳化過度等視覺效果,恢復的圖像更加真實,而且從表2的評價指標中可以看出,對比LR算法,本文方法有質的飛躍。

圖5 本文方法去模糊前后效果對比圖

表2 不同方法對圖6中單張圖像的質量評價結果

實驗中LR濾波算法在迭代150次時處理一張圖片平均用時約2.5min,而本文測試集共1111張圖片,如果使用LR濾波在1111張圖片上測試,大約需要46h,時間代價太大。因此本文只對GAN、DeblurGAN以及本文方法在GOPRO驗證集上測量平均PSNR與SSIM值,結果如表3所示。

從表3可以得知,相比DeblurGAN方法,本文方法在評價指標PSNR上提升了約6.7%,在SSIM上提升了約9%,其結果說明本文提出的雙判別器加權生成對抗網絡方法是有效的。

表3 不同方法在GOPRO驗證集上的圖像質量評價

3 結論

為解決現有方法在恢復模糊圖像時仍存在的邊緣模糊現象,本文在原始生成對抗網絡的基礎上,增加了一個判別器,引入加權的思想,提出基于雙判別器加權生成對抗網絡的圖像去模糊方法。通過搭建生成器、判別器模型,引入雙判別器對抗損失和感知損失來恢復圖像的細節部分。實驗中使用GOPRO數據集來訓練模型,將本文方法與原始GAN、LR算法及DeblurGAN方法進行對比,發現本文方法可以有效地恢復出運動模糊圖像的細節部分,且沒有棋盤偽影、銳化等現象,提升了圖像視覺效果,在評價指標PSNR與SSIM上有更好的表現。本文方法簡單且通用,為圖像去模糊的發展提供了一種新的思路。

[1] 李明東, 張娟, 伍世虔, 等. 基于RANSAC變換的車牌圖像去模糊算法[J]. 傳感器與微系統, 2020, 39(2): 153-156, 160.

LI Mingdong, ZHANG Juan, WU Shiyu, et al. A deblurring algorithm for license plate image based on RANSAC transform[J]., 2020, 39(2): 153-156, 160.

[2] 馬蘇欣, 王家希, 戴雅淑, 等. 監控視頻下模糊車牌的去模糊與識別探析[J]. 信息系統工程, 2019(11): 111-113.

MA Suxin, WANG Jiaxi, DAI Yashu, et al. Research on the deblurring and recognition of fuzzy license plates under surveillance video[J]., 2019(11): 111-113.

[3] 裴慧坤, 顏源, 林國安, 等. 基于生成對抗網絡的無人機圖像去模糊方法[J]. 地理空間信息, 2019, 17(12): 4-9, 155.

FEI Huikun, YAN Yuan, LIN Guoan et al. Deblurring method of UAV image based on generative confrontation network[J]., 2019, 17(12): 4-9, 155.

[4] 黃允滸, 吐爾洪江, 唐泉, 等. 一種基于à trous算法的遙感圖像模糊集增強算法[J]. 計算機應用與軟件, 2018, 35(3): 187-192, 246.

HUANG Yunhu, TU Erhong, TANG Quan, et al. A remote sensing image fuzzy set enhancement algorithm based on à trous algorithm[J]., 2018, 35(3): 187-192, 246.

[5] 張廣明, 高爽, 尹增山, 等. 基于模糊圖像和噪聲圖像的遙感圖像運動模糊復原方法[J]. 電子設計工程, 2017, 25(18): 82-86.

ZHANG Guangming, GAO Shuang, YI Zengshan, et al. Remote sensing image motion blur restoration method based on blurred image and noise image[J]., 2017, 25(18): 82-86.

[6] 吳慶波, 任文琦. 基于結構加權低秩近似的泊松圖像去模糊[J]. 北京航空航天大學學報, 2020, 46(9): 1701-1710.

WU Qingbo, REN Wenqi. Poisson image deblurring based on structure-weighted low-rank approximation[J]., 2020, 46(9): 1701-1710.

[7] RICHARDSON W. Bayesian-based iterative method of image restoration[J]., 1972, 62(1): 55-59.

[8] LUCY B. An iterative technique for the rectification of observed distributions[J]., 1974, 79(6): 745-754.

[9] IAN G, JEAN P, MEHDI M, et al. Generative adversarial nets[C]//27th(NIPS), 2014: 2672-2680.

[10] LEDIG C. Photo-realistic single image super-resolution using a generative adversarial network[C]//(CVPR), 2017: 105-114.

[11] LI Y, ZHAO K, ZHAO J. Research on super-resolution image reconstruction based on low-resolution infrared sensor[J]., 2020(8): 69186-69199.

[12] LI Z, WANG W, ZHAO Y. Image Translation by Domain-Adversarial Train[J]., 2018: 1-11. Doi: 10.1155/2018/8974638.

[13] YANG T, CHANG X, SU H, et al. Raindrop removal with light field image using image inpainting[J]., 2020(8): 58416-58426.

[14] Mirza M, Osindero S. Conditional generative adversarial nets[J/OL].: 1411.1784, 2014,https://arxiv.org/abs/1411.1784.

[15] Orest K, Volodymyr B, Mykola M, et al. DeblurGAN: Blind motion deblurring using conditional adversarial networks[C]//, 2018: 8183-8192.

[16] NGUYENT, LE T, VU H. Dual discriminator generative adversarial nets[C]//29th, 2017: 2667-2677.

[17] Lucas T, A?ron V, Matthias B. A note on the evaluation of generative models[J/OL].: 1511.01844, 2015.https:// arxiv.org/abs/1511.01844

[18] IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//ICML'15:32nd, 2015, 37: 448-456.

[19] Ulyanov D, Vedaldi A, Lempitsky V. Instance normalization: the missing ingredient for fast stylization[C]//(CVPR), 2016: 1-13.

[20] LI C, WAND M. Precomputed Real-time texture synthesis with markovian generative adversarial networks[C]//, 2016: 702-716.

[21] Maas L, Hannun Y, Ng Y. Rectifier nonlinearities improve neural network acoustic models[C]//., 2013: 1-3.

[22] JOHNSON J, ALAHI A, FEI L. Perceptual losses for real-time style transfer and super-resolution[C]//, 2016: 694-711.

[23] SUN J, CAO W, XU Z, et al. Learning a convolutional neural network for non-uniform motion blur removal[C]//(CVPR), 2015: 769-777.

[24] NAH S, KIM H, LEE M. Deep multi-scale convolutional neural network for dynamic scene deblurring[C]//(CVPR), 2017: 257-265.

[25] Kingma D, Ba J. Adam: A method for stochastic optimization[C]//(ICLR), 2015: 1-15.

Image Deblurring Method Based on a Dual-Discriminator Weighted Generative Adversarial Network

HUANG Mengtao,GAO Na,LIU Bao

(College of Electrical & Control Engineering, Xi’an University of Science and Technology, Xi’an 710054, China)

The original generative adversarial network (GAN) is susceptible to the problems of vanishing gradients and mode collapse during the training process, and its deblurring effectiveness is poor. This study proposes an image deblurring method using a dual-discriminator weighted GAN. To extend the original GAN, a discriminator network is added to combine the forward and reverse Kullback–Leibler (KL) divergences into an objective function, and weights are used to adjust the ratio of forward and reverse KL divergences to leverage the complementary characteristics of the two divergences to avoid the formation of undesirable patterns in the process of learning clear pictures. Theoretical analysis proves that when an optimal discriminator is given, the difference between the forward and reverse KL divergences between real and generated data can be minimized. Experimental results demonstrate that compared to the existing methods, the proposed method can restore the details of an image more realistically and provides better performance in terms of the evaluation indexes of peak signal-to-noise ratio and structural similarity.

generation adversarial network, weighted, dual discriminator, image deblurring

TN911.7

A

1001-8891(2022)01-0041-06

2021-01-24;

2021-04-08.

黃夢濤(1965-),女,教授,博士,主要從事基于圖像的測量與識別和智能系統等方面的研究。E-mail:huangmt@xust.edu.cn

劉寶(1983-),男,講師,碩士生導師,主要從事多源信息融合、圖像處理等研究。E-mail:xiaobei0077@163.com

陜西省重點研發計劃項目(2019GY-097、2021GY-131);西安市科技計劃項目(2020KJRC0068);榆林市科技計劃項目(CXY-2020-037)。