基于YOLOV3模型的物體識別系統研究

陳沛豪,韓宇光,鐘皓俊,余澤,劉鑫蕾

(華東理工大學,上海,200237)

1 YOLO V3算法原理

近年來,隨著卷積神經網絡的興起,傳統的利用手工設計圖像特征的目標檢測方法已經發展為基于深度學習的目標檢測方法[1-2]。當下的深度學習算法主要可以分為兩類,第一類是基于候選區域的兩階段目標檢測算法,代表性的算法是R-CNN框架,以及在此基礎上通過構建區域建議網絡生成候選框提出的Faster R-CNN。第二類是基于回歸的單階段目標檢測算法,該種算法直接預測物體的類別概率、位置坐標而無需生成候選區域,代表性的算法有YOLO系列與SSD系列。[3]相較而言,兩階段的檢測算法通常具有較高的檢測精度,但檢測速度較慢,而單階段檢測算法以犧牲了一定檢測精度的代價提高了檢測速度。

1.1 YOLO V3主網絡結構分析

YOLO V3模型基于卷積神經網絡,對于卷積神經網絡而言,增加卷積層的數量能夠提取到圖像更多的特征值,使得圖像識別的結果更加精確。因此,在一定程度上,網絡越深,表達能力越強,性能越好[4]。但隨著卷積層數量的增多,計算量也隨之增大,同時還會帶來梯度爆炸等一系列的問題。

為了讓網絡模型能夠學習到優秀的特征,做出更為準確的分類結果,同時又能夠使計算量不至于過大,YOLO V3采用了大量卷積核為3*3和1*1的卷積層,并加入了殘差層的結構。YOLO V3模型共有53個卷積層,這種特征提取網絡結構被稱為Darknet53。其結構圖如圖1所示。

圖1 YOLO V3主要網絡結構圖

由圖中可以看出Darknet53采用了[Convolutional-Convolution-Residual]的子模塊網絡,構成了全卷積的網絡形式,使網絡對于任何分辨率輸入的圖片均可以進行特征提取[5]。

1.2 改進的YOLOv3算法

1.2.1 多尺度檢測網絡改進

原始YOLOv3網絡以Darknet53網絡結構為骨干,使用3個預測層以3種不同的尺度檢測對象。該網絡將輸入的原圖像經過8倍下采樣、16倍下采樣、32倍下采樣后的特征圖作為特征融合網絡的輸入,在一般場景下,由于目標大小與距離的不確定性,該方法對正常大小的物體有不錯的檢測效果,但是在平常的生活環境下,大部分對兒童可能造成危險的目標在圖像中所占比例較小,對目標的檢測效果會大大降低,并且由于下采樣操作會丟失目標很多的有用信息,會造成一些目標漏檢。

1.2.2 特征融合網絡改進

卷積神經網絡中,不同層次的特征圖含有目標不同的特征信息。淺層特征分辨率更高,含有目標更豐富的位置信息,深層特征含有較強的語義信息,但位置信息相對粗糙。利用淺層特征可以將簡單的目標區分開來,利用深層的特征可以區分開一些復雜的目標,因此構建特征金字塔,將高層網絡與低層網絡的特征信息融合更有利于對目標特征的描述。原始YOLOv3算法采用的特征融合網絡為FPN,通過將52×52、26×26、13×13三個不同尺度的特征信息通過特征金字塔結構進行融合,實現多尺度檢測。

2 YOLOV3模型在兒童看護方面的應用

2.1 訓練及驗證數據集

數據集的優劣能夠直接影響訓練模型參數的好壞,本文選取coco數據集作為訓練集。鑒于尖銳物品與細小物品對兒童潛在危險較大,因此選擇coco數據集中相關物品進行模型訓練。

實驗平臺的操作系統為Windows 10,CPU為Intel Core i7,GPU為NVIDIA 1080 ti,編程語言為python,深度學習框架為Tensorflow。

實驗平臺的配置如表1所示。

表1 實驗平臺配置

2.2 實驗結果及分析

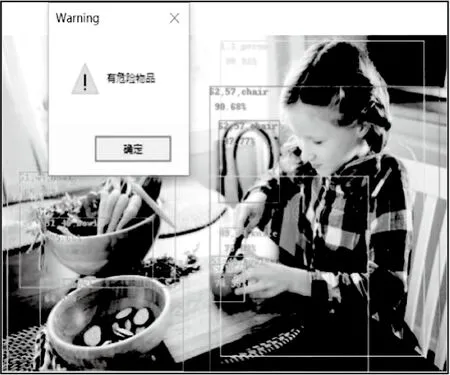

測試結果顯示該圖像中人像與刀的像素距離為184,小于既定閾值,故觸發報警提示,如圖2和圖3所示。

圖2 危險物品識別測試圖

圖3 危險物品距離圖

3 總述

本文采用YOLO V3的深度學習算法,設計了兩個模型。一個是簡易的兒童看護系統,通過圖像處理系統對兒童及潛在危險物品進行識別,判斷其之間的距離,并與預設的安全閾值距離進行對比,實現安全預警。經過實驗驗證該系統運行時,當兒童與潛在危險物品距離小于預設值時,系統會發出警告,從而實現輔助看管功能,緩解監護人對兒童的看護壓力。不管是在對目標的檢測速度上還是檢測精度上,基于YOLOV3系統的目標檢測與定位方法能夠更快、更準地檢測出行人與車輛,實驗結果證明了方法的有效性。