一種基于深度學習圖像超分的環(huán)形靶標穩(wěn)定檢測方法

崔海華 徐振龍 楊亞鵬 孟亞云 王寶俊

1.南京航空航天大學機電學院,南京,2111062.中航西安飛機工業(yè)集團股份有限公司制造工程部,西安,710089

0 引言

靶標檢測是目標跟蹤、大視場測量等領(lǐng)域的基礎(chǔ)任務,靶標檢測的好壞直接影響目標跟蹤精度與測量精度。隨著我國航空航天行業(yè)的飛速發(fā)展,人們對大尺度部件的跟蹤與測量提出了更高的要求。JIANG等[1]研制了具有編碼特征的小型柔性靶標,提出了基于共柱面特征約束的柔性靶標標定方法,并基于大視場視覺測量原理實現(xiàn)了航天器艙段坐標系的構(gòu)建。溫卓漫等[2]針對航天空間站機械臂輔助對接和目標抓捕過程中的位姿識別問題,提出了一種基于合作靶標快速識別的檢測算法,能在1.5 m的距離內(nèi)準確識別靶標并完成位姿的檢測。由此可知,靶標的準確識別與定位是目標跟蹤與大視場測量等技術(shù)中的關(guān)鍵一環(huán)。張小迪等[3]從靶標設(shè)計的角度出發(fā),提高了靶標的識別率與定位精度。OLSON[4]、GARRIDO等[5]設(shè)計了一種方形編碼標志,在位姿估計、增強現(xiàn)實等領(lǐng)域中具有較高的應用價值,但是方形標志角點的提取精度會隨著測量距離的增大而降低。王穎等[6]設(shè)計了圓環(huán)形平面標定靶標并基于該靶標對工業(yè)管道內(nèi)表面進行了三維測量,測量精度為0.081 mm。為提高特征點物體的匹配精度,周申江等[7]在近景攝影測量過程中提出了一種環(huán)形編碼標志自動識別算法,該算法抵抗噪聲能力強,圓形標志點圓心求解可達亞像素精度。上述方法均在不同程度上提高了靶標的檢測能力,但目前靶標的識別依然面臨著多個方面的挑戰(zhàn):當靶標與相機之間的距離逐漸增大時,其定位精度將下降;當靶標與相機之間的夾角過大時,會因靶標圖像變形較大而出現(xiàn)識別困難;具有更高分辨率的相機可以帶來更高的定位精度,但同時也增加了硬件成本,尤其是多目視覺系統(tǒng)中數(shù)據(jù)的傳輸帶寬限制了相機可用的最高分辨率。

近年來,基于深度學習的圖像超分辨率技術(shù)迅猛發(fā)展,該技術(shù)可以從一幅低分辨率圖像中提取出抽象特征,然后通過上采樣操作重建出一幅高分辨率圖像,主要特點是可以較好地恢復一幅圖像的邊緣、紋理等高頻信息[8]。ZHANG等[9]在檢測微小人體圖像任務中使用超分辨率技術(shù)來提高檢測準確性。楊夏寧等[10]在高空航拍圖像三維重建任務中采用超分辨率技術(shù)解決了地面目標特征粗糙導致重建精度較低的問題。

鑒于環(huán)形靶標識別的痛點,結(jié)合基于深度學習的圖像超分技術(shù),本文提出了一種面向環(huán)形靶標識別的圖像超分方法,針對靶標特點設(shè)計損失函數(shù),訓練了一種基于深度學習的圖像超分模型,將包含多種噪聲的低分辨率的環(huán)形靶標圖像重建為高分辨率的圖像,從提升圖像質(zhì)量的角度解決了極端條件下的靶標識別與定位難題。所提方法即插即用,可以嵌入到傳統(tǒng)環(huán)形靶標檢測算法之中。

1 超分辨率模型原理與構(gòu)建

1.1 基于超分的環(huán)形靶檢測方法

在環(huán)形靶標檢測之前,將原始圖像輸入到超分模型中,模型對圖像進行抽象特征提取,然后對提取到的特征進行上采樣操作,最后將上采樣結(jié)果重建為高分辨圖像,高分辨率圖像的長、寬分別為原始圖像長、寬的2倍。將經(jīng)過模型處理后的高分辨率圖像輸入到現(xiàn)有環(huán)形靶標檢測算法中,最終得到環(huán)形靶標的編碼信息與位置信息。

研究發(fā)現(xiàn),應用上述超分模型時,無需修改現(xiàn)有環(huán)形靶標檢測算法便可直接使用。在工程應用中,超分模型被封裝為一個獨立模塊,僅需通過接口便可調(diào)用。這使得該超分模型具有即插即用的特點,可便于該技術(shù)的傳播與應用。

1.2 超分辨率模型原理

圖像的超分辨率技術(shù)是指通過某種算法實現(xiàn)低分辨率圖像到高分辨率圖像的轉(zhuǎn)換,傳統(tǒng)超分辨率技術(shù)的基本思想是基于信號處理方法,從圖像的空域或頻域等多個角度提取特征[8,11],計算新位置的像素值,重建更加真實的高分辨率圖像。隨著深度學習技術(shù)的發(fā)展,近年來出現(xiàn)了較多的基于深度學習的圖像超分方法,并形成了一套較為完整的評價體系。其中增強超分深度網(wǎng)絡(enhanced deep networks for super-resolution,EDSR)[12]、高效亞像素卷積神經(jīng)網(wǎng)絡(efficient sub-pixel convolutional neural network,ESPCN)[13]、更快的超分卷積神經(jīng)網(wǎng)絡(faster super-resolution convolutional neural network,F(xiàn)SRCNN)[14]、拉普拉斯超分網(wǎng)絡(Laplacian super-resolution network,LapSRN)[15]等模型已集成到圖像處理庫OpenCV的dnn superres模塊中,無需額外安裝深度學習框架便可直接嵌入到現(xiàn)有靶標識別程序中,有利于技術(shù)的共享與傳播。表1比較了上述四種模型的性能,針對靶標定位需求,并達到更高的跟蹤精度,本文選取性能較好的EDSR模型作為研究對象,改進其損失函數(shù),使得該模型可以在包含較明顯的黑白邊界特征的環(huán)形靶標圖像中具有更好的超分效果。

表1 不同超分模型的性能比較

本文使用的超分模型是一種對單幅圖像進行超分操作的模型,超分模型利用保存在模型參數(shù)中的先驗知識與低分辨圖像的信息,重建出一幅對應的高分辨率圖像。通常可以將一組對應的低分辨率圖像(以下簡稱“低分圖像”)與高分辨率圖像(以下簡稱“高分圖像”)之間的關(guān)系用下式表述:

Ix=D(Iy;δ)

(1)

其中,D(·)表示一個退化函數(shù),高分圖像Iy在退化函數(shù)與影響退化函數(shù)的參數(shù)集合δ的共同作用下形成了低分圖像Ix。對圖像的超分操作可表述為圖像退化過程的逆過程,其表達式為

(2)

其中,F(xiàn)(·)表示超分模型,低分圖像Ix經(jīng)過超分模型與超分模型參數(shù)集合θ的作用下形成了高

當使用相機拍攝一張數(shù)字圖像時,可以認為是一個通過降采樣手段獲得離散化數(shù)據(jù)的過程,則退化函數(shù)可表示為

D(Iy;δ)=(Iy)↓s{s}?δ

(3)

其中,↓s表示比例因子為s時的降采樣操作。

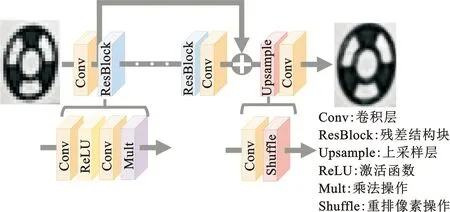

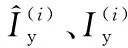

為實現(xiàn)超分過程,使用圖1所示的網(wǎng)絡結(jié)構(gòu)。考慮到網(wǎng)絡層數(shù)越深則特征提取效果越好,以及殘差結(jié)構(gòu)在梯度傳播中的優(yōu)良表現(xiàn),超分網(wǎng)絡主體使用具有殘差結(jié)構(gòu)的深度網(wǎng)絡,并使用基于殘差結(jié)構(gòu)的卷積層組合來提取低分圖像的特征。傳統(tǒng)卷積操作難以增大特征圖的長、寬,如圖2所示,將四個通道的特征圖重新排列則可實現(xiàn)特征圖的上采樣操作,通過多次實驗確定了當上采樣倍率為2時可以兼顧超分效果與耗時等要求。

圖1 放大倍率為2的超分模型的網(wǎng)絡結(jié)構(gòu)Fig.1 Network structure of super-resolution model with magnification as 2

圖2 上采樣操作中每4個特征層中的元素按順序排列到新特征圖中Fig.2 Elements in every four feature layers in unsampling operation are reshaped in the new feature graph

1.3 設(shè)計損失函數(shù)

為了評價預測高分圖像的準確性,通常使用絕對像素差值評價預測高分圖像與真實高分圖像間的差距,這種評價方法又被稱為L1損失。該種損失的計算方便,但僅從像素級角度比較了預測值與真實值,沒有考慮到環(huán)形靶標的特征。本文額外使用感知損失Lp來提高超分模型對靶標輪廓的超分重建能力。損失函數(shù)L1、Lp的計算表達式分別如下:

(4)

(5)

分別將預測高分圖像與真實高分圖像輸入預訓練的VGG19網(wǎng)絡中,并記錄每層卷積后的特征圖。將特征圖之間的差異作為超分模型的損失,以使超分模型所輸出的預測高分圖像的細節(jié)紋理更加接近真實高分圖像的細節(jié)紋理,由此提高超分模型對特征的提取能力與對圖像的重建能力。總損失函數(shù)L定義為L1與Lp的加權(quán)和,即

L=αL1+βLp

(6)

在實驗中保持其他條件不變,令α在范圍[0,1]內(nèi)每隔0.1取值,令β=1-α,然后訓練模型并測試,發(fā)現(xiàn)當α、β分別為0.8和0.2時靶標識別率最高,當β值超過0.6時,模型的圖像超分效果急劇下降。

2 數(shù)據(jù)處理與模型訓練

2.1 獲取真實圖像

為了得到環(huán)形靶標的高分圖像,使用500萬像素的工業(yè)相機在距離靶標1 m、2 m、3 m、4 m等不同距離上分別拍攝,獲得靶標圖像共計8632張。每次拍攝前移動或旋轉(zhuǎn)靶標,使其在圖像中的位置與形態(tài)不盡相同,以模擬實際使用時靶標的拍攝狀態(tài)。為了更好地評判靶標超分后的定位精度,在不同距離拍攝前,需要對相機進行標定。為了擴展靶標的識別范圍,在保持相機位姿不變的情況下微小調(diào)整鏡頭光圈與對焦環(huán),使得模型具備對過亮、過暗、虛焦靶標圖像的優(yōu)良重建能力。調(diào)整對焦環(huán)時,需要先拍攝準確對焦的靶標圖像,然后再拍攝虛焦后的圖像,對焦環(huán)的旋轉(zhuǎn)角度不宜調(diào)整過多,避免相機內(nèi)參發(fā)生劇烈變化,從而影響定位精度的評價。

獲得靶標高分圖像后,需要再獲取每張高分圖像對應的低分圖像,而這在實際過程中較難實現(xiàn)。本文使用一種較為便捷可行的降采樣方法,在高分圖像中加入較小的高斯噪聲并做模糊處理,然后對圖像進行雙三次插值的降采樣處理。上述操作可作如下描述:

D(Iy;δ)=((Iy+nζ)?κ)↓s{ζ,κ,s}?δ

(7)

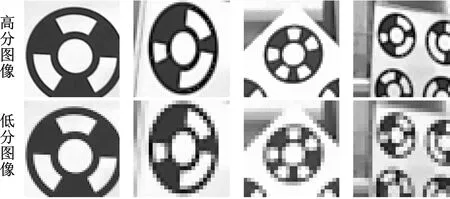

其中,nζ表示標準差為ζ的高斯噪聲,?表示卷積操作,κ表示模糊核。這樣的操作可以較好地模擬出分辨率較低的相機所拍攝到的圖像,最終得到高分與低分的圖像對,部分靶標圖像如圖3所示。其中圖3a為原始圖像,圖3b為環(huán)形靶標局部圖像,作為訓練集的高分辨率數(shù)據(jù)集;圖3c為將圖3b中環(huán)形靶標局部圖像的長、寬分別縮放0.5倍后得到的圖像,作為低分辨率數(shù)據(jù)集。真實圖像數(shù)據(jù)集中不同距離d下的靶標高分圖像與對應的低分圖像如圖4所示。

(a) 原始圖像 (c) 局部低分圖像圖3 真實圖像數(shù)據(jù)集中高分圖像與低分圖像對比Fig.3 Comparison of HR and LR circular targets in real image data set

(a) d=1 m (b) d=2 m(c) d=3 m(d) d=4 m圖4 真實圖像數(shù)據(jù)集中不同距離下高低分圖像對比Fig.4 Comparison of HR and LR circular targets in real image data set under different distances

2.2 合成圖像

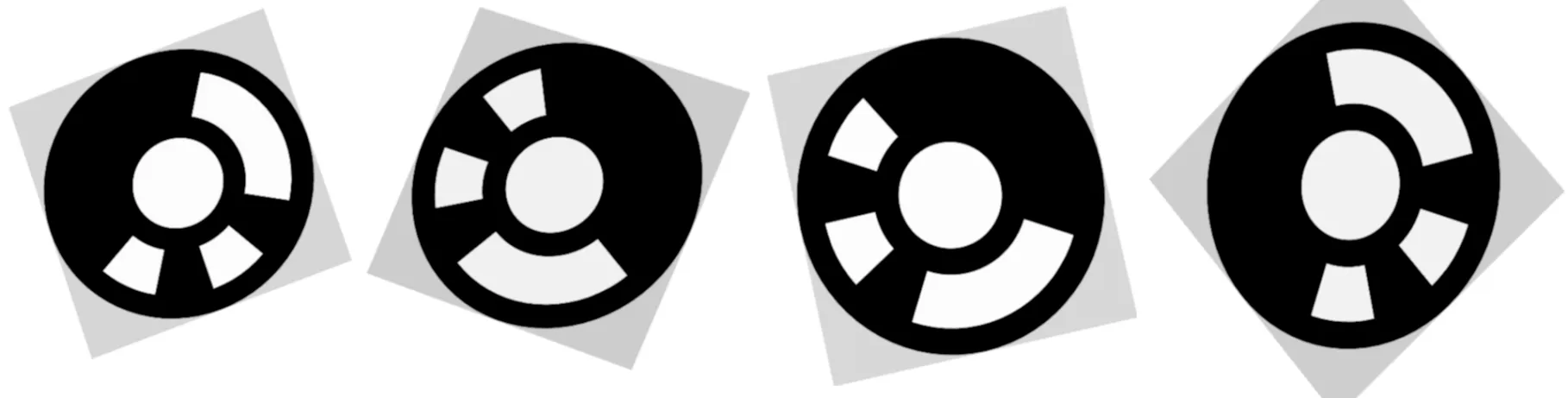

獲取環(huán)形靶標所需的真實圖像時間較長、人力成本較高,并且圖像數(shù)據(jù)集具有靶標狀態(tài)不夠豐富的缺點,為此使用圖形學技術(shù)生成靶標圖像。在空間原點放置平面對象,然后將隨機生成的環(huán)形靶標圖像貼圖在平面對象上,并使靶標圓心位于原點。在一定范圍內(nèi),隨機設(shè)置虛擬相機的光心位置與朝向從而確定虛擬相機外參,使平面對象在虛擬相機的拍攝范圍內(nèi),并設(shè)置虛擬相機視角、畫面偏移度、分辨率等參數(shù)從而確定虛擬相機內(nèi)參。令虛擬相機生成高分圖像與低分圖像,然后對低分圖像添加較小的高斯噪聲或高斯核較小的高斯模糊,由此可得到高分與低分的合成圖像對,部分合成圖像如圖5所示。

圖5 環(huán)形靶標部分合成圖像Fig.5 Partial synthetic images of circular targets

2.3 模型訓練

為加快模型訓練速度并提高訓練效果,在數(shù)據(jù)預處理階段進行隨機裁剪、翻轉(zhuǎn)、調(diào)整亮度對比度等操作。以一定步長將所有原始圖像隨機裁剪為具有相同長寬的小圖像,在加載數(shù)據(jù)階段累疊小圖像,方便并行訓練。增廣數(shù)據(jù)時隨機翻轉(zhuǎn)上述小圖像并調(diào)整亮度和對比度,但不進行隨機旋轉(zhuǎn)操作,避免引入重采樣過程中的噪聲。訓練所需的超參數(shù)如表2所示。隨機初始化模型參數(shù),多次訓練,得到10個超分模型。本文研究發(fā)現(xiàn),上述增廣操作可將靶標定位精度提高1.3%,使用包含真實圖像與合成圖像的混合數(shù)據(jù)集后可使靶標定位精度再提高2.7%,并將靶標識別準確率提高11.9%。

表2 超參數(shù)配置

3 識別與定位實驗

超分模型的效果通常使用結(jié)構(gòu)相似度(structural similarity,SSIM)和峰值信噪比(peak signal to noise ratio,PSNR)兩個指標進行評價[16],針對環(huán)形靶標的特點,本文使用靶標識別率與靶標定位精度作為評價指標。識別率定義為一幅圖像中靶標識別到的數(shù)量除以該幅圖像中的靶標總數(shù),實驗中發(fā)現(xiàn)已識別到靶標的編號均解碼正確,故識別率的定義中不考慮解碼錯誤的情況。考慮到靶標的真實圓心位置難以獲得,所以將定位精度定義為靶標圓心間距的測量值除以真值,靶標間距測量值由雙目視覺系統(tǒng)得到,真值由圓心間距標定而得。為了獲得較為準確的靶標間距真值,在已印刷有環(huán)形靶標的白板前0.5 m處架設(shè)雙目視覺系統(tǒng),調(diào)整靶標與視覺系統(tǒng)間的夾角,并將相機分辨率調(diào)整至最高,標定視覺系統(tǒng)后識別靶標編號并重建圓心空間位置,按照編號順序計算兩兩靶標圓心間的空間距離,多次重復上述過程,根據(jù)3σ原則剔除離群值,并將靶標間距均值作為后續(xù)測量靶標間距的真值。上述兩個評價指標的表達式分別為

(8)

(9)

式中,fr為識別率;n為已識別到的靶標數(shù)量;m為圖像中的靶標總數(shù);fl為定位精度;lm為測量值;lt為真值。

在不同距離下使用超分模型對相機拍攝的靶標圖像進行超分處理,超分效果如圖6所示,可以發(fā)現(xiàn),經(jīng)過超分處理后靶標邊緣更加清晰。圖6中,由上到下的4組圖分別由環(huán)形靶標距離相機1 m、2 m、3 m、4 m時拍攝而得,每組圖中從左到右分別為原始圖像、環(huán)形靶標的局部圖像、多種超分圖像,其中超分圖像是由對應的超分模型對環(huán)形靶標局部圖像的長、寬分別縮放2倍后得到的圖像。圖中PSNR與SSIM兩個評價指標值由超分后的圖像與局部圖像計算而得。從圖6中可以發(fā)現(xiàn),評價本文超分模型效果的PSNR與SSIM兩個評價指標值較高,表明超分圖像與原始靶標圖像具有較高的相似性。與兩種評價指標值最高的ESPCN模型效果相比,本文超分模型的靶標輪廓沒有出現(xiàn)鋸齒狀失真現(xiàn)象。

圖6 不同距離下環(huán)形靶標圖像的多種超分效果對比Fig.6 Comparison of the effects of circular targets by multiple super-resolution operations under different distances

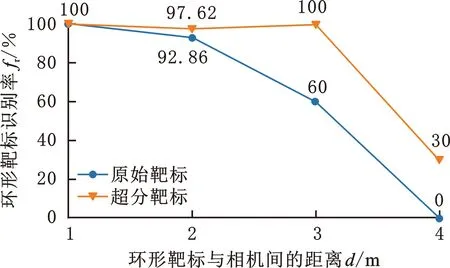

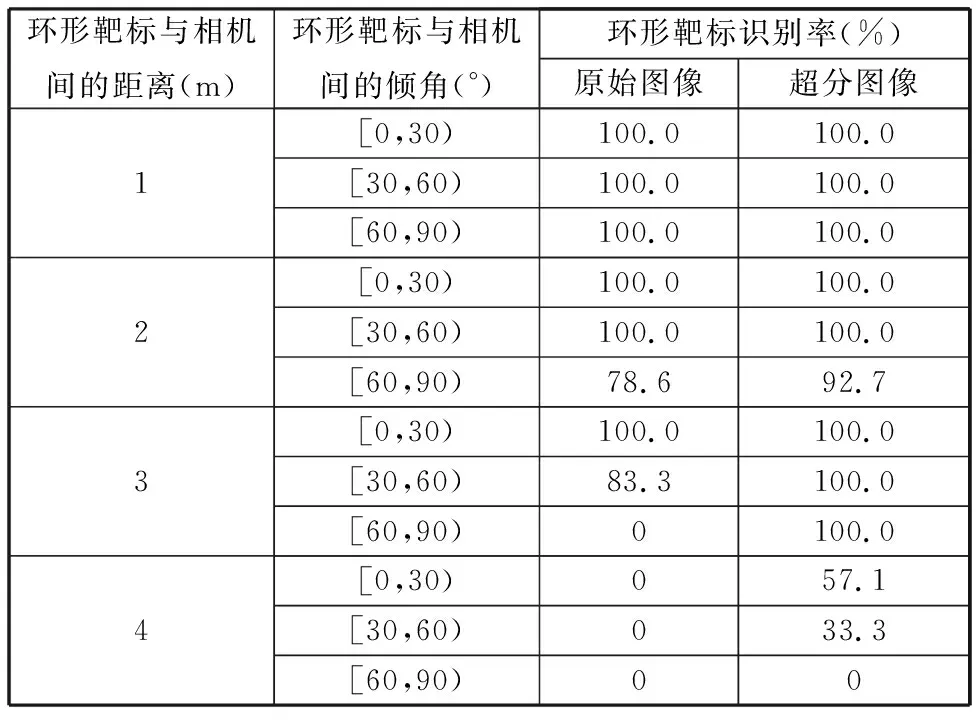

不考慮環(huán)形靶標與相機間的傾角,統(tǒng)計各組別的靶標識別率,結(jié)果如圖7所示。計算各組別的靶標定位精度,結(jié)果如圖8所示,其中未畫出環(huán)形靶標與相機間的距離d=4 m時的靶標定位誤差,系因d=4 m時原始靶標識別率為零,無法討論定位精度,同時d=4 m時超分靶標定位誤差達到了1.08 mm,對靶標定位已無意義。若所有圖像按照距離、靶標傾角等因素進行劃分,則識別率的統(tǒng)計結(jié)果如表3所示,表中將不同傾角的靶標按每30°劃分為三個左閉右開的區(qū)間。

圖7 不同距離下原始靶標與超分靶標的識別率對比Fig.7 Comparison of the recognition rate between original targets and super-resolution targets in different distances

從實驗結(jié)果中可以發(fā)現(xiàn),在雙目視覺系統(tǒng)與靶標識別算法不變的情況下,僅將原始圖像做超分操作,當靶標距離相機1 m、2 m、3 m時靶標定位精度分別提高1.13%、4.56%、8.47%(圖8)。尤為顯著的是,超分處理后靶標識別率大幅提高,當靶標距離相機2 m、3 m、4 m時靶標識別率分別提高4.76%、40%、30%(圖7)。超分操作后的圖像可有效改善因傾角較大、距離較遠等導致靶標識別困難的不利情況,當靶標距離較遠時,超分操作后的靶標識別率顯著高于原始靶標識別率。當靶標距離相機較遠時,靶標輪廓失真明顯,且隨傾角的增大鋸齒狀效應會更加顯著,導致輪廓提取、圓度計算、長短軸之比計算等檢測環(huán)節(jié)中可能將正確的靶標輪廓過濾掉了。超分操作可有效提高靶標輪廓提取的準確性,減少噪聲、失真等對靶標檢測的干擾,從而提高檢測效果。

表3 不同靶標傾角下原始靶標與超分靶標的識別率對比

本文所述超分操作在不同尺寸的圖像上耗時不同,采用Intel i9-9900X的CPU與RTX 2080 Ti的GPU時,當輸入圖像尺寸為1024 pixel×1080 pixel時耗時約為500 ms,當輸入圖像尺寸為120 pixel×120 pixel時耗時約為100 ms。實驗所用靶標距離相機1 m時,靶標的感興趣區(qū)域約為120 pixel×120 pixel。

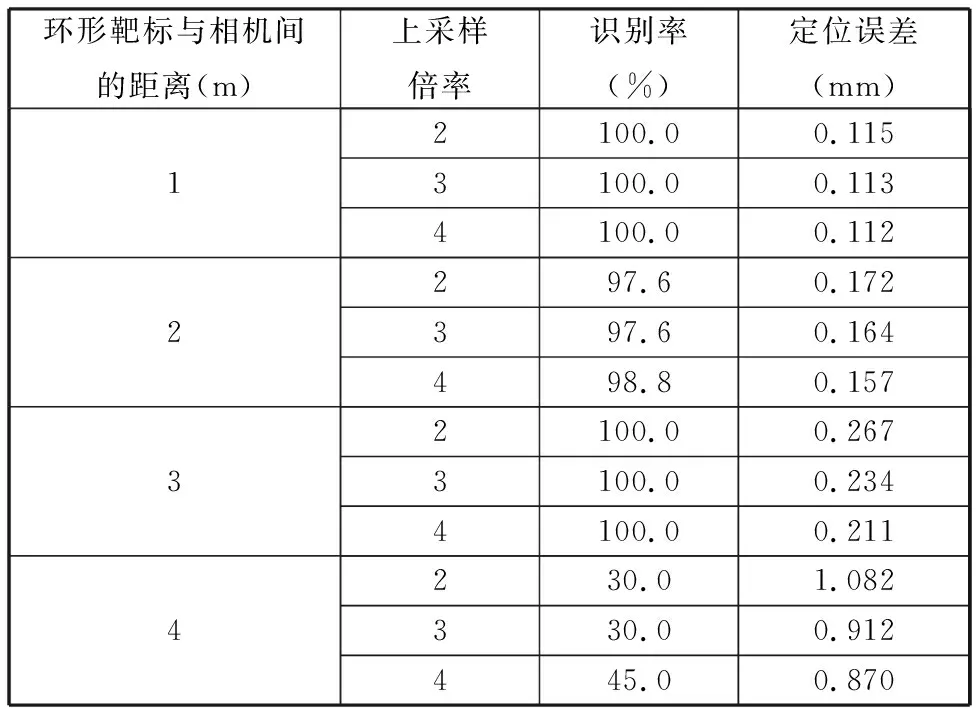

上采樣倍率對靶標檢測的影響如表4所示,不同上采樣倍率與耗時的關(guān)系如表5所示。在對檢測時間要求不高的場景下(靜態(tài)測量,如空間定位任務),當靶標距離相機為1~2 m的較近距離時,上采樣倍率為2即可得到較好的檢測效果;當靶標距離相機約為4 m的較遠距離時,上采樣倍率可適當調(diào)整為3或4以提高檢測效果,但與近距離靶標檢測相比,此時定位精度較差。在對檢測時間要求較高的場景下(動態(tài)測量,如跟蹤任務),選取上采樣倍率為2可以保證較好檢測效果與較短耗時。

表4 不同距離下上采樣倍率對識別率與定位誤差的影響對比

表5 不同上采樣倍率下超分過程的耗時對比

由上述分析可見,本文提出的面向環(huán)形靶標識別的圖像超分方法對靶標的識別與定位有較好的提升效果,具有積極意義。

4 結(jié)語

應用本文提出的圖像超分方法可有效提高環(huán)形靶標的識別率與定位精度。實驗結(jié)果表明:靶標識別率最多可提高40%,靶標定位精度最多可提高8.47%,尤其在靶標距離相機較遠、傾角較大等極端條件下,對圖像進行超分操作可較好地提高靶標檢測效果,但當距離過遠時定位精度將下降。所提方法在靜態(tài)測量中有較好應用前景,但在靶標動態(tài)測量中因耗時較長而影響應用。

與現(xiàn)有工作相比,將本文提出的方法應用在圖像輸入階段,可以方便地嵌入到已有環(huán)形靶標的檢測技術(shù)之前,為推廣與普及該方法創(chuàng)造了良好條件。本文提出的方法目前存在一些局限性,對圖像進行超分操作較為耗時,不利于動態(tài)跟蹤場景下的應用,雖然可以先提取靶標感興趣區(qū)域再超分,以減小計算量、縮減時間,但這樣無法對不清晰的靶標做有效檢測,所以應當從減小模型規(guī)模、縮短計算時間的角度對本文方法做進一步改進。可以再豐富超分模型使用的數(shù)據(jù)集,在后續(xù)工作中采集更多靶標圖像,擴展超分模型適用范圍,提高魯棒性。