基于BiGRU和注意力交互模型的方面級情感分析

汪平凡

北京星網船電科技有限公司,北京 102308

0 前言

互聯網技術的發展拓寬了信息交互的渠道,人們習慣在網絡平臺發表觀點,表達個人情感。提取并分析帶有個人情感色彩的文本信息可以幫助我們認識事物的多面性,具有一定的應用價值[1]。如何將非結構文本轉化為計算機可以識別的結構化信息,以及如何有效識別文本中特定方面的情感傾向成為研究的熱點。

傳統的粗粒度級情感分析只關注文本整體情感傾向,無法深入挖掘句子中潛在的語義信息[2]。方面級情感分析旨在識別句子中某個特定實體或屬性的情感傾向(如積極、消極、中性)。例如,給定一句話“餐廳的食物非常美味,但周圍的環境很糟糕”,那么“食物”和“環境”這兩個方面詞的情感極性分別是積極和消極,因此,情感極性的判別不僅由句子的內容決定,而且與文本中特定方面詞密切相關。如果我們忽略了方面詞對整個句子的影響,就無法準確地分析出文本所表達的情感傾向[3]。

神經網絡因其獨特的優勢而被研究者們應用在情感分析領域。TANG D等人[4]提出TD-LSTM模型,該模型使用兩個LSTM網絡分別對上下文和方面詞建模,將得到的隱藏向量拼接起來輸入到softmax層進行情感分類。GRAVES A等人[5]使用循環卷積神經網絡進行文本分析,該方法從正反兩個方向學習詞語的時序關系。TAI KS等人[6]考慮了句子語義信息,在LSTM網絡基礎上引入外部依存樹來提高情感分析的準確度。

由于句子中每個詞對情感分類的貢獻不同,注意力機制被應用到深度學習模型中為詞語分配不同的權重分數。WANG X等人[7]結合LSTM網絡和注意力機制分析文本中特定方面的情感傾向,模型在訓練過程中關注特定方面信息,避免對文本做相同處理。余本功等人[8]使用雙重注意力機制分析文本信息,利用綜合權重強化特定方面詞和上下文之間的相關特征。MA D等人[9]提出交互注意力模型(IAN),利用注意力機制交互學習方面詞和上下文之間的關聯信息,取得了較好的情感分類效果。曾鐸等人[10]提出多頭注意力循環神經網絡模型,使得模型充分學習方面詞和上下文之間的特征關系。

本文將GRU網絡和注意力機制相結合,提出了基于BiGRU的注意力交互模型。該模型分別對句子和方面詞建模,考慮方面詞對句子整體情感極性的影響。首先,利用Bert預訓練模型表示句子和方面詞的特征向量,然后,GRU網絡提取詞向量信息,得到隱藏層向量表示,注意力機制交互學習句子和方面詞之間的關聯,區分句子中不同詞語對情感分類結果的影響。

1 相關模型和技術

1.1 Bert模型

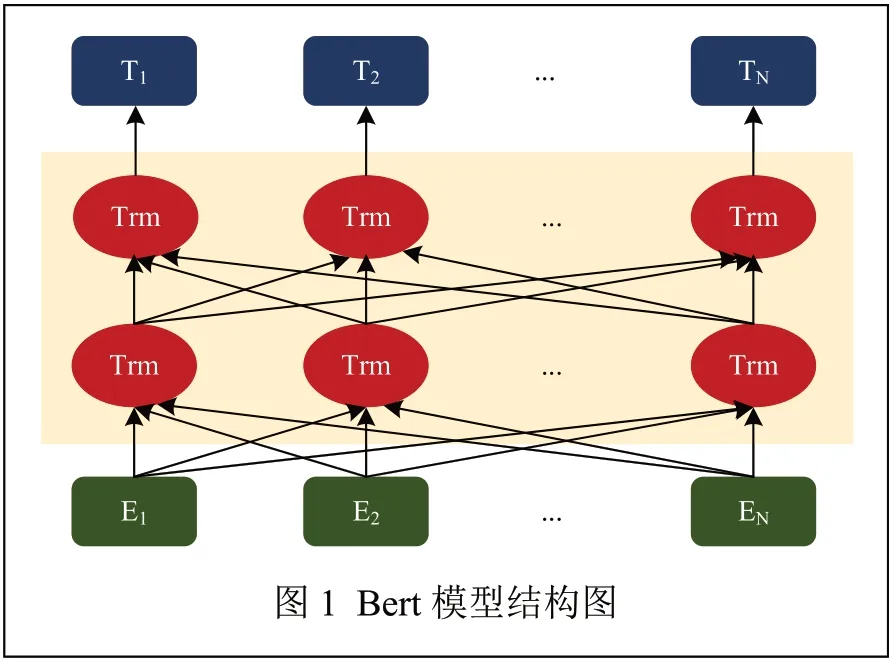

Bert模型是DEVLIN J等人[11]提出的一種預訓練模型,該模型在Transformer的基礎上進行改進。與word2Vec、Glove等語言表征模型不同,Bert模型旨在通過調節所有層中的信息來預先訓練詞向量,去除詞語之間較長距離的限制,將目標詞與上下文之間的內在關聯顯式地表現出來,可以解決模型無法并行處理和信息長期依賴的問題。Bert網絡結構如圖1 所示。

1.2 門控循環單元

門控循環單元(Gate Recurrent Unit,GRU)是循環神經網絡(Recurrent Neural Network,RNN)中的一種門控機制,其旨在解決循環神經網絡中出現的梯度衰減或爆炸問題,并同時捕捉時間序列中長距離間的依賴關系。GRU網絡是在長短期記憶網絡的基礎上發展而來,僅存在更新門和重置門,GRU網絡通過門結構來控制信息的流動。與LSTM網絡相比,GRU網絡結構相對簡單,更容易進行訓練,能夠在很大程度上提高模型的訓練速度。

1.3 注意力機制

BAHDANAU D等[12]首次將注意力機制引入到自然語言處理任務中,用以解決源序列與目標序列因距離過長而無法建立依賴關系的問題。注意力機制可以自動學習并計算輸入數據對輸出數據的貢獻大小,從而為詞語分配相應的權重分數,引入注意力機制可以更好地學習詞之間的依賴關系,增強對重要詞匯的關注。

2 基于BiGRU的注意力交互模型

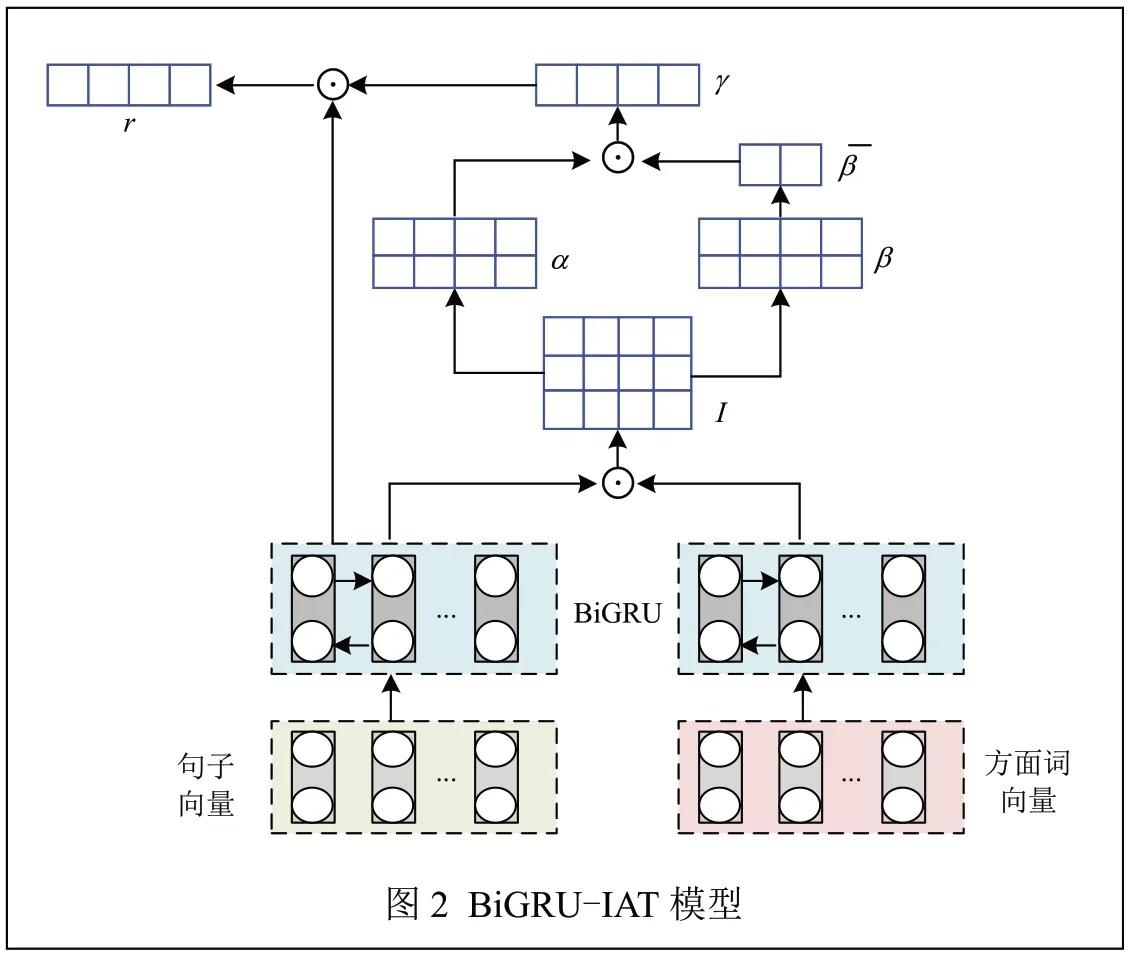

在方面級情感分析問題中,首先給定一個句子s=[w1,w2,…,wi,…,wj,…,wn]和 方 面 詞t=[wi,wi+1,…,wi+m],方面詞可以是單詞或短語,目的是判斷方面詞在句子中的情感極性。本文提出的模型如圖2所示,主要包括詞嵌入層、雙向GRU層、注意力交互層和輸出層。

2.1 詞嵌入層

詞嵌入層包括方面詞向量和句子向量嵌入,給定句子s=[w1,w2,…,wi,…,wj,…,wn],n表示句子的長度,方面詞t=[wi,wi+1,…,wi+m],m表示方面詞的長度。使用Bert預訓練模型將每個單詞映射為連續的詞向量表示,Bert模型通過調節所有層的信息來預訓練詞向量,能夠根據上下文信息調整詞向量表示,從而有效解決詞語的多義性問題。

本文使用規模較小的BERTBase訓練詞向量,其相關的參數設置如表1所示。

表1 BERTBase參數

2.2 雙向GRU網絡層

將文本詞向量輸入到雙向GRU網絡中,GRU網絡提取方面詞和上下文信息得到隱藏層向量表示。通過輸入s=[v1;v2;…;vn]和前向GRU網絡,可以得到隱藏狀態序列,其中,dh是隱藏狀態的維數。通過輸入s=[v1;v2;…;vn]和后向GRU網絡得到。雙向GRU網絡中,最終輸出的隱藏向量表示為,其中,,n為句子長度。

2.3 注意力交互層

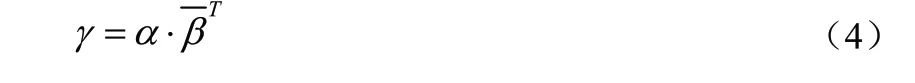

注意力機制獲取隱藏層向量的關鍵信息,為詞語分配不同的權重分數,交互式學習詞向量之間的依賴關系。給定方面序列表示為,句子序列表示,首先計算交互注意力權重矩陣矩陣的值表示句子和方面詞之間的詞對相關性,分別對交互矩陣的行和列做歸一化處理,得到行和列的權重值α和β,其中,α表示方面詞對句子的權重分數,β表示句子對每個方面詞的權重分數,對β逐列取平均值得到方面級注意力權重,用以表示方面詞中的重要部分,最后得出方面詞序列對每個詞語的權重分數γ∈Rn,γ值代表著文本詞對方面詞的重要程度,具體計算公式如式(1)~式(4)所示:

其中,αij——方面詞對全部文本的注意力權重值;

Iij——方面序列和句子序列的交互注意力權重矩陣。

其中,βij——文本對方面詞的注意力權重值。

其中,——方面級注意力權重;

n——句子長度。

其中,α——方面詞對文本的注意力權重值;

——方面級注意力權重的轉置。

使用文本對方面詞和方面詞對文本的注意力權重值乘上句子隱藏向量表示,最終得到方面詞和上下文的交互表示,用于文本的最終分類,具體計算如公式(5)所示:

其中,——句子向量的轉置;

γ——注意力權重。

2.4 輸出層

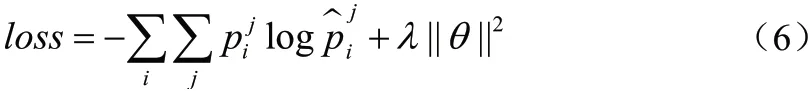

將最終的向量表示輸送到softmax層得到文本的

情感極性,P表示真實的情感分類,表示預測的情感分類,損失目標函數如公式(6)所示:

其中,i——句子中的索引;

j——3種分類;

λ——L2正則化系數;

θ——模型中設置的參數。

3 實驗

3.1 數據集及參數設置

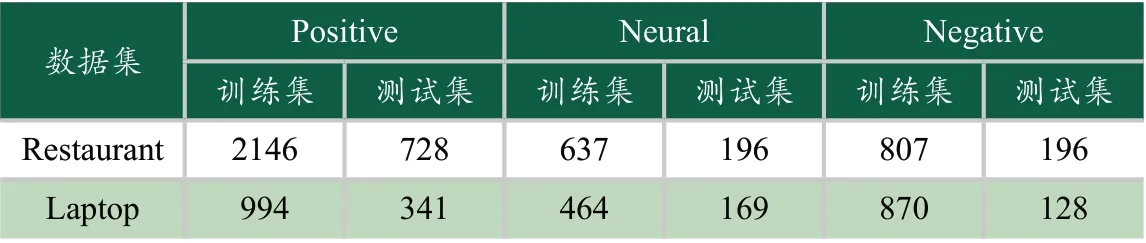

本文在SemEval2014數據集(包括Laptop和Restaurant數據集)進行實驗,該數據集已標注句子中的方面詞及其Positive、Neural和Negative 3種情感極性。數據集的統計信息如表2所示。

表2 數據集統計

將數據集分為訓練集和測試集進行學習,所有權重矩陣隨機初始化,所有偏置項設置為0,L2正則化系數設置為0.0001,dropout設置為0.5,使用Bert預訓練模型表示句子和方面詞的特征向量。GRU隱藏狀態的維度設置為150,Adam優化器初始學習率為0.01,批處理大小為64。

3.2 對比模型及實驗結果

將BiGRU-IAT模型與多個模型在SemEval數據集上進行實驗,驗證本文模型的有效性。

TD-LSTM模型[4]:使用兩個LSTM網絡學習文本信息,將得到的隱藏向量拼接起來,送入softmax層進行情感分類。

AT-LSTM模型[7]:使用LSTM網絡分別對句子和方面詞編碼,注意力機制捕捉隱藏狀態與方面詞向量之間的內在聯系。

ATAE-LSTM模型[7]:該模型在AT-LSTM模型的基礎上改進,將方面詞嵌入到每個單詞向量中,充分考慮方面詞對句子整體情感傾向的影響。

IAN模型[9]:利用LSTM網絡學習句子和方面詞信息,注意力機制交互式學習句子和方面詞的注意權重。

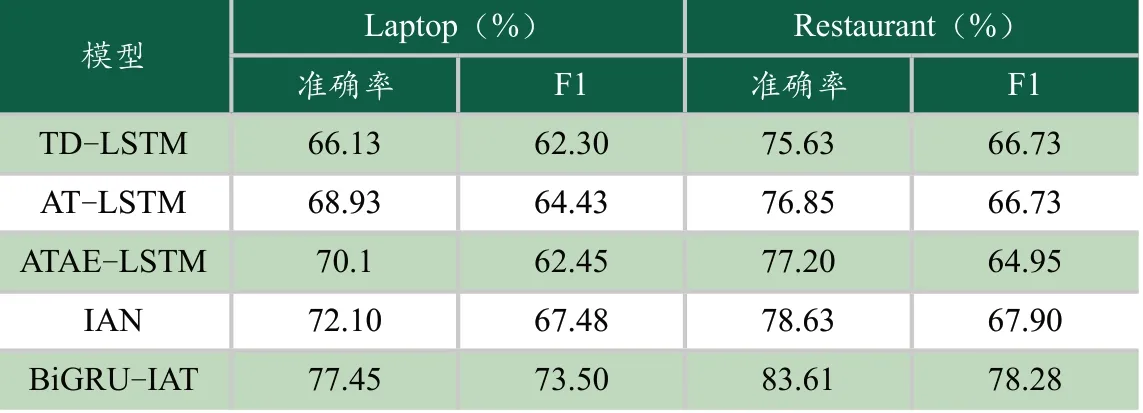

實驗中使用準確率和F1值作為評價指標,驗證模型的有效性,實驗結果如表3所示。

表3 不同模型實驗結果對比

從表3中可以看出本文模型取得了較好的分類效果,分類準確率分別達到77.45%、83.61%,F1值達到73.5%、78.28%。TD-LSTM模型的性能較差,主要原因是根據方面詞的位置信息分割語句,LSTM網絡無法獲取完整的語義信息,從而影響了模型的情感分類效果。AT-LSTM模型中引入注意力機制,模型可以充分捕捉句子中方面詞的關鍵信息。ATAE-LSTM模型在AT-LSTM模型基礎上進一步擴展,使用LSTM網絡對方面詞和上下文建模,充分考慮方面詞對句子情感極性的影響,將方面詞作為模型的一部分參與訓練,得到文本在給定方面詞上的權重表示。IAN模型使用交互注意網絡學習方面詞和上下文的內在聯系,進一步強調文本中方面詞的重要性。

本文提出的BiGRU-IAT模型結合了GRU網絡和注意力機制的優勢,使用Bert預訓練模型分別對句子和方面詞編碼,充分考慮文本語義相關性,分析詞語在不同上下文中的語義表達,從而有效地解決一詞多義的問題。GRU網絡從正反兩個方向提取詞向量信息得到隱藏層向量表示,注意力機制交互式學習方面詞和句子之間的關聯性,從而得到較好的情感分類效果。

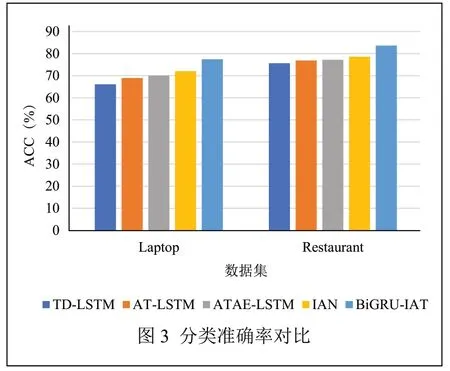

在不同模型中分類準確率的對比結果如圖3所示,橫軸表示Laptop和Restaurant數據集,縱軸為準確率(ACC)。

從圖中可以直觀地看出,BiGRU-IAT模型在SemEval2014數據集上準確率最高,實驗結果充分說明了該模型的有效性。

4 結論

本文針對傳統神經網絡模型忽略方面詞的問題,提出了基于BiGRU的注意力交互模型,充分考慮方面詞對文本整體情感傾向的影響。模型使用Bert表示句子和方面詞的特征向量,GRU網絡從正反兩個方向獲取方面詞和上下文的語義信息,利用注意力機制交互學習句子和方面詞之間的內在聯系。最后,在SemEval2014數據集上與多個模型進行對比,實驗結果驗證了BiGRU-IAT模型的有效性。