SAR影像和光學影像梯度方向加權的快速匹配方法

樊仲藜,張 力,王慶棟,劉思婷,2,葉沅鑫

1. 中國測繪科學研究院,北京 100039; 2. 蘭州交通大學測繪與地理信息學院, 甘肅 蘭州 730070; 3. 西南交通大學地球科學與環(huán)境工程學院,四川 成都 611756

近年來,隨著SAR影像數(shù)據(jù)在地理國情監(jiān)測[1]、地表沉降變化檢測[2]等領域發(fā)揮的作用越來越顯著,其與光學影像截然不同的成像機理與特性引起學術界和工業(yè)界的廣泛關注。結合SAR影像與光學影像各自優(yōu)勢,實現(xiàn)對大量地表特性信息的互補,能夠更好地解決變化檢測、目標識別、地物分類等任務。目前SAR影像和光學影像聯(lián)合應用的關鍵前提在于影像匹配,影像匹配的本質(zhì)是在多幅影像之間尋找同名點的過程[3],但是由于SAR影像獨特的成像機理,使其與光學影像之間存在顯著的非線性灰度差異,同時SAR影像還會受到嚴重的相干斑噪聲干擾[4],這些影響因素使光學影像上的顯著特征點在SAR影像上極不穩(wěn)定,甚至失效,導致現(xiàn)有的影像匹配技術難以應用于SAR影像和光學影像間的匹配,因此SAR影像和光學影像的匹配技術是目前遙感領域的難點,也是熱點研究問題之一[5-7]。

影像匹配方法主要可分為基于特征的方法、基于區(qū)域的方法[8]和基于深度學習的方法[9-10]。基于特征的方法通過在輸入的影像之間提取共有特征,并檢測特征間的相似性來實現(xiàn)影像匹配。這些影像特征可以是點特征[11]、線特征[12]、面特征[13]或是局部不變性特征(SIFT[14]、SURF[15]等)。為了得到較好的匹配效果,檢測到的影像特征應具有良好的穩(wěn)定性、可區(qū)分性和可重復性,但是在具有顯著非線性灰度差異的影像之間很難提取到具有高重復率的共有特征,從而導致匹配不到足夠數(shù)量的同名點,使得此類方法在SAR影像和光學影像匹配任務上失敗。

基于區(qū)域的方法也被稱為模板匹配方法,通過在影像間設置一定尺寸大小的影像窗口,并選擇某種相似性測度作為檢測影像相似性的準則來實現(xiàn)影像匹配[16]。傳統(tǒng)的模板匹配方法通常是利用影像的灰度信息進行匹配,代表性的方法有:互信息(mutual information,MI)[17]、歸一化互相關(normalized cross correlation,NCC)[18]等。由于NCC方法能夠?qū)τ跋耖g的線性灰度變化保持穩(wěn)健,因此被廣泛應用于光學遙感影像匹配,但其對影像間的非線性灰度差異較為敏感。對于MI方法,其本質(zhì)是依賴于影像灰度的統(tǒng)計信息進行匹配,與影像間灰度變化的方式相關性較弱,故理論上其對影像間的非線性灰度差異有一定的適應性,然而MI方法忽略了鄰域像素的影響,使得計算結果容易陷入局部極值而導致誤匹配,并且其對模板窗口大小比較敏感,匹配過程計算量較大,因此MI方法在SAR影像和光學影像的匹配時效果不佳。

受到深度學習技術的影響,一些基于深度神經(jīng)網(wǎng)絡進行SAR影像和光學影像匹配的方法被提出。文獻[9]提出了一種基于圖像風格遷移的匹配方法,通過改進的VGG-19網(wǎng)絡模型將SAR影像和光學影像進行風格互換,再利用SIFT或SURF等算法對互換風格后的影像進行匹配,該方法能夠獲取較多的正確匹配點。文獻[10]改進了一種用于檢測圖像相似性的Siamese網(wǎng)絡模型[19-20],通過抽取特征以及去除池化層對原網(wǎng)絡進行優(yōu)化,該方法取得了較高的正確匹配率和匹配精度。現(xiàn)階段基于深度學習的方法存在一定的局限性,首先需要花費大量的時間和精力來制作訓練數(shù)據(jù)集以及訓練模型,并且由于地表形態(tài)構造的多樣性,使得訓練數(shù)據(jù)集難以具有良好的通用性,導致對于不同類型的地表形態(tài),訓練模型缺乏良好的泛化能力;其次,此類方法的執(zhí)行效率較低,由于需要將遙感影像輸入到神經(jīng)網(wǎng)絡模型中進行訓練,這個過程需要對海量樣本數(shù)據(jù)進行迭代計算,對計算環(huán)境的軟硬件配置提出挑戰(zhàn),并且非常耗時,因此這類方法難以達到實際應用的要求,缺乏時效性。

除上述的各種方法之外,近年來,一些研究者發(fā)現(xiàn)影像的幾何結構和形狀特征能夠有效抵抗影像間的非線性灰度差異[21-22],因而將其引入到SAR影像和光學影像的匹配當中,并取得了較好的匹配效果。這類方法不直接利用影像的灰度信息進行匹配,而是首先利用如影像的梯度、局部自相似性(local self-similarity,LSS)、相位一致性(phase congruency,PC)等能有效地表達影像結構的信息來構建特征描述符,隨后建立描述符之間的相似性測度,并采用模板匹配的策略對影像進行匹配。文獻[23]利用具有對比度和光照不變性的相位一致性特征對方向梯度直方圖(histograms of oriented gradients,HOG)[24]進行了改進,提出了相位一致性方向直方圖(histogram of orientated phase congruency,HOPC),在光學和SAR影像的匹配任務上取得了較好的效果。但是,HOG和HOPC是在一個稀疏的采樣格網(wǎng)(非逐像素)內(nèi)進行特征構建,是一種相對稀疏的特征表達方式,難以精確地捕獲影像的細節(jié)結構信息,另外其計算效率較低。文獻[25]利用方向梯度信息構建了一種稠密結構特征描述符(channel features of orientated gradients,CFOG),通過逐像素地提取鄰域結構特征,增強了描述符對于結構信息的細節(jié)表達能力,同時在頻率域中完成影像匹配,顯著提高了匹配性能及計算效率。不過,CFOG是利用水平和垂直方向的梯度內(nèi)插出的方向梯度,其計算精度還可進一步提高。針對這一問題,本文提出一種更精確的方向梯度計算方法,并以此構建特征描述符進行SAR影像和光學影像的匹配。

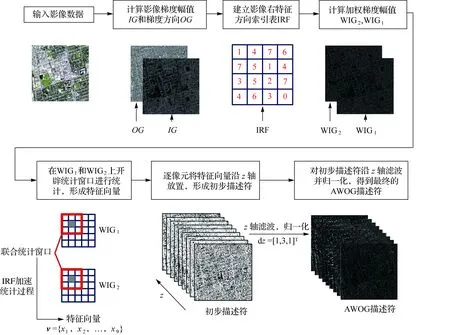

本文提出的SOFM方法使用影像的梯度信息構建出一種表達影像結構的特征描述符,即角度加權方向梯度AWOG,隨后選擇描述符之間的差值的平方和(SSD)作為用于匹配的相似性測度,并利用快速傅里葉變換將匹配過程轉(zhuǎn)換到頻率域進行。設計了一套基于本文方法的自動匹配流程,并通過設計多組試驗來驗證本文方法的有效性和匹配性能。

1 結構特性表達的影像相似性

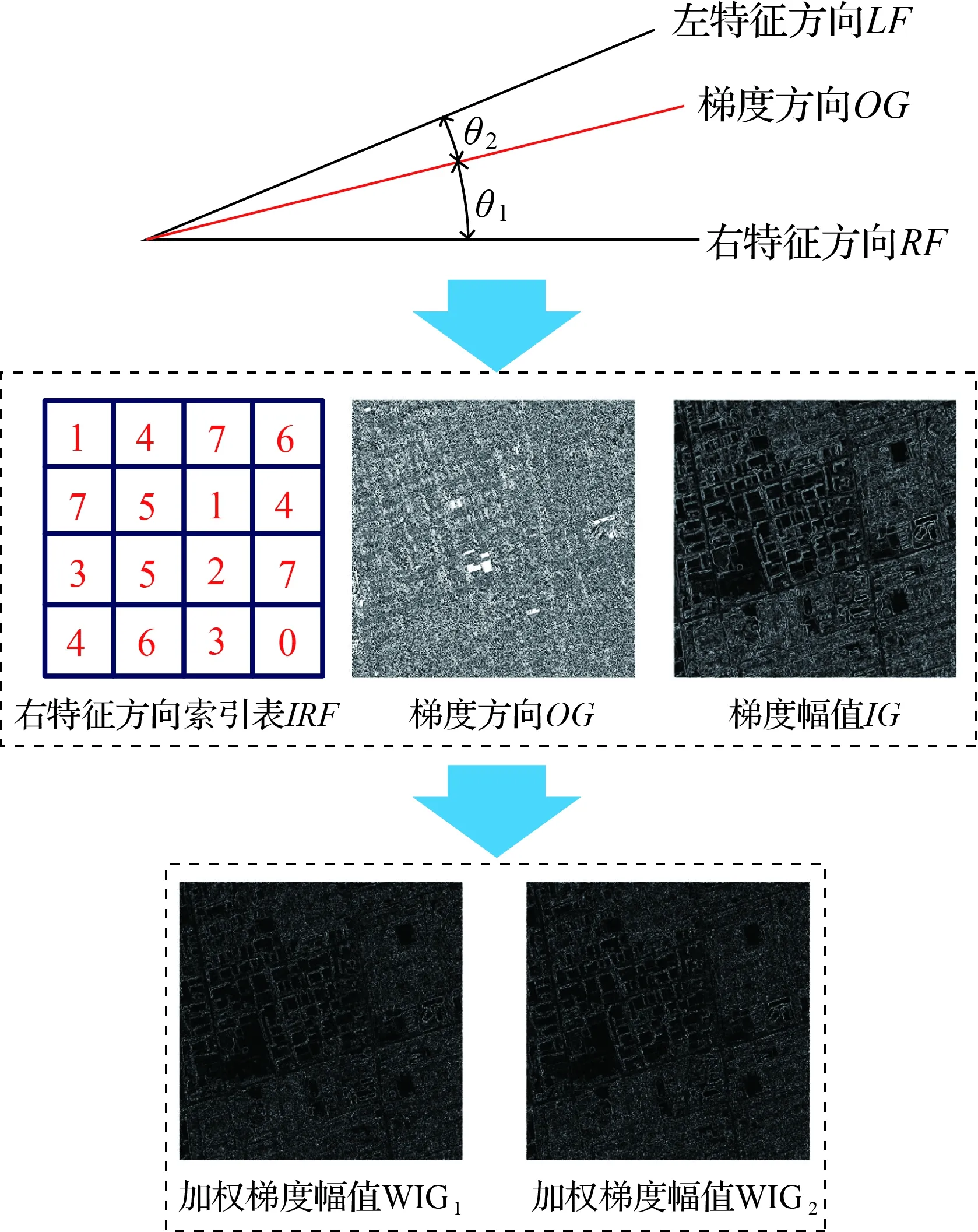

本節(jié)將給出利用影像梯度信息構建AWOG描述符的詳細步驟,以及給出在頻率域中表達的影像匹配函數(shù)的詳細推導過程。

1.1 特征描述符

AWOG描述符的提出受到HOG[23]和CFOG[25]的啟發(fā)。HOG描述符最初被用于處理行人檢測任務,由于對影像結構具有良好的表達能力,其應用范圍被拓展到目標識別[26]、影像分類[27]和影像檢索[28]等領域。CFOG是在HOG的基礎上發(fā)展的一種逐像素的結構特征描述符,其使用方向梯度信息來表達影像結構特性,能夠有效抵抗影像間的光照和對比度變化,以及非線性灰度差異。因此,本文同樣選擇利用影像梯度幅值和方向信息來構建AWOG特征描述符。

如圖1所示,對于一幅給定的影像,首先使用x方向的濾波器dx=[-1,0,1]和y方向的濾波器dy=[-1,0,1]T對影像進行濾波,得到影像在x軸和y軸方向的方向梯度gx和gy。

圖1 影像梯度方向OG和梯度幅值IG的計算Fig.1 Computational process of orientation and magnitude of image gradient

隨后根據(jù)式(1)和式(2)計算影像的梯度幅值IG和梯度方向OG。由于不同類型的傳感器所獲取的影像之間存在輻射強度反轉(zhuǎn)的現(xiàn)象[29],因此為削弱SAR影像和光學影像間因輻射強度反轉(zhuǎn)所造成的影響,以提高描述符的穩(wěn)健性,對梯度方向OG進行一步歸化操作[25,30],根據(jù)式(2)計算得到的梯度方向OG其值域為[0°,360°) ,將屬于區(qū)間[180°,360°)的值統(tǒng)一減去180°,OG的值域被歸化到[0°,180°)

(1)

(2)

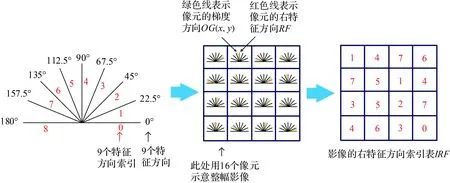

如圖2所示,按角度間隔為22.5°將OG的值域8等分,等分的區(qū)間被9個角度方向所隔開,由于特征描述符將在這9個角度方向上統(tǒng)計得到,故將它們稱為9個特征方向,按角度從小到大為9個特征方向賦予索引號0~8。

圖2 右特征方向索引表IRF的構建Fig.2 Construction of index table IRF

對于影像中任意像元p(x,y),其梯度方向值OG(x,y)存在于某兩個特征方向所構成的角度區(qū)間內(nèi)(極少數(shù)恰好位于某特征方向上,但不影響后續(xù)計算),將該角度區(qū)間中角度值較大的特征方向稱為像元的左特征方向LF,角度值較小的特征方向稱為像元的右特征方向RF,根據(jù)式(3)進行計算

(3)

可得到像元右特征方向的索引號IRF(x,y),由此對整幅影像進行計算,得到影像的右特征方向索引表IRF,該索引表將用于加速后續(xù)的計算過程。

如圖3所示,對于任意像元p(x,y),其梯度方向值OG(x,y)存在于其左特征方向LF和右特征方向RF所構成的角度區(qū)間內(nèi),因此可根據(jù)梯度方向值OG(x,y)與左右特征方向的角度差,將該像元的梯度幅值IG(x,y)加權分配到其左右特征方向上,OG(x,y)與其左右特征方向中某一個的角度差越小,說明OG(x,y)距離該特征方向越近,從而IG(x,y)向該特征方向分配的值越大;反之,OG(x,y)與該特征方向的角度差越大,說明OG(x,y)距離該特征方向越遠,IG(x,y)向該特征方向分配的值越小。

圖3 加權梯度幅值WIG1、WIG2的計算過程Fig.3 Computational process of weighted magnitude of image gradient

基于上述加權原則,根據(jù)式(4)計算像素的梯度方向值OG(x,y)與右特征方向RF的角度差θ1(x,y)以及與左特征方向LF的角度差θ2(x,y)

(4)

隨后根據(jù)θ1(x,y)和θ2(x,y)對梯度幅值IG(x,y)進行加權分配,由此對整幅影像進行處理,得到影像的加權梯度幅值WIG1和WIG2。

逐像元為中心在WIG1和WIG2上同時開辟尺寸為3×3像素的統(tǒng)計窗口,對兩個窗口內(nèi)9個特征方向上的加權梯度幅值進行統(tǒng)計,利用右特征方向索引表IRF加速統(tǒng)計過程,聯(lián)合兩個統(tǒng)計窗口,將統(tǒng)計結果以向量的形式輸出,該向量即為統(tǒng)計窗口中心像元的特征向量。使用索引表進行統(tǒng)計相比于不使用索引表的統(tǒng)計方式,在統(tǒng)計窗口內(nèi)的每個像元處均可減少兩次乘法、兩次除法和一次減法運算而只保留兩次加法運算,因此,使用索引表進行統(tǒng)計將極大地提高特征描述符的提取速度。

將每個像元處的特征向量沿垂直于影像平面的z軸方向排列便形成初步的影像描述符。隨后使用z軸方向的濾波器dz=[1,3,1]T對初步描述符進行濾波,z軸上的濾波操作對不同特征方向的特征值起到平滑作用,該操作能夠減小影像間局部幾何和強度變形引起的畸變所造成的影響[25]。對z軸濾波后的描述符進行歸一化便得到最終的AWOG特征描述符。

綜上,AWOG特征描述符的構建過程如圖4所示。

圖4 AWOG特征描述符的構建Fig.4 Construction of AWOG

1.2 相似性測度

由于AWOG描述符具有多層級結構,相比于傳統(tǒng)的單層描述符來說其數(shù)據(jù)量較大,在空間域中進行匹配較為耗時,因此選擇在頻率域中進行匹配[31],在頻率域中能夠顯著提高匹配時的計算速度[25],選擇描述符之間差值的平方和作為同名點匹配時的相似性準則,并利用快速傅里葉變換推導出在頻率域中表達的影像匹配函數(shù)。

差值的平方與表達的AWOG描述符之間的相似性測度表示為

d(v)=∑x[A1(x)-A2(x-v)]2

(5)

式中,x表示某像元的像素坐標;A1(x)和A2(x-v)分別表示參考影像描述符和輸入影像描述符被模板窗口覆蓋的區(qū)塊;變量v表示輸入影像描述符的搜索窗口中某像元相對于搜索窗口中心像元的偏移向量;d(v)為兩個描述符區(qū)塊之間的差值的平方和函數(shù)。

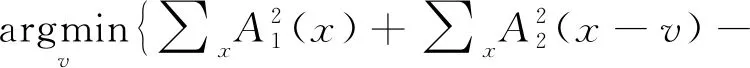

為了得到參考影像中的某像元在輸入影像上的最佳匹配位置,需對式(5)求最小值,由此,同名點的搜索問題轉(zhuǎn)化為計算使式(5)達到最小值的偏移向量vi。進而給出如下影像匹配函數(shù)

(6)

對于模板匹配的過程,需要在輸入影像搜索窗口中的每個像元位置上,計算與模板窗口間的相似性值,該計算過程非常耗時,因此,為了提高計算效率,采用快速傅里葉變換將該過程轉(zhuǎn)換到頻率域進行加速。

將式(6)中的平方項展開

2∑xA1(x)·A2(x-v)}

(7)

對于式(7),等式右側(cè)第1項的計算值是一個常數(shù),因此計算時可將其忽略。后兩項可以視為描述符之間的相關計算,由于空間域中的相關對應頻率域中的相乘,因此可利用快速傅里葉變換(二維或三維)將后兩項轉(zhuǎn)換到頻率域中計算。影像的匹配函數(shù)轉(zhuǎn)化為

2F-1[F(A2(x-v))F*(A1(x))]}

(8)

式中,F(xiàn)和F-1表示快速傅里葉變換的正變換和逆變換;F*表示對F求復共軛。

對于式(8),等式右側(cè)第1項表達輸入影像描述符與自身的相關計算,對于進行了歸一化的特征描述符如AWOG、FLSS[32]、FHOG[32]等,右側(cè)第1項的計算值幾乎為一個常數(shù),同時其在影像不同位置處的計算值的變化率對于式(8)右側(cè)第2項的計算結果幾乎沒有影響,因此參照文獻[32],選擇忽略式(8)右側(cè)第1項而只保留第2項。因此同名點匹配被轉(zhuǎn)化為計算對式(8)右側(cè)第2項反符號求得最大值時對應的偏移向量vi。最終得到如下影像匹配函數(shù)

(9)

式(9)表達了兩幅影像的描述符在頻率域中的互相關,該計算會得到一幅相關圖,因此通過確定最大反應值所在位置,便可以得到同名匹配點。

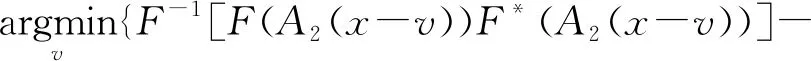

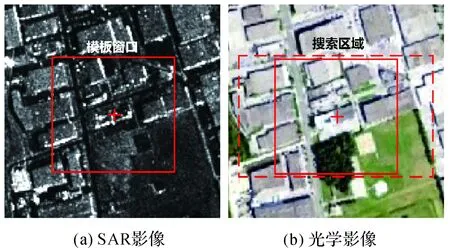

為驗證上述影像匹配函數(shù)的有效性,利用x方向的相似性曲線將其與MI[17]和NCC[18]進行比較,選擇尺寸為41×41像素的模板窗口在一組高分辨率城區(qū)影像上進行測試,測試影像如圖5所示。

圖5 相似性曲線測試影像Fig.5 Images for testing similarity curve

圖6展示SOFM、MI[17]和NCC[18]等3種方法在X方向上的相似性曲線,通過對比可以發(fā)現(xiàn),SOFM方法的相似性曲線比較光滑并成功檢測到了正確匹配位置,相比之下,MI和NCC方法的相似性曲線則不夠光滑,且峰值位置與正確匹配位置存在一定偏差。通過相似性曲線的對比,初步證明了本文方法的有效性,關于本文方法匹配性能的詳細分析見第3節(jié)。

2 SAR影像和光學影像模板匹配流程

(1) 將SAR影像作為參考影像,光學影像作為輸入影像,為兩影像構建影像金字塔。若影像間分辨率差異不超過2倍,一般為影像金字塔設置4個層級,層級間的縮放比為2;若影像間分辨率差異較大,則根據(jù)分辨率差異倍數(shù)為分辨率較高的影像增加一定的金字塔影像層數(shù),并通過建立查找表的方式在分辨率差異較小的層級間進行匹配。由低層級影像構建高層級影像時,先對低層級影像進行高斯濾波,后按照雙線性內(nèi)插的采樣方式生成高層級影像。隨后由頂層金字塔影像進入后續(xù)處理步驟。

圖6 SOFM、MI和NCC方法的相似性曲線Fig.6 Similarity curves of SOFM, MI and NCC

(2) 為保證所提取影像特征點的均勻性,選擇使用分塊Harris算子,計算參考影像中每個像元處的Harris特征值,隨后將影像劃分為n×n個互不重疊的格網(wǎng)區(qū)域,提取每個格網(wǎng)內(nèi)特征值較大的k個點作為特征點,整幅影像將得到k×n×n個特征點。關于劃分的格網(wǎng)數(shù)n和格網(wǎng)內(nèi)特征點數(shù)k的選擇,一般經(jīng)驗性的將k設置為1~5個點,再根據(jù)期望得到的總點數(shù)計算出格網(wǎng)數(shù)n。

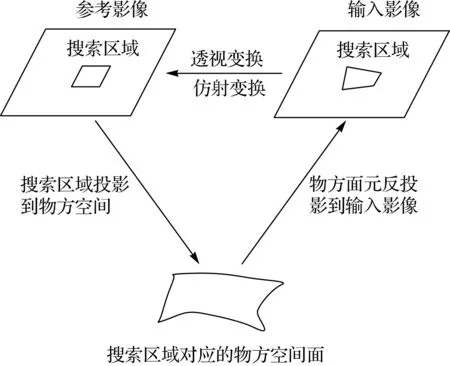

(3) 考慮到影像之間存在旋轉(zhuǎn)與尺度差異,而AWOG描述符不具備旋轉(zhuǎn)與尺度不變性,因此在匹配之前對影像進行image-reshaping操作(圖7)來消除影像間的旋轉(zhuǎn)和尺度差異,目前所允許的影像間的縮放倍數(shù)約為0.2~5。處理步驟為:①以特征點為中心在參考影像上確定一定尺寸的搜索區(qū)域;②給定搜索區(qū)域的近似高程面(區(qū)域平均高程面或已有概略DEM),利用參考影像的定向參數(shù)將搜索區(qū)域投影到近似高程面上,得到搜索區(qū)域?qū)奈锓矫嬖虎劾糜跋癯上衲P?如RFM模型)將物方面元反投影到輸入影像上得到相應的搜索區(qū)域范圍;④建立參考影像的搜索區(qū)域和輸入影像的搜索區(qū)域之間的透視變換或仿射變換模型,并根據(jù)所建立的變換模型對輸入影像的搜索區(qū)域進行重采樣,基本上消除其與參考影像之間的旋轉(zhuǎn)和尺度差異。

(4) 根據(jù)本文提出的SOFM算法,對經(jīng)過步驟(3)處理的參考影像和輸入影像的影像塊提取AWOG描述符,并根據(jù)給出的影像匹配函數(shù)完成同名點匹配。

(5) 重復步驟(3)—步驟(4),直至遍歷所有特征點,得到初始的同名點集合,由于匹配過程在提取的影像塊上進行,此時同名點坐標由局部像素坐標系所表達,因此通過坐標轉(zhuǎn)換將同名點坐標表達在原始輸入影像的像素坐標系上,并輸出初始同名點集合。

圖7 影像匹配時的image-reshaping操作 Fig.7 Image-reshaping processing used for image matching

(6) 構建二維透視變換表達的RANSAC框架,設置一定的粗差閾值及迭代次數(shù),將步驟(5)輸出的初始同名點集合輸入該框架,迭代剔除殘差大于閾值的點對,輸出內(nèi)點率最高的同名點集合。

(7) 構建二維透視變換表達的整體最小二乘模型,將步驟(6)剔除粗差后的同名點集合作為輸入,計算單個點的殘差和整體的標準差,迭代刪除殘差較大的同名點對,直至標準差小于給定的閾值,將剩余的同名點集合作為匹配結果,并由此計算當前層級金字塔影像的仿射變換參數(shù)。

(8) 重復步驟(2)—步驟(7),并將計算出的仿射變換參數(shù)向低層級影像傳遞,從而實現(xiàn)由粗到精的影像匹配策略,直至完成金字塔底層影像的匹配,并記錄最終輸出結果。

3 試驗與分析

為驗證所提出方法的有效性,本文試驗將僅考慮影像間的平移差異,對于影像間的旋轉(zhuǎn)和尺度差異可通過第2節(jié)中的image-reshaping操作進行消除,使得影像間只剩余平移參數(shù)未知,而平移參數(shù)與影像自身的無控定位精度有關。因此,為簡化試驗步驟,試驗中所使用的參考影像均為經(jīng)過多視處理后的SAR影像的數(shù)字正射影像圖(以下簡稱DOM),輸入影像均為經(jīng)過正射糾正后的光學影像的DOM。試驗過程中使用的計算機配置為Intel(R)Core(TM)i9-10885H CPU @2.4 GHz,64 GB。

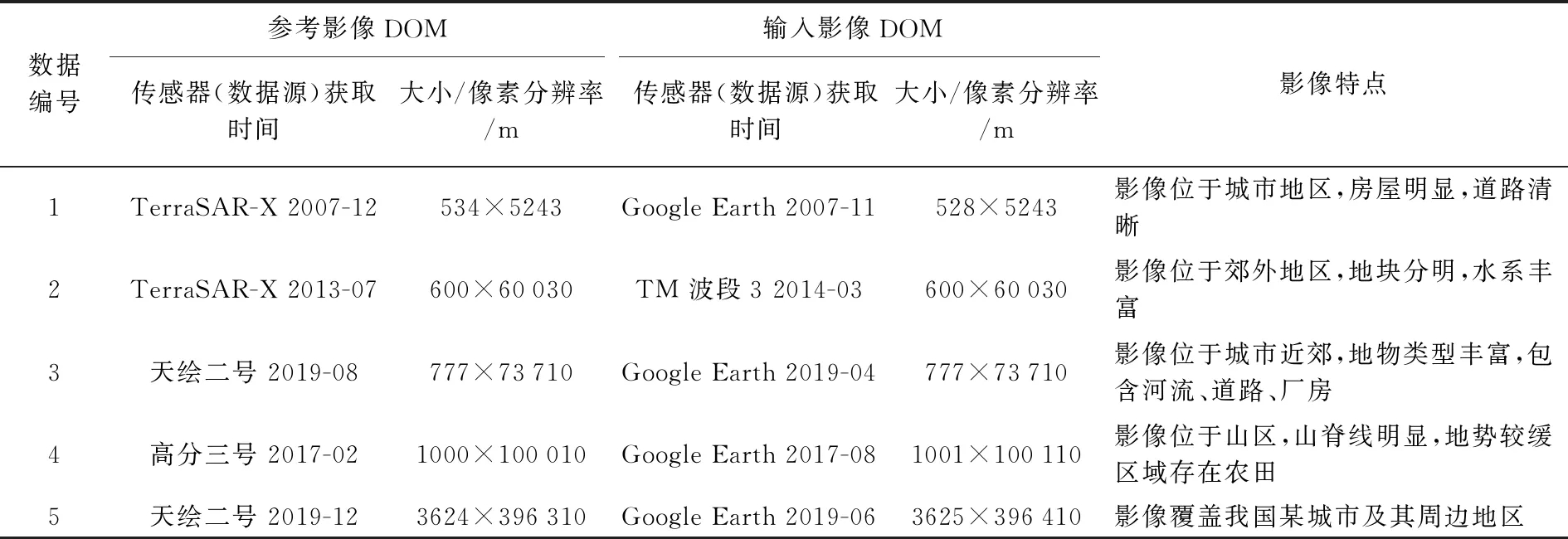

3.1 試驗數(shù)據(jù)

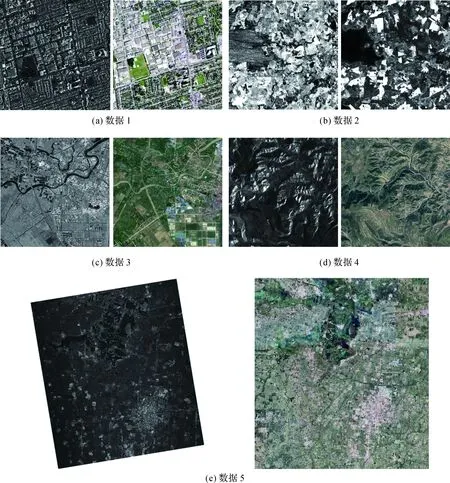

選擇5組不同分辨率且覆蓋不同地面場景的SAR影像和光學影像的DOM作為試驗數(shù)據(jù),如圖8所示。具體的數(shù)據(jù)描述見表1。

表1 試驗數(shù)據(jù)描述

圖8為試驗影像的縮略圖,可以看出每組影像間均存在顯著的非線性灰度差異。

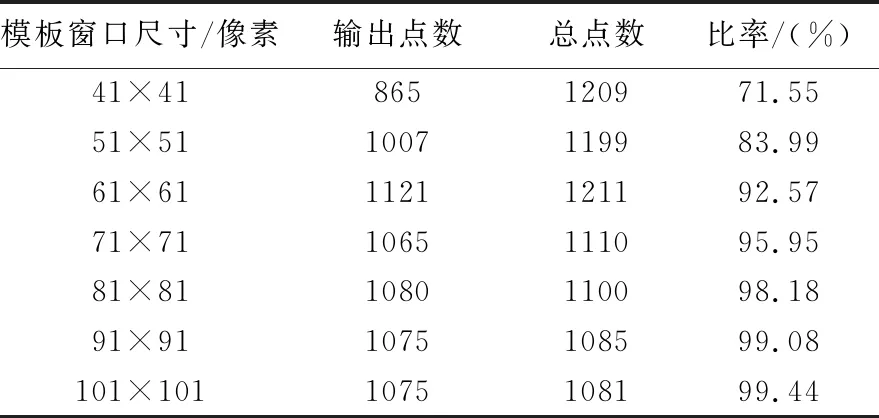

3.2 SOFM方法對模板窗口大小的適應性分析

使用表1中的第5組試驗數(shù)據(jù),按照第2節(jié)的匹配流程對影像進行匹配,固定搜索窗口為31×31像素,改變模板窗口的尺寸(41×41像素~101×101像素),記錄最終輸出的點數(shù)以及匹配到的總點數(shù),試驗結果見表2。

表2 不同模板窗口下的影像匹配結果

分析表2中的結果可知,隨著設置的模板窗口尺寸的增大,最終輸出的點數(shù)逐漸增多且趨于穩(wěn)定,輸出點數(shù)占匹配總點數(shù)的比率逐漸上升,當模板窗口尺寸設置為61×61像素時,輸出點的數(shù)量以其占總點數(shù)的比率均已達到較高水平,因此在應用中將模板窗口的尺寸固定為61×61像素即可。

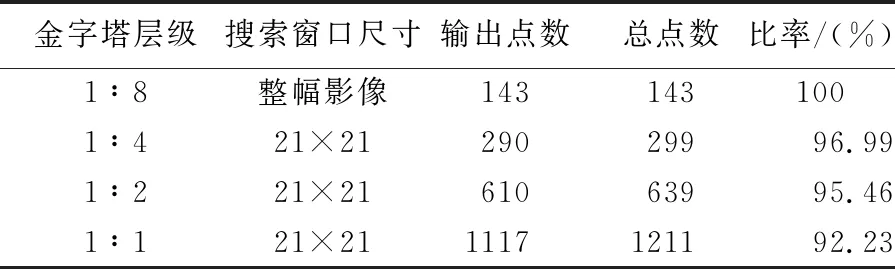

3.3 SOFM方法對搜索窗口大小的適應性分析

使用表1中的第5組試驗數(shù)據(jù),對試驗影像建立影像金字塔(4級),相鄰層級間的縮放倍數(shù)為2,選擇61×61像素的模板窗口,對頂層金字塔影像進行整個影像范圍內(nèi)的搜索,計算影像間的仿射變換參數(shù)并向低層級影像傳遞,并對低層級影像重新提取特征點,在低層級影像中設置21×21像素的搜索窗口,記錄最終輸出的點數(shù)以及匹配到的總點數(shù),試驗結果見表3。

表3 影像金字塔匹配結果

圖8 試驗影像Fig.8 The images used in the experiments

對表3進行分析可知,在影像匹配時,通過使用對影像建立影像金字塔的方式,既能加快影像匹配的速度,又能穩(wěn)定地獲取數(shù)量足夠多的同名點。

3.4 匹配性能對比分析

為驗證SOFM方法的匹配性能,使用表1中的第1~4組試驗數(shù)據(jù),選擇CFOG[25]、HOPC[23]、DLSC[33]、MI[17]、NCC[18]等方法進行對比分析與評價,對比的內(nèi)容包括:正確匹配率(正確匹配率=正確匹配點數(shù)/總匹配點數(shù))、計算效率和均方根誤差(RMSE)等3個方面。試驗步驟為:①在參考影像上提取200個Harris特征點;②利用影像金字塔為每個特征點在輸入影像上確定一個21×21像素的搜索窗口,采用不同尺寸的模板窗口(31×31像素~91×91像素)對影像進行匹配并記錄不同方法的性能表現(xiàn)。

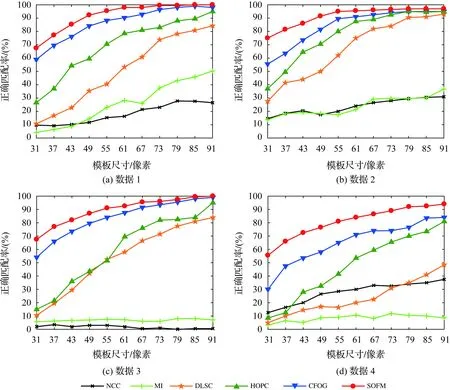

圖9展示了參與對比的6種匹配方法在4組試驗影像上的正確匹配率(容差為1.5像素)。

通過對圖9進行分析可以得到以下結論。

(1) NCC方法總體上在各組試驗中的正確匹配率最低,甚至在第3組試驗中出現(xiàn)了近乎匹配失敗的情況,究其原因,NCC方法直接利用影像的灰度信息進行匹配,其能夠?qū)τ跋耖g的線性灰度變化具有良好的適應性,但對影像間的非線性灰度差異非常敏感,因此NCC方法在進行光學影像間的匹配時表現(xiàn)良好,但在匹配SAR影像和光學影像時效果較差。

(2) MI方法在多組試驗中的表現(xiàn)雖然優(yōu)于NCC方法,但其總體上的正確匹配率仍然較低,MI方法本質(zhì)是依賴影像灰度的統(tǒng)計信息進行匹配,故理論上來講其匹配效果應與影像間灰度變化的方式相關性較弱,但MI方法在匹配過程中不考慮鄰域像素的影響,導致計算結果容易陷入局部極值而產(chǎn)生誤匹配,因此MI方法不適用于SAR影像和光學影像的匹配。

圖9 SOFM、CFOG、HOPC、DLSC、MI和NCC在不同模板尺寸下的正確匹配率Fig.9 The correct matching ratios of SOFM, CFOG, HOPC, DLSC, MI and NCC with different template sizes

(3) HOPC和DLSC方法的表現(xiàn)較好,總體來看,HOPC在各組試驗影像上的正確匹配率均高于DLSC。這兩種方法屬于基于影像結構特性的匹配方法,HOPC和DLSC方法分別利用了影像的相位一致性(PC)和局部自相似性(LSS)信息來表達影像的幾何構造,但是由圖9可知,相比于SOFM這兩種方法的匹配性能受模板尺寸變化的影響較大,在模板尺寸較大時,能夠得到較高的正確匹配率;但當設置的模板尺寸逐漸減小時,這兩種方法的正確匹配率會出現(xiàn)較明顯的降低。

(4) 相比于上述的幾種方法,SOFM和COFG在各試驗像對上的正確匹配率更高,但是整體而言,SOFM方法在每組試驗中的表現(xiàn)均優(yōu)于CFOG。SOFM的正確匹配率受模板尺寸變化的影響更小,性能更加穩(wěn)定,在模板尺寸較小時仍能保證較高的正確匹配率。當設置模板尺寸為31×31像素時,SOFM方法在4組試驗上的正確匹配率平均要比CFOG方法高17.8%。分析其原因,可能是由于CFOG方法是利用水平和垂直方向的梯度插值得到多個固定方向的方向梯度,并對方向梯度進行高斯卷積來得到目標像素的特征向量。而這種計算方式會引入一定程度的模糊,降低特征向量之間的區(qū)分性,因此當設置模板尺寸較小或影像質(zhì)量較差時,會導致其匹配效果出現(xiàn)一定程度的下降。而SOFM方法則是以方向間的角度差為權重,將像素的梯度值加權分配到與梯度方向相關性最強的兩個固定方向上,同時結合索引表進行鄰域統(tǒng)計得到目標像素的特征向量,增強了特征向量的獨特性,因此其穩(wěn)健性更好,匹配效果更優(yōu)。

圖10展示了各方法在4組試驗中的平均運行時間。

圖10 SOFM、CFOG、HOPC、DLSC、MI和NCC在不同模板尺寸下的平均運行時間Fig.10 The average running times of SOFM, CFOG, HOPC, DLSC, MI and NCC with different template sizes

分析圖10可得如下結論。

(1) 總體上MI方法的計算效率最低,其次較低的是DLSC方法,NCC方法的計算效率雖然較高,但是其匹配效果較差,HOPC方法的計算效率略高于NCC。CFOG方法的計算效率最高,SOFM方法的計算效率略低于CFOG方法。

(2) SOFM和CFOG方法的時間消耗隨著模板尺寸的增大只有微小增加,而其他4種方法的時間消耗會隨著模板尺寸的增大而迅速增加。當模板尺寸較大時(47×47像素及以上),HOPC和DLSC方法能夠得到較高的正確匹配率,但同時也會有更長的時間消耗。

(3) 當設置模板尺寸91×91像素時,SOFM、CFOG、HOPC、DLSC、MI、NCC等方法的時間消耗分別為2.51、1.31、11.18、30.17、29.44和14.99 s,通過數(shù)據(jù)對比可以看出,除CFOG比SOFM方法快1.2 s之外,NCC方法的時間消耗約是SOFM方法的6倍,最慢的DLSC方法的時間消耗約是SOFM方法的12倍。因此,相較之下,SOFM方法在保證較高的正確匹配率的前提下,達到了快速匹配的效果。

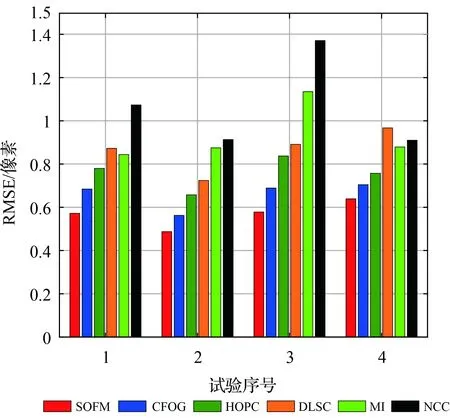

圖11展示了當模板尺寸為91×91像素時各方法在4組數(shù)據(jù)上的RMSE。由圖11可知SOFM方法在各組試驗影像上均具有最小的RMSE,這說明相較于其余幾種方法,SOFM方法具有最高的匹配精度,能夠在進行SAR影像和光學影像的匹配時更具優(yōu)勢。

圖11 SOFM、CFOG、DLSC、HOPC、MI和NCC在各試驗影像上的RMSEFig.11 The RMSEs of correct matches of SOFM, CFOG, HOPC, DLSC, MI and NCC

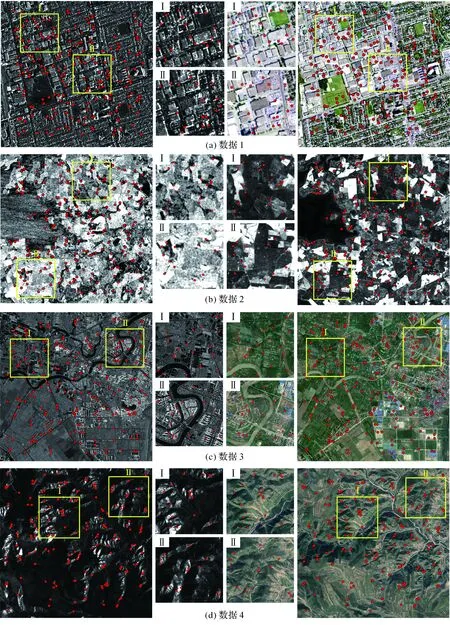

圖12展示了SOFM方法在各組試驗影像上的匹配結果(模板尺寸61×61像素),可以看出匹配到的同名點數(shù)量充足且分布均勻,觀察局部放大圖能夠看到同名點的對應位置關系是正確的。

通過以上的各組試驗和對比分析,證明了本文提出的SOFM方法在正確匹配率、匹配穩(wěn)定性、計算效率和匹配精度等方面均更具優(yōu)勢,能夠快速、高效地完成SAR影像與光學影像之間的自動匹配任務。

4 討 論

針對當前遙感領域較為困難的SAR影像和光學影像間的匹配問題,本文提出了一種基于影像結構特性的快速匹配方法SOFM。該方法利用影像的梯度信息構建了一種特征描述符—角度加權方向梯度AWOG,然后利用描述符之間的差值的平方和建立了用于模板匹配的相似性測度,并推導出了利用快速傅里葉變換在頻率域中表達的影像匹配函數(shù),在頻率域中進行影像匹配能夠大幅提高計算效率,隨后給出了使用本文方法的模板匹配流程。通過與現(xiàn)有的影像匹配方法CFOG、HOPC、DLSC、MI和NCC在多個方面進行對比分析,結果顯示:SOFM方法能夠較好地抵抗SAR影像與光學影像之間的非線性灰度差異,其匹配性能良好且更具穩(wěn)定性,同時在計算效率和匹配精度方面也有著優(yōu)異的表現(xiàn)。SOFM方法能夠快速地完成SAR影像與光學影像之間的自動匹配任務,獲得精度高且分布均勻的同名匹配點,為后續(xù)的相關應用提供了可靠保障。

圖12 SOFM的匹配結果Fig.12 The image matching results of SOFM

考慮到SAR影像生成的正射影像圖(DOM)的平面精度基本只與傳感器的定軌精度有關,與瞬時成像姿態(tài)角幾乎沒有相關性,而目前衛(wèi)星定軌精度已經(jīng)達到足夠高的水平,因此SAR影像的DOM能夠保證較高的平面精度[34]。筆者下一步的工作將使用由天繪二號衛(wèi)星數(shù)據(jù)生成的正射影像圖(DOM)及數(shù)字高程模型(DEM)作為控制信息,將光學原始影像與之進行匹配,匹配得到的同名點將作為控制點來精化光學原始影像的RPC參數(shù),從而可形成一套完全基于國產(chǎn)SAR衛(wèi)星數(shù)據(jù)和光學衛(wèi)星數(shù)據(jù)的無控測圖方法流程,以期在無法實地測得控制點的境外地區(qū)實現(xiàn)高精度的無控測圖。

試驗過程中也發(fā)現(xiàn)本文方法目前存在一定不足:①SOFM方法中的AWOG描述符不具有旋轉(zhuǎn)和尺度不變性,但可利用影像的定向參數(shù)基本消除影像間的旋轉(zhuǎn)和尺度差異(見第2節(jié))。試驗結果表明,對于地形起伏較小的區(qū)域如平地、丘陵地甚至是山體高度變化不大的山區(qū),本文方法都能得到較好的匹配結果,但是對于高程變化劇烈的山區(qū)如我國橫斷山區(qū),方法便有可能失效,因此尚需要進一步研究能夠抵抗局部影像間旋轉(zhuǎn)和尺度差異的方法,以更好地解決復雜地形區(qū)域的SAR影像與光學影像之間的匹配。②SOFM方法依賴于影像中蘊含的結構特征進行匹配,如果影像的結構特征不夠豐富,如影像中含有大面積的森林區(qū)域,則方法得到的有效特征點數(shù)量會有一定程度的減少,同時其分布情況也會在一定程度上變差,因此,在進一步的研究中將考慮引入紋理特征來輔助進行匹配。