基于深度掩碼的玉米植株圖像分割模型

鄧寒冰,許童羽,周云成,苗 騰,3,李 娜,吳 瓊,朱 超,沈德政

基于深度掩碼的玉米植株圖像分割模型

鄧寒冰1,2,許童羽1,2※,周云成1,2,苗 騰1,2,3,李 娜1,2,吳 瓊1,2,朱 超1,沈德政1

(1. 沈陽農業大學信息與電氣工程學院,沈陽 10866;2. 遼寧省農業信息化工程技術研究中心,沈陽 10866;3. 北京農業信息技術研究中心,北京 00097)

隨著深度學習技術在植物表型檢測領域的應用,有監督深度學習逐漸成為植物表型信息的提取與分析的主要方法。但由于植物結構復雜、細節特征多,人工標注的成本和質量問題已成為制約技術發展的瓶頸。該研究針對玉米苗期植株圖像分割問題提出一種基于深度掩碼的卷積神經網絡(Depth Mask Convolutional Neural Network,DM-CNN),將深度圖像自動轉換深度掩碼圖像,并替代人工標注樣本完成圖像分割網絡訓練。試驗結果表明,在相同的網絡訓練參數下,通過測試DM-CNN得到的平均交并比為59.13%,平均召回率為65.78%,均優于人工標注樣本對應的分割結果(平均交并比為58.49%,平均召回率為64.85%);此外,在訓練樣本中加入10%室外玉米苗期圖像后,DM-CNN對室外測試集的平均像素精度可以達到84.54%,證明DM-CNN具有良好的泛化能力。該研究可為高通量、高精度的玉米苗期表型信息獲取提供低成本解決方案及技術支持。

圖像分割;模型;圖像處理;玉米;深度掩碼;植物表型;深度密度函數

0 引 言

隨著越來越多的視覺傳感器應用于植物全生長期信息采集過程,計算機視覺技術逐漸成為植物表型組學領域的研究重點。如何快速、高精度地獲取植物表型信息一直都是該領域研究的技術難點,而圖像分割方法是解決該問題的一個重要技術手段。

傳統的圖像分割對象主要分為灰度圖像和彩色圖像,由于人眼對復雜圖像只能識別幾十個灰度等級,同時分割場景不斷復雜化,對分割技術的算法要求也愈加嚴格,因此在多數情況下只利用灰度信息無法從背景中提取目標,必須借助于彩色圖像[1]。彩色圖像分割有很多方法,基于顏色和空間特征可以將圖像分割分為有監督和無監督。目前,大量成熟的有監督算法(如最大似然、決策樹、K-最鄰近、神經元網絡等)已經可以利用不同顏色空間實現果實、植株、葉片和根系等圖像分割[2]。而對于無監督方法來說,聚類算法是這類方法的首選,Jiao等[3]基于圖聚類與高級語義相結合的無監督分割方法,將給定的圖像過分割成一組超像素,在底層視覺特征中加入圖像顯著性作為人類感知的先驗知識,提高了無監督圖像分割的精度。此外,彩色圖像作為多光譜圖像的一個特例,從數據類型、預處理方法、特征提取方法、算法效率等幾個方面看,任何適用于多光譜圖像的分割方法也都可以用于彩色圖像分割[4]。而大部分適用于灰度圖像的分割方法(直方圖閾值法、聚類法、區域增長、邊緣檢測、模糊算法等)也可以擴展到彩色圖像,其原理是將彩色圖像劃分為多個顏色空間分量(如RGB、HSV、Lab空間分量),在不同的顏色空間分量上使用灰度圖像的分割方法,通過找到特定區域內的特征相似性,對像素進行聚類可獲得分割結果[5]。為了提高分割大尺寸圖像的算法效率,超像素算法也成為計算機視覺領域的一個重要手段,將大尺寸圖像均勻分成固定的初始區域,在區域內將近似像素聚合成超像素,降低后續計算的算法復雜度[6]。

在傳統計算機視覺、機器學習等方法的支撐下,植物表型檢測領域的研究人員已經將算法集成到軟硬件平臺上,為植物表型信息高通量獲取提供工具和技術手段。Jin等[7]從表型特征傳感器、地面和空中表型平臺應用兩個方面進行闡述,通過分析圖像、葉綠素熒光圖像和熱紅外圖像等信息,實時量化植物生長過程,光合作用情況等,為大規模、多維度的植物表型信息獲取與分析提供了全面的一體化的解決方案。Filipa等[8]設計了rosettR系統,用于在無菌環境下計算植株幼苗期花環總面積,面積差代表不同基因型之間的生長差異,以及對光照條件和滲透的脅迫,利用混合模型設定閾值,將前景與背景分離,同時基于特征排序實現植株圖像的精準分割;Zhou等[9]人設計了Leaf-GP系統,該系統可以用于不同的計算平臺,實現擬南芥和小麥的高通量信息獲取,通過提取RGB圖像中的高綠值區域來區分葉片顏色與土壤表面藻類顏色,同時利用葉片端點圍成的區域,獲取該區域葉片分割圖像;Massimo等[10]設計了Phenotiki系統,對擬南芥形體、生長過程、葉片顏色和葉片數量進行統一分析,利用半監督學習算法實現對葉片區域的自動分割過程。

傳統的圖像分割算法主要是基于圖像的紋理、顏色、形狀等人工設計的底層特征對圖像進行分割,分割精度受人工因素制約,算法缺少普適性和遷移性。而隨著深度學習技術的發展,人們利用深度神經網絡從原始圖像中自動抽取圖像的多尺度特征,并通過上采樣方式將特征圖恢復到與輸入圖像相同的分辨率,實現對目標的端到端、高精度、像素級圖像分割[11]。特別是隨著深度學習和遷移學習的融合,利用“預訓練+調優”(Pre-training + Fine-tuning)的方式可以使模型泛化能力得到提升,使用遷移參數來初始化深度學習網絡,以提升網絡性能[12]。目前,深度神經網絡已經成為實現語義分割[13-14]、實例分割[15-16]和全場景分割[17-18]的首選模型。特別是在植物表型信息的提取方面,由于植物的生長環境和品種的差異都會造成其植株、器官、果實等圖像信息差異性較大,很難通過人工特征提取方式實現高精度圖像分割。因此,國內外研究機構已經嘗試將深度學習技術應用于植物表型信息獲取與表達。

Sa等[19]通過改造Faster R-CNN模型,從顏色和近紅外兩種模式提取特征信息,實現甜椒的快速檢測。Pound等[20]利用改進后的CNN模型,實現對于小麥根系、葉片、葉根、穗尖和穗根等部位的識別,發現了部分小麥生物學性狀與關鍵基因點位的關聯。Dyrmann等[21]提出一個基于全卷積神經網絡的自動雜草識別方法,該方法在強葉片遮擋條件下可以識別谷物生長區域的單株雜草實體,該團隊還利用CNN實現對22種植物種類的分類,準確率在86.2%[22]。Mostafa等[23]利用三種深度學習模型來識別植物類別,通過遷移學習的方式對預訓練模型進行調優處理,通過數據增強和參數控制,提高了網絡的識別能力并降低了過擬合。Yalcin等[24]利用深度學習框架來識別若干種植物的物候期,采用預訓練的卷積神經網絡自動提取圖像特征,其試驗結果表明CNN在物候期判別方面由于基于手工特征的機器學習算法。

在深度學習技術的推動下,國內研究人員也廣泛開展相關的研究工作,試圖從利用深度學習模型簡化特征提取過程,提高植物表型特征的提取精度。段凌鳳等[25]基于SegNet模型構建了PanicleNet深度卷積神經網絡,利用模型將原圖像劃分出的子圖像進行分割,在拼接子圖得到稻穗圖像分割結果。劉立波等[26]針對全卷積網絡分割精度低的問題,提出一種結合條件隨機場的改進全卷積網絡模型,實現棉田冠層圖像分割,平均像素精度為83.24%。陳進等[27]通過改進U-Net網絡,增加網絡深度和批量歸一化層,實現水稻收獲籽粒圖像分割,解決由于訓練數據少造成的過擬合問題。任守綱等[28]提出一種基于反卷積引導的VGG網絡模型,利用反卷積全連接層實現番茄葉部病害分割,在遮擋和弱光條件下具有強魯棒性。張善文等[29]利用編碼-解碼網絡結構,提出一種基于多尺度融合卷積神經網絡,實現了在復雜背景下的黃瓜病害葉片病斑區域分割。項榮等[30]設計一種基于最大類間方差法的改進脈沖耦合神經網絡模型,對原模型中鏈接輸入項進行加權處理,實現了番茄植株夜間圖像分割。

大部分深度學習方法都是基于有監督學習模式,即利用人工標注的數據樣本對深度學習模型進行訓練,進而得到具備一定泛化能力的網絡模型,實現對目標對象的分類、目標檢測、圖像分割等計算機視覺任務。然而,在對植物進行人工標注時,由于植物本身結構復雜、細節內容較多、空間遮擋等問題,標注難度遠超過常規標注任務,這導致標注時間增加,標注精度下降等問題,提高了人工標注的成本。為了能夠解決這問題,本研究以玉米植株為研究對象,提出一種基于深度掩碼的卷積神經網絡(Depth Mask Convolutional Neural Network,DM-CNN),在原Mask R-CNN[31]的基礎上增加了深度掩碼通道,該通道利用深度相機獲取的深度圖像,自動產生深度掩碼圖像,為訓練過程自動提供玉米植株的標注信息,降低了人工標注成本,同時簡化了室內環境下基于有監督學習的玉米植株表型信息獲取過程。

1 材料與方法

1.1 試驗材料和數據采集

試驗選擇的玉米品種為“先玉335”,自選系PH6WC為母本、PH4CV為父本組配而成。PH6WC是從PH01N× PH09B雜交組合選育而成,來源于Reid種群;PH4CV是從PH7V0×PHBE2雜交組合選育而成,來源于Lancaster種群。該品種幼苗綠色,葉鞘紫色,葉緣綠色,花藥粉紅色,穎殼綠色,株型緊湊,成株葉片數19片左右,具有高抗莖腐病、中抗黑粉病、彎孢菌葉斑病、大斑病、小斑病、矮花葉病和玉米螟等,其優越的抗病性可以讓玉米在其營養生長期保持個體健康和株形完整。此外,為了增加玉米苗期植株形體的多樣性,本試驗分別選取玉米營養生長期30~35 d的植株作為研究對象,單體株高在25~120 cm范圍內。

試驗的圖像采集設備為Kinect傳感器2.0(彩色鏡頭分辨率1 920×1 080,30FPS;深度鏡頭分辨率512×424,30FPS),該設備可以在同一時刻采集鏡頭范圍內的彩色信息和深度信息。由于本研究提出的圖像分割模型對于深度圖像有精度要求,考慮到Kinect利用結構光來計算目標到攝像頭距離,而室外自然光源會嚴重干擾傳感器對目標距離(深度值)的估算,因此本試驗在室內環境下采集玉米植株深度圖像信息。官方提供的Kinect傳感器2.0的最優拍攝距離為0.5~4.5 m,因此本試驗將傳感器的拍攝位置固定,與拍攝對象(玉米植株)保持約2.0~2.5 m的距離,玉米植株與背景布有0.5~1.0 m的距離,這樣可以保證背景布和玉米植株都在Kinect的有效拍攝范圍內,具體的試驗場景布局如圖1所示。

試驗選取了400株玉米苗期植株,植株高度范圍是25~120 cm。在試驗中傳感器是固定的,玉米植株被放置在可旋轉底座上,通過旋轉底座可以從不同角度對玉米植株進行拍攝取樣。試驗分別選取了8個拍攝角度進行拍攝,即可以獲得的原始圖像樣本包括3 200張彩色圖像(RGB圖像)和3 200張深度圖像(灰度圖像)。其中彩色圖像包括訓練樣本(2 600張)、驗證樣本(400張)和測試樣本(200張)。樣本集采用同分布抽樣形成每類樣本集,保證所有高度的玉米植株在不同樣本集的分布是相同的。

由于本試驗要基于Mask R-CNN模型對人工標注樣本和深度掩碼標注樣本的訓練效果和實例分割精度進行對比,因此需要將彩色圖像與深度圖像的像素進行像素映射,以保證深度圖像與彩色圖像在空間內容上的一致性。由于微軟提供的像素映射函數會在RGB圖像中生成大量的噪點,而大部分的噪點會出現在玉米植株葉片附近,這會影響模型訓練中的特征提取效果,因此本研究通過直接調整RGB圖像與深度圖像的大小和顯示區域使2種圖像實現內容上的近似映射。

為了在訓練過程中使用高分辨率的圖像,試驗選擇分辨率為1 024×1 024的圖像作為訓練樣本,避免出現圖像目標對象缺失,同時保證Kinect在拍攝較矮植株(20~50 cm)信息完整,本試驗在訓練之前,先將彩色圖像與深度圖像進行像素近似映射處理。由于初始RGB圖像的分辨率為1 920×1 080,而目標植株的拍攝位置位于幕布的中心區域,在不改變原始RGB圖像分辨率的前提下,本試驗直接在原始的圖像中心區域獲取分辨率為1 024×1 024大小的彩色圖像;同時對于深度圖像,根據Kinect相機的內參和外參將深度圖像向彩色圖像進行像素映射,在多次調整和匹配后,發現可以通過擴充、裁剪等方式將原深度圖像的分辨率擴展為1 024×1 024,并保證RGB圖像與深度圖像內容上的近似映射。具體做法是首先將深度圖像的高和寬分別擴大為原圖像的1.437倍,然后選取圖像中行坐標為25、列坐標為18位置的像素作為裁剪區域的左上角,截取分辨率為700×540的圖像,再通過雙線性內插操作將截取區域放大到分辨率為1 400×1 080的深度圖像,最后在中心區域截取1 024×1 024像素的深度圖像,這時的深度圖像與彩色圖像可以實現像素映射,而這些處理后的深度圖像,可以用于生成深度掩碼標注樣本,且在樣本數量和樣本內容上與RGB圖像的樣本集合保持一致,具體操作過程如圖2所示。

1.2 試驗過程和模型

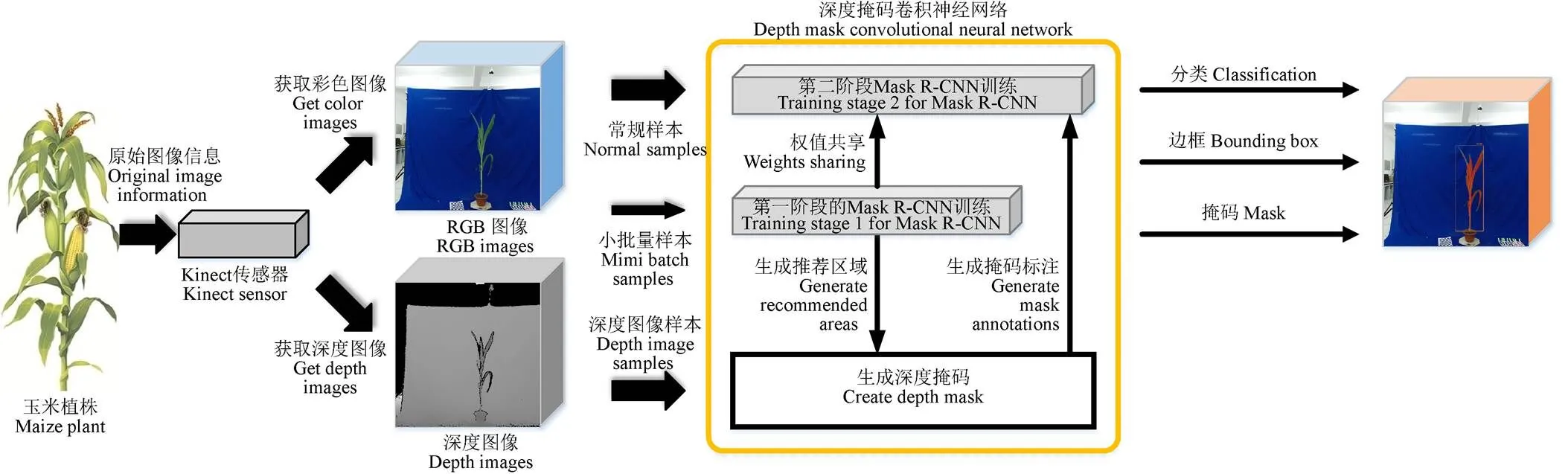

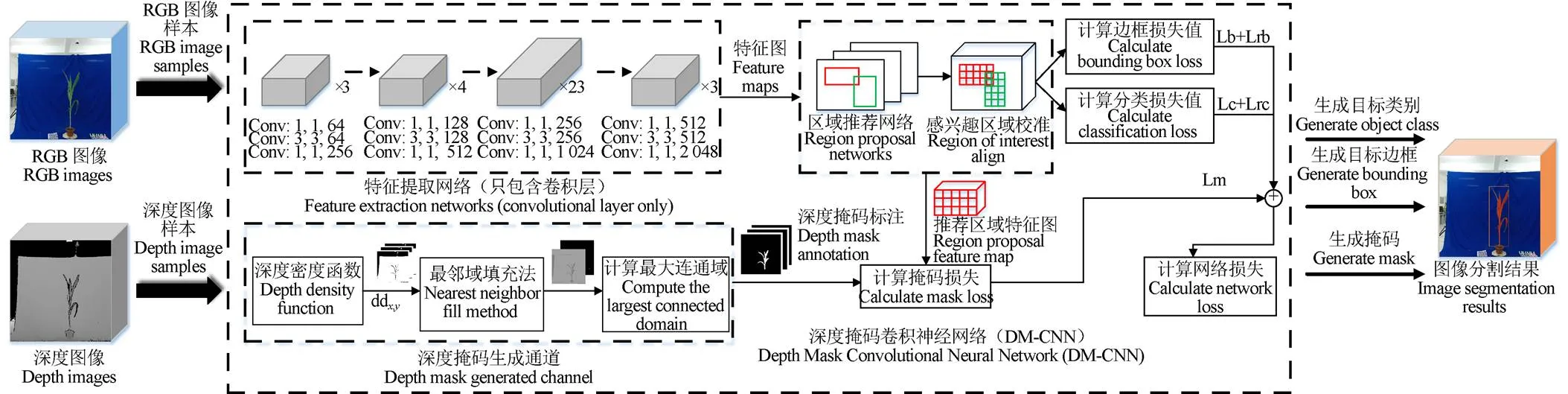

本研究提出了一種利用玉米植株的深度圖像,自動生成植株目標區域掩碼的方法,利用該方法產生的標注信息實現網絡的自動訓練和圖像分割,模型訓練和圖像分割過程如圖3所示。在Mask R-CNN網絡的基礎上增加深度掩碼通道,將深度圖像自動轉換成可供網絡訓練的掩碼,以替代人工標注過程來產生標注樣本。此外,將網絡的訓練過程分為兩個階段,利用小批量樣本訓練模型的目標識別能力,讓網絡能夠識別玉米植株并產生一個目標區域;深度掩碼生成算法可以利用該目標區域產生玉米植株的掩碼,用于第二階段的網絡訓練,同時第二階段的訓練過程也可以共享第一階段的權值,加速訓練收斂。最終,訓練后的網絡模型可以用于分割玉米植株圖像。

1.3 平臺與性能參數

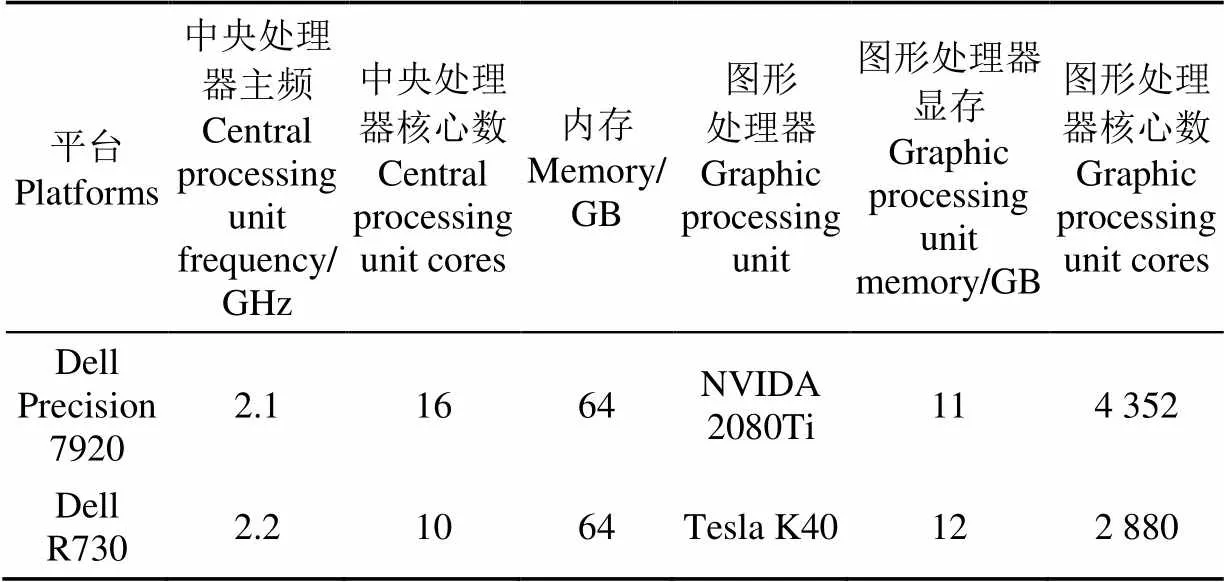

由于試驗后期需要對不同樣本集訓練的模型進行測試和對比,為了加速樣本訓練速度,本試驗分別將不同訓練集對應的訓練任務分配到1臺工作站和1臺服務器上完成。不同的平臺主要存在圖形處理器性能上的差異,只會影響訓練總時長,對訓練結果不會產生影響。詳細平臺的相關參數如表1所示。

圖3 利用自動生成的深度掩碼實現深度掩碼卷積神經網絡的訓練及圖像分割

表1 試驗平臺參數

在試驗過程中記錄了不同顯卡在處理相同任務所耗費的時間,Tesla K40圖形處理器在處理2 600張圖像(分辨率為1 024×1 024)所耗費的時間約為5 000 s,而NVIDA 2080Ti圖形處理器在處理相同任務耗費的時間約為1 500 s,可以看出后者圖形處理器由于其核心數和顯存帶寬較大,因此在訓練時長上明顯低于Tesla K40圖形處理器,對于相同的任務至少能節約2/3的時長。

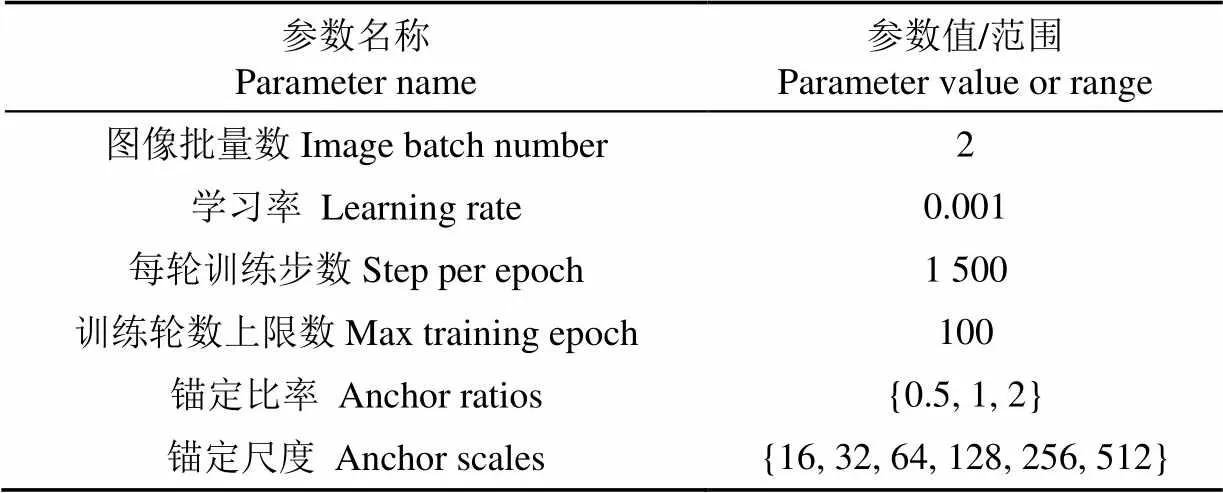

1.4 網絡構建與參數設置

深度卷積神經網絡對圖像的特征提取效果直接決定最終的圖像分割的結果。本試驗使用的玉米植株圖像類別單一、場景簡單,但對玉米植株的株形、葉片細節等部分的特征提取有較高的要求,因此本研究在選擇特征提取網絡時,利用多層小尺寸卷積核來組合出更多的細節特征,進而表達玉米植株的關鍵屬性。但當無限制的增加卷積層數并不能帶來特征提取性能的無限提升,反而會導致網絡收斂變得更慢,分類精度也變得更差,產生“越深越差”的現象。為解決這一問題,He等[32]在2016年提出了殘差卷積神經網絡(ResNet),利用殘差學習方法徹底解決了深度卷積神經網絡“越深越差”問題,在網絡中嵌入了基本的殘差學習模塊,通過使用多個殘差網絡層來學習輸入輸出之間的殘差表示,該研究表明使用一般意義上的殘差層來學習殘差比直接學習輸入、輸出間映射可以獲得更快的收斂速度和更高的分類精度。目前,ResNet已經成為圖像基礎特征提取的主要模型,文獻[32]一共給出了5種深度的網絡結構(ResNet-18、ResNet-34、ResNet-50、ResNet-101和ResNet-152),其中ResNet-152在ImageNet數據集上的top-1和top-5的分類錯誤率方面表現最好,但考慮到本試驗使用的樣本量相對少且類別單一,對于越深的網絡出現過擬合的風險就越大,而且ResNet-101在ImageNet數據集上的top-1和top-5分類錯誤率方面同樣非常優秀,因此本試驗選擇ResNet-101作為特征提取網絡,用來完成玉米植株圖像的特征提取任務。Mask R-CNN[31]是He團隊在2017年提出的實現端到端的像素級別的圖像實例分割模型[32]。其在Faster R-CNN基礎上發展而來,除了Faster R-CNN結構中的bounding-box回歸分支和分類分支之外,又增加了預測目標掩碼的分支,用于在bounding-box區域內產生不同對象的像素級別的二值掩碼,將目標檢測和對象分割并行處理,取得非常不錯的實例分割結果。2018年,He又對Mask R-CNN進行了優化,實現了常規場景下的全目標的實例分割[34]。

Mask R-CNN和ResNet在卷積層部分是共享權值的,因此本試驗首先利用公開數據集對ResNet的進行預訓練,用于提高Mask R-CNN模型中卷積層的泛化能力和特征提取能力。本研究以微軟的COCO[35]數據集訓練后的ResNet-101卷積層參數對Mask R-CNN的卷積層進行參數初始化。由于本試驗只針對玉米植株做實例分割,與文獻[31]中所用到的數據訓練樣本不同。因此,針對網絡訓練中的調優過程(fine-tuning)要在原方法的基礎上進行調整。首先,將網絡訓練的調優過程分成兩個階段,第一階段僅使用小批量的人工標注圖像來訓練,該過程主要是用于訓練模型中的區域推薦網絡RPN(Region Proposal Network)部分,提高網絡對相同場景下玉米植株位置信息的定位精度,該位置信息將用于限定計算深度掩碼標注時的區域范圍,此外第一階段的訓練結果可用通過權值共享方式給第二階段的訓練來使用。第二階段則利用深度掩碼產生的標注信息和RGB圖像進行常規訓練,直到網絡輸出的總損失值收斂于0值附近,則訓練結束。為了提高對株形偏小的玉米植株的特征提取能力,在推薦框的錨定尺度(anchor scales)上增加了16像素的標準值,具體訓練參數如表2所示。

表2 模型訓練的關鍵參數及初始值

2 基于深度掩碼的圖像分割優化

2.1 基于深度掩碼的實例分割網絡模型構建

人工標注成本是制約有監督學習發展的一個主要問題,對于植物這種結構復雜、細節較多的研究對象,其標注的效果也會因人而異,經常會出現關鍵位置不能完全與物體邊緣形態一致的問題,與目標對象的真實信息存在一些差距。此外,人工標注的圖像樣本對于描述完整的物理世界場景來說還是不夠的,而無監督學習目前主要用于解決的聚類問題上,其精度也不足以實現植物細節信息的描述。因此,需要找到一種折中的方法來減少人工標注的工作量,同時能夠較好地描述視覺場景。為此,研究人員嘗試利用多種模態數據描述場景信息,通過模態之間內容的空間一致性來實現不同模態之間的信息補充,以不同的角度來描述場景中的目標信息,提高多模態數據對物理世界的描述能力。

本研究從多模態機器學習的角度出發,針對玉米植株研究如何在可控的室內場景下利用深度圖像來代替人工標注圖像,實現無人工標注樣本的有監督深度學習。為此,本研究提出了深度掩碼卷積神經網絡(DM-CNN)模型,利用深度圖像生成深度掩碼標注,并將這個標注信息將連通彩色圖像一起輸入到Mask R-CNN網絡中進行訓練,具體如圖4所示。其中深度掩碼標注過程包括3個步驟:1)利用深度密度函數產生深度密度圖;2)結合深度密度圖提出一種最鄰域填充法,用于補全深度圖中的噪聲點,讓深度圖所表示的內容更接近彩色圖像;3)求得二值掩碼圖像的最大連通域,獲得完整植株的標注信息。

注:Conv:1,1,64表示一個卷積層,該卷積層的卷積核大小為1×1,通道數為64,以此類推;ddx,y為深度密度函數,具體內容如式(1)所示;Lb為網絡邊框損失值,Lrb為網絡中RPN(Region Proposal Network)模塊輸出的邊框損失值,Lc為網絡輸出的分類損失值,Lrc為網絡中RPN(Region Proposal Network)模塊輸出的分類損失值,Lm為網絡輸出的掩碼損失值(詳見2.4章節)。

2.2 深度密度函數

本研究使用的深度密度(Depth density)函數是在文獻[36]中第一提出,主要用于計算深度圖像中每個像素與其相鄰區域其他像素深度值的近似程度推論出該像素是處于物體邊緣還是物體表面。但是文獻[36]中并沒有考慮像素之間的距離對深度密度計算的影響,該算法會在玉米植株表面位置生成大量噪聲。因此,本研究對深度密度函數進行改進,加入了像素距離的概念,同時在計算過程中不對像素進行歸一化處理,同時利用求和函數來代替積分過程,最大程度的保證了原深度圖像中不同位置的像素實際深度分布情況。

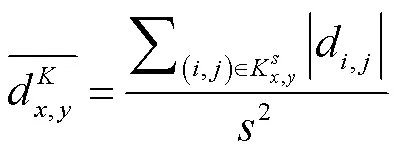

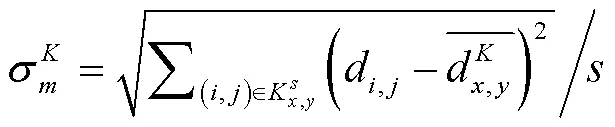

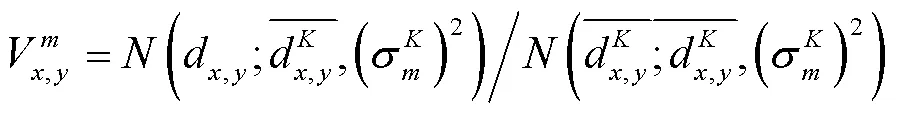

設深度圖像的尺寸為×,其中為圖像的高度(像素行數),為圖像的寬度(像素列數);d,y為圖像上(,)位置的像素的深度值,其中深度值由灰度值表示,取值范圍為[0,255]之間的整數;dd,y表示圖像上點(,)對應的深度密度值,其表達式如式(1)所示。

式(1)中的表示轉換函數,其中包含3個參數,表示圖像上以點(,)為中心,以·為大小的計算區域;Δ表示區域內的像素距離差。式(1)可以解釋為:深度密度函數是以深度圖像上(,)點為中心,在區域內,利用像素距離算子Δ的計算像素點(,)與該區域內其他像素點的深度值相似概率。

為了求解式(1),本研究首先給出幾個參數定義:

表示以(,)點為中心、區域內的各像素點深度與d, y的方差,如式(3)所示。

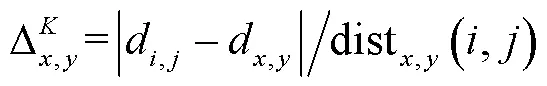

dist,y(,)表示在區域內,像素點(,)與中心點(,)之間的像素距離,如式(5)所示。

對于區域內的任意像素點,該點與中心點(,)的像素距離差如式(6)所示。

在計算深度密度值時,本研究選擇高斯分布函數作為算子,如式(7)所示。

則對于深度圖像中的點(,),其與區域中的深度均值的近似度可以如式(8)所示。

同樣,對于深度圖像中的點(,),其與區域中其他像素點之間的深度近似程度可以如式(9)所示。

根據上述公式可以得到深度密度函數,如式(10)所示。

利用公式10計算得到的深度密度dd,y的取值區間為(0,1]。其中,深度密度值越接近于0表示該點與該區域的整體深度值分布情況差異很大,則該點屬于深度圖中的邊界像素或者噪聲像素的概率較高;深度密度值越接近于1表示該點與該區域的整體深度值分布差異較小,則該像素點位于物體表面的幾率較大。這就證明了如果一個像素點的深度密度接近于1,則該點有很大概率與其周圍·范圍內的像素點屬于同一物體。基于這一原理可以對全卷積的分割結果進行優化。加入像素距離算子前后的深度密度圖像如圖5所示。

2.3 最近鄰域像素填充法及深度掩碼獲取

利用改進后的深度密度函數得到深度密度圖,可以很好地反映出任意像素點在深度圖中的深度分布情況(物體表面或物體邊緣)。但該函數對于深度圖中的初始噪聲是無法修正的,噪聲主要存在于目標對象的邊緣位置上,覆蓋了許多玉米植株的細節信息,造成深度信息缺失,這會影響深度卷積神經網絡的訓練精度。為了解決這一問題,本研究提出了一種最近鄰域像素填充方法,首先統計深度圖像中水平或垂直兩個方向的灰度分布情況,再根據噪聲區域最近鄰域的灰度分布情況動態填充噪聲產生的灰度低洼區域,將噪聲轉變成有效灰度,減少噪聲對深度圖的影響。具體算法如下:

1)對深度圖像中的灰度進行分級處理,默認分8級灰度,形成分級深度圖像;

2)遍歷分級深度圖像,找到該圖像中像素最多的像素級,將該級灰度值作為背景灰度;

3)以1像素為單位,按序遍歷分級深度圖像中的水平或垂直方向上的像素線,對于在同一條像素線任意位置相連的兩個像素,如果后面像素的值與前面像素的值相等,則后面像素歸屬于前面像素的像素集合,否則為后面的像素新建一個像素集合,最終在像素線上劃分多個不同像素值的像素點集合;

4)遍歷這些像素集合,如果當前像素集合的像素值低于相鄰兩側像素集合的像素值,且當前像素的深度密度值小于0.5(邊緣噪聲可能性較大),則相鄰兩側中像素值較低的像素填充給當前區域;如果兩側像素集合中較低像素值等于背景灰度值,則不用進行填充;

5)判斷當前圖像是否成為二值圖像,如果是則輸出圖像,如果不是則返回步驟3;

6)算法結束,輸出的二值圖像中像素值較低的為目標區域,像素值較高的為背景區域。

算法的執行效果如圖6a所示。在得到二值圖像后,使用網絡中推薦框分支輸出的位置信息來限定二值圖像中的對象所在區域,通過閾值分割即可得到背景前玉米植株的圖像信息,結果如圖6b所示。雖然玉米植株的整體信息已經顯示出來,而葉片邊緣細節部分還存在很多的噪聲。為了獲取圖像中更準確的目標邊緣點信息(即深度掩碼邊緣信息),對圖6b求最大連通域,得到的最大連通域如圖6c所示,可以看出噪聲與原閾值分割結果相比少了很多。在求得最大連通域基礎上,可以利用3×3大小的核來查找連通域上的邊界點,當核中心點值為1(白色),而其他位置有0值點(黑色)時,則該中心點為邊界點。而這樣就可獲得整個連通域邊緣的全部坐標信息,形成深度掩碼信息。

2.4 損失函數與評價指標

本研究分別利用人工標注樣本、深度掩碼標注樣本進行了網絡模型的訓練和驗證,試驗中主要記錄6種損失值的變化,分別包括:

1):網絡輸出的總損失值;

2)Lb:網絡輸出的目標框(或稱目標區域)損失值;

3)Lc:網絡輸出的分類損失值;

4)Lm:網絡輸出的掩碼損失值;

5)Lrb:網絡中RPN(Region Proposal Network)模塊輸出的目標框(或稱目標區域)損失值;

6)Lrc:網絡中RPN模塊輸出的分類損失值。

在計算損失函數過程中,由于訓練樣本中相同生長階段的玉米植株特征比較相似,而且數據集中只有選定1個輸出類型(num_class=1),因此如果學習率設置偏高時,會導致訓練中計算Lrc和Lm時出現數值溢出。但是如果單純降低學習率,又會讓模型收斂變慢。因此在訓練模型過程中對損失函數進行了調整,對Lrc和Lm進行加權處理,如式(11)所示。

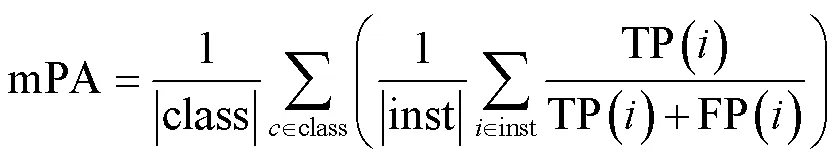

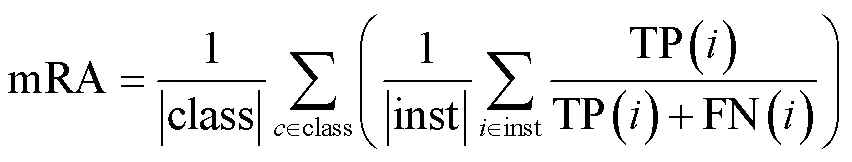

對Lrc和Lm分別乘上一個加權系數0=10、1=10,通過提高分類損失函數初始值來減緩其梯度下降的趨勢。此外,為了驗證網絡模型的圖像分割精度,本研究選取3種實例分割的評價指標,分別為平均像素精度、平均召回率和平均交并比。其中平均像素精度(mean Pixel Accuracy,mPA)如式(12)所示。

平均召回率(mean Recall Accuracy,mRA)如式(13)所示。

平均交并比(mean Intersection over Union,mIoU)如式 (14)所示。

式(12)~式(14)中,TP表示真正例,FP表示假正例,FN表示假負例,inst表示全部測試圖片集,class表示測試集中的類別數,由于本研究只針對玉米植株一種類別進行處理,因此class=1。

3 結果與分析

3.1 樣本真值獲取

為了測試深度圖像產生的深度掩碼標注信息在網絡模型上的訓練效果,同時與基于人工標注樣本訓練的模型分割結果進行對比,首先需要獲得彩色圖像中的玉米植株的真實分割區域(真值圖)。不同于以往的深度學習方法(以人工標注區域作為真值),本試驗要比較人工標注樣本與深度掩碼標注樣本在訓練模型后的實例分割精度差異,因此如果以人工標注區域作為真值,那么基于人工標注樣本訓練出的深度學習模型將會在分割精度上有更高的概率接近于真值,這樣的對比缺乏公平性。因此,在圖像采集使用了藍色背景,這有利于實現在彩色圖像中對玉米完整植株形態信息的提取任務。提取過程主要用到顏色閾值,在室內光照環境不變的情況下,通過提取并對比玉米植株位置和背景位置的顏色直方圖,分別得到玉米植株區域和藍色背景區域各自特有的紅色、綠色、藍色區間,利用顏色閾值來獲得玉米植株的連續像素區域,并以此作為真實圖。通過對比不同區域的顏色直方圖,構建顏色閾值,去掉不符合顏色區間的像素點,效果如圖7所示。從圖中可以看出,在室內場景下(藍色背景)利用顏色直方圖獲取的植株信息比較完整,可以用來作為真值圖像來驗證深度學習模型的實例分割精度。

3.2 人工標注樣本與深度掩碼標注樣本對比

為了保證兩種不同樣本訓練過程的公平性,在對DM-CNN模型進行訓練時,采用與Mask R-CNN相同的參數進行初始化(如1.4節中表2所示)。試驗首先利用室內樣本進行對比,分別利用人工標注樣本和深度掩碼標注樣本來訓練DM-CNN模型,圖8給出了這兩種樣本的各自對應的6種訓練損失和6種驗證損失分布情況。從圖8中可以看出,對于訓練過程中的、Lb、Lm和Lrb這4種損失值,兩種數據集有相同的收斂趨勢,深度掩碼標注樣本集合對應的損失值下降得更明顯一些。而對于Lc和Lrc,深度掩碼標注樣本的收斂速度更快。對于驗證損失值函數,兩種數據樣本集對應的6種損失值變化趨勢相近,特別是對于Lb和Lm,二者的損失變化分布非常接近,而DM-CNN在驗證過程中損失函數更為平穩。這說明深度掩碼標注樣本對于訓練深度卷積神經網絡能夠獲得與人工標注樣本相似的穩定性。

此外,為了驗證本方法在面對復雜環境下玉米植株圖像實例分割的有效性,試驗采用了遷移學習的思路,分別在原樣本中用室外玉米植株樣本替換一定比例(10%)的數據。為保證試驗對比的公平性,訓練數據集同樣分為2種類別:第一種是在原室內人工標注樣本的基礎上,用10%比例的室外人工標注數據替換其原有數據(即90%室內人工+10%室外人工);第二組是在原深度掩碼標注樣本的基礎上,用10%的室外人工標注數據替換其原有數據(即90%室內深度掩碼+10%室外人工)。利用這2類訓練數據訓練網絡,其過程如圖9所示,從圖中可以看出,即使在原深度掩碼訓練集中少量替換了一些具有復雜背景的玉米植株圖像(室外人工標注樣本),其對應的6種損失函數的收斂過程仍略優于人工標注樣本。這說明使用深度掩碼標注樣本訓練的網絡對于遷移學習也有很好的適應能力。

3.3 結果分析

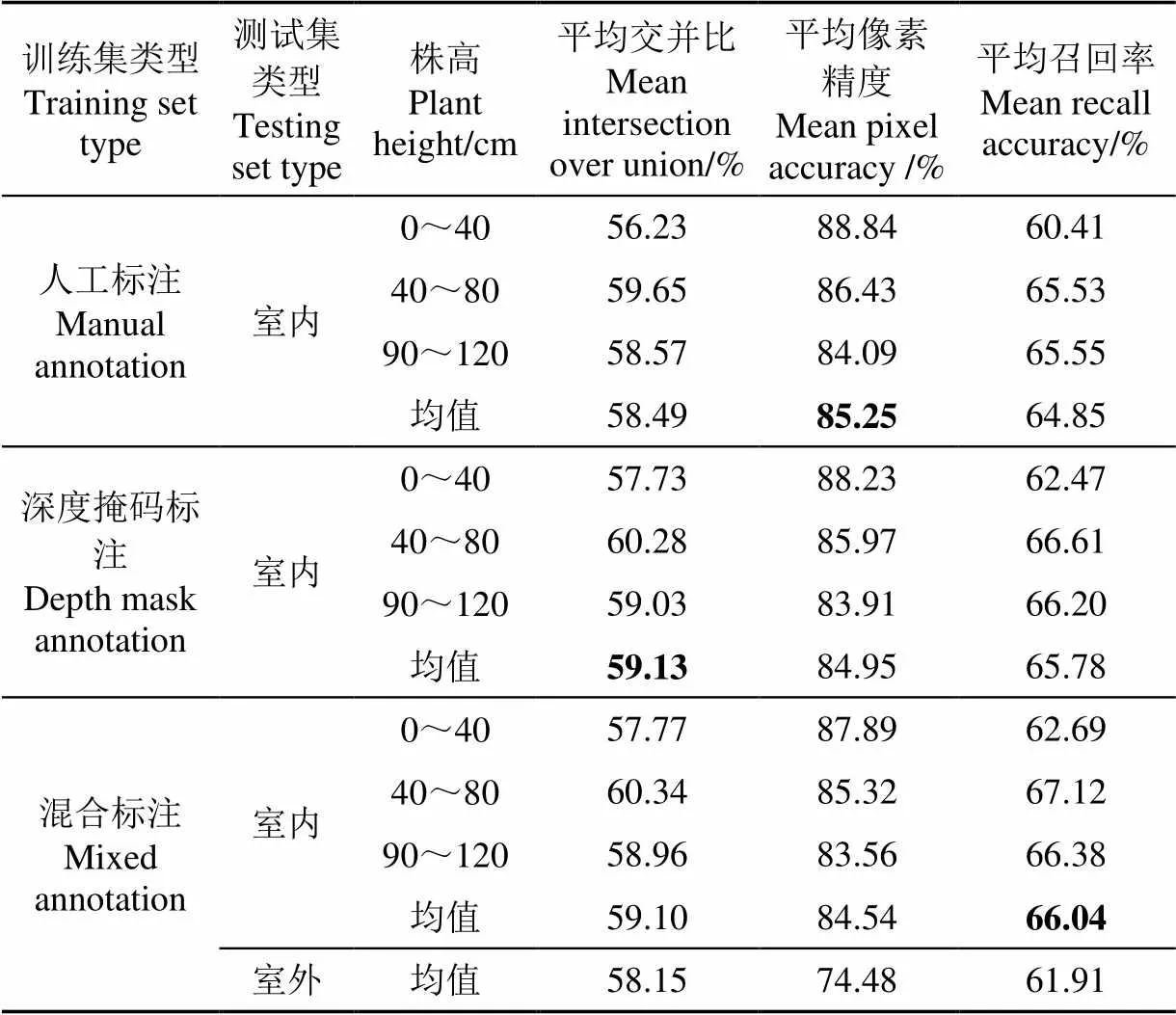

為展示DM-CNN對于玉米苗期不同株高的圖像分割效果,本試驗根據玉米株高將室內測試集(Indoor set)圖像分為3個子集,對應的株高范圍分別為0~40、40~80和80~120 cm,同時為了驗證模型對室內玉米圖像的總體分割效果,試驗中也計算了3種株高范圍對應指標的平均值(室內均值Indoor mean)。另外,室外測試集(Outdoor set)為玉米頂視圖像,沒有株高的區分,因此直接給出3種評價指標的均值,具體的試驗結果如表3所示。

對于室內(Indoor)測試集,在經過人工標注樣本的訓練后可以獲得最高的平均像素精度(mPA=85.25%),略優于深度掩碼標注樣本訓練后的平均精度(mPA=84.95%)和混合標注樣本訓練后的平均像素精度(mPA=84.54%);此外,該模型在經過深度掩碼標注樣本訓練后,可以獲得最高的均交并比(mIoU=59.13%);而且,模型在經過混合標注樣本訓練后,可以獲得最高的平均召回率(mRA=66.04%),略優于深度掩碼對應的平均召回率(mRA=65.78%)。

在對不同株高的玉米圖像分割結果進行分析,DM-CNN對于玉米株高在0~40 cm的圖像可以獲得更高平均精度,其中人工標注對應的平均像素精度達到88.84%,深度掩碼標注對應的平均精度達到88.23%,混合標注對應的平均精度達到87.89%;對于玉米株高在40~80 cm范圍的圖像可以獲得更高的平均交并比,其中混合標注對應的平均交并比為60.34%,深度掩碼對應的平均交并比為60.28%,人工標注對應的平均交并比為59.65%;對于平均召回率方面,株高在40~80 cm范圍內的圖像能夠獲得更高的平均召回率,人工標注、深度掩碼標注和混合標注對應的值分別為65.53%、66.61%和67.12%。除此之外,由于混合樣本中添加了室外人工標注樣本參與訓練,因此訓練后的模型對室外復雜背景的玉米植株圖像也具備實例分割能力。在表3中最后一行添加了室外(Outdoor)測試集,通過計算3種評價指標可以看出室外測試集的3種指標略低于室內測試集,證明DM-CNN模型通過遷移學習仍可以獲得較好的圖像分割精度。

表3 人工標注、深度掩碼標注和混合標注對應的3種評價指標的對比

由此可見,相比于經過人工標注樣本訓練后的模型,深度掩碼標注樣本訓練后的模型具有更高的均交并比和平均召回率。而在深度掩碼中替換10%的人工標注數據后,其均交并比沒有下降的特別明顯,而評價召回率提高到了66.04%,其結果要優于存人工標注樣本的訓練結果。這說明該模型在室內環境下,可以利用深度掩碼標注樣本代替人工標注樣本對Mask R-CNN進行訓練。

圖10給出利用深度掩碼標注樣本訓練后的網絡模型在圖像分割測試的結果。其中左邊6列展示了該模型利用室內場景下獲取的深度掩碼樣本(RGB圖像+深度掩碼)訓練后的實例分割結果,從圖中可以看出,DM-CNN對3種尺度范圍玉米植株都有比較好的分割效果。證明該模型可以在室內場景下,利用深度掩碼標注樣本替代人工標注樣本進行網絡模型訓練,并能夠獲得比較好的效果。此外,圖10d給出了在混合樣本訓練后,該模型對室外玉米植株頂視圖的分割效果,證明DM-CNN模型具有遷移學習的能力,即在原深度掩碼訓練樣本中替換一定比例(本研究中的比例是10%)的室外人工標注樣本(復雜背景圖像),在相同的訓練條件下,收斂后的模型也可以對室外場景下的玉米植株進行實例分割,且得到很好的分割結果,說明DM-CNN有很好的泛化能力。

為了驗證方法優越性,本試驗將DM-CNN對室外測試樣本的分割結果與經典分割方法對比,本研究分別選取了基于閾值分割的大津法(OTSU)、基于圖像隨機中心點的K-means算法、基于邊緣檢測的分水嶺分割算法和Canny算法,基于超像素的SLIC算法、基于區域增長的圖像分割算法和基于圖分割的Grabcut算法進行比較。從分割結果上看(圖11),由于基于閾值、基于邊緣檢測和基于區域增長的方法只考慮顏色、紋理、灰度變化等因素,因此分割效果差,邊緣檢測算法雖然在提取目標對象邊緣信息有一定效果,但是邊緣一般是不連續的且出現過分割現象;基于圖分割的Grabcut算法的分割結果與真值比較接近,但是Grabcut是交互式算法,需要人工去限定分割區域。所以上述這些傳統方法在相同的條件下都不如DM-CNN的分割效果,從圖中可以看出DM-CNN的分割結果可以比較清晰和完整地得到玉米苗期植株整體形態,這也表明該模型對具有復雜背景圖像的適應性更強,能夠去除背景得到精度更高的圖像分割結果。

由試驗中室內、室外玉米植株圖像分割結果可以看出,DM-CNN模型可以利用在室內環境下獲取的深度圖像,實現深度學習模型的自動標注和自動訓練,建立了一種近似“非監督學習”模式。從試驗結果來看,本研究中提出的網絡模型和理論方法在特定環境下存在一定的優勢,同時也有一定的局限性。首先,試驗主要在室內環境下獲取的玉米植株的深度圖像,其原因是Kinect設備對外界自然光照強度變化十分敏感,在室外采集到的深度圖像會附帶大量噪聲(體現在深度圖像上就是一些缺損像素點),這對于本研究中計算深度密度函數影響較大,因為在生成的深度圖像中,缺損像素有默認的像素值,而當噪聲點相對集中時,噪聲的深度密度值dd,y也會接近于1(與的圖像中平滑物體表面位置的計算結果相似),最終會對影響模型的分割精度。室內環境的光源可控,能夠有效避免外界自然光的影響,因此能夠獲得噪聲較少的深度圖像。其次,在試驗中選擇使用單一顏色的背景布來簡化試驗場景,將目標對象(玉米植株)放置在背景前進行圖像獲取,這是由于本研究提出的方法是要與經過人工標注樣本訓練后的實例分割精度進行對比,因此不能像傳統機器學習、深度學習方法一樣,使用人工標注樣本作為真值來進行精度對比,這是因為在訓練中已經使用到了人工標注圖像進行訓練,訓練出的模型會在分割圖像時更偏向于人工標注的區域,這就造成評價指標的偏差(精度、交并比的值會與于人工標注的結果更接近),因此本研究利用單一背景布來簡化圖像,利用顏色閾值分割提取玉米植株在圖像中的真實區域,并以此作為真值進行對比,保證了試驗結果對比的公平性和準確性。最后,在實際應用中,為了測試該網絡模型是否具備對室外復雜環境下的玉米植株圖像實例分割的能力,本研究選擇利用遷移學習模式來實現模型對室外玉米植株圖像實例分割。同樣以減少人工標注樣本為目標,試驗在原室內深度掩碼樣本集基礎上,替換了一定比例的室外人工標注樣本(占總樣本數10%),并以此為訓練集對DM-CNN模型進行調優。結果發現,經過調優的模型對室外玉米植株圖像也有很好的分割效果。

本研究雖然在面向玉米植株圖像實例分割的有監督學習過程中減少人工標注樣本成本,但是方法還存在一定的局限性,一是深度圖像的成像環境是室內,不能在室外獲得深度圖像,這需要在以后的研究工作中更換圖像采集設備(如激光雷達等);二是深度圖像采集時背景相對簡單,這樣采集的圖像與室外復雜環境下采集的圖像缺少共性,這需要在以后的研究工作中進行調整,針對具有復雜背景信息的圖像應該選擇更適合的方法(如全景分割等);三是本研究中給出的評價指標值并是在未改變基礎網絡結構的前提下獲得的,因為本研究中的對比需要建立在相同的網絡結構下,因此改變結構對本研究中提出的方法沒有直接影響,但對于不同的植株對象應該可以通過調整網絡結構獲得更好的特征表達,這部分任務將會在本研究的后續研究工作中實現。

4 結 論

本研究基于Mask R-CNN模型提出了面向簡單場景和復雜場景下玉米苗期植株圖像實例分割模型DM-CNN,利用Kinect設備獲取的深度圖像生成訓練模型所需的深度掩碼,并以此來替代人工標注生成的掩碼,實現DM-CNN模型的自動訓練過程。在試驗過程中主要得到以下幾個結論:

1)針對玉米苗期植株圖像人工標注時間成本高、精度低等問題,在Mask R-CNN模型的基礎上提出一種基于深度掩碼的深度卷積網絡DM-CNN,該模型可以在室內場景下,利用Kinect產生深度圖像自動生成深度掩碼標注信息,實現有監督的網絡訓練過程。

2)提出改進的深度密度函數,在計算深度圖像上每個像素點的深度密度值時加入像素間距離參數,剔除了原深度密度圖中的波紋狀無效數據,提高了小尺寸物體表面深度密度值的精度。

3)在深度密度函數的基礎上,提出了最近鄰域像素填充法,將深度密度圖像轉換成二值圖像(背景+植株),再利用第一階段訓練后的網絡產生的推薦框,將推薦框中的植株信息提取出來,并求出當前區域的最大連通域,自動生成深度掩碼標注信息。

4)通過試驗結果對比,發現利用深度掩碼標注樣本訓練的模型在平均交并比(mIoU=59.13%)和平均召回率(mRA=65.78%)都優于人工標注樣本(mIoU=58.49%,mRA=64.85%);而模型對玉米苗期的不同株高圖像分割效果都很理想,其中株高在0~40 cm的平均像素精度為88.23%,株高在40~80cm的平均像素精度為85.97%,株高在80~120 cm的平均像素精度在83.91%;此外,在原深度掩碼標注樣本的基礎上,替換10%的室外人工標注樣本進行訓練,也可以實現模型在不同場景下的遷移,在對室外復雜場景下的玉米苗期圖像(頂視圖)分割試驗中,平均交并比為58.15%,平均像素精度為74.48%,平均召回率為61.91%。

因此,DM-CNN可以在室內場景下利用Kinect設備產生的深度圖像自動生成深度掩碼標注樣本,基于深度掩碼樣本訓練后的網絡可以達到相同場景下人工標注數據的網絡訓練效果,并且在替換小比例人工標注樣本(10%)進行訓練后可以實現從室內玉米植株圖像分割到室外玉米植株圖像分割的模型遷移,訓練后的模型對室外玉米植株的也能產生高質量的分割效果,證明其模型的室外場景泛化能力也可以通過提高樣本的人工標注樣本的比例來實現。由此可見,在室內環境下,針對玉米苗期植株的株形信息提取工作,利用深度掩碼圖像來代替人工標注圖像實現深度學習模型的自動標注和訓練是具備可行性的,降低了人工標注的時間成本,為實現玉米苗期關鍵性狀的高通量、高精度、低成本表型分析提供理論方法支撐。

[1] 黃鵬,鄭淇,梁超. 圖像分割方法綜述[J]. 武漢大學學報:理學版,2020,66(6):519-531.

Huang Peng, Zheng Qi, Liang Chao. Overview of image segmentation methods[J]. Journal of Wuhan University: Natural Science Edition, 2020, 66(6): 519-531. (in Chinese with English abstract)

[2] Jayanthi M G, Shashikumar D R. Survey on agriculture image segmentation techniques[J]. Asian Journal of Applied Science and Technology, 2017, 1(8): 143-146.

[3] Jiao X, Chen Y G, Dong R. An unsupervised image segmentation method combining graph clustering and high-level feature representation[J]. Neurocomputing, 2020, 409: 83-92.

[4] 劉東升,廖通逵,孫煥英,等. 中國遙感軟件研制進展與發展方向:以像素專家PIE為例[J]. 中國圖像圖形學報,2021,26(5):1169-1178.

Liu Dongsheng, Liao Tongkui, Sun Huanying, et al. Research progress and development direction of Chinese remote sensing software: Taking PIE as an example[J]. Journal of Image and Graphics, 2021, 26(5): 1169-1178. (in Chinese with English abstract)

[5] 袁洪波,趙努東,程曼. 基于圖像處理的田間雜草識別研究進展與展望[J]. 農業機械學報,2020,51(S2):323-334.

Yuan Hongbo, Zhao Nudong, Cheng Man. Review of weed recognition based on image processing[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(S2): 323-334. (in Chinese with English abstract)

[6] David S, Alexander H, Bastian L. Superpixels: An evaluation of the state-of-the-art[J]. Computer Vision and Image Understanding, 2018, 166: 1-27.

[7] Jin X L, Pablo J Z, Schmidhalter U, et al. High-throughput estimation of crop traits: A review of ground and aerial phenotyping platforms[J]. IEEE Geoscience and Remote Sensing Magazine, 2021, 9(1): 200-231.

[8] Filipa T, Karel J, Bernadette S, et al. RosettR: Protocol and software for seedling area and growth analysis[J]. Plant Methods, 2017, 13(13): 1-10.

[9] Zhou J, Christopher A, Albor D A, et al. Leaf-GP: An open and automated software application for measuring growth phenotypes for arabidopsis and wheat[J]. Plant Methods, 2017, 13(117): 1-17.

[10] Massimo M, Mario V G, Pierdomenic P, et al. Phenotiki: An open software and hardware platform for affordable and easy image-based phenotyping of rosette-shaped plants[J]. The Plant Journal, 2017, 90(1): 204-216.

[11] 田萱,王亮,丁琪. 基于深度學習的圖像語義分割方法綜述[J]. 軟件學報,2019,30(2):440-468.

Tian Xuan, Wang Liang, Ding Qi. Review of image semantic segmentation based on deep learning[J]. Journal of Software, 2019, 30(2): 440-468. (in Chinese with English abstract)

[12] 王東方,汪軍. 基于遷移學習和殘差網絡的農作物病害分類[J],農業工程學報,2021,37(4):199-207.

Wang Dongfang, Wang Jun. Crop disease classification with transfer learning and residual networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(4): 199-207. (in Chinese with English abstract)

[13] Badrinarayanan V, Kendall A, Cipolla R. SegNet: A deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 2481-2495.

[14] Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: Semantic image segmentation with deep convolutional net, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848.

[15] Chen H, Sun K Y, Tian Z, et al. BlendMask: Top-down meets bottom-up for instance segmentaion[C]// IEEE Conference on Computer Vision and Pattern Recognition, Seattle: IEEE, 2020.

[16] Liu S, Qi Lu, Qin H F, et al. Path aggregation network for instance segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City: IEEE, 2018.

[17] Kirillov A, Girshick R, He K M. Panoptic feature pyramid networks[C]//IEEE Conference on Computer Vision and Pattern Recognition, Long Beach: IEEE, 2019.

[18] Sun H, Li C, Liu B Q, et al. AUNet: Attention-guided dense-upsampling networks for breast mass segmentation in whole mammograms[J]. Physics in Medicine and Biology, 2020, 65(5): 1-17.

[19] Sa I, Ge Z Y, Dayoub F, et al. DeepFruits: A fruit detection system using deep neural networks[J]. Sensors, 2018, 16(8): 1-23.

[20] Pound M P, Atkinson J A, Townsend A J, et al. Deep machine learning provides state-of-the-art performance in image-based plant phenotyping[J]. GigaScience, 2017, 6(10): 1-10.

[21] Dyrmann M, J?rgensen R N, Midtiby H S. RoboWeedSupport - Detection of weed locations in leaf occluded cereal crops using a fully convolutional neural network[J]. Advances in Animal Biosciences, 2017, 8(2): 842-847.

[22] Dyrman M, Karstoft H, Midtiby H S. Plant species classification using deep convolutional neural network[J]. Biosystems Engineering, 2016, 151: 72–80.

[23] Mostafa M G, Berrin Y, Erchan A. Plant identification using deep neural networks via optimization of transfer learning parameters[J]. Neurocomputing, 2017, 235: 228-235.

[24] Yalcin H. Plant phenology recognition using deep learning: Deep-Pheno[C]//International Conference on Agro-Geoinformatics, Fairfax: IEEE, 2017.

[25] 段凌鳳,熊雄,劉謙,等. 基于深度全卷積神經網絡的大田稻穗分割[J]. 農業工程學報,2018,34(12):202-209.

Duan Lingfeng, Xiong Xiong, Liu Qian, et al. Field rice panicle segmentation based on deep full convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(12): 202-209. (in Chinese with English abstract)

[26] 劉立波,程曉龍,賴軍臣. 基于改進全卷積網絡的棉田冠層圖像分割方法[J]. 農業工程學報,2018,34(12):193-201.

Liu Libo, Cheng Xiaolong, Lai Junchen. Segmentation method for cotton canopy image based on improved fully convolutional network model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(12): 193-201. (in Chinese with English abstract)

[27] 陳進,韓夢娜,練毅,等. 基于U-Net模型的含雜水稻籽粒圖像分割[J]. 農業工程學報,2020,36(10):174-180.

Chen Jin, Han Mengna, Lian Yi, et al. Segmentation of impurity rice grain images based on U-Net model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(10): 174-180. (in Chinese with English abstract)

[28] 任守綱,賈馥瑋,顧興健,等. 反卷積引導的番茄葉部病害識別及病斑分割模型[J]. 農業工程學報,2020,36(12):186-195.

Ren Shougang, Jia Fuwei, Gu Xingjian, et al. Recognition and segmentation model of tomato leaf diseases based on deconvolution-guiding[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(12): 186-195. (in Chinese with English abstract)

[29] 張善文,王振,王祖良. 多尺度融合卷積神經網絡的黃瓜病害葉片圖像分割方法[J]. 農業工程學報,2020,36(16):149-157.

Zhang Shanwen, Wang Zhen, Wang Zuliang. Method for image segmentation of cucumber disease leaves based on multi-scale fusion convolutional neural networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(16): 149-157. (in Chinese with English abstract)

[30] 項榮,張杰蘭. 基于改進PCNN的番茄植株夜間圖像分割算法[J]. 農業機械學報,2020,51(3):130-137.

Xiang Rong, Zhang Jielan. Image segmentation for tomato plants at night based on improved PCNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(3): 130-137. (in Chinese with English abstract)

[31] He K M, Gkioxari G, Dollar P, et al. Mask R-CNN[C]//IEEE International Conference on Computer Vision, Hawai: IEEE, 2017.

[32] He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition, Las Vega: IEEE, 2016.

[33] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39: 1137-1149.

[34] Hu R H, Dollár P, He K M, et al. Learning to segment every thing[C]//IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City: IEEE, 2018.

[35] Lin T Y, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context[C]//European Conference on Computer Vision, Zurich: Springer Science, 2014

[36] 鄧寒冰,周云成,許童羽,等. 基于RGB-D的肉牛圖像全卷積網絡語義分割優化[J]. 農業工程學報,2019,35(18):151-160.

Deng Hanbing, Zhou Yuncheng, Xu Tongyu, et al. Optimization of cattle’s image semantics segmentation with fully convolutional networks based on RGB-D[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 151-160. (in Chinese with English abstract)

Segmentation model for maize plant images based on depth mask

Deng Hanbing1,2, Xu Tongyu1,2※, Zhou Yuncheng1,2, Miao Teng1,2,3, Li Na1,2, Wu Qiong1,2, Zhu Chao1, Shen Dezheng1

(1.,,110866,; 2.,110866,; 3.,100097,)

Supervised deep learning has gradually been one of the most important ways to extract the features and information of plant phenotype in recent years. However, the cost and quality of manual labeling have become the bottleneck of restricting the development of technology, due mainly to the complexity of plant structure and details. In this study, a Depth Mask Convolutional Neural Network (DM-CNN) was proposed to realize automatic training and segmentation for the maize plant. Firstly, the original depth and color images of maize plants were collected in indoor scene using the sensors of Kinect. The parallax between depth and color camera was also reduced after aligning the display range of depth and color images. Secondly, the depth and color images were cropped into the same size to remain from the consistency of spatial and content. The depth density function and nearest neighbor pixel filling were also utilized to remove the background of depth images, while retaining the maize plant pixels. As such, a binary image of the maize plant was represented, where the depth mask annotations were obtained by the maximum connection area. Finally, the depth mask annotations and color images were packed and then input to train the DM-CNN, where automatic images labeling and segmentation were realized for maize plants indoors. A field experiment was also designed to verify the trained DM-CNN. It was found that the training loss of depth mask annotations converged faster than that of manual annotations. Furthermore, the performance of DM-CNN trained by depth mask annotations was slightly better than that of manual ones. For the former, the mean Intersection over Union (mIoU) was 59.13%, and mean Recall Accuracy (mRA) was 65.78%. For the latter, the mIoU was 58.49% and mRA was 65.78%. In addition, the dataset was replaced 10% depth mask samples with manual annotations taken in outdoor scene, in order to verify the generalization ability of DM-CNN. After fine-tuning, excellent performance was achieved for the segmentation with the top view images of outdoor seedling maize, particularly that the mean pixel accuracy reached 84.54%. Therefore, the DM-CNN can widely be expected to automatically generate the depth mask annotations using depth images in indoor scene, thereby realizing the supervised network training. More importantly, the model trained by depth mask annotations also performed better than that by manual annotations in mean intersection over union and mean recall accuracy. The segmentation was also suitable for the different plant height ranges during the maize seedling stage, indicating an excellent generalization ability of the model. Moreover, the improved model can be transferred and used in the complex outdoor scenes for better segmentation of maize images (top view), when only 10% of samples (depth mask annotations) were replaced during training. Therefore, it is feasible to realize automatic annotation and training of deep learning model using depth mask annotations instead of manual labeling ones. The finding can also provide low-cost solutions and technical support for high-throughput and high-precision acquisition of maize seedling phenotype.

image segmentation; models; image processing; maize; depth mask; plant phenotype; depth density function

鄧寒冰,許童羽,周云成,等. 基于深度掩碼的玉米植株圖像分割模型[J]. 農業工程學報,2021,37(18):109-120.doi:10.11975/j.issn.1002-6819.2021.18.013 http://www.tcsae.org

Deng Hanbing, Xu Tongyu, Zhou Yuncheng, et al. Segmentation model for maize plant images based on depth mask[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 109-120. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.18.013 http://www.tcsae.org

2020-11-02

2021-06-30

國家自然科學基金(31601218,61673281,31901399);中國博士后科學基金(2018M631812);遼寧省自然基金面上項目(20180551102);遼寧省教育廳科學研究經費項目(LSNQN202022)

鄧寒冰,博士,講師,研究方向為機器學習與模式識別。Email:deng anbing@syau.edu.cn

許童羽,博士,教授,研究方向為作物表型信息獲取與分析。Email:xutongyu@syau.edu.cn

10.11975/j.issn.1002-6819.2021.18.013

S823.92;TP391.41

A

1002-6819(2021)-18-0109-12