改進ResNet18網絡模型的羊肉部位分類與移動端應用

張垚鑫,朱榮光,孟令峰,馬 蓉,王世昌,白宗秀,崔曉敏

改進ResNet18網絡模型的羊肉部位分類與移動端應用

張垚鑫1,2,朱榮光1,2※,孟令峰1,馬 蓉1,王世昌1,白宗秀1,崔曉敏1

(1. 石河子大學機械電氣工程學院,石河子 832003;2. 農業農村部西北農業裝備重點實驗室,石河子 832003)

針對傳統圖像分類模型泛化性不強、準確率不高以及耗時等問題,該研究構建了一種用于識別不同部位羊肉的改進ResNet18網絡模型,并基于智能手機開發了一款可快速識別不同部位羊肉的應用軟件。首先,使用數據增強方式對采集到的羊背脊、羊前腿和羊后腿肉的原始手機圖像進行數據擴充;其次,在ResNet18網絡結構中引入附加角裕度損失函數(ArcFace)作為特征優化層參與訓練,通過優化類別的特征以增強不同部位羊肉之間的類內緊度和類間差異,同時將ResNet18網絡殘差結構中的傳統卷積用深度可分離卷積替換以減少網絡參數量,提高網絡運行速度;再次,探究了不同優化器、學習率和權重衰減系數對網絡收斂速度和準確率的影響并確定模型參數;最后,將該網絡模型移植到安卓(Android)手機以實現不同部位羊肉的移動端檢測。研究結果表明,改進ResNet18網絡模型測試集的準確率高達97.92%,相比ResNet18網絡模型提高了5.92個百分點;把改進ResNet18網絡模型部署到移動端后,每張圖片的檢測時間約為0.3 s。該研究利用改進ResNet18網絡模型結合智能手機圖像實現了不同部位羊肉的移動端快速準確分類,為促進羊肉的智能化檢測及羊肉市場按質論價提供了技術支持。

圖像處理;圖像識別;模型;羊肉;ResNet18;移動端;羊肉部位分類

0 引 言

羊肉的肉質鮮嫩,營養價值高,且其中含有豐富的維生素、鈣、磷、鐵等,深受人們喜愛[1]。不同部位羊肉的品質[2-3]以及脂肪酸、蛋白質等營養成分含量[4-5]各不相同,且不同部位羊肉的顏色、失水率、風味、嫩度和加工適宜性等也會隨儲藏時間改變[6]。隨著人們生活水平的不斷提高,對肉制品真實性的要求也越來越高,然而不同部位的羊肉經常被混淆出售,該行為破壞了市場“按質論價”的原則。因此,尋求一種快速、準確鑒別不同部位羊肉的方法對維護肉制品行業的市場秩序具有重要意義。

目前,用于肉制品檢測的技術主要有近紅外光譜、高光譜成像以及傳感器(電子鼻、電子舌)檢測等[7]。Sanz等[8]將高光譜成像技術與機器學習算法相結合,對羔羊的背長肌、腰大肌、半膜肌進行分類,準確率為96.67%。Kamruzzaman等[9]采用高光譜成像技術結合主成分分析算法對夏洛萊羊的半腱肌、背闊肌和腰大肌進行了分類,準確率高達100%。但上述方法因成本高和操作復雜等缺點難以應用推廣。隨著手機運算速度的提高,基于移動端的肉制品檢測研究逐漸增多[10-12]。趙鑫龍等[10]基于智能手機開發了一種用于牛肉大理石花紋檢測的軟件,檢測準確率為95.56%,且單張檢測時間低于0.5 s。然而,有關不同部位羊肉分類判別應用軟件的研究仍然較少,孟令峰等[11]利用反向傳播神經網絡對基于手機圖片的不同部位羊肉進行分類,并開發了相應的手機應用軟件,但其準確率為90.94%,方法精度有限。

近年來,各種卷積神經網絡模型不斷涌現,其網絡層次越來越深,結構越來越復雜,精度越來越高[13-16]。目前,深度學習已逐步應用于農畜產品新鮮度[17]、成熟度[18]、品質檢測[19-20]和摻假檢測[21-23]等相關研究。當深度學習的網絡深度達到一定界限時,在其訓練過程中會出現梯度消失的現象,導致網絡難以收斂。ResNet網絡[24]通過引入殘差結構解決該問題,現已應用于茶葉[25]、柑橘[26]等其他食品分類中,但仍存在參數過多、運算成本高等問題。因此,一些網絡為了提高運行速度,將訓練好的網絡進行壓縮或將網絡結構輕量化[27]。有研究表明,MobileNet網絡[28]中的深度可分離卷積能在不影響準確率的前提下降低計算量,提高運行速度。由于羊背脊、羊后腿、羊前腿等不同部位的羊肉顏色和紋理特征較為相似,導致不同部位羊肉類別之間的區分精度不高,且不同的貯藏時間會影響不同羊肉部位的外觀形態進而對部位的區分產生影響。因此,為增強不同部位羊肉之間差異的判別效果,提高網絡模型的分類精度,本研究借鑒人臉識別中的附加角裕度損失函數(ArcFace)[29],并將其作為不同部位羊肉分類網絡模型的特征優化層參與訓練,通過最大化分類界限區分不同部位羊肉之間的細微特征。

本研究為實現基于手機圖像的不同部位羊肉分類判別,引入附加角裕度損失函數(ArcFace)作為ResNet18網絡的特征優化層以增強不同部位羊肉特征之間的可分性,并借鑒MobileNet輕量化網絡,將ResNet18網絡殘差結構中的傳統卷積替換為深度可分離卷積以減少網絡參數量,進而比較不同優化器、學習率和權重衰減系數對網絡收斂速度和準確率的影響,然后建立基于改進ResNet18網絡的不同部位羊肉識別模型,最后將改進ResNet18網絡模型移植到Android終端。本研究提出在深度學習模型中引入Arcface以及深度可分離卷積的方法可為其他深度網絡改進提供參考。另外,本研究開發的不同部位羊肉分類手機應用軟件(APP)將深度學習方法應用于手機終端,具有很好的實用性和便攜性。

1 材料與方法

1.1 圖像采集與預處理

1.1.1 羊肉樣本圖像采集

本研究試驗樣本采購于石河子市中心農貿市場,樣本分別取自6只小尾寒羊(6~8月齡),在進行約30 h的排酸后送至石河子大學農畜產品實驗室進行樣本制備。試驗制備的羊背脊、羊前腿和羊后腿肉樣本的長、寬、高約為40 mm、30 mm、10 mm,將其真空包裝后置于4 ℃冰箱內冷藏。為避免外界自然光照對試驗產生影響,使采集環境更加穩定,整個試驗過程均在封閉環境下進行,并對光源進行補償。圖像采集前,將試驗樣本從冰箱中取出,待其恢復至室溫后使用手機(華為P10,華為技術有限公司,中國)進行圖像采集,分別于每天的10:00和22:00進行2次圖像采集,連續采集12 d。拍攝過程中,手機攝像頭位于羊肉樣本正上方12 cm的位置。試驗剔除提前腐敗的異常樣本后,得到羊背脊、羊前腿和羊后腿樣本各14 個,共計1 008張圖像,圖像格式為.jpg,圖像分辨率為2 976×3 968像素。

1.1.2 圖像數據預處理

本研究為提高網絡模型的適應性與泛化性,對獲得的羊肉圖片采用隨機旋轉、水平和垂直翻轉、調節亮度飽和度對比度、添加高斯模糊和椒鹽噪聲等方式進行數據集擴充[30]。擴充后的數據集數量為原來的9倍,共10 080張圖片,不同擴充方式下的羊肉圖片示例如圖1所示。本試驗所采用的數據集包括羊前腿、羊后腿和羊背脊3類不同部位羊肉,為保證樣本量均衡,從每類樣本中隨機選取2 000張共計6 000張不同部位羊肉的手機圖片,按照4∶1的比例劃分為訓練集(4 800張)和測試集(1 200張)。

1.2 基于改進ResNet18網絡的不同部位羊肉分類模型構建

1.2.1 ResNet18網絡

激活函數隨卷積神經網絡層數的不斷加深而逐漸增多,從而將輸入數據映射到更加離散的高維空間,造成網絡較難收斂。針對上述問題,He等[24]提出ResNet網絡,其由卷積層、池化層、歸一化層、殘差結構和全連接層等結構組成。ResNet18網絡通過引入殘差結構可解決由于網絡層數較多而出現的退化問題,以免在提取特征過程中丟失信息。然而,ResNet18網絡在進行多分類時仍存在類別邊界不清晰、網絡參數量過多和不便移植到手機端等問題。

1.2.2 附加角裕度損失函數(ArcFace)

ResNet18網絡采用Softmaxloss損失函數實現多分類時,先將神經網絡的輸出數值轉化為每個類的相對概率,然后再映射到(0,1)區間內,最終選取概率值最大的類別作為預測結果。傳統的Softmaxloss損失函數(1)如式(1)所示

1.2.3 深度可分離卷積

隨著網絡層數的增加,網絡的參數量也隨之增加,使得網絡訓練效率逐漸降低。針對此問題,本研究借鑒MobileNet網絡中的深度可分離卷積,將其代替ResNet18網絡中的傳統卷積以獲得更高效的輕量化網絡,使網絡在幾乎不影響準確率的前提下大大降低計算量,以便將改進ResNet18網絡模型部署到移動端。

1.2.4 改進ResNet18網絡模型構建

本研究提出的改進ResNet18網絡是通過對ResNet18網絡進行以下2個方面改進而獲得。一方面,對ResNet18網絡的殘差結構進行改進,將其中的傳統卷積替換為深度可分離卷積。深層卷積對輸入層的每個通道分別進行卷積操作,然后利用逐點卷積提取不同通道在相同空間位置上的特征信息。相比傳統卷積,深度可分離卷積可在不影響分類精度的前提下降低網絡參數量,提高網絡效率。另一方面,為區分不同部位羊肉特征之間的細微差異,引入附加角裕度損失函數(ArcFace)[29]作為改進ResNet18網絡的特征優化層參與訓練,在角度空間增加角度間隔以加強類內緊度和類間差異,最大化不同部位羊肉的分類界限。本研究提出的改進ResNet18網絡主要由以下7部分組成:卷積層、池化層、歸一化層、殘差結構(3個)、全連接層、Softmax分類層和特征優化層,其結構示意圖如圖2所示,其中,殘差結構由卷積核大小為3×3步長為2的卷積、卷積核大小為3×3步長為1的深度卷積和卷積核大小為1×1步長為1的逐點卷積構成。整個改進ResNet18網絡的損失函數由Softmax分類層的Softmaxloss損失函數1與特征優化層的附加角裕度損失函數(ArcFace)3兩部分之和組成,進行網絡訓練時,通過最小化損失函數以實現羊背脊、羊前腿和羊后腿之間的精準分類與識別。

1.2.5 試驗環境

羊肉部位分類模型訓練的試驗環境:硬件包括Intel? CoreTMi7-6700KCPU @ 3.40 GHz處理器,40 GB內存和NVIDIA GeForce RTX 2080 Ti 顯卡(11 GB 顯存)等,軟件包括操作系統Windows 10(64位)、編程語言Python 3.6.5、深度學習框架Pytorch1.1.0、通用計算架構CUDA 10.0和GPU加速庫CUDNN 7.4.1。手機APP開發及軟件測試的環境:硬件為內存64 GB的華為手機(P10,華為技術有限公司,中國),軟件包括Android8.0操作系統和Android Studio安卓應用軟件開發環境。

1.2.6 評價指標

本研究采用準確率(Accuracy,%)來評價所有不同部位羊肉分類模型的性能,并通過混淆矩陣分析三種部位羊肉的錯分情況。準確率為分類正確的樣本數占樣本總數的比例,其計算如式(5)所示

式中TP、FP、FN、TN分別為混淆矩陣中分類模型對不同部位羊肉的分類情況統計。其中TP為正類判定為正類的樣本個數,FP為負類判定為正類的樣本個數,FN為正類判定為負類的樣本個數,TN為負類判定為負類的樣本個數。進行分類任務時,把要預測樣本的實際類別數視為正樣本數,其他所有類別之和為負樣本數。

圖2 改進ResNet18網絡模型的結構示意圖

Fig.2 Structure diagram of improved ResNet18 network model

2 結果與分析

2.1 附加角裕度損失函數(ArcFace)對特征分布的影響分析

為探究附加角裕度損失函數(ArcFace)對不同部位羊肉特征分布的影響,本研究將ResNet18網絡和ResNet18_ArcFace網絡提取的兩個特征進行可視化,其特征分布圖如圖3所示。相比ResNet18網絡,ResNet_ArcFace網絡在增強類內緊度的同時還增加了類間差異,使得同一部位羊肉特征的相似度增強,不同部位羊肉之間特征差異性增大,進而提高了網絡模型的魯棒性。

為進一步量化不同網絡所提取的特征對羊肉部位的類內緊度和類間差異的影響,本研究從不同部位特征總的方差和中心距(中心之間的距離之和)兩個指標對其進行對比分析。ResNet18網絡和ResNet18_ArcFace網絡訓練集和測試集的方差和中心距如表1所示。其中,ResNet18_ArcFace網絡訓練集和測試集的方差分別為7.27和12.49,比ResNet18網絡分別減少了7.30和2.47。ResNet18_ArcFace網絡訓練集和測試集的中心距分別為49.53和42.57,比ResNet18網絡分別增大了24.02和15.63。結果表明,ResNet18網絡引入ArcFace可提高不同部位羊肉之間的可區分性。

表1 ResNet18網絡、ResNet18_ArcFace網絡特征分布的對比分析

2.2 深度可分離卷積對網絡模型參數量的影響分析

利用深度可分離卷積替換ResNet18網絡殘差結構中的傳統卷積后,卷積分為深度卷積和逐點卷積2個部分。因此,網絡中殘差結構的參數量由原來3.13×106降至0.36×106,整體網絡的參數量由原來的11.69×106降至7.68×106。結果表明,與ResNet18網絡相比,引入深度可分離卷積的改進ResNet18網絡可減少參數量。

2.3 模型參數對改進ResNet18網絡模型的影響分析

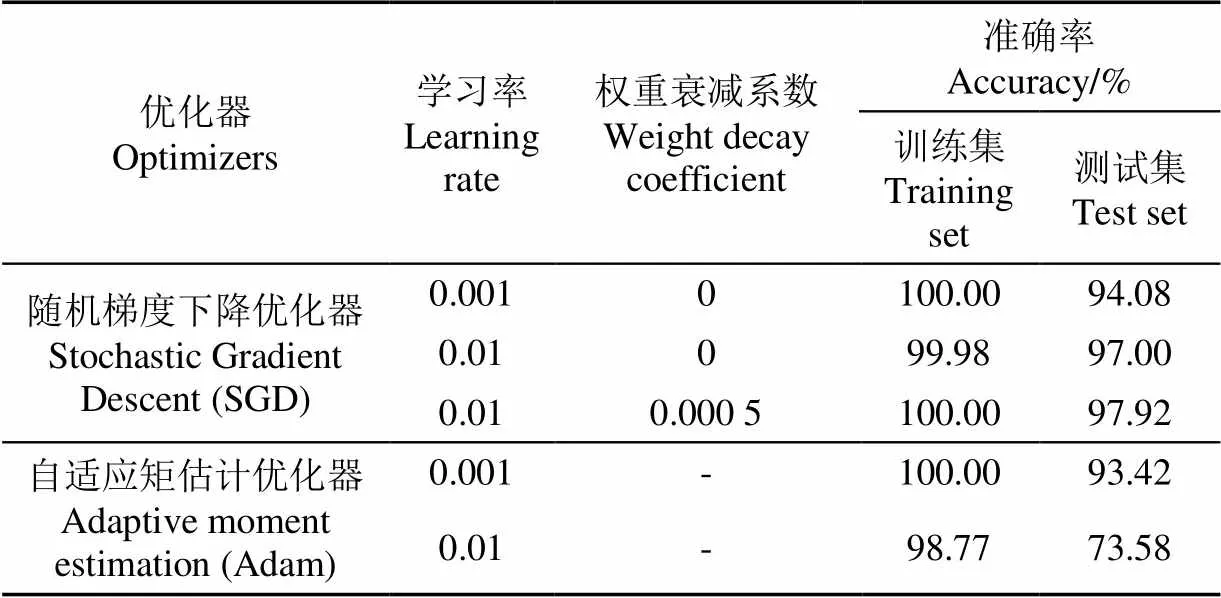

為研究訓練過程中的模型參數對改進ResNet18網絡模型的影響,本研究分別選用隨機梯度下降(Stochastic Gradient Descent,SGD)優化器和自適應矩估計優化器(Adaptive moment estimation,Adam)兩種優化器,并分別設置學習率為0.01和0.001,權重衰減系數為0和0.000 5對模型進行訓練,并對比分析不同參數對模型準確率的影響。測試集的準確率隨參數的變化趨勢如圖4所示。由圖4可知,Adam比SGD優化器收斂速度更快,但網絡模型準確率波動較大。模型參數對改進ResNet18網絡模型影響的具體情況如表2所示,當采用學習率為0.01,權重衰減系數為0.000 5的SGD優化器時,測試集的準確率為97.92%,且準確率曲線趨勢更加平穩。

表2 改進ResNet18網絡模型在不同參數下準確率的對比分析

注:Adam優化算法中加入權重衰減系數無效。

Note: It is invalid for adding weight decay coefficient in Adam optimization algorithm.

2.4 改進ResNet18網絡模型與其他網絡模型的對比分析

本研究中所有網絡模型均使用遷移學習的方式進行訓練,凍結網絡中除全連接層之外的所有網絡層,只對最后一層進行訓練。訓練模型時采用SGD優化器,學習率設置為0.01,權重衰減系數設置為0.000 5。試驗過程中的批次樣本數為32,最大輪數為100輪。

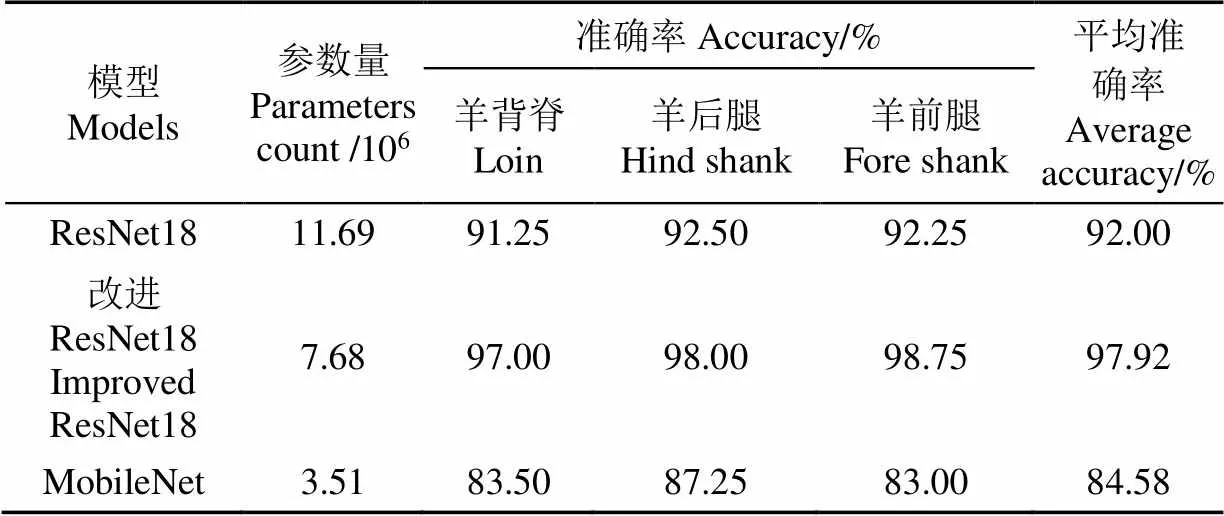

ResNet18、改進ResNet18和MobileNet網絡模型的準確率隨訓練輪數的變化如圖5所示。由圖5可知,ResNet18網絡模型經過21輪訓練準確率達到90.25%,最終穩定在92.00%;改進ResNet18網絡模型經過6輪訓練準確率達到95.25%,最終穩定在97.92%;MobileNet網絡模型經過17輪訓練準確率達到78.34%,最終穩定在84.58%。與ResNet18網絡模型和MobileNet網絡模型相比,改進ResNet18網絡模型收斂速度更快,且準確率分別提升了5.92和13.34個百分點。

ResNet18、改進ResNet18和MobileNet網絡模型對不同部位羊肉的分類結果對比情況如表3所示。由表3可知,使用改進ResNet18網絡模型對羊背脊、羊后腿和羊前腿的分類準確率分別為97.00%、98.00%和98.75%。與ResNet18網絡模型相比,改進ResNet18網絡模型對羊背脊、羊后腿和羊前腿的分類準確率分別提高了5.75、5.50和6.50個百分點;與MobileNet網絡模型相比,改進ResNet18網絡模型對羊背脊、羊后腿和羊前腿的分類準確率分別提高了13.50、10.75和15.75個百分點。結果表明,與ResNet18網絡模型和MobileNet網絡模型相比,改進ResNet18網絡模型對不同部位羊肉的分類準確率均有較大提升。

表3 ResNet18、改進ResNet18和MobileNet網絡模型分類結果對比

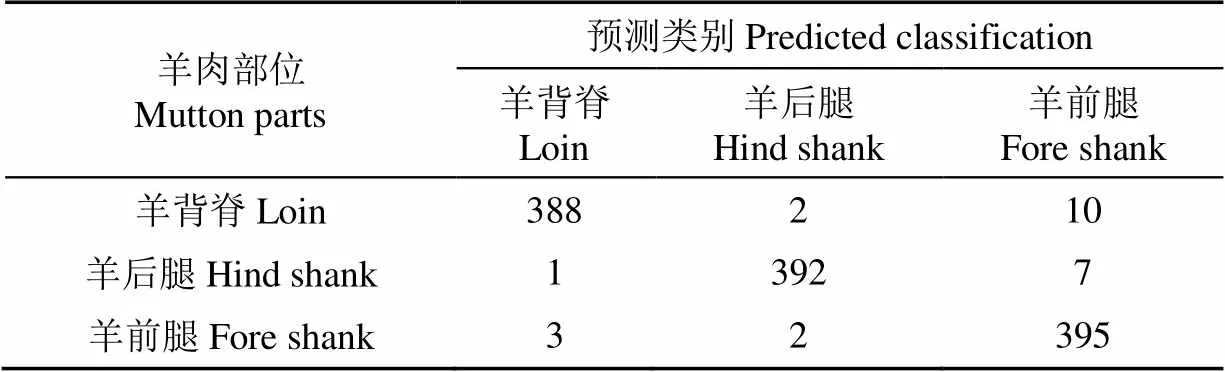

改進ResNet18網絡模型的混淆矩陣如表4所示。由表4可知,使用改進ResNet18網絡模型對1 200個不同部位羊肉數據集進行測試,僅25個不同部位的羊肉圖像分類錯誤,分類效果良好。另外,本研究通過進一步分析不同部位羊肉數據集的錯分情況可知,不同部位羊肉的顏色和紋理特征是其分類過程中的重要依據,當樣本與背景顏色區分度不大和樣本紋理不清晰(模糊或有噪聲)時,則容易發生誤分。誤分樣本大多為亮度較大、飽和度較低、添加了椒鹽噪聲和模糊的圖片,其較為復雜的背景影響了樣本的準確識別。

表4 改進ResNet18網絡模型的混淆矩陣

2.5 不同部位羊肉分類手機APP實現

為了實現不同部位羊肉精準分類在移動端的快速檢測,本研究采用Pytorch Mobile框架將訓練好的改進ResNet18網絡模型部署到Android設備中。首先,將訓練好的改進ResNet18網絡模型轉換成TorchScript模型,并保存為相應的.pt格式。然后,在Android Studio軟件環境中開發羊肉部位分類手機應用APP,APP主要包括前端界面和后端處理。前端界面主要由.xml文件進行布局,通過添加文本和按鈕組件實現羊肉圖片和檢測結果的顯示。后端處理通過編寫Java語言實現,包括圖像獲取、圖像處理和模型判別功能。在運用APP對不同部位羊肉進行識別時,首先,使用圖像獲取功能采集圖像,然后,利用圖像處理功能將獲取圖像的大小壓縮至224×224像素并存儲,最后,調用.pt格式的TorchScript模型對壓縮后的圖片進行識別。利用測試集1 200張圖片對羊肉部位分類手機APP進行測試,得出每張圖片的檢測時間約為0.3 s。

3 結 論

1)本研究在ResNet18網絡的基礎上引入附加角裕度損失函數(ArcFace),并將殘差結構中的傳統卷積替換為深度可分離卷積,構建了改進ResNet18網絡模型用于不同部位羊肉的分類。該網絡模型不僅提高了不同部位羊肉之間的可區分性,而且減少了網絡的參數量。

2)改進ResNet18網絡模型對不同部位羊肉分類的準確率高達97.92%。與ResNet18網絡模型和MobileNet網絡模型相比,改進ResNet18網絡模型的分類準確率分別提升了5.92個百分點和13.34個百分點。

3)將本研究提出的改進ResNet18模型轉化為TorchScript模型移植到移動端后,所開發的羊肉檢測應用軟件能夠實現對不同部位羊肉快速準確分類,每張圖像的檢測時間約為0.3 s。

總體而言,本研究提出的改進ResNet18網絡模型采用了大量背景較為復雜的數據進行訓練,可以實現不同部位羊肉的快速準確分類,但所開發的手機APP較為簡單。后續研究中,將會考慮羊肉品種、產地以及儲藏時間對模型的影響。另外,本研究提出的改進ResNet18網絡模型可為實現其他類別差異細微的樣本快速準確分類提供參考。

[1] 王彩霞,王松磊,賀曉光,等. 高光譜圖譜融合檢測羊肉中飽和脂肪酸含量[J]. 光譜學與光譜分析,2020,40(2):595-601.

Wang Caixia, Wang Songlei, He Xiaoguang, et al. Detection of saturated fatty acid content in mutton by using the fusion of hyperspectral spectrum and image information[J]. Spectroscopy and Spectral Analysis, 2020, 40(2): 595-601. (in Chinese with English abstract)

[2] Junkuszew A, Nazar P, Milerski M, et al. Chemical composition and fatty acid content in lamb and adult sheep meat[J]. Archives Animal Breeding, 2020, 63(2): 261-268.

[3] 李貞子,楊具田,宋巧,等. 不同性別及部位的蘭州大尾羊肉食用品質[J]. 食品工業科技,2014,35(17):354-357,361.

Li Zhenzi, Yang Jutian, Song Qiao, et al. Edible quality of Lanzhou fat-tailed sheep in different gender and anatomical regions[J]. Science and Technology of Food Industry, 2014, 35(17): 354-357, 361. (in Chinese with English abstract)

[4] 陳學敏,朱國茵,羅海玲,等. 基于指紋圖譜的歐拉羊肉揮發性風味物質定量分析[J]. 農業機械學報,2020,51(5):349-355.

Chen Xuemin, Zhu Guoyin, Luo Hailing, et al. Quantitative analysis of Oula lamb meat volatile compounds based on fingerprint[J]. Journal of Agricultural Machinery, 2020, 51(5): 349-355. (in Chinese with English abstract)

[5] 王亞娜,王曉香,王振華,等. 大足黑山羊宰后成熟過程中揮發性風味物質的變化[J]. 食品科學,2015,36(22):107-112.

Wang Yana, Wang Xiaoxiang, Wang Zhenhua, et al. Changes in volatile flavor components in Dazu black goat meat during postmortem aging[J]. Food Science, 2015, 36(22): 107-112. (in Chinese with English abstract)

[6] 劉文營,王守偉. 羊肉生產及加工工藝對肉及肉制品品質的影響研究進展[J]. 食品科學,2020,41(1):304-311.

Liu Wenying, Wang Shouwei. Recent progress in understanding the effect of mutton production and processing technologies on the quality of meat and meat products[J]. Food Science, 2020, 41(1): 304-311. (in Chinese with English abstract)

[7] Dumalisile P, Manley M, Hoffman L, et al. Discriminating muscle type of selected game species using Near Infrared (NIR) spectroscopy[J/OL]. Food Control, 2020, 110, [2019-11-01], https: //doi. org/10. 1016/j. foodcont. 2019. 106981.

[8] Sanz J A, Fernandes A M, Barrenechea E, et al. Lamb muscle discrimination using hyperspectral imaging: Comparison of various machine learning algorithms[J]. Journal of Food Engineering, 2016, 63(2): 92-100.

[9] Kamruzzaman M, Elmasry G, Sun D, et al. Application of NIR hyperspectral imaging for discrimination of lamb muscles[J]. Journal of Food Engineering, 2011, 104(3): 332-340.

[10] 趙鑫龍,彭彥昆,李永玉,等. 基于深度學習的牛肉大理石花紋等級手機評價系統[J]. 農業工程學報,2020,36(13):250-256.

Zhao Xinlong, Peng Yankun, Li Yongyu, et al. Mobile phone evaluation system for grading beef marbling based on deep learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(13): 250-256. (in Chinese with English abstract)

[11] 孟令峰,朱榮光,白宗秀,等. 基于手機圖像的不同貯藏時間下冷卻羊肉的部位判別研究[J]. 食品科學,2020,41(23):21-26.

Meng Lingfeng, Zhu Rongguang, Bai Zongxiu, et al. Discrimination of chilled lamb in different parts under different storage time based on mobile phone images[J]. Food Science, 2020, 41(23): 21-26. (in Chinese with English abstract)

[12] Adi K, Pujiyanto S, Nurhayati O D, et al. Beef quality identification using thresholding method and decision tree classification based on android smartphone[J/OL]. Journal of Food Quality, 2017, 2017, [2017-09-05], https: //doi. org/10. 1155/2017/1674718.

[13] Zhao A, Balakrishnan G, Durand F, et al. Data augmentation using learned transformations for one-shot medical image segmentation[C]// 2019 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach: IEEE, 2019.

[14] Brossard M, Bonnabel S. Learning wheel odometry and IMU Errors for localization[C]// 2019 International Conference on Robotics and Automation (ICRA), Montreal: IEEE, 2019.

[15] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2017, 60(6): 84-90.

[16] 陳娟,陳良勇,王生生,等. 基于改進殘差網絡的園林害蟲圖像識別[J]. 農業機械學報,2019,50(5):194-202.

Chen Juan, Chen Liangyong, Wang Shengsheng, et al. Pest recognition based on improved residual network[J]. Transactions of the Chinese Society for Agriculture Machinery, 2019, 50(5): 194-202. (in Chinese with English abstract)

[17] 焦俊,王文周,侯金波,等. 基于改進殘差網絡的黑毛豬肉新鮮度識別方法[J]. 農業機械學報,2019,50(8):364-371.

Jiao Jun, Wang Wenzhou, Hou Jinbo, et al. Freshness identification of Iberico pork based on improved residual network[J]. Transactions of the Chinese Society for Agriculture Machinery, 2019, 50(8): 364-371. (in Chinese with English abstract)

[18] 向陽,林潔雯,李亞軍,等. 芒果雙面成熟度在線檢測分級系統[J]. 農業工程學報,2019,35(10):259-266.

Xiang Yang, Lin Jiewen, Li Yajun, et al. Mango double-sided maturity online detection and classification system[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(10): 259-266. (in Chinese with English abstract)

[19] 趙志衡,宋歡,朱江波,等. 基于卷積神經網絡的花生籽粒完整性識別算法及應用[J]. 農業工程學報,2018,34(21):195-201.

Zhao Zhiheng, Song Huan, Zhu Jiangbo, et al. Identification algorithm and application of peanut kernel integrity based on convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(21): 195-201. (in Chinese with English abstract)

[20] 張思雨,張秋菊,李可. 采用機器視覺與自適應卷積神經網絡檢測花生仁品質[J]. 農業工程學報,2020,36(4):269-277.

Zhang Siyu, Zhang Qiuju, Li Ke. Detection of peanut kernel quality based on machine vision and adaptive convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(4): 269-277. (in Chinese with English abstract)

[21] Han F K, Huang X Y, Aheto J H, et al. Detection of beef adulterated with pork using a low-cost electronic nose based on colorimetric sensors[J/OL]. Foods, 2020, 9(2), [2020-02-10], https: //www. researchgate. net/publication/339311410_Detection_of_Beef_Adulterated_with_Pork_Using_a_Low-CostElectronic_Nose_Based_on_Colorimetric_Sensors.

[22] Zhou L, Zhang C, Liu F, et al. Application of deep learning in food: A review[J]. Comprehensive Reviews in Food Science and Food Safety, 2019, 18(6): 1793-1811.

[23] Yang J, Xu J F, Wu X L, et al. Deep learning for vibrational spectral analysis: Recent progress and a practical guide[J]. Analytica Chimica Acta, 2019, 1081: 6-17.

[24] He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CPVR), Las Vegas: IEEE, 2016.

[25] 林麗惠,羅志明,王軍政,等. 融合整體與局部信息的武夷巖茶葉片分類方法[J]. 智能系統學報,2020,15(5):919-924.

Lin Lihui, Luo Zhiming, Wang Junzheng, et al. Classification of Wuyi rock tealeaves by integrating global and local information[J]. CAAI Transactions on Intelligent Systems, 2020, 15(5): 919-924. (in Chinese with English abstract)

[26] 李善軍,胡定一,高淑敏,等. 基于改進SSD的柑橘實時分類檢測[J]. 農業工程學報,2019,35(24):307-313.

Li Shanjun, Hu Dingyi, Gao Shumin, et al. Real-time classification and detection of citrus based on improved single short multibox detecter[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(24): 307-313. (in Chinese with English abstract)

[27] Cheng Y, Wang D, Zhou P, et al. A survey of model compression and acceleration for deep neural networks[J/OL]. Signal Processing, [2020-04-14], https: //arxiv. org/abs/1710. 09282.

[28] Howard A G, Zhu M L, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications[J/OL]. Computer Vision and Pattern Recognition, [2017-04-17], https: //arxiv. org/abs/1704. 04861.

[29] Deng J K, Guo J, Xue N N, et al. ArcFace: Additive angular margin loss for deep face recognition[C]// 2019 IEEE Conference on Computer Vision and Pattern Recognition (CPVR), Long Beach: IEEE, 2019.

[30] 趙立新,侯發東,呂正超,等. 基于遷移學習的棉花葉部病蟲害圖像識別[J]. 農業工程學報,2020,36(7):184-191.

Zhao Lixin, Hou Fadong, Lyu Zhengchao, et al. Image recognition of cotton leaf diseases and pests based on transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(7): 184-191. (in Chinese with English abstract)

Classification of mutton location on the animal using improved ResNet18 network model and mobile application

Zhang Yaoxin1,2, Zhu Rongguang1,2※, Meng Lingfeng1, Ma Rong1, Wang Shichang1, Bai Zongxiu1, Cui Xiaomin1

(1.,,832003,;2,,832003,)

Accurate and timely detection of meat parts has gradually been highly demanding in meat consumption. However, the traditional image classification cannot clearly distinguish the similar color and texture characteristics for different mutton parts under different storage time, particularly with the low generalization and time-consuming. In this study, an improved ResNet18 network model was proposed to classify the different mutton parts, while, the corresponding mobile application software was developed using the optimal model. Firstly, 1 008 mutton images of loin, hind shank, and fore shank under different storage times (0-12 d) were collected, and then 9 types of data-augmentation were used to expand the dataset. After that, 6 000 images were randomly selected from the augmented dataset for modeling, where 80% of the images were used as the training dataset, and the remainder was used as the test dataset. Secondly, Additive Angular Margin Loss (ArcFace) and the depthwise separable convolution were introduced into the ResNet18 network for the improved one. Thirdly, the improved ResNet18 network wastrained with the augmented images of different mutton parts. Meanwhile, an evaluation was made to determine the effect of different parameters on the convergence speed and accuracy of improved ResNet18. Optimizers of stochastic gradient descent (SGD) and adaptive moment estimation (Adam), the learning rate of 0.01 and 0.001, weight decay coefficient of 0 and 0.000 5 were adopted for experimental comparison. The optimal classification model was then determined for different mutton parts. Finally, a mobile application software was developed to transplant the TorchScript model that transformed from the improved ResNet18. The results showed that the ArcFace greatly improved the distinguishability of different mutton parts, while the depthwise separable convolution significantly reduced the parameters of the network. Furthermore, the improved ResNet18 network using SGD optimizer presented a higher accuracy and more stable performance than that using the Adam in the test phase. When the learning rate was set to 0.01, the weight decay coefficient was set to 0.000 5, and the SGD optimizer was used to train the improved ResNet18 network, only 25 images of different parts of lamb were classified incorrectly in the 1 200 test sets, where the classification accuracy of the model was 97.92%, while the average classification accuracies of the loin, hind shank, and fore shank were 97.00%, 98.00%, and 98.75%, respectively. Compared with the original, the classification accuracy of the improved ResNet18 was improved by 5.92 percentage points, while the classification accuracies of loin, hind shank, and fore shank were improved by 5.75, 5.50, and 6.50 percentage points, respectively. Compared with the MobileNet model, the classification accuracy of improved ResNet18 was improved by 13.34 percentage points, while the classification accuracies of loin, hind shank, and fore shank were improved by 13.50, 10.75, and 15.75 percentage points, respectively. Moreover, the software using the improved ResNet18 quickly and accurately classified different mutton parts, where the average detection time of each image was about 0.3 s. The finding can provide the technical and theoretical support to improve the level of intelligent detection of meat products for the fair competition of the meat market.

image processing; image recognition; models; mutton; ResNet18; mobile terminal; classification of mutton parts

張垚鑫,朱榮光,孟令峰,等. 改進ResNet18網絡模型的羊肉部位分類與移動端應用[J]. 農業工程學報,2021,37(18):331-338.doi:10.11975/j.issn.1002-6819.2021.18.038 http://www.tcsae.org

Zhang Yaoxin, Zhu Rongguang, Meng Lingfeng, et al. Classification of mutton location on the animal using improved ResNet18 network model and mobile application[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 331-338. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.18.038 http://www.tcsae.org

2020-10-03

2021-07-22

國家自然科學基金地區科學基金項目(31860465);兵團中青年科技創新領軍人才計劃項目(2020CB016);石河子大學青年創新人才培育計劃項目(CXRC201707)

張垚鑫,博士生,研究方向為圖像處理,機器學習。Email:yxzl_ysh@163.com

朱榮光,博士,教授,博士生導師,研究方向為農畜產品無損檢測與裝備研發。Email:rgzh_jd@163.com

10.11975/j.issn.1002-6819.2021.18.038

TS251.7

A

1002-6819(2021)-18-0331-08