基于超復數小波和圖像空域的卷積網絡融合注視點預測算法

李 策, 朱子重, 許大有, 高偉哲, 靳山崗

(蘭州理工大學 電氣工程與信息工程學院, 甘肅 蘭州 730050)

一個場景中哪些部分或者哪些特有的形式吸引人類的眼球,是視覺心理學研究的主要內容之一.同時設計注視點預測的計算模型,亦是計算機視覺中一個長期研究的課題[1].常見的注視點預測算法通常將注視點預測問題構建成一個視覺注意力或顯著性的估計問題,通過提取圖像特征,得到圖像中的顯著性區域,從而實現圖像的注視點預測.Itti等[2]通過高斯金字塔模型生成多尺度圖像,對原圖像濾波提取顏色、亮度、方向特征,利用中心位置與周邊區域之差獲得三種特征,模擬人類視覺注意力機制,得到圖像的注視點圖.受此啟發,許多學者利用不同的特征或不同的顯著圖計算方法,得到圖像中人眼注視的顯著區域.Hou等[3]提出了一種分析每幅圖像的對數光譜并獲取光譜殘差的方法,該方法可以獲得預注意視覺搜索行為的估計.Torralba等[4]基于圖像全局上下文信息,提高觀察者在真實場景中眼睛運動的預測性能.此外,將圖像變換到頻域中,Guo等[5-7]研究了圖像頻域的幅度譜和相位譜與人眼注視之間的關系,并取得了一定的成果,推動了注視點預測模型的發展.

然而,傳統算法通過在空域或者頻域中提取與注視點相關的低級特征信息,進行注視點預測,其結果與人眼真實注視位置差距較大.隨著自然場景下眼動追蹤大規模數據的采集,為了提高注視點預測準確度,基于數據驅動的機器學習技術和卷積神經網絡變得更加實用.

Judd等[8]采用基于機器學習的方法,通過學習多種圖像特征來訓練視覺注意模型,從一組低級、中級、高級視覺特征中預測注視密度圖,該方法認為圖像中物體屬性有助于注視點的預測.隨著卷積神經網絡在計算機視覺任務中表現出較好的性能,研究者提出了基于卷積神經網絡的注視點預測模型.Vig等[9]提出深度網絡集成eDN (ensemble of deep networks)模型,這是利用卷積神經網絡預測圖像顯著性的第一次嘗試.Kümmerer等[10]為了探討低級特征和高級特征對注視點預測的貢獻,提出了Deep Gaze II模型,取得了較好的效果.Cornia等[11]提出了多級融合的卷積神經網絡ML-Net(multi-level network)模型,融合了卷積神經網絡中不同層中提取的特征,由三個模塊組成:一個特征提取卷積神經網絡、一個特征編碼網絡和一個先驗學習網絡.Pan等[12]利用生成對抗網絡SalGAN (saliency prediction with generative adversarial networks)模型獲得注視點預測圖,它由生成器和鑒別器兩個模塊組成,生成器可以更好地生成注視點圖,判別器可以更好地分辨真實注視點圖與生成注視點圖.Cornia等[13]提出顯著視注意模型SAM(saliency attentive model),將編碼器產生的特征圖送入到卷積長短期記憶網絡,細化注視點預測圖,最后通過添加中心先驗獲得最終的注視點預測圖.Liu等[19]提出了空間上下文長期遞歸卷積網絡DSCLRCN(spatial contextual long-term recurrent convolutional network)模型,首先利用卷積神經網絡學習圖像的局部顯著性,然后對圖像進行水平和垂直掃描,生成一個空間長短期模型來捕捉全局語義信息;DSCLRCN模型利用上述兩個操作可以有效地結合局部和全局上下文信息來預測圖像的注視點.

上述基于卷積神經網絡的算法中,卷積提取特征過程往往是在空域中進行的,容易丟失圖像的細節信息;同時常用的卷積核操作僅可獲得單一尺度的特征圖,導致獲得的注視點預測精度不高;此外,對于比較復雜的場景圖像,現有算法依然存在注視點預測不準確以及預測有誤的現象.

為此,本文提出了一種基于超復數小波和圖像空域的卷積網絡融合注視點預測算法.從超復數小波變換[14]的頻域中提取圖像的細節信息,并且結合圖像空域特征信息,作為注視點預測的輸入信息來源;同時在卷積網絡中,利用不同步長的空洞卷積,獲得圖像頻域和空域特征圖下多尺度的注視點預測信息,有效解決了由于特征圖尺度單一導致的注視點預測偏低問題;進而引入通道和空間的注意力機制,有效抑制了特征圖中背景信息的干擾,提高了注視點預測精度.

1 基于超復數小波和圖像空域的卷積網絡融合注視點預測算法

針對已有注視點預測模型存在特征細節缺失、尺度單一和背景信息干擾導致的注視點預測精度偏低等問題,本文提出了一種基于超復數小波和圖像空域的卷積網絡融合注視點預測算法.首先,利用卷積神經網絡提取圖像經過超復數小波變換的頻域注視點預測信息,與卷積神經網絡獲取的圖像空域注視點預測信息結合,得到圖像的注視點預測特征信息;然后,將獲得的圖像頻域和空域特征圖作為空洞空間金字塔池化模塊[15]ASPP(atrous spatial pyramid pooling)的輸入,得到不同感受野的注視點預測信息,能夠解決卷積操作獲得特征圖的尺度單一問題;最后,引入殘差卷積注意力模塊[16]Res_CBAM(residual convolutional block attention module),有效抑制了特征圖中背景信息的干擾,從而實現了圖像注視較好的預測.在公開的數據集SALICON[17]和CAT2000[18]上,分別從主觀和客觀對比實驗中驗證了所提算法的可行性.

本文所提算法框架如圖1所示,分為4個模塊:

圖1 本文所提模型結構圖Fig.1 The architecture of the proposed model

1) 圖像頻域信息獲取模塊,利用超復數小波變換[14]獲取圖像的細節信息;

2) 特征提取模塊,使用雙分支網絡(FDFN和SDFN)分別從頻域和圖像的空域中提取與注視點相關的特征信息;

3) ASPP模塊,獲取不同感受野的特征信息,提高注視點預測準確度;

4) Res_CBAM模塊,結合空間和通道的注意力機制,獲取輸出特征圖中與注視點預測相關的特征信息,利用網絡模型推理注視點位置,獲得較為準確的注視點預測圖.

1.1 圖像頻域信息獲取模塊

超復數小波變換具有良好的平移不變性和方向選擇性,同時能夠有效提取圖像的細節信息,因此本文利用超復數小波變換獲得圖像的頻域信息,將其作為注視點預測的細節信息輸入到卷積網絡中,解決由于卷積網絡提取空域特征時圖像部分細節信息容易丟失的問題,提高注視點預測精度.圖像經過超復數小波變換后,可以產生4幅近似圖和12幅子帶圖.本文中所使用的超復數小波變換是指雙樹四元數二維離散小波變換,二維的四元數解析信號被定義為

其中:f(x,y)表示一個實數范圍內的二維信號;fHi1(x,y)和fHi2(x,y)分別表示信號f(x,y)沿著x軸和y軸方向的希爾伯特變換;fHi3(x,y)表示f(x,y)在兩個方向上的希爾伯特變換;σ(x)表示在x軸方向的脈沖函數;σ(y)表示在y軸方向上的脈沖函數.

圖像經過超復數小波變換后,獲得的頻域圖可以表示為

(5)

其中:φ(·)和ψ(·)分別表示對應方向上的尺度函數和小波基函數;每一個超復數的實部表示近似部分,i、j、k三個方向上的虛部分別表示水平細節、垂直細節和對角細節;LL代表低頻子帶;LH、HL和HH代表三個高頻子帶.

本文中,用超復數小波變換將圖像由RGB空間轉換到頻域空間,而利用超復數小波變換的目的是獲取注視點預測細節信息,因此所提算法僅使用超復數小波變換的子帶圖,即令實部為零,通過頻域特征提取網絡(frequency domain feature network,FDFN)提取與注視點相關的細節信息.

1.2 特征提取模塊

由于卷積提取注視點特征信息過程中,圖像的細節信息不可避免地會有一些丟失;而超復數小波變換產生的子帶圖補充了注視點預測的細節信息,同時圖像空域中的顏色、紋理、亮度等信息也是與注視點預測高度相關的特征信息.因此,本文提出了一種雙分支卷積網絡,利用FDFN和SDFN(spatial domain feature network,融合空域特征提取網絡)同時學習圖像頻域和空域中與注視點相關的有效信息,提高注視點預測精度.本文使用經過修改的VGG16卷積網絡提取注視點預測特征,為了保證特征圖中注視點信息的完整性,在后兩個池化層(Pool4,Pool5)中去掉了下采樣過程,從而使特征圖的尺寸不再降低.對于FDFN模塊,圖像的頻域信息來源于超復數小波變換第一、二、三級分解的子帶圖(HWT1,HWT2,HWT3).在超復數小波變換的子帶圖中,一方面通過卷積方式獲取與注視點預測相關的細節信息;另一方面,由于池化操作會改變特征圖的尺寸,為了保證特征圖尺寸大小的一致性,對于超復數小波變換二級分解的子帶圖(HWT2),去掉Conv1模塊中提取特征圖的池化操作.這樣,在Conv2模塊中,由超復數小波變換一級分解子帶產生的特征圖與二級分解子帶產生的特征圖尺寸一致,通過融合二者,可以有效增加超復數小波變換不同級分解之間的信息互補,獲取豐富的注視點預測細節信息,從而更加有效地進行注視點預測.同樣的,對于超復數小波變換三級分解的子帶圖(HWT3),去掉Conv1和Conv2模塊中的池化操作.具體過程如圖2所示.其中,使用VGG16去掉后兩個池化層(Pool4,Pool5)下采樣后對HWT1進行特征提取,而對于HWT2和HWT3在使用上述網絡提取特征時,又去掉部分池化層(如紅色虛線框所示).對于SDFN模塊,其輸入圖像(Img)空域的特征提取過程與HWT1一致.

圖2 VGG16提取超復數小波變換多級分解特征示意圖

由FDFN和SDFN模塊得到的頻域和空域的注視點預測特征圖,本文中通過卷積的方式將二者進行融合(如圖1中頻/空域特征融合模塊),得到融合了頻域和空域信息的注視點預測特征圖.

1.3 ASPP模塊

在注視點預測模型中,注視點的產生不僅要考慮圖像的局部信息,還要考慮圖像的全局信息,因此本文利用不同步長的空洞卷積,獲取特征圖不同感受野信息,從而更好地得到注視點預測位置.ASPP[15]在輸入特征圖上利用不同感受野的空洞卷積操作,多次提取輸入特征圖的信息,在獲得特征圖更多感受野信息的同時,將獲取到的不同感受野特征圖池化,減少網絡模型參數量.為了獲取圖像頻域和空域中不同尺寸感受野的注視點預測信息,本文將雙分支網絡獲得的圖像空域特征和超復數小波變換頻域特征融合后作為ASPP模塊的輸入,所提算法中使用采樣率為rates={4,8,12}、卷積核為3×3的空洞卷積從輸入特征圖提取不同感受野的特征圖信息,如圖3所示.此外,對輸入特征圖進行正常的卷積提取特征和特征圖的平均計算,與原文的ASPP模塊相比,本文通過ASPP模塊獲取圖像頻域和空域的不同尺寸感受野中注視點預測相關的信息,從而獲得更好的注視點預測準確性.

圖3 ASPP模塊示意圖

1.4 Res_CBAM模塊

卷積操作能夠提取圖像中的顯著特征,對于注視點預測模型,由于提取的注視點特征圖中,有一部分表征的是背景干擾信息,容易導致模型預測的注視點位置分散,降低注視點預測的精度.由于Res_CBAM模塊[16]在圖像分類和目標檢測中能夠抑制圖像背景信息,取得提高目標分類精度和目標檢測準確度的效果,因此本文將Res_CBAM模塊引入到注視點預測任務中,選擇性地整合多層次的上下文語義信息,可以減少背景的干擾,增加注視點預測相關信息的權重,從而使注視點預測模型取得更好的性能.

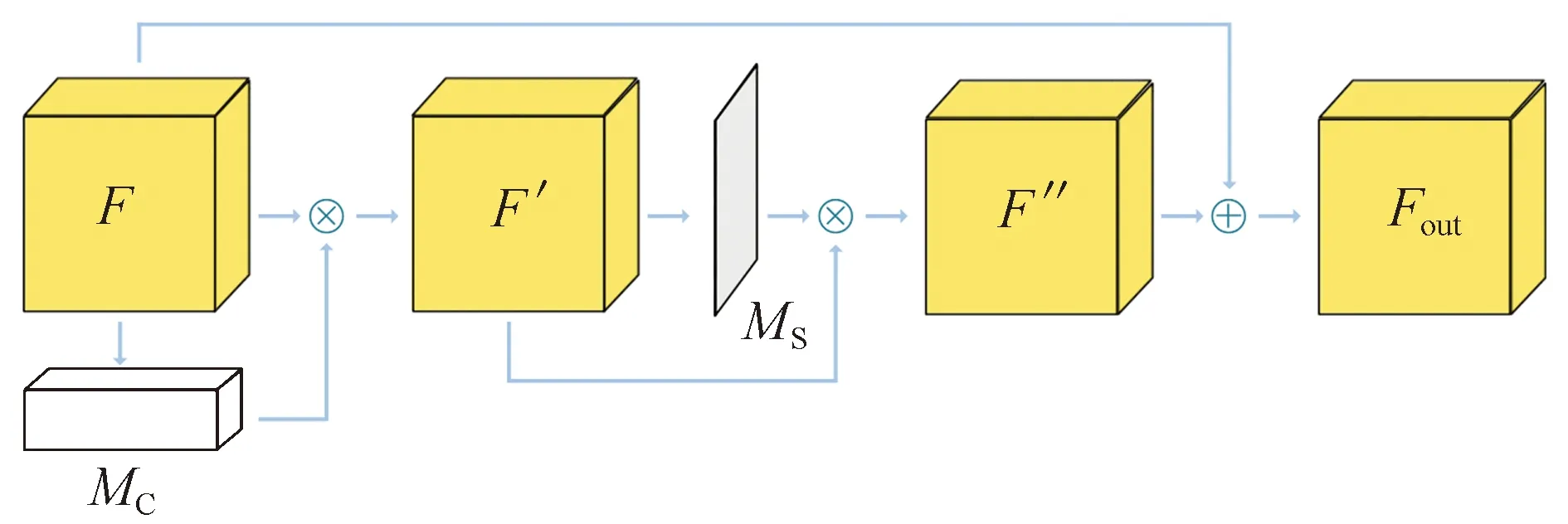

如圖4所示,當給定特征圖F∈RW×H×C作為輸入(C表示特征圖的通道,W×H表示特征圖的尺寸),MC∈R1×1×C表示通道注意圖,MS∈RW×H×1表示空間位置注意圖,則Res_CBAM模塊可以表示為

圖4 Res_CBAM模塊Fig.4 Res_CBAM module

(6)

其中:?表示對應位置元素相乘;F′表示通道注意輸出特征圖;F″表示空間位置注意輸出特征圖;Fout是殘差卷積注意模塊的輸出.

通道注意圖MC和空間位置注意圖MS可由下面的公式計算獲得:

在本文中,使用Res_CBAM模塊作為注意力機制,對卷積提取頻域信息過程中最后四個池化層的輸出進行約束增強處理.將Res_CBAM模塊的輸出與解碼過程融合,提高網絡推理過程中注視點預測的準確性.最終,解碼后可以獲得與圖像尺寸大小一致的注視點預測圖.

1.5 損失函數

(9)

其中:i表示圖像第i個像素;ε是一個正則化常數.利用KL-Div衡量注視點預測結果與標注的顯著性密度圖之間的分布差異,L1值越小說明差異性越小,即注視點預測結果越好.為了更好地擬合KL-Div,提高算法精度,通過Adam優化算法逐步最小化損失函數,獲得較好的網絡模型參數.

2 實驗分析

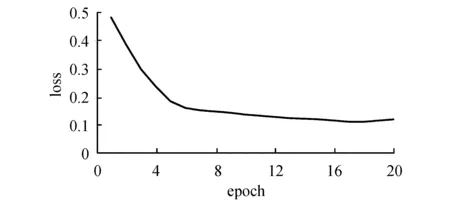

為了對模型性能進行全面的評估,在所提模型的訓練和測試過程中,使用SALICON[17]和CAT2000[18]兩個公開的注視點預測數據集完成本次實驗.本文使用實驗平臺的CPU型號是Intel Core i7 9700K 8GB,GPU型號是GTX 2080 8GB顯存,操作系統是Ubuntu16.04.算法是基于Tensorflow 1.14.0版本實現.程序中,卷積網絡的權重初始化為在ImageNet上訓練的VGG16模型的權重.網絡中,將學習率設置為10-5,batch_size設置為1,訓練20個批次.在20個批次訓練中,將在驗證集上損失函數最小的一次作為最優模型.圖5是20個批次在驗證集上的損失函數曲線,可以看出隨著訓練批次的增加,損失函數逐漸降低,13次以后損失函數的變化不是很大,在第18個批次時最小,因此本文采用第18個批次的訓練參數作為本文所提算法中最終的模型參數.并且應用線性相關系數CC(Pearson’s correlation coefficient)、Shuffled ROC曲線下的面積sAUC(shuffled area under curve)、相似度度量SIM(similarity)和標準化掃描路徑顯著性NSS(normalized scanpath saliency)等評價指標對所提模型進行全面的評價[19].

圖5 在驗證集上的損失函數曲線Fig.5 Loss function curve on the validation sets

CC是衡量注視點預測圖與密度分布GT圖之間線性關系的隨機變量,如下式所示:

(10)

SIM以直方圖的形式度量兩個分布之間的相似度,如下式所示:

(11)

NSS指標是專門為評價注視點預測模型而定義的,其思想是量化眼睛注視點處的顯著性映射值,并將其與顯著性映射方差進行歸一化,如下式所示:

(12)

Shuffled ROC曲線下的面積sAUC是AUC的一種變體,它使用其他圖像的人類注視圖作為非注視點分布.AUC指標定義為ROC曲線下的面積.

本節首先從主觀和客觀上與其他模型比較分析.此外,本次試驗中,針對模型的每一個模塊進行了控制變量實驗,在SALICON數據集上利用評價指標定量分析預測效果.

2.1 在SALICON數據集上主客觀實驗對比

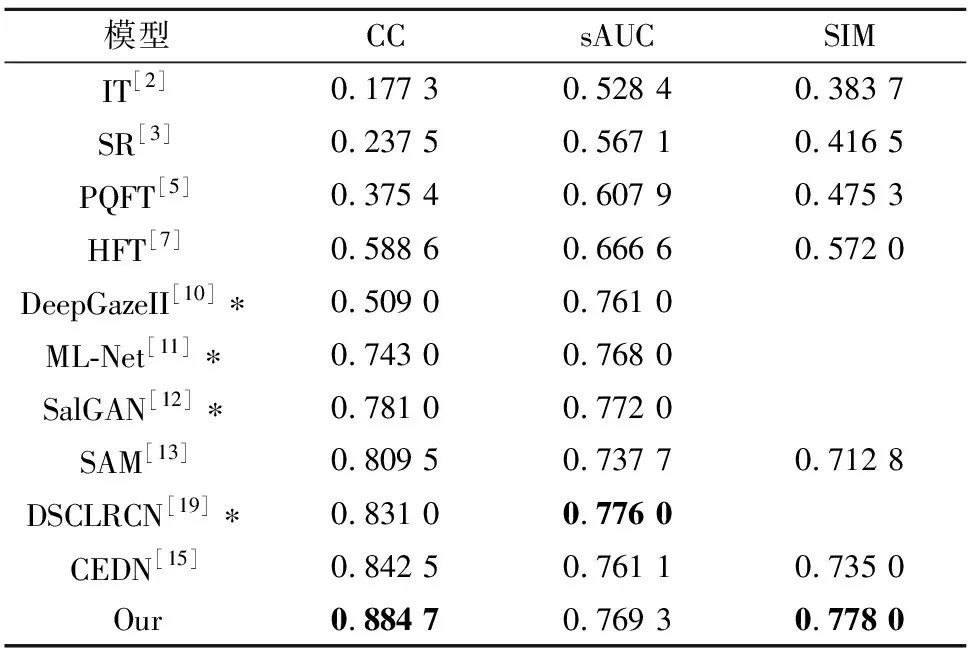

在SALICON數據集[17]上,表1與現有的注視點預測算法進行了客觀結果對比,其中*表示引用論文中的實驗結果.可以看出,本文所提算法在CC、sAUC和SIM三個評價指標上均能取得較好的注視點預測結果.在評價指標CC和SIM上,本文所提算法與CEDN[15]算法相比,分別提高了5%和9%;而在sAUC評價指標上,本文所提算法雖然沒有完全達到DSCLRCN[19]的性能,但其值僅降低了0.86%,相差較小.

表1 SALICON數據集上客觀對比結果Tab.1 Objective results on the SALICON dataset

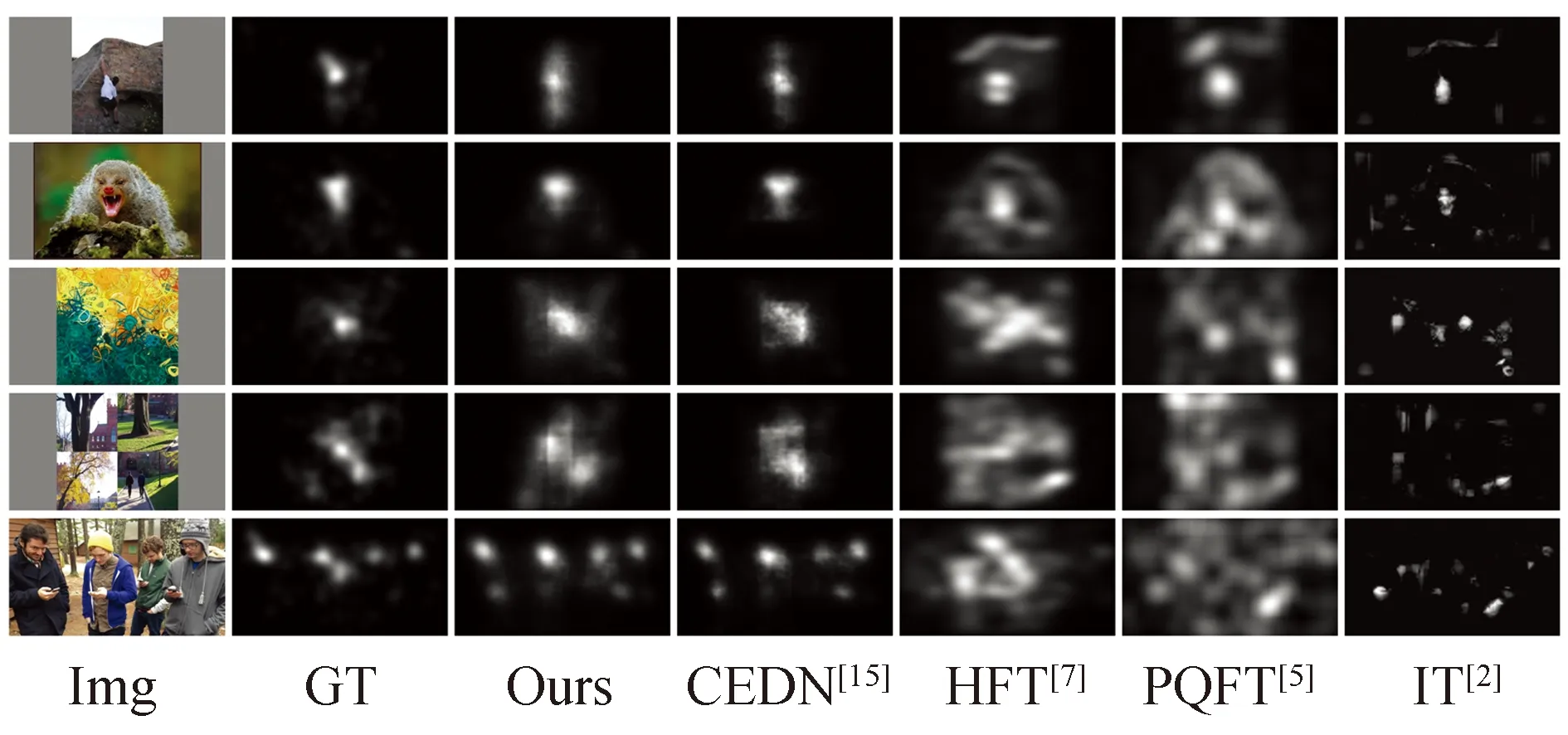

從主觀結果上看(如圖6所示),可以觀察到,基于卷積神經網絡(本文所提算法、CEDN[15]、SAM[13])的算法效果遠遠優于傳統算法(HFT[7]、IT[2]).對于較簡單的圖像場景(圖6前兩行),本文所提算法的注視點預測位置相對比較精確.對于復雜的圖像場景(圖6后三行),本文所提算法依然能找到符合人眼注視的位置,CEDN[15]、HFT[7]、IT[2]算法在第四幅圖像上的注視點位置預測有誤.

圖6 SALICON數據集下主觀結果對比Fig.6 Subjective results on the SALICON dataset

2.2 在CAT 2000數據集上主客觀實驗對比

為了驗證模型的泛化性能,在CAT2000[18]數據集上進行訓練和測試.CAT2000數據集的圖像尺寸較大,因此相應地增加了注視點預測難度.實驗的客觀結果見表2,其中*表示引用論文中的實驗結果.從表2可以看到,與CEDN[15]算法相比,本文所提算法在CC、sAUC和SIM三個評價指標上分別提高了9.4%、4.8%和4.7%.

表2 CAT 2000上客觀結果對比Tab.2 Objective results on CAT 2000 dataset

主觀結果如圖7所示,可以看出,相對于其他算法,本文所提算法在CAT2000數據集上依然能夠獲得較好的注視點預測效果,說明本文所提算法具有較好的魯棒性.

圖7 CAT 2000測試主觀對比結果Fig.7 Subjective results on the CAT 2000 dataset

2.3 超復數小波變換、ASPP和Res_CBAM模塊分析

為了說明本文所提算法中每個模塊的有效性,本節對超復數小波變換級數、ASPP模塊和Res_CBAM模塊在注視點預測中所起到的有效性進行驗證.結果表明,所提算法中每個模塊都能有效提高注視點預測準確度.

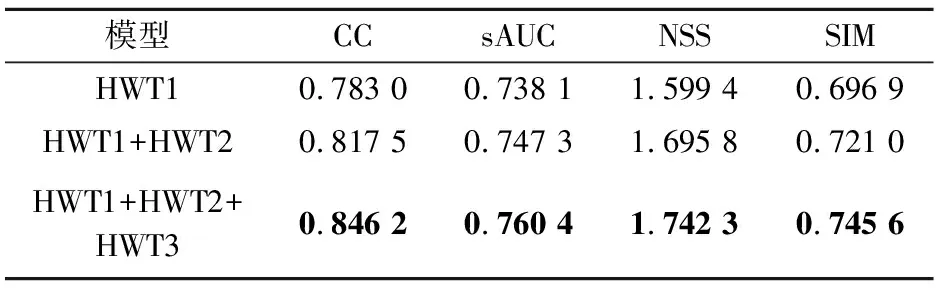

2.3.1超復數小波不同級數變換性能分析

由于超復數小波可以進行多級變換,因此在卷積網絡中,超復數小波的哪一級或者哪些級的信息有利于注視點預測是需要考慮的.對此,利用超復數小波不同級的分解訓練網絡模型,在SALICON數據集上通過CC、sAUC、SIM和NSS評價標準確定超復數小波變換特征圖的選取,具體實驗結果見表3.由圖8可以看出,利用超復數小波多級變換的子帶圖可以增加注視點預測的細節信息,提高注視點預測精度.然而,當加入超復數小波變換的第四級分解子帶圖時,模型性能提升不大,有些評價指標還有略微的下降,相對于僅用一級超復數小波變換,使用前三級超復數小波變換的結果在CC、sAUC、NSS和SIM評價指標上,注視點預測準確度提高了8.4%、3.0%、8.9%和7.0%.因此,所提模型中使用了超復數小波變換的前三級分解子帶圖.超復數小波變換將圖像從RGB三通道的空域變換到含有圖像細節的頻域,利用頻域的細節信息,有效豐富了注視點預測特征.上述實驗表明,使用超復數小波變換可提高注視點預測的準確度.

圖8 使用超復數小波變換不同級分解的主觀結果對比Fig.8 Subjective results of different levels of quaternion wavelet transform

表3 加入超復數小波變換不同級分解的客觀結果分析

2.3.2ASPP和Res_CBAM模塊

為了評估ASPP和Res_CBAM模塊的作用,所提模型中去掉ASPP模塊(-ASPP)或者去掉CBAM模塊(-CBAM)進行注視點預測,通過在評價指標CC、sAUC、NSS和SIM上對比測試結果,驗證模塊的有效性.

本節從客觀評價標準和主觀注視點預測圖兩個方面對注視點預測算法中所使用的模塊進行評價.在表4(其中-ASPP和-CBAM分別表示在本文所提模型中去掉ASPP或者Res_CBAM模塊)中可以看到,使用ASPP模塊在CC、sAUC、NSS和SIM

表4 加入ASPP和Res_CBAM模塊的客觀結果分析Tab.4 Analysis of objective results by using the ASPP and Res_CBAM modules

評價指標上能夠提高1.8%、1.1%、1.2%和2.3%,使用Res_CBAM模塊在CC、sAUC、NSS和SIM評價指標上注視點預測準確度也有相應的提高,分別提高了0.5%、0.3%、0.1%和0.2%.

主觀結果如圖9所示.可以看出,ASPP模塊可以模擬人類視覺系統,從特征圖中獲得不同感受野信息,結合這些不同感受野信息,預測出較為準確的注視點位置(圖9最后一行);對于大量的注視點預測特征圖,在特征圖空間位置和通道中,除了含有大量與注視點相關的信息外,一些特征圖是對背景信息的表達,而Res_CBAM模塊能夠從特征圖空間位置和通道中篩選出與注視點相關的信息,抑制背景信息的干擾;對于比較復雜的圖像,也能夠獲得較準確的注視點預測(圖9第三行).

圖9 ASPP和Res_CBAM模塊的主觀對比Fig.9 Subjective results of different levels of quaternion wavelet transform

3 結語

超復數小波變換能夠從頻域角度為注視點預測提供相關的圖像細節信息,與現有的深度卷積算法結合,可以更加全面地得到注視點預測特征信息,進而提高算法精度.ASPP模塊可以增大感受野,在網絡模型學習參數時,模擬人眼觀察圖像的過程,由局部到全局,判斷注視點位置的正確性和準確性.而Res_CBAM模塊在網絡模型中能夠學習推理注視點預測過程,提高注視點預測精度.從主觀和客觀實驗結果對比表明,本文所提算法取得了較好的注視點預測效果.今后將結合圖像中人與人、人與物體、物體與物體之間的語義關系,從圖像中獲取更加符合人類視覺的注視點預測結果.此外,本算法今后將從模型壓縮入手,減少模型的參數量,使模型進一步滿足實時性的要求.