用于彈載線陣紅外與激光掃描成像引信的輕量化卷積神經網絡目標識別方法

武軍安,郭 銳,劉榮忠,柯尊貴

(1.南京理工大學 智能彈藥技術國防重點學科實驗室,江蘇 南京 210094;2.西南技術物理研究所,四川 成都 610041)

末敏彈是一種將復合探測、穩態掃描與爆炸成形彈丸技術應用于子母彈的靈巧化彈藥,其中的復合探測技術是其核心技術。縱觀國內外已裝備的末敏彈,主要以點元紅外敏感器、主動毫米波雷達和被動毫米波輻射計作為探測器,并將幾種探測器進行組合實現復合探測體制。探測信號大多是以一維的數據形式對掃描區域進行描述,對目標的細節特征描述有限[1]。然而隨著現代戰場環境的復雜化以及干擾、隱身等對抗技術的發展,基于點元探測器的末敏彈越來越難以滿足現代戰場環境下的作戰要求。因此需要對掃描區域進行更為精細化的成像式探測來提高末敏彈在復雜戰場環境下的適應能力。線陣紅外與激光雷達探測器是將像元以線列形式排列的探測器,成像需要結合掃描運動才能實現。而末敏彈工作時恰好做螺旋穩態掃描運動,因此利用線陣探測器可以很容易地實現對地面目標的掃描成像,將二者進行復合式探測既能獲取較高分辨率的紅外輻射信息,也能獲取對目標三維幾何描述的距離信息,對末敏彈的目標判斷和場景分析提供了更加全面、完整和豐富的特征信息[2-3]。

基于卷積神經網絡(convolutional neural network,CNN)的識別算法避免了傳統識別算法中復雜的目標分割、特征提取等過程,是一種將原圖像直接作為輸入的端到端的識別模型。2015年HE等[4]提出的ResNet在ImageNet數據集上的分類誤差降低到了3.57%,其性能已經遠遠超過傳統特征提取的識別算法,由此可見CNN對復雜環境下的目標識別具有明顯優勢,這也為末敏彈在復雜環境下的目標識別提供了新的研究方向。CNN強大的圖像特征提取能力使其在目標識別領域得到了廣泛的運用,一些學者已經將CNN運用在異源圖像的目標識別任務中。劉峰等[5]在AlexNet基礎上提出了一種CNN融合識別模型,先利用CNN對三波段的可見光圖像、長波紅外圖像和短波紅外圖像分別進行特征提取,然后采用基于互信息特征選擇的方法對特征量進行壓縮,最后再利用全連接層完成了海上目標分類任務。Gao等[6]同樣利用AlexNet將可見光圖像與激光雷達上采樣后的距離圖像拼接構成4通道的RGB-D數據,實現了車輛目標分類識別任務。江澤濤等[7]對可將光圖像與紅外圖像利用加權融合規則進行融合,將融合后的圖像作為CNN的輸入,實現了對不同場景的識別,經實驗驗證,融合后的圖像比單獨使用源圖像的識別準確率更高。

雖然利用CNN對異源圖像進行目標識別取得了較好的效果,但對紅外像和距離像上的研究較少,同時還需滿足彈載對實時性的要求對CNN網絡需要輕量化設計,來減少模型量計算量。因此,本文根據彈載應用場景以及距離像和紅外像的成像特點,提出了一種分布式融合輕量級卷積神經網絡(distributed fusion convolutional neural net,DF-Net),通過圖像融合、分布式卷積和深度可分離卷積實現了CNN的輕量化設計,并利用縮比場景的自建數據集對本文所提方法及網絡結構進行實驗分析與討論。

1 末敏彈線陣掃描成像模型

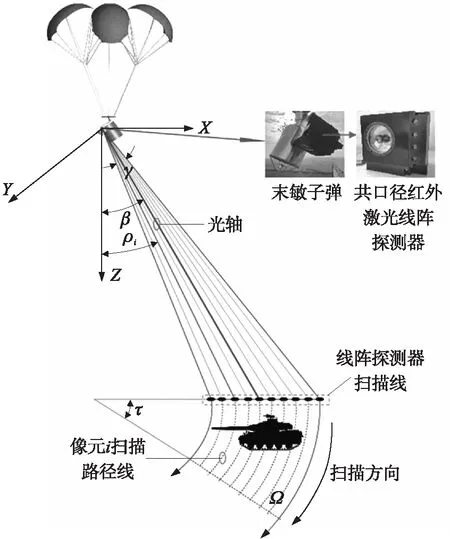

彈載線陣探測器的掃描成像是借助末敏彈的穩態旋轉掃描運動來實現的,其成像示意圖如圖1所示。圖中,β為末敏彈的掃描角;γ為線陣探測器俯仰方向上的視場角,線陣紅外與線陣激光的視場角相同并且被像元等分;τ為轉動角,即子彈在一段時間內繞回轉軸轉過的角度;ρi為視場中線陣探測器第i個像元光路與鉛錘方向的夾角。

圖1 線陣掃描成像模型示意圖

為了保證兩幅圖像的配準,紅外與激光接收端為同視場,并且在同一時刻采集。線陣激光雷達通過計算每個像元的激光發射與接收回波之間的時間差來實現測距,設APD的像元數量為M,當掃描線轉過τ時會在地面形成一個局部掃描區域Ω,區域Ω由N次掃描的掃描線數據構成,將掃描線數據按先后順序進行拼接可獲得一個大小為M×N的二維距離矩陣D′:

D′=(dij)M×N

(1)

式中:i=1,2,…,M;j=1,2,…,N。線陣紅外探測器則直接通過接收熱輻射得到紅外輻射灰度信息R:

R=(rij)M×N

(2)

式中:dij和rij分別為第i個激光與紅外像元在第j次采樣時測得的距離值和紅外強度值。

由于獲得的紅外數據R本身就是8 bit量化后的灰度值,因此R可直接作為紅外圖像。而對于掃描得到的距離數據則需要進行一步處理。首先將距離數據轉換為激光腳點與子彈的相對高度數據H′:

H′=D′cosρi

(3)

然后選擇合適的量化區間S,對H′進行8 bit量化即可作為本文CNN與圖像融合算法所需的距離灰度像D:

(4)

式中:“[·]”表示取整,hmax為H′中的最大值,h′ij為H′中的元素。

2 分布式-融合輕量化卷積神經網絡算法模型

2.1 基于導向濾波的紅外像與距離像融合算法

在本文中將融合圖像作為前級卷積神經網絡的輸入數據,目的是增加輸入特征的多樣性,提高輕量化CNN對目標分類的準確率,因此對融合圖像,希望能在充分反映互補特征的同時具有較低的算法復雜度,以滿足彈載環境對實時性的要求。本文融合算法的具體過程如下。

①源圖像分解。

首先通過高斯濾波對圖像進行平滑處理得到圖像的低頻分量LD和LR:

LD=D*g,LR=R*g

(5)

式中:g為高斯平滑核;“*”表示卷積。高斯核參數的選取應保證盡可能濾除細節特征。獲得圖像的低頻分量后得到高頻分量HD和HR:

HD=D-LD,HR=R-LR

(6)

對于小尺寸、紋理特征不豐富的圖像經一次低通濾波就可以得到很平滑的低頻圖像,因此本文對源圖像只進行了一次分解。

②低頻融合系數的構建。

圖像的低頻子圖保留了原圖像的近似特征,對于本文的低頻子圖而言,由于只進行了一次非降采樣的分解,直接使用平均融合容易導致圖像邊緣模糊、對比度降低,因此對低頻融合系數進行如下處理:首先建立2個與源圖像尺寸一致且系數均為0.5的初始融合系數矩陣mR和mD;然后將源圖像作為引導圖對初始系數進行導向濾波,即:

(7)

(8)

根據導向濾波的特性可知[12],若圖像中某一區域的局部方差較小,則認為處于引導圖像的平坦區域,此時濾波器的輸出即為相鄰像素的平均值;若局部方差較大,此時只有一邊的權重會被平均,從而保證了邊緣不被模糊,因此初始權重經導向濾波后保證了空間上的連續性。

③高頻融合系數的構建。

在高頻子圖中主要包含了場景中邊緣特征、目標紋理特征、邊界變化特征等灰度值變化較為強烈的區域,為了在融合圖像中更好地體現上述特征,對于高頻分量通常選用“絕對值取大”的方法進行融合,首先構建初始融合權重CR,CD:

(9)

CD=1-CR

(10)

同理,為了讓融合權重具有空間連續性,與低頻分量處理一樣,使用導向濾波對初始權重進行處理,即:

(11)

經歸一化后得到高頻融合系數:

(12)

④重建融合圖像。

利用②和③獲得的融合系數分別對高頻子圖和低頻子圖進行加權求和,則融合后的高頻圖HF和低頻圖LF分別為

(13)

式中:“·”表示矩陣元素點積運算。最終的融合圖像F只需將融合高頻圖HF和融合低頻圖LF相加即可獲得,即:

F=HF+LF

(14)

2.2 分布式-融合卷積神經網絡結構

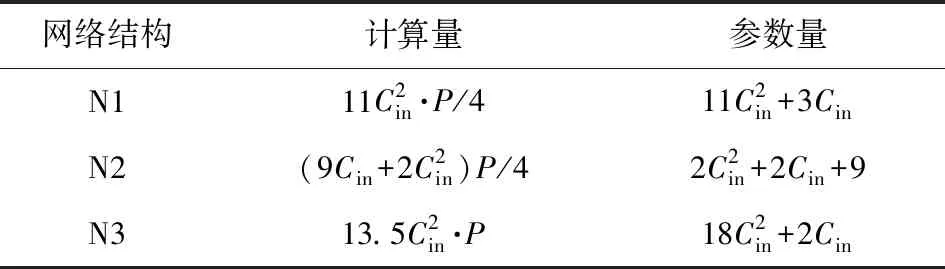

本文設計的DF-Net網絡框架從整體上將網絡分為:前級的分布式特征提取網絡和后級融合網絡。在前級網絡中,距離像、紅外像以及融合像各自擁有獨立的卷積網絡,同時卷積操作并未使用傳統卷積加池化下采樣或者直接利用深度可分離卷積進行提取,而是由2組步長為2步長(s=2)的3×3卷積(3×3 Conv)和1×1卷積(1×1 Conv)構成。這種方式雖然比深度可分離卷積的計算量大,但學習特征能力更強;與傳統卷積加池化下采樣的方式相比,省去池化操作(Pool)的同時進一步降低網絡的計算復雜度。圖2是以上3種結構的實現方式,設輸入特征圖為M×N×Cin,輸出特征圖均為(M/2)×(N/2)×2Cin,圖中N1為本文卷積結構,N2為深度可分離卷積結構,N3為帶有池化下采樣的卷積結構,所有網絡均使用了批次歸一化層(batch normalizing,BN)[11],表1為3種網絡結構的計算量和參數量,表中,Cin為輸入的通道數,P為輸入圖像大小。通過表1中計算量與參數量的對比,本文結構雖然比N2結構計算復雜度高,但相比N3的傳統結構計算量下降了約79.6%,參數量下降了37.5%。

表1 不同卷積結構計算復雜度對比

圖2 3種結構的實現方式

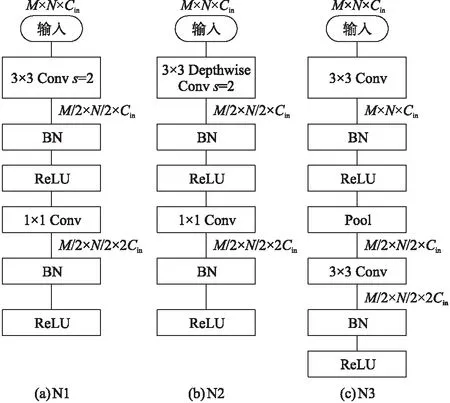

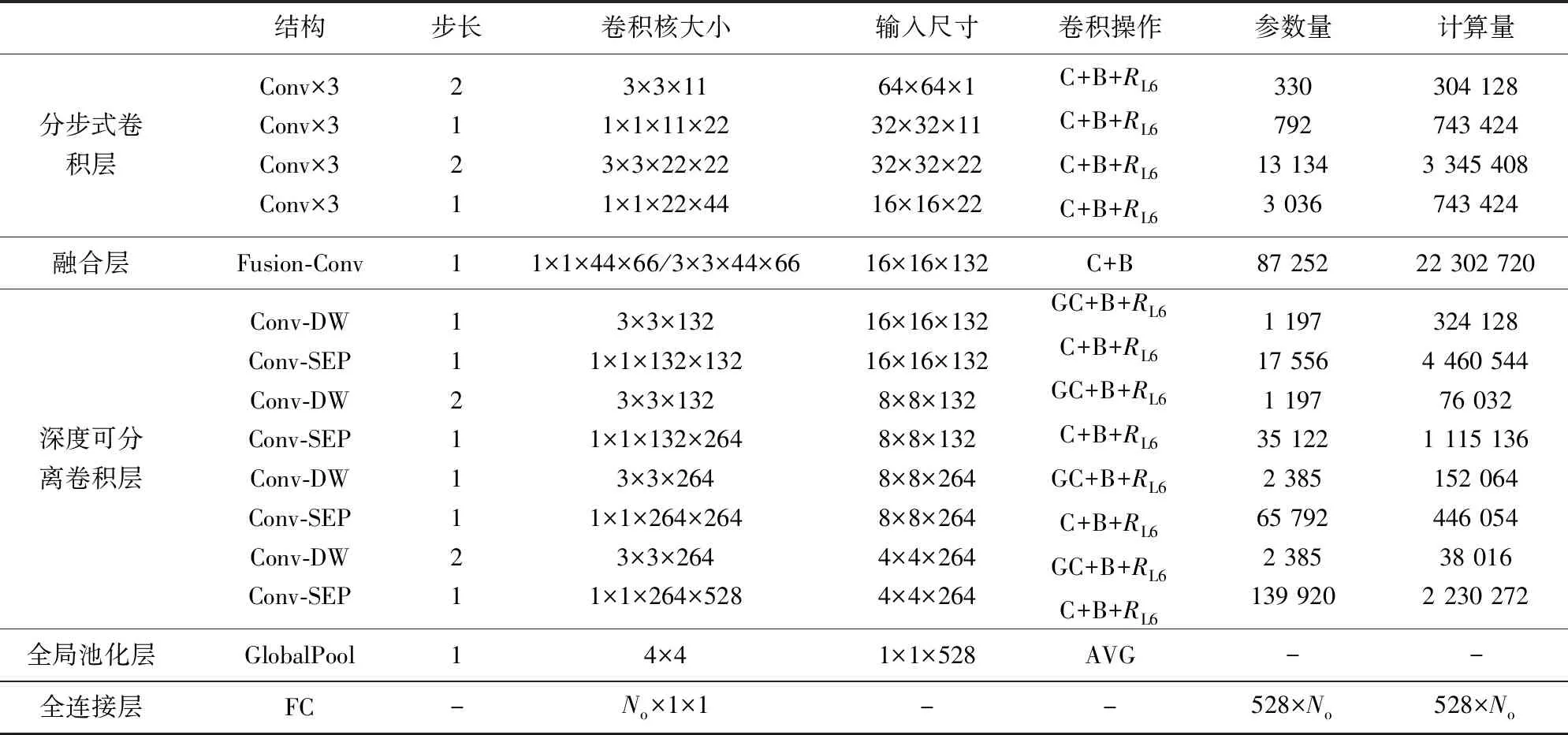

網絡的后級則是對上述特征量進行融合、提取與壓縮,并最終給出分類結果。對前級的特征融合,利用雙尺度卷積核進行融合,首先對3個通道的特征圖進行首尾拼接;然后利用3×3卷積核和1×1卷積核分別對拼接后的特征圖進行卷積以實現特征間的融合。最后再將卷積后的特征圖進行拼接并送入后續卷積層中。對融合后的特征圖利用深度可分離卷積模塊進行卷積,根據文獻[11]指出的深層特征對網絡性能的貢獻高于淺層網絡特征,因此在融合卷積層后面又增加了多組深度可分離卷積模塊來提高網絡對特征的學習能力。表2給出了本文DF-Net網絡具體的結構設計參數,輸入的距離像、紅外像以及融合圖像先經13層CNN卷積得到4×4×528的特征圖,最后利用全局平均池化將特征圖變為1×528的一維特征向量,并與輸出分類數量一致的神經元構成全連接層,并利用SoftMax層得到每種類別的分類概率。網絡在每個卷積層和激活層之間增加了批次歸一化層,用于加快網絡的訓練收斂速度和防止過擬合的發生。每個卷積層之間選用RL6作為網絡的激活函數,即:

RL6=min(max(0,x),6)

(15)

表2中,C表示普通卷積;GC表示可分離卷積;B表示批次歸一化操作;RL6為ReLU6激活函數層,No為最終的分類數。

表2 DF-Net 網絡設計參數及計算復雜度

3 實驗與結果分析

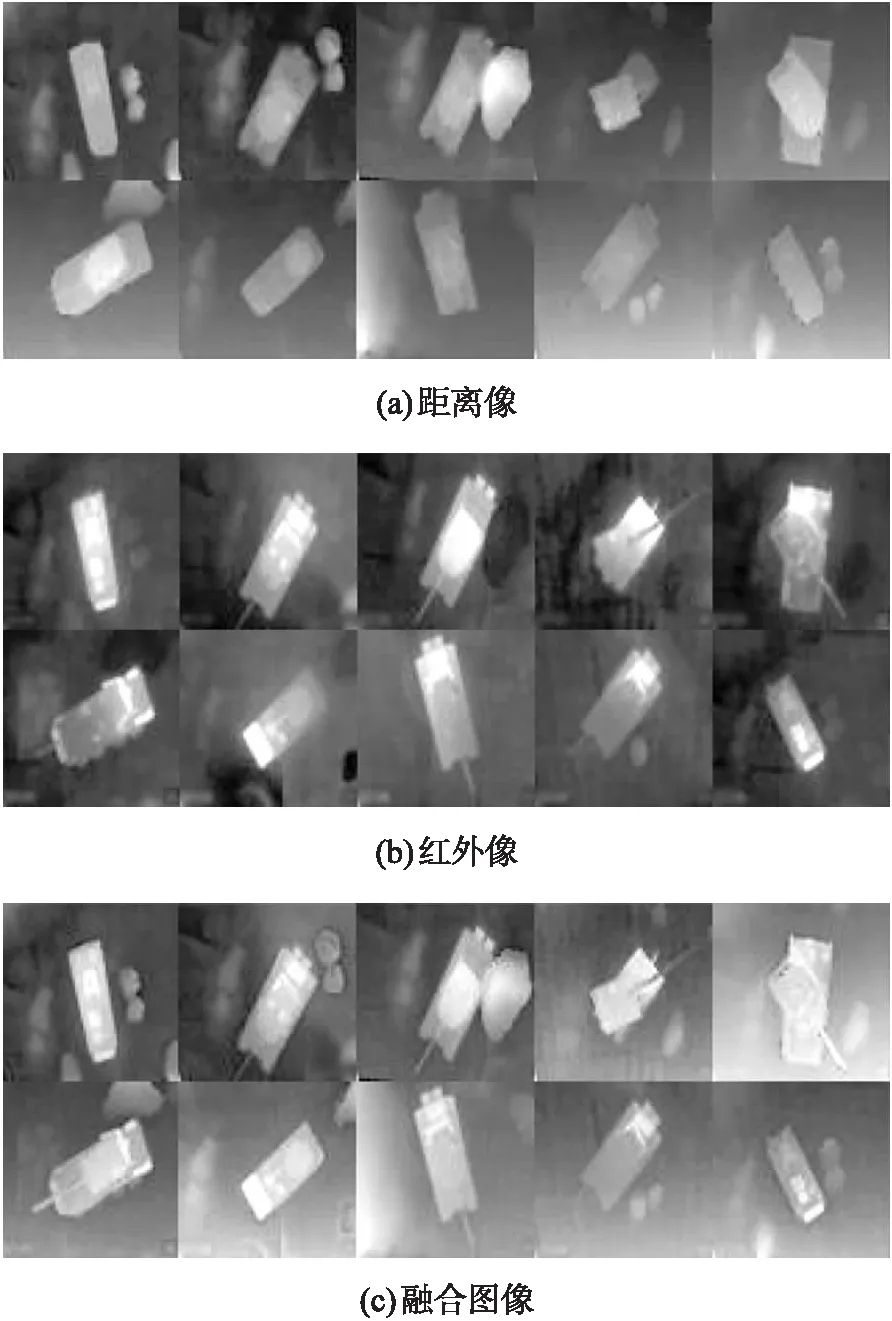

實驗所用數據集通過實驗室搭建的縮比實驗平臺獲得。在模擬場景搭建時考慮了裝甲目標在真實戰場環境下的工作情況,為了讓數據更加真實,模擬了在不同坡度、不同地形、不同高度、目標存在局部遮擋以及目標周圍存在障礙物情況下的實驗場景。裝甲目標選取了主戰坦克、裝甲運兵車、自行火炮等多種模擬目標,目標縮比比例為1∶24(平均長、寬、高分別約為36 cm,13 cm,10 cm),探測器最大探測高度3 m,同時為了模擬紅外特征在裝甲目標發熱處內部設計了電子恒溫加熱裝置,保證與地面溫差大于10 ℃。樣本的獲取首先利用縮比模擬場景共獲取4 000組樣本,樣本中圖像大小為64×64,然后利用翻轉、平移、旋轉和隨機裁剪等方法對樣本進行增廣,最后將樣本數據分為4類裝甲目標(坦克目標、運兵車目標、自行火炮和導彈車,每類各11 000)和非裝甲目標(由不含裝甲目標的背景構成共44 000)。對裝甲目標樣本進行分類后,CNN網絡不僅可以建立目標識別的二分類網絡(裝甲目標44 000和非裝甲目標40 000),也可建立目標分類的五分類網絡(4類裝甲目標各11 000個,非裝甲目標從40 000中隨機抽取11 000作為樣本),從而驗證網絡對裝甲目標分類判別的能力。在數據集劃分上,選取總數據集的80%作為訓練集,剩下的20%作為測試集,分別用于網絡的訓練和測試階段。圖3為數據集中部分樣本示例,數據集中包含裝甲目標的部分紅外圖像、距離圖像和融合圖像。

圖3 數據集中部分樣本示例

在實驗中所有網絡均采用了帶動量的小批量隨機梯度下降算法作為網絡模型訓練的優化算法,訓練一次的樣本量(Batch size)根據GPU內存容量設置為100,為了保證網絡訓練的穩定收斂,學習率的調整策略選用階梯式(STEP)策略,設初始學習率α0=0.01,每經過一次階躍步長k新的學習率α衰減為

α=α0×ω?t/k」

(16)

式中:ω為衰減系數;“?·」”為向上取整符號;t為當前迭代訓練次數。在本文中k=10 000,ω=0.1,即網絡每進行10 000次的迭代訓練,學習率衰減為原來的10%,總迭代次數為50 000次。實驗在PC機上進行,主要配置如下:CPU Intel I7-8700k,GPU NVIDIA GeForce GTX1080Ti(顯存8G),內存 DDR4 16G,網絡模型在Caffe開源架構上進行訓練與測試,操作系統運行環境為Ubuntu 16.04。

實驗結果如下:

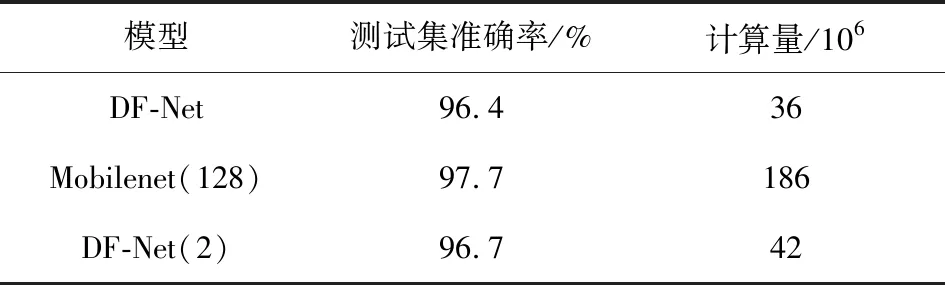

①不同網絡結構對性能的影響。 將本文網絡與流行的輕量化網絡Mobilenet128[10]以及將DF-Net中前級分布式卷積改為N3結構的DF-Net(2)進行了性能對比,結果如表3所示,可以看出:雖然DF-Net準確率較Mobilenet128降低了1.3%,但計算量僅為Mobilenet128的12%;對本文圖像,前級網絡使用深度可分離卷積不利于網絡對特征的學習,以N1和N3作為網絡前級效果較好,二者性能相當,在準確率上只高了0.3%,但從計算量和參數量上來看N1結構更具有優勢。

表3 測試集準確率與計算量對比

②融合圖像對網絡性能的影響。 當刪除融合圖像時網絡在測試集上的準確率為94%,下降了2.1%,可以看出,引入融合圖像可以提高網絡對特征的提取能力。

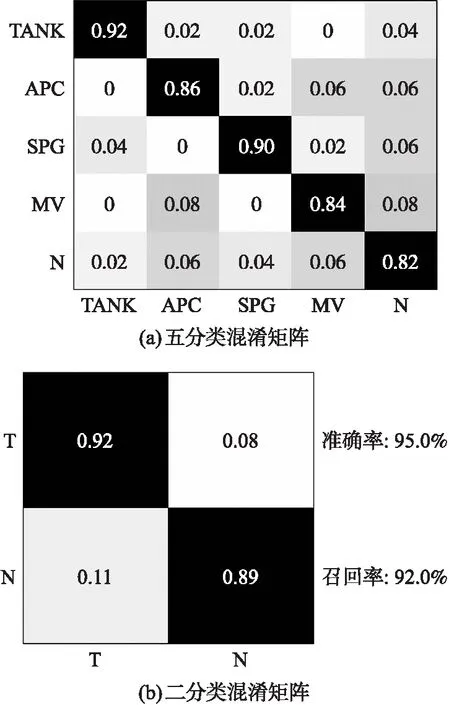

③DF-Net在復雜環境下的網絡性能。 利用模擬場景采集背景環境較為復雜的距離圖像和紅外圖像樣本,并利用樣本增強方法將數據擴充到400組(包含4類裝甲目標的樣本每類50組,其余為不含裝甲目標的樣本),來驗證網絡模型的泛化能力以及對復雜背景環境下的目標識別能力,并用混淆矩陣對性能進行評估。圖4(a)是五分類預測的混淆矩陣(TANK坦克,APC運兵車,SPG自行火炮,MV導彈車),圖4(b)是二分類混淆矩陣(T裝甲目標,N無目標),混淆矩陣中縱坐標表示真實樣本分類,橫坐標表示預測樣本分類,矩陣中數字均為百分比。

圖4 DF-Net網絡模型目標分類混淆矩陣

從混淆矩陣可以看出,五分類的總體準確率為86.8%,二分類為90.5%,相比之前在測試集上的實驗結果有所降低,但總體上看,DF-Net模型依然具有較強的目標識別和分類能力。在圖4(a)中可以發現,五分類任務的準確率要低于二分類任務,而且在對4類裝甲進行預測時均出現了少部分目標被誤判為非目標的情況,同時裝甲運兵車(APC)和反坦克導彈車(MV)之間還出現了一定程度的混淆。出現上述情況主要有以下兩方面原因:①實驗環境的局限使得訓練樣本無法包括所有可能性,導致模型訓練不夠充分;②不同類裝甲目標的車身主體存在相似的情況(例如裝甲運兵車和反坦克導彈車),當只掃描到目標局部或者目標遮擋較為嚴重時,模型無法得到準確的判定信息從而造成分類混淆,或者探測高度較高時目標在低分辨的圖像上特征丟失嚴重也可能造成分類混淆。

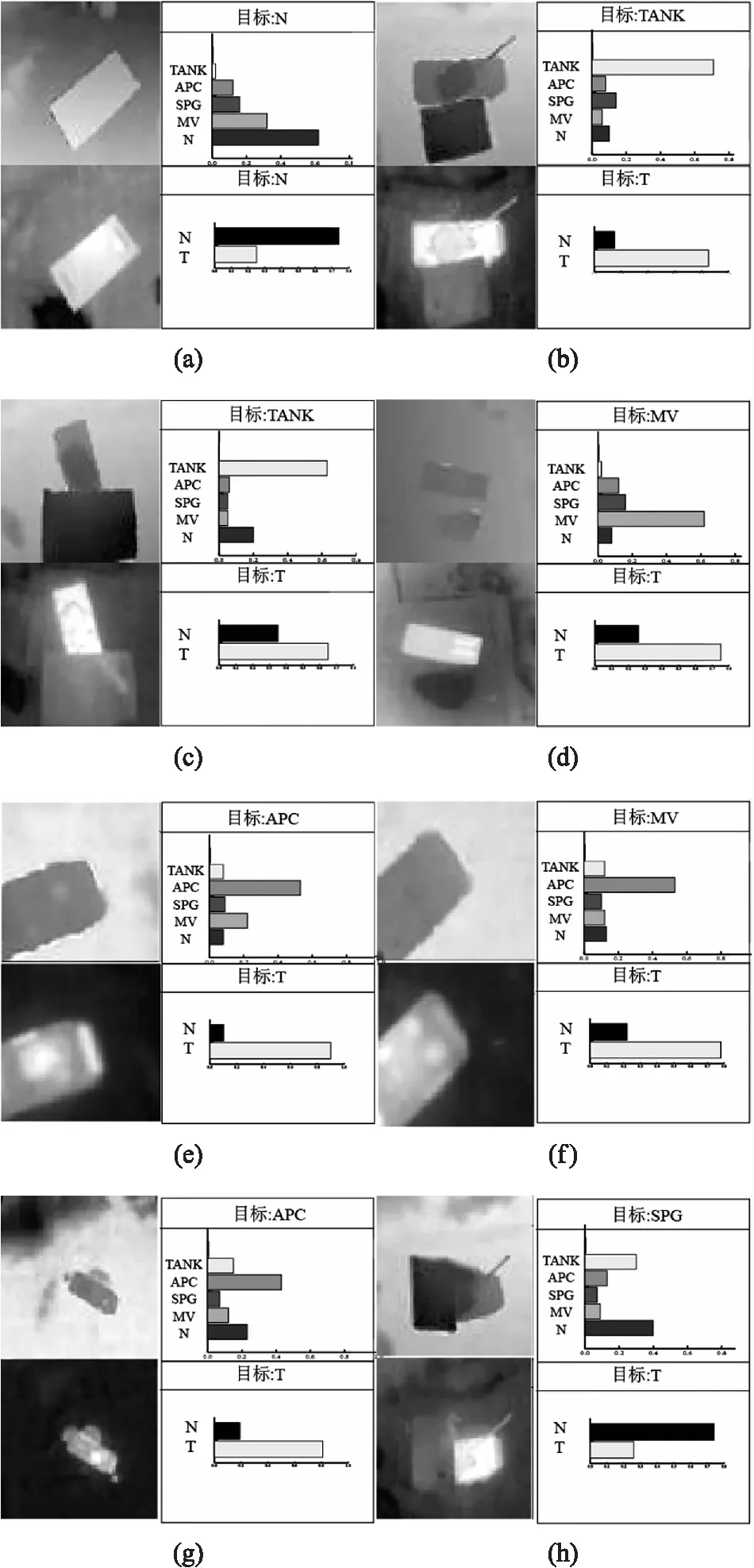

圖5是從數據集中選取的8組實驗樣本并利用DF-Net分別進行2分類和5分類的結果,圖5(a)為假目標樣本,圖5(b)~圖5(d)為目標四周有障礙物或者局部遮擋的情況,圖5(e)、圖5(f)為目標局部掃描樣本,圖5(g)為在高處探測時目標四周有大量干擾的樣本,圖5(h)為目標超過50%被遮擋的樣本。

圖5 部分樣本識別結果

從實驗結果上可以看出:網絡在樣本a~e中均準確識別出了目標,樣本a是長寬高與裝甲目標相似的矩形偽目標,由于在訓練樣本中加入了此類偽目標,因而未產生虛警,樣本b~d是目標周圍有障礙物或者存在局部遮擋的情況,此時網絡也做出了正確識別;樣本e和f是車體相似的兩類不同的目標,由于是局部圖像,兩個目標的特征較為相似,因此在五分類任務中將反坦克導彈車錯誤分類成了運兵車,但是在二分類的裝甲目標識別任務中被準確分類;對樣本e進行分類時,雖然此時目標在視場中比例較小,周圍還存在熱源與障礙物干擾,但DF-Net依然給出了正確分類;對于樣本h,由于此時目標被大面積遮擋,其特征不能被充分描述,從而導致目標分類錯誤。

4 結束語

本文為了提高末敏彈在復雜背景環境下對裝甲目標的識別能力,利用CNN在圖像處理上的優勢,提出了一種適用于低分辨距離像和紅外圖像的融合-分布式輕量化卷積神經網絡模型DF-Net。通過實驗表明:

①融合圖像的引入可以提高網絡對特征的提取能力,在相同網絡層數下能夠獲得更好的識別精度,對于低分辨的紅外圖像和距離像應盡可能選取計算量小、更好保留邊緣紋理特征的算法來提高系統的實時性;

②DF-Net通過前級N1結構的分布式卷積處理和后級的深度可分離卷積,讓網絡具有更少計算量,同時也具有優異的目標識別性能;

③CNN具有強大的特征提取能力,因此本文方法適用于背景環境復雜以及對抗環境干擾要求較高的戰場環境。