基于深度Q-Learning的信號燈配時優化研究

趙 純,董小明

(安慶師范大學 計算機與信息學院,安徽 安慶 246000)

0 引 言

隨著機動車數量的不斷增長,道路交叉口的擁堵問題迫在眉睫,想要更好地處理交通擁堵問題,就必須從根源出發。傳統的交通信號控制時間固定,導致綠燈階段的不必要等待,造成了極大的資源浪費,而且也需要大量的人力物力資源[1]。因此通過交通信號控制,能夠很好地緩解擁堵壓力,減少交通事故的發生,使系統更加效率化和合理化。

交叉口路網系統具有一定的不確定性和實時性,因此需要設計一個能夠感知狀態變化、選擇最優時間的控制器。由于近年來交通控制系統的目標是通過預測未來的交通狀態提前制定適當的控制方案[2],這一方案突出了智能交通的重要性和艱巨性。但是隨著強化學習和深度學習的不斷發展進步,有許多學者把深度學習和強化學習結合為深度強化學習應用到交通控制上[3]。機器學習是目前快速發展的理論方向,包含了眾多的研究方向,而強化學習是機器學習的一個領域,使得強化學習成為時下研究的熱點問題之一[4-5]。

強化學習是一種自適應生成控制策略,其中一個或多個Agent學習如何利用Agent和環境本身之間的交互產生的經驗來解決環境中的任務。早期階段的交通信號強化學習控制對手動特征提取有著很大的依賴性,需要極大的人力資源,而且狀態非常不穩定,很容易就丟失最主要的狀態信息。強化學習由于近年來AlphaGo[6]等的成功而越來越吸引人們的關注和研究興趣。

文中提出的方法主要優勢在于:

(1)通過采用密集采樣策略和改進后的獎勵函數相結合的方式對Agent模型進行修改,這種方式在一定程度上提高了控制的性能。

(2)所有的仿真實驗都是使用現在國際主流的交通模擬軟件(simulation of urban mobility,SUMO)來完成的,大大提高了實驗的可靠性和穩定性。

(3)參數設置合理,通過多次實驗減少偶然性,提高了控制系統的穩定性。

1 交通信號配時的深度Q-Learning算法

文中的Agent通過與環境進行交互學習如何制定一個最優策略[7]。交互由微型交通模擬器進行處理,模擬器能夠讓智能體體驗多種情況,并在模擬過程中學習哪些因素影響并激活了錯誤的信號燈相位。在強化學習框架[8]中,Agent被定義為三個基本屬性:狀態表示、一組可能的行為和獎勵函數。

1.1 狀態表示

近年來有關交通信號燈控制器的研究工作提出了信息豐富的狀態,但在現實中,由于這種表示中所使用的信息很難收集,所以很難實現。而Agent感知到某一時刻t的環境狀態,這里使用一種簡單并且易于應用的狀態表示方法來增加獲得良好結果的可能性。在交叉口的每一條臂上,進入的車輛在單元中被離散化,這些單元可以識別其中是否有車輛。環境狀況被表現為路面的離散化,目的是告知Agent車輛在特定時間內的位置。

1.2 動作行為

動作集確定了Agent可用的交互方式,它被定義為一個交通燈的配置,執行一個操作就意味著在一組車道上將一些交通燈變綠,并保持固定的時間。以下表示Agent可以采取的所有可能的操作:

·東西向前進:綠色階段適用于位于東西向且想要直行或右轉的車輛。

·東西向左轉:綠色階段適用于處于東西向并希望左轉的車輛。

·南北前進:綠色階段適用于位于南北向并希望直行或右轉的車輛。

·南北向左轉:綠色階段適用于位于南北向并希望左轉的車輛。

1.3 獎 勵

根據Agent選擇的動作行為,從環境中產生反饋給Agent,以評估其選擇的行動。Agent通過收到的獎勵來改進其將來的行為選擇策略,積極的獎勵是好的行動的反饋結果,而消極的獎勵是在選擇壞的行動之后得到的。在此實驗中,目標是最大化通過交叉口的交通流量。為了達到這個目標,獎勵應該從一些績效指標中獲得確信的流量效率,因此Agent能夠理解是否采取了合理的行動來提高或降低交叉口效率。

1.4 傳統的Q學習

Q-Learning是無模型強化學習的一種形式,它包括為從特定狀態執行的操作并分配一個稱為Q-value的值。Q-value的目的是量化一個行動的優缺點,使用即時獎勵和最大預期未來回報相結合,這樣Agent就知道哪些行動將導致最佳的總體策略[9]。然后,該狀態與該狀態的動作值之間的映射被一個深層神經網絡逼近。

傳統的Q學習算法[10-11]更新式如下:

Q(st,at)=Q(st,at)+α(rt+1+γ.maxAQ(st+1,at+1)-Q(st,at))

(1)

該方程使用學習率α來更新當前的Q值。rt+1表示與在狀態st處采取行動相關的獎勵,Q(st+1,at)表示近期未來的Q值,st+1是環境在狀態st選擇動作后演化的下一個狀態,γ是假設值介于0和1之間的折扣因子,通過這個折扣因子可以降低未來獎勵的重要性。

1.5 Q-Learning更新公式

文中使用了改進后的公式,如下:

Q(st,at)=rt+1+γ.maxAQ'(st+1,at+1)

(2)

獎勵rt+1是在st采取行動之后才收到的獎勵,Q(st,at)是st+1采取相關行動后有關的Q值,也就是采取行動后的下一個狀態,折扣因子γ表示和即時獎勵相比,未來獎勵的懲罰相對較小。這個公式是通過即時獎勵和未來動作的折扣Q值來更新狀態st中當前行動Q值的規則。所以,表示未來動作隱含價值的Q'(st+1,at+1)是持有st+1之后的最大折扣回報,即Q''(st+2,at+2)。同樣,它也擁有下一個狀態的最大折扣回報,即Q'''(st+3,at+3)。這就說明不管Agent如何選擇動作,不僅僅基于即時獎勵,而且也基于未來預期折扣獎勵。在模擬過程中,Agent迭代地獲得關于動作序列值的知識。最后,希望它能夠選擇動作序列,從而獲得更高的累積回報以獲得最佳性能。

1.6 獎勵函數

文中涉及的獎勵函數:

文獻獎勵函數:當Agent選擇一個錯誤的動作時,就給它返回一個負值,當它選擇一個好的動作時,就給它返回一個正值。不良行為可以表示為在當前時間步驟t中,與前一時間步驟t-1中的情況相比,在隊列中添加更多車輛的操作,導致與上一時間步驟相比等待時間更長。

文獻獎勵函數的等式如下:

rt=Swt-1-Swt

(3)

其中,rt表示在時間步驟t的獎勵,Swt-1和Swt是在時刻t-1和t時所有車輛的總等待時間。

將上面這個等式進行了改進,表示如下:

rt=0.8·Swt-1-Swt

(4)

等式符號與式(3)基本相同,唯一的不同就在于系數為0.8,修改這個系數的主要原因是增加所獲得獎勵的幅度。這種變化的效果是,Agent對行動的后果有更強的代表性,訓練的有效性得到了提高。

1.7 深度神經網絡

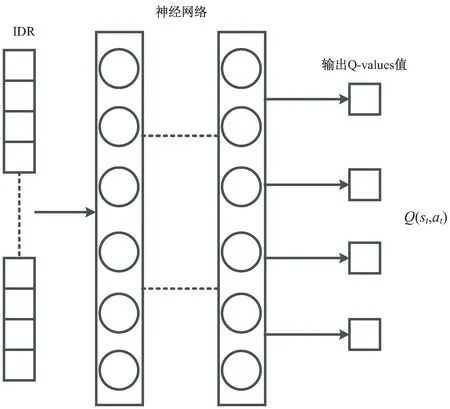

文中使用了深度Q-Learning算法,將觀察到的環境狀態st映射到與動作相關的Q值,并搭建一個深度神經網絡[12]。它的輸入是時間步長為t時的IDR(環境狀態向量),深度神經網絡的輸出是來自狀態st的作用Q值。

一般地,神經網絡的輸入nin被定義為:

(5)

(6)

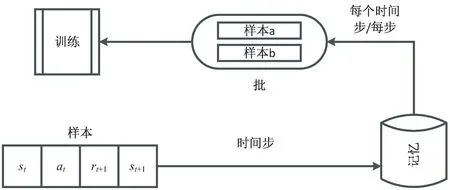

神經網絡是基于感知機的擴展,而深度神經網絡(DNN)可以理解為有很多隱藏層的神經網絡。多層神經網絡和深度神經網絡DNN其實也是指的一個東西,DNN有時也叫做多層感知機,它是一種具有校正線性單位激活函數和完全連接的深層神經網絡。圖1清楚地展示了神經網絡的層與層之間的聯系。

圖1 神經網絡訓練機制

從圖1可以看出,作為深度神經網絡的輸入,輸入了n個IDR向量,并傳輸給神經網絡層進行訓練,訓練結束后輸出與時間步t相關的Q-Value值。

2 仿真實驗

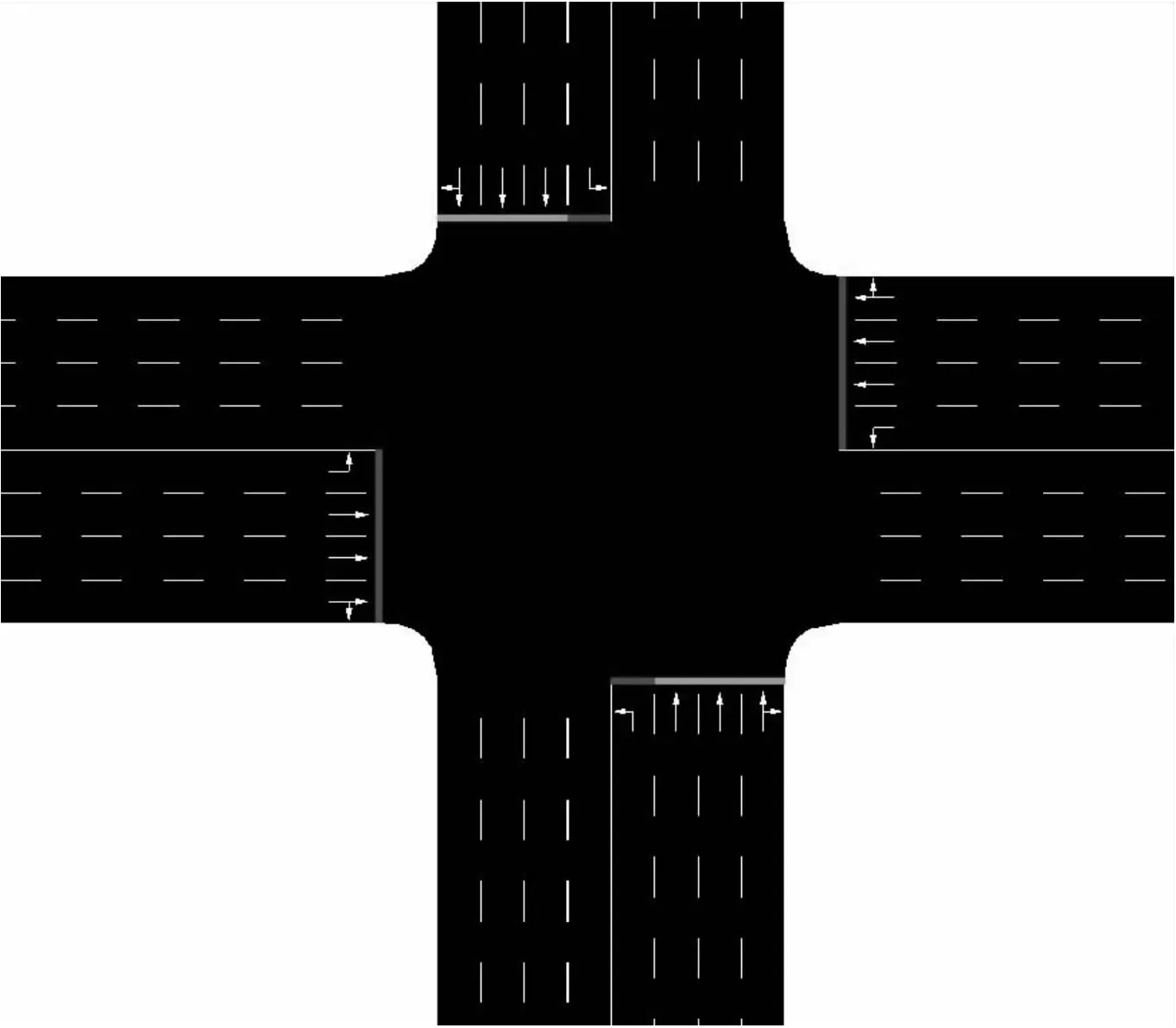

本實驗所使用的實驗環境是國際通用的交通模擬軟件SUMO[13](simulation of urban mobility),它是一種開源,微觀,多模態的交通模擬,具體到道路上每一輛車的運行路線都可以單獨規劃,允許模擬由單個車輛組成的給定交通需求。如何在給定的道路網絡中移動,示意圖如圖2所示。使用可視化編輯器NetEdit設計交叉口的靜態元素,環境由一個4方向的交叉口來表示,每個臂有4條駛入的車道和4條駛出的車道,每條臂長700米,車輛接近交叉口的時候,有三個方向的車道可以選擇,真實地還原了十字交叉口的車輛情況。通過這個軟件,用戶可以隨心所欲地設計道路基礎設施的每一個元素,包括道路特性、交叉口的車道連接等,實現交通流的微觀控制。環境中的交通燈系統由每個入口車道的停車線上的顏色表示,該顏色表示車道在精確時間步長上的交通燈狀態。環境中的每個紅綠燈都是按照以下規則工作的:

圖2 交通路網

(1)顏色的相位變化總是這樣的:紅綠黃紅。

(2)每個紅綠燈相位的持續時間是固定的。綠色時間始終為10秒,黃色時間始終為4秒。因此,紅色相位的持續時間被定義為自上次相位變化以來的時間量。

(3)對于每個時間步,至少有一個紅綠燈處于黃色或綠色相位。

(4)不可能所有的紅綠燈同時處于紅燈狀態。

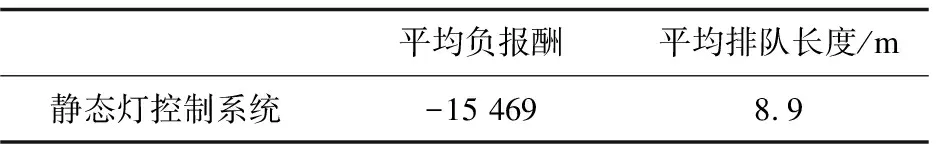

為了比較Agent的性能差異,引入了靜態交通系統[14]作為比較的基線。靜態交通系統具有相同的紅綠燈相位集,以相同的順序遍歷每個紅綠燈相位,并且具有固定的預定義持續時間。

在交通量特別少的情況下,交通燈固定循環不是一個好的策略,因為許多車輛都會等待大量的時間,并且會亮起空車道的相位燈。但是在交通量大的情況下,來自四面八方的車輛很多,因此靜態交通燈的政策可以說是最有效的。在南北向交通和東西向交通場景中,需要更多綠燈時間的車道但沒有優先次序,因為有一個固定的周期,這將使得排隊時間較長的車輛等待的時間超過必要時間,從而導致系統的性能平庸。靜態交通燈的評價結果如表1所示,此數據將作為對比Agent性能的重要指標之一。

表1 靜態交通燈評價結果

Traci(traffic control interface)是SUMO給出的連接到交通仿真的一個接口,使得人們可以獲取仿真中的參數還有實時控制仿真。Traci使用基于TCP的客戶端/服務器體系結構,將SUMO作為服務器,可以將車輛的特性、類型和外觀進行定義,還可以與運行中的模擬進行交互操作,在每個時間步長里檢索交叉口的實時狀態。模擬訓練過程如圖3所示,用戶通過SUMO-GUI工具觀看圖形化模擬過程,可用于檢查Agent的性能。

圖3 訓練過程

模型實驗使用了以下的超參數進行模擬訓練:

神經網絡:5層,每層包含400個神經元。

γ值:0.25。

獎勵函數:文獻獎勵。

采樣策略:通過這種方式,代理將嘗試更多地考慮其對環境演化的預測,從而選擇當前的操作,使接下來的幾個操作的預期回報最大化。這種方式有很長的前瞻性,并且每一步都試圖尋找最佳的策略來獲得最佳績效,但是缺乏一定的穩定性,具體表現通過下面的實驗結果體現。

文中對實驗的策略進行了改進,通過結合密集采樣策略和改進后的獎勵函數對Ag ent模型進行訓練,超參數如下:

神經網絡:5層,每層包含400個神經元。

γ值:0.75。

獎勵函數:改進后的獎勵函數。

采樣策略:密集采樣策略。通過強化該模型的實施和測試,從而提高γ值較高的時候Agent在訓練階段的性能,這種新的獎勵函數和抽樣策略的結合有利于解決Q值不穩定的問題,減少了未來最佳行為誤導的可能性。Agent的培訓階段包括在給定的環境狀態下找到最有價值的行動。盡管如此,在訓練的早期階段,并不知道哪些動作是最有價值的。為了克服這一問題,在培訓開始時,Agent應發現行動的后果,而不必擔心其性能表現。因此,在任務中發現最有價值的行為和行為的頻率應該增加。

經驗回放機制:

文中實驗所使用的經驗回放機制[15]是在訓練階段為提高Agent的性能和學習效率而采用的一種技術。它包括以稱為批處理的隨機樣本組的形式向Agent提交學習所需的信息,而不是立即提交Agent在模擬過程中收集的信息(通常稱為在線學習)。批處理來自一個直觀地稱為內存的數據結構,它存儲在訓練階段收集的每個樣本。樣本m定義為四種元素。m={st,at,rt+1,st+1},其中rt+1是在從狀態st采取動作之后得到的獎勵,它將環境演變成下一個狀態st+1。

訓練實例包括從記憶中收集一組樣本,并使用上述樣本進行神經網絡訓練。圖4顯示了與內存交互的表示。如前所述,經驗回放技術需要一個內存,其特征是內存大小和批處理大小。內存大小表示內存可以存儲多少個樣本,并設置為40 000個樣本,批大小定義為在一個訓練實例中從內存中檢索的樣本數。如果在某個時間步進記憶填充時,將移除最舊的樣本,以便為新樣本留出空間。因此,如果在每個時間步將一個樣本插入存儲器,則單個樣本在其消除之前仍存儲在存儲器中的片段數約為150,為訓練實例收集樣本的次數取決于批大小和訓練實例的頻率。

圖4 內存交互示意圖

使用經驗回放,培訓階段有兩個主要優勢:

(1)消除了觀察序列中的相關性。

(2)刷新Agent的體驗。

在這種環境中,兩個連續的狀態是自然相關的,因為環境st+1的狀態是狀態st的直接演化。狀態st+1中包含的大多數信息不是由于Agent的行為而派生的,但是,作為當前情況的自發轉變,因此已經實現了經驗回放,以避免在智能體的神經網絡中引入誤導性關聯。其次,在訓練過程中,神經網絡有可能會忘記在訓練的早期階段所獲得的關于某個情境的知識。通過使用經驗回放,代理偶爾會收到以前在舊狀態下所學內容的“刷新”。

3 實驗結果分析

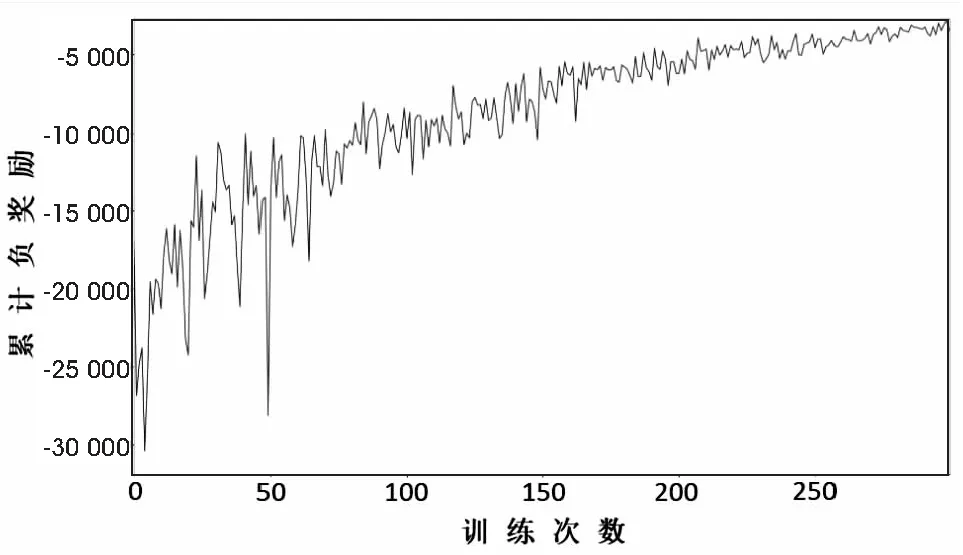

在此次的實驗中,將γ設置為較高的0.75,設置這么高的γ值意味著使Agent的預期累積回報能夠達到最大化,保持真實性的同時提高效率。因為未來幾次行動的預期回報會顯著影響在某一步選擇的行動的價值。這種方法與環境的性質卻恰恰相反:在一個確定的環境中,每次Agent從狀態st采取動作時,環境總是在特定的狀態st+1中演化。圖5是在訓練結束后獲得的累積獎勵值,從圖中可以很清楚地看到,快要結束的時候,Agent表現很不穩定,嚴重影響了代理的穩定性,從而導致性能的下降。因為在訓練快要結束的時候,基本上不可能采取隨機行動,大多數的還是選擇剝削行為,最終導致其中車輛的高等待排隊時間。

圖5 改進前的累計獎勵值

再來看看結合了密集采樣策略和新獎勵函數的這種方式,如圖6所示。在訓練快要結束的時候,累積獎勵值的穩定性有著顯著的提升,這是對于好的行動選擇策略的極好信號。通過這種新的結合方式能夠很好地解決Q值不穩定的問題,因為新獎勵函數增強了對錯誤行為選擇的懲罰,并且大大減少了對未來最佳行為誤導的可能性。

圖6 改進后的累計獎勵值

這種密集采樣策略實際上大大增加了Agent訓練的數據集,使得動作值更加穩定和漸進。圖5的采樣方法收集了大約250萬個樣本,用于1 600次的訓練。但是在這種密集采樣策略下,減少到只有300次迭代,但是采集的樣本總數高達6 000萬多個,由此可見數據集采樣呈現一個質的提升。

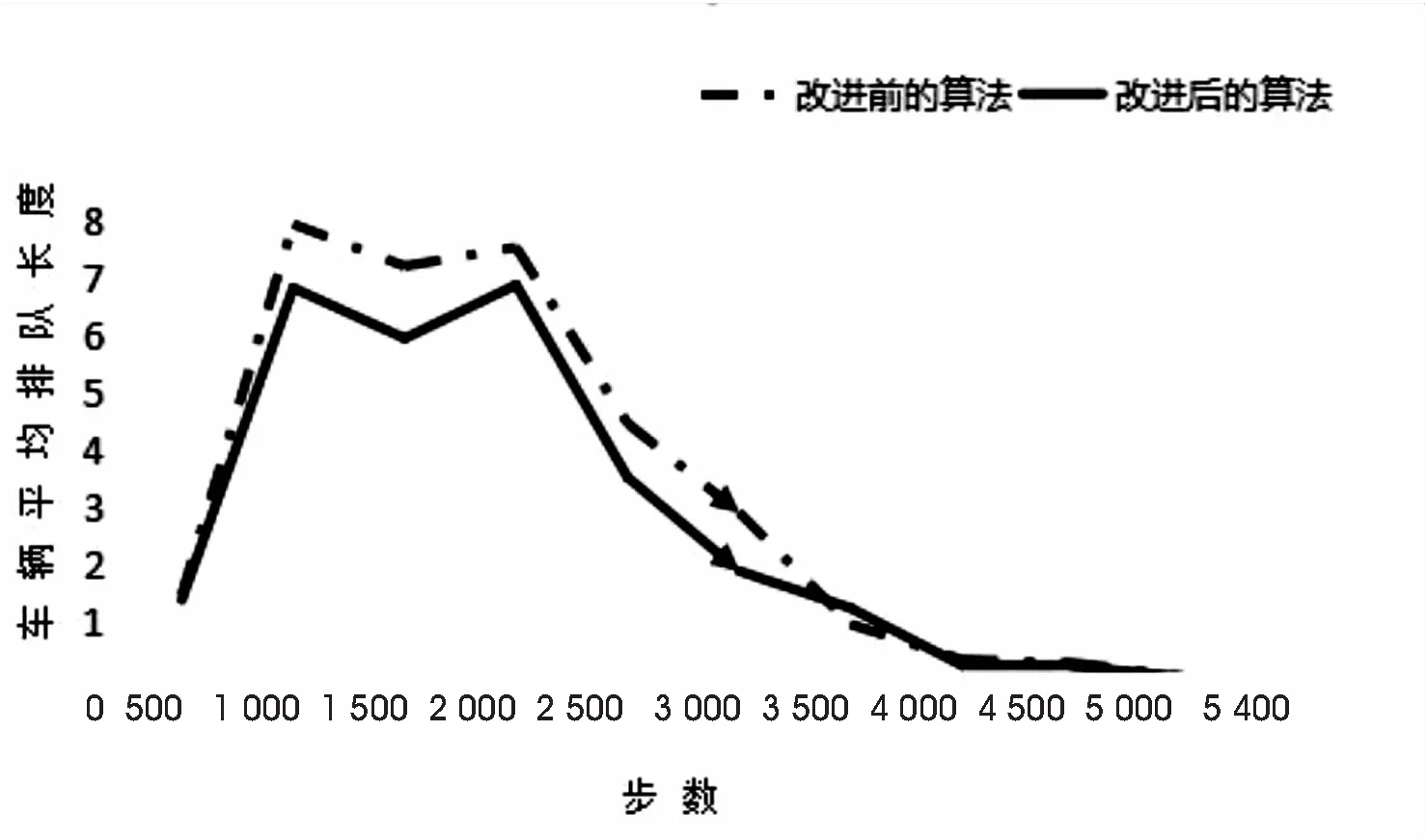

將訓練好的兩種網絡模型進行測試,從圖7可以明顯看出,改進后的平均排隊長度顯著提高,說明這種新的結合策略使Agent性能得到了顯著的提升,并提高了系統的穩定性。

圖7 算法測試結果對比

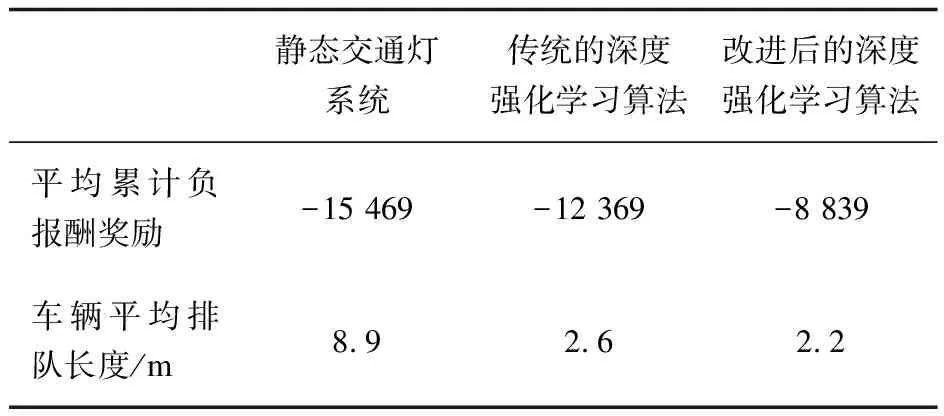

下面將具體的實驗數據列了一張表格進行對比,如表2所示。改進后的平均累積負獎勵值相比于靜態交通燈系統非常低,獎勵值提高了將近42%以上,車輛的平均排隊長度也大大地減少了。性能也優于使用傳統策略的深度強化學習算法,總體效率提升了29%左右。

表2 三種算法測試結果反饋

實驗結果表明,文中所提出的新獎勵函數和密集采樣策略的結合對解決交通擁堵問題起到了很好的改善作用,說明這種方法是可取的。

4 結束語

交通智能化、數據化、復雜化已經是現在社會的一種潮流和趨勢。文中將深度強化學習應用到交通燈信號配時當中,顯著地減少了交叉口的擁堵狀況,大大地節約了能源的消耗,在效率和性能的提升上起到了很大的作用。在現實世界中,駕駛員還可以利用本系統提供的策略模式,在交叉口進行不同的駕駛行為,最終達到提高交叉口效率的目的。文中提出一種采用密集采樣策略和改進后的新獎勵函數相結合的新控制方法,在一定程度上提高了控制的性能。

在未來的工作中,筆者將對更加復雜的路口進行研究,為交通系統開辟更多高效率的算法,應該更多地從單個車輛的角度分析和優化Agent策略的公平性,而不是僅僅通過最小化延誤或最大化吞吐量來提高交叉口的整體性能。在過去的幾年中,交通信號控制的強化學習技術已經明顯成熟,特別是隨著深度學習的普及。對于實際設備,強化學習交通信號控制器的假設部署應接受在線和離線數據方面的培訓,以便在學習標準交通效率政策后能夠適應特定場景。由于該文只是仿真實驗,未來還將應用到實際的場景中,使交通行業迎來更加智能化的時代。