基于卷積神經網絡模型的木材宏、微觀辨識方法*

趙子宇 楊霄霞 郭 慧 葛浙東 周玉成,

(1.山東建筑大學信息與電氣工程學院 濟南 250101;2.中國林業科學研究院木材工業研究所 北京 100091)

木材辨識在木結構古建筑、海關、進出口檢疫檢驗等領域均有著廣泛應用,對現代木材工業和木材貿易起到至關重要、保駕護航的作用。傳統的木材辨識主要基于木材的微觀解剖特征(顯微結構參數)和宏觀特征(顏色、氣味、紋理等)判斷材種的科、屬或種,基于宏觀特征辨識木材在生產實踐上應用價值較大,但準確性較差;基于微觀解剖特征辨識木材準確性較高,但在生產現場不太適用。近年來,機器視覺技術逐步應用到木材辨識中,如朱佳等(2014)提出一種基于Graph Cuts的圖像分割方法對木材SEM進行特征提取,通過木材輪廓、細胞等特征辨識木材種類;Barmpoutis等(2018)將木材橫切面圖像的顏色、紋理等特征轉化為多維聯合直方圖形式,通過支持向量機分類器辨識木材。但以上方法均存在木材辨識訓練參數多、訓練耗時長、分類正確率低等問題,需探尋更快、更準確的方法實現最佳辨識效果(項宇杰等,2019;劉子豪等,2013)。

卷積神經網絡研究始于20世紀80年代(Lecunetal.,1989),是一類包含卷積計算且具有深度結構的前饋神經網絡,是深度學習的代表算法之一(Krizhevskyetal.,2012)。卷積神經網絡具有表征學習能力,能夠自動提取圖像特征,模型可直接采用原始圖像作為輸入(Chenetal.,2017;Kiranyazetal.,2016)。Yang等(2019)以5種針葉材表面紋理圖像作為卷積神經網絡模型的輸入,通過K倍交叉驗證法對模型性能進行衡量,此方法運算耗時較長。陳龍現等(2018)采用自行開發的計算機斷層掃描系統掃描木材內部缺陷,并使用LeNet-5模型對木材內部缺陷圖像進行辨識,但木材種類相對單一,辨識效果不佳。劉英等(2019)將卷積神經網絡應用到木材缺陷檢測中,采用非下采樣剪切波變換預處理和線性迭代聚類方法對木材缺陷進行分類,但辨識準確率較低。He等(2019)采用一種混合的全卷積神經網絡(Mix-FCN)定位木材缺陷位置,并從木材表面圖像中自動分類缺陷類型。但現有的卷積神經網絡模型需要大量訓練樣本,耗時長,木材辨識僅對較少材種進行研究,并未能運用到實際應用中(李楠,2018)。

傳統的微觀解剖特征辨識方法需對木材樣本橫、徑、弦三切面進行解剖,染色后用高倍顯微鏡獲得圖像,耗時7~15天,這對海關、進出口檢疫檢驗等法定部門在盡可能短的時間內鑒別木材材種的要求不相符。鑒于此,本研究提出一種基于卷積神經網絡模型——PWoodIDNet模型的木材宏、微觀辨識方法,該模型以木材樣本橫切面圖像作為輸入,通過分解卷積核方式減少運算參數,并通過GPU并行算法對模型進行分類更新,從采集樣本到鑒定出結果僅需1 h左右,可為海關、進出口檢疫檢驗、家具企業等法定部門和企業提供先進的辨識方法和儀器,從而推動我國木材進出口檢疫檢驗行業和木材加工制造企業的科技進步。

1 PWoodIDNet模型構建

PWoodIDNet模型采用雙GPU模式,模型卷積層通過分解卷積核方式將多個小的卷積核堆疊,即改進后的Inception模塊,減少運算參數,步長設置為1,使輸出特征圖尺寸不變;模型池化層是在卷積層之后分別設置4個最大池化層和1個平均池化層,從而達到特征選擇和降維的目的;模型全連接層后設置Dropout方法,抑制過擬合現象。

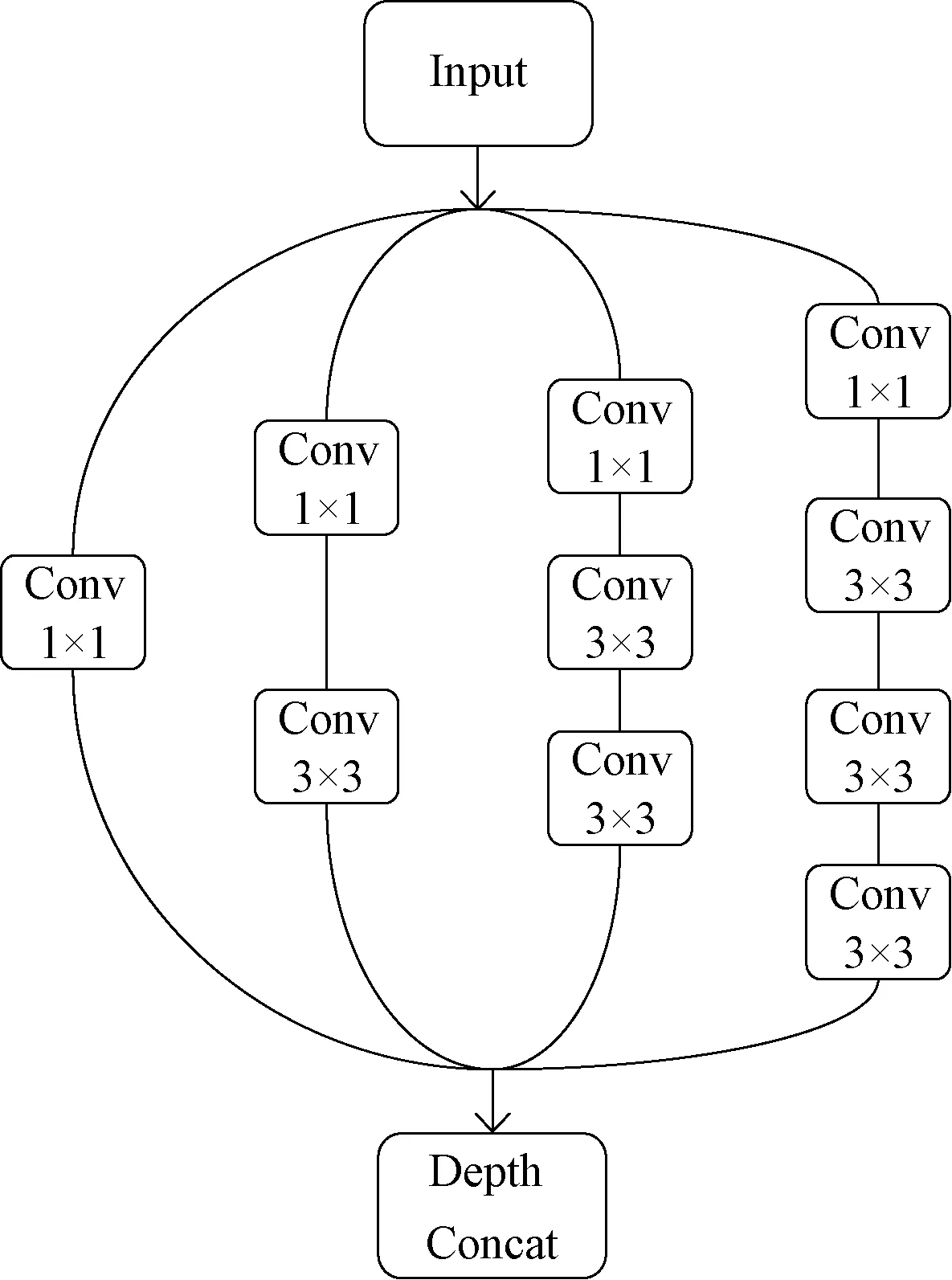

圖1中紅色區域表示采用改進后的Inception模塊對圖像進行卷積。現行Inception模塊通過1×1、3×3、5×5的卷積核與3×3的最大池化層連接在一起,并在每個卷積層和池化層前添加1×1的卷積核進行降維。本研究對現行Inception模塊進行改進,將5×5的卷積核、3×3的最大池化層替換為2組3×3的卷積核、3組3×3的卷積核,增加網絡層數,減少運算參數,加深網絡寬度,以提高網絡對尺度的適應性。最后將4個分支進行特征融合,得到輸出特征圖,使下一層可從不同尺度上提取到更多的特征。構建方式如圖2所示。

圖2 改進的Inception模塊Fig.2 Improved Inception module

圖2中上一層的輸出特征圖(Input)輸入到改進后的Inception模塊,并行進入4個分支進行特征提取。第一分支由1×1的卷積核組成,第二分支由1×1的卷積核與1組3×3的卷積核組成,第三分支由1×1的卷積核與2組3×3的卷積核組成,第四分支由1×1的卷積核與3組3×3的卷積核組成,最后4個分支輸出到Depth Concat層進行特征融合。

模型構建過程如下:

第一步,構建輸入圖像卷積層。設輸入圖像尺寸為Z(i,j,k)_In,0≤i≤224、0≤j≤224、k=3。構建32個5×5的卷積核,其中GPU1為16個5×5,GPU2為16個5×5。則GPU1的f=5,令步長為s0=2,擴充值為p′,則有:

(1)

Ll1=(Ll-1+2p′-f)/s0+1。

(1.1)

由式(1.1)得,填充值p′=3。

GPU2的f=5,令步長為s0=2,擴充值為p′,則有:

(2)

Ll2=(Ll-1+2p′-f)/s0+1。

(2.1)

由式(2.1)得,填充值p′=3。

第二步,構建最大池化層(32)。設上層GPU1和GPU2輸出圖像尺寸為A1(i1,j1)和A2(i2,j2),其中i1、j1、i2、j2均為113,即上層GPU1和GPU2輸出圖像均為113×113×16。構建32個3×3矩陣,GPU1為16個3×3矩陣,GPU2為16個3×3矩陣。則GPU1的f=3,令步長為s0=2,擴充值為p′,預指定參數p→∞,則最大池化模型為:

(i1,j1)∈{0,1,…,Ll+1}。

(3)

Ll+1=(Ll+2p′-f)/s0+1。

(3.1)

由式(3.1)得,填充值p′=0。

GPU2的f=3,令步長為s0=2,擴充值為p′,預指定參數p→∞,則最大池化模型為:

(4)

(4.1)

由式(4.1)得,填充值p′=0。

第三步,構建卷積層(64)。設上層GPU1和GPU2輸出圖像尺寸為Z1(i1,j1)和Z2(i2,j2),其中i1、j1、i2、j2均為56,即上層GPU1和GPU2輸出圖像均為56×56×16。

構建改進的Inception模塊。

①第一分支:構建16個1×1的卷積核,GPU1為8個1×1,GPU2為8個1×1。

②第二分支:

a.構建6個1×1的卷積核,GPU1為3個1×1,GPU2為3個1×1。

b.構建8個3×3的卷積核,GPU1為4個3×3,GPU2為4個3×3。

③第三分支:

a.構建6個1×1的卷積核,GPU1為3個1×1,GPU2為3個1×1。

b.構建16個3×3的卷積核,GPU1為8個3×3,GPU2為8個3×3。

④第四分支:

a.構建6個1×1的卷積核,GPU1為3個1×1,GPU2為3個1×1。

b.構建24個3×3的卷積核,GPU1為12個3×3,GPU2為12個3×3。

⑤將GPU1和GPU2在第一分支中輸出的8個56×56的矩陣、第二分支中輸出的4個56×56的矩陣、第三分支中輸出的8個56×56的矩陣與第四分支中輸出的12個56×56的矩陣相加,得到32個56×56的矩陣(32=8+4+8+12),即GPU1和GPU2中改進的Inception模塊輸出特征圖尺寸均為56×56。

第四步,構建最大池化層(64)。設上層GPU1和GPU2輸出圖像尺寸為A1(i1,j1)和A2(i2,j2),其中i1、j1、i2、j2均為56,即上層GPU1和GPU2輸出圖像均為56×56×32。構建64個3×3矩陣,GPU1為32個3×3矩陣,GPU2為32個3×3矩陣。

第五步,構建卷積層(128)。設上層GPU1和GPU2輸出圖像尺寸為Z1(i1,j1)和Z2(i2,j2),其中i1、j1、i2、j2均為28,即上層GPU1和GPU2輸出圖像均為28×28×32。

構建Inception模塊,同第三步計算步驟,將GPU1和GPU2在第一分支中輸出的16個28×28的矩陣、第二分支中輸出的8個28×28的矩陣、第三分支中輸出的16個28×28的矩陣與第四分支中輸出的24個28×28的矩陣相加,得到64個28×28的矩陣(64=16+8+16+24),即GPU1和GPU2中Inception模塊輸出特征圖尺寸均為28×28。

第六步,構建最大池化層(128)。設上層GPU1和GPU2輸出圖像尺寸為A1(i1,j1)與A2(i2,j2),其中i1、j1、i2、j2均為28,即上層GPU1和GPU2輸出圖像均為28×28×64。構建128個3×3矩陣,GPU1為64個3×3矩陣,GPU2為64個3×3矩陣。

第七步,構建卷積層(256)。設上層GPU1和GPU2輸出圖像尺寸為Z1(i1,j1)與Z2(i2,j2),其中i1、j1、i2、j2均為14,即上層GPU1和GPU2輸出圖像均為14×14×64。

構建Inception模塊,同第三步計算步驟,將GPU1和GPU2在第一分支中輸出的32個14×14的矩陣、第二分支中輸出的16個14×14的矩陣、第三分支中輸出的32個14×14的矩陣與第四分支中輸出的48個14×14的矩陣相加,得到128個14×14的矩陣(128=32+16+32+48),即GPU1和GPU2中Inception模塊輸出特征圖尺寸均為14×14。

第八步,構建最大池化層(256)。設上層GPU1和GPU2輸出圖像尺寸為A1(i1,j1)和A2(i2,j2),其中i1、j1、i2、j2均為14,即上層GPU1和GPU2輸出圖像均為14×14×128。構建256個3×3矩陣,GPU1為128個3×3矩陣,GPU2為128個3×3矩陣。

第九步,構建卷積層(512)。設上層GPU1和GPU2輸出圖像尺寸為Z1(i1,j1)和Z2(i2,j2),其中i1、j1、i2、j2均為7,即上層GPU1和GPU2輸出圖像均為7×7×128。

構建Inception模塊,同第三步計算步驟,將GPU1和GPU2在第一分支中輸出的64個7×7的矩陣、第二分支中輸出的32個7×7的矩陣、第三分支中輸出的64個7×7的矩陣與第四分支中輸出的96個7×7的矩陣相加,得到256個7×7的矩陣(256=64+32+64+96),即GPU1和GPU2中Inception模塊輸出特征圖尺寸均為7×7。

第十步,構建平均池化層。設上層GPU1和GPU2輸出圖像尺寸為A1(i1,j1)和A2(i2,j2),其中i1、j1、i2、j2均為7,即上層GPU1和GPU2輸出圖像均為7×7×256。構建512個7×7矩陣,GPU1為256個7×7矩陣,GPU2為256個7×7矩陣。

第十一步,構建全連接層。設置1個全連接層,全連接層后加入Dropout方法,抑制過擬合。構建分類層(輸出),采用Softmax分類器進行分類,分類數為16。

模型在每個卷積層和全連接層后均設置ReLU激活函數,實現模型更好地提取圖像相關特征,擬合訓練數據,且計算簡單。

2 材料與方法

2.1 試驗材料

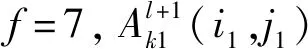

試驗用16種木材樣本取自山東建筑大學木材標本館,分別為東非黑黃檀(Dalbergiamelanoxylon)、尼泊爾紫檀(Glutasp.)、紅櫟(Quercussp.)、樟子松(Pinussylvestrisvar.mongolica)、輻射松(Pinusradiata)、西非蘇木(Danielliasp.)、非洲檀香(Spirostachysafricana)、白梧桐(Triplochitonscleroxylon)、輕木(Ochromasp.)、南美紅雞翅(Andirasp.)、普拉藤黃(Platoniainsignis)、菲律賓烏木(Diospyrossp.)、軍刀豆(Machaeriumsp.)、黃楊木(Buxussp.)、楓木(Acersp.)和納托山欖(Palaquiumsp.)。采用SkyScan1272型顯微CT和ZW-H3800工業相機,以木材橫切面為研究對象,分別獲取木材微觀和宏觀結構圖像。表1所示為不同樹種宏、微觀部分圖像效果。

表1 不同樹種宏、微觀部分圖像效果Tab.1 Partial rendering of macro-and micro-images of different tree species

木材微觀試驗樣本直徑約2 mm,高約8 mm,分辨率0.95 μm,樣本每旋轉0.1°采集1次數據,每次掃描獲得數據3 600行1 280列,直至完成對樣本180°掃描。利用NRecon軟件重構截面圖像,消除環形偽影和射線硬化等不良影響,進行平滑和其他顯示設置,截取圖像大小為2 280×1 760。

木材宏觀試驗樣本尺寸為50 mm×50 mm×20 mm。不同光照條件下獲取木材樣本紋理特征,并進行初步降噪與飽和度調整,圖像大小為1 920×1 080。

2.2 樣本數據處理

首先,選擇16種木材樣本,每種樣本獲取50張高分辨率顯微CT圖像和工業相機圖像,共1 600幅;然后,截取具有木射線、薄壁組織、軸向管胞、紋孔等特征的目標區域,擴充至2 400幅,在樣本表面紋理圖像中隨機選取波狀紋、皺狀紋、斑點狀、多孔狀等特征區域,擴充至2 400幅,共4 800幅,截取樣本圖像大小為224×224;通過水平翻轉、垂直翻轉、鏡像、亮度變換等圖像增強算法二次擴充數據集,最終宏、微觀圖像集擴充至19 200幅。截取后的圖像通過手動篩選,避免樣本選取的單一性和誤選性,提升數據集的多樣性。其中,70%圖像用于木材辨識的訓練集,30%圖像用于驗證集。

2.3 PWoodIDNet模型訓練

2.3.1 模型訓練參數 模型訓練次數設為4 200次,學習率設為0.000 1,訓練批次樣本數設為16,權重參數和偏置參數初值用均值μ=0、標準偏差σ=0.01的截斷正態分布隨機生成,模型全連接層輸出為16。

2.3.2 并行加速 為加快模型訓練速度和搜索匹配速度,系統硬件采用AMD Ryzen Threadripper 2920X CPU @3.5GHz,內存為128 GB,GPU顯卡采用NIVIDIA GeForce RTX 1080Ti,利用GPU運算庫進行并行優化,提高訓練模型精度和效率(Krizhevskyetal.,2012)。

3 結果與分析

3.1 模型優化

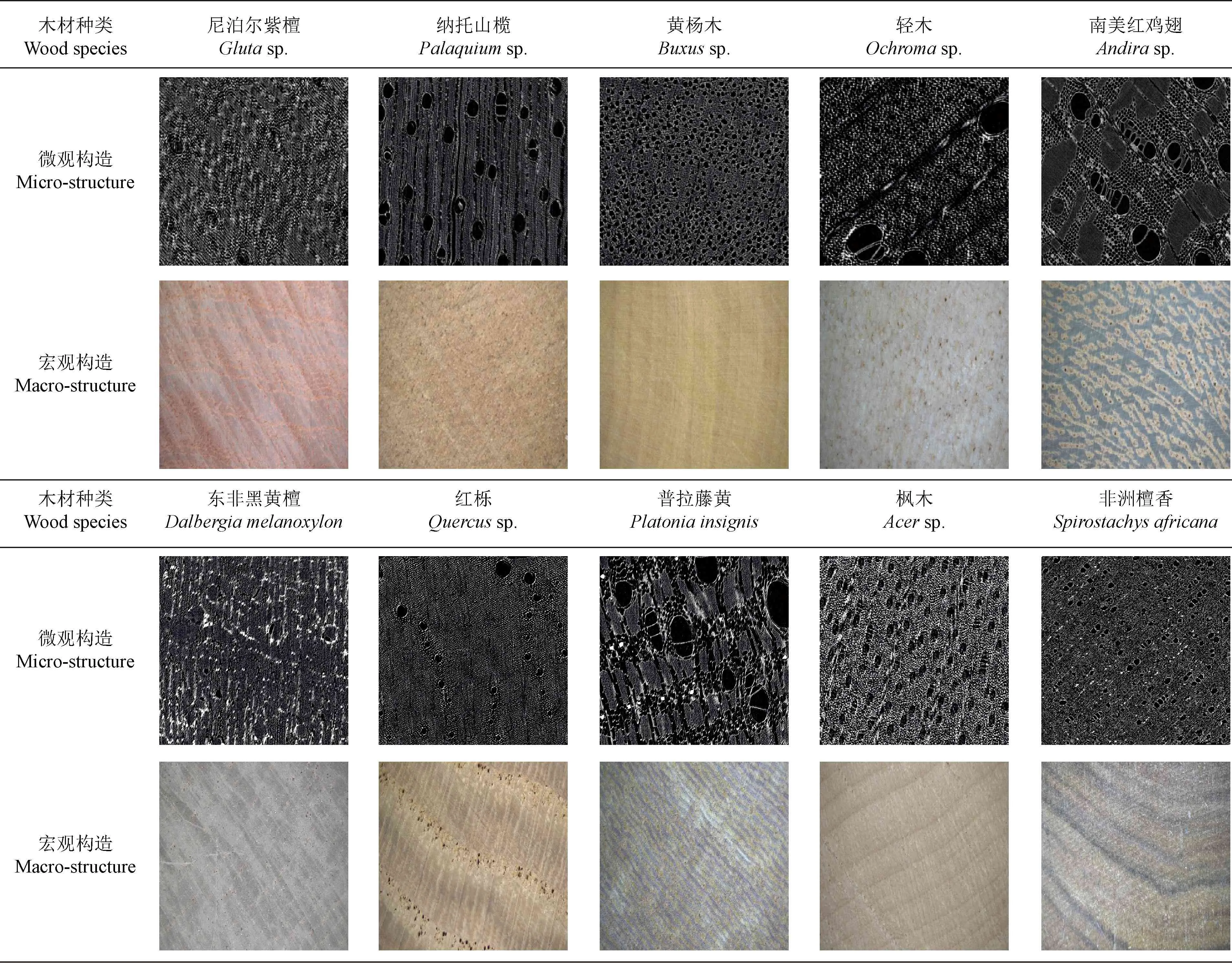

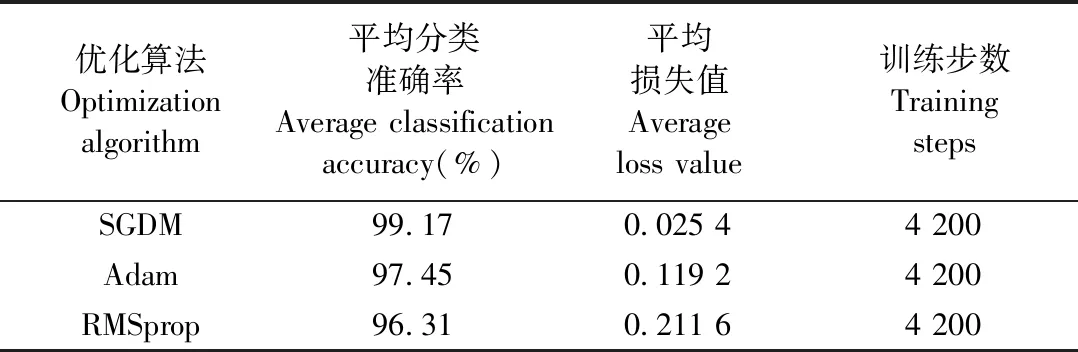

在卷積神經網絡中,優化算法選擇是模型設計的關鍵。當前,優化算法種類繁多,其中以SGDM(Rumelhartetal.,1986;Traorebetal.,2018;Dimauroetal.,2019)、RMSprop(Hintonetal.,2012)、Adam(Kingmaetal.,2014)最為常見。本研究選用木材微觀數據集,分別對3種常見優化算法進行比較,選出最適合PWoodIDNet模型的優化算法。

采用3種優化算法對模型進行訓練,如圖3所示。SGDM優化算法模型分類準確率曲線最平緩,當迭代次數為300次時,模型已接近收斂狀態;同時,SGDM優化算法能夠抑制模型震蕩,并加速學習。RMSprop優化算法模型分類準確率曲線持續出現振蕩現象,振蕩頻率范圍最大位置準確率最低達30%(0.3)。Adam優化算法模型分類準確率曲線較RMSprop平緩,網絡結構模型的訓練分類精度波動較大,訓練過程未達到收斂狀態。

圖3 不同優化算法分類準確率對比Fig.3 Comparison of classification accuracy of different optimization algorithms

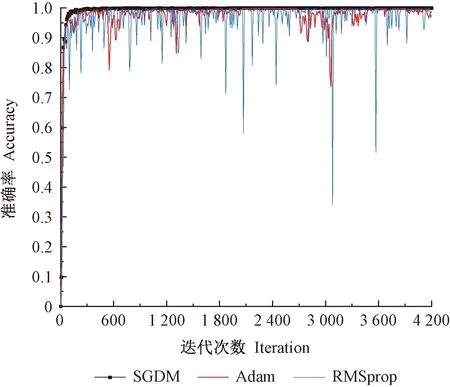

不同優化算法損失值對比如圖4所示。訓練初期,SGDM、Adam優化算法模型的初損失值較大,但收斂速度較快;RMSprop優化算法模型持續出現振蕩現象,并一直持續到訓練結束。訓練中期,SGDM優化算法模型持續處于收斂狀態,損失值接近0,高于其他算法的收斂速度。當迭代次數達3 600次后,Adam優化算法模型振蕩現象減輕,并逐漸趨于收斂狀態。

圖4 不同優化算法損失值對比Fig.4 Comparison of loss value of different optimization algorithms

不同優化算法的分類結果如表2所示。在迭代次數相同的情況下,SGDM優化算法模型對木材顯微CT圖像的辨識效果最佳,測試集的平均分類準確率為99.17%,相比Adam優化算法提高1.72%,相比RMSprop優化算法提高2.86%。

表2 不同優化算法的分類結果Tab.2 Classification results of different optimization algorithms

綜上所述,采用SGDM優化算法可有效抑制模型振蕩,收斂更穩定,能夠提高PWoodIDNet模型對木材的辨識效果。

3.2 PWoodIDNet模型與現行模型準確率比較

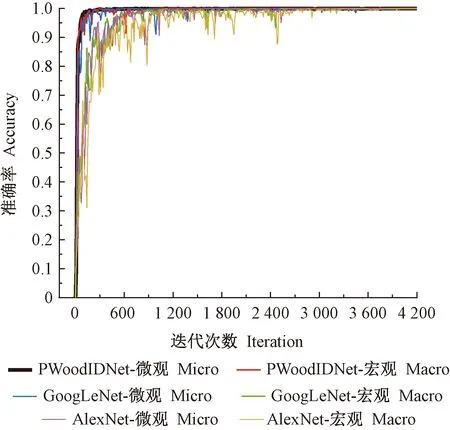

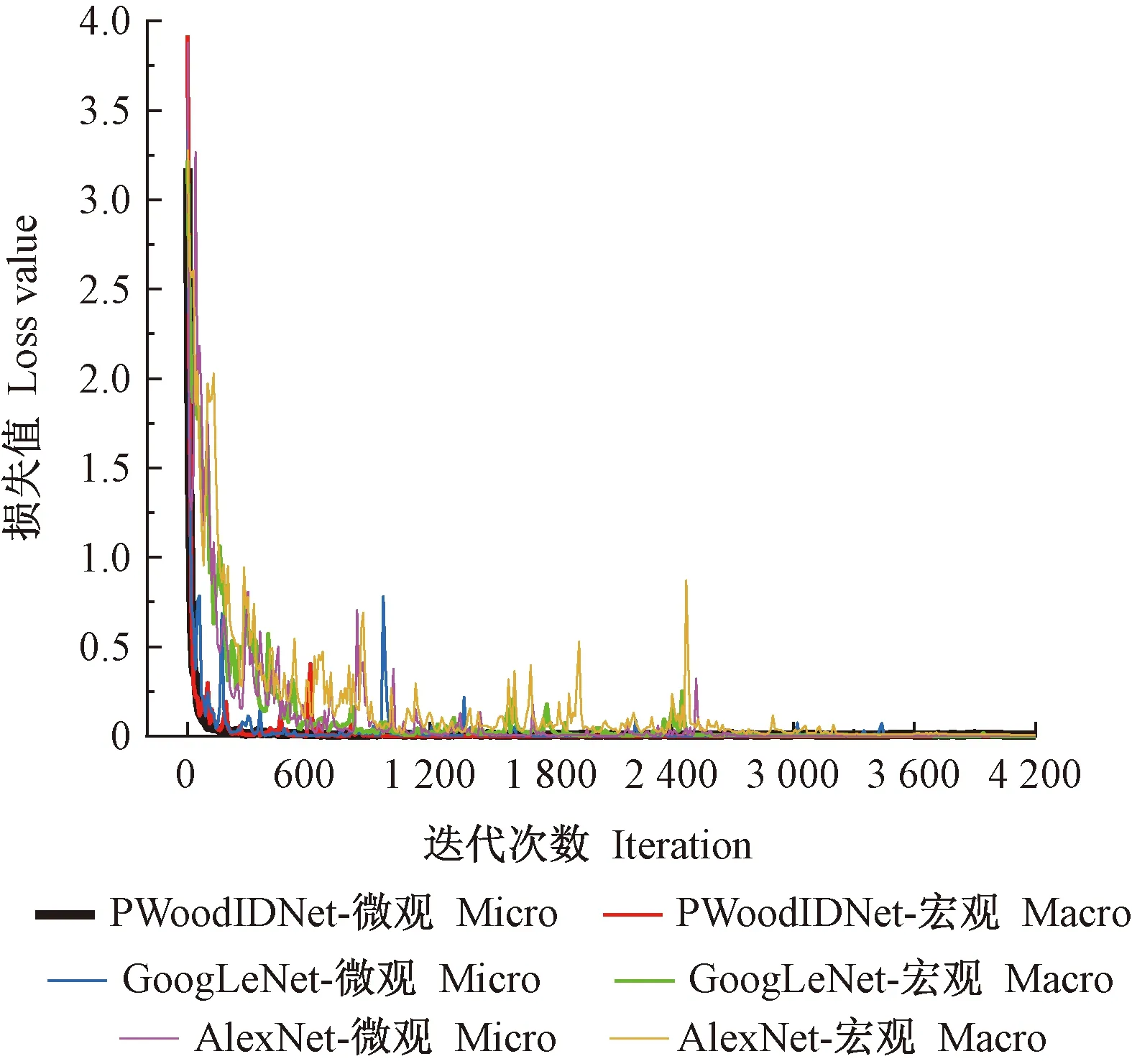

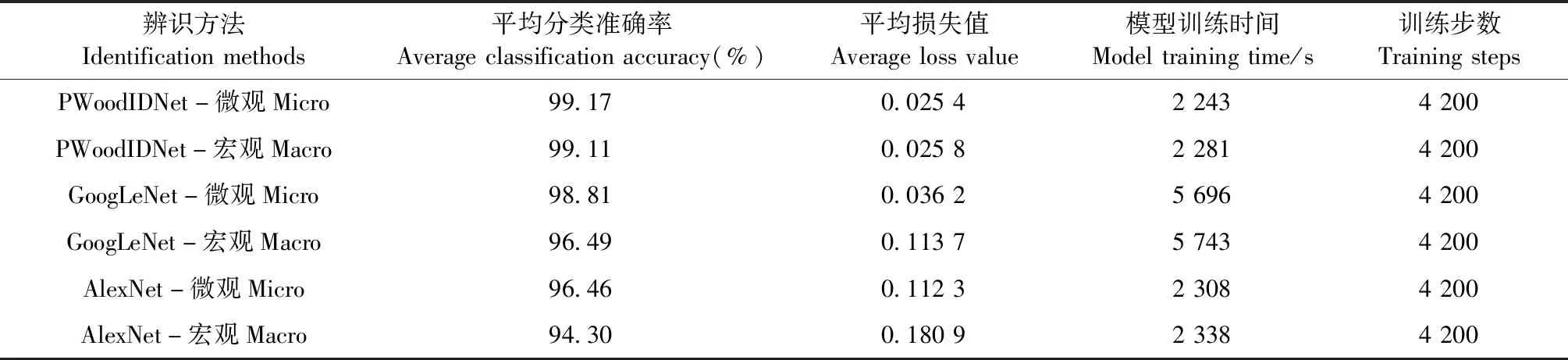

對國內外現行經典的AlexNet模型、GoogLeNet模型(Szegedyetal.,2015)與PWoodIDNet模型進行分類準確率和損失值比較,數據集分別采用木材微觀和宏觀數據集。

3種模型的分類準確率如圖5所示。訓練初期,PWoodIDNet模型分類準確率隨迭代次數增加逐漸趨于收斂狀態,當迭代次數為300次時,分類準確率達99%,并一直持續到迭代完成,辨識效果優于其他模型,分類準確率最高可達99.98%;GoogLeNet模型分類準確率隨迭代次數增加持續增大,但分類準確率曲線出現振蕩現象,未達到收斂狀態;AlexNet模型分類準確率曲線振蕩現象比較嚴重,分類準確率較低。隨迭代次數增加,GoogLeNet模型、AlexNet模型分類準確率曲線僅出現小范圍振蕩,未出現劇烈波動,逐漸趨于收斂狀態。

圖5 3種模型的分類準確率Fig.5 Classification accuracy of three models

3種模型的損失值如圖6所示。PWoodIDNet模型損失值隨迭代次數增加逐漸降低,當迭代次數為200次時出現拐點,損失值逐漸趨于收斂狀態,直至迭代結束。隨PWoodIDNet模型網絡層數增加,運算參數減少,加速損失值收斂速度。GoogLeNet模型迭代600次左右時曲線出現輕微振蕩現象,損失值整體呈下降趨勢,隨迭代次數增加逐漸趨于收斂狀態。AlexNet模型損失值整體呈下降趨勢,當迭代次數為1 000次時,曲線仍不斷出現振蕩現象,收斂速度較慢,迭代次數達3 000次后,損失值變化緩慢,逐漸接近0。

圖6 3種模型的損失值Fig.6 Loss value of three models

采用卷積神經網絡模型實現木材宏、微觀圖像的辨識,結果如表3所示。同一模型,微觀圖像平均分類準確率均高于宏觀圖像。PWoodIDNet模型分類準確率、運算速度明顯高于其他2種模型,相比現行GoogLeNet模型,準確率提高1.49%,速度提高59.69%;相比現行AlexNet模型,準確率提高3.76%,速度提高2.63%。PWoodIDNet通過優化模型和分解卷積核方式,提高了分類準確率,驗證了模型的有效性。

表3 木材辨識模型結果Tab.3 Results of wood identification model

3.3 PWoodIDNet模型復雜度與時間消耗分析

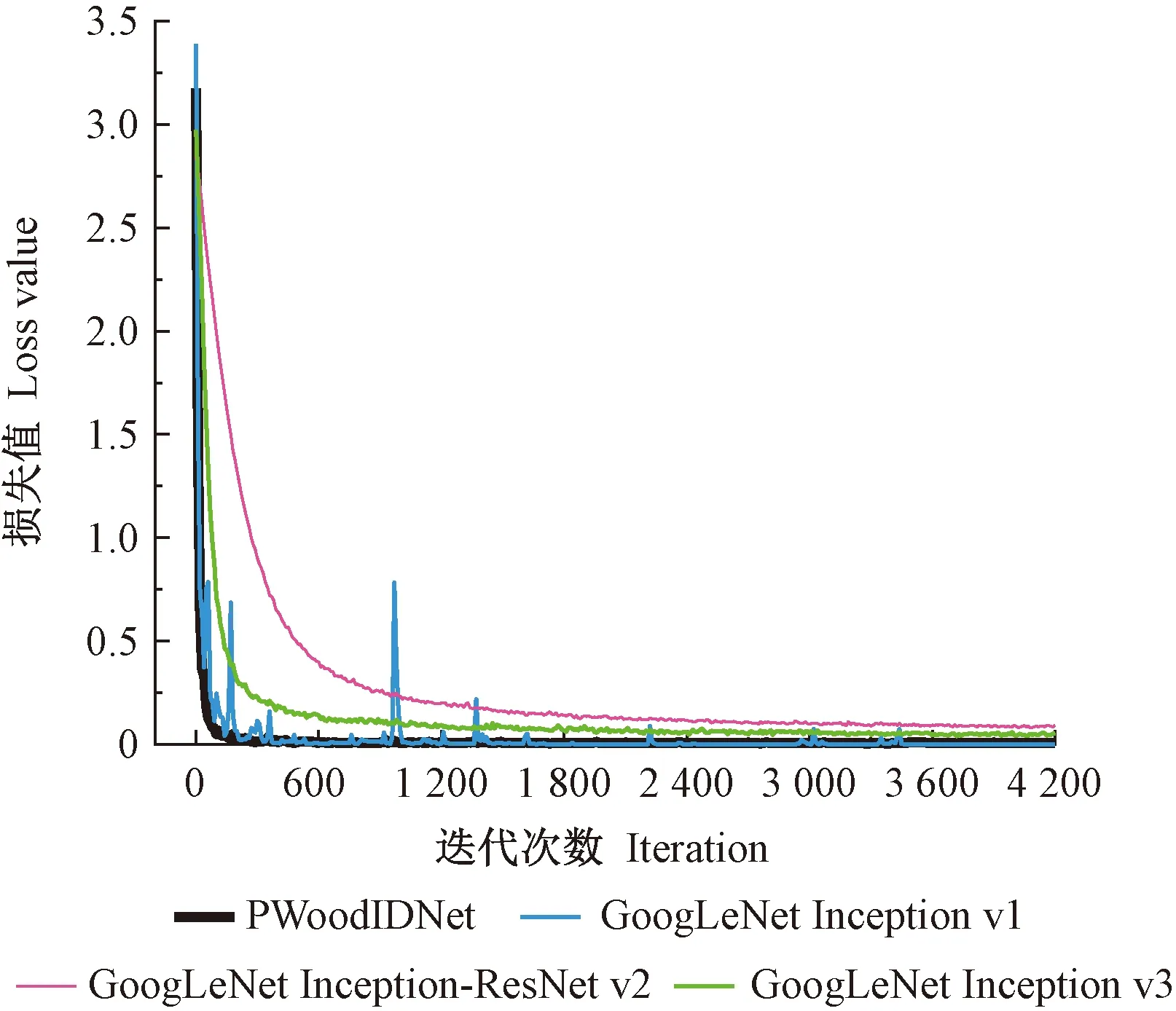

PWoodIDNet模型通過分解卷積核方式將1×1與3×3的卷積核堆疊,減少運算參數,即改進后的Inception模塊。采用小尺寸的卷積核進行卷積,通過4組改進后的Inception模塊,網絡層數僅72層,模型整體復雜度降低,訓練和預測時間減少。木材微觀數據集下PWoodIDNet模型與現行GoogLeNet模型的損失值如圖7所示,雖然PWoodIDNet模型的初損失值較高,但收斂速度最快,模型的泛化能力強。如表4所示,PWoodIDNet模型網絡層數和訓練耗時最少,體現出模型復雜度較低的特點,其他3種GoogLeNet模型的網絡層數較多且復雜,收斂速度較慢。

圖7 微觀數據集下PWoodIDNet模型與GoogLeNet模型的損失值Fig.7 Loss value of PWoodIDNet and GoogLeNet models under micro data sets

表4 不同模型的復雜度與時間對比Tab.4 Complexity and time comparison of different models

4 討論

4.1 高分辨率顯微CT對木材辨識的影響

木材辨識技術包括宏觀辨識和微觀辨識2種方法,通常采用無損檢測設備,既不破壞木材內部結構又省去切片制作過程,提高了辨識效率。高分辨率顯微CT具有穿透力強、檢測速度快、非破壞性等特點,常用于木材缺陷檢測、密度測定等方面(彭冠云等,2009;費本華等,2007)。本研究將高分辨率顯微CT應用于木材微觀構造辨識,薄壁組織、管胞、樹膠道、導管、木射線等特征清晰可見,很大程度上提高了木材辨識的質量。應進一步豐富木材圖像數據集,建立屬于自己的Web網站服務器,實現高分辨率顯微CT檢測的木材微觀圖像云共享。

4.2 PWoodIDNet模型對木材辨識的影響

本研究通過優化模型和卷積核尺寸,實現快速、準確辨識木材,克服了傳統手動特征提取、分類效果不佳、訓練方法復雜、訓練參數過多、耗時過長等問題。采用高分辨率顯微CT獲取的木材微觀圖像,提高了樣本質量,應用PWoodIDNet模型,提升了模型分類準確率,加快了辨識速度。但本研究只對16種木材樣本進行研究,木材種類相對單一,應增加木材種類,并設計開發出更適合多樹種識別的網絡模型。

5 結論

PWoodIDNet模型突破現有辨識方法木材辨識種類范圍窄、準確率低和辨識速度慢的難點,能夠有效辨識木材,分類準確率可達99%,是一種高效、無損、準確的木材辨識分類方法,可為海關、進出口檢疫檢驗、家具企業等法定部門和企業提供先進的辨識方法和儀器,推動我國木材進出口檢疫檢驗行業和木材加工制造企業的科技進步。