基于風格解耦和自適應層實例歸一化的圖像翻譯方法

蔡興泉,魏岳超,孫海燕

(北方工業大學信息學院,北京 100144)

圖像翻譯指的是在保持圖像的某些特征的基礎上,將圖像從一個圖像域遷移至另一個圖像域的圖像處理任務。通過輸入來自兩個不同圖像域的訓練集訓練模型,使模型可以根據源域中的圖像生成目標域中的對偶圖像,同時約束生成的圖像和目標域中的圖像保持盡量一致的分布。圖像風格遷移、圖像超分辨率[1]、圖像修復[2]等多種圖像處理任務均可以視作圖像翻譯的子問題。圖像翻譯的概念最早由Hertzmann等[3]提出,Hertzmann等通過類比一對通過某種轉換前后的圖像對,將此種轉換模式應用于其他圖像上,實現了類似風格遷移的效果,但受限于計算難度大,這類方法并沒有進一步地發展。

隨著卷積神經網絡的發展,Gatys等[4]通過卷積神經網絡提取圖像的內容特征,計算提取特征圖的Gram矩陣以度量圖像的紋理,然后由網絡輸出特征融合后的圖像,實現了將輸入的風格圖像的風格遷移至內容圖像上的效果。Johnson等[5]采用類似全卷積網絡的結構進行圖像風格遷移,使用感知損失來度量圖像間的差異,提升了圖像風格遷移的速度。Huang等[6]使用自適應實例歸一化(adaptive instance normalization, AdaIN),以對齊內容圖像與風格圖像的均值和方差,從而實現任意風格的風格遷移。這類基于卷積神經網絡或是基于全卷積網絡的圖像風格遷移方法需要使用預訓練的特征提取網絡對圖像進行特征提取,對風格圖像的材質和紋理較為敏感,因此更適于處理藝術圖像的風格遷移,而不適用于更為復雜的圖像翻譯任務中。

近年來,Goodfellow等[7]提出的生成對抗網絡(generative adversarial networks, GAN),已經廣泛地應用于圖像處理領域。在訓練時,生成對抗網絡通過使生成器和判別器進行零和博弈,判別器促使生成器生成和真實樣本相近的偽樣本,間接地達到生成逼真圖像的目的。但是,生成器接收的輸入是隨機噪聲,因此生成對抗網絡的輸出結果是不可控的。為了克服這個問題,Mirza等[8]提出了條件生成對抗網絡(conditional generative adversarial networks, CGAN)。CGAN的生成器和判別器加入了條件信息,使CGAN具有根據輸入的條件信息控制輸出結果的能力。

Isola等[9]基于CGAN的思想提出了pix2pix模型,實現了以圖像作為輸入,翻譯后的圖像作為輸出的端到端的圖像翻譯。pix2pix采用U-net[10]作為生成器,U-net相當于一個自編碼器,以一張圖像作為輸入的條件信息,對其編碼并解碼輸出翻譯圖像。判別器方面,pix2pix提出PatchGAN作為判別器,可對圖像實現更精細的判別,提升了翻譯圖像的質量。Wang等[11]將pix2pix擴展為pix2pixHD,采用由粗到細的多段生成器,多尺度PatchGAN作為判別器,同時改進了對抗損失,實現了高分辨率圖像的翻譯。pix2pix和pix2pixHD都是有監督的圖像翻譯方法,但是現實中訓練所需要的成對圖像數據集難以獲取,限制了這類有監督方法的應用。

針對成對圖像數據集難以獲取的問題,Zhu等[12]提出CycleGAN,通過一對對稱的GAN和循環一致性損失約束,實現了不需要成對圖像數據集的無監督圖像翻譯。由于網絡結構和損失函數上的一些局限性,CycleGAN在一些圖像內容的幾何結構變化較大的數據集上效果不佳。Liu等[13]假設圖像域間共享一個潛空間,提出了UNIT。UNIT將兩個生成器中的一部分層的參數共享,以強制對齊圖像域間共享的潛空間,從而由給定的兩個圖像域的邊緣分布推斷出它們之間的聯合分布,提升了無監督圖像翻譯的效果。受到InfoGAN[14]和β-VAE[15]的解耦表示學習的啟發,Huang等[16]在UNIT的基礎上,結合了解耦表示學習提出MUNIT。MUNIT將兩個圖像域間共享的潛空間分為內容空間和風格空間,使用不同的編碼器分別對圖像的內容和風格解耦,并于解碼器中重構,完成無監督圖像翻譯,同時能實現多模態的翻譯結果。

盡管這些無監督圖像翻譯方法已經可以在多個數據集上執行圖像翻譯,但是在一些變化較大的數據集上生成的圖像質量較低。原因在于無監督學習時對圖像域間的內容約束不足,導致圖像翻譯過程中內容變化過大,難以保持原圖像的內容;其次,模型難以處理不同圖像域之間的風格的復雜映射關系,使得圖像的風格傳遞不佳,導致生成的圖像質量較低。針對這些問題,現主要研究一種基于風格解耦和自適應層實例歸一化的圖像翻譯方法,通過增強圖像域間內容變化的約束,改善圖像風格的傳遞,以提升圖像翻譯的效果。

1 基于風格解耦的圖像翻譯模型

1.1 模型結構總覽

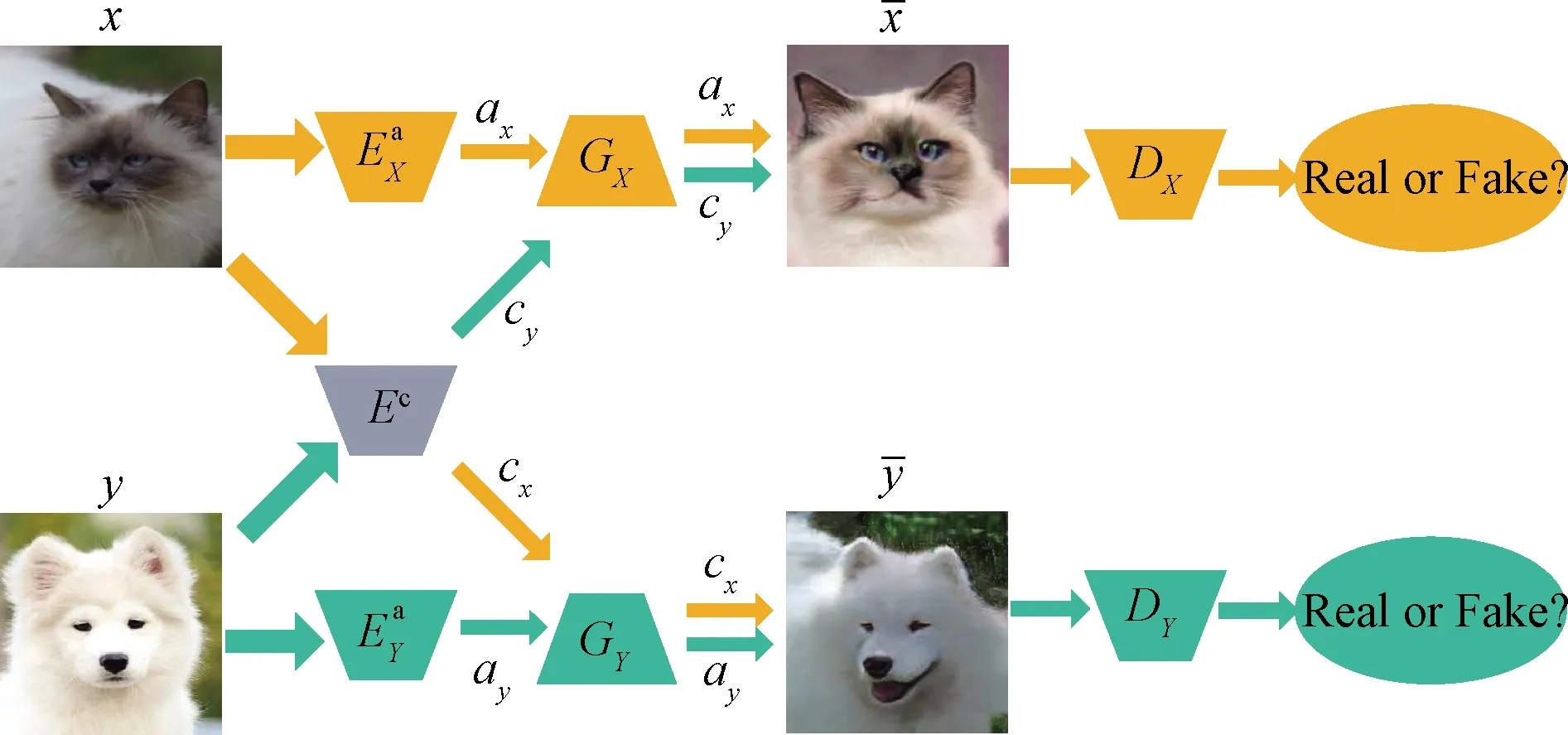

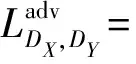

受CycleGAN的對稱GAN結構啟發,使用基于風格解耦和自編碼器結構的生成器。在訓練階段,采用多尺度PatchGAN作為判別器;在生成階段,采用跨域共享的內容編碼器以及域間獨立的風格編碼器和解碼器等。內容編碼器和風格編碼器采用不同的網絡結構,分別對圖像的內容和風格進行編碼。

圖1 模型的結構總覽

與CycleGAN的對稱GAN架構不同,本文模型的編碼器可以分別提取圖像的內容編碼和風格編碼。通過交換編碼和重復編解碼,在訓練時多次對圖像進行重構,增強圖像的循環一致性約束,從而提升模型的圖像翻譯效果,增強模型在多種任務上的適應能力。

1.2 生成器結構

圖像翻譯過程中,通過解耦及重組源域圖像的內容編碼和目標域圖像的風格編碼,即可完成源域圖像到目標域圖像的圖像翻譯。

1.2.1 內容編碼器

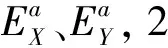

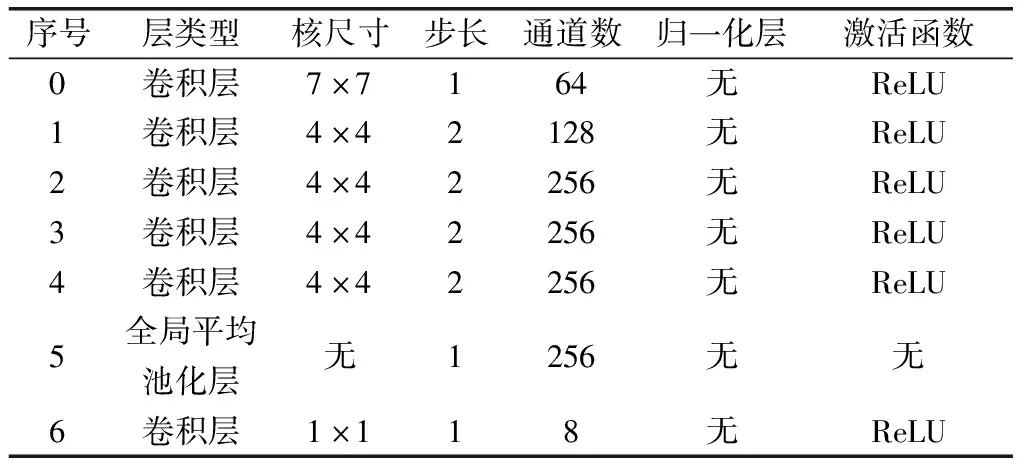

在圖像翻譯過程中,不同圖像域的內容編碼分布于不同的隱空間中,則使用不同分布內容編碼的解碼器生成的圖像難以還原原圖像的內容,使得生成圖像的內容與輸入圖像的內容不一致,導致生成的圖像質量下降。針對該問題,采用兩個圖像域共享一個相同的內容編碼器Ec的方法,這樣就能強制將圖像的內容編碼映射至同一隱空間,使翻譯前后圖像的內容強制對齊,以保持圖像翻譯前后內容一致,從而提升圖像翻譯的效果。內容編碼器Ec的具體網絡結構參數如表1所示。

表1 內容編碼器的網絡結構

內容編碼器Ec的網絡結構通過改進文獻[5]提出的深度殘差網絡結構改進得到。由于內容編碼器只用于提取圖像的內容特征,不需要對圖像進行上采樣,因此只使用Johnson等提出的網絡結構的下采樣部分。內容編碼器Ec由3個卷積層、4個殘差層組成,與文獻[5]提出的網絡結構類似,內容編碼器不含池化層,且在除第一層卷積之外的其余層之后加入實例歸一化(instance normalization, IN)[17]層。實例歸一化在會在每個圖像實例上單獨計算,可保持圖像的內容相互獨立,從而保持翻譯前后的圖像的內容具有不變性。

1.2.2 風格編碼器

表2 風格編碼器的網絡結構

1.2.3 基于上采樣卷積的解碼器

為了更好地傳遞目標圖像域的風格信息,在解碼器的殘差層后加入自適應層實例歸一化(adaptive layer-instance normalization, AdaLIN)[18]。AdaLIN融合了自適應實例歸一化(AdaIN)和層歸一化(layer normalization, LN)[19],表達式為

(1)

式(1)中:α為前一卷積層的輸出;μI(α)、σI(α)分別為逐通道計算的α的均值和標準差;μL(α)、σL(α)分別為整層計算的α的均值和標準差;αI、αL分別為α經過AdaIN和LN所得到的輸出;p為AdaIN和LN分別所占的權重比,γ、β為全連接層計算得到的仿射變換參數。p的取值范圍在0~1,p接近于1,則AdaIN占有較大的比例;p接近于0,則LN占有較大比例。在訓練時,p會動態地調整,以適應AdaIN和LN分別所占的比例。AdaIN逐通道計算均值和方差,則通道之間互不相關;而LN在整層全部通道上計算均值和方差,即通道之間完全相關;通過AdaLIN,本文模型的解碼器在訓練時可以動態地調整AdaIN和LN所占的比值,從而使解碼器根據輸入的內容編碼和風格編碼自適應地改變圖像的風格,改善圖像風格的傳遞,提升生成圖像的質量。

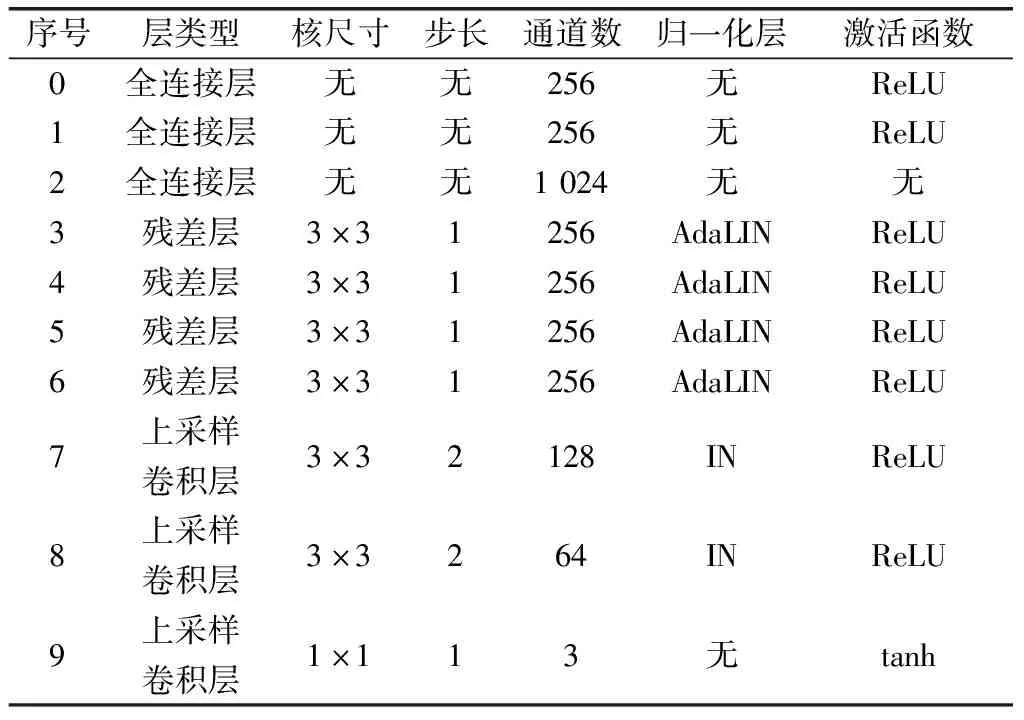

根據Odena等[20]的觀點,反卷積層會使生成的圖像產生棋盤格狀的偽影。因此,本文模型的解碼器使用上采樣+卷積的方法來替代反卷積層。解碼器的網絡結構如表3所示。

表3 解碼器的網絡結構

本文模型的解碼器由3個全連接層、4個殘差層和3個上采樣卷積層構成,共有GX、GY2個解碼器,分別用于生成圖像域X、Y的圖像。解碼器通過接收內容編碼器輸出的內容編碼和對應圖像域的風格編碼器輸出的風格編碼,在全連接層產生仿射變換參數γ、β,然后風格編碼在殘差層中與內容編碼結合,由上采樣卷積層輸出翻譯后的圖像,實現生成具有內容編碼表示的內容和風格編碼表示的風格的圖像。

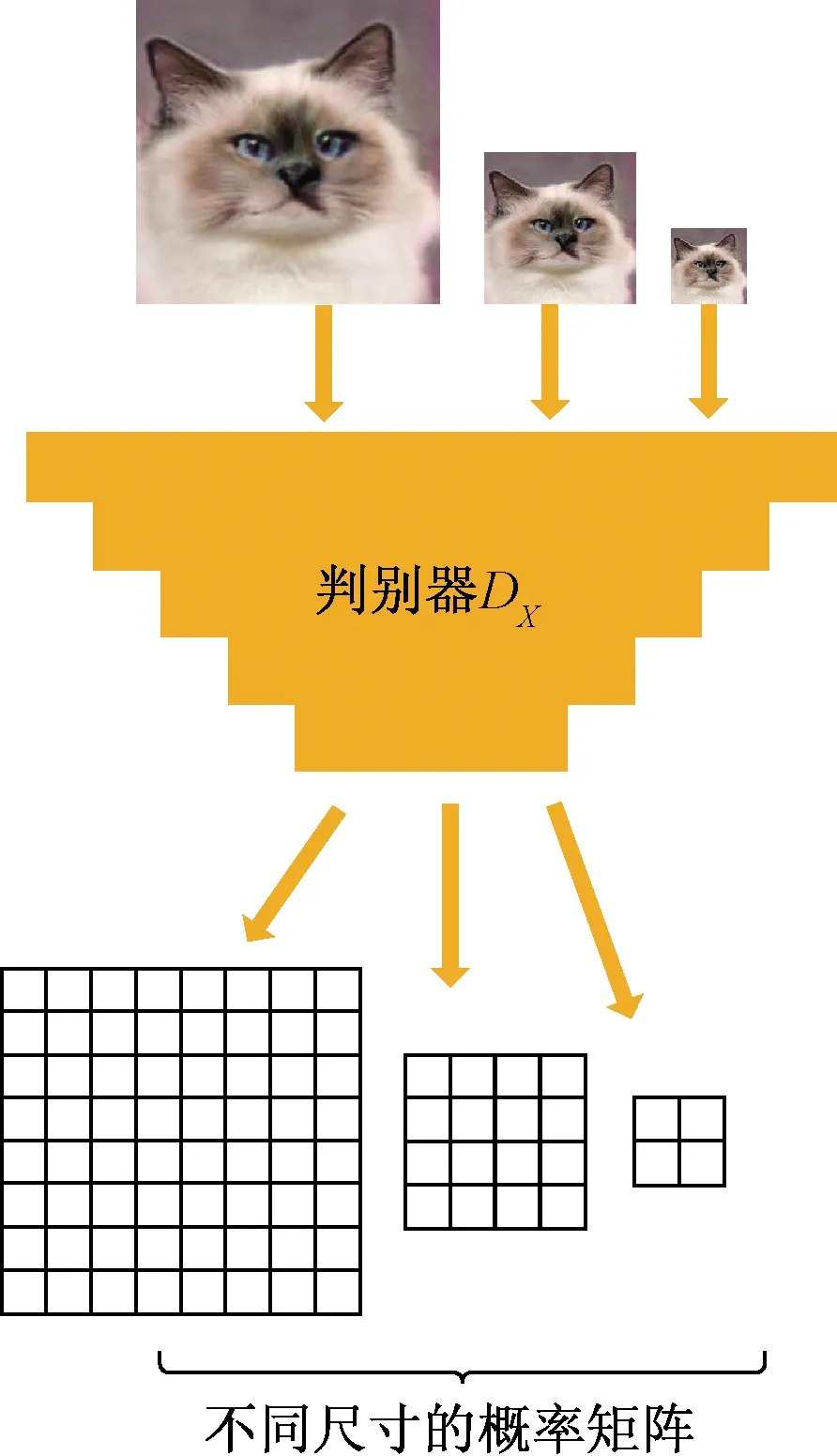

1.3 基于多尺度PatchGAN的判別器

采用文獻[11]提出的多尺度PatchGAN作為模型的判別器。傳統的判別器由圖像識別模型發展而來,只能輸出一個表示圖像為真的概率值,而PatchGAN在最后輸出的是一個概率矩陣。相對于整幅圖像為真的概率值,概率矩陣包含了更多的信息;矩陣中的每個元素的感受野大小對應著原圖像的一個Patch的尺寸;每個元素的值表示對應的Patch為真的概率值。在此基礎上,多尺度PatchGAN分別對輸入的圖像進行2次下采樣,對下采樣后的圖像再次進行判別,共輸出3個不同尺寸的概率矩陣,其結構圖如圖2所示。本文模型中,最大的概率矩陣的尺寸為16×16,則矩陣中的每個元素對應的感受野大小為46×46,相當于將輸入的圖像分割為46×46個Patch,并對每個Patch進行判別得到概率值,再對結果求平均值。相對于PatchGAN,多尺度PatchGAN通過判別不同尺寸的圖像,在計算量變化不大的條件下間接地增加了判別器的感受野。多尺度PatchGAN輸出的不同尺寸的概率矩陣中,較小尺寸的表示判別器對圖像全局的判別結果,而較大尺寸的表示對圖像細節的判別結果。多尺度PatchGAN在不同尺度上對圖像進行判別,同時判別了圖像的全局和細節,提升了判別能力。而訓練時多尺度PatchGAN也會反作用于生成器,引導生成器生成全局更真實、細節更精細的圖像。

圖2 多尺度PatchGAN判別器

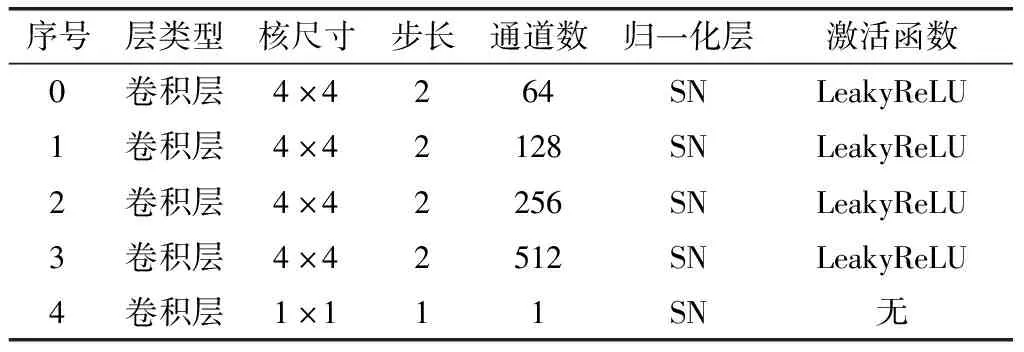

本文模型采用2個判別器DX、DY,分別對圖像域X、Y的圖像進行判別,每個判別器的網絡結構如表4所示。

表4 判別器的網絡結構

為了使判別器訓練時更穩定,同時使其具有更強的魯棒性、泛化能力,需要使其滿足K-Lipschitz約束,如式(2)所示。為了滿足K-Lipschitz約束,需要進行譜歸一化(spectral normalization, SN)運算,如式(3)所示。

(2)

(3)

2 損失函數

本文模型包含2個對稱的GAN,模型訓練時共同對2個GAN進行優化以完成圖像域X、Y之間的圖像翻譯。因此,本文模型的損失函數由生成器和判別器的對抗損失、自重建損失、跨域循環一致性損失、隨即風格編碼重建損失和正則化項構成,總損失函數表示為

(4)

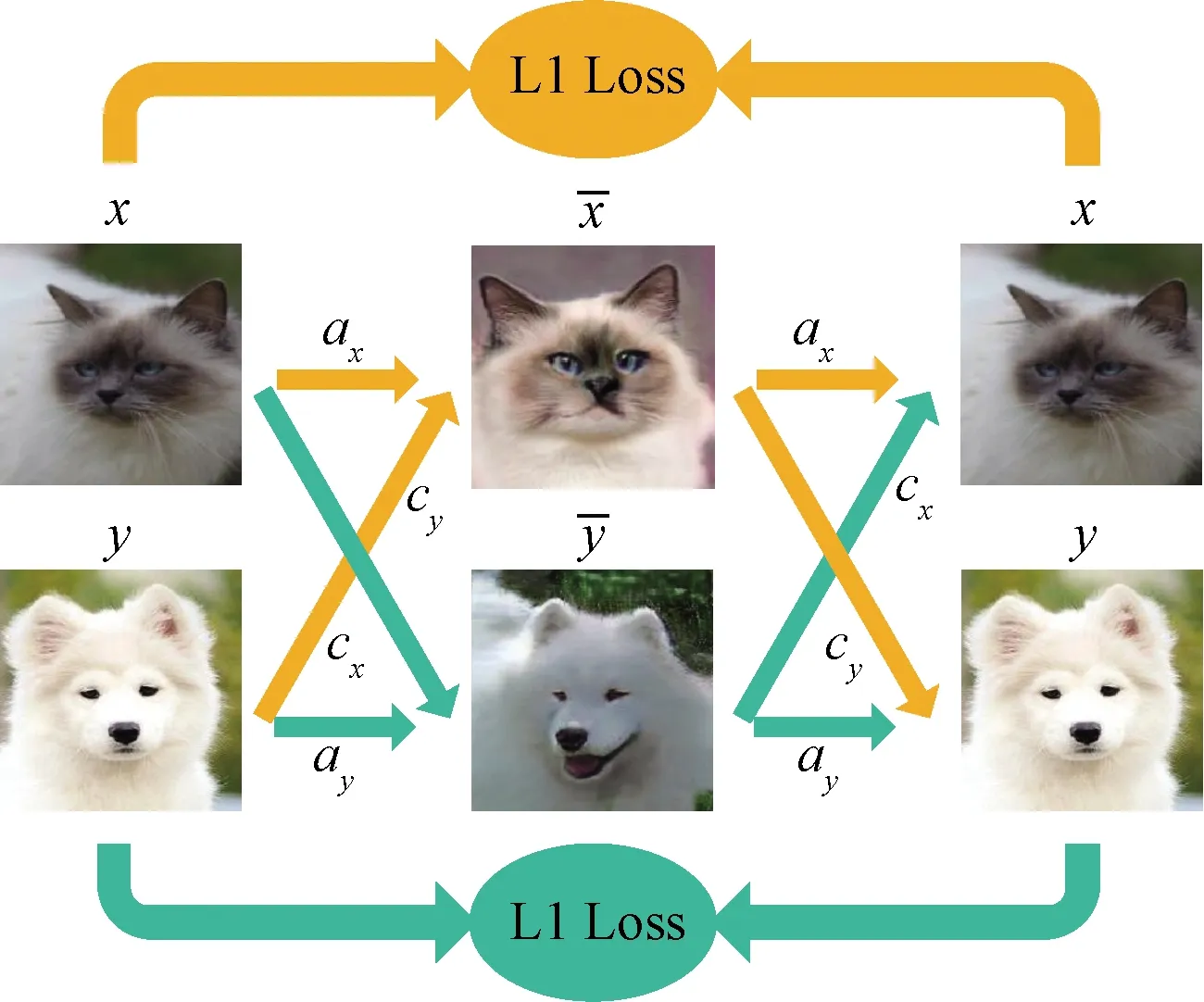

2.1 對抗損失

模型的對抗損失為生成器的對抗損失和判別器的對抗損失。在訓練過程中,生成器的目標是使生成的偽圖像能被判別器判別為真,而判別器的目標則是能區分真實圖像和生成的偽圖像。對圖像翻譯而言,模型訓練的目標本質是學習將圖像域X映射至圖像域Y以及將圖像域Y映射至圖像域X的兩個映射函數。原始GAN使用的交叉熵損失函數適用于圖像分類任務,它更關注于圖像的真偽而不是圖像離決策邊界的距離;而最小二乘生成對抗網絡(least squares generative adversarial networks, LSGAN)[21]使用的最小二乘損失函數可以有效地懲罰遠離決策邊界的假樣本,從而增強判別器對假樣本的判別能力,更適合圖像生成任務,因此本文模型的對抗損失使用最小二乘損失函數。

(5)

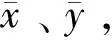

圖3 隨機風格圖像的生成過程

(6)

(7)

模型判別器的對抗損失為

(8)

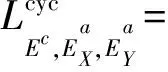

2.2 自重建損失

自重建損失用于約束解碼器,使解碼器可根據原圖像的內容編碼和風格編碼還原輸入圖像的內容和風格。輸入一對圖像x、y,分別進行編碼,不交換它們的內容編碼,解碼器GX、GY應能根據x、y的內容編碼和風格編碼輸出x、y的自重建圖像。因此,構建自重建損失為

(9)

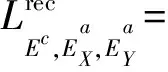

2.3 跨域循環一致性損失

由于對抗損失只能約束生成器生成對應圖像域的圖像,而不能保證輸入圖像的內容在編解碼過程中不丟失,因此需要循環一致性損失對生成器進行約束。由于本文模型解耦并重組內容編碼和風格編碼,因此本文模型在CycleGAN提出的循環一致性損失上擴展為跨域循環一致性損失。

圖4 跨域循環一致性損失

(10)

CycleGAN的循環一致性損失用于約束生成器,使圖像在翻譯前后的重要內容特征保持一致;而跨域循環一致性損失在循環一致性損失的基礎之上,增加了對生成器中的編碼器的約束,確保在重復的編解碼過程中編碼保持一致。

在跨域循環一致性損失中,輸入圖像的內容編碼和風格編碼均進行了兩次編解碼操作,且內容編碼在兩個圖像域中交換過。這促使風格編碼在相同圖像域內傳遞并保持,內容編碼在不同圖像域間傳遞并保持。采用跨域循環一致性損失,可以有效地保持內容編碼和風格編碼在翻譯過程中不變,也就使生成器能有效地保留并傳遞圖像的內容和風格,提升生成器生成的圖像的質量和真實感。

2.4 隨機風格編碼重建損失

圖像的內容編碼和風格編碼在跨域循環一致性損失中隱式地受到約束,但是隨機風格編碼az并未受到約束。為增強生成器保留并傳遞隨機風格的能力、提升隨機風格編碼對圖像風格的表征能力,對隨機風格編碼也增加重建損失。由于使用隨機風格編碼生成的偽圖像風格為隨機的,沒有能與之對照的圖像,因此直接對隨機風格編碼az進行重建,則隨機風格編碼az的重建損失為

(11)

隨機風格編碼符合標準正態分布,增加隨機風格編碼重建損失可引導生成器根據不同的風格編碼生成不同的風格圖像,提升生成圖像的多樣性。

2.5 正則化項

對內容編碼和風格編碼增加L2正則化項,以防止模型產生過擬合,正則化項為

(12)

3 實驗結果及分析

為了驗證所提出方法的有效性,已經實現了該方法,并在多個數據集上進行實驗和分析。所用的計算機的硬件環境:CPU為Intel Xeno W2104,GPU為Nvidia RTX2080ti,內存為16 G。計算機的軟件環境:操作系統為Win10,模型的開發框架為tensorflow 1.14.0,開發語言為python3.7。

3.1 實驗數據集與參數設置

所用的數據集包括Cat?Dog、Summer?Winter和Edge?Shoes等。Cat?Dog為貓狗面部圖像數據集[22],取從Google images上收集的861張貓的面部圖像和1 315張狗的面部圖像,選擇100張貓的面部圖像和100張狗的面部圖像作為測試集,其余的圖像作為訓練集供模型訓練。Summer?Winter為夏季與冬季風景圖像數據集[12],包含從Flickr上收集的Yosemite國家公園的風景照片,取其中1 366張夏季風景圖像、1 102張冬季風景圖像,選擇268張夏季風景圖像和206張冬季風景圖像作為測試集,其余作為訓練集供模型訓練。Edge?Shoes為邊緣圖和鞋圖像數據集,包含UT Zappos50K數據集[23]中的50 025張鞋圖像,以及用HED[24]提取的50 025張鞋的邊緣圖像,其中取200張鞋的圖像和200張鞋的邊緣圖像作為測試集,其余作為訓練集供模型訓練。

模型的輸入圖像和輸出圖像的尺寸均為256×256,每次訓練的batch size為1,使用均值為0、標準差為0.02的隨機正態分布對網絡中的參數進行初始化;使用Adam算法對模型進行優化,學習率設為0.000 1,一階矩估計的指數衰減率為0.5,二階矩估計的指數衰減率為0.999。各個損失函數的權重超參數λadv、λrec、λcyc、λlat、λreg分別為1、10、10、10、0.01。

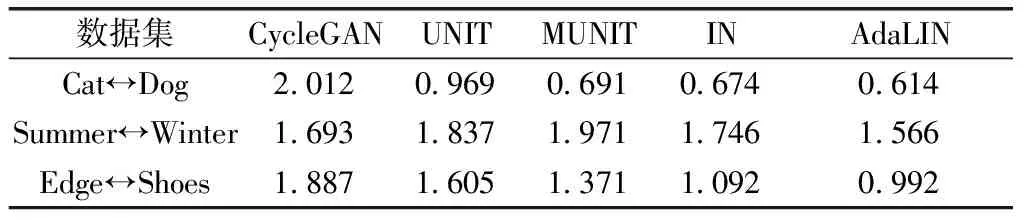

3.2 量化實驗與分析

使用弗雷歇起始距離(Fréchet inception distance,FID)[25]來評估翻譯后的圖像質量。將真實圖像和偽圖像分別輸入預訓練的Inception-V3網絡中,并分別提取網絡的最后一個池化層,通過均值和協方差矩陣計算兩個分布之間的弗雷歇距離,從而衡量兩個分布的相似度。FID可以有效地評價圖像的質量,其結果和人眼的判斷較為接近。FID的值越小,表示真實圖像和生成的偽圖像分布越接近,生成的偽圖像質量越高。

選擇了無監督圖像翻譯中的代表性方法CycleGAN、UNIT和同樣采用解耦思想的MUNIT,與本文的方法進行對比實驗。對于CycleGAN、UNIT和MUNIT,采用原始代碼的Tensorflow版本,并使用和原始代碼一致的超參數設置。所有方法在測試集上進行圖像翻譯,并計算不同模型在測試集上輸出的圖像與真實圖像的平均FID。同時,為了對解碼器中加入的自適應實例歸一化層的效果進行評估,將只使用實例歸一化(IN)的模型和加入自適應層實例歸一化(AdaLIN)后的模型分別在測試集上測試,并計算輸出的圖像與真實圖像的平均FID。不同模型的平均FID如表5所示。

表5 不同模型的平均FID對比

由表5可知,CycleGAN在貓狗圖像數據集與邊緣圖和鞋圖像數據集上表現較差,在風景圖像數據集上表現較好;UNIT和MUNIT在貓狗圖像數據集與邊緣圖和鞋圖像數據集上表現較好,在風景圖像數據集上表現較差;使用IN時,本文模型在貓狗圖像數據集與邊緣圖和鞋圖像數據集上表現較好,但是在風景圖像數據集上表現要差于CycleGAN;在使用AdaLIN后,本文模型在3種數據集上的表現均要更好,證明了本文方法對于提升生成圖像質量的有效性。

3.3 不同歸一化的對比實驗與分析

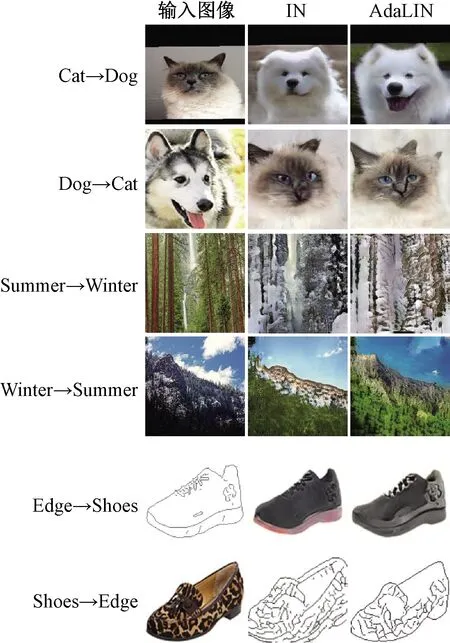

對于只使用實例歸一化的模型和加入自適應層實例歸一化后的模型,分別取在測試集上的一部分輸出圖像進行對比實驗,結果如圖5所示。

圖5 不同歸一化的效果對比

在貓狗圖像翻譯任務上,相對于使用實例歸一化的模型,采用自適應層實例歸一化的模型可以更好地約束輸入圖像的面部朝向,從而避免生成的圖像的面部出現扭曲,影響翻譯的效果。

在夏季風景圖像轉換為冬季風景圖像任務上,采用自適應層實例歸一化前,模型生成的圖像色彩不夠均勻,而且對于輸入圖像的內容保留不足;采用后,圖像在保留了輸入圖像的重要內容同時,選擇性地改變了圖像的風格,使圖像色彩更均勻,結構更真實,增強了生成圖像的觀感。

在邊緣圖像與鞋圖像的轉換任務上,采用自適應層實例歸一化后,生成的鞋圖像整體色調更均勻,真實感更好;生成的邊緣圖像保持了鞋的整體輪廓,同時去掉了多余的邊緣線條。

3.4 隨機風格圖像實驗與分析

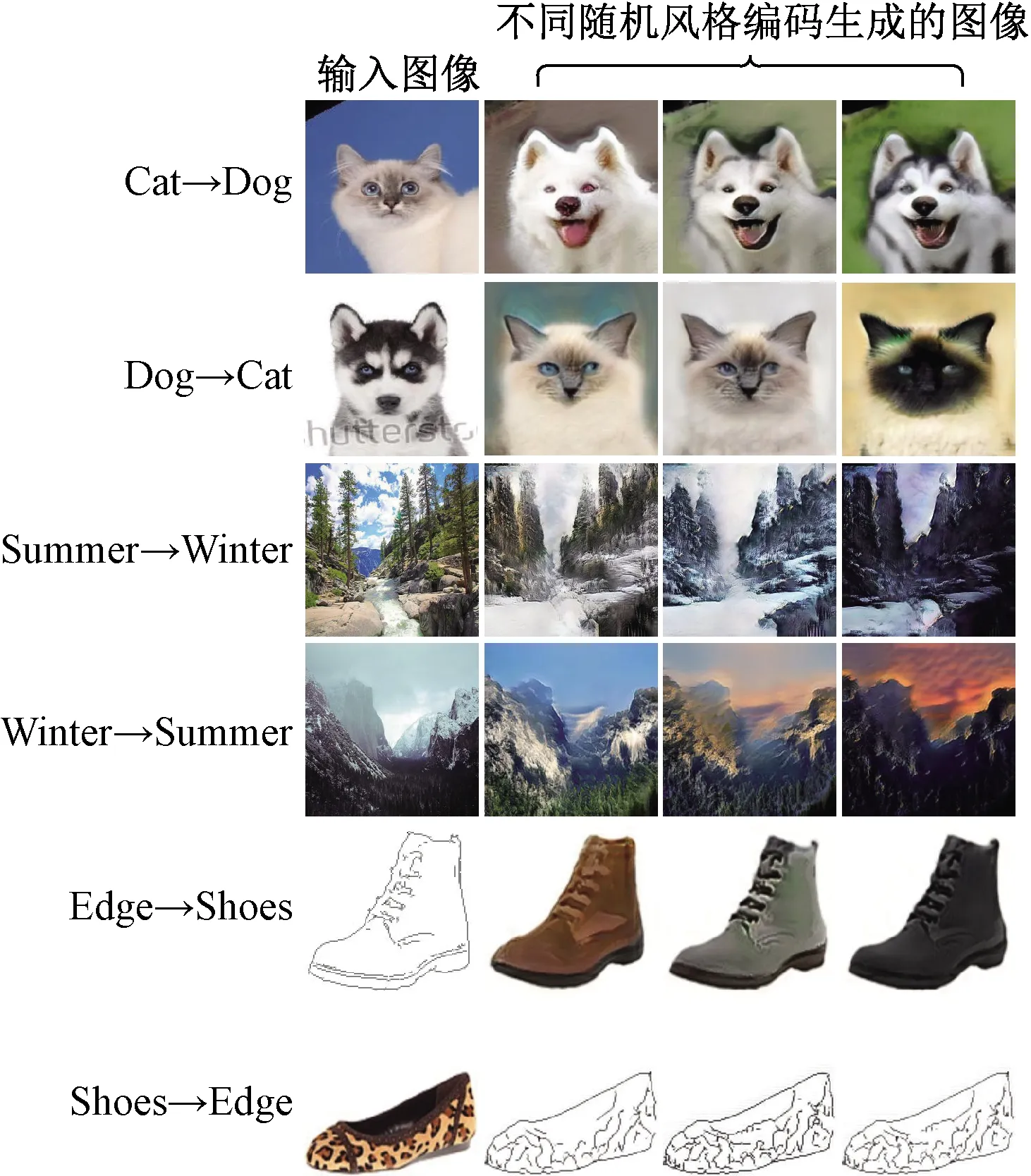

為驗證模型生成隨機風格圖像的能力,采用服從標準正態分布的隨機風格編碼進行圖像翻譯,實驗結果如圖6所示。

圖6 隨機風格圖像效果圖

在訓練時,模型受到隨機風格編碼重建損失的約束,在訓練集上采樣了目標域圖像的不同風格。因此,在輸入圖像相同的情況下,本文方法可以根據隨機產生的不同的風格編碼生成不同風格的目標域圖像,提升了圖像翻譯的多樣性。

3.5 不同模型翻譯效果的對比實驗與分析

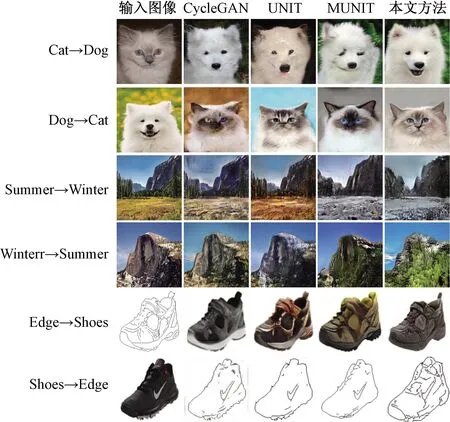

分別取CycleGAN、UNIT、MUNIT以及本文方法在測試集上的一部分輸出圖像進行對比實驗。

如圖7所示,其中第一列為輸入的原圖像,其余列分別為不同方法對輸入圖像的翻譯結果。

圖7 不同模型的翻譯效果對比

在貓圖像轉換為狗圖像的任務中,CycleGAN和UNIT生成的圖像質量較低,出現了細節模糊、翻譯不完全等現象。相對于原圖像,MUNIT生成的圖像的幾何變化較大,圖像翻譯地較為完全,但是眼睛處和耳朵處出現了變形和模糊。本文方法生成的狗圖像,在整體的幾何變形和細節的生成之中取得了平衡,圖像的質量和觀感較好。在狗圖像轉換為貓圖像的任務中,CycleGAN生成的圖像保留了原圖像的幾何形狀,但是面部出現變形,且毛色不均勻,導致圖像質量較低。UNIT和MUNIT生成的圖像質量較好,但是嘴部出現了偽影。本文方法生成的圖像保留了嘴部細節,整體的協調性較好。

在夏季風景圖像轉換為冬季風景圖像任務上,CycleGAN和UNIT生成的圖像保留了更多原圖像的內容,但是生成的積雪較少,圖像整體翻譯效果較差;MUNIT生成的圖像出現了較多的積雪,但是草地的顏色不夠均勻;本文方法生成的圖像積雪較多,圖像整體色調均勻,使得圖像更真實、觀感更好。在冬季風景圖像轉換為夏季風景圖像任務上,CycleGAN生成的圖像整體色調變化較小;UNIT生成的圖像色調偏暗,山有些模糊;MUNIT生成的圖像出現了較多植被,但是山上生成的植被不均勻;本文方法的圖像整體色調偏亮,生成的植被豐富,使得圖像的整體觀感良好。

在邊緣圖像轉換為鞋圖像的任務上,CycleGAN生成的圖像質量較高,但是鞋尖處顏色不夠均勻;UNIT和MUNIT生成的圖像整體色調不太一致,真實性較低;本文方法生成的圖像色調均勻,整體真實性更強。在鞋圖像轉換為邊緣圖像的任務上,CycleGAN生成的圖像邊緣處出現黑影,細節較差;UNIT和MUNIT生成的圖像大致地還原了輸入圖像的輪廓;本文方法生成的圖像包含更多細節,更好地還原了輸入圖像的邊緣。

4 結論與展望

針對無監督圖像翻譯內容不一致、風格傳遞不佳、多樣性不佳的問題,提出了一種基于風格解耦和自適應層實例歸一化的圖像翻譯方法。采用基于解耦表示的生成器,兩個圖像域間共享內容編碼器,對齊翻譯前后圖像的內容,增強輸入圖像與生成圖像的內容一致性;在解碼器的殘差層中加入自適應層實例歸一化,使模型自適應地對風格進行處理,增強風格傳遞的效果,改善生成圖像的質量;將隨機風格編碼融合進對抗損失,實現隨機風格圖像的生成,提升生成圖像的多樣性。實驗驗證表明本文方法生成的圖像質量更佳,且可以生成多樣化的圖像。

下一步研究工作包括將本文方法擴展,以應用于目標檢測、圖像增強、圖像修復等工作中。