基于深度學(xué)習(xí)網(wǎng)絡(luò)的舞蹈動(dòng)作識(shí)別方法研究

閆琳

(西安航空職業(yè)技術(shù)學(xué)院,陜西西安 710089)

近年來,對(duì)于視頻技術(shù)的研究成為學(xué)術(shù)界研究的熱點(diǎn)之一。在眾多視頻技術(shù)中,視頻動(dòng)作識(shí)別對(duì)于視頻智能化應(yīng)用有著重要意義,其在較多領(lǐng)域均有著廣泛的應(yīng)用[1-5]。

對(duì)于視頻信息的提取通常依靠?jī)蓚€(gè)步驟,首先提取視頻中的相關(guān)視覺特征;然后對(duì)提取的特征進(jìn)行學(xué)習(xí),生成相應(yīng)的描述標(biāo)簽。在該技術(shù)中,最重要的是有效提取特征,深度學(xué)習(xí)算法是當(dāng)前提取視頻特征最為高效的方法之一。但傳統(tǒng)上基于該方式的提取方法更注重視頻上空間域,即視頻幀中像素信息的提取,卻忽略了視頻動(dòng)作在時(shí)間域上動(dòng)作狀態(tài)的變化。以人類的認(rèn)知為例,物體的動(dòng)作是不斷變化的,人除了依靠動(dòng)作靜止時(shí)的畫面判斷動(dòng)作的類別,還需關(guān)注動(dòng)作從開始到結(jié)束變化的全過程。深度學(xué)習(xí)作為人工智能技術(shù)中的重要算法之一,其提取特質(zhì)的方式與人類幾乎一致。因此,文中重點(diǎn)介紹了視頻中時(shí)域特征的提取方法[6-10]。

1 理論基礎(chǔ)

1.1 深度學(xué)習(xí)算法

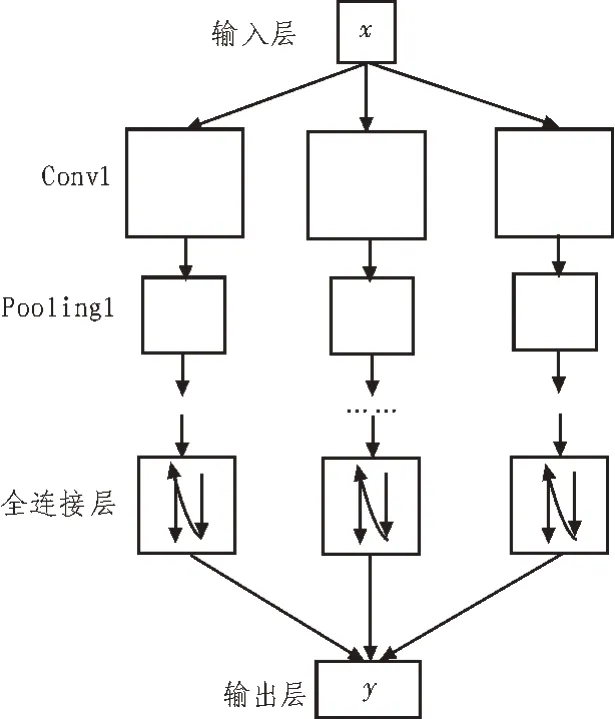

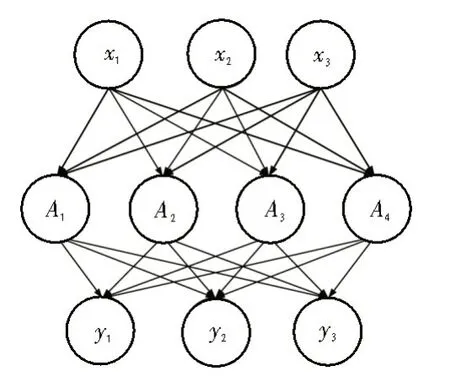

卷積神經(jīng)網(wǎng)絡(luò)是圖像處理領(lǐng)域中最常用的深度學(xué)習(xí)網(wǎng)絡(luò)。該網(wǎng)絡(luò)的結(jié)構(gòu)如圖1 所示,主要包括了卷積、池化和全連接運(yùn)算[11]。

圖1 卷積神經(jīng)網(wǎng)絡(luò)

1.1.1 卷積層

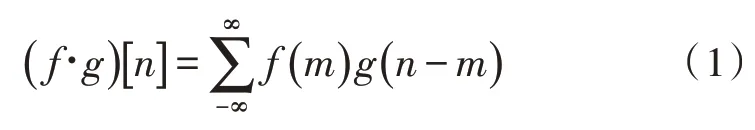

卷積是一種常見的信息處理領(lǐng)域的數(shù)學(xué)運(yùn)算,離散域上的卷積運(yùn)算方法,如式(1)所示。

在離散域上的卷積運(yùn)算需要合理的選擇卷積核,卷積核通常是一個(gè)n2的矩陣。卷積運(yùn)算的示意圖如圖2 所示。

圖2 卷積運(yùn)算示意

在圖2 中,W是使用的卷積核,使用的是3×3 的維度。卷積核可對(duì)特征的模式進(jìn)行強(qiáng)化或隱藏,靈活地進(jìn)行圖像特征的提取。

1.1.2 池化層

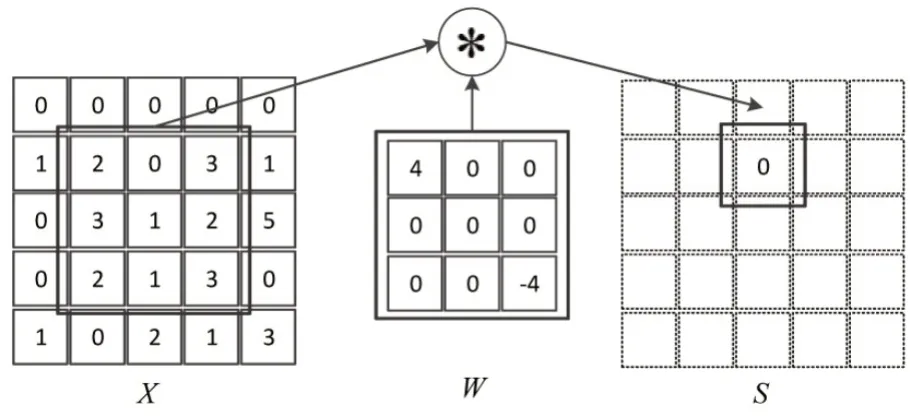

池化層是指在卷積獲得的特征中,選擇某一局部區(qū)域替代完整區(qū)域,池化實(shí)現(xiàn)了特征的過濾與選擇。常用的池化運(yùn)算包括最大值池化與均值池化。其中,均值池化的運(yùn)算方法如圖3 所示[12]。

圖3 均值池化運(yùn)算示意圖

對(duì)于卷積神經(jīng)網(wǎng)絡(luò),池化層的引入實(shí)現(xiàn)了圖像信息的降采樣,可以有效地簡(jiǎn)化網(wǎng)絡(luò)結(jié)構(gòu),防止出現(xiàn)過擬合。

1.1.3 全連接層

卷積神經(jīng)網(wǎng)絡(luò)的最末端是全連接層,全連接層對(duì)前一層的特征進(jìn)行綜合即可得到網(wǎng)絡(luò)的分類器。其連接示意圖如圖4 所示。

圖4 全連接層示意圖

全連接層的運(yùn)算方式與傳統(tǒng)單隱藏層的神經(jīng)網(wǎng)絡(luò)類似,通過連接權(quán)重與偏置連接輸入層到隱藏層,以及隱藏層到輸出層。其計(jì)算方式如式(2)所示。

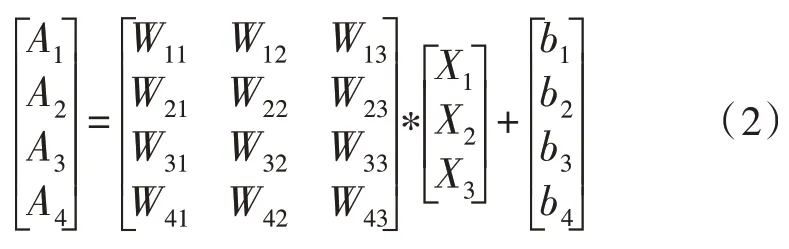

1.1.4 輸出層

輸出層借助非線性函數(shù)將全連接層的輸出轉(zhuǎn)化為深度網(wǎng)絡(luò)的最終輸出,對(duì)于二分類問題通常選擇Logistic 函數(shù)。文中選擇的是Softmax 交叉熵函數(shù),其形式如式(3)所示。

其中,c代表分類的類別,當(dāng)輸出結(jié)果與實(shí)際的類別一致時(shí),yc=1。

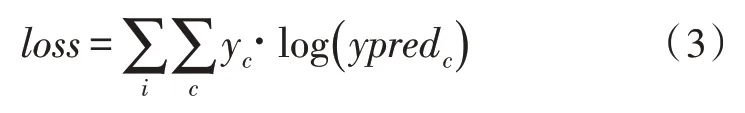

1.2 基于時(shí)空域的雙卷積神經(jīng)網(wǎng)絡(luò)

空間域中的特征提取方法與圖像信息的提取方法一致,文中在時(shí)間域上的特征借助光流(Optical Flow)進(jìn)行標(biāo)識(shí)。循環(huán)神經(jīng)網(wǎng)絡(luò)如圖5 所示,光流反映了空間內(nèi)物體運(yùn)動(dòng)狀態(tài)改變后像素的變化軌跡,在運(yùn)動(dòng)檢測(cè)中有廣泛的應(yīng)用。其獲取方法如下:

圖5 循環(huán)神經(jīng)網(wǎng)絡(luò)

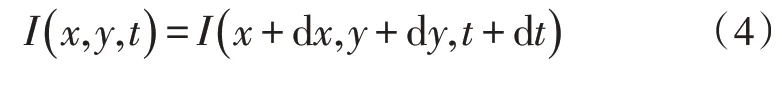

在時(shí)間t下對(duì)于空間坐標(biāo)位置點(diǎn)O(x,y),該點(diǎn)像素亮度為I(x,y,t)。在dt時(shí)間內(nèi),下一幀內(nèi)該點(diǎn)移動(dòng)到新的位置(x+dx,y+dy)。此時(shí),由于時(shí)間極短,該點(diǎn)的光亮度存在式(4)中的關(guān)系[13-15]。

其泰勒展開式如式(5)所示。

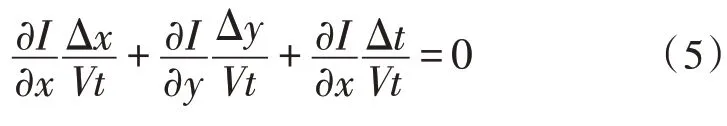

此時(shí),可以得到該點(diǎn)的光流等式,如式(6)所示。

在式(7)中,Vx與Vy是光流矢量。從該微分方程中,求解光流矢量需要引入金字塔(LK)算法。

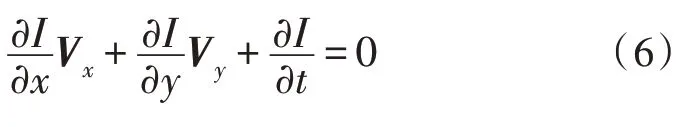

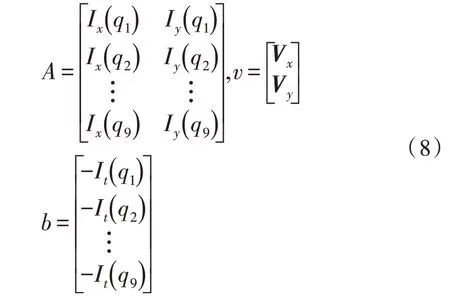

對(duì)于3×3 大小的像素區(qū)域,共包含9 個(gè)光流軌跡,用矩陣的形式可以表示為式(7)。

其中的變量如式(8)所示。

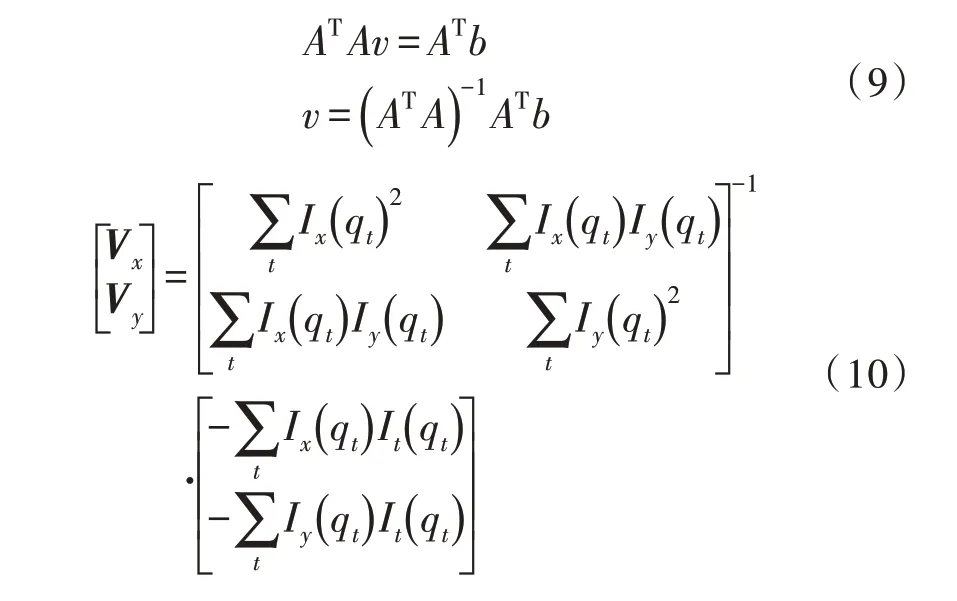

利用式(9)可以求解得式(10)。

2 方法實(shí)現(xiàn)

2.1 實(shí)驗(yàn)設(shè)計(jì)

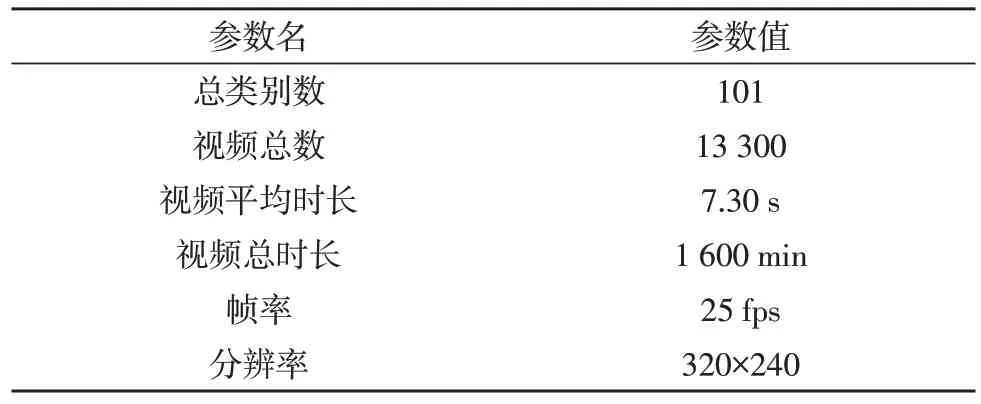

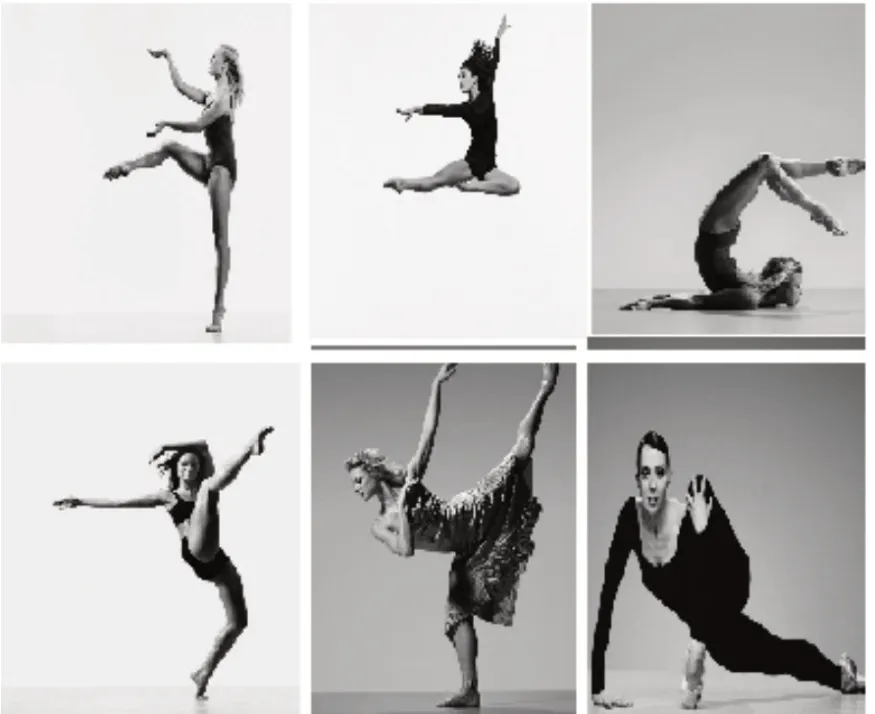

為了評(píng)估模型的有效性,文中在舞蹈視頻動(dòng)作數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn)。該數(shù)據(jù)集的參數(shù),如表1 所示。在該數(shù)據(jù)集內(nèi),存在101 個(gè)類別的舞蹈動(dòng)作,視頻的幀數(shù)均是25 fps,分辨率均為320×240,視頻的時(shí)間長度在2.31~67.24 s 之間。部分視頻幀如圖6所示。

表1 數(shù)據(jù)集參數(shù)

圖6 舞蹈動(dòng)作視頻數(shù)據(jù)集

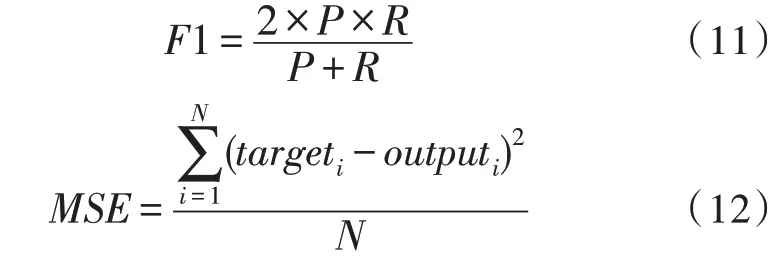

為了衡量模型對(duì)于舞蹈動(dòng)作的識(shí)別精度,文中使用深度學(xué)習(xí)中常用的評(píng)價(jià)指標(biāo)F1 與MSE。這兩個(gè)指標(biāo)的定義方式如式(11)~(12)所示。

2.2 仿真結(jié)果

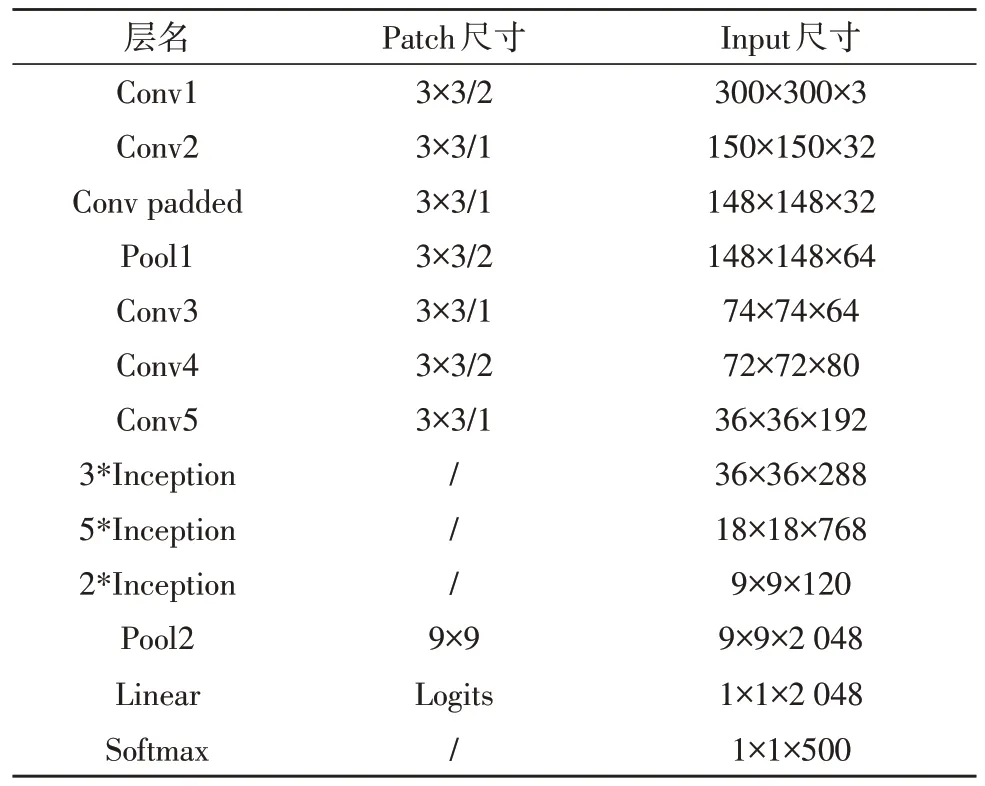

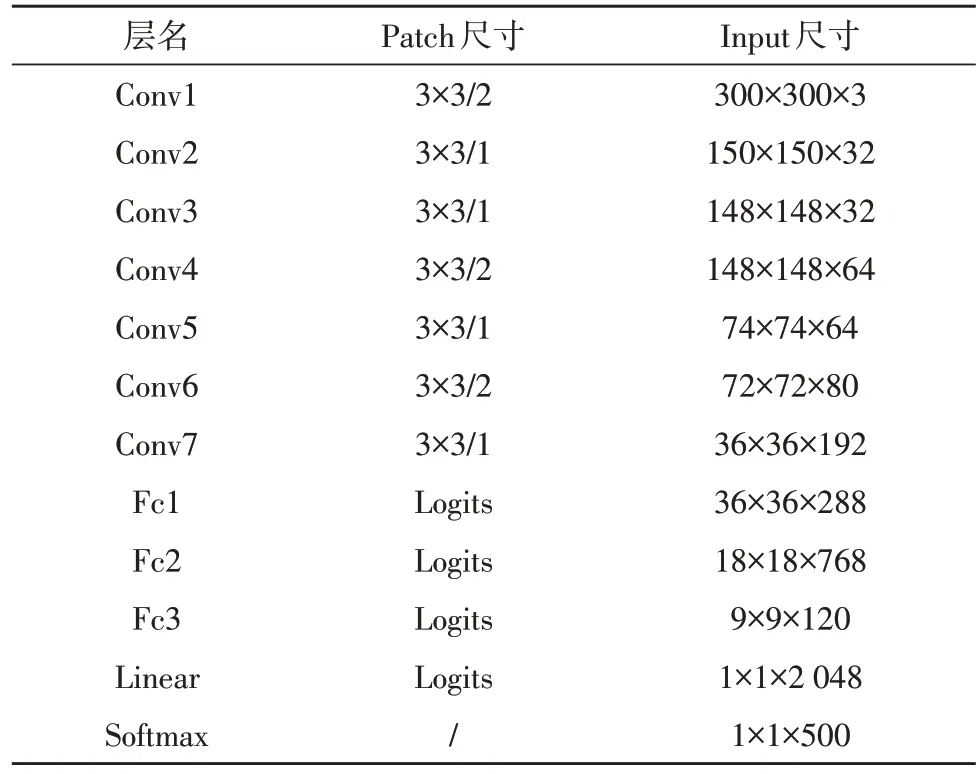

為了更優(yōu)地衡量文中模型對(duì)于視頻中舞蹈動(dòng)作的識(shí)別效果,文中引入了兩個(gè)已在工業(yè)上廣泛使用的深度卷積網(wǎng)絡(luò):Inception V3 與3D-CNN 網(wǎng)絡(luò)。其各自的網(wǎng)絡(luò)參數(shù)設(shè)置,分別如表3、表4 所示。

表3 Inception V3參數(shù)設(shè)置

表4 3D-CNN 網(wǎng)絡(luò)參數(shù)設(shè)置

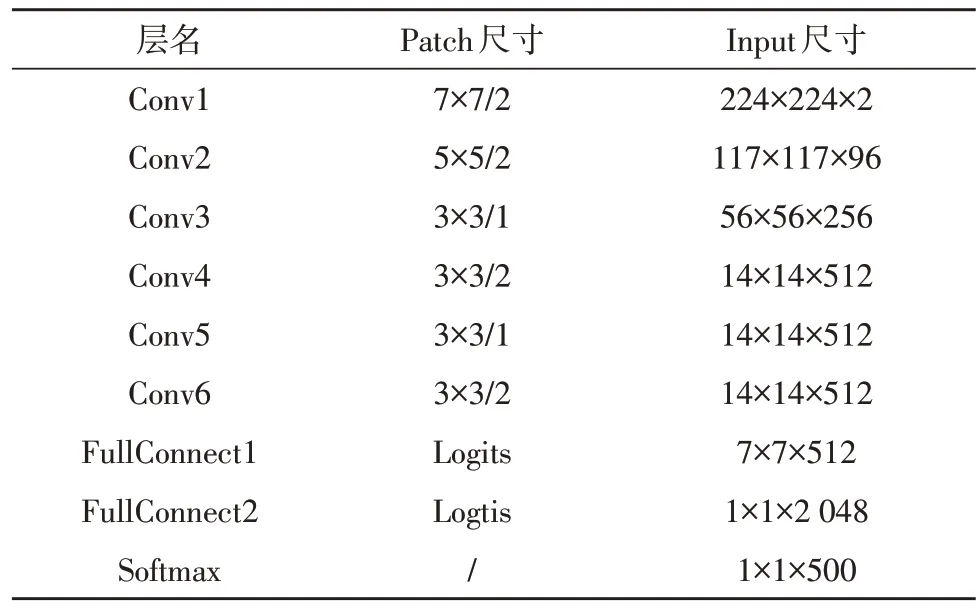

表5 給出了文中雙路卷積網(wǎng)絡(luò)的參數(shù)設(shè)置,其采用兩個(gè)相同的卷積結(jié)構(gòu)。經(jīng)過表3~5 的比對(duì)可以發(fā)現(xiàn),3 個(gè)網(wǎng)絡(luò)的復(fù)雜度基本一致。將表1 給出的視頻數(shù)據(jù)庫按照7∶3 的比例劃分為訓(xùn)練集與測(cè)試集。3 個(gè)網(wǎng)絡(luò)訓(xùn)練完成后,使用測(cè)試集進(jìn)行測(cè)試。測(cè)試結(jié)果如表6 所示。

表5 雙路卷積網(wǎng)絡(luò)參數(shù)設(shè)置

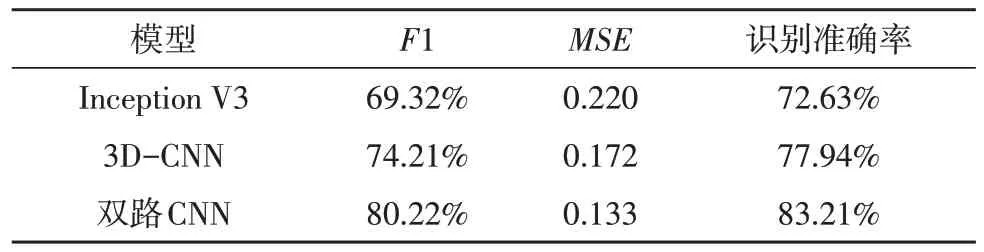

從表6 的測(cè)試結(jié)果可以看出,在3 個(gè)網(wǎng)絡(luò)中,網(wǎng)絡(luò)F1 指標(biāo)最差的是Inception V3 的69.32%,居中的是3D-CNN 網(wǎng)絡(luò),最優(yōu)的是雙路卷積網(wǎng)絡(luò),其較Inception V3 的F1 提升了10.90%。MSE與F1 是兩個(gè)相互負(fù)相關(guān)的指標(biāo),表6 的第3 列數(shù)據(jù)較優(yōu)地驗(yàn)證了這一數(shù)據(jù)趨勢(shì),證明了測(cè)試結(jié)果的有效性。從表6中第4 列對(duì)于舞蹈動(dòng)作識(shí)別的準(zhǔn)確率來看,文中提出的雙路CNN 算法由于引入了手工提取的時(shí)域光流信息,對(duì)于Inception V3 與3D-CNN 網(wǎng)絡(luò)分別有10.85%與5.27%的提升。

表6 3個(gè)網(wǎng)絡(luò)性能對(duì)比

3 結(jié)束語

文中對(duì)視頻動(dòng)作的識(shí)別方法進(jìn)行了研究,通過對(duì)傳統(tǒng)的深度卷積網(wǎng)絡(luò)的調(diào)研發(fā)現(xiàn),這些深度網(wǎng)絡(luò)提取的特征更多是空間維度的信息,缺乏時(shí)域信息的提取,影響了動(dòng)作識(shí)別的精度。文中使用光流信息表征時(shí)域動(dòng)作的狀態(tài)變化,構(gòu)建了雙路卷積網(wǎng)絡(luò),大幅度提升了舞蹈動(dòng)作的識(shí)別精度。在后續(xù)的研究中,可以繼續(xù)優(yōu)化時(shí)域卷積網(wǎng)絡(luò)的結(jié)構(gòu),提升算法的性能。