融合手部骨架灰度圖的深度神經網絡靜態手勢識別?

章東平束 元周志洪

(1.中國計量大學信息工程學院,浙江省電磁波信息技術與計量檢測重點實驗室,浙江 杭州310018;2.上海市信息安全綜合管理技術研究重點實驗室,上海200240)

近年來,手勢識別受到了很多學者的廣泛關注[1-5],但基于機器視覺的手勢識別,尤其是在無約束環境下通過手部動作來控制智能機器[6]方面,仍然是一項具有挑戰性的任務。 在無約束環境下進行手勢識別時涉及的挑戰主要包括:手勢的自由度值較大[7]、自我遮擋、手部定位不準確和背景環境復雜等方面。 基于上述眾多因素的影響,無約束環境下手勢識別算法的綜合性能普遍不高,尤其是識別準確率方面,具有較大的提升空間。

手勢識別基于運動狀態可分為靜態手勢識別和動態手勢識別。 靜態手勢,是指每一種靜態形式的手部姿勢都分別表示某種特定的意義,即一張圖片代表一個手勢。 動態手勢是在一定的時間段內,由一組靜態手部姿勢形成的一個更為復雜的手勢來表示某種特定的意義,即一段視頻代表一個手勢。

基于傳統方法的手勢識別算法主要有:一種貝葉斯視覺注意模型[8]在檢測和識別靜態手勢時,將選擇性注意模型引入,且模擬了人體大腦視覺皮層的部分功能,然后使用支持向量機(SVM)分類器對手勢進行分類,該方法在NUSHP-II 手勢數據集上的準確率為94.36%;一種有效結合機器學習模型與模板匹配的方法[9],在作者的數據集上獲得了99.75%的基本手勢識別率以及100%的復雜手勢識別率;一組深度混合分類器[10],用于以自我為中心的手勢識別,在NUSHP-II 數據集的識別精度為97.72%;一種樸素貝葉斯分類器系統[11],在基于靜態手勢的協作機器人方面表現良好,其結果在不同的工作環境、距離、角度、不同大小的人等條件下產生了較好的魯棒性;一種融合表面肌電和加速度傳感信息的識別方法[12],對四路表面肌電與三軸加速度信號進行數據采集,通過支持向量機完成分類,在作者的數據集上達到了91.2%的識別率。

基于神經網絡的動態手勢識別算法主要有:文獻[13]提出了一種ResNet-10 輕型CNN 架構用于手勢檢測,提出了一種D-CNN ResNeXt-101 模型來對手勢進行分類,在EgoGesture 數據集和NVIDIA Dynamic Hand Gesture 數據集進行了手勢分類測試,準確度分別為94.04%和83.82%;一種融合了Masked Res-C3D 網絡和骨架LSTM 模型[14],并提出了一種通過權重融合層融合異常結果和分類模型缺陷的方案,用于RGB-D 視頻中的異常手勢識別,在IsoGD 數據集上識別率為68.42%。

基于神經網絡的靜態手勢識別算法主要有:一種使用CNN 的手勢識別[15],其背景減少技術用于去除建議手部區域的敏感背景,并獲得了95.96%的平均識別率;一種基于R-CNN 的手勢識別[16]產生了識別精度為99.4%,但平均一張圖像的識別計算時間為40 s,這在計算上是較為昂貴的;一種使用Faster R-CNN 對象檢測器為協作機器人建立的智能手勢識別[17],在作者自己的數據集上測試的平均準確度為91.94%,且平均一張圖像的識別計算時間為230 ms;一種通過遷移學習利用兩個天線的阻抗變化和深度卷積神經網絡對頻譜圖圖像對手勢進行分類[18],該方法在作者自己的數據集上準確度達到94.6%;一種帶有CPF 的Faster R-CNN 對象檢測器來找到RGB 圖像中手的準確位置[19],在Gloves 數據集上進行了測試,平均精度為95.51%。

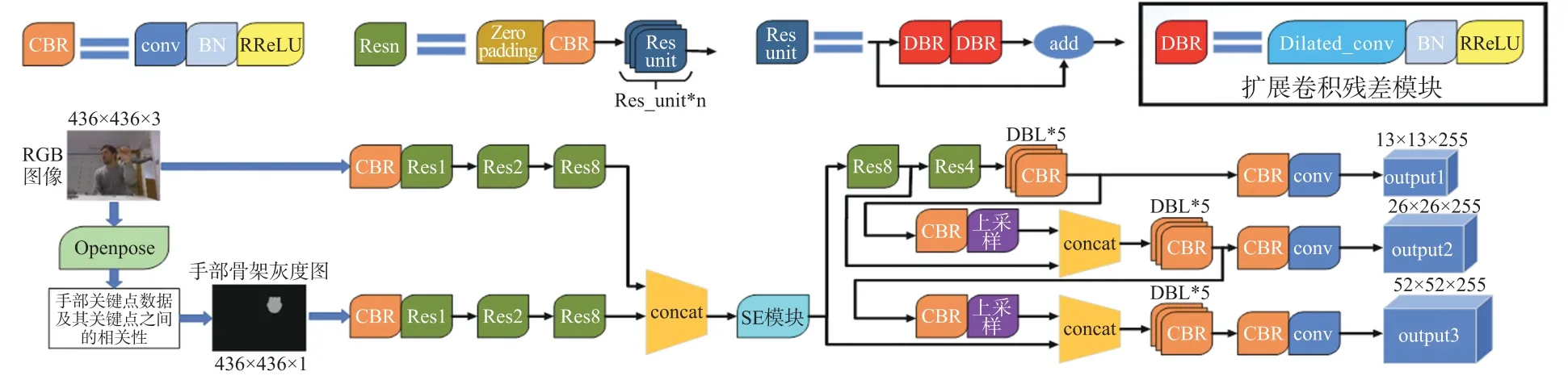

為解決在無約束環境下靜態手勢識別準確率不高的問題,本文提出了一種融合手部骨架灰度圖的深度神經網絡。 首先,構建了一種基于手部關鍵點及其相關性的手部骨架灰度圖作為網絡輸入。 當訓練網絡時僅輸入RGB 圖像,因圖像中的手容易受到無約束環境下燈光、自身手指間的遮擋以及背景顏色,尤其是自身膚色等方面的影響,導致網絡僅依靠通過RGB 圖像獲得的紋理,顏色和輪廓等特征信息無法實現更精準的手部檢測定位,從而進一步的導致靜態手勢識別在無約束環境下手部定位不準確且準確率不高的情況;而在輸入RGB 圖像的基礎上同時輸入手部骨骼灰度圖,并將兩者以增加通道的形式進行特征融合后,通過手部關鍵點及其相互間的連接信息增強手部圖像特征,增大手勢的類間差異,同時降低無約束環境對手勢識別的影響,以提高手部識別的準確率。 其次,在網絡結構方面,以yolov3[20]神經網絡作為主干網絡,將殘差模塊中的卷積替換為擴展卷積,通過增大卷積視野的方式來提高對手勢占畫面比較大情況下的準確率。 然后,在手部骨架灰度圖和RGB 圖像特征融合后,通過SE 模塊學習通道之間的相關性,自動學習每個特征通道的重要程度,對每個通道上的特征進行縮放,以增強兩張圖像之間的特征融合。 最后,采用RReLU激活函數來代替Leaky ReLU 激活函數,以提升網絡的魯棒性,從而降低無約束環境對靜態手勢識別的影響。

1 網絡結構

一種融合手部骨架灰度圖的深度神經網絡如圖1 所示:以yolov3 神經網絡為主干網絡,首先通過RGB 圖像經openpose 提取的手部數據來構建手部骨架灰度圖,并連同RGB 圖像一起輸入到網絡中;其次在多尺度模塊前以增加通道的形式將RGB 圖像的特征與手部骨架灰度圖進行特征融合,并一個通過SE 模塊學習通道之間的相關性,對每個通道上的特征進行縮放;然后將殘差模塊中的1?1 的卷積改成膨脹系數為2 的擴展卷積,3?3 的卷積改成膨脹系數為3 的擴展卷積;最后將激活函數由Leaky ReLU 函數改為RReLU 函數。

圖1 融合手部骨架灰度圖的深度神經網絡

2 手部骨架灰度圖構建

2.1 基于openpose 獲取手部骨架信息

卡內基梅隆大學在2017 年CVPR 會議上提出一種提取手部關鍵點的開源代碼[21], 簡稱openpose。 手部關鍵點名稱如表1 所示,手部骨架示意圖如圖2 所示,表1 中的序號分別對應圖2 中的關鍵點序號。 該算法的原理主要是利用立體幾何,以多視圖作為監督信號源,生成一致的手部關鍵點標簽,引導訓練手部關鍵點檢測器,輸出手部21個關鍵點歸一化后的二維坐標值及其對應的得分。

圖2 手部骨架圖

表1 openpose 手部關鍵點名稱

2.2 手部骨架灰度圖構建

提出的一種基于手部關鍵點信息和關鍵點之間相關性的手部骨架灰度圖,如圖3 所示,是在openpose 輸出的基礎上,將歸一化后21 個手部關鍵點位置坐標值(x,y)及其對應關鍵點得分的輸出文件進行如下計算和處理所得。

圖3 部分手勢的GHS 圖像

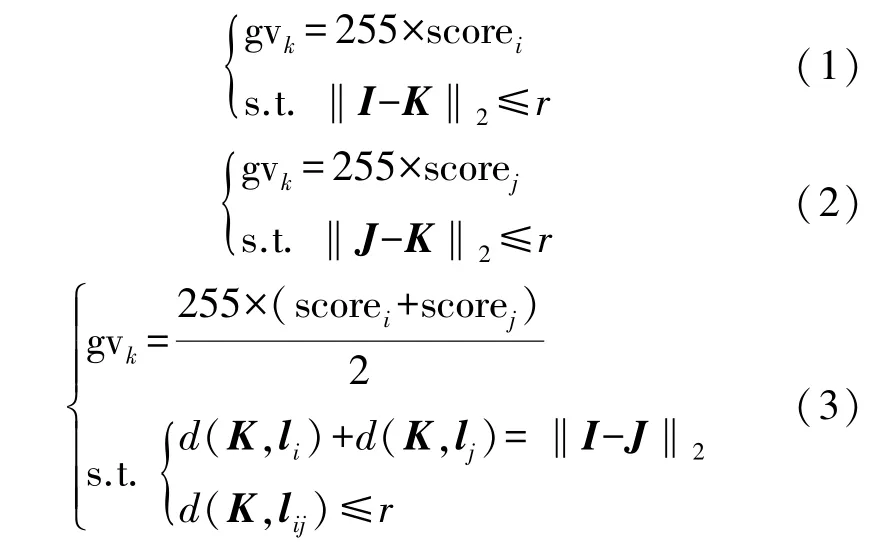

首先,按照原圖的像素級寬高進行還原,以便在原圖像上定位。 然后以關鍵點為圓心,r個像素點為半徑畫圓,所得的圓內所有像素點的灰度值,均為關鍵點得分乘以255。 最后,關鍵點之間的關聯性表現在以上述圓的直徑為寬,關鍵點之間歐式距離為長,構成的長方形內所有像素點的灰度值為兩個關鍵點的平均得分乘以255。 手部骨架灰度圖的其他像素點的灰度值均置為0。 上述計算如式(1)~式(3)所示:

式中:gv 表示灰度值,k表示第k個像素點,score 表示關鍵點得分,i和j分別表示第i和j個關鍵點,I、J和K分別表示對應關鍵點在原圖像上的坐標值(x,y),I-K2表示求兩個坐標點之間的歐式距離;d(K,li)表示求點K到直線li之間的距離,lij表示過點I和J的直線,li表示過點I且與直線lij垂直的直線,lj表示過點J且與直線lij垂直的直線。

2 SE 模塊

SE 模塊[22]是2018 年由來自Momenta 的高級研發工程師胡杰及其所在WMW 團隊在CVPR 會議上提出的,模塊的網絡結構如圖4 所示,其中e 是一個縮放參數,目的是為了減少通道數從而降低計算量。 該模塊的組成有3 個部分,分別是Squeeze 操作、Excitation 操作和Scale 操作。

圖4 SE 模塊網絡結構

Squeeze 操作如式(4)所示,利用全局的池化,將大小為C×H×W的輸入特征綜合為C×1×1 的特征描述,其中C為通道數,H和W分別為圖像的高寬。

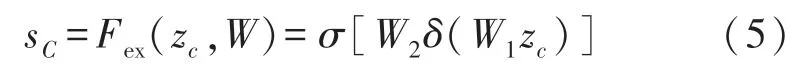

Excitation 操作如式(5)所示,先利用一個全連接層操作將W1和zc相乘,其中W1的維度是(C/r)×C,再經過一個ReLU 層,輸出的維度不變;然后再將結果和W2相乘,且和W2相乘也是一個全連接層的過程,W2的維度是C×(C/r),因此輸出的維度就是1×1×C;最后再經過sigmoid 函數,得到s。

式中:δ和σ分別表示第一次全連接操作和第二次全連接操作。

Scale 操作如式(6)所示,即把uc矩陣中的每個值都乘以sc,其中uc是一個二維矩陣特征圖,sc是權重系數,YC表示結合了權重之后SE 模塊的最終輸出。

3 改進yolov3 原激活函數

3.1 Leaky ReLU 激活函數

Yolov3 中使用的激活函數是Leaky ReLU 激活函數,作用在于對網絡的上一層節點輸出做非線性轉換,同時解決神經網絡的梯度消失問題。 相較于ReLU 激活函數,Leaky ReLU 是給所有負值賦予一個非零斜率,其計算如式(7)所示:

式中:xi表示函數輸入,yi表示函數輸出,ai表示一個在(0,1)區間內的一個固定參數。 由于在訓練過程中ai是固定不變的,從而限制了網絡在無約束環境下的魯棒性。

3.2 RReLU 激活函數

RReLU 激活函數,是在Leaky ReLU 激活函數的基礎上,將負值的斜率在訓練中變為隨機的值,即ai是從一個均勻的分布中隨機抽取的數值,但在測試環節就會固定下來。 RReLU 激活函數如式(8)所示:

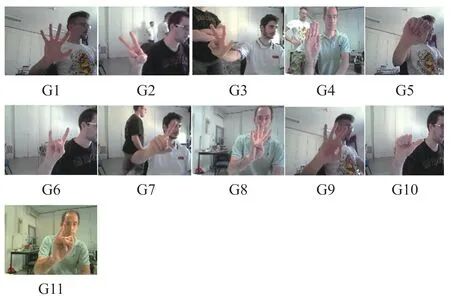

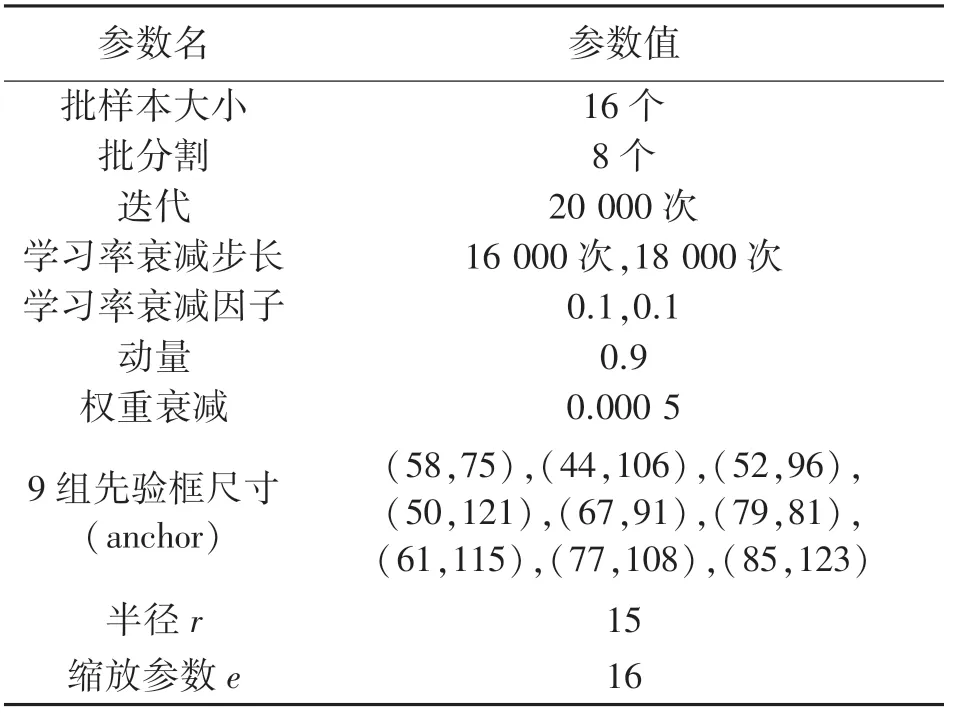

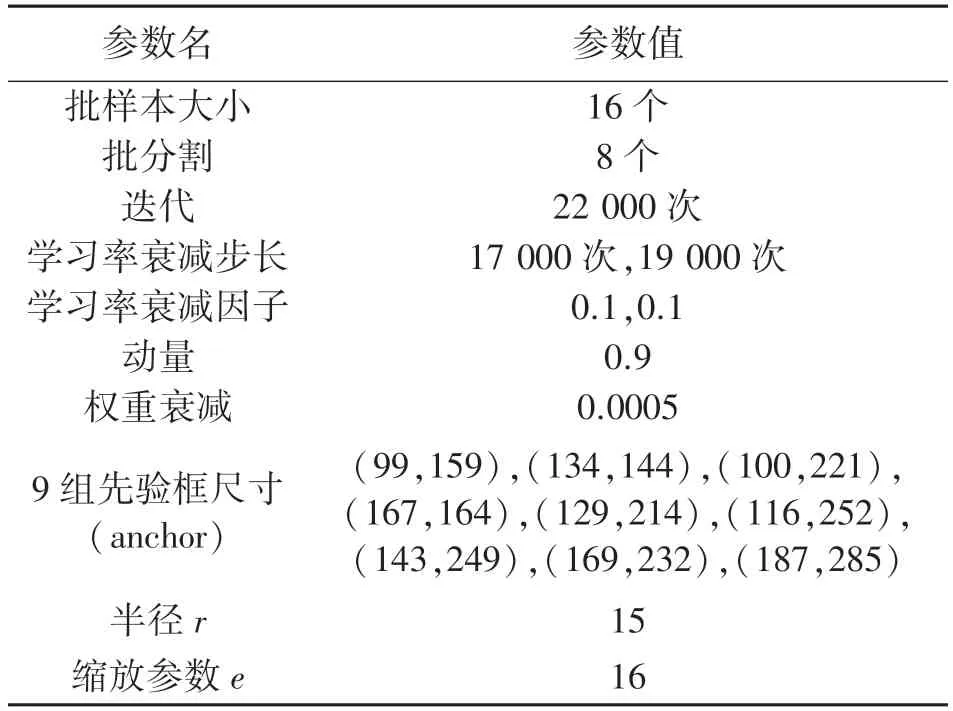

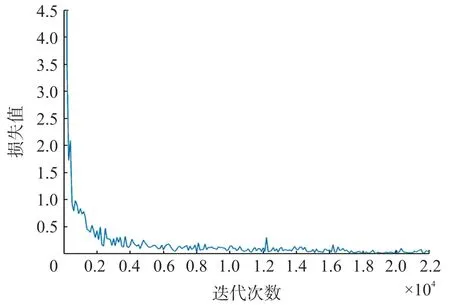

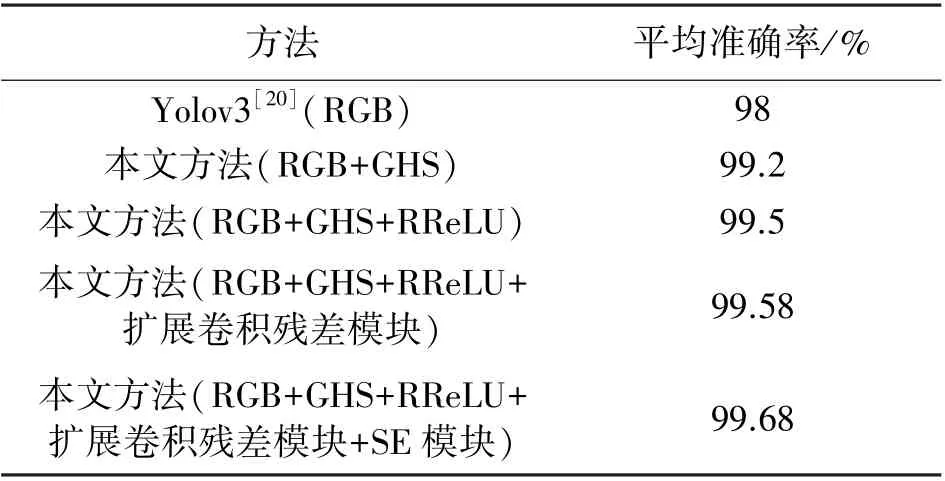

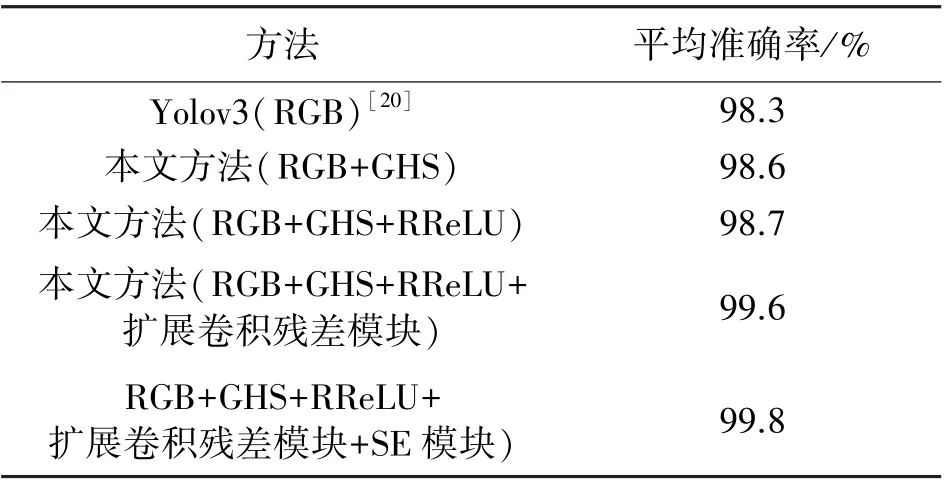

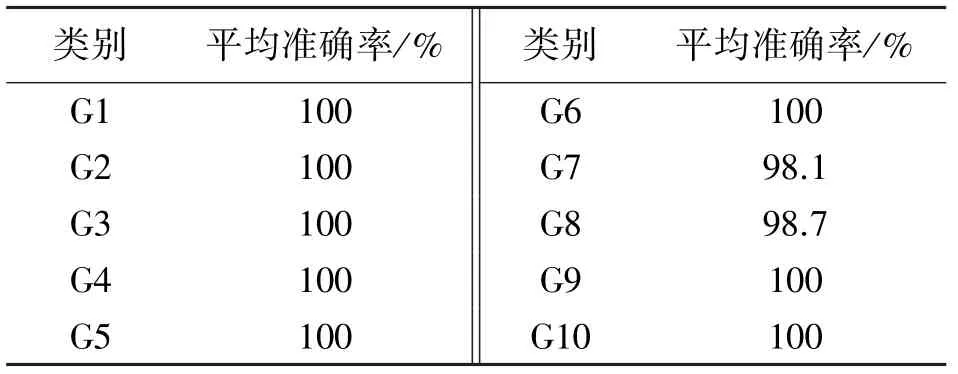

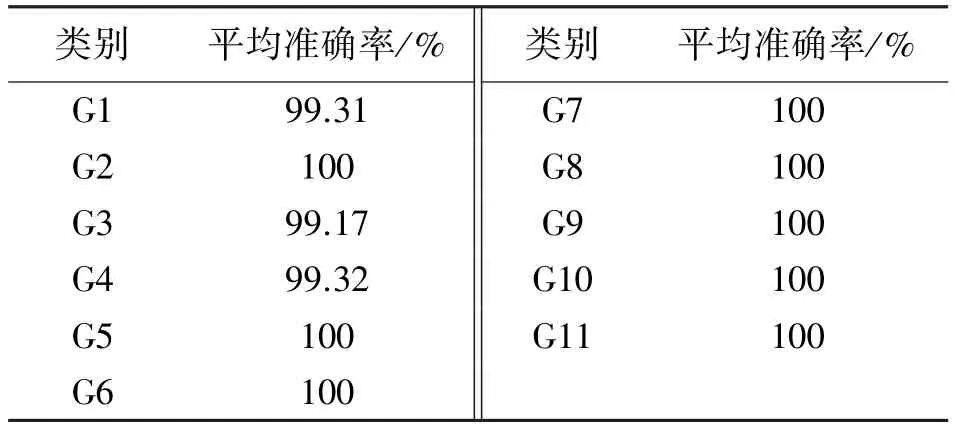

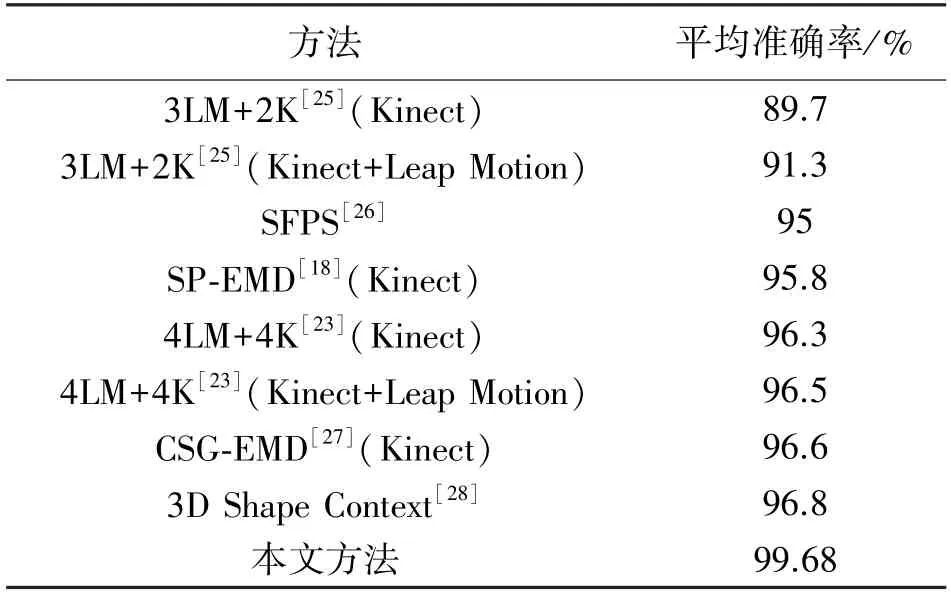

式中:ai∈U(l,u),l Yolov3 網絡引入了FPN 結構,同時它的檢測層由三級特征層的融合,直接將淺層網絡所得的特征與深度卷積后的特征進行融合,這樣的結構解決了其他部分網絡(例如SSD 模型)最后一層自動篩掉小物體的問題,提高了小物體的識別能力,從而提高了在手部占畫面比較小情況下的手勢識別精度。 且Yolov3 網絡模型的識別速度達到了較高的實時水平,而本文因手部骨架灰度圖的提取需要一定時間,所以以Yolov3 為主干網絡后可一定程度上保證了本文提出的手勢識別網絡模型的識別速度。 4.1.1 Microsoft Kinect & Leap Motion 數據集 Microsoft Kinect & Leap Motion 數據集[23]包含RGB 數據、深度數據和Leap Motion 數據。 該數據集包含由14 個不同的人分別做10 種不同的手勢,并且每個人對每個手勢重復做10 次,總共有1 400個不同的數據樣本。 對應10 個手勢的RGB 圖像圖5所示,例如拳頭,“Yes”、數字以及小拇指等。 圖5 Microsoft Kinect & Leap Motion 數據集RGB 手勢圖像示意圖 4.1.2 Creative Senz3D 數據集 Creative Senz3D 數 據 集[24]是 通 過 Creative Senz3D 相機獲取的。 該數據集包含4 個不同的人執行的11 個不同的手勢,同時每個人將每個手勢分別重復30 次,總共進行了1 320 次采集。 對應11個手勢的RGB 圖像圖6 所示,例如拳頭,數字1 至5 等。 圖6 Creative Senz3D 數據集RGB 手勢圖像示意圖 所有的訓練和測試均在臺式電腦上進行,電腦的主要配置為Intel(R)Core(TM)i5-8400 CPU @2.80 GHz、6GB 的GPU NVIDIA GeForce GTX 1060顯卡和8GB 的運行內存。 程序在Windows10 系統下運行,同時調用并行計算架構(CUDA)、英偉達神經網絡庫(Cudnn)、開源計算機視覺庫(OPENCV)。模型訓練時使用官網提供預訓練權重文件來初始化本文的網絡權重參數,以便訓練時加快模型的收斂速度。 在yolov3 中,由于適合的先驗尺寸將會直接影響到靜態手勢識別時的速度以及目標框在定位時的精度,因此對所有訓練樣本數據集上標注出的邊界框數據采用K-means 聚類來獲得最優的9 組先驗框尺寸。 具體訓練參數值如表2 和表3 所示。 其中,參數半徑r用于構建手部骨架灰度圖,縮放參數e用于SE 模塊的通道數縮放。 表2 Microsoft Kinect & Leap Motion 數據集的訓練參數設置 表3 Creative Senz3D 數據集的訓練參數設置 圖7 Microsoft Kinect & Leap Motion數據集訓練時損失曲線圖 在Microsoft Kinect & Leap Motion 數據集上,最終模型共訓練20 000 次,耗時29 h。 訓練模型時,從14 個人中隨機抽取10 個人作為訓練數據,即訓練數據集共1 000 張RGB 圖片和1 000 張對應的手部骨架灰度圖,剩余的4 個人的400 張RGB 圖像和400 張對應的手部骨架灰度圖作為測試數據集。 在訓練過程中,通過繪制模型損失曲線觀察訓練動態過程,其對應的損失值變化曲線如圖7 所示。 可看出:模型在前期迭代中損失值縮減迅速,模型快速擬合;當迭代訓練4 000 次后,損失值下降放緩;當迭代至20 000次時,損失值收斂至0.010 3,結束訓練在Creative Senz3D 數據集上,最終模型共訓練22 000 次,耗時25 h,訓練模型時,按照不同的手勢執行人采用留一法將數據分為訓練數據集和測試數據集。 訓練數據集由3 個人共990 張RGB 圖片和990 張對應的手部骨架灰度圖,剩余的1 個人的330 張RGB 圖像和330 張對應的手部骨架灰度圖作為測試數據集。 在訓練過程中,通過繪制模型損失曲線觀察訓練動態過程,其對應的損失值變化曲線如圖8 所示。 可看出:模型在前期迭代中損失值快速縮減,模型快速擬合;當迭代訓練4 400 次后,損失值下降放緩;當迭代至22 000 次時,損失值收斂至0.021 5,結束訓練。 圖8 Creative Senz3D 數據集訓練時損失曲線圖 本文提出的一種融合手部骨架灰度圖的深度神經網絡,每一步改進分別在Microsoft Kinect & Leap Motion 數據集上測試結果如表4 所示,在Creative Senz3D 數據集上測試結果如表5 所示。 該網絡算法在Microsoft Kinect & Leap Motion數據集上每一類的準確率情況,具體如表6 所示,其中除G7 和G8 的準確率分別為98.1%和98.7%,其他類別準確率均達到了100%。 在Creative Senz3D數據集上每一類的準確率情況,具體如表7 所示,其中除G1、G3 和G4 的準確率分別為99.31%、99.17%和99.32%,其他類別準確率均達到了100%。 表4 每一步改進在Microsoft Kinect & Leap Motion數據集上的測試結果 表5 每一步改進在Creative Senz3D 數據集上測試結果 表6 Microsoft Kinect & Leap Motion 數據集上10 類的測試結果 表7 Creative Senz3D 數據集上11 類的測試結果 不同的手勢識別方法以及yolov3 在Microsoft Kinect & Leap Motion 數據集上測試結果如表8 所示。 通過對比可以清晰的看出,本文提出的方法比其他方法在平均準確率上至少提高了2.88%,且基于GHS 圖像和RGB 圖像的手勢識別速度為26 fps。 表8 不同算法在Microsoft Kinect & Leap Motion數據集上的測試結果 不同的手勢識別方法以及yolov3 在Creative Senz3D 數據集上測試結果如表9 所示。 通過對比可以清晰的看出,本文提出的方法比其他方法在平均準確率上至少提高了0.2%,且基于GHS 圖像和RGB 圖像的手勢識別速度為31 fps。 表9 不同算法在Creative Senz3D 數據集上的測試結果 通過上述實驗結果表格的對比,說明無約束環境下靜態手勢在識別過程中,使用手部關鍵點及其相互關聯性構建手部骨架灰度圖,以yolov3 為主干網絡,添加擴展卷積殘差模塊和SE 模塊,并用RReLU 函數作為激活函數的方法在識別準確率上有著較大的提升。 該方法在Microsoft Kinect & Leap Motion 數據集和Creative Senz3D 數據集上均進行了測試對比實驗,相比其他靜態手勢識別方法,本文提出的識別方法在這兩個無約束環境下的靜態手勢數據集有著優秀的表現。 在Microsoft Kinect & Leap Motion 數據集和Creative Senz3D 數據集上準確率均達到了最高,分別為99.68%和99.8%,且基于GHS 圖像和RGB 圖像的手勢識別速度分別為26 fps 和31 fps。 手勢識別在空間定位方面依舊有著不小問題。如今的手勢識別算法距離理想的空間定位能力,即得到手部的精準位置還有著不小的差距,而其也正是未來人機交互的重要基礎。 同時,本文提出的解決方法仍未能完全解決對應的挑戰和難點,尤其在網絡延遲和實時性方面依舊有著較大的提升空間。3.3 Yolov3 為主干網絡

4 實驗

4.1 實驗數據集介紹

4.2 實驗參數設置

4.3 在Microsoft Kinect & Leap Motion 數據集和Creative Senz3D 數據集上實驗結果分析

5 結論