基于注意力機制與特征融合的圖像超分辨率重建

王詩言,曾 茜,周 田,吳華東

(重慶郵電大學通信與信息工程學院,重慶 400065)

0 概述

圖像處理技術快速發展,而人們對圖像質量的要求也逐漸提高,如何獲取高質量的圖像成為迫切需要解決的問題。單幅圖像超分辨率重建(Single Image Super-Resolution,SISR)指由低分辨率(Low-Resolution,LR)圖像恢復出高分辨率(High-Resolution,HR)圖像,該技術目前已被廣泛應用于計算機視覺、醫學成像、衛星圖像和視頻安全監控等多個領域。

目前,圖像超分辨率重建方法主要有基于插值、基于重建和基于學習[1-2]三類。DONG 等人提出端到端卷積神經網絡SRCNN 來學習LR 和HR 圖像之間的映射關系[3]。SRCNN 體現了卷積神經網絡(Convolutional Neural Network,CNN)在特征提取和表示方面的優越性,該網絡結構可被看作是傳統稀疏編碼方法的擴展。此后,DONG 等人又提出了快速超分辨率卷積神經網絡FSRCNN[4],通過在網絡末端使用反卷積層,有效地獲取了原始圖像中的高頻信息。隨著卷積神經網絡深度的不斷增加,網絡訓練的難度也越來越大。針對這一問題,HE 等人提出了殘差神經網絡(Residual Neural Network,ResNet)[5],通過引入殘差學習的思想加速網絡的收斂。在此基礎上,KIM 等人提出了深度卷積網絡VDSR[6]。通過對殘差學習的利用,該網絡使用了20個卷積層,有效增加了網絡深度。為減少網絡參數數量,KIM 等人進一步提出了深度遞歸卷積網絡(Deeply-Recursive Convolutional Network,DRCN)[7],通過使用遞歸結構,引入遞歸監督和跳躍連接。為解決實時超分辨率重建問題,SHI 等人提出一種高效的亞像素卷積神經網絡(Efficient Sub-Pixel Convolutional Neural Network,ESPCN)[8],利用亞像素卷積的上采樣方式實時恢復HR 圖像。LEE 等人提出了增強深度殘差網絡(Enhanced Deep Residual Network,EDSR)[9],刪除了批規范化(Batch Normalization,BN)操作,并大規模增加了每一層的輸出特性。通過設計有效的網絡結構,卷積神經網絡在圖像超分辨率重建中取得了優于傳統方法的效果。

圖像非局部特性在傳統方法中得到了廣泛使用[10-11],然而多數基于CNN 的超分辨率重建方法并沒有充分利用圖像固有的這一特征,并且集中于設計更深或更廣的網絡來學習更多的圖像特征,較少利用高階的特征統計量,而文獻[12]表明,圖像的高階特征比一階特征更具表征力。此外,多數基于CNN 的超分辨率重建方法只在單一尺度下提取圖像特征,忽略了不同尺度下的圖像細節信息。

針對上述問題,本文設計一種基于注意力機制和多尺度特征融合的網絡結構。利用淺層特征提取模塊提取圖像原始特征,在注意力機制和多尺度特征融合模塊中,通過注意力機制對圖像的非局部特性和二階統計特征進行融合,利用多尺度特征提取模塊獲取不同尺度下的圖像特征信息。在此基礎上,將提取到的深度特征通過重建模塊實現圖像重建。

1 相關工作

1.1 非局部先驗

圖像的非局部特征在傳統圖像重建領域中得到了廣泛使用,其基本原理是在整幅圖像中搜索相似的圖像塊,進而利用這些相似圖像塊所提供的互補信息來進行圖像重建。BUADES 等人提出一種基于圖像中所有像素的非局部平均操作來提高圖像去噪能力的方法[10],對于某一個圖像塊,在整幅圖像范圍內搜索與之相似的圖像塊,然后根據圖像塊之間的相似性對不同的圖像塊賦予不同的權值,加權平均后得到去噪圖像塊,即圖像非局部去噪方法。非局部思想是一種經典的計算機視覺方法,其在神經網絡中具有廣闊的應用前景。WANG 等人提出的非局部神經網絡(Non-Local Neural Networks,NLNN)[13]可以很好地捕捉到較遠位置像素點之間的依賴關系,由此將非局部操作融入到用于視頻分類的非局部卷積神經網絡中。

1.2 注意力機制

近年來,注意力機制被廣泛應用于深度神經網絡。上文提到的的NLNN,也是注意力機制的一種應用。HU 等人提出SENet[14]來學習信道間的相關性,通過網絡的全局損失函數自適應地重新矯正通道之間的特征相應強度,該網絡結構在圖像分類方面較傳統方法取得了顯著的性能改進。WOO等人設計的提卷積塊注意模塊(Convolutional Block Attention Module,CBAM)[15]結合了空間和通道的注意力機制,相比于SENet 只關注通道的注意力機制可以取得更好的效果。ZHANG 等人將注意力機制引入超分辨率重建任務中[16],通過注意力機制來區別對待不同的通道,從而提高網絡的表征能力。然而,這些網絡只關注了圖像的一階特征(如全局平均池化),忽略了圖像的高階信息特征。DAI 等人證明二階統計量能夠更好地捕捉圖像特征[17],并設計一個二階注意力網絡(Second-Order Attention Network,SAN),通過考慮比一階更高的特征統計量來自適應地利用信道特征。

2 融合注意力機制與多尺度特征的網絡結構

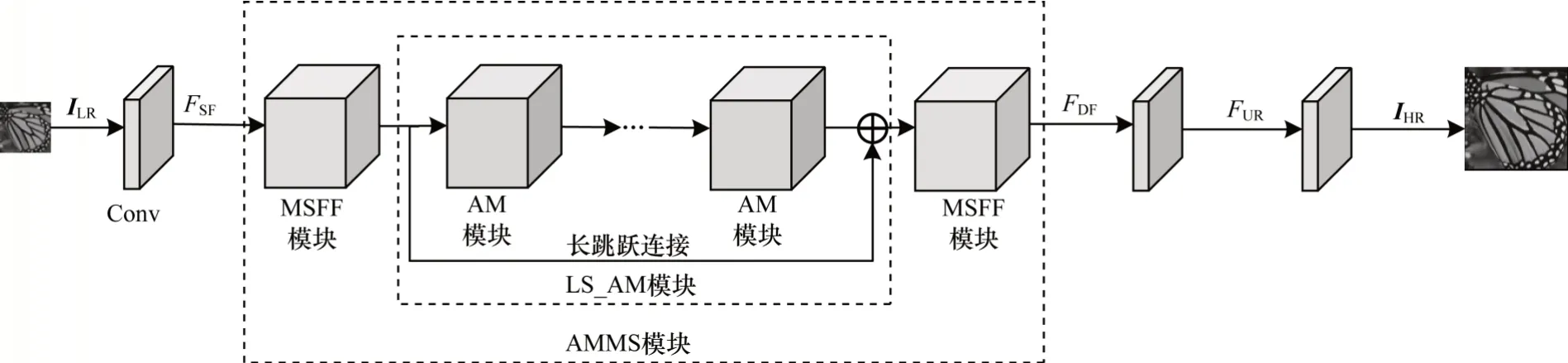

如圖1 所示,本文設計的網絡結構包含淺層特征提取(Shallow Feature extraction,SF)、深度特征提取(Deep Feature extraction,DF)和重建(Reconstruction,RE)3 個模塊。

圖1 本文設計的網絡結構Fig.1 The network structure designed in this paper

2.1 淺層特征提取模塊

令ILR表示輸入圖像,IHR表示輸出圖像。首先通過一個3×3 的卷積核來提取淺層特征FSF:

其中,HSF(·)表示卷積操作,WSF表示濾波器權重項,BSF為偏置項,f表示激活函數。本文采用ReLU 作為激活函數,其數學表達式為:

2.2 深度特征提取模塊

在深度特征提取模塊,提取到的淺層特征FSF經過注意力機制與多尺度特征融合模塊(AMMS)進行深度特征提取:

其中,HAMMS(·) 表示AMMS 模塊操作。對于AMMS模塊,由圖1 可見,其由兩個多尺度特征融合模塊(MSFF)和一個LS_AM 模塊構成。下文將對這兩個模塊分別進行介紹。

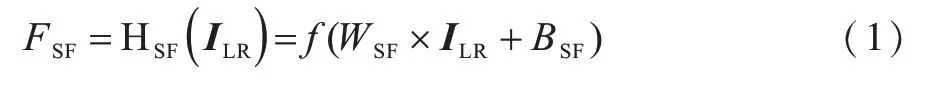

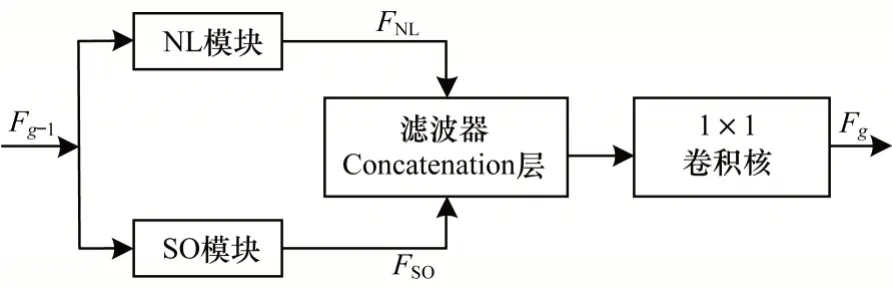

2.2.1 MSFF 模塊

在圖像超分辨率重建中,需要在不同的特征尺度上進行特征信息提取。然而目前多數算法都只使用單一的卷積核進行特征提取。但實際上,圖像的特征信息通常是不同尺度的,單一的卷積核只能提取單一的尺度特征,這樣就會導致丟失多尺度下完整的特征信息。受GoogleNet 結構的啟發,本文通過一個多尺度特征融合模塊(MSFF)來提取不同尺度的信息特征,以更好地獲取圖像的結構信息。如圖2所示,MSFF 模塊主要由多尺度特征提取層、特征融合層和降維層3 個部分組成。

圖2 多尺度特征融合模塊結構Fig.2 Structure of multi-scale feature fusion module

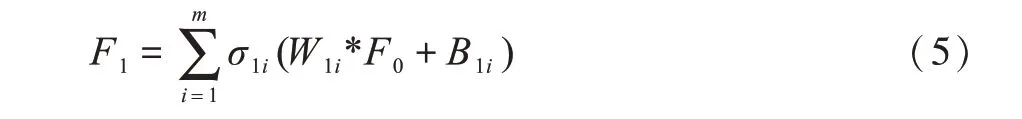

對于多尺度特征提取層,采用3 個尺度的卷積核,分別為1×1、3×3、5×5。其中,1×1 的卷積核能夠保留上一層的特征并與其他尺度的特征融合,使得網絡包含與淺層特征相關的信息特征。在每個卷積核后采用一個非線性層提高模塊的非線性映射能力。用F0表示多尺度特征融合模塊中的輸入特征,則經過該多尺度特征提取后的特征表示為:

其中,W1i和B1i分別表示第i個卷積核的權重和偏置項,*表示卷積操作,σ1i表示ReLU 非線性操作,數學表達式同式(2)。

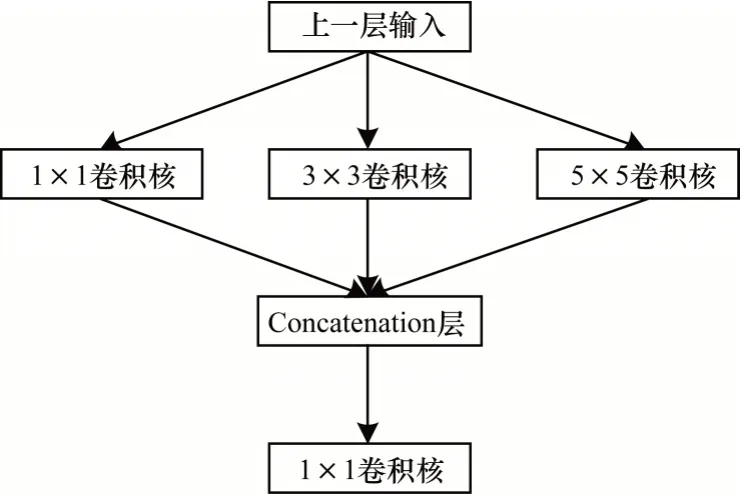

在提取到多尺度特征之后,需要對其進行特征融合。此處采用Concatenation 層將各個尺度下的特征圖進行疊加,如圖3 所示。

圖3 Concatenation 層融合原理Fig.3 Fusion principle of Concatenation layer

假設上述多尺度特征提取層包含m個卷積層,則該多尺度特征融合層表示為:

降維層的主要作用是降低Concatenation 層的維度,其包含一個1×1 的卷積核。1×1 的卷積核可保持Concatenation 層的所有特征信息,同時由于其通道數較少,因此卷積得到的多尺度特征圖也會減少。多尺度特征融合模塊的數學表達式如下:

其中,W2和B2分別表示降維層中卷積核的權重和偏置項。

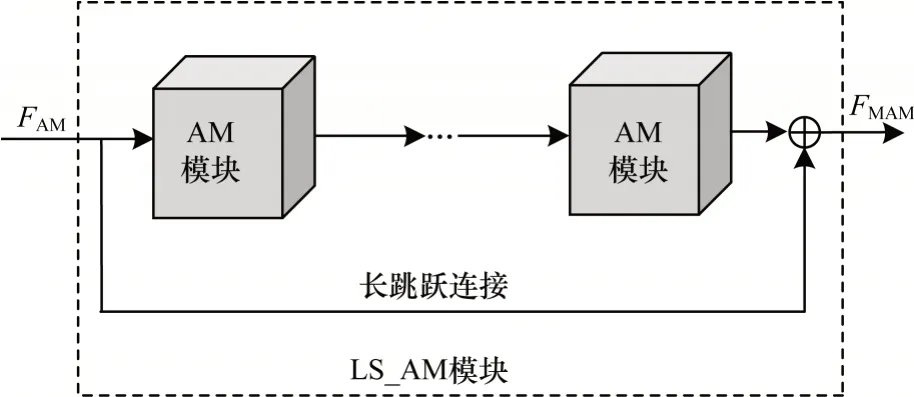

2.2.2 LS_AM 模塊

LS_AM 模塊結構如圖4 所示,其由M個注意力機制模塊(AM)和長跳躍連接(Long Skip Connection,LSC)構成。

圖4 LS_AM 模塊結構Fig.4 Structure of LS_AM module

分別用FAM和FMAM表示LS_AM 模塊的輸入和輸出特征:

其中,HLS_AM()表示基于M個AM 模塊和長跳躍連接的LS_AM 模塊操作,HM_AM()表示M個AM 模塊操作,WLSC()表示長跳躍連接操作。LSC 不僅能夠穩定網絡訓練,而且其通過傳遞低頻圖像也豐富了低頻信息特征。

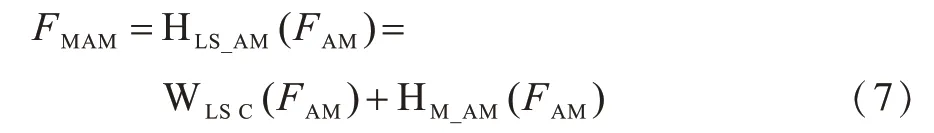

注意力機制模塊結構如圖5 所示,其通過兩種方式提取圖像特征,即非局部提取(NL)和二階特征提取(SO),最后將提取到的特征進行融合,作為每一個注意力單元模塊的輸出。

圖5 注意力機制模塊結構Fig.5 Structure of diagram of attention mechanism module

以Fg-1和Fg分別表示第M個注意力模塊中的輸入和輸出特征圖。非局部和二階特征提取操作是同步進行的,對于非局部特征提取分支,有:

其中,HConv_NL(·)表示非局部特征提取操作,FNL表示經過該操作得到的特征圖。對于二階特征提取分支,有:

其中,HConv_SO(·) 表示二階特征提取操作,FSO表示經過該操作得到的特征圖。

為充分利用非局部和二階特征信息,采用Concatenation 層進行特征融合(其原理同2.2.1 節),則非局部和二階特征融合表示為:

其中,Hff()· 表示Concatenation 操作。此外,一個1×1的卷積層被用于Concatenation 層的后面,這種卷積操作有利于減少特征圖的參數量,以此減少計算損失。

通過注意力機制模塊得到的特征Fg可以表示為:

其中,HAM(·)表示基于非局部及二階特征融合的注意力模塊操作。通過特征融合操作,非局部和二階特征提取是同步執行的,因此,可以有效地利用圖像的固有屬性特征提高網絡的性能。

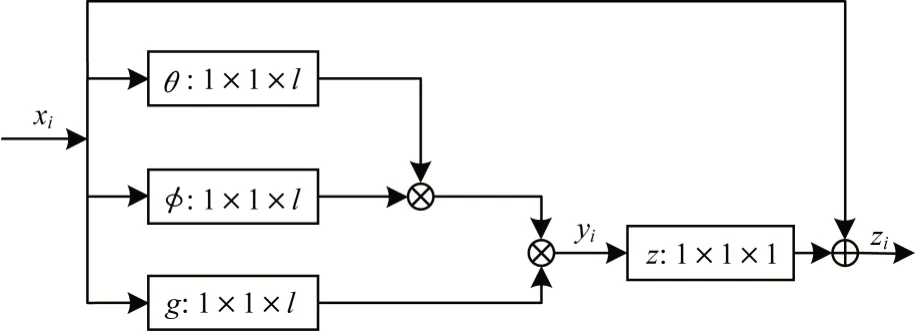

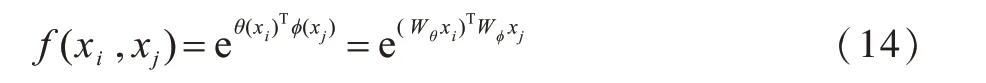

1)非局部操作

圖像的非局部特性作為先驗信息,可以提供自然圖像中豐富的結構信息。本文利用圖像的自相似性,將非局部操作合并到CNN 中計算整個圖像的特征相關性。非局部操作過程如圖6 所示。

圖6 非局部操作過程Fig.6 Process of non-local operation

深度神經網絡中的非局部操作可以表示為:

其中,x表示輸入圖像,y表示同x大小一樣的輸出圖像,i代表輸出特征位置索引,j代表全圖中所有可能位置的枚舉索引,函數f(xi,xj)用來計算xi和xj的相關性,函數g(xj)是對特征xi的變換函數,用來計算輸入圖像在位置j的表示。文獻[11]中詳細討論了f和g的幾種形式,此處考慮g(xj)為線性的情況,即:

其中,wg是一個可學習的權重矩陣。本文考慮f為embedded Gaussian,即:

其中,Wθ、Wφ表示可學習的權重項。非局部模塊計算公式為:

其中,Wz表示可學習得到的參數矩陣,+xi表示殘差連接,yi表示非局部算子。該非局部操作可以看作是一個殘差模塊,其能夠在不影響原始網絡結構的基礎上,方便地嵌入到網絡框架中,與網絡一起訓練。因此,整個非局部操作與網絡一起通過反向傳播進行參數更新,不會對反向傳播訓練產生影響。

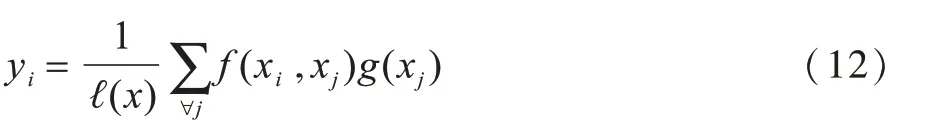

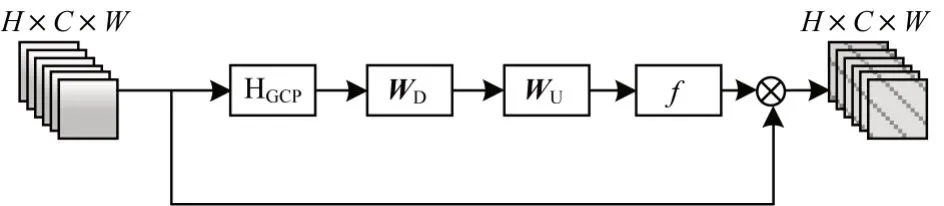

2)二階特征提取

文獻[12]表明,高階特征比傳統的一階特征包含更多的統計特征,而傳統的卷積和全局平均池化操作只能提取圖像的一階特征。因此,受文獻[15]的啟發,本文通過全局協方差池化(Global Covariance Pooling,GCP)操作來提取圖像的二階統計特征,如圖7 所示。

圖7 二階特征提取操作過程Fig.7 Process of second-order feature extraction operation

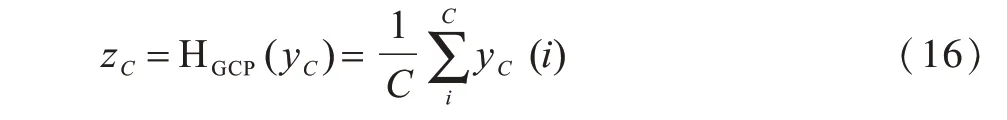

首先通過GCP 濾波器來提取二階統計特征,則第C維的特征統計量為:

其中,HGCP(·) 表示全局協方差池化操作,yC表示輸入特征,yC(i) 表示在位置i處的輸入特征。為充分利用特征間的相關性,借鑒文獻[14]方法,本文使用門函數來更好地提取特征:

其中,WU和WD是可學習得到的權重矩陣。此處WU、WD被分別設置為=4、C=64,f(·)、δ(·) 分別為Sigmoid 和ReLU 函數。利用Sigmoid 函數將其縮放到0 到1 之間,對特征圖進行重新校準,將校準后的特征圖與原來每個通道的特征圖的值對應相乘。最后,得到的信道特征表示為:

其中,sC和xC分別表示尺度因子和第C維的信道特征。

2.3 重建模塊

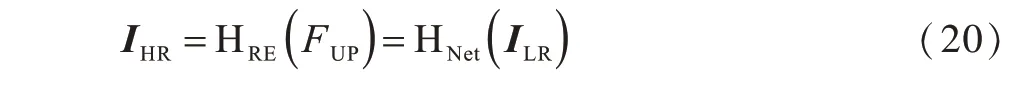

在重建模塊,得到的深度特征首先經過上采樣模塊,如式(19)所示:

其中,HUP(·) 表示上采樣操作。對于上采樣操作的選擇,有基于插值、基于反卷積、基于亞像素卷積等操作,但是用以上方法訓練網絡需要固定縮放因子,即一個放大因子對應訓練一個模型。HU 等人提出的Meta-SR 模型[18],通過輸入一系列與縮放因子及坐標相關的向量,可動態地預測不同數量的卷積濾波器權重,其根據縮放因子和坐標偏移量因子求出相應的映射參數,通過卷積便可獲得最終的超分辨率圖像。因此,本文使用該模型中的Meta-Upscale模塊替代傳統上采樣操作,利用單一模型將特征圖放大任意縮放因子。

將得到的上采樣特征FUP經過一個卷積層進行重建,得到最后的超分辨率重建圖像:其中,HRE(·)表示重建操作,其通過卷積便可獲得最終的超分辨率圖像,HNet(·)表示本文設計的網絡結構。

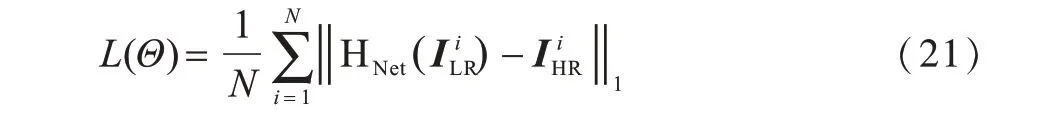

2.4 損失函數

本文采用均方誤差(Mean Square Error,MSE)作為損失函數,則網絡優化目標表示為:

其中,Θ表示網絡中所有的參數表示通過本文網絡結構得到的高分辨率圖像分別表示第i對重建圖像和原始的高分辨率圖像。

3 實驗結果與分析

3.1 數據集

本文采用Timofte 數據集[19]中的91 幅圖像以及BSD 數據集中的BSD200[19]作為訓練集。在Set5[20]、Set14[21]和BSD100[19]標準數據集上進行測試,這三個數據集通常用于圖像超分辨率重建。其中:Set5 數據集包含動植物圖像;Set14 包含動植物和景物圖像,比Set5 具有更多的細節信息;BSD100 數據集包含城市建筑圖像,其邊緣信息多,重構難度也較大。為與其他重建方法進行比較,本文采用PSNR和SSIM 指標來評價重建質量。沿用現有的方法,只對YCbCr 顏色空間中的亮度通道(Y 通道)進行超分辨重建,為便于顯示,另外兩個色度通道使用與其他方法相類似的雙三次插值算法。

3.2 訓練細節

本文通過最小化損失函數訓練網絡,以ADAM optimizer[22]作為優化方法,其中,β1=0.9,β2=0.99,ε=10-8。初始學習率設為10-4,然后每迭代2×105次,學習率減少一半。本文提出的網絡模型是在NVIDIA GTX 1080 GPU 上使用Tensorflow 框架實現的。對于非局部和二階特征操作,選取1×1 的卷積核進行卷積操作,同時用零填充特征圖的邊界,以保持特征圖的大小。對于上述操作以外的卷積核,設定其大小為3×3,濾波器個數C=64。設置注意力機制模塊的個數M=20。

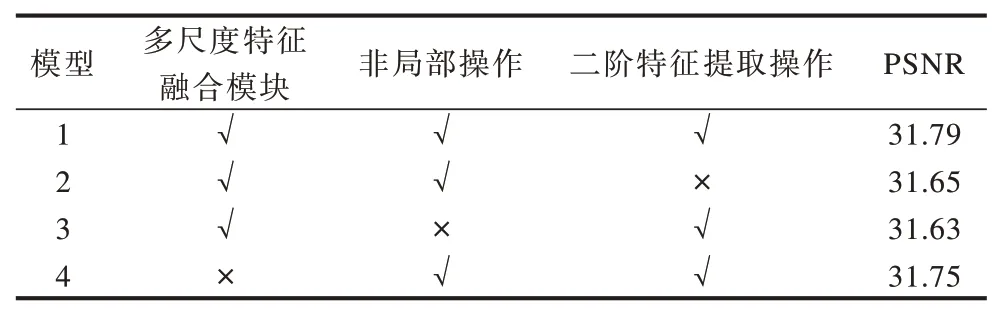

3.3 網絡結構

為研究注意力機制(包含非局部及二階特征提取操作)以及多尺度特征融合模塊對網絡結構的影響,本文引入消融學習的思想,以尺度因子factor=4為例,在Set5 數據集上比較以上模塊對PSNR 平均值的影響。由表1 可以看出,同時使用注意力機制以及多尺度特征融合的模型PSNR 值最高。

表1 Set5 上不同模塊構成模型的PSNR 平均值Table 1 Average PSNR for the models with different module compositions on Set5dB

3.4 實驗比較

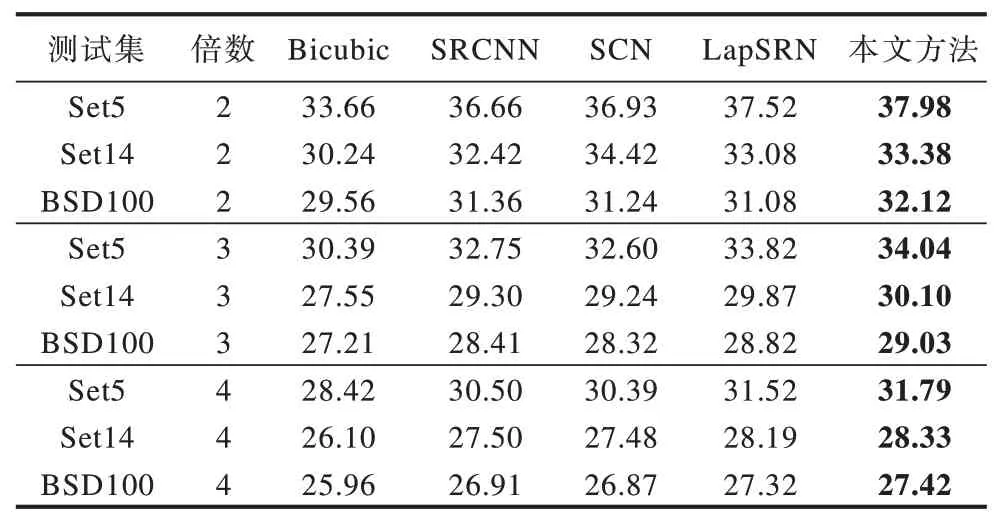

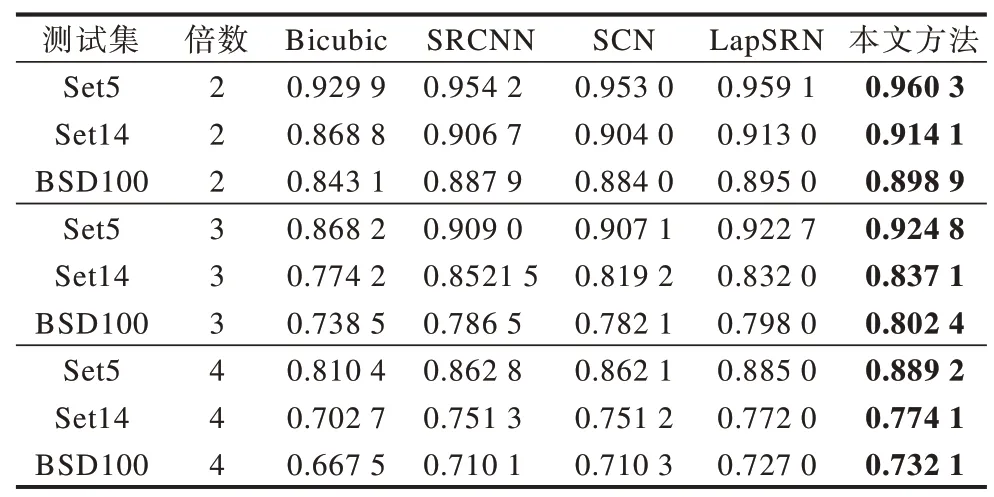

將本文提出的網絡結構與Bicubic、SRCNN[3]、SCN[23]、LapSRN[24]4 種圖像超分辨率重建方法進行比較。SRCNN 模型具有三層卷積結構,其將一個低分辨率圖像通過雙三次插值放大到目標大小作為網絡輸入。SCN 模型在SRCNN 三層結構的基礎上結合了傳統的稀疏編碼思想,該模型具有五層卷積結構。LapSRN 模型在網絡中融入了拉普拉斯金字塔模型的思想,該模型具有24層網絡結構。Bicubic方法使用Matlab interp2函數實現,其他對比方法的實現均來自作者的公開源代碼。表2 給出了Set5、Set14、BSD100 測試集上不同方法的PSNR 平均值。表3 給出了Set5、Set14、BSD100測試集上不同方法的SSIM 平均值,其中加粗數據為PSNR、SSIM 值最好的結果。

表2 Set5、Set14 和BSD100 上不同方法的PSNR 平均值Table 2 Average PSNR for different methods on Set5,Set14 and BSD100dB

表3 Set5、Set14 和BSD100 上不同方法的SSIM 平均值Table 3 Average SSIM for different algorithms on Set5,Set14 and BSD100

由表2 和表3 可以看出:當放大因子為2 時,本文方法在每個測試數據集上PSNR 和SSIM 的平均值都高于其他方法;當因子分別為3 或4 時,可以得到相同的結果,這說明本文方法設計的網絡結構性能相較于其他方法有顯著提升。

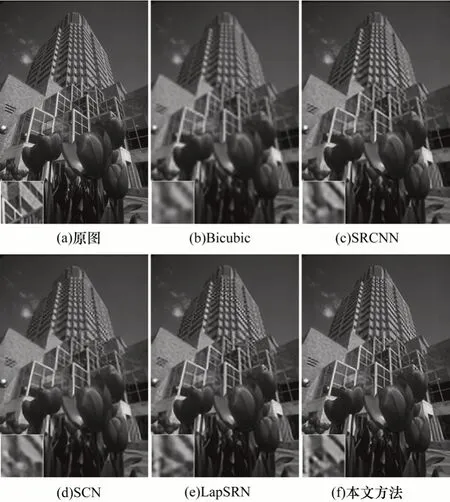

從Set5、Set14和BSD100這三個測試集中選擇3張圖片進行測試。將圖像特定的區域進行放大,以更好地觀察紋理細節的重建效果。圖8~圖10 展示了本文方法和其他4 種方法分別在尺度因子為2、3、4 情況下的重建效果。從主觀視覺效果上來看,與其他4 種方法相比,通過本文方法重建的圖像恢復了更多的高頻細節并具有更清晰的邊緣。因此,綜合主觀效果和客觀指標兩個方面可知,本文方法相對于主流超分辨率重建方法能夠得到更好的重建效果。

圖8 尺度因子為2 時不同方法的視覺重建效果Fig.8 Visual reconstruction quality of different methods when the scale factor is 2

圖9 尺度因子為3 時不同方法的視覺重建效果Fig.9 Visual reconstruction quality of different methods when the scale factor is 3

圖10 尺度因子為4 時不同方法的視覺重建效果Fig.10 Visual reconstruction quality of different methods when the scale factor is 4

4 結束語

本文結合注意力機制和多尺度特征,設計一個卷積神經網絡用于圖像超分辨率重建。通過注意力機制模塊融合圖像的非局部信息和二階特征,對圖像的固有屬性特征進行探索并自適應地學習其他特征,使該網絡更注重信息特征,并且具有更強的識別學習能力。同時,利用不同尺度的卷積核提取圖像的特征,并對提取到的多尺度特征進行融合,從而保存多尺度完整的信息特征。實驗結果表明,通過該方法重建的圖像質量在視覺效果和定量指標方面較Bicubic、SRCNN、SCN和LapSRN 方法均有較大提升。后續將研究更深層次的網絡結構,進一步優化圖像重建效果。