基于多視圖的半監(jiān)督集成學(xué)習(xí)方法*

張振良 劉君強 黃 亮 張 曦

(1.鄂爾多斯應(yīng)用技術(shù)學(xué)院 鄂爾多斯 017000)(2.南京航空航天大學(xué)民航學(xué)院 南京 211100)

1 引言

在機器學(xué)習(xí)和數(shù)據(jù)挖掘應(yīng)用程序中,我們尋找很多方法來提高分類器的性能。集成學(xué)習(xí)是一種機器學(xué)習(xí)方法,最初,集成學(xué)習(xí)的提出是由于Schapire 證明了多個弱分類器可以形成一個強分類器,所謂的弱分類器是指分類效果很差的模型,集成學(xué)習(xí)的目的是通過組合多個分類器的輸出來構(gòu)造多個不同的分類器[1]。所謂“集成”是專家的混合體,用以防止過度擬合以及減少所有基礎(chǔ)學(xué)習(xí)器的誤差,而如何結(jié)合多種學(xué)習(xí)器的輸出結(jié)果和提高基分類器的多樣性來提高分類器的精度是重點[2]。

集成分類器的關(guān)鍵是根據(jù)所有基分類器的預(yù)測來量化未標(biāo)記樣本的置信度,而精度也隨分類器的數(shù)量增加而增加,而且對所有的訓(xùn)練集以及算法沒有要求,避免了大量交叉驗證[3]。

現(xiàn)有的算法大多只使用標(biāo)記數(shù)據(jù)來構(gòu)造分類器,而且在很多情況下,標(biāo)記數(shù)據(jù)的數(shù)量通常不足以訓(xùn)練出魯棒性很強的分類器,同時大多數(shù)情況下,標(biāo)簽數(shù)據(jù)的獲取成本很高,而未標(biāo)記的數(shù)據(jù)則很容易獲得而且數(shù)量更多。基于這個原因,半監(jiān)督學(xué)習(xí)獲得了越來越多的關(guān)注,它致力于從未標(biāo)記樣本中獲得信息,尋找大量的未標(biāo)記數(shù)據(jù)中的規(guī)律,再利用少部分已標(biāo)記數(shù)據(jù)的信息,做出預(yù)測。大多數(shù)現(xiàn)有的SSL(Semi-supervised learning)技術(shù)主要是在未標(biāo)記數(shù)據(jù)的信息獲取方式上加以區(qū)別。

將半監(jiān)督學(xué)習(xí)方法引入到集成學(xué)習(xí)中,鄔[4]提出三重訓(xùn)練的思想,訓(xùn)練生成三個分類器,而且無需滿足苛刻的獨立條件,然后使用其他兩個分類器同意的未標(biāo)記數(shù)據(jù)對另一個分類器進行改進,由于未標(biāo)記數(shù)據(jù)的分類誤差估計比較困難,因此,在未標(biāo)記數(shù)據(jù)與標(biāo)記數(shù)據(jù)具有相同分布的前提下,僅對標(biāo)記數(shù)據(jù)進行分類誤差計算。三次訓(xùn)練過程的學(xué)習(xí)一直持續(xù)到誤差停止減小為止,這意味著已經(jīng)達(dá)到了最大的泛化效果。在一定的理論證明限制下,將一致的未標(biāo)記樣本逐步加入到標(biāo)記數(shù)據(jù)中,用于細(xì)化相應(yīng)的分類器,直到?jīng)]有一個分類器的預(yù)測誤差進一步減小,一旦學(xué)習(xí)過程完成,就可以用兩個或多個成員分類器一致同意的標(biāo)簽來預(yù)測未標(biāo)記或看不見的數(shù)據(jù)[5]。三重訓(xùn)練方法很有吸引力,因為它在原始的共同訓(xùn)練方法中成功地解除了對兩個條件獨立視圖的要求,而沒有經(jīng)歷過實踐中提出的耗時的交叉驗證過程。

王立國[6]提出改進的三重訓(xùn)練算法,先選取信息量最大的未標(biāo)記樣本,利用差分進化算法產(chǎn)生新樣本,再利用這些新樣本繼續(xù)迭代[2]。楊印衛(wèi)、王國鋒[1]選取了支持向量機(SVM)、隱馬爾科夫模型(HMM)以及徑向基神經(jīng)網(wǎng)絡(luò)(RBF)這三個單分類器作為異構(gòu)集成學(xué)習(xí)模型的基分類器,同時采用了majority voting和stacking兩種集成結(jié)果整合策略來選擇最優(yōu)組合,證明異構(gòu)集成學(xué)習(xí)模型的泛化能力相比于以往單分類模型得到了改善,同時模型復(fù)雜度降低。傅向華、馮博琴[7]等提出一種異構(gòu)神經(jīng)網(wǎng)絡(luò)集成協(xié)同構(gòu)造算法,利用進化規(guī)劃同時進化網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)和連接權(quán)值,連續(xù)學(xué)習(xí)生成多個異構(gòu)最優(yōu)網(wǎng)絡(luò),然后對異構(gòu)網(wǎng)絡(luò)進行組合。在構(gòu)造神經(jīng)網(wǎng)絡(luò)集成的過程中通過協(xié)同合作,保持各網(wǎng)絡(luò)間的負(fù)相關(guān),從而在提高成員網(wǎng)絡(luò)精度的同時增加各成員網(wǎng)絡(luò)之間的差異度。

這些算法的優(yōu)點在于不要求用于分類的屬性由多個獨立視圖描述,從而大大擴展了基于共同訓(xùn)練的半監(jiān)督學(xué)習(xí)的適用性。但是,這些算法的一個潛在弱點是,因為初始分類器是由Boosting 算法進行自舉采樣,基分類器差異性被樣本多樣性局限,算法的成功在很大程度上取決于原始集合分類的多樣性

本文將從采用多個視圖以及不同的特征降維方法和學(xué)習(xí)模型來創(chuàng)建更加多樣化的基學(xué)習(xí)器,未標(biāo)記的數(shù)據(jù)通過集合成員的簡單多數(shù)表決來預(yù)測,而不是復(fù)雜測量方法,以期有效地提高以最小的開銷成本預(yù)測未標(biāo)記樣本的標(biāo)記的準(zhǔn)確性,其次所提出的方法預(yù)測具有特定標(biāo)簽的數(shù)據(jù)的概率,然后可以使用該方法選擇最可靠的預(yù)測的未標(biāo)記數(shù)據(jù)以添加到標(biāo)記數(shù)據(jù)。相比之下,其他算法隨機選擇池中的一定數(shù)量的未標(biāo)記數(shù)據(jù)用以訓(xùn)練。鑒于這些屬性,基于多視圖的半監(jiān)督集成學(xué)習(xí)算法能夠可靠地應(yīng)用于各種分類問題。

2 相關(guān)工作

2.1 多視圖方法(Multi-View,MV)

所謂視圖其實就是特征集,在具體的分類過程中,由于訓(xùn)練集可能有著多種多樣的特征屬性,如果全部輸入到網(wǎng)絡(luò)中進行學(xué)習(xí)不但數(shù)據(jù)龐大難以學(xué)習(xí),而且特征之間也無主次,影響精度。我們以垃圾郵件的分類為例[8],在諸如公共垃圾郵件數(shù)據(jù)集之類的研究中,如主題長度,信息大小,附件大小和圖片數(shù)量等特征都在分類垃圾電子郵件時有所幫助。基于以上特點,本文總結(jié)了上述14 個特征如表1 所示,并且采用兩個視圖也就是數(shù)據(jù)集來表示電子郵件。這種特殊的數(shù)據(jù)構(gòu)建方法使我們的工作與大多數(shù)現(xiàn)有工作不同。在實際部署中,我們確定可以通過當(dāng)前的電子郵件技術(shù)(即路線跟蹤和內(nèi)容記錄)輕松捕獲和計算上述特征。

表1 視圖示例

為了更好地描述本文方法,使用ɑ 和b 表示兩個視圖的所有特征,已標(biāo)記樣本用(<ɑ,b>,c)表示,其中 ɑ∈ A 和 b∈ B 是示例的兩個部分,c 是標(biāo)簽,0表示負(fù)類,1 表示正類。假設(shè)在A 和B 上有兩個函數(shù)f1和f2,使得f1(ɑ)=f2(b)=c。這意味著每個標(biāo)簽都與兩個視圖相關(guān)聯(lián),其中每個視圖都包含足夠的信息來確定示例的標(biāo)簽。因此,如果給出k 個例子,可以給出具有標(biāo)記的數(shù)據(jù)集 L:(<ɑk,bk>,ck)(k=1,2,…,ck是已知的)。設(shè) U=(<ɑi,bi>,ci)(i=1,2,…,ci未知)表示大量未標(biāo)記數(shù)據(jù),我們的任務(wù)是訓(xùn)練一個分類器來分類新的例子。

2.2 多特征降維方法(Multi-Feature)

由上可知,采用多個視圖描述兩組特征,但為了構(gòu)建用于解決分類問題的可靠模型,期望特征應(yīng)包含盡可能多的有用信息,并且特征的數(shù)量盡可能小[9]。但是,由于關(guān)于數(shù)據(jù)集的先驗知識通常很少,因此難以區(qū)分哪些特征是相關(guān)的哪些特征不相關(guān)。因此,通常需要考慮大量功能,包括許多不相關(guān)和冗余的功能。不幸的是,不相關(guān)和冗余的特征不僅會降低學(xué)習(xí)效率,而且會對因此訓(xùn)練的機器學(xué)習(xí)的性能產(chǎn)生負(fù)面影響,從優(yōu)化的角度而言,特征選擇是一個組合優(yōu)化問題。首先,由于特征子集的大小不是先驗已知的,因此決策空間的維度是不可簡化的。其次,因為功能可能彼此之間具有互補或相互矛盾的相互作用,決策空間是不可分離的。因此,給定m 維特征集,所有可能的特征子集的數(shù)量都大到2m,這使得用傳統(tǒng)的窮舉搜索方法解決它的可能性很小[10]。

現(xiàn)有的特征降維方法有獨立成分分析(ICA)、主成分分析法(PCA)、粒子群優(yōu)化算法(PSO)以及競爭群優(yōu)化算法(CSO)等。ICA的基本思想即在線性變換的基礎(chǔ)上,使用訓(xùn)練樣本找到一組相互獨立的投影軸,利用其獨立成份作為樣本數(shù)據(jù)。PCA利用去除了樣本二階統(tǒng)計意義的相關(guān)性信息,ICA則利用去基于訓(xùn)練樣本的二階統(tǒng)計信息。使樣本的各階統(tǒng)計意義下的信息都得到了充分利用。PCA 基于訓(xùn)練樣本的二階統(tǒng)計信息,因而其忽視了高階統(tǒng)計意義下的信息。在PSO中,每個粒子在n 維搜索空間中保持位置和速度,表示候選解決方案和可能更好的解決方案的方向。為了搜索全局最優(yōu)的位置,每個粒子按公式迭代更新,但當(dāng)優(yōu)化問題具有高維度和復(fù)雜的搜索空間時,其性能仍然有限,為了提高PSO 的性能,已經(jīng)提出了許多PSO變體,包括基于參數(shù)自適應(yīng)的變體,基于結(jié)構(gòu)的拓?fù)渥凅w等。在CSO中[11],粒子從隨機選擇的競爭者中學(xué)習(xí),而不是從全球或個人最佳位置學(xué)習(xí)。在每次迭代中,將群體隨機分成兩組,并在每組的粒子之間進行成對競爭。在每次比賽之后,獲勝者粒子將直接傳遞到下一次迭代,而輸家粒子將通過從獲勝者粒子中學(xué)習(xí)來更新其位置和速度。

3 基于多視圖的半監(jiān)督集成學(xué)習(xí)方法

3.1 基于多視圖的未標(biāo)記樣本篩選

半監(jiān)督學(xué)習(xí)算法的關(guān)鍵步驟是估計標(biāo)簽置信度,以選擇適當(dāng)?shù)奈礃?biāo)記樣本進行標(biāo)記。這對于普通的分類而言很簡單,只需要隨機選擇未標(biāo)記樣本即可,但由于有著大量的未標(biāo)記樣本,有些未標(biāo)記樣本可能對于學(xué)習(xí)沒有幫助甚至?xí)鸬椒醋饔茫詫ξ礃?biāo)記樣本的篩選是很有必要的,很多文獻[12]忽略了這一點。

為了解決這個問題,通過評估未標(biāo)記樣本的標(biāo)記對現(xiàn)有標(biāo)記數(shù)據(jù)的影響來估計標(biāo)記置信度是可行的,但是基于假設(shè)標(biāo)記數(shù)據(jù)上的回歸量的誤差應(yīng)該減少最多,如果使用最可信的未標(biāo)記樣品在每次迭代中重復(fù)評估模型將導(dǎo)致高計算復(fù)雜性。基于這些原因,提出了一種基于分歧的篩選算法。借用Tri-Training[13]的想法,使用基于三個視圖訓(xùn)練的三個回歸量來確定如何選擇合適的未標(biāo)記樣品進行標(biāo)記。對于任何回歸量,我們通過利用其他兩個回歸量的均勻性來估計標(biāo)記置信度。如果其他兩個回歸量的估計值之間的差異較小,則未標(biāo)記的樣本獲得較高的標(biāo)記置信度。使用此方案,不再需要評估模型。在每次迭代中,我們選擇具有最小估計差異的未標(biāo)記樣本以擴展標(biāo)記數(shù)據(jù)。

然而,僅考慮估計差異將導(dǎo)致所選未標(biāo)記樣本的分布偏差。原因是較小的估計差異傾向于有利于具有較低估計值的未標(biāo)記樣本。例如,如果樣本A 和 B 的估計變量值約為 30 和 300,則樣本 A 更容易獲得較小的估計差異。這個問題會導(dǎo)致模型傾向于僅從樣本空間的一部分學(xué)習(xí)知識,從而降低模型的泛化。為了緩解這個問題,在每次迭代中,我們按照它們的估計值對未標(biāo)記的樣本進行排序,并將它們分成幾個具有相同數(shù)量的未標(biāo)記樣本的區(qū)間,然后分別為每個區(qū)域選擇未標(biāo)記的樣本。

在學(xué)習(xí)步驟中,它應(yīng)用學(xué)習(xí)模型根據(jù)當(dāng)前標(biāo)記數(shù)據(jù)從三個視圖重新訓(xùn)練學(xué)習(xí)模型,并且用以對未標(biāo)記樣本U1預(yù)測,在選擇步驟中,對于每個視圖,它首先通過使用式(1)計算估計差異Δy,其次,它根據(jù)候選樣本集進行排序估計并將其分成具有相同數(shù)量樣本的β部分。最后,它分別選擇每個部分中具有最小估計差異的α%樣本篩選出來得到U用以下面的算法。

3.2 構(gòu)造基學(xué)習(xí)器

構(gòu)造差異性更好的基學(xué)習(xí)器是我們的目的,從而促進半監(jiān)督以及集成學(xué)習(xí)的泛化性能。值得一提的是,為了盡可能獨立地創(chuàng)建視圖,模型應(yīng)盡可能地不同。例如,線性判別分析(LDA)和線性支持向量機(LSVM)都具有線性超平面,因此,它們創(chuàng)建的“模型”不太獨立。相比之下,LDA 和k-近鄰(kNN)更可能會創(chuàng)建不同的視圖,因為KNN具有與LDA 不同的離散超平面。假如我們根據(jù)特征的多少我們構(gòu)建了兩種視圖,選取了獨立成分分析(ICA)、主成分分析法(PCA)、粒子群優(yōu)化算法(PSO)以及競爭群優(yōu)化算法(CSO)四種特征降維方法,模型上采用樸素貝葉斯分類器(NB)、J48 決策樹(J48)以及KNN(k=5)3 種模型。則我們可以提供2*4*3=24 種不同的訓(xùn)練方式,再通過重抽樣方法提高訓(xùn)練集的多樣性,提供具有穩(wěn)定差異性的基分類器。

通過上述步驟,可以生成大量的基分類器。但由于基分類器的數(shù)量可能很大,所以其他所有分類器都不太可能就未標(biāo)記數(shù)據(jù)達(dá)成一致。該問題的解決方案是引入投票機制來預(yù)測標(biāo)簽,與給出確定性標(biāo)簽的三訓(xùn)練算法不同,所提出的方法預(yù)測具有特定標(biāo)簽的數(shù)據(jù)的概率。然后可以使用該概率來選擇最合適的未標(biāo)記樣本。這不會增加太多計算復(fù)雜度,因為基于來自每個基礎(chǔ)分類器的置信度輸出而不是如在共同學(xué)習(xí)算法中使用交叉驗證來計算置信水平。

3.3 基學(xué)習(xí)器集成算法步驟

首先定義已標(biāo)記樣本L 及篩選后的未標(biāo)記樣本集U,重抽樣算法[14]B(x),排序函數(shù)S

1)根據(jù)上述方法構(gòu)造24 種學(xué)習(xí)模型P=<V,F(xiàn)(x),H(x)> ,其中 V 為視圖,F(xiàn) 為特征降維方法,H 為基本模型,同時對L 進行重抽樣,依照重抽樣后的樣本以及學(xué)習(xí)模型訓(xùn)練24 種基分類器hi=P<B(L)>,其中B為重抽樣算法。

2)使用第i個分類器hi預(yù)測未標(biāo)記樣本xk,得到其分類結(jié)果hi(xk)=yi,同時使用其余23 個分類器進行預(yù)測得到分類結(jié)果hj(xk)=yj,(j≠i,i,j=1,2,…,24),若有ni個預(yù)測結(jié)果與hi預(yù)測結(jié)果相同,則得到xk在置信度為

相比于其他算法,本算法優(yōu)點有:

1)通過增加多視圖以及特征降維方法增加基學(xué)習(xí)器差異性。

2)通過對未標(biāo)記樣本的篩選,增加半監(jiān)督學(xué)習(xí)的穩(wěn)定性。

3)集成方式在運算中調(diào)整各分類器權(quán)值,進行增量式學(xué)習(xí),進一步提升分類器性能。

4 仿真實例

4.1 UCI數(shù)據(jù)集實驗

為了比較所提算法與其他算法的性能,我們對來自UCI 機器學(xué)習(xí)庫的8 個數(shù)據(jù)集進行了一系列實驗[15]。數(shù)據(jù)集的屬性總結(jié)如表2。

表2 UCI分類數(shù)據(jù)屬性

對于每個數(shù)據(jù)集,使用數(shù)據(jù)集中的25%樣本作為測試數(shù)據(jù),其余75%用于訓(xùn)練。在我們測試SSL 算法時,并非所有訓(xùn)練數(shù)據(jù)都與標(biāo)簽一起使用,盡管所有數(shù)據(jù)都已標(biāo)記。我們?nèi)藶榈貙?0%的數(shù)據(jù)設(shè)置為標(biāo)記其余80%未標(biāo)記。例如,假設(shè)有一個包含1000個實例的數(shù)據(jù)集,250個實例用作測試數(shù)據(jù),750個實例用作訓(xùn)練數(shù)據(jù),其中750個實例中的150 個被視為已標(biāo)記,其余600 個被視為未標(biāo)記,訓(xùn)練和測試集的選擇是隨機的,同時保留所有集合中正負(fù)類的原始比率。

本文使用n 倍交叉驗證的平均錯誤率(用n =3)在標(biāo)記數(shù)據(jù)上作為CSO的適應(yīng)度函數(shù),以降低選擇特征子集中過度擬合的風(fēng)險。CSO 算法中的其他參數(shù)設(shè)置如下。種群大小為30,最大迭代次數(shù)為100,φ為0.1。在第一次在[0,1]之間隨機初始化粒子,閾值參數(shù)λ為0.5。PCA 轉(zhuǎn)換中涵蓋的方差設(shè)置為0.95。每個算法獨立運行25次,

4.2 實驗結(jié)果

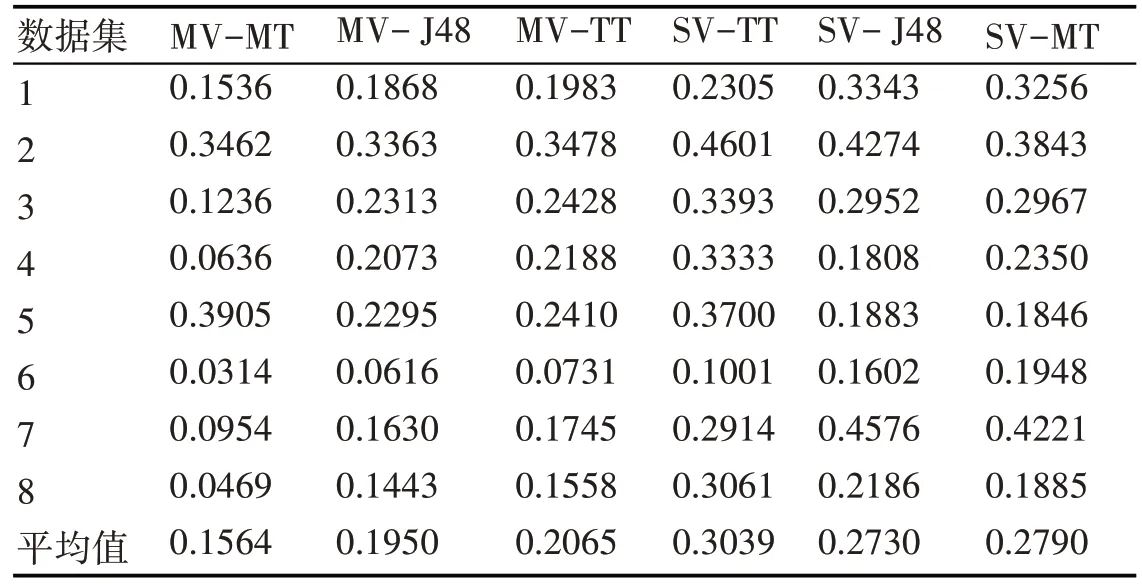

計算各分類器絕對誤差后的具體結(jié)果見表3~表6,其中“MT”表示采用多種學(xué)習(xí)模型,“MF”表示多種特征降維方法,“MV”表示多視圖方法,“3M”表示所提算法,“ST”表示單視圖方法,“TT”表示三重訓(xùn)練方法,具體的特征降維以及學(xué)習(xí)模型的字母表示在3.2 節(jié)中已有描述。在表3 中,我們發(fā)現(xiàn)J48決策樹在這些特定數(shù)據(jù)集上比其他學(xué)習(xí)模型有著更好的性能,而其他模型在相同數(shù)據(jù)集上產(chǎn)生更大的誤差。因此在MT算法中由于其他模型會降低整體集成,因為他們給出了更多的錯誤決策,即便如此,MT 方法仍然具有與J48 方法極其相近的誤差。我們可以得出結(jié)論,直接使用原始的學(xué)習(xí)模型,不經(jīng)過其他方法的調(diào)整,MT方法并沒有展現(xiàn)出自身的優(yōu)勢,因為他集合多種模型優(yōu)勢的同時也吸收了其劣勢。

表4~5 為使用多種特征降維方法以及多視圖方法對分類器泛化能力的提升,可以看到無論對于單一的學(xué)習(xí)模型,還是MT方法,多視圖以及多特征降維方法都可以極大提升分類器的精度,單一的特征操作方法誤差都與MF 方法相差甚遠(yuǎn),多視圖方法對TT 學(xué)習(xí)模型也有著巨大的改進。同樣的,在有其他算法的調(diào)整下,無論是特征降維還是多視圖方法,MT算法都展現(xiàn)出了優(yōu)于單一分類器的性能,此時集成學(xué)習(xí)能夠更好吸收多種學(xué)習(xí)模型的優(yōu)勢,展現(xiàn)出對單一分類器模型的巨大優(yōu)勢。

表3 MT算法誤差比較

表5 MV算法誤差比較

表6 3M算法誤差比較

在最后一組實驗中最后我們同時采用MT、MF以及MV 方法來構(gòu)造分類器,調(diào)查包含更多基礎(chǔ)學(xué)習(xí)器是否能夠進一步提高泛化能力。在這項工作中進行的最后一組實驗是比較使用前3 組實證研究中使用的設(shè)置組合生成的集合。具體結(jié)果如表6,3M 通過結(jié)合使用三種不同的特征操作方法和四種不同的分類器模型來創(chuàng)建多樣性,從而產(chǎn)生24種不同的基學(xué)習(xí)器。 MF-MT,MV-MT,MV-MF-TT,MF-TT 和 MV-TT 分別有著 12,6,6,4,2 種基分類器,其錯誤率也隨基分類器數(shù)量的減少而增加。所以我們可以得出結(jié)論,所提方法通過增加基分類器的多樣性來提升集成學(xué)習(xí)的泛化性能。

4.3 垃圾郵件分類實驗

在本節(jié)中,我們使用真實郵件數(shù)據(jù)集并在真實的網(wǎng)絡(luò)環(huán)境中評估我們提出3M分類模型。其中包含58 個屬性和總共4601 封電子郵件(813 封垃圾郵件和688 封合法電子郵件)[16]。為了評估基于分歧的半監(jiān)督學(xué)習(xí)算法,我們將該數(shù)據(jù)集分為兩部分:標(biāo)記數(shù)據(jù)和未標(biāo)記數(shù)據(jù),其中未標(biāo)記數(shù)據(jù)由從原始數(shù)據(jù)集中隨機選擇的600個實例組成,進行60次迭代測試,然后計算預(yù)測率后與其他分類器模型相比較。

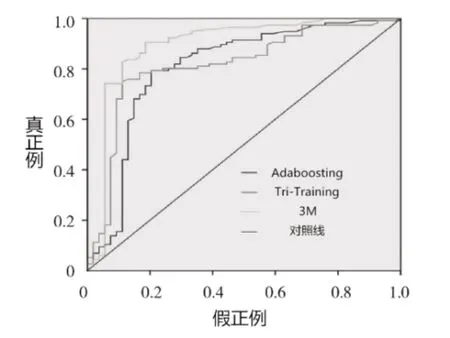

圖1為ROC曲線圖,是用于比較各種分類器性能的重要度量。它代表了作為單個標(biāo)量的預(yù)期性能,其中曲線下面積越大,表示分類器性能實驗越好,可以看出,即便在考慮原樣本中正負(fù)樣本比例的情況下,3M算法仍然展現(xiàn)了良好的性能。

圖2 為在學(xué)習(xí)過程中分類器的精度變化,可以看出在少量訓(xùn)練樣本時相較于其他算法由于3M算法可以吸收未標(biāo)記樣本的從而有著良好的預(yù)測性能,與普通的半監(jiān)督算法相比,它有著多種模型用以及時糾正半監(jiān)督算法中的錯誤。

圖1 ROC曲線圖

圖2 預(yù)測精度變化圖

圖3 參數(shù)β對算法的影響

圖3~圖4 為篩選未標(biāo)記樣本時參數(shù)的設(shè)置對誤差的影響,當(dāng)β=1 時,算法根本無法達(dá)到其最優(yōu)性能。也就是直接選用全部的未標(biāo)記樣本根本無法窮盡半監(jiān)督算法的性能,當(dāng)β=3 時,多視圖半監(jiān)督回歸算法可以很快最優(yōu)性能。

其次,所提出算法在每組中選擇ɑ%樣本用以學(xué)習(xí)。為了研究參數(shù)ɑ的影響,我們確定β=3,并將ɑ從1 增加到9。結(jié)果顯示在圖4。如果我們?yōu)楱唬è弧?)指定一個太小的值,則多視圖半監(jiān)督回歸算法在幾次迭代中無法達(dá)到其最佳性能。它表明,ɑ可以加速半監(jiān)督學(xué)習(xí)過程。但是,如果我們?yōu)楱唬è?≥7)設(shè)置了太大的值,則在多次迭代后RMSE 將顯示不穩(wěn)定的上升和下降趨勢。它表明在一次迭代中選擇太多未標(biāo)記的樣本往往會帶來噪音。最終在ɑ=3時半監(jiān)督效果較好。

圖4 參數(shù)α對算法的影響

5 結(jié)語

本文提出了一種新型的集成分類器,使用多種視圖、特征降維方法和學(xué)習(xí)模型來構(gòu)造更多的基分類器來提高集成性能,篩選無標(biāo)記樣本加入到學(xué)習(xí)中,最后在將其與Tri-Training 和非SSL 學(xué)習(xí)模型進行比較,表明所提出的3M 模型優(yōu)于比較算法。與原始單視圖數(shù)據(jù)相比,更好的性能可歸因于多個視圖配合不同的特征操縱方法帶來的多樣性。此外,通過使用集成方法,改善了未標(biāo)記數(shù)據(jù)的預(yù)測準(zhǔn)確度,因此能夠降低半監(jiān)督學(xué)習(xí)未標(biāo)記數(shù)據(jù)的風(fēng)險。我們的結(jié)果證實,由不同類型的基礎(chǔ)模型組成并使用不同特征的異構(gòu)集成學(xué)習(xí)具有優(yōu)異的泛化性能。

將來我們將研究此種方法在差異性方面的更多發(fā)展以及在故障預(yù)測方面的應(yīng)用。并將其應(yīng)用于民用航空故障診斷或分類中,更好地提升安全性以及降低維修成本。