基于輕量化改進YOLOv5的蘋果樹產量測定方法

李志軍 楊圣慧 史德帥 劉星星 鄭永軍

摘要:果樹測產是果園管理的重要環節之一,為提升蘋果果園原位測產的準確性,本研究提出一種包含改進型YOLOv5果實檢測算法與產量擬合網絡的產量測定方法。利用無人機及樹莓派攝像頭采集摘袋后不同著色時間的蘋果果園原位圖像,形成樣本數據集;通過更換深度可分離卷積和添加注意力機制模塊對YOLOv5算法進行改進,解決網絡中存在的特征提取時無注意力偏好問題和參數冗余問題,從而提升檢測準確度,降低網絡參數帶來的計算負擔;將圖片作為輸入得到估測果實數量以及邊界框面總積。以上述檢測結果作為輸入、實際產量作為輸出,訓練產量擬合網絡,得到最終測產模型。測產試驗結果表明,改進型YOLOv5果實檢測算法可以在提高輕量化程度的同時提升識別準確率,與改進前相比,檢測速度最大可提升15.37%,平均mAP最高達到96.79%;在不同數據集下的測試結果表明,光照條件、著色時間以及背景有無白布均對算法準確率有一定影響;產量擬合網絡可以較好地預測出果樹產量,在訓練集和測試集的決定系數R分別為0.7967和0.7982,均方根誤差RMSE分別為1.5317和1.4021 kg,不同產量樣本的預測精度基本穩定;果樹測產模型在背景有白布和無白布的條件下,相對誤差范圍分別在7%以內和13%以內。本研究提出的基于輕量化改進YOLOv5的果樹產量測定方法具有良好的精度和有效性,基本可以滿足自然環境下樹上蘋果的測產要求,為現代果園環境下的智能農業裝備提供技術參考。

關鍵詞:蘋果原位測產;深度學習;果實檢測;BP神經網絡;YOLOv5

中圖分類號:S252+.9文獻標志碼:A文章編號:202105-SA005

引用格式:李志軍,楊圣慧,史德帥,劉星星,鄭永軍.基于輕量化改進YOLOv5的蘋果樹產量測定方法[J].智慧農業(中英文),2021,3(2): 100-114.

LI Zhijun, YANG Shenghui, SHI Deshuai, LIU Xingxing, ZHENG Yongjun. Yield estimation method of apple tree based on improved lightweight YOLOv5[J]. Smart Agriculture, 2021, 3(2): 100-114. (in Chinese with English abstract)

1引言

果樹產量測定不但可以幫助果農掌握果樹的生長情況、估算果園的整體產值,而且可以為合理安排收獲提供定量依據[1]。傳統的果樹測產方法主要依靠人工目測清點,不僅對測產人員的經驗有較高要求,而且勞動強度大、精度較低[2]。

為實現蘋果測產流程的自動化,學者開始利用機器視覺等技術進行相關研究,主要集中在利用該技術從果樹圖像提取出果實個數等信息[3-5],而基于圖像信息估測果樹產量的研究仍需進一步深入。程洪等[6]提出將果實區域比例、果實個數比、小面積果實比例、果實樹葉比等作為特征輸入,建立神經網絡的方法擬合果樹產量。

Crtomir等[7]從果樹撿果結束到果實收獲期內,采集“Golden Delicious”和“Braebum”兩種蘋果樹圖像數據,以果實個數為輸入,產量為輸出構建人工神經網絡進行模型的訓練和測試。該方法需要進行多組數據的采集,因此僅適用于接近或已經位于成熟期的蘋果果樹測產。Roy等[8]提出了一種基于顏色識別蘋果的半監督聚類方法,以及一種利用空間屬性從具有任意復雜幾何形狀的蘋果簇中估計數量的無監督聚類方法,將其集成為一個完整的端到端計算機視覺系統,使用單個攝像機捕獲的圖像作為輸入,輸出果園的預測產量,在不同數據集上的準確度為91.98%~94.81%。

基于深度學習的目標檢測算法可以快速檢測出目標數量,其主要分為兩類,一類是以YOLO(You Only Look Once)系列[9-12]和SSD(Single Shot MultiBox Detector)系列[13-15]為代表的一階段檢測算法,該類算法具有較快的檢測速度,但是精度相對偏低;另一類是以區域卷積神經網絡(Region-CNN,R-CNN)系列[16-18]為代表的二階段檢測算法,其檢測精度較高,缺點是實時性差。YOLOv5憑借其較快的檢測速度以及良好的檢測精度得到了研究人員的青睞[19,20]。具體來看,YOLOv5在數據的輸入端增加了Mosaic數據增強、自適應錨框計算、自適應圖片縮放等操作;特征提取網絡為基于CSPNet[21]的CSPDarknet53,可以在一定范圍內降低內存損耗;處理輸出部分采用FPN[22]和PANet[23]結構,可以加快各層級之間的信息流通。

本研究以自然環境下的蘋果為研究對象,通過對YOLOv5檢測算法進行輕量化改進,考慮摘袋后不同著色時間、不同光照條件以及背景有無白布對結果的影響進行數據分析;融合產量擬合網絡,建立蘋果樹測產模型,將圖像數據作為輸入,估測蘋果樹產量,為果實收獲期合理安排采摘人員提供參考,為現代果園環境下的智能農業裝備提供技術參考。

2數據采集與處理

2.1圖像數據采集

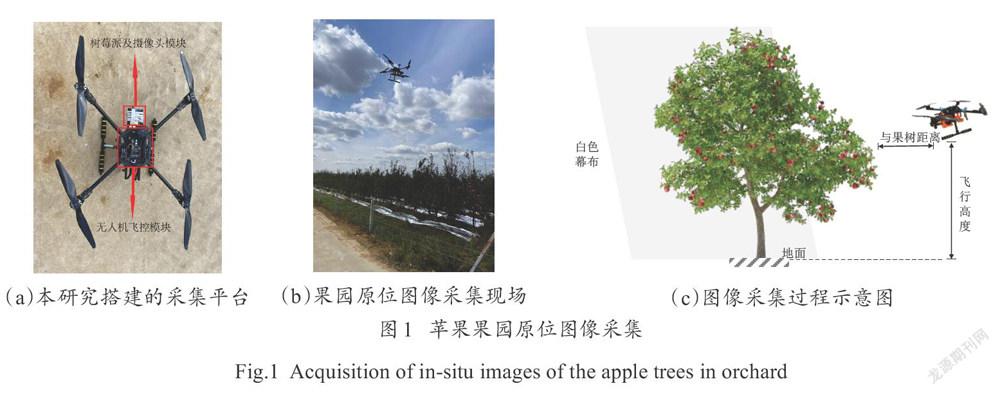

原位圖像在山東省煙臺市棲霞市官道鎮姚莊村山東通達現代農業集團有限公司果園基地(北緯37°16′,東經120°64′)采集,蘋果品種為“煙富3號”,摘袋后著色16~22d采摘果實。采集設備為自制的四旋翼無人機(圖1),搭載樹莓派4B作為圖像采集與存儲核心,其CPU為Cortex-A72@1.5GHz,GPU為Broadcom VideoCore VI,運行內存8GB,存儲容量128G。攝像頭(Raspberry Pi Camera V2),像素為500萬,采集頻率為30Hz,影像最大光圈為F2.35,焦距為3.15 mm,視場角為65°。

為降低其他果樹產生的干擾,采用長4m、高3m的白色幕布為背景,跟隨無人機移動(如圖1(c)所示)。圖像采集時無人機飛行高度為1.5 m,距離果樹1.2 m,在晴天時采集順光、側光、逆光三個角度的有白色背景與自然條件圖像,作為測產模型的訓練及在自然環境下的應用效果驗證。

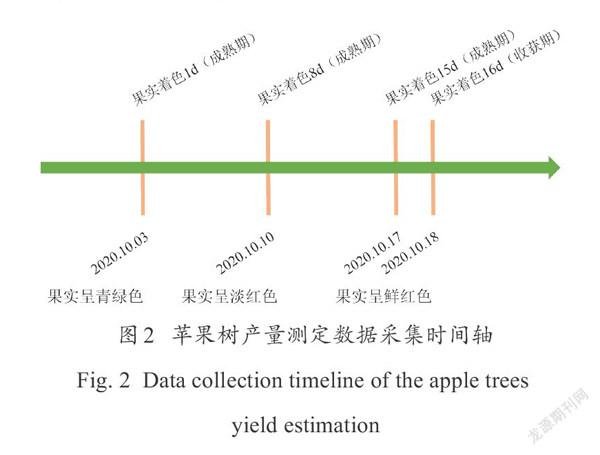

著色1d的蘋果顏色呈現青綠色,與果樹葉片顏色較為接近;8d時開始上色,顏色呈現淡紅色;著色15d即可完全上色。不同著色時間的數據,便于對本研究提出的果實檢測算法進行泛化能力測試。圖像采集日期為2020年10月3日至17日,每隔7 d采集一次圖像,采集時間為上午10點至下午4點,共采集到蘋果著色1d、著色8d、著色15 d的三組數據,在果實著色16d時采集果樹產量數據(圖2)。

2.2圖像數據預處理

2.2.1數據清洗

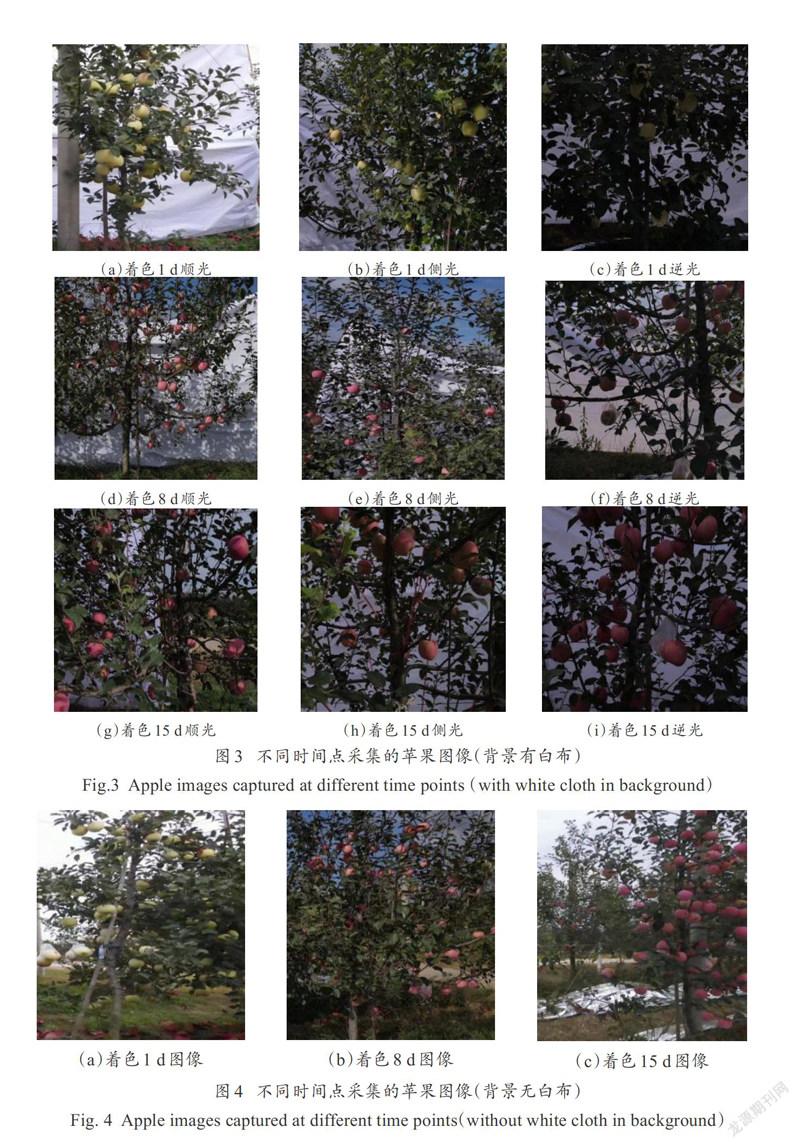

為降低重復圖片數量以及無果實圖片對模型訓練的干擾,使用人工篩選的方法對采集圖像進行數據清洗,即刪除因無人機懸停造成的重復圖片以及無人機姿態調整過程中不含蘋果的圖片。數據清洗后,著色1d、8d和15d部分數據如圖3所示。利用不同著色時間采集的不同光照條件數據,分析不同著色時間以及不同光照條件數據對檢測算法的影響。圖像數據包含果樹整體圖像以及局部圖像,檢測算法在工作過程中只迭代訓練標注過的果實區域。本研究無人機拍攝的整體圖像與局部圖像果實區域大小相近、分布相似,故將整體與局部圖像作為訓練數據可以使算法在不損失檢測準確率的同時提高其泛化能力。

利用不同時間點采集的背景無白布數據,與背景有白布數據進行對比分析,驗證本研究提出檢測算法的實際應用效果,背景無白布下不同時間點采集的部分蘋果圖片如圖4所示。

2.2.2數據集劃分與標注

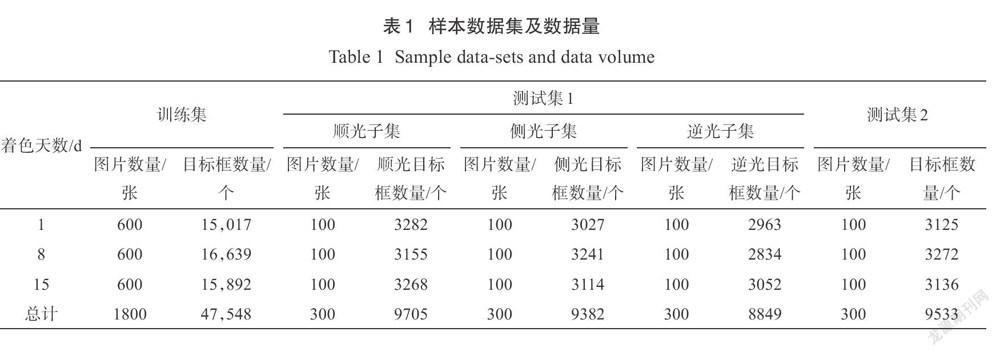

數據清洗后,著色1d、8d和15d數據各保留1000張。從背景有白布數據中隨機挑選300張圖片作為測試集1,并將測試集1分為順光、側光和逆光三個子集,每個子集包含100張圖片;從背景無白布數據中挑選300張作為測試集2,不分光照條件子集;剩下的圖片均作為訓練集數據。

采用人工劃分方法,在labelling軟件中對目標果實進行框選,包含目標框的位置坐標、類別等信息,標注結果如圖5(第104頁)所示。

標注完成后,將樣本數據集制作成標準PASCAL. VOC2012格式的數據集,圖片及目標框數量如表1所示。

2.3產量數據采集

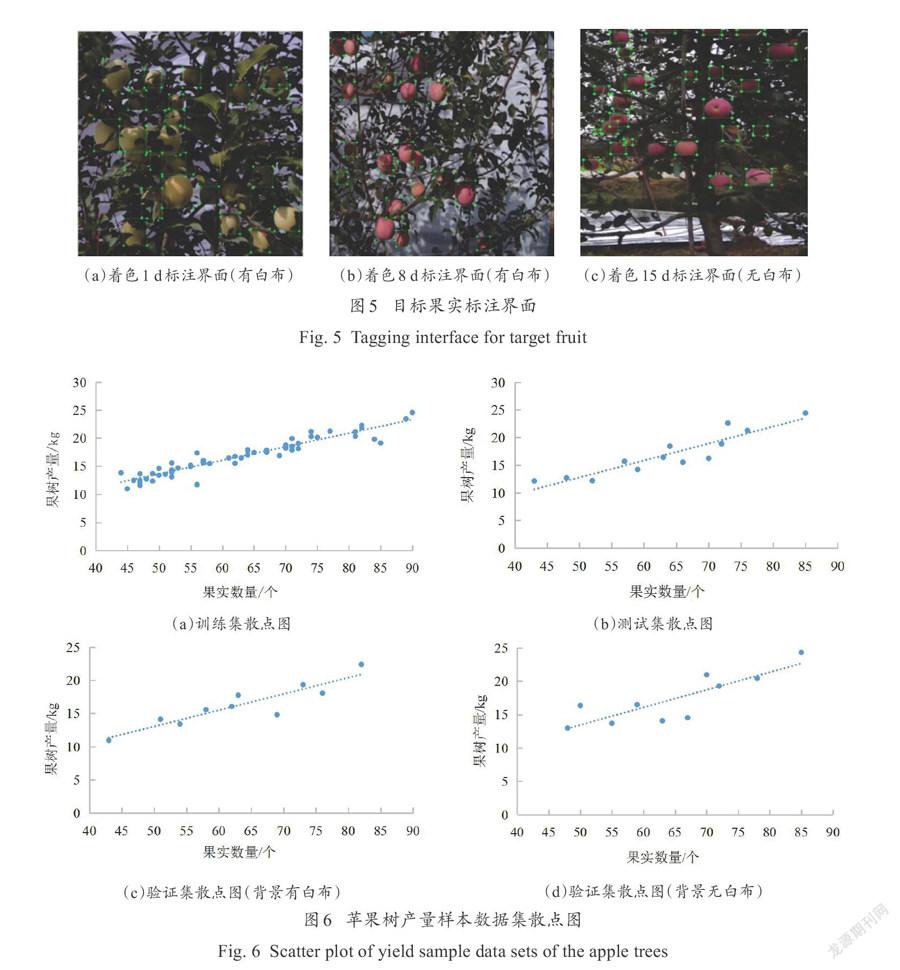

產量數據于2020年10月18日9:00—17:00采集,此時蘋果著色16 d。采集時對單株果樹進行編號,在每株果樹收獲前,使用無人機拍攝當前果樹圖像;收獲后,將單株果實放置在同一個框中,使用電子秤對蘋果進行稱重,去掉框的重量即可得到單株果樹產量。得到數據共93組,每組數據包含果樹圖像以及相應產量,其中60組用于產量擬合網絡訓練,13組用于產量擬合網絡測試,10組用于背景有白布的測產模型驗證,10組用于背景無白布的測產模型驗證。將不同產量數據集數據繪制成散點圖,如圖6所示。果實數量與果樹產量之間呈現一定的線性相關性,并且果實平均重量在250~280 g之間,表明該果園的果樹長勢較好,果樹個體之間無明顯差異。

3蘋果樹測產模型

3.1模型總體結構

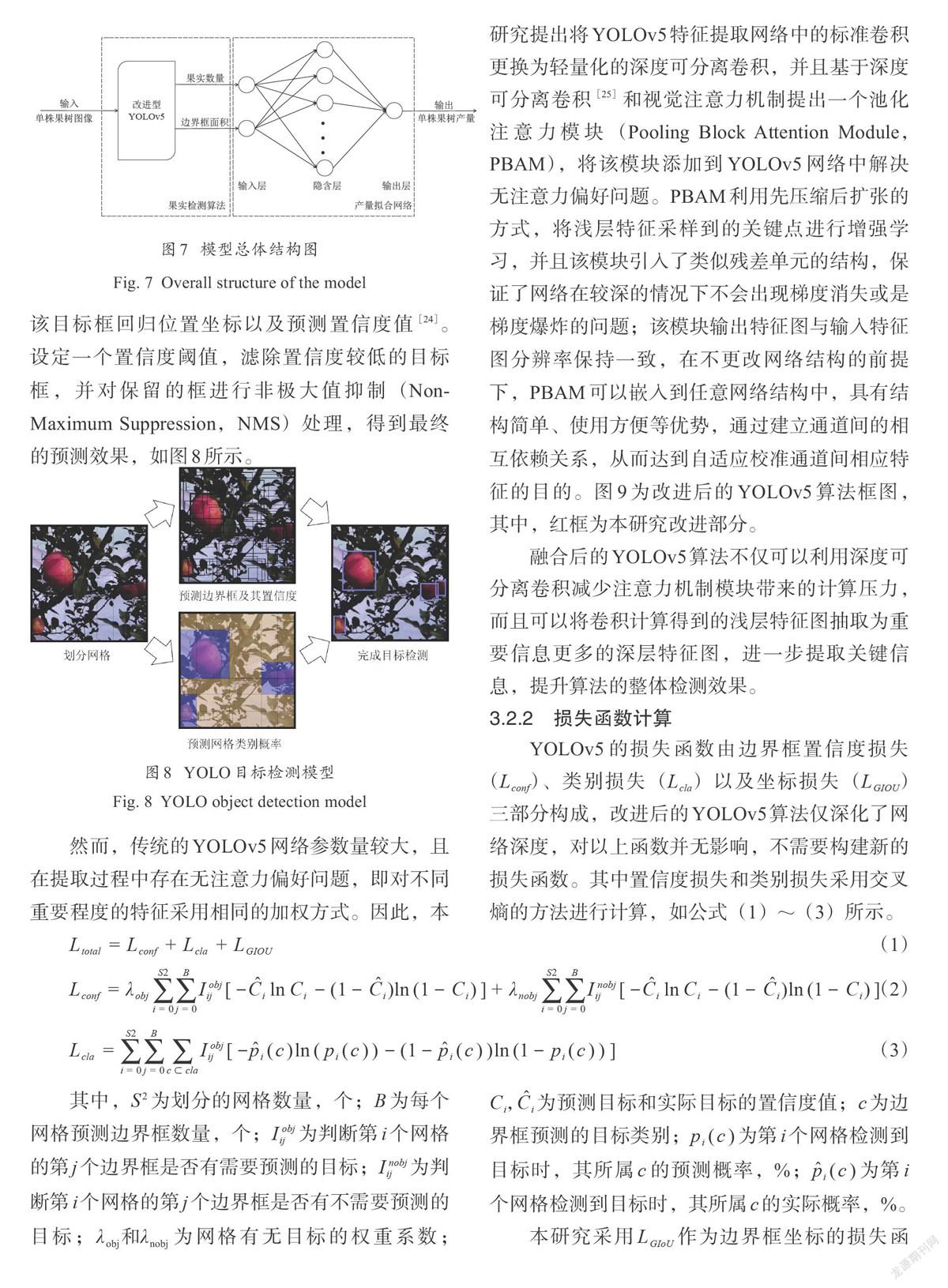

本研究提出的果樹測產模型分為果實檢測算法和產量擬合網絡兩部分,如圖7所示。果實檢測算法利用改進型Y0L0v5對輸入的果樹圖像進行目標檢測,輸出圖像中果實數量以及所有果實邊界框總面積;產量擬合網絡負責將上述算法的輸出作為當前網絡的輸入,利用BP神經網絡擬合果樹產量。檢測算法部分使用圖像訓練集、擬合網絡部分使用產量訓練集分開進行訓練,訓練完成后,可實現在測產模型中輸入果樹圖像即可直接輸出相應的果樹產量。

3.2改進型YOLOv5果實檢測算法

3.2.1基于輕量化改進的YOLOv5

YOLOv5模型起源于YOLO,該算法在輸出層回歸目標框的位置坐標及其所屬類別具有良好的檢測速度。YOLO算法的核心思想是將輸入圖片劃分為7×7個網格,目標中心所在的網格負責預測該目標。每個網格負責預測2個目標框,該目標框回歸位置坐標以及預測置信度值[24]。設定一個置信度閾值,濾除置信度較低的目標框,并對保留的框進行非極大值抑制(Non- Maximum Suppression, NMS)處理,得到最終的預測效果,如圖8所示。

然而,傳統的YOLOv5網絡參數量較大,且在提取過程中存在無注意力偏好問題,即對不同重要程度的特征采用相同的加權方式。因此,本研究提出將YOLOv5特征提取網絡中的標準卷積更換為輕量化的深度可分離卷積,并且基于深度可分離卷積[25]和視覺注意力機制提出一個池化注意力模塊(Pooling Block Attention Module,PBAM),將該模塊添加到YOLOv5網絡中解決無注意力偏好問題。PBAM利用先壓縮后擴張的方式,將淺層特征采樣到的關鍵點進行增強學習,并且該模塊引入了類似殘差單元的結構,保證了網絡在較深的情況下不會出現梯度消失或是梯度爆炸的問題;該模塊輸出特征圖與輸入特征圖分辨率保持一致,在不更改網絡結構的前提下,PBAM可以嵌入到任意網絡結構中,具有結構簡單、使用方便等優勢,通過建立通道間的相互依賴關系,從而達到自適應校準通道間相應特征的目的。圖9為改進后的YOLOv5算法框圖,其中,紅框為本研究改進部分。

融合后的YOLOv5算法不僅可以利用深度可分離卷積減少注意力機制模塊帶來的計算壓力,而且可以將卷積計算得到的淺層特征圖抽取為重要信息更多的深層特征圖,進一步提取關鍵信息,提升算法的整體檢測效果。

3.2.2損失函數計算

YOLOv5的損失函數由邊界框置信度損失(L)、類別損失(L)以及坐標損失(L)三部分構成,改進后的YOLOv5算法僅深化了網絡深度,對以上函數并無影響,不需要構建新的損失函數。其中置信度損失和類別損失采用交叉熵的方法進行計算,如公式(1)~(3)所示。

L-L+L+L(1)

(2)

其中,S為劃分的網格數量,個;B為每個網格預測邊界框數量,個;為判斷第i個網格的第j個邊界框是否有需要預測的目標;為判斷第i個網格的第j個邊界框是否有不需要預測的目標;λ和λ為網格有無目標的權重系數;C,為預測目標和實際目標的置信度值;c為邊界框預測的目標類別;p(c)為第i個網格檢測到目標時,其所屬c的預測概率,%;為第i個網格檢測到目標時,其所屬c的實際概率,%。

本研究采用L作為邊界框坐標的損失函數,如公式(4)~(6)所示。

(4)

(5)

(6)

其中,A為真實框的面積,像素;B為預測框的面積,像素;C為A和B的最小外接矩形面積,像素。

3.3產量擬合網絡

由于果實檢測數量以及邊界框面積與估測產量之間的函數映射關系并不明確,屬非線性函數關系特征,因此本研究采用BP神經網絡作為果實產量擬合部分,提升模型整體對任意復雜模式的分類能力與多維函數映射能力。由于BP網絡的輸入包含了邊界框面積,因此圖像拍攝的距離與相機的參數就顯得尤為重要。本研究在圖像采集時,保持采集平臺與果樹的距離不變,并且固定相機的參數,保證測產的準確性。

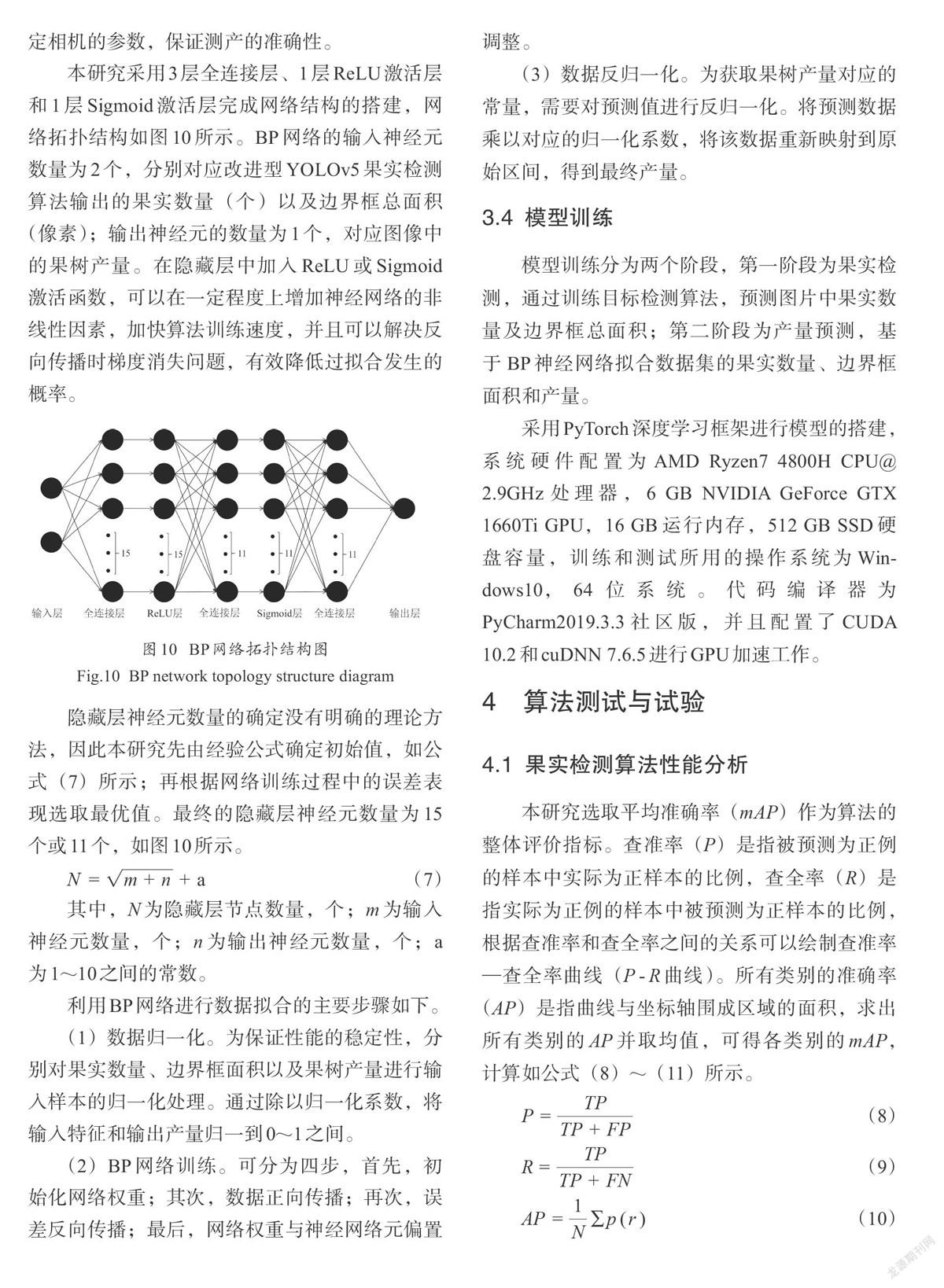

本研究采用3層全連接層、1層ReLU激活層和1層Sigmoid激活層完成網絡結構的搭建,網絡拓撲結構如圖10所示。BP網絡的輸入神經元數量為2個,分別對應改進型YOLOv5果實檢測算法輸出的果實數量(個)以及邊界框總面積(像素);輸出神經元的數量為1個,對應圖像中的果樹產量。在隱藏層中加入ReLU或Sigmoid激活函數,可以在一定程度上增加神經網絡的非線性因素,加快算法訓練速度,并且可以解決反向傳播時梯度消失問題,有效降低過擬合發生的概率。

隱藏層神經元數量的確定沒有明確的理論方法,因此本研究先由經驗公式確定初始值,如公式(7)所示;再根據網絡訓練過程中的誤差表現選取最優值。最終的隱藏層神經元數量為15個或11個,如圖10所示。

(7)

其中,N為隱藏層節點數量,個;m為輸入神經元數量,個;n為輸出神經元數量,個;a為1~10之間的常數。

利用BP網絡進行數據擬合的主要步驟如下。

(1)數據歸一化。為保證性能的穩定性,分別對果實數量、邊界框面積以及果樹產量進行輸入樣本的歸一化處理。通過除以歸一化系數,將輸入特征和輸出產量歸一到0~1之間。

(2)BP網絡訓練。可分為四步,首先,初始化網絡權重;其次,數據正向傳播;再次,誤差反向傳播;最后,網絡權重與神經網絡元偏置調整。

(3)數據反歸一化。為獲取果樹產量對應的常量,需要對預測值進行反歸一化。將預測數據乘以對應的歸一化系數,將該數據重新映射到原始區間,得到最終產量。

3.4模型訓練

模型訓練分為兩個階段,第一階段為果實檢測,通過訓練目標檢測算法,預測圖片中果實數量及邊界框總面積;第二階段為產量預測,基于BP神經網絡擬合數據集的果實數量、邊界框面積和產量。

采用PyTorch深度學習框架進行模型的搭建,系統硬件配置為AMD Ryzen7 4800H CPU@2.9GHz處理器,6 GB NVIDIA GeForce GTX 1660Ti GPU,16 GB運行內存,512 GB SSD硬盤容量,訓練和測試所用的操作系統為Windows 10,64位系統。代碼編譯器為PyCharm2019.3.3社區版,并且配置了CUDA 10.2和cuDNN 7.6.5進行GPU加速工作。

4算法測試與試驗

4.1果實檢測算法性能分析

本研究選取平均準確率(mAP)作為算法的整體評價指標。查準率(P)是指被預測為正例的樣本中實際為正樣本的比例,查全率(R)是指實際為正例的樣本中被預測為正樣本的比例,根據查準率和查全率之間的關系可以繪制查準率一查全率曲線(P-R曲線)。所有類別的準確率(AP)是指曲線與坐標軸圍成區域的面積,求出所有類別的4P并取均值,可得各類別的mAP,計算如公式(8)~(11)所示。

(8)

(9)

(10)

(11)

其中,TP為正樣本預測正確的數量,個;FN為負樣本預測錯誤的數量,個;FP為正樣本預測錯誤的數量,個;TN為負樣本預測正確的數量,個;p(r)為不同查準率r下對應的查全率p;AP為第i類的檢測準確率;N為類別數量,個。

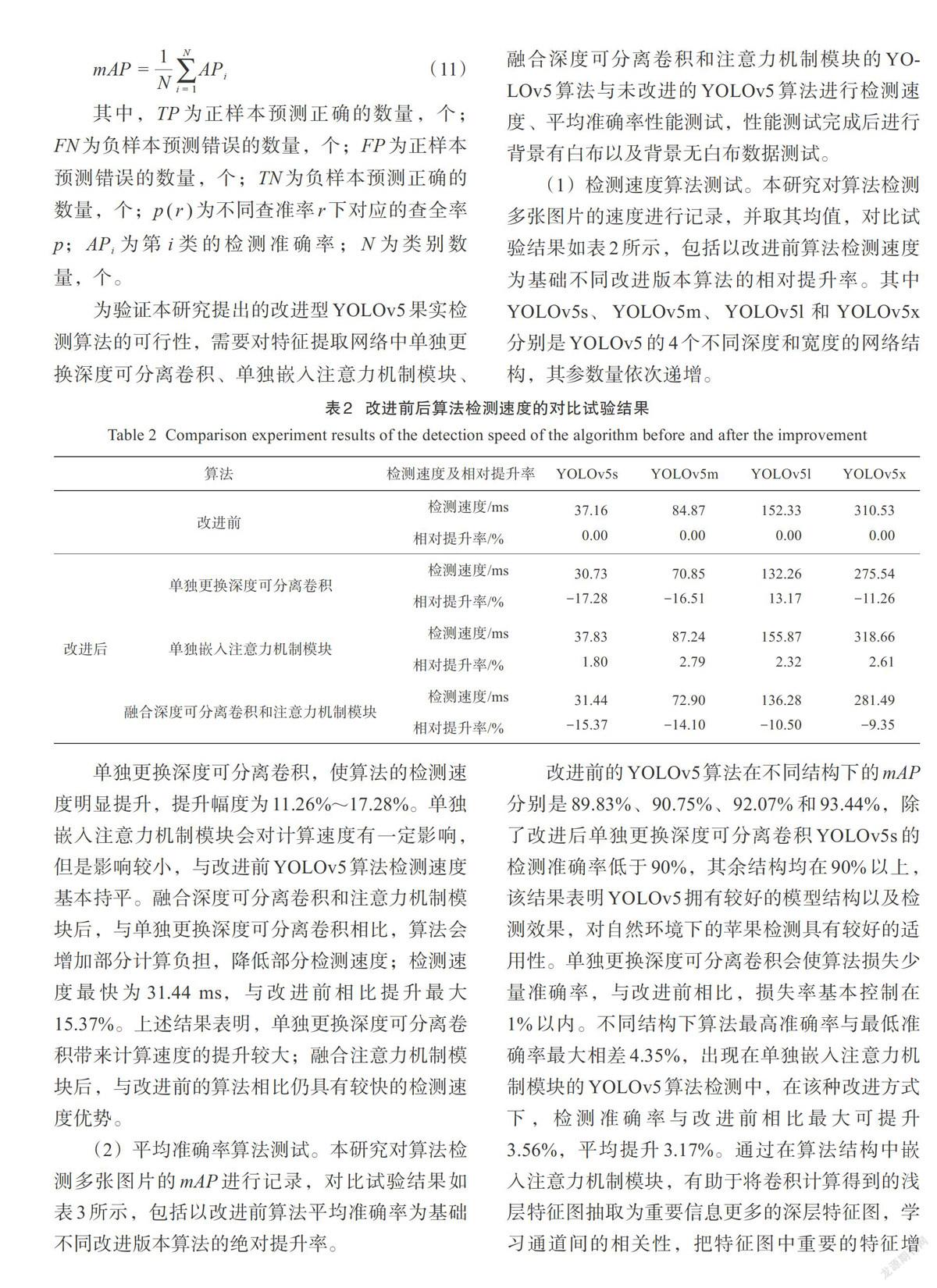

為驗證本研究提出的改進型YOLOv5果實檢測算法的可行性,需要對特征提取網絡中單獨更換深度可分離卷積、單獨嵌入注意力機制模塊、融合深度可分離卷積和注意力機制模塊的YOLOv5算法與未改進的YOLOv5算法進行檢測速度、平均準確率性能測試,性能測試完成后進行背景有白布以及背景無白布數據測試。

(1)檢測速度算法測試。本研究對算法檢測多張圖片的速度進行記錄,并取其均值,對比試驗結果如表2所示,包括以改進前算法檢測速度為基礎不同改進版本算法的相對提升率。其中YOLOv5s、YOLOv5m、YOLOv51和YOLOv5x分別是YOLOv5的4個不同深度和寬度的網絡結構,其參數量依次遞增。

單獨更換深度可分離卷積,使算法的檢測速度明顯提升,提升幅度為11.26%~17.28%。單獨嵌入注意力機制模塊會對計算速度有一定影響,但是影響較小,與改進前YOLOv5算法檢測速度基本持平。融合深度可分離卷積和注意力機制模塊后,與單獨更換深度可分離卷積相比,算法會增加部分計算負擔,降低部分檢測速度;檢測速度最快為31.44ms,與改進前相比提升最大15.37%。上述結果表明,單獨更換深度可分離卷積帶來計算速度的提升較大;融合注意力機制模塊后,與改進前的算法相比仍具有較快的檢測速度優勢。

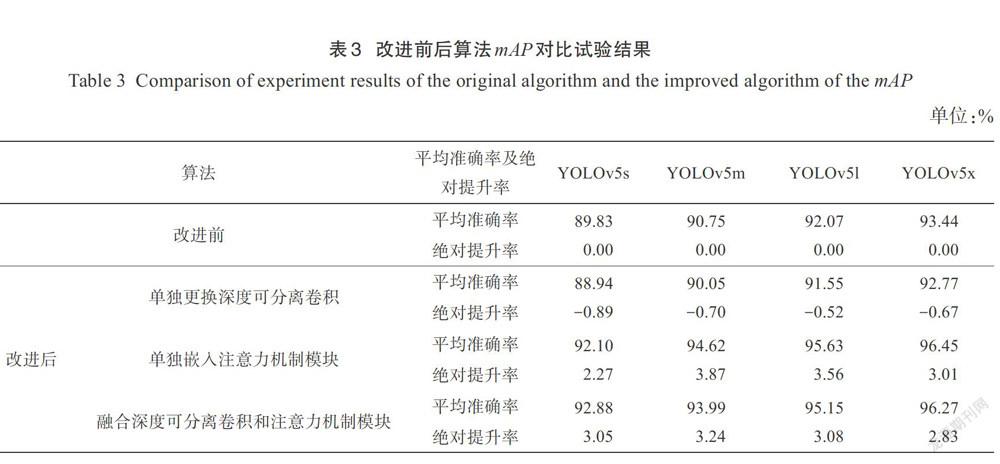

(2)平均準確率算法測試。本研究對算法檢測多張圖片的mAP進行記錄,對比試驗結果如表3所示,包括以改進前算法平均準確率為基礎不同改進版本算法的絕對提升率。

改進前的YOLOv5算法在不同結構下的mAP分別是89.83%、90.75%、92.07%和93.44%,除了改進后單獨更換深度可分離卷積YOLOv5s的檢測準確率低于90%,其余結構均在90%以上,該結果表明YOLOv5擁有較好的模型結構以及檢測效果,對自然環境下的蘋果檢測具有較好的適用性。單獨更換深度可分離卷積會使算法損失少量準確率,與改進前相比,損失率基本控制在1%以內。不同結構下算法最高準確率與最低準確率最大相差4.35%,出現在單獨嵌入注意力機制模塊的YOLOv5算法檢測中,在該種改進方式下,檢測準確率與改進前相比最大可提升3.56%,平均提升3.17%。通過在算法結構中嵌人注意力機制模塊,有助于將卷積計算得到的淺層特征圖抽取為重要信息更多的深層特征圖,學習通道間的相關性,把特征圖中重要的特征增強,次要的特征減弱,對關鍵信息進行更進一步的提取,有效提升算法的整體檢測效果。融合后的YOLOv51和YOLOv5x檢測準確率均超過95%,其中YOLOv5x的檢測準確率達到96.27%,為測試結果最高。以上結果均表明改進后的Y0L0v5算法具有較高的檢測準確率。

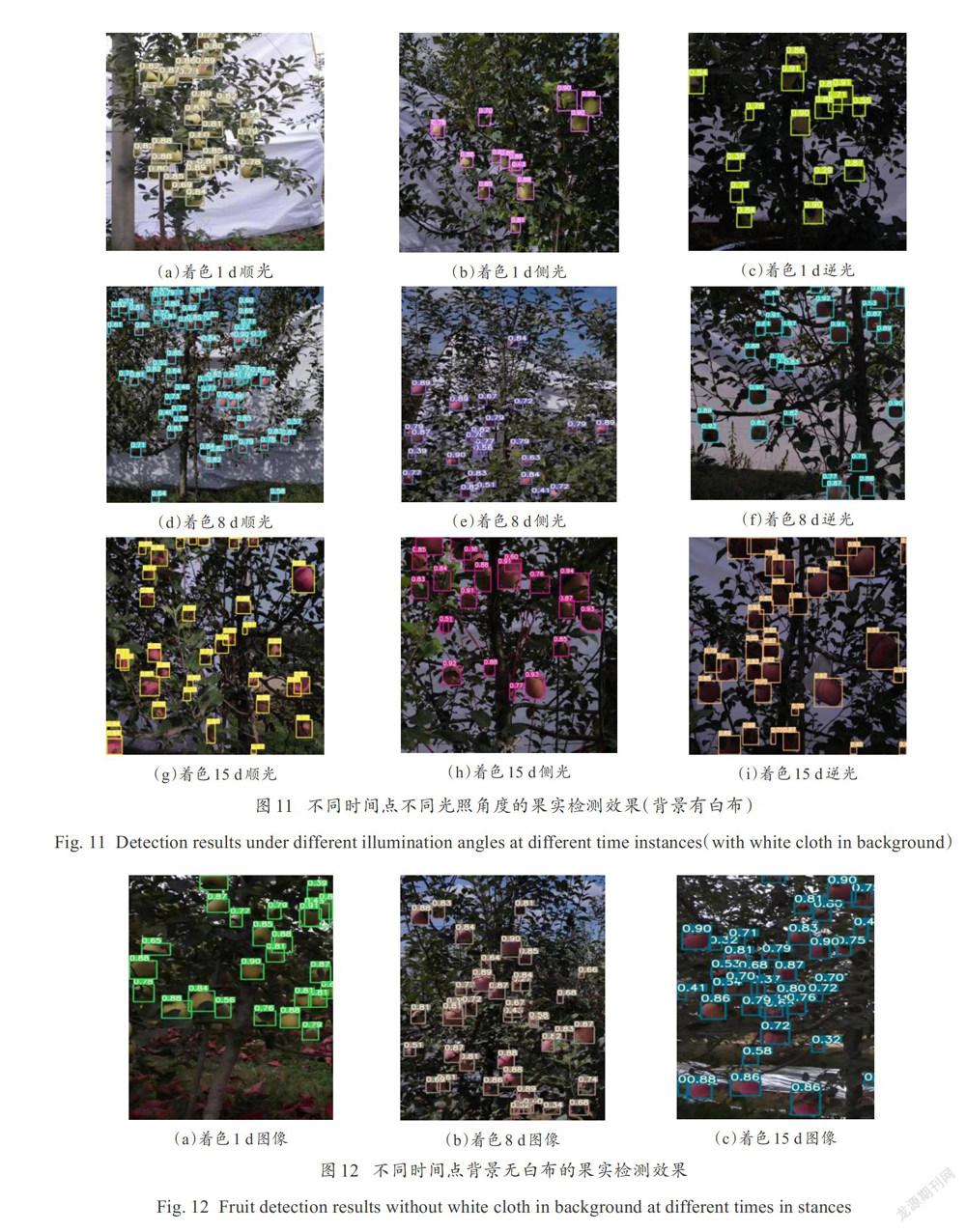

(3)背景有白布算法測試。在自然光照條件下,太陽光作為主要的光源,不同的拍攝角度會在一定程度上影響目標檢測的mAP。本研究選取了不同時間點下不同光照角度的蘋果圖像作為樣本數據集,對改進后的YOLOv5模型進行迭代訓練,目標檢測效果如圖11。

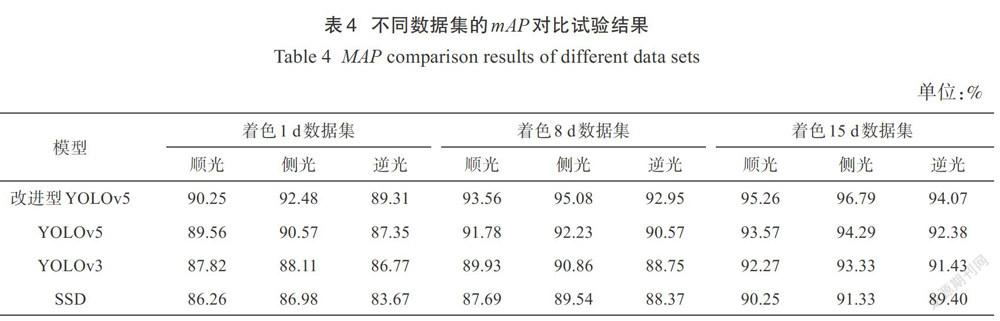

順光拍攝的照片明亮清晰,不會出現明顯的光影變化;側光拍攝的照片層次分明,物體有較為明顯的輪廓;逆光拍攝的照片陰暗模糊,容易出現曝光不足。本研究針對上述不同數據集,并且與YOLOv5、YOLOv3、SSD等模型進行對比實驗,各模型檢測結果如表4所示。

改進的YOLOv5在各種不同的光源和時間點的數據中,全部得到了最好的檢測結果。最高mAP出現在著色15d側光數據集,達到96.79%,在不同數據集中表現均優于YOLOv5、YOLOv3、SSD,在不同測試集中平均mAP為93.30%,說明改進YOLOv5算法具有較好的檢測性能;所有算法在側光條件下檢測效果最好,在逆光條件下檢測效果最差的原因是:逆光下樹葉與果實的顏色較暗,果實邊緣不夠清晰,容易造成混淆,增加目標檢測難度;算法效果隨著色時間提高,原因在于著色1d果實顏色與樹葉顏色較為接近,呈現出綠色,容易誤識別,而第15d果實顏色較為鮮艷,可以明顯與周圍葉片區分開,檢測準確率較高。

(4)背景無白布算法測試。為驗證改進型YOLOv5果實檢測算法在自然環境下的應用效果,對無白色背景的著色1d、8d和15d蘋果圖像進行測試,結果如圖12。

結果可知,算法均可完成檢測任務,對近處的果實識別率較高。由于近處的蘋果區域面積較大,呈現特征較多,算法對其預測的置信度較高;遠處的蘋果在圖像上占據的像素點數量較少,呈現的特征較少,識別置信度受到影響。

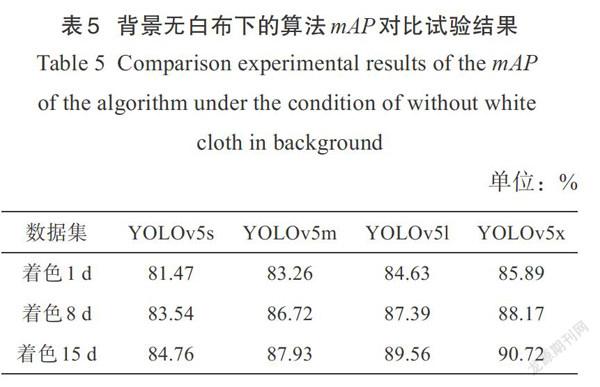

表5為無白布背景下的算法mAP對比結果,與背景有白布的算法檢測準確率相比,在不同著色時間的數據集下均有一定的準確度損失。但是對于果樹測產而言,需要測定的是距離攝像頭較近的果樹產量,利用算法過濾背景中的果樹果實,減少背景果實對其產量的影響,因此在該背景下并不是檢測準確率越高越好。本研究的果實檢測算法恰能滿足識別近處蘋果、濾除遠處蘋果的要求,可適用于背景無白布的果實檢測。

4.2產量擬合網絡性能分析

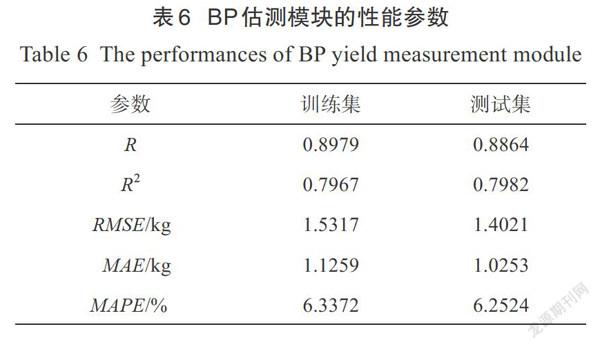

采用表6中的相關參數評估產量擬合網絡的性能。相關系數R和決定系數R用于衡量預測產量和實際產量之間的相關程度,數值越大表明二者的相關性越好;均方根誤差RMSE用來衡量預測產量和實際產量之間的誤差,其值越小表明精確度越高;平均絕對誤差MAE和平均絕對百分比誤差MAPE能夠反映預測產量偏離實際產量的程度,數值越小,表明二者差別越小,擬合效果越好。在訓練集和測試集上預測產量和實際產量的R分別為0.8979和0.8864,R分別為0.7967和0.7982,表明果實數量、邊界框面積和產量之間線性相關程度較高,曲線擬合較好。

對于訓練集樣本,RMSE為1.5317 kg,MAE為1.1259 kg,MAPE為6.3372%;對于測試集樣本,RMSE為1.4021 kg,MAE為1.0253 kg,MAPE為6.2524%。

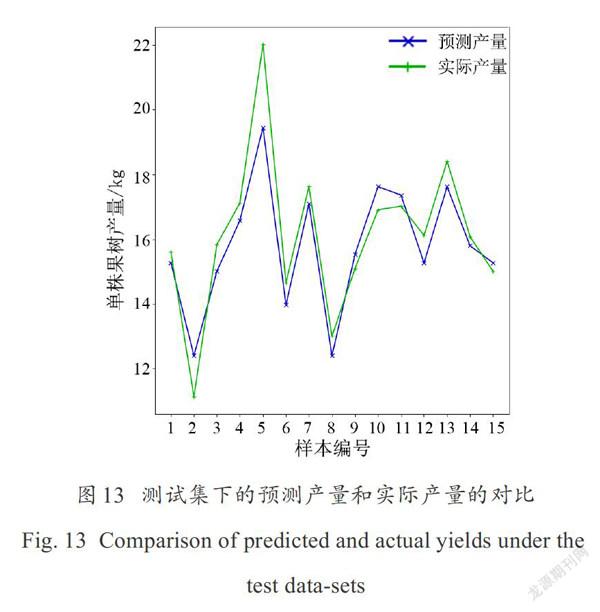

基于樣本訓練集建立的產量擬合網絡,在測試集上的對比結果如圖13所示。可見,該模型可以較好地預測出果樹產量,對于不同產量樣本的預測精度基本穩定,具有較好的魯棒性。通過測試結果可知該模型可適用于自然環境下果樹收獲前的產量測定。

4.3測產模型測試

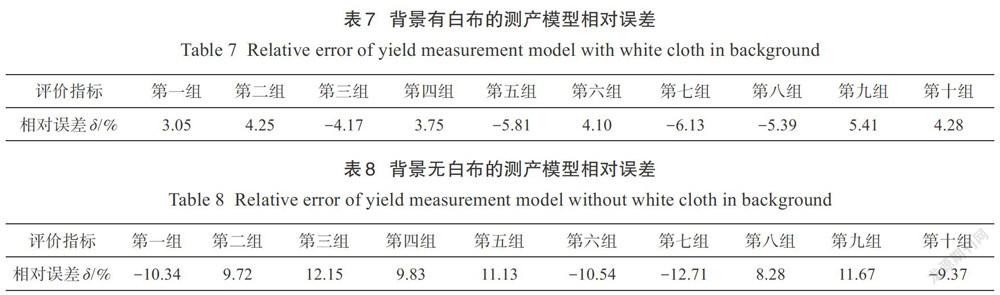

(1)背景有白布的測產模型性能測試。用本研究提出的蘋果樹測產模型,以產量驗證集中背景有白布的果樹圖像作為輸入,輸出該株果樹的預測產量。由表7所示的相對誤差可見,測產模型相對誤差的絕對值取值范圍為3.05%~6.13%。在對10組數據的預測過程中,僅有第7組的誤差稍大,總體相對誤差范圍基本在7%以內。表明提出的果樹測產模型對于輸入背景有白布的果樹圖像,有著較好的產量預測效果;可以通過果實檢測算法和產量擬合網絡的協調工作,學習到圖像數據以及產量數據的重要特征,輸出相應的預測產量。

(2)無白布背景的測產模型性能測試。為驗證本研究提出的測產模型在自然環境下的應用效果,選用產量驗證集中圖像背景無白布的數據集作為模型輸入,輸出該株果樹的預測產量,經過計算后得到表8所示的相對誤差。

與背景有白布的測試結果相比,背景無白布的測產模型相對誤差偏大,絕對值的取值范圍為8.28%~12.71%。出現這一現象的主要原因在于背景中有其他果樹果實的干擾,產量擬合網絡在預測產量時會將檢測到的果實均判定為當前果樹果實,導致結果出現一定的偏差。但是,背景果樹中僅有部分特征較多的蘋果會被識別,大部分蘋果由于距離較遠,在圖像中占據的像素點較少,檢測算法不能識別,因此造成的影響不大,相對誤差總體范圍在13%以內。上述結果表明,本研究提出的測產模型具有良好的精度和有效性,并且在不同背景下的測產魯棒性較好,可適用于自然環境下的蘋果樹產量測定。

5結論

本研究提出了一種蘋果樹測產模型,融合產量擬合網絡和改進型YOLOv5果實檢測算法,結合數據集預處理,對模型進行了訓練和應用,結論如下。

(1)通過更換深度可分離卷積和添加注意力機制模塊改進的YOLOv5蘋果檢測網絡,解決網絡中存在的特征提取時無注意力偏好問題和參數冗余問題。以圖像數據集為輸入,得到估測果實數量以及邊界框面總積。測試結果表明,該算法可以在提高輕量化程度的同時提升準確率,與改進前相比,檢測速度最大可提升15.37%,平均mAP最高達到96.79%,在不同數據集下的測試結果表明光照條件、著色時間以及背景有無白布均對算法準確率有一定影響。

(2)以估測果實數量與邊界框面積為輸入、實際產量為輸出,訓練產量擬合網絡,測試結果表明,產量擬合網絡訓練集和測試集的R分別為0.7967和0.7982,RMSE分別為1.5317和1.4021 kg,測產誤差較小。

(3)將果實檢測算法和產量擬合網絡融合得到最終的測產模型。試驗結果表明,果樹測產模型在背景有白布和無白布的條件下,相對誤差范圍分別在7%以內和13%以內,證明本研究建立的蘋果園原位測產模型具有較好的精度和魯棒性。如增加更多的樣本作為數據輸入,可進一步提高目標的識別度和測產的準確性。

參考文獻:

[1]黑龍江省佳木斯農業學校,江蘇省蘇州農業學校.果樹栽培學總論[M].北京:中國農業出版社,2009.

Jiamusi Agricultural. School of Heilongjiang province, Suzhou Agricultural. School of Jiangsu province. General. introduction to fruit cultivation[M]. Beijing: China Agriculture Press, 2009.

[2]王少敏,張毅,高華軍,等.蘋果套袋栽培技術[M].濟南:山東科學技術出版社,2006.

WANG S, ZHANG Y, GAO H, et al. Apple bagging cultivation technology[M]. Jinan: Shandong Science and Technology Press, 2006.

[3] PAPAGEORGIOU E I, AGGELOPOULOU K D, GEMTOS T A, et al. Yield prediction in apples using fuzzy cognitive map learning approach[J]. Computers and Electronics in Agriculture, 2013, 91: 19-29.

[4] AGGELOPOULOU A D, BOCHTIS D, FOUNTAS S,et al. Yield prediction in apple orchards based on image processing[J]. Precision Agriculture, 2011, 12(3):448-456.

[5] ZHOU R, DAMEROW L, SUN Y, et al. Using colour features of cv.'Gala' apple fruits in an orchard in image processing to predict yield[J]. Precision Agriculture, 2012, 13(5):568-580.

[6]程洪,DAMEROW L, BLANKE M,等.基于樹冠圖像特征的蘋果園神經網絡估產模型[J].農業機械學報,2015, 46(1): 14-19.

CHENG H, DAMEROW L, BLANKE M, et al. Ann model for apple yield estimation based on feature of tree image[J]. Transactions of the CSAM, 2015, 46(1): 14-19.

[7] CRTOMIR R, CVELBAR U, TOJNKO S, et al. Application of neural. networks and image visualization for early predicted of apple yield[J]. Erwerbs-Obstbau, 2012, 54(2): 69-76.

[8] ROY P, KISLAY A, PLONSKI P, et al. Vision-based preharvest yield mapping for apple orchards[J]. Computers and Electronics in Agriculture, 2019, 164: ID 104897.

[9] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time objectdetection[C]//The IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, New York, USA: IEEE, 2016: 779-788.

[10] REDMON J, FARHADI A. YOLO9000: Better, faster, stronger[C]// The IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, New York, USA: IEEE, 2017: 7263-7271.

[11] REDMON J, FARHADI A. YOLO v3: An incremental. improvement[EB/OL]. 2018. arXiv: 1804.02767vl.

[12] BOCHKOVSKIY A, WANG C, LIAO H. YOLOv4: Optimal. speed and accuracy of object detection[EB/OL]. 2020. arXiv: 2004.10934.

[13] LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector[C]// European Conference on Computer Vision. Cham, Switzerland: Springer,2016: 21-37.

[14] ZHANG S, WEN L, BIAN X, et al. Single-shot refinement neural. network for object detection[C]// The IEEE Conference on Computer Vision and Pattern Reco-gnition. Piscataway, New York, USA: IEEE, 2018: 4203-4212.

[15] WANG D, ZHANG B, CAO Y, et al. SFSSD: Shallow feature fusion single shot multibox detector[C]// International. Conference in Communications, Signal. Processing, and Systems. Cham, Switzerland: Springer, 2019: 2590-2598.

[16] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]// The IEEE Conference on Computer Vision and Pattern Recognition. Piscataway,New York, USA: IEEE, 2014: 580-587.

[17] GIRSHICK R. Fast R-CNN[C]// Proceedings of the IEEE International. Conference on Computer Vision. Piscataway, New York, USA: IEEE, 2015: 1440-1448.

[18] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal. networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[19]周偉鴻,朱思霖.基于深度學習技術的智慧考場方案的應用探究[J].信息技術與信息化,2020(12): 224-227.

ZHOU W, ZHU S. Research on the application of smart examination room solutions based on deep learning technology[J]. Information Technology and Informatization, 2020(12): 224-227.

[20]王洋.改進YOLOv5的口罩和安全帽佩戴人工智能檢測識別算法[J].建筑與預算,2020(11): 67-69.

WANG F. Artificial. intelligence detection and recognition algorithm for masks and helmets based on improved YOLOv5[J]. Construction and Budget, 2020 (11): 67-69.

[21] WANG C Y, LIAO H Y M, YEH I H, et al. CSPNet: A new backbone that can enhance learning capability of CNN[C]// The IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Seattle, WA, USA: CVPRW, 2020: 390-391.

[22] LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detect-ion[C]// The IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, New York, USA: IEEE, 2017: 2117- 2125.

[23] LIU S, QI L, QIN H, et al. Path aggregation network for instance segmentation[C]// The IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, New York, USA: IEEE, 2018: 8759-8768.

[24]李德鑫,閆志剛,孫久運.基于無人機視覺的河道漂浮垃圾分類檢測技術研究[J/OL].金屬礦山:1-11.[2021-06-20]. http://kns.cnki.net/kcms/detail/34.1055.TD.20210608.1117.005.html.

LI D, YAN Z, SUN J. Study on classification and detection technology of river floating garbage based on UAV vision[J/OL]. Metal. Mine: 1-11. [2021-06-20].http://kns.cnki.net/kcms/detail/34.1055.TD.20210608.1117.005.html.

[25] SIFRE L, MALLAT S. Rigid-motion scattering for texture classification[J]. Computer Science, 2014, 3559: 501-515.

Yield Estimation Method of Apple Tree Based on Improved Lightweight YOLOv5

LI Zhijun1,2, YANG Shenghui1,2, SHI Deshuai1,2, LIU Xingxing1,2, ZHENG Yongjun1,2*

(1. College of Engineering. China Agricultural. University, Beijing 100083, China; 2. Yantai Institute of China Agricultural. University. Yantai 264670, China)

Abstract: Yield estimation of fruit tree is one of the important works in orchard management. In order to improve the accuracy of in-situ yield estimation of apple trees in orchard, a method for the yield estimation of single apple tree, which includes an improved YOLOv5 fruit detection network and a yield fitting network was proposed. The in-situ images of the apples without bags at different periods were acquired by using an unmanned aerial. vehicle and Raspberry Pi camera, formed an image sample data set. For dealing with no attention preference and the parameter redundancy in feature extraction, the YOLOv5 network was improved by two approaches: 1) replacing the depth separable convolution, and 2) adding the attention mechanism module, so that the computation cost was decreased. Based on the improvement, the quantity of fruit was estimated and the total. area of the bounding box of apples were respectively obtained as output. Then, these results were used as the input of the yield fitting network and actual. yields were applied as the output to train the yield fitting network. The final. model of fruit tree production estimation was obtained by combining the improved YOLOv5 network and the yield fitting network. Yield estimation experimental. results showed that the improved YOLOv5 fruit detection algorithm could improve the recognition accuracy and the degree of lightweight. Compared with the previous algorithm, the detection speed of the algorithm proposed in this research was increased by up to 15.37%, while the mean of average accuracy (mAP) was raised up to 96.79%. The test results based on different data sets showed that the lighting conditions, coloring time and with white cloth in background had a certain impact on the accuracy of the algorithm. In addition, the yield fitting network performed better on predicting the yield of apple trees. The coefficients of determination in the training set and test set were respectively 0.7967 and 0.7982. The prediction accuracy of different yield samples was generally stable. Meanwhile, in terms of the with/without of white cloth in background, the range of relative error of the fruit tree yield measurement model was respectively within 7% and 13%. The yield estimation method of apple tree based on improved lightweight YOLOv5 had good accuracy and effectiveness, which could achieve yield estimation of apples in the natural. environment, and would provide a technical. reference for intelligent agricultural. equipment in modem orchard environment.

Key words: apple in-situ yield estimation; deep learning; fruit detection; BP neural. network; YOLOv5

(登陸www.smartag.net.cn免費獲取電子版全文)

作者簡介:李志軍(1996—),男,碩士研究生,研究方向為智能農業裝備。E-mail:335022969@qq.com。

*通訊作者:鄭永軍(1973—)男,博士,教授,研究方向為智能農業裝備。電話:13810868016。E-mail:zyj@cau.edu.cn。