模態自適應權值學習機制下的多光譜行人檢測網絡

陳 瑩,朱 宇

(江南大學 輕工過程先進控制教育部重點實驗室,江蘇 無錫214122)

1 引 言

行人檢測是自動駕駛、智能視頻監控等領域的核心技術,要求能適應全天候及各種場景的變換。傳統行人檢測的輸入源是可見光模態,可見光圖像在光照充足的情況下,能提供豐富的視覺信息,一旦環境改變,提供的視覺信息會非常有限,所以傳統的行人檢測極易受到不良光照及惡劣天氣的影響。為了解決這一問題,一種能同時應用紅外和可見光兩種模態信息的多光譜行人檢測技術應運而生。紅外模態作為多光譜行人檢測的另一輸入源,其使用紅外成像技術提供的紅外圖片在黑暗條件下可以較好地顯示出人體,彌補可見光模態的不足,但通常在光照較好時,其表現力不如可見光圖片,因此這種動態變化要求檢測過程中能夠有效地融合利用多模態信息。

近年來,針對多光譜行人檢測中的多模態信息融合問題,文獻[1]研究了卷積神經網絡不同融合時期(前期,中間,后期)以及同一融合方法直接堆疊對實驗結果的影響,得出利用中間層特征直接堆疊策略可以最大限度地整合紅外和可見光信息。Konig 等[2]使用Faster R-CNN 框架[3]中的區域建議生成網絡和隨機森林算法協同完成檢測,采用文獻[1]的融合方式,但在后續訓練中同時使用到融合后的特征層以及原始雙流的兩模態特征層。文獻[4]采用一種新型無監督行人檢測方式,在特征融合部分沿用特征堆疊策略。Song 等[5]將像素級圖像融合與基于卷積神經網絡的行人檢測算法結合。然而這幾種算法均未能關注到每種模態對檢測任務的貢獻不同,無法有效地適應環境的動態變化。Lee 等[6]考慮到上述算法[1-2,4]中特征堆疊策略的不足,在特征融合時加入特征關聯層,但側重的是對模態特征進行特征加強,未充分考慮模態與模態之間的關系,文獻[7-8]考慮到不同光照條件下每種模態融合的權重不同,設計了一個光照感知網絡,模擬白天黑夜照明情況,但結果的優劣過于依賴光照感知網絡。

針對上述問題,本文提出了一個基于多模態自適應權值學習融合機制的行人檢測網絡。首先將兩種模態的圖片送入雙流多光譜行人檢測框架中,再分別從兩流提取特征送入自適應權值學習融合網絡中,網絡根據每種模態的貢獻差異,學習到每流特征的權值,因此兩流特征加權融合得到融合特征,然后在融合特征的基礎上生成新的特征金字塔,同時為減少行人負樣本數量,采用了一種豐富行人先驗信息的策略,完成行人檢測任務。

2 基于多光譜信息融合的行人檢測

2.1 問題分析

在多光譜行人檢測中,紅外和可見光兩種模態表現出來的特征不同[9]。可以為行人檢測提供互補的信息。因此多光譜信息的融合方式尤為重 要 ,目 前 有 直 接 堆 疊 策 略[1-2,4],特 征 關 聯 策略[6]等。

直接堆疊策略直接在輸入時或在訓練過程中選定某一層對兩模態做通道堆疊,即兩模態之間按1:1 的權重進行融合,未考慮不同模態對任務的不同影響,易丟失有效特征信息[10],影響檢測性能。特征關聯策略提取某一層雙流特征并相乘,將相乘后的特征再與原始特征堆疊作為融合特征。該策略雖然對特征信息進行了加強,也考慮到模態之間的交互性,但還是未完全考慮到兩模態在不同場景下對任務的貢獻比重不同,同時在融合時這兩種策略均只是選擇了某一特定層,而忽視了剩余特征層的重要性。

圖1 紅外和可見光圖像對Fig. 1 Infrared and visible image pairs

如圖1 所示,第一列和第二列分別是可見光和紅外圖片,每一行的圖片均是在同一場景和時刻拍攝的,圖中用綠框標出了同一目標在兩張圖像上的差異(彩圖見期刊電子版)。當光照充足,四周無遮擋時,可見光圖像(a)上的行人顯示得較為完整,而對應紅外圖像(b)上目標卻不能被分辨出來。同樣在白天,可見光圖像(c)上的目標由于被樹蔭遮擋,無法顯示出完整的人形,而紅外圖像(d)能區分出行人和背景。由此可見,不同情況下,檢測網絡對兩模態的依賴程度存在著較大差異,因此需要一種融合策略能自適應環境改變,根據檢測任務學習兩個模態的差異性,從而為兩個模態分配相應權重。

2.2 網絡框架

結合以上問題,以及多光譜行人檢測是目標檢測中的一個特殊任務,需要針對其在輸入的多源性以及檢測行人任務的單一性兩方面搭建合適的基礎框架。本文選用Li 等[11]提出的FSSD(Feature Fusion Single shot Multibox Detector)框架作為檢測的基礎框架,并將其擴展為雙流。FSSD 級聯原始檢測器SSD[12]中不同尺度的特征層,以融合高層語義信息和低層細節信息,這是因為SSD 對于高分辨率的低層特征沒有再利用[13],而這些層對于檢測類似行人這樣的小目標很重要,這也是本文算法選擇FSSD 的主要原因。

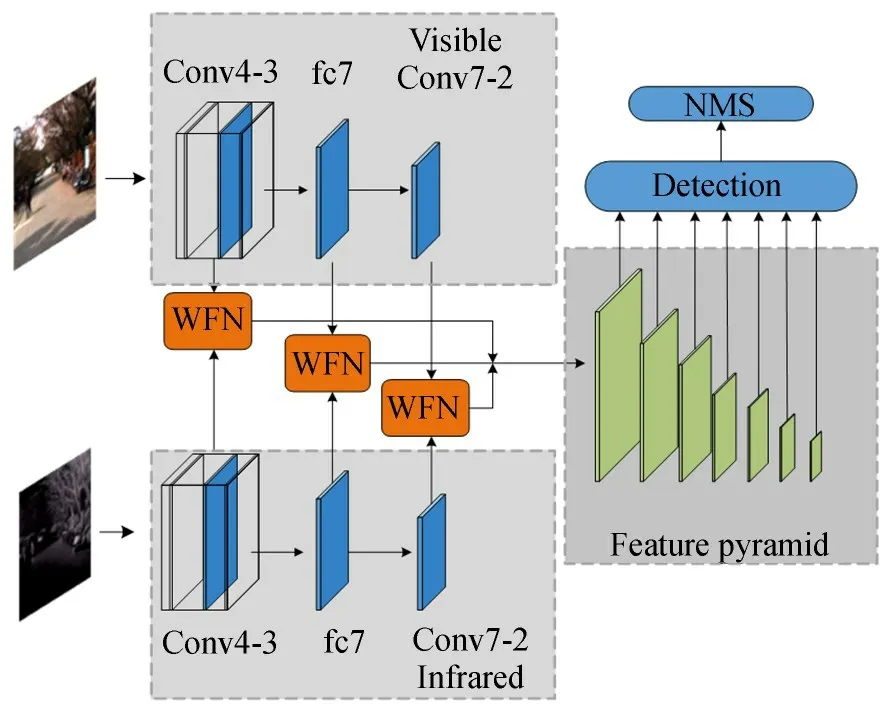

網絡框架如圖2 所示,512×512,對齊的可見光和紅外圖片先經過前向傳播的兩分支網絡提取特征,再將特征送入權值學習融合網絡(Weight-learning Fusion Network,WFN)完成加權融合,然后利用融合特征生成特征金字塔用于行人的分類和回歸,最終的檢測結果會經過非極大 值 抑 制(Non-Maximum Suppression,NMS)層。下面介紹網絡的組成。

圖2 多光譜行人檢測框架Fig. 2 Multispectral pedestrian detection network framework

2.2.1 可見光和紅外分支

紅外分支與可見光分支的網絡結構完全相同,均是以在ImageNet 上預訓練的VGG16 網絡為基礎網絡。在特征提取階段,文獻[11]中提出尺寸小于10×10 的特征層可提供的信息較少,因此本文選取VGG16 網絡的conv4-3 和fc7 特征層,兩層尺寸分別為64×64,38×38,并添加了19×19 的conv7-2 層,得到可見光分支的三個特征 :f1,f2,f3,及 對 應 的 紅 外 分 支 的 三 個 特

2.2.2 模態融合部分

模態融合主要利用WFN 完成模態的加權融合,本文將在2. 3 節介紹WFN 模塊。該部分首先將提取得到的三組對應特征送入WFN,進行模態加權融合,得到加權融合后的三個高低層特征F1,F2,F3,并對三個特征進行尺寸歸一化,即先利用1×1 的卷積核對三個特征進行通道降維,再使用雙線性插值法將尺寸歸一化為64×64,最后級聯這三個特征得到特征Fc。具體操作如式(1)~式(2)所示,其中i表示層數,i= 1,2,3,ΦW表示經過WFN 完成的加權融合操作,ΦC表示級聯操作,Γi指對特征的尺寸歸一化操作。

2.2.3 特征金字塔

特征金字塔部分用于完成行人目標的分類以及檢測框的定位和回歸。與原始FSSD 不同,本文算法是對兩模態融合后的融合特征Fc,而不是對單一流的特征操作,以獲得更多模態之間的交互信息。具體操作是采用下采樣方法,即利用7 組3×3 的卷積核和relu 的組合操作實現,生成圖1 右側的特征金字塔。

2.3 自適應加權融合網絡

針對2. 1 節提出的問題,受文獻[14]中RGB圖與深度圖融合方法的啟發,本文在雙流檢測網絡中對雙流融合機制進行設計,提出自適應權值學習融合網絡。該網絡可以自適應關注兩個模態的重要信息,從而學習并分配權重,強化對重要信息的學習。 本文對從兩個分支對應的conv4-3,fc7,conv7-2 層提取到的三組特征對都嵌入了WFN 模塊,以充分利用每一層的特征。第三部分的實驗證明了選取該融合時機的有效性。

圖3 權值學習融合網絡Fig. 3 Weight-learning fusion network

網絡框架如圖3 所示,圖中左側第一個框是直接堆疊方法,即級聯融合,網絡輸入為尺寸相同 的 可 見光 和 紅 外特 征fi和fi′(i表 示 層 數,i=1,2,3),級聯融合是做簡單的通道堆疊操作,從而得到通道堆疊后的特征Sfi,在直接堆疊融合算法中,之后的訓練直接應用特征Sfi。本文則是對特征Sfi進行加權操作,得到一組權重矩陣,然后分別與原始特征相乘,得到分別加權后的兩個特征,再級聯得到最終加權融合后的特征Fi。該網絡主要由以下兩個部分組成。

2.3.1 加權部分

該部分由3×3 卷積和sigmoid 激活函數組合完成加權操作。其中3×3 的卷積操作是為了在分離特征Sfi時,進一步加深特征的深度。分離出的兩組特征再經過sigmoid 激活函數得到對應權重矩陣wi,w′i,如式(3)~式(4)所示。其中C1,C2表示卷積核的權重,b1,b2表示卷積核的偏差,

sigmoid 函數輸出在(0,1)之間,輸出范圍有限,優化穩定。兩個權重矩陣wi,w′i各自代表了每個模態對網絡的貢獻。當光照充足,可見光模態對網絡的貢獻較大,相應wi就越接近于1,wi′則接近0;相反,當網絡更依賴紅外模態時,wi′ 接近1,wi則接近0,且wi,wi′ 是由網絡自主學習得來,可以自適應外界環境的動態變化。將獲得的權重矩陣與原始特征相乘,那么加權后的兩個特征就分別代表了模態最優特征。

2.3.2 級聯部分

自適應加權融合網絡中有兩個部分應用到了級聯(concat),第一次是將輸入的一組特征fi,fi′級聯。第二次是將加權后的特征級聯,并使用1×1 的卷積核降維,得到加權融合后的特征Fi。

2.4 豐富行人先驗信息

FSSD 是單階段的檢測算法[15],沒有雙階段目標檢測器Faster-RCNN 的候選區域生成階段[16],而是采用了先驗框(Prior boxes)機制預設不同大小的先驗框。FSSD 設置了五種不同寬高比的先驗框,以檢測出不同大小的各種目標。但是行人檢測只有行人一個目標,不同寬高比的先驗框不僅增加了網絡的計算量,還給行人目標的檢測帶來了干擾信息。

如圖4 所示本文統計了kaist 多光譜行人數據集[17]中訓練集的行人實例的寬高比,由此在本文中將寬高比簡化成0. 41。同時因為我們在網絡訓練過程中只采用行人實例高度大于50 的圖片,所以針對先驗框的尺寸也進行了重新設置,并為了應對行人擁擠的場景,在水平方向增加先驗框的密集度,如圖5 右所示(圖5 左是原始先驗框設置)。

圖4 寬高比統計Fig. 4 Statistics of aspect ratio

圖5 先驗框設置Fig. 5 Prior boxes settings

2.5 損失函數和優化方法

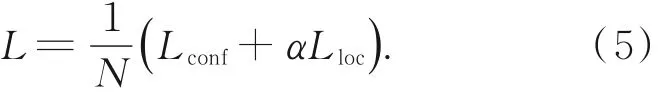

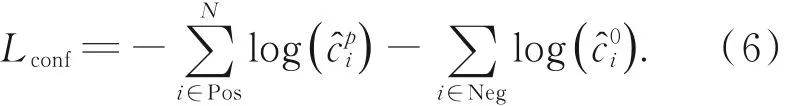

網絡的損失函數是位置和分類損失的加權和,如式(5)所示。 其中,N是匹配的先驗框數量,α是兩損失的加權值,本文使用文獻[12]中的默認設置,將α設為1。

分類損失如式(6)所示是softmax 損失。指網絡輸出的第i個樣本框為p類的置信度其中t=1 時代表分類為行人,t=0時則為背景。

位置損失如式(7)所示是正樣本(i∈pos)的真實框g和預測框l偏移量的smooth-L1 損失,(cx,cy)是框的中心點坐標,w,h分別是框的寬和高。是第i個預測框和第j個標注框的偏移量的定義如式(8)所示,其中d是先驗框。

本文采用隨機梯度下降算法,以提高訓練速度,加快網絡學習進程。

3 實驗結果與分析

3.1 實驗配置

本文提出的算法是在深度學習框架Pytorch下完成的,實驗所使用環境Ubuntu14. 0,CUDA8. 0. 61,python3. 6,硬件配置為TITAN XP。網絡的初始學習率為0. 000 5,沖量為0. 9,權重衰減項為0. 000 5。

3.2 數據集與評價指標

本實驗使用的公開數據集是kaist 多光譜數據集,該數據集是目前為止國內外最大型,且能提供成對配準標注的紅外和可見光圖像的多光譜行人檢測數據集,包含95 328 對,103 128 個密集標注的,交通場景下的紅外可見光圖像對,且圖像尺寸均為640×512。為與其他算法[4-9,18]保持數據一致性,本文沿用文獻[1]的處理方式:在訓練集中去除嚴重遮擋以及行人高度<50 的行人實例,得到最終用于訓練的7 904 張訓練圖片。測試集使用原數據集劃分的2 252 張圖片,包含白天和夜晚拍攝的圖片。

網絡訓練時為了維持正負樣本的平衡,正負樣本比例設置為1∶3,并為了增強網絡的泛化能力,采用了數據增廣策略。

實驗計算對數空間下[10-2,100]的平均漏檢率(Log-average Miss Rate,MR)來比較算法性能。MR 值越小,則算法性能越優。同時在空間對數坐標下繪制的missrate-FPPI 曲線圖[19]也用來評估算法的性能,該曲線圖橫坐標是平均每張圖片中負樣本被檢測為正樣本的數量(False Positives Per Image,FPPI),縱坐標是指在實際為正的樣本中,未被正確檢測出來的概率,即漏檢率(Miss Rate)。 曲線越低,代表的算法性能越優。

3.3 消融實驗

3.3.1 多模態信息的重要性及互補性

本部分比較了單支可見光,紅外以及雙支多模態網絡的性能。表1 是三種網絡在白天,夜晚及全天的檢測性能,其中多模態網絡整體獲得了26. 96% 的MR 值,分別比只使用可見光模態和紅外模態的單流網絡減少了12. 91% 和11. 28%,可以發現利用多模態信息的雙流檢測網絡的檢測性能更優。

對比表1 的兩個單模態網絡在白天黑夜的MR 值大小以及圖6~圖7 的missrate-FPPI 曲線(藍色代表紅外分支,紫色代表可見光分支,彩圖見期刊電子版)的高低,可以看出,在白天,單支可見光比單支紅外網絡性能更優;而在夜晚的大部分場景下,單支紅外比單支可見光網絡性能更優,驗證了兩模態的互補性。

表1 不同模態的MR 值Tab. 1 MR values of different modals (%)

圖8 是在kaist 數據集上的檢測實例(彩圖見期刊電子版)。(紅色框代表真實標注框,綠色框代表網絡輸出的檢測框,從左到右分別為(a)原始標注,(b)單支可見光模態,(c)單支紅外模態,(d)雙支多模態以及(e)Fusion-RPN[2]。 關于與Fusion-RPN 算法的比較將在3. 4 節介紹)相鄰的兩行是同一組可見光和紅外圖片,第一組是在夜晚拍攝,第二組和第三組均為白天拍攝。由幾組圖片可以看出,單獨使用某一分支網絡只能在白天或黑夜一種情況下性能更優,并不能適應環境變化,雙支多模態網絡明顯性能更優化穩定,進一步驗證了上文的結論,佐證了多模態自適應融合實驗的可行性。

圖6 兩分支在白天的檢測結果Fig. 6 Detection results of the two branches during the day

圖7 兩分支在夜晚的檢測結果Fig. 7 Detection results of the two branches during the night

3.3.2 多模態融合實驗

兩模態的正確融合可以大幅度提升檢測性能,然而兩模態正確融合的關鍵就是如何融合和何時融合。針對這兩個關鍵問題,本文做了如下兩組實驗。

3.3.2.1 選取融合時機

本文為了更有效地融合多光譜信息,更好地發揮WFN 模塊的優勢。本部分研究了兩種不同時機嵌入WFN 模塊的方案。圖9 表示(a),(b)兩種嵌入WFN 模塊的策略。

融合時機(a):先逐層加權自適應融合,再對融合后的三個特征進行高低層級聯,獲得最終的用于生成特征金字塔的融合特征。

圖8 檢測實例Fig. 8 Detection examples

融合時機(b):先在每一單獨分支對三層特征進行高低層級聯,再對分別來自兩流的高低層級聯特征做加權自適應融合操作,獲得最終的用于生成特征金字塔的融合特征。

本文選擇融合方式(a),是因為逐層融合可以充分利用每一層的特征信息,讓網絡充分學習更多兩模態之間的信息,相較融合方式(b),減少了特征信息丟失的可能性。表2 是兩種方式在Kaist 數據集上的MR 值,本文選擇的融合方式(a)的MR 值比融合方式(b)低了1. 09%,圖10(ours 和fusion b)也展示了兩種方式的missrate-FPPI 曲線圖,顯然,融 合 方 式(a)的性能較優。

3.3.2.2 選取融合方法

本文通過實驗比較了直接堆疊和自適應權值學習兩種融合方法的優劣,實驗結果如表3 和圖10(ours 和stack)所示,顯然,采用自適應權值學習融合方式可以顯著提高網絡性能。

圖9 兩種融合時機Fig. 9 Two fusion stages

表2 不同融合時機的MR 值Tab. 2 MR values of different fusion stages

3.4 算法的整體性能

為驗證算法的先進性,將本文算法與當前先進 算 法ACF+T+THOG[17],Fusion-RPN[2],YOLO-TGB[18],DSSD-HC[6],TS-RPN[4]在Kaist數據集上進行了MR 值的比較,結果如表4 所示。可以看出本文提出的算法MR 值為26. 96% 與當前最優方法Fusion-RPN(29. 73%)相比,降低了2. 77%,與baseline 算法相比分別降低了27. 84%,與最新的三種算法相比分別降低了4. 24%,7. 36%,3. 7%。

表4 不同方法在Kaist 數據集上的MR 值Tab. 4 MR values of different methods on the Kaist dataset

為了進一步驗證本文算法的領先性,如圖10所示,挑選了當前采用直接堆疊策略的最優算法Fusion-RPN,和ACF+T+THOG(baseline)兩種算法繪制missrate-FPPI 曲線圖,由圖10 可以看出,本文提出的算法(ours)曲線是明顯低于另兩種算法的。同時圖8 也對比了本文算法(d)和Fusion-RPN 算法(e)在kaist 數據集上的檢測實例。觀察兩個算法在第一組和第二組圖片上的檢測結果,可以發現本文算法不僅能框出更多使用直接堆疊的Fusion-RPN 算法漏檢的行人目標,而且對已分類出的行人目標的定位也更加準確。因此本文的自適應權值融合方法可以有效提升行人檢測性能,優于其他算法。

4 結 論

本文根據自動駕駛,智能視頻監控等領域對行人檢測能適應全天候及各種場景變化的要求,提出了基于多模態信息融合權值學習的行人檢測網絡,首先分析了當前一些融合方法,融合時機存在的問題,然后介紹了本文算法提出的雙流行人檢測框架以及權值學習融合網絡的各部分組成和工作原理,并通過實驗驗證本文算法的先進性。實驗結果證明:相比目前采用直接堆疊的最優算法以及當前先進算法的漏檢率,本文算法獲得了較低的漏檢率:26. 96%,基本能為行人檢測提供互補的模態信息,滿足行人檢測自適應場景變化的需求。