基于改進YOLO V3算法的軌道扣件缺陷檢測

韋若禹,李舒婷,吳松榮,鄭英杰,劉 東

(1.磁浮技術與磁浮列車教育部重點實驗室,成都 610031; 2.西南交通大學電氣工程學院,成都 611756)

隨著我國鐵路的快速發展,鐵路運輸承擔能力也隨之越來越高,如何有效保障鐵路運營安全已成為鐵路養護工作中的關鍵問題[1-2]。扣件是連接道床和鋼軌的重要軌道組件,鋼軌振動和環境溫差等因素會使扣件損壞或脫落,長此以往會出現鋼軌變形、坍塌等問題,嚴重時會直接導致列車發生脫軌事故[3-4]。而我國鐵路軌道扣件數量眾多,因此迫切需要智能化、自動化的檢測手段來快速且準確地識別扣件缺陷[5-6]。

當前我國主要采用人工巡道的方法檢查軌道扣件中的缺陷,這種方法不僅經常發生漏檢現象,而且極度依賴巡道工的經驗,需要耗費大量的人力和物力,已經不適應如今鐵路軌道的發展[7-8]。隨著深度學習(Deep learning)和神經網絡的興起[9],國內外學者提出了許多基于神經網絡的目標檢測[10-11]和目標跟蹤算法[12],并且已有相關研究將其用于處理鐵路圖像,如通過卷積神經網絡(Conventional neural network)識別有砟軌道區域[13-14]、軌道塞釘[15]等零件狀態等,獲得了良好的檢測效果。

目前應用比較廣泛且基于深度卷積神經網絡的目標檢測算法可以分為兩類:一類是基于候選區域的目標檢測算法,如R-CNN[16](Region-Conventional Neural Network)、Fast R-CNN[17]、Faster R-CNN[18]等,這類算法首先獲取圖像中可能存在目標的子區域,接著將所有的子區域作為輸入,并通過深度卷積神經網絡提取目標特征,最后進行類別檢測和邊框修正;另一類是基于端對端學習的目標檢測算法,如SSD(Single Shot Multibox Detector)[19]、YOLO(You Only Look Once)[20]、YOLO V3[21]等,此類算法不需要提取候選區域,只要給定輸入圖像,就可以直接利用該算法檢測出圖像中的目標類別和目標邊框,大大加快了檢測速度。

本文將采集到的現場環境下的圖像樣本制作成軌道扣件缺陷檢測數據集,以YOLO V3模型為基礎,將軌道扣件的各類缺陷作為訓練和檢測的目標。但由于檢測目標尺寸普遍較小,目標包含的特征信息量較少,在使用YOLO V3算法檢測時,誤識別率較高,因此本文對YOLO V3目標檢測算法提出了兩點改進。先使用K-means算法對扣件數據集的目標候選框尺寸進行聚類分析,采用分析得到的聚類中心進行模型訓練,以提高模型的識別準確率;同時調整網絡結構,根據檢測目標的尺寸選取兩組尺度特征,對扣件缺陷的位置和類別進行預測,以減少運算量,提升檢測速度。

1 YOLO V3算法

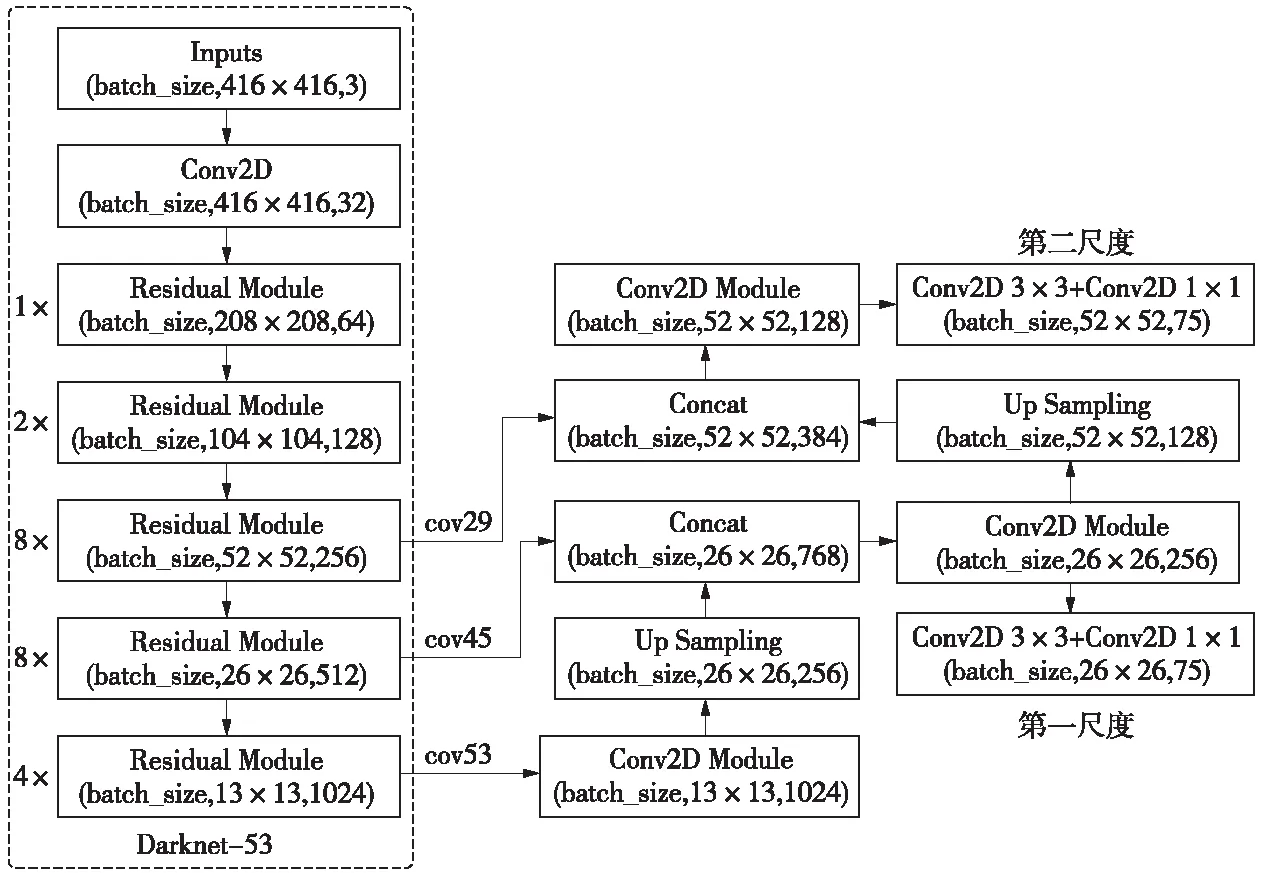

圖1 Darknet-53網絡結構

YOLO[20]系列算法訓練模型時通過卷積神經網絡直接輸入整張圖像,是一種端到端的目標檢測算法,省去了生成候選區域的中間步驟,因此能夠快速將目標和背景區域進行區分,實現實時檢測目標物體的功能。相比于YOLO V2中的骨干網絡Darknet-19,YOLO V3參考了殘差神經網絡結構,通過在網絡中引入殘差單元,降低訓練深層網絡的難度,并且將Darknet-19網絡擴充至53層并稱該骨干網絡為Darknet-53[21]。圖1為Darknet-53的網絡結構,其中方框圈出的部分為殘差組件,最左側一列的1、2、8等數字代表重復殘差組件的數量;網絡的輸入尺寸為416×416,輸出13×13、26×26和52×52三種尺度的特征圖,并送入檢測網絡。

檢測網絡將輸入的圖像劃分成S×S個相同大小的單元格,如果目標的中心落入某一單元格,則該網格負責預測該目標[20],并通過卷積層將特征提取出來,以便于正確識別目標。一個單元格需要預測多個邊界框,每個邊界框包含置信度信息和預測的位置信息(tx,ty,tw,th)。將圖像左上角設置為坐標原點,則單元格相對于整幅圖像的坐標為(cx,cy),且先驗框(anchor box)的寬度和高度分別為pw和ph,那么預測出的邊界框可以表示為

(1)

式中,(bx,by)為預測邊界框的中心坐標;bw、bh分別表示預測邊界框的寬度和高度。通過該公式可得到多個邊界框的信息,YOLO V3網絡采用非極大值抑制算法,去除置信得分較低的邊界框,保留置信得分較高的邊界框為目標的檢測框[22]。

2 改進的YOLO V3模型

本文主要研究軌道扣件中的缺陷檢測問題,原YOLO V3網絡中定義的先驗框和網絡的層級結構并不適用于本文的研究對象。因此,首先使用K-means算法對數據集進行聚類分析,然后針對扣件缺陷檢測,對原網絡的層級結構進行修改。

2.1 數據集目標框的聚類分析

YOLO V3網絡使用anchors boxes對邊界框進行預測,初始anchor boxes是一組尺寸固定的先驗框,對先驗框的選擇會影響網絡對目標物體的檢測準確度和速度。在Faster R-CNN和SSD檢測算法中,anchor boxes的大小是通過人工確定的,這種做法會導致主觀性比較強。YOLO V3網絡為了選出尺寸合適的先驗框,使用K-means聚類算法對數據集的目標框進行聚類分析。

在K-means算法中,設置anchor boxes的目的是使其與臨近的真實框有更大的IOU值,并且IOU的值應該與框的尺寸無關。IOU表示真實標注框與預測框的交并比,用來衡量預測邊界框的準確性,當IOU=1時,說明真實標注框與預測框重合,其計算公式如下

(2)

式中,btrue和bpred分別表示真實標注框和預測框。

K-means算法通常使用歐氏距離、切比雪夫距離、曼哈頓距離等方法作為距離量度,計算兩點間的距離。在YOLO V3網絡中,如果聚類算法仍采用這些常用的距離,會導致不能產生很好的檢測效果。因此可通過自定義的距離公式計算邊框之間的相似度,自定義的距離度量公式如下

d(box,centroid)=1-IOU(box,centroid)

(3)

式中,centroid表示聚類時被選作中心的邊框;box表示樣本中標注的邊框;IOU(box,centroid)表示樣本標注框和聚類中心框的交并比。

本文選取K=1~10,分別對訓練集中的樣本圖像進行K-means聚類分析,得到K值與平均交并比AvgIOU之間的關系如圖2所示。

圖2 K-means聚類分析結果

從圖2可以看出,隨著K值的增大,平均交并比的變化曲線逐漸平緩,曲線的拐點可認為是最佳的anchor boxes的個數。當K>3時,曲線開始變得平緩,所以確定anchor boxes的數量為3,這樣既可以加快損失函數的收斂速度,又可以降低預測框引起的誤差。對應先驗框的大小設置為3個聚類的中心,在本訓練數據集上相對應的分別是(31,69),(39,82),(60,93)。

2.2 改進的目標檢測網絡結構

YOLO V3采用類似FPN的上采樣和融合做法,在3個尺度的融合特征圖上分別獨立做檢測,對目標物體的尺度變化適應性較好。但在軌道扣件缺陷檢測任務中,檢測目標普遍較小,因此需要對YOLO V3的網絡結構進行一些改進,從而適應特定的軌道扣件缺陷檢測任務,同時為了提升運算速率,加快缺陷檢測整體流程,從原網絡結構中提取兩組尺度特征對扣件缺陷的位置和類別進行預測,使其更好地適應檢測軌道扣件缺陷的任務。

圖3為改進后的YOLO V3網絡結構,輸入圖像尺寸為416×416,Darknet-53中conv53層做五次卷積操作后進行上采樣操作,將結果與Darknet-53中的conv45層融合,然后進行五次卷積操作、3×3和1×1等卷積后得到第一尺度26×26的特征圖。以類似的方法對Darknet-53中的conv29層進行特征融合,可以得到第二尺度52×52的特征圖。

圖3 改進后的YOLO V3網絡結構

通過改進后的網絡結構可以使YOLO V3網絡結構更好地適應軌道扣件檢測場景中檢測目標普遍較小的情況,進而提高模型檢測的準確率。由于采用了與現實場景相匹配的尺度數目,改進后的YOLO V3模型還可以有效減少不必要的計算量,提升檢測速度。

3 實驗結果與對比分析

3.1 實驗運行環境

表1為本文的實驗硬件環境配置,同時在服務器上搭建軟件環境,包括Windows 10.0、CUDA8.0、OpenCV3.4.0等常用環境,深度學習算法使用Darknet-53框架。

表1 實驗硬件環境配置

3.2 網絡訓練

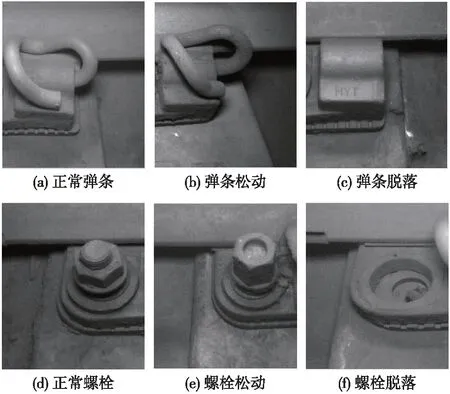

實驗的圖像數據來源為安裝于某地鐵列車上的軌道智能巡檢系統,該系統通過高速工業相機拍攝軌道,并得到DTVI2型扣件圖像。該類型扣件包含彈條和螺栓兩個主要零件,其中零件的脫落和松動是最容易出現的問題。因此本文自制了軌道扣件缺陷六分類數據集,類別名稱分別為正常彈條(sh)、彈條松動(sh_loose)、彈條脫落(sh_off)、正常螺栓(nut)、螺栓松動(nut_loose)、螺栓脫落(nut_off),各類典型樣本如圖4所示。

圖4 典型扣件缺陷圖像

對圖像數據進行整理后,因為缺陷樣本稀缺,所以對100余張缺陷扣件圖像進行旋轉、鏡像等數據增強處理后擴展到600張,其中各類缺陷均占1/4。將200張正常扣件樣本與500張缺陷樣本組合作為訓練數據集,再選取剩余100張缺陷樣本與100張正常扣件樣本組合作為測試數據集。采用Yolo_mark工具對數據集的圖像進行標注并以Yolo數據的格式進行存儲。

使用YOLO V3網絡和改進后的YOLO V3網絡分別進行訓練,訓練的批量大小為64,衰減系數為0.000 5,采用動量為0.9的異步隨機梯度下降,在訓練的初始階段選擇0.001的學習率,并利用旋轉、調整飽和度、調整曝光量等方法增強和擴充數據集中的圖像樣本。

在訓練過程中,通過繪制Loss曲線可以直觀地觀察訓練模型的迭代過程,圖5為改進前后的YOLO V3網絡在訓練過程中對應的Loss曲線。圖5(a)為原YOLO V3網絡對應的Loss曲線,圖5(b)為改進后YOLO V3網絡對應的Loss曲線,如圖所示,當迭代次數達到20000次后,各參數趨于穩定,改進前后網絡的Loss值分別降至0.27和0.15左右。從Loss函數的收斂情況分析可知,改進后YOLO V3網絡的訓練效果比較理想。

圖5 改進前后的YOLO V3損失函數曲線

3.3 改進前后檢測算法的性能對比

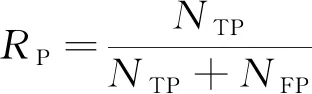

為了準確且有效地對檢測算法的性能進行評價,本文選擇準確率RP和召回率RR作為評價指標,其計算公式分別為

(4)

(5)

式中,NTP為正確識別的目標數量;NFP為被錯誤識別的目標數量;NFN為沒有被識別出來的目標數量。

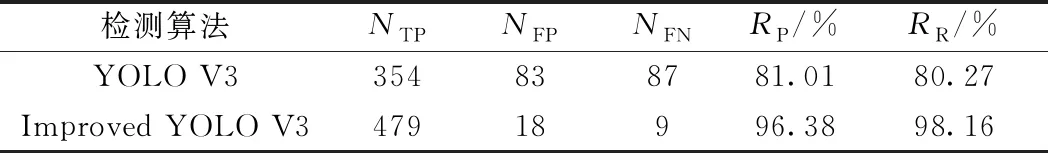

用來測試的200張圖像中共有489個目標,分別使用原YOLO V3算法和改進后的YOLO V3算法對測試數據集進行目標檢測,分別計算它們的準確率RP和召回率RR,結果如表2所示。

從表2可以看出,與原YOLO V3算法相比,改進后的YOLO V3對扣件缺陷的漏檢和誤檢數量均有明顯下降,檢測準確率達到96.38%,提高了15.37%,召回率達到98.16%,提升了17.89%,說明改進后的YOLO V3算法具有更高的可靠性。

表2 改進前后算法的目標檢測結果對比

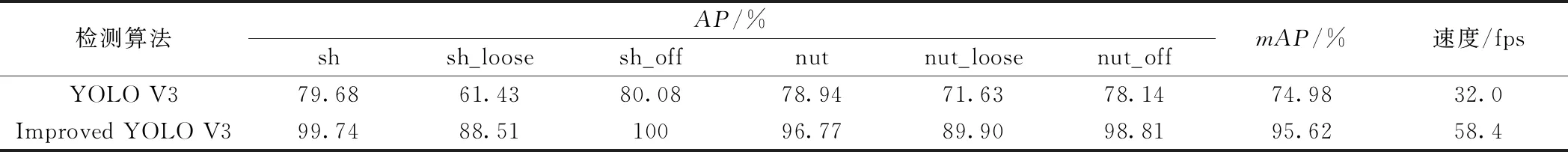

在測試數據集上,分別利用YOLO V3改進前后算法計算六類目標的平均準確率(Average Precision,AP),平均準確率對準確率和召回率綜合考慮,可用來衡量檢測算法的可靠性,并且可以用來分析每個類別的檢測結果,是評價檢測模型準確性的直觀評價標準。同時計算六類目標檢測的平均準確率均值(mean Average Precision,mAP),mAP值反映了檢測模型識別所有類別的綜合性能。測試結果如表3所示,可以看出,改進后的YOLO V3算法的平均準確率均值mAP提升了20.64%,達到95.62%,檢測速度在原YOLO V3的基礎上提升了82.5%,達到58.4fps,說明改進后的YOLO V3算法具有更好的檢測性能。

表3 YOLO V3改進前后算法的檢測結果對比

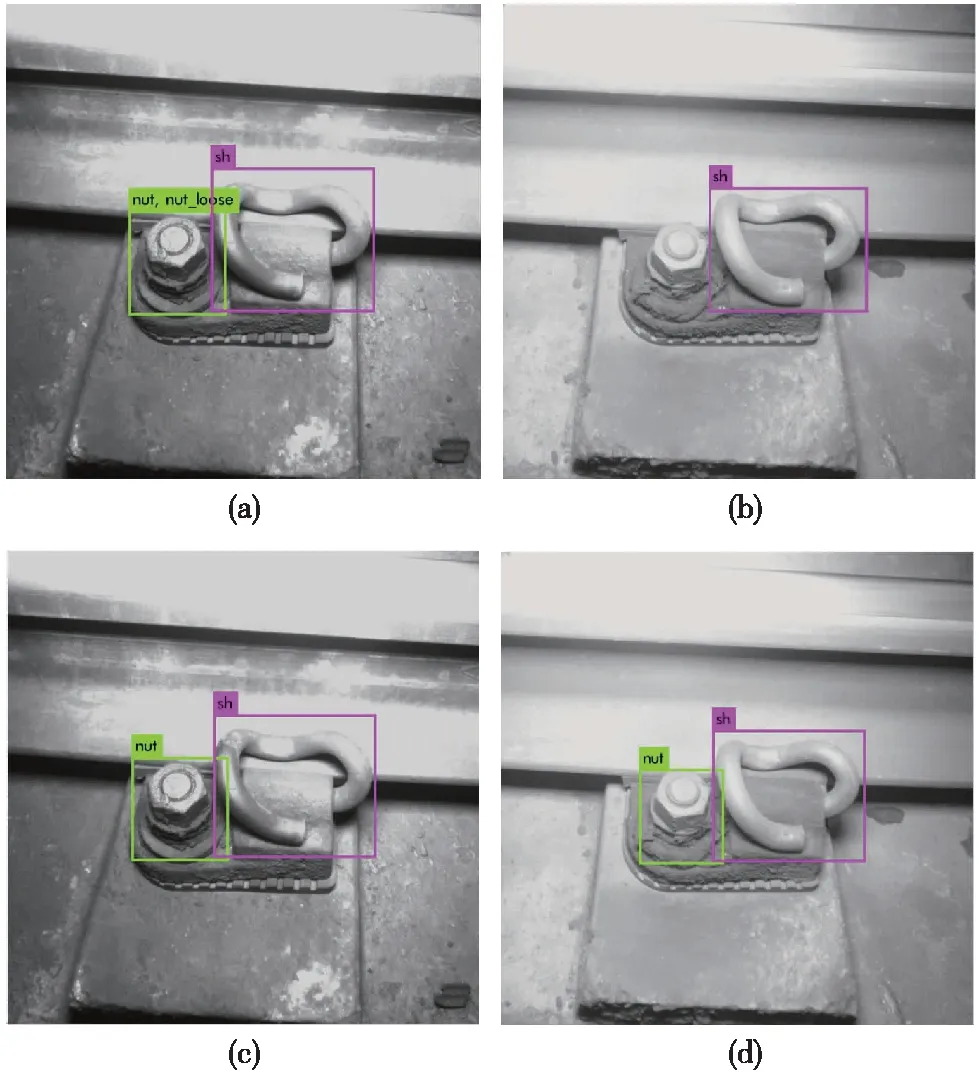

圖6 YOLO V3改進前后算法的檢測結果對比

圖6為YOLO V3改進前后算法的檢測結果,圖6(a)、圖6(b)是原YOLO V3目標檢測算法對扣件缺陷的檢測結果,圖6(c)、圖6(d)是改進后的YOLO V3目標檢測算法對扣件缺陷的檢測結果。對比圖6(a)、圖6(c),可以發現原YOLO V3對扣件缺陷的檢測存在誤檢的情況,把正常的但有污漬的螺栓誤認為是松動的螺栓,而改進后的YOLO V3則可以透過污漬正確識別出正常螺栓。對比圖6(b)、圖6(d),可以發現原YOLO V3存在漏檢的問題,而改進后的YOLO V3網絡則可以檢測出原網絡漏檢的螺栓。

3.4 不同檢測算法的性能對比

為了更全面地評測改進YOLO V3算法的目標檢測性能,使用文獻[18]中的Faster R-CNN檢測算法和文獻[19]中的SSD檢測算法進行對比實驗,并以mAP和檢測速度作為評價算法檢測性能的兩個指標,實驗結果如表4所示。

表4 不同算法的檢測結果對比表

從表4可以看出,在Fater R-CNN、SSD和YOLO V3算法中,平均準確率均值mAP最高的為Faster R-CNN算法,檢測速度最快的為YOLO V3算法。本文方法與FasterR-CNN相比,mAP提高了15.01%,主要原因是本文方法采用了Anchor機制和改進的網絡結構,提高了網絡對目標的檢測準確率;本文方法與原YOLO V3算法相比,檢測速度大幅提高,主要是因為本文方法精簡了網絡結構,減少了不必要的計算量,從而提升了檢測速度。由此可見,改進后的YOLO V3算法同時保證了檢測的準確性和檢測速度,能夠較好地完成軌道扣件缺陷檢測任務。

4 結語

提出一種基于卷積神經網絡的YOLO V3改進方法,并將其應用于軌道扣件缺陷檢測領域。通過采用目標框維度聚類和調整網絡結構等方法改進YOLO V3算法,并使用DTVI2型扣件圖像作為數據集進行扣件缺陷檢測實驗。實驗結果表明,相比于原YOLO V3網絡,改進后YOLO V3算法的檢測準確率和召回率均有明顯提高,具有更好的檢測效果。但在實時性方面,改進后的YOLO V3算法與實際工程應用仍存在著差距,如何在不影響檢測性能的條件下提升檢測速度將是未來的主要研究方向。