融合評(píng)分矩陣和評(píng)論文本的Deep-FRR評(píng)分預(yù)測(cè)模型

侯 越,謝 斌,陳佳興

(蘭州交通大學(xué) 電子與信息工程學(xué)院,蘭州 730070)

推薦系統(tǒng)已經(jīng)廣泛的應(yīng)用于電子商務(wù)、視聽娛樂、社交網(wǎng)絡(luò)和新聞門戶中,并且取得了極大的成功[1].協(xié)同過濾算法是推薦系統(tǒng)常用的技術(shù)手段,該算法通過用戶-項(xiàng)目評(píng)分矩陣計(jì)算用戶、項(xiàng)目間的相似度為用戶進(jìn)行推薦.隨著互聯(lián)網(wǎng)技術(shù)的飛速發(fā)展,推薦系統(tǒng)的用戶和項(xiàng)目數(shù)量呈現(xiàn)指數(shù)級(jí)增長(zhǎng),用戶打分項(xiàng)目不足項(xiàng)目總數(shù)的1%,致使評(píng)分矩陣極其稀疏,相似度計(jì)算趨于困難,使得推薦系統(tǒng)質(zhì)量急劇下降.為緩解評(píng)分矩陣的稀疏性問題,研究人員提出了許多基于評(píng)分預(yù)測(cè)的推薦模型來填充評(píng)分矩陣.文獻(xiàn)[2]提出一種基于矩陣分解(matrix factorization,簡(jiǎn)寫為MF)的協(xié)同過濾方法,將每個(gè)用戶和項(xiàng)目分別映射成兩個(gè)隱含因子向量,以兩向量的內(nèi)積作為用戶對(duì)項(xiàng)目的預(yù)測(cè)評(píng)分.為提升模型的性能,基于矩陣分解的改進(jìn)模型相繼出現(xiàn).文獻(xiàn)[3]提出一種基于概率論圖模型(probabilistic matrix factorization,簡(jiǎn)寫為PMF)的矩陣分解改進(jìn)方法,該模型假設(shè)用戶對(duì)項(xiàng)目的評(píng)分滿足正態(tài)分布,通過最大似然估計(jì)來優(yōu)化用戶、項(xiàng)目的隱含因子矩陣,取得了較好的效果.

近年來,隨著深度學(xué)習(xí)在自然語言處理、計(jì)算機(jī)視覺等領(lǐng)域的長(zhǎng)足進(jìn)步,許多學(xué)者開始將深度神經(jīng)網(wǎng)絡(luò)應(yīng)用于推薦系統(tǒng).文獻(xiàn)[4-5]提出一種深度矩陣分解(deep matrix factorization,簡(jiǎn)寫為DMF)模型,該模型將用戶和項(xiàng)目的隱含因子向量輸入神經(jīng)網(wǎng)絡(luò)得到預(yù)測(cè)評(píng)分.與傳統(tǒng)矩陣分解模型相比,深度矩陣分解模型可以更好地學(xué)習(xí)到用戶和項(xiàng)目間的非線性關(guān)系.文獻(xiàn)[6-8]提出一種利用受限玻爾茲曼機(jī)(restricted boltzmann machine,簡(jiǎn)寫為RBM)的方法解決評(píng)分矩陣的稀疏性問題,文獻(xiàn)[9-10]采用自編碼機(jī)(auto-encoders,簡(jiǎn)寫為AES)的方法,通過用戶-項(xiàng)目評(píng)分矩陣建模進(jìn)行評(píng)分預(yù)測(cè).

除了用戶對(duì)項(xiàng)目的評(píng)分外,評(píng)論文本也包含了用戶對(duì)項(xiàng)目的喜愛程度及項(xiàng)目自身的屬性特征,因此,一些基于評(píng)論文本特征提取的評(píng)分預(yù)測(cè)模型被相繼提出.文獻(xiàn)[11]提出利用潛狄利克雷模型(latent dirichlet allocation,簡(jiǎn)寫為L(zhǎng)DA)提取評(píng)論數(shù)據(jù)集中用戶和項(xiàng)目的隱含語義特征來進(jìn)行評(píng)分預(yù)測(cè)的思路,文獻(xiàn)[12]使用卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,簡(jiǎn)寫為CNN)提取項(xiàng)目描述的文本特征,并結(jié)合PMF模型進(jìn)行評(píng)分預(yù)測(cè),但該方法僅考慮了項(xiàng)目的評(píng)論文本,卻忽略了用戶的評(píng)論文本.文獻(xiàn)[13]提出一種Deep-CoNN(deep cooperative neural network)模型,該模型通過兩個(gè)并行的CNN網(wǎng)絡(luò)分別提取用戶評(píng)論文本和項(xiàng)目評(píng)論文本的特征,并將這兩個(gè)特征表示成低維向量,通過隱因子分解機(jī)來進(jìn)行評(píng)分預(yù)測(cè).

但既有的基于評(píng)論文本特征提取的評(píng)分預(yù)測(cè)模型僅考慮了評(píng)論文本本身,卻沒有充分挖掘評(píng)分矩陣中用戶、項(xiàng)目隱含因子間的交互關(guān)系.基于此,提出一種融合了用戶-項(xiàng)目評(píng)分矩陣和評(píng)論文本的深度學(xué)習(xí)評(píng)分預(yù)測(cè)模型(deep fusion of rating matrix and review text,Deep-FRR),其中,矩陣分解模塊和深度矩陣分解模塊用于提取用戶和項(xiàng)目間的線性和非線性交互關(guān)系,卷積神經(jīng)網(wǎng)絡(luò)模塊用于提取用戶和項(xiàng)目評(píng)論文本中的潛在語義特征,然后在融合層實(shí)現(xiàn)三模塊的融合,并通過全連接層進(jìn)行評(píng)分預(yù)測(cè).最后,采用五個(gè)亞馬遜的公開數(shù)據(jù)集對(duì)本文的Deep-FRR模型和其它評(píng)分預(yù)測(cè)模型進(jìn)行對(duì)比實(shí)驗(yàn),并詳細(xì)分析Deep-FRR模型的隱含因子數(shù)、詞向量初始化方式對(duì)預(yù)測(cè)性能的影響.

1 Deep-FRR模型結(jié)構(gòu)設(shè)計(jì)

將不同的深度學(xué)習(xí)模型進(jìn)行融合可使融合模型擁有子模型各自的優(yōu)點(diǎn),從而提高模型性能.鑒于此,本文融合傳統(tǒng)矩陣分解模塊、深度矩陣分解模塊、卷積神經(jīng)網(wǎng)絡(luò)模塊,提出一種融合用戶-項(xiàng)目評(píng)分矩陣和評(píng)論文本的評(píng)分預(yù)測(cè)模型Deep-FRR,其模型結(jié)構(gòu)如圖1所示,該模型采用矩陣分解模塊和深度矩陣分解模塊對(duì)用戶和項(xiàng)目間的線性和非線性關(guān)系進(jìn)行建模,同時(shí)使用卷積神經(jīng)網(wǎng)絡(luò)模塊提取了用戶評(píng)論文本和項(xiàng)目評(píng)論文本的語義特征,然后將評(píng)論特征向量、線性和非線性特征向量進(jìn)行融合,最后通過全連接層進(jìn)行評(píng)分預(yù)測(cè).

1.1 矩陣分解模塊

給定一個(gè)用戶-項(xiàng)目評(píng)分矩陣R,矩陣分解的目標(biāo)是將R近似分解成兩個(gè)隱含因子矩陣PN×K和QM×K的乘積,即R≈PTQ,其中:N表示用戶數(shù)量;M表示項(xiàng)目數(shù)量;K代表隱含因子數(shù)目.假設(shè)有3個(gè)用戶和4個(gè)項(xiàng)目,且隱含因子向量的維度為3,則矩陣分解過程可用圖2表示.

通過矩陣分解,每個(gè)用戶u和項(xiàng)目i可以分別用一個(gè)K維的隱含因子向量pu和qi表示,則用戶u對(duì)項(xiàng)目i的預(yù)測(cè)評(píng)分被表示為對(duì)應(yīng)隱含因子向量的內(nèi)積,即

(1)

然后通過隨機(jī)梯度下降法最小化式(2)的損失函數(shù)來分別求解隱含因子矩陣.

(2)

其中:rui表示用戶u和項(xiàng)目i的真實(shí)評(píng)分;λ1和λ2分別表示用戶隱含因子向量pu和項(xiàng)目隱含因子向量qi的正則化系數(shù);Iui是指示函數(shù),如果用戶u對(duì)項(xiàng)目i有評(píng)分,則Iui=1,否則Iui=0.

(3)

式中:⊙符號(hào)表示將兩個(gè)向量求內(nèi)積.

1.2 深度矩陣分解模塊

(4)

式(4)中,令z0=f(pu,qi)=pu⊕qi,表示將兩個(gè)K維向量拼接成一個(gè)2K維向量,然后將z0輸入h層神經(jīng)網(wǎng)絡(luò)σ1,σ2,…,σh,wh代表第h層神經(jīng)網(wǎng)絡(luò)的權(quán)重,bh代表第h層的偏置,ah代表第h層的激活函數(shù),這里使用ReLu激活函數(shù),具體過程如下:

(5)

1.3 卷積神經(jīng)網(wǎng)絡(luò)模塊

Deep-FRR模型利用圖3所示的兩個(gè)并行的卷積神經(jīng)網(wǎng)絡(luò)分別從用戶評(píng)論文本和項(xiàng)目評(píng)論文本中提取了用戶u和項(xiàng)目i的評(píng)論文本特征[15],由于兩個(gè)卷積神經(jīng)網(wǎng)絡(luò)對(duì)評(píng)論文本的處理方法相同,下面僅對(duì)提取用戶u的評(píng)論文本特征的過程進(jìn)行說明.

對(duì)每個(gè)用戶u,把他所有的j條評(píng)論組成一個(gè)評(píng)論集合Du={du1,du2,…,duj},然后對(duì)Du進(jìn)行去停用詞、分詞處理,再通過word2vec[16]技術(shù)將Du映射成n×k的詞向量矩陣Cn×k,并將此詞向量矩陣Cn×k作為卷積神經(jīng)網(wǎng)絡(luò)輸入層的輸入,其中:n表示評(píng)論集Du中的單詞數(shù);k表示詞向量的維度.

然后,卷積層通過大小為h×k的濾波器以步長(zhǎng)1自上而下滑動(dòng)來提取詞向量矩陣Cn×k的局部特征,如式(6)所示.

ci=f(ω·xi∶i+h-1+b),

(6)

其中:f是ReLU函數(shù);ω代表卷積核;xi∶x+h-1代表Cn×k中從i到i+h-1共h行詞向量;b是偏置項(xiàng).通過卷積層,最終得到詞向量矩陣Cn×k的局部特征矩陣C=[c1,c2,…,cn-h+1].

對(duì)卷積層之后得到的局部特征矩陣采用最大池化的方法,用最大特征代替局部特征,得到局部特征的最優(yōu)解oi:

oi=max{c1,c2,…,cn-h+1}.

(7)

之后,將所有局部特征的最優(yōu)解拼接起來得到用戶u的評(píng)論文本局部特征表達(dá)Ou=[o1,o2,…,on].

將Ou輸入全連接層,得到用戶u的評(píng)論文本特征向量du:

du=wu·Ou+bu,

(8)

其中:wu表示全連接層的權(quán)重;bu代表全連接層的偏置項(xiàng).

(9)

1.4 融合層

(10)

(11)

其中,w和b分別表示全連接層的權(quán)重與偏置.

2 實(shí)驗(yàn)設(shè)計(jì)

2.1 實(shí)驗(yàn)數(shù)據(jù)與實(shí)驗(yàn)平臺(tái)

在亞馬遜的5個(gè)商品評(píng)論數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),數(shù)據(jù)集的基本情況如表1所列.由表1可知,5個(gè)所選數(shù)據(jù)集全部為高稀疏程度數(shù)據(jù)集,符合模型所需實(shí)驗(yàn)要求.實(shí)驗(yàn)所用平臺(tái)為Windows10 64位系統(tǒng),Intel-i5 CPU,16GByte內(nèi)存,開發(fā)環(huán)境為python3.6,并使用了Keras 2.2.4深度學(xué)習(xí)框架.

表1 亞馬遜商品評(píng)論數(shù)據(jù)集Tab.1 Amazon product review dataset

2.2 實(shí)驗(yàn)參數(shù)設(shè)置

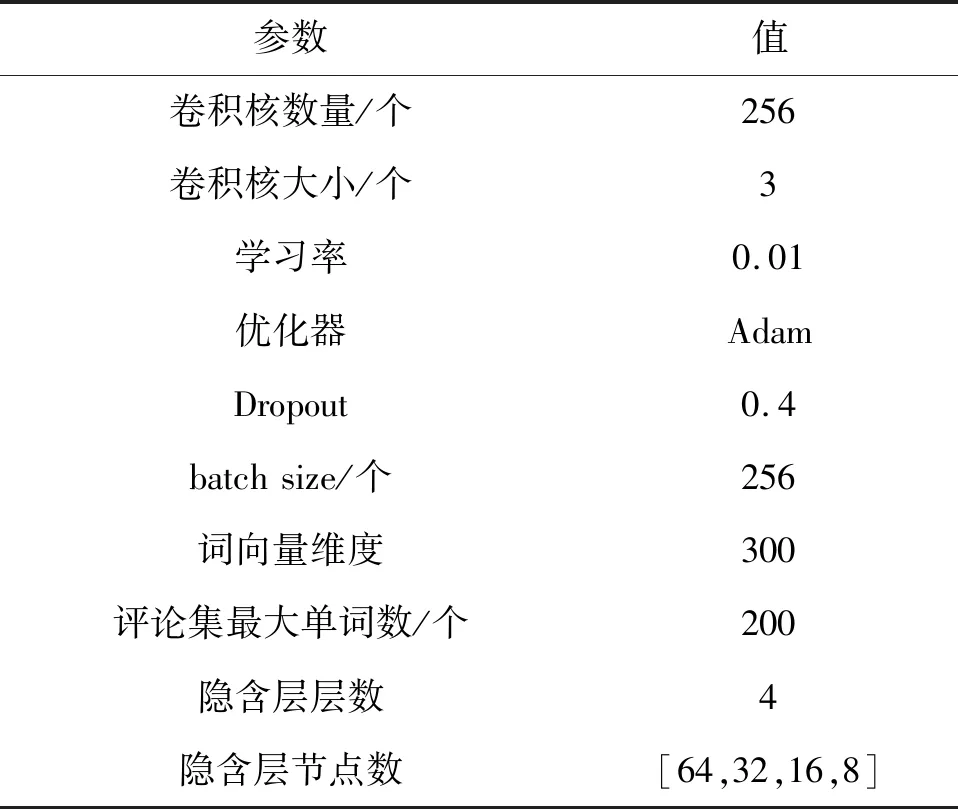

模型參數(shù)選取的好壞直接影響評(píng)分預(yù)測(cè)精度,經(jīng)多次實(shí)驗(yàn)驗(yàn)證,表2中各類模型參數(shù)設(shè)置能顯著提升模型預(yù)測(cè)性能.

表2 模型參數(shù)設(shè)置Tab.2 Parameter setting

2.3 評(píng)價(jià)指標(biāo)

實(shí)驗(yàn)采用均方誤差(mean-square error,簡(jiǎn)寫為MSE)作為評(píng)價(jià)指標(biāo),MSE越小代表模型的性能越好,MSE的計(jì)算公式如下:

(12)

其中:T代表測(cè)試集樣本數(shù).

2.4 對(duì)比實(shí)驗(yàn)?zāi)P?/h3>

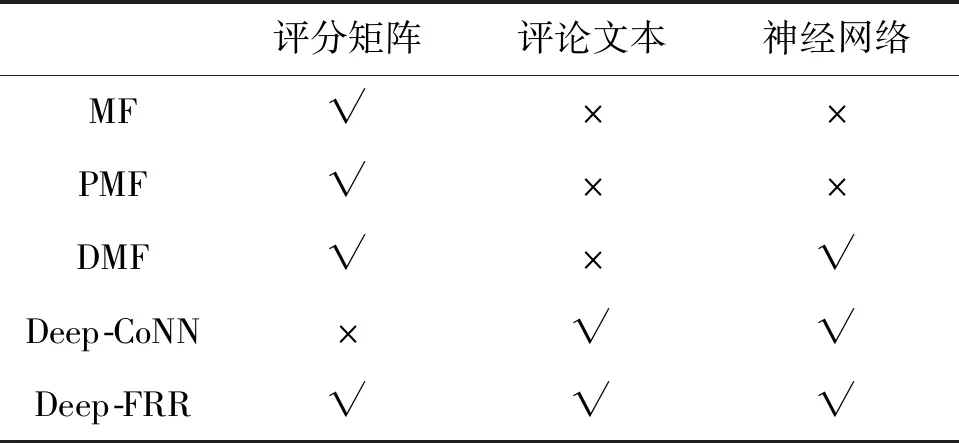

將提出的Deep-FRR模型與下列評(píng)分預(yù)測(cè)模型進(jìn)行對(duì)比實(shí)驗(yàn):

1) MF:矩陣分解模型.

2) PMF:概率矩陣法分解模型.

3) DMF:深度矩陣分解模型.

4) Deep-CoNN:采用了兩個(gè)CNN網(wǎng)絡(luò)分別提取用戶評(píng)論文本和項(xiàng)目評(píng)論文本的特征來預(yù)測(cè)評(píng)分的模型.

表3為不同模型間的對(duì)比,√表示模型使用了該項(xiàng),×表示模型未使用該項(xiàng).由表3可知,MF模型和PMF模型僅使用了評(píng)分矩陣,而DMF在使用了評(píng)分矩陣的基礎(chǔ)上,采用了神經(jīng)網(wǎng)絡(luò)進(jìn)行建模,Deep-CoNN模型僅使用了評(píng)論文本,而模型Deep-FRR同時(shí)使用了評(píng)分矩陣和評(píng)論文本作為神經(jīng)網(wǎng)絡(luò)模型的輸入.

表3 不同模型對(duì)比Tab.3 Comparison of different models

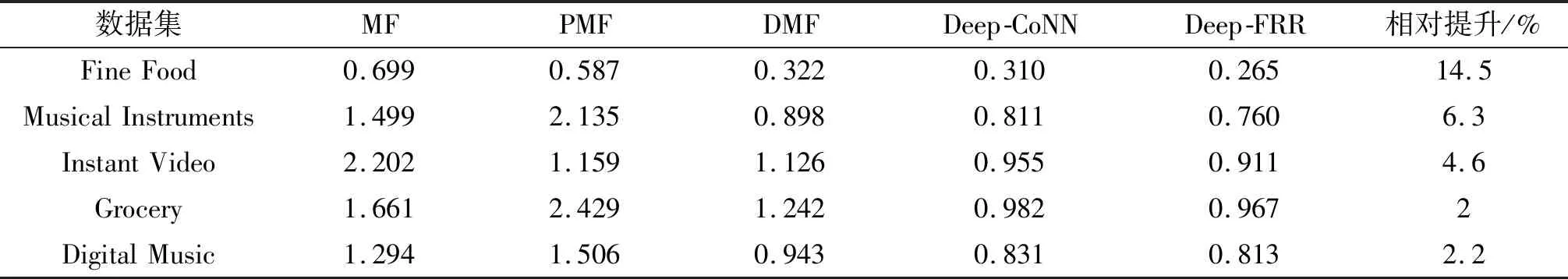

3 模型精度分析

實(shí)驗(yàn)選擇80%的數(shù)據(jù)集樣本作為訓(xùn)練集,用剩余20%的數(shù)據(jù)集樣本作為測(cè)試集,通過表4中的參數(shù)分析,將隱含因子數(shù)K設(shè)為75,詞向量初始化方式設(shè)為GloVe-Trained,上述模型在測(cè)試集上的MSE對(duì)比結(jié)果如表5所列.從相對(duì)提升百分比來看,同一數(shù)據(jù)集上Deep-FRR模型的MSE較其他最優(yōu)預(yù)測(cè)模型提升明顯.

表4 不同參數(shù)實(shí)驗(yàn)結(jié)果Tab.4 Experimental results under different parameters

從與其它模型的比較來看:基于神經(jīng)網(wǎng)絡(luò)的預(yù)測(cè)模型如DMF、Deep-CoNN的預(yù)測(cè)精度均高于MF模型和PMF模型,說明采用了神經(jīng)網(wǎng)絡(luò)的預(yù)測(cè)模型擁有更強(qiáng)的非線性擬合能力;基于用戶和項(xiàng)目評(píng)論文本特征提取的Deep-CoNN模型在測(cè)試集上的表現(xiàn)優(yōu)于僅使用項(xiàng)目評(píng)分矩陣的模型MF、PMF和DMF,而本文提出的融合了項(xiàng)目評(píng)分矩陣及項(xiàng)目和用戶評(píng)論文本的Deep-FRR模型在測(cè)試集上的預(yù)測(cè)精度均高于上述模型,且相對(duì)于Deep-CoNN模型的提升最高可達(dá)14%,說明Deep-FRR模型可以同時(shí)學(xué)習(xí)到用戶-項(xiàng)目間的線性和非線性交互關(guān)系以及用戶評(píng)論文本和項(xiàng)目評(píng)論文本中的語義表達(dá).

4 Deep-FRR模型影響因子分析

由模型訓(xùn)練過程可知,隱含因子數(shù)和詞向量初始化方法分別影響著Deep-FRR模型矩陣分解模塊和文本特征提取模塊的性能,為研究這兩個(gè)關(guān)鍵參數(shù)對(duì)Deep-FRR模型性能的綜合影響,選擇不同的隱含因子數(shù)和詞向量初始化方法在5個(gè)數(shù)據(jù)集上進(jìn)行多次實(shí)驗(yàn),其中隱含因子數(shù)從{15,25,50,75,100,150,200}中選擇.詞向量的初始化方法有以下三種:

1) Random:隨機(jī)初始化每個(gè)詞的詞向量,然后通過后續(xù)的訓(xùn)練去動(dòng)態(tài)的調(diào)整.

2) GloVe-Static:使用GloVe預(yù)訓(xùn)練的詞向量,在訓(xùn)練過程中不再調(diào)整該詞向量.

3) GloVe-Trained:使用GloVe預(yù)訓(xùn)練的詞向量,并且在后續(xù)訓(xùn)練模型的過程中不斷自動(dòng)調(diào)整.

4.1 詞向量影響分析

表5是不同參數(shù)條件下,Deep-FRR模型在5個(gè)數(shù)據(jù)集上的預(yù)測(cè)精度對(duì)比.由表5可知,在不同隱含因子數(shù)下,使用預(yù)訓(xùn)練詞向量GloVe-Static和GloVe-Trained的模型,總體性能優(yōu)于使用隨機(jī)初始化詞向量的模型,說明在數(shù)據(jù)集稀疏的情況下,使用預(yù)訓(xùn)練詞向量,可以更好地挖掘評(píng)論文本中隱含語義特征.而使用了GloVe-Trained的模型綜合表現(xiàn)要優(yōu)于使用GloVe-Static的模型,說明在使用預(yù)訓(xùn)練詞向量之后再根據(jù)數(shù)據(jù)集自身的特點(diǎn)進(jìn)行動(dòng)態(tài)的微調(diào),可以使模型獲得更好的性能.

表5 不同模型的實(shí)驗(yàn)結(jié)果Tab.5 Experimental results of different models

4.2 隱含因子數(shù)影響分析

為分析隱含因子數(shù)對(duì)模型性能的影響,根據(jù)上述結(jié)論選擇了GloVe-Trained方式初始化詞向量,并比較不同隱含因子數(shù)下Deep-FRR模型在5個(gè)數(shù)據(jù)集上的預(yù)測(cè)精度差異,其結(jié)果如圖4所示.

由圖4可知,隨著隱含因子數(shù)的增加,除Instant Video數(shù)據(jù)集之外,Deep-FRR模型在其它4個(gè)數(shù)據(jù)集上的MSE整體呈下降趨勢(shì),因?yàn)镮nstant Video數(shù)據(jù)集中用戶數(shù)和物品數(shù)目很少,所以在隱含因子數(shù)較小的情況下能夠?qū)W習(xí)到用戶和物品之間的交互關(guān)系.由于太多的隱含因子數(shù)目會(huì)使模型的參數(shù)數(shù)量增多,在訓(xùn)練時(shí)會(huì)消耗更多的計(jì)算機(jī)資源,因此,經(jīng)過綜合考慮,在實(shí)驗(yàn)中將隱含因子數(shù)設(shè)為75較為合適.

5 結(jié)論

提出了一種融合用戶-項(xiàng)目評(píng)分矩陣和評(píng)分文本的Deep-FRR評(píng)分預(yù)測(cè)模型,該模型可同時(shí)學(xué)習(xí)用戶-項(xiàng)目間的線性、非線性交互關(guān)系及用戶、項(xiàng)目評(píng)論文本中的語義特征表達(dá).實(shí)驗(yàn)結(jié)果表明,本文Deep-FRR模型具有更低的預(yù)測(cè)誤差,選取隱含因子數(shù)75和GloVe-Trained詞向量初始化方法能有效提升預(yù)測(cè)精度.鑒于機(jī)器硬件性能受限等原因,本次實(shí)驗(yàn)在模型文本處理模塊僅選擇了部分評(píng)論文本進(jìn)行了特征提取,而沒有采用全部評(píng)論文本,因此,未來將在機(jī)器性能提升的條件下在更大數(shù)量的文本數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),以進(jìn)一步提升模型的預(yù)測(cè)精度和性能.

蘭州交通大學(xué)學(xué)報(bào)2020年5期

蘭州交通大學(xué)學(xué)報(bào)2020年5期

- 蘭州交通大學(xué)學(xué)報(bào)的其它文章

- 探究性學(xué)習(xí)策略導(dǎo)向下的學(xué)習(xí)者思辨能力培養(yǎng)與提升

- 思政課培育提升大學(xué)生社會(huì)責(zé)任感的對(duì)策研究

- 甘肅省“校園足球”活動(dòng)競(jìng)賽體系發(fā)展困境與對(duì)策

- 新工科背景下行業(yè)地方高校教學(xué)質(zhì)量監(jiān)控與反饋體系的構(gòu)建與實(shí)踐

- 甘肅省國(guó)有企業(yè)混合所有制改革股權(quán)結(jié)構(gòu)與績(jī)效研究

- 一株耐鐵細(xì)菌的篩選與培養(yǎng)及其重金屬耐受性研究