結合注意力機制的深度學習光流網絡*

周海赟,項學智,翟明亮,張榮芳,王 帥

1.南京森林警察學院 治安學院,南京 210023

2.哈爾濱工程大學 信息與通信工程學院,哈爾濱 150001

1 引言

光流場是計算機視覺中的重要底層信息,在自動駕駛、動作識別、視頻處理等領域擁有廣泛應用,因此光流估計一直是視覺分析領域里的一個熱門研究課題。傳統方法[1-3]通常利用亮度恒常假設和運動空間平滑假設等一系列先驗約束構造能量泛函,并通過變分極小化能量泛函來求解光流,此類方法較容易集成人類對運動的先驗知識,因此本文將其稱為知識驅動方法。Horn 和Schunck[1]首次采用變分方法解決光流估計問題,該方法基于亮度恒常和平滑性假設構造能量泛函,此后的方法大多在此基礎上通過添加新的約束項來改善能量泛函。Sun 等[2]設計了一種非局部平滑項,用于抑制運動邊界的平滑。Brox 和Malik[3]將圖像描述符匹配算法引入變分框架,擴展了經典的能量泛函。雖然這類知識驅動的變分方法可以通過預先定義的約束項來估計光流,但是此類方法在計算中需要通過多次迭代獲得精確解,在需要高精度運動場的場合,其運行速度通常無法滿足實際應用中的實時性要求。近年來,隨著深度學習的興起,卷積神經網絡憑借其強大的學習能力,在圖像分類[4]、目標識別[5]、語義分割[6]等多個領域取得了重大突破,其影響力也逐漸滲透到了光流計算領域。Dosovitskiy 等[7]首先將卷積神經網絡引入光流估計領域,設計了兩個U 型網絡模型FlowNetS 和FlowNetC,并發布了一個大型合成數據集Flying-Charis,專門用于光流網絡的訓練。對于FlowNetS 模型,兩幀圖像以堆疊的方式輸入網絡,網絡通過一系列卷積操作和反卷積操作自行學習二者之間的運動信息。對于FlowNetC 模型,兩幀圖像被分開處理,網絡通過兩個分支分別提取兩幀圖像的特征,之后通過相關層計算特征圖之間的相關程度。FlowNetS 和FlowNetC 網絡在FlyingChairs 數據集上以有監督的方式端到端地訓練。兩個深度學習模型可以從大量的數據中自動地學習光流,只是準確性還無法與知識驅動方法相提并論。在FlowNet經典模型被提出之后,更多的深度學習光流方法陸續被提出。Vaquero等[8]將粗到精的推理策略引入網絡,將光流估計問題轉化為回歸和分類問題。文獻[9-13]將知識驅動方法中的經典先驗假設融入網絡,使網絡以無監督的方式學習光流。其中文獻[8-9,12-13]都是基于經典的U 型網絡架構設計的模型,主要特點是架構簡單,易于與其他有效算法結合。除了經典的U 型網絡架構之外,空間金字塔網絡也是光流估計的基本網絡架構之一。Ranjan 和Black[14]將空間金字塔引入深度學習光流方法中,設計了一種空間金字塔網絡模型SpyNet,利用傳統方法中的變形操作,將第二幅圖像向第一幅圖像變形,在每一層計算增量光流以解決大位移問題。與FlowNet 和Flownet2.0 方法相比,SpyNet 的參數量更小,運行速度更快,但準確率略低。基于SpyNet,Hu 等[15]設計了一種用于光流估計的循環空間金字塔網絡。Dai等[16]提出了一種基于空間金字塔的新型網絡架構,通過運動信息來約束視頻中的時間信息。空間金字塔網絡可以獲得多尺度特征信息,而且使用金字塔分層計算可以解決光流估計中大位移問題,然而這種網絡架構忽略了特征通道的相關性,不能學習和修改通道特征的權重。除了U 型網絡和空間金字塔架構之外,級聯結構也被引入到學習光流中。Ilg 等[17]在FlowNet 的基礎上設計了一種堆疊網絡模型FlowNet2.0,將FlowNetS 和FlowNetC 作為子網絡堆疊在一起,并在子網絡之間加入變形操作,以提高光流估計模型的準確率。FlowNet2.0 在FlyingThings3D 數據集[18]上對各個子網絡進行微調,得到的模型具有很高的準確率,但模型的訓練過程較為復雜,且其參數量是FlowNet 的5倍。Unfow[10]是一種無監督網絡,它利用堆疊架構和更加魯棒的Census 損失函數來提高光流網絡的學習能力。級聯架構以迭代細化的方式提高光流估計的準確性,因此訓練過程復雜且耗時。上述幾種深度學習光流估計方法從大量圖像數據中學習運動規律,本文將其稱為數據驅動方法。數據驅動方法雖然在訓練階段較為耗時,但在推理階段速度較快,可有效解決傳統知識驅動型方法實時性差的問題。但現有的數據驅動光流網絡大多來源于計算機視覺中其他像素級任務的網絡架構,在處理運動信息時缺乏靈活性,無法區分不同通道下運動信息的重要程度,導致網絡對運動特征提取的效率不高。同時,基于編解碼架構的網絡采用卷積操作來提取兩幀圖像之間的運動特征,隨著特征圖分辨率的逐漸降低,會丟失大量的細節信息,這也進一步限制了稠密光流估計的準確率。

本文將通道注意力機制和空洞卷積引入U 型深度學習光流網絡,并設計了一個空洞卷積和注意力單元級聯的模塊,以解決上述幾種問題。U 型深度學習光流網絡的各層卷積層提取的是多通道特征圖,且每個通道下的特征圖包含的運動信息并不相同,然而以往的深度學習光流網絡并沒有考慮到不同通道之間的區別,對所有通道下的特征都進行統一處理,這將極大地限制深度學習網絡的學習能力。通道注意力機制可以自適應地調整各通道下的特征權重,在卷積層的各層之間級聯上注意力單元后,網絡可以在訓練過程中不斷地對各通道下特征圖的權重進行調整,以使網絡逐層提取出更具有針對性的特征圖,得到更加有效的運動信息,從而提高模型的學習能力;空洞卷積已經被廣泛應用于各類像素級任務中,與普通卷積相比,空洞卷積可以在增大卷積核感受野的同時保持特征圖的尺寸,以避免大量細節信息隨著特征圖尺寸的減小而丟失,對于光流估計這一類像素級問題,細節丟失將會大幅度降低光流估計的精度,因此本文將空洞卷積引入深度學習光流網絡中,保證光流細節不損失,從而有效地學習更多的空間信息;除此之外,本文還將知識驅動方法中的光流先驗約束融入深度學習網絡中,構建了知識與數據混合驅動的光流網絡,進一步提升了光流估計精度。

2 結合通道注意力機制與空洞卷積的光流學習網絡

本文提出的深度學習光流網絡基于U 型網絡架構,其整體架構如圖1 所示。網絡包含收縮和擴張兩部分,收縮部分首先通過若干層卷積層分別提取兩幀相鄰圖像的低級特征,之后在相關層計算兩幅特征圖的相關性,并通過級聯的通道注意力單元和空洞卷積進一步提取高級運動特征,最后將得到的高級特征作為擴張部分的輸入。擴張部分通過一系列反卷積操作將高級特征圖恢復至原始圖像分辨率,其中每層反卷積層后都級聯注意力單元,并通過特征復用減少細節信息丟失。

Fig.1 Overall architecture of network圖1 網絡的整體架構

2.1 注意力機制

視覺注意力機制是人類視覺所特有的大腦信號處理機制。人類視覺通過快速掃描全局圖像,獲得需要重點關注的目標區域,而后對這一區域投入更多的注意力資源,以獲取更多所關注目標的細節信息,抑制其他無用信息。這是人類利用有限的注意力資源從大量信息中快速篩選出高價值信息的手段,是人類在長期進化中形成的一種生存機制,人類視覺注意力機制極大地提高了視覺信息處理的效率與準確性。深度學習中的注意力機制從本質上講與人類的選擇性視覺注意力機制相似,目標也是從眾多信息中選擇出對當前任務目標更關鍵的信息。當前注意力機制目前已經廣泛應用于圖像分類、目標檢測、行人重識別等多個計算機視覺領域。Wang等[19]提出了一種用于圖像分類的殘差注意力網絡。Zhang 等[20]提出了一種注意力引導的遞歸網絡,用于顯著目標檢測。Zhu 等[21]則設計了一種用于目標檢測的全卷積注意力網絡。Yang 等[22]提出了一個專用于行人重識別任務的端到端注意力網絡。Chen 等[23]提出了一種語義分割的注意力機制,可以對每個像素位置的多尺度特征進行加權。袁嘉杰等[24]提出一種基于注意力卷積模塊的深度神經網絡,以促進網絡的信息流動。孫萍等[25]在目標檢測網絡中引入注意力特征庫,有效地提升模型的檢測精度和檢測速度。以上這些工作表明,注意力機制能夠將網絡的注意力向最具信息性的特征方向調整。然而,利用注意力機制來解決光流估計任務的工作還很少。在光流估計任務中,運動物體的不同位置具有不同的光流特性,例如運動物體的邊界部位更側重于光流的邊緣特征,運動物體的內部則更側重于光流的平滑性,深度學習光流網絡利用卷積操作不斷提取包含不同運動信息的多通道特征圖,本文將通道注意力機制與深度學習光流網絡相結合,在網絡的各層卷積層之間級聯上注意力單元,可以使網絡逐層地調整各通道特征圖的權重,針對運動物體的不同位置學習更具有針對性且更加有用的運動信息,以提升U 型網絡的光流學習能力。

2.2 空洞卷積

空洞卷積的主要思想是在標準卷積核之間加入空洞,使卷積核在保證尺寸不變的情況下增大感受野,最近已被廣泛應用于語義分割、圖像分類以及目標檢測等多個任務領域中。Chen 等[26]較早地將空洞卷積應用于語義分割領域,Yamashita 等[27]提出了由多個空洞卷積網絡跳躍連接的網絡模型,增強了語義分割效果。Yu 等[28]則設計了一個用于圖像分類和語義分割的空洞殘差網絡。石祥濱等[29]利用空間卷積和時間卷積來縮減深度學習光流模型的參數量。與普通卷積相比,空洞卷積可以在提取運動特征的同時保證特征圖分辨率不變。由于U 型網絡包含收縮和擴張兩部分,收縮部分通常利用普通卷積操作不斷地縮小特征圖的尺寸以增大感受野,從而導致特征圖的分辨率不斷降低,損失大量細節信息。本文在引入注意力機制的同時將空洞卷積集成進U 型光流網絡,將U 型網絡中收縮部分的普通卷積替換為空洞卷積后,使網絡在不損失特征圖尺寸的同時提取運動特征,以此保留重要的細節信息,提升網絡的學習能力。

2.3 深度學習光流網絡收縮部分

本文所設計的深度學習光流網絡收縮部分負責提取輸入圖像對中的運動特征,由圖像特征提取、相關層及級聯的注意力機制和空洞卷積模塊組成,其網絡架構如圖2 所示。

圖2 為光流網絡的收縮部分,收縮部分首先通過3 層標準卷積層分別提取兩幀相鄰圖像的特征,每層卷積層之后連接一層ReLU 層,卷積核大小分別為7×7、5×5 和3×3,步長為2,輸出的特征圖個數分別為64、128、256,之后通過一個相關層來進行特征圖匹配,找到特征圖間的對應關系,相關層所表達的相關函數定義如式(1)所示。

其中,x1、x2分別表示第一幀和第二幀的特征圖,N表示相關向量c1(x1)和c2(x2)的長度。相關層輸出的特征圖隨后輸入至級聯的空洞卷積和注意力單元模塊中,其中包含6 層空洞卷積層,即圖2 中的n為6,每層卷積層之后均連接注意力單元。空洞卷積在不增加卷積核尺寸的同時增大感受野,可以避免網絡在下采樣過程中丟失重要的細節特征,從而提升網絡學習光流的能力。注意力單元則利用不同通道之間特征圖的相互依賴關系,進一步優化空洞卷積層輸出的特征圖,注意力單元的細節如圖3 所示。

注意力單元包括壓縮和激勵兩部分,給定尺寸為H×W的特征圖X=x1,x2,…,xc,注意力單元可以自適應地調整不同通道特征圖的權重,其中壓縮部分對輸入特征圖進行全局平均池化操作,輸出特征圖由S=s1,s2,…,sc表示,sc的定義如式(2)所示:

Fig.2 Architecture of contracting part圖2 收縮部分的網絡架構

Fig.3 Attention unit圖3 注意力單元

其中,sc為每個通道信息量。

激勵部分包含兩層卷積層和一層激活層,第一層卷積層連接一層ReLU 層,用來壓縮特征圖的數量,可以用1×1×C/r來表示輸出特征圖的數量,其中C表示輸入特征圖的通道數,本文將壓縮參數r設置為64。第二層卷積層用來恢復通道的數量,通道權重由P=p1,p2,…,pc表示,之后將這些權重輸入激活函數,并將權重值規范化到0 至1 之間。最后將輸入特征圖X=x1,x2,…,xc與權重P=p1,p2,…,pc分別相乘,得到優化后的特征圖R=r1,r2,…,rc,其中rc的定義如式(3)所示。

注意力單元的參數細節如表1 所示。注意力單元并不會改變輸入的分辨率,其中激勵部分可以自適應地學習每個通道的權重。每一層空洞卷積層的輸出特征圖的個數分別設置為512、512、512、512、1 024、1 024,空洞參數分別設置為2、2、4、4、8、8,除最后一層空洞卷積層外,其他每一層之后均連接ReLU 層,由于空洞卷積可以在保證特征圖分辨率的情況下增大感受野,收縮部分最后輸出的特征圖的分辨率只縮減至原始分辨率的1/8,而不是1/64,從而有效地保護了運動細節信息。

Table 1 Architecture of attention unit表1 注意力單元網絡架構

2.4 深度學習光流網絡擴張部分

深度學習光流網絡擴張部分的架構如圖4 所示,收縮部分輸出的特征通過級聯的注意力單元進行整合,該模塊包含3 個反卷積層和1 個標準卷積層,每層反卷積層后均連接注意力單元。擴張部分可以估計出多尺度光流,將特征映射的分辨率擴大到原始分辨率的1/4。每個反卷積層的卷積核尺寸為3×3,輸出的通道數分別為512、256、128、64,每個卷積層后均為ReLU 層。為了使網絡能夠感知多級特征,網絡復用了擴張部分相應尺度下的特征圖。

Fig.4 Architecture of expanding part圖4 擴張部分的網絡架構

2.5 網絡訓練的損失函數

傳統的光流估計算法是通過構建能量函數來約束圖像與光流之間的關系,此類知識驅動方法被稱為變分光流方法。Horn 和Schunck[1]首先提出了一種用于光流估計的變分框架,該框架利用亮度恒常和全局平滑假設來約束光流。之后Brox 將更多的約束項引入能量泛函中,極大地提升了變分光流方法的估計精度[3]。

當前卷積神經網絡已開始逐漸應用于光流估計任務中,此類數據驅動方法可以從大量數據中學習運動信息。給定兩幅輸入圖像以及光流真值,訓練網絡的目的是讓網絡自行學習圖像對之間的運動關系,即光流。在有監督方法中通常采用端點誤差(end point error,EPE)作為損失函數來引導網絡的訓練過程,端點誤差損失函數的定義如式(4)所示。

其中,ux,y、vx,y是點p=(x,y) 處的預測光流;是點p=(x,y)處的光流真值;H和W是圖像的高度和寬度。

為充分利用運動先驗知識,實現優勢互補,本文引入變分光流方法中行之有效的亮度恒常假設、梯度恒常假設、全局平滑約束,并對各項使用基于全變分(total variation,TV)的魯棒懲罰函數,最后將這些約束項與EPE損失進行求和構成新的光流損失函數。

亮度恒常假設的定義如式(5)所示。

其中,I(x,y,t)表示t時刻點p=(x,y)處的像素值,u、v分別是水平和垂直光流。應用在深度學習光流網絡中的亮度恒常損失函數的定義如式(6)所示。

其中,N表示圖像中像素點的總數;Ii(p)表示第i幀圖像在像素點p=(x,y)處的像素值;ψ表示魯棒懲罰函數,這里采用Charbonnier 懲罰函數(x2+0.0012)α;w=(u,v)T表示t時刻與t+1 時刻兩幀圖像之間的光流向量,w(p)為像素點p=(x,y)處的光流向量。

相比于亮度恒常假設,梯度恒常假設對外部光照變化更加魯棒,梯度恒常假設的定義如式(7)所示。

其中,?=(?x,?y)T表示空間梯度。空間梯度損失函數的定義如式(8)所示。

亮度恒常假設和梯度恒常假設并沒有考慮到相鄰像素之間的相互作用,忽略了圖像中的空間信息,常用的光流空間約束項是全局平滑約束,其定義如式(9)所示。

其中,ρs表示Charbonnier懲罰函數。

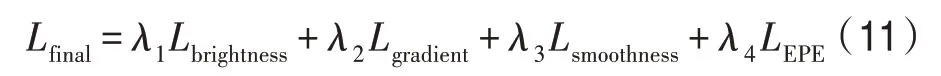

最終的深度學習光流損失函數為以上損失函數的總和,其定義如式(11)所示。

其中,λ1、λ2、λ3、λ4分別表示亮度恒常損失函數、空間梯度損失函數、圖像驅動的平滑項損失函數和端點誤差損失函數的權重,本文采用加權求和的方式計算Lfinal,首先在網絡擴張部分的不同分辨率下分別計算Lfinal,之后將所有分辨率下的Lfinal相加得到最后的損失函數總和。不同分辨率下每一項損失函數的權重如表2 所示,由于亮度恒常損失函數、空間梯度損失函數、圖像驅動的平滑項損失函數和端點誤差損失函數在訓練過程中的重要程度有所不同,各項損失函數所占的權重比例也有所不同,即在網絡訓練中起到的作用越大,權重系數越大。其中端點誤差損失函數的權重參數參考FlowNetS[7]而設置,亮度恒常損失函數及空間梯度損失函數的重要程度隨著分辨率尺度的不斷增加而逐漸加強,因此按照等差數列的規律不斷增加權重,即分辨率越大,所占權重比例越大。由于分辨率尺度并不影響圖像驅動的平滑項,因此不同分辨率尺度下的圖像驅動的平滑項損失函數權重全部相等。

Table 2 Parameter settings表2 參數設置

3 實驗結果與分析

所設計的光流網絡在FlyingChairs 和Flying-Things3D 數據集上進行訓練,在FlyingChairs 數據集上訓練時,批量大小設置為8,在FlyingThings3D 數據集上訓練時批量大小設置為4。在FlyingChairs 數據集上訓練的迭代次數為1.2×106次,初始學習率為0.000 1,在訓練到4×105次之后每經過2×105次迭代,學習率縮減一半。然后,在FlyingThings3D 數據集上進行微調,初始學習率設置為0.000 01,并在迭代3×105之后每迭代105次將其減小一半。此外,分別 在MPI-Sintel、KITTI2012 和KITTI2015 數據集的訓練集和測試集上測試訓練得到的模型,并與近期相關工作進行了全面比較。值得注意的是,訓練網絡的訓練集并不包含這3 類數據集中的訓練集。表3和表4 顯示了在不同基準數據集下測試得到的數值結果,誤差度量使用平均端點誤差(average end point error,AEE),在KITTI2015 數據集上使用的誤差度量為光流估計錯誤像素點所占的百分比。

MPI-Sintel 訓練和測試集分別包含1 041 和552個圖像對,提供了Clean 和Final 兩個版本的數據集,其中Final 版本包含運動模糊、大氣變化、霧效果和噪點,比Clean 版本更加復雜,且更具挑戰性。KITTI 數據集由車載立體攝像系統捕獲的真實道路場景組成,KITTI2012 數據集包含194 個訓練圖像對和195 個測試圖像對;KITTI2015包含200個訓練圖像對和200個測試圖像對。這兩個數據集僅包含稀疏的光流真值。

由表3 和表4 可以看出,本文的模型在MPISintel 的Clean 和Final 的數據集上的測試結果優于SpyNet[14]、CaF-Full-41c[8]、FlowNet2.0-S[17]、FlowNet2.0-C[17]和Dai 等[16]有監督學習方法和DSTFlow[9]、Un-Flow[10]、DenseNetFlow[11]、OccAwareFlow[12]等無監督學習方法。

Table 3 Quantitative evaluation on MPI-Sintel datasets表3 MPI-Sintel數據集上的定量評估

Table 4 Quantitative evaluation on KITTI datasets表4 KITTI數據集上的定量評估

由表3 可以看出,FlowNet2.0-S、FlowNet2.0-C 和SpyNet 的結果與本文模型很接近,但其精度并未超越本文模型,其中SpyNet 在FlyingChairs 數據集上進行訓練,FlowNet2.0-S 和FlowNet2.0-C 在FlyingChairs和FlyingThings 數據集上都進行了訓練。SpyNet 利用空間金字塔網絡來學習光流,與本文方法一樣同屬于輕量級網絡,然而其準確度略低于本文模型。

同時由表4 可以發現,在KITTI2012 數據集上無監督方法UnFlow 與有監督方法相比獲得了更好的結果,經過分析總結出以下三點原因:首先,UnFlow與FlowNet2.0 均通過堆疊多個FlowNet 子網絡來提升網絡性能;其次,UnFlow 的訓練數據集還包含3 個數據集SYNTHIA、Cityscapes 和KITTI raw,這些都是與自動駕駛相關的數據集,與測試集場景較為相似,可認為是進行了有針對性的優化;最后,Unflow 使用相對亮度恒常假設更加魯棒的先驗假設。因此,Unflow 在KITTI 數據集上的性能優于其他方法。此外,Unflow 和OccAwareFlow 均使用了前后向一致性校驗來估計遮擋區域,這在一定程度上也有利于提升光流估計精度。

與無監督方法相比,有監督方法通常難以獲得足夠數量的具有真值的真實圖像序列,因此大多是在合成數據集上進行訓練,例如FlyingChairs 和Flying-Things3D,因此在合成數據集Sintel 上進行測試時,有監督方法FlowNetS、FlowNetC、SpyNet 和Dai 等的準確性更加接近于本文網絡訓練得到的模型。

之后在MPI-Sintel數據集上進一步微調了所得到的模型,并對微調后的模型標記后綴“+ft”,表5顯示了微調后的模型在MPI-Sintel數據集下測試的數值結果。

Table 5 Quantitative evaluation on MPI-Sintel datasets after fine-tuning表5 微調后在MPI-Sintel數據集上的定量評估

由表5 可以看出,在MPI-Sintel 數據集上微調后的本文模型與“RecSpyNet+ft”[15]、“FlowNetS+ft”[7]、“FlowNetC+ft”[7]、“SpyNet+ft”[14]相比具有更好的結果。SpyNet+ft[14]的結果與本文模型很接近,但精度仍略低。

圖5 和圖6 展示了本文模型、FlowNetC[7]和Flow-Net2-C[17]在MPI-Sintel final 數據集上測試的可視化結果對比圖,其中圖6 為將局部細節放大后的對比圖,從中可以看出,本文模型與FlowNetC 和Flow-Net2-C 相比具有更清晰的運動細節,特別是在腿部、手臂等細節部分,而且邊緣處的噪聲也得到了很好的抑制,這說明本文所設計的網絡可以獲得更好的運動邊緣效果,證明了所提出方法的有效性。

Fig.5 Visual comparison on MPI-Sintel dataset(final)圖5 在MPI-Sintel(final)數據集上的可視化比較

Fig.6 Comparison of enlarged local details圖6 局部細節放大后的對比

4 結束語

本文提出了一個全新的深度學習光流網絡,其將通道注意力單元和空洞卷積引入光流網絡中,通道注意力單元可以通過各通道之間的關系自適應地調整各通道的特征,從而提高網絡的運動學習能力。同時,網絡可以學習特征圖的權重,使網絡可以學習更重要的特征。對于像素級估計任務,空洞卷積可以在保持特征圖分辨率不變的情況下有效地擴大感受野,減少空間信息的丟失。在MPI-Sintel 和KITTI數據集上的測試結果證明了所設計網絡的有效性。