基于條件生成對抗網絡的乳腺上皮和間質區域自動分割

張澤林,徐 軍

(江蘇省大數據分析技術重點實驗室(南京信息工程大學),南京 210044)

(*通信作者電子郵箱xujung@gmail.com)

0 引言

上皮和間質區域是病理組織圖像中的兩種基本結構,在乳腺病理圖像中,約有80%的腫瘤起源于上皮組織[1],并且上皮-間質轉化(Epithelial-Mesenchymal Transition,EMT)過程參與了腫瘤的惡性進展[2],因此上皮和間質區域的自動分割對乳腺癌的診斷和預后具有重要的臨床價值。但是,在組織病理圖像中上皮和間質組織的自動分割具有以下的挑戰:1)上皮和間質兩種組織的紋理結構復雜,不同病理圖像之間以及不同的病理分級之間兩種組織的差異性大,因此很難提取到適應性很強的組織區域識別特征;2)上皮和間質組織區域之間沒有明顯的邊界,甚至兩種組織區域交疊在一起,所以模型對兩種區域的區分很困難;3)染色劑和掃描儀等一些外部因素造成的病理圖像之間的差異也對模型識別兩種區域帶來了挑戰。

傳統的分割方法如文獻[3]中使用超像素過分割的方法從病理圖像中提取小圖像塊,然后訓練支持向量機(Support Vector Machine,SVM)[4],最后以圖像塊分類的方式分割口腔鱗癌圖像中上皮和間質組織;文獻[5]中提出了基于貝葉斯表決模型的上皮區域分割方法,該方法使用間質區域細胞的紋理和顏色特征,通過貝葉斯投票的方式去除了間質區域所有的細胞,從而得到了上皮區域的分割結果;文獻[6]使用了基于二值圖割的方法來分割牙源性囊腫圖像中的上皮和間質區域,其中二值圖的權重大小取決于圖像中上皮和間質區域的顏色直方圖概率;文獻[7]中首先用80×80 的滑動窗提取了重疊的圖像小塊,之后提取了圖像小塊的局部二值模式(Local Binary Pattern,LBP)特征,最后用提取的小塊LBP 特征訓練SVM分類器來分割上皮和間質區域。

相較于傳統的分割模型,深度學習分割模型具有更高的分割準確性和魯棒性。深度學習分割模型的分割機制一般分為基于滑動塊分類預測的分割機制和端到端的分割機制。基于滑動塊分類預測的模型在分割大尺寸的病理圖像時將會花費大量的時間。如文獻[8]首先根據專家標記的上皮和間質區域邊界線來重疊地提取兩種區域圖像塊構建訓練集,然后訓練分類卷積神經網絡(Convolutional Neural Network,CNN)Alexnet[9],最后逐塊地預測上皮和間質兩種區域;文獻[10]中提出了一種結合有監督CNN 分類網絡和無監督圖分割模型的方法來分割上皮和間質區域,該方法通過結合分類識別兩種區域和定位兩種區域的邊緣,從而可以更準確地分割兩種區域;文獻[11]分別用CNN和LBP、區域感知以及像素強度三種傳統特征的提取方式分別提取了上皮和間質區域的2 類特征,然后用SVM 分類器對四種方式提取的特征分類來對上皮和間質區域進行分割,實驗結果表明,基于CNN 深度特征的方式可以取得最好的分割性能。

和基于滑動塊分類預測的分割模型相比,端到端的分割模型在分割效率上更高,但是端到端模型的訓練會更加困難。因為一般對于分類器網絡,架構都只有一個編碼器,而端到端的分割網絡則需要多訓練一個解碼器,解碼器的訓練要比編碼器的訓練更加困難。因此基于編碼器的結構,文獻[12]中提出了全卷積網絡(Fully Convolutional Network,FCN)解決了語義分割的問題。FCN 相對于分類器網絡的主要變化是在編碼器的輸出端串聯了由一個反卷積構成的解碼器,這樣就可以實現端到端的分割。基于FCN 的結構,越來越多的端到端模型被提出并成功地運用在醫學圖像的分割任務中。文獻[13]中先將免疫組織化學(ImmunoHistoChemistry,IHC)[14]染色的病理圖像和對應的蘇木素和伊紅(Hematoxylin and Eosin,H&E)染色的病理圖像配準,然后在IHC染色的病理圖像中用顏色反卷積[15]算法分離通道,并訓練一個Unet[16]分割IHC 染色中上皮區域,最后用訓練好的分割模型微調訓練配準的H&E 染色的病理圖像數據集,并在H&E 染色的病理圖像中分割上皮和間質區域;文獻[17]中基于VGG(Visual Geometry Group)網絡[18]、殘差網絡(Residual Network,Resnet)[19]和預訓練的Resnet 三種CNN 的結構設計了三種端到端的分割模型來對乳腺H&E 染色病理圖像中的上皮和間質區域進行分割。

本文構建了一種端到端的上皮間質分割條件對抗網絡(EPithelium and Stroma segmentation conditional Generative Adversarial Network,EPScGAN)對上皮和間質區域進行自動分割,與一般深度學習分割模型相比,EPScGAN 具有更好的分割性能。

1 EPScGAN模型

一般的深度學習模型都會用一個預定義的損失函數來計算模型輸出和標記之間的誤差,從而監督模型的訓練。對于不同的模型和任務都會有不同的損失函數,因此損失函數的選擇會對網絡的性能產生較大的影響。對抗生成網絡(Generative Adversarial Network,GAN)[20]提供了可訓練的損失函數機制。因為GAN 中的生成器可以是一個解碼器網絡,也可以是一個端到端的分割網絡,而判別器的作用是提取生成器生成圖像和標記圖像的特征,然后在特征水平上判斷生成器的生成結果和標記圖像之間的差距。GAN 的優化目標函數如式(1):

其中:x是生成器的輸入;z是生成器的輸出;G代表生成器網絡;D代表判別器網絡。但是生成器的生成輸入都是一系列隨機的噪聲,因此生成結果無法控制。條件對抗生成網絡(conditional GAN,cGAN)[21]通過在生成器和判別器的輸入中添加生成條件,從而使得生成器的輸出變得可控。cGAN的優化目標函數如式(2)所示:

其中:y為添加的約束條件。

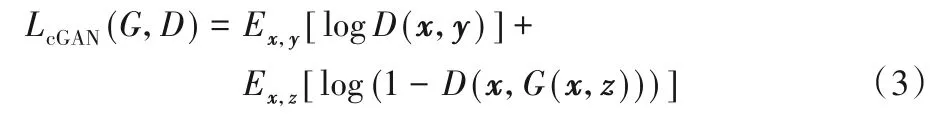

Pix2pix 模型[22]首次應用cGAN 機制完美地解決了圖像翻譯問題。Pix2pix的優化目標函數如式(3):

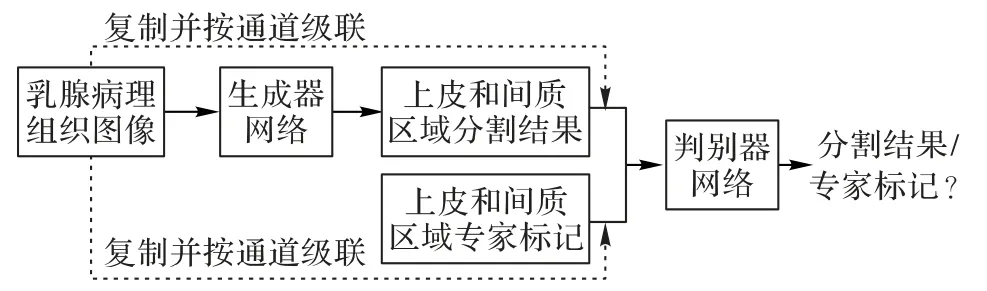

在Pix2pix 中生成器的輸入x由隨機向量變成了圖像,判別器的輸入在原來的生成圖像z或標記圖像y中拼接了原始輸入圖像x作為條件進行判別。本文基于cGAN 和Pix2pix 的模型結構,構建了上皮和間質組織分割模型EPScGAN,模型結構如圖1所示。

圖1 EPScGAN模型結構Fig.1 Structure of EPScGAN model

EPScGAN 包含1 個生成器網絡和1 個判別器網絡,生成器的主要作用是分割輸入的病理圖像并輸出分割結果,而判別器的主要作用是判別生成器生成的圖像和真實的標記圖像之間的誤差。生成器網絡是一個端到端的CNN 分割模型,而判別器網絡是一個多層的CNN分類模型。

1.1 生成器結構

在醫學圖像分割任務中,端到端的分割模型越來越得到了廣泛的應用。主要過程是先用編碼器下采樣提取特征,然后再用解碼器上采樣解碼輸出分割結果。目前在醫學圖像分割中比較流行的幾個端到端分割框架有FCN、Unet 等。FCN根據其上采樣的步長大小又可以分為:FCN32s、FCN16s 和FCN8s。Unet 的網絡結構和FCN 類似,都是在多個尺度下將編碼器提取的深度特征和解碼器特征進行了融合。但不同之處在于FCN 的解碼器只有一個反卷積層,因此是將其他尺度的編碼器特征上采樣后直接和解碼器特征拼接融合,而Unet采用了和編碼器相同尺度的對稱解碼器結構,將編碼器不同尺度下的深度特征和相同尺度的解碼器特征相融合。一系列的實驗結果表明,Unet 的這種短連接對端到端的分割網絡非常有效。因為編碼器的編碼過程會使得一些細節特征被下采樣,導致解碼器沒有足夠的信息來恢復細節的結構。而短連接操作可以將原始圖像的細節信息盡可能地保留下來,從而使得網絡可以更精確地分割一些細小的目標。在一定的情況下,這種結構和Resnet 結構非常相似。和Unet 類似,Segnet[23]也使用了這種短連接操作,與Unet 不同的是Segnet 的解碼器使用了上采樣串聯1×1 的平滑卷積來替代反卷積操作,這樣就使得解碼器的訓練相對更加容易。但是直接采用這種跳躍式的短連接結構存在語義代溝問題。文獻[24]中提出的Unet++結構,主要是解決一般Unet 網絡的深度和語義代溝問題。因為在Unet 中短連接操作直接把編碼器的低維特征拼接到了解碼器的高維特征中,而且編碼器層數越淺,語義代溝越大。所以為了避免語義代溝的問題,本文使用無短連接的編碼解碼結構,生成器的網絡結構如圖2所示。

圖2 EPScGAN生成器框架結構Fig.2 Framework of EPScGAN generator

為了盡可能多地保留細節信息,本文的編碼器只使用了3 個下采樣卷積層,并且為了增加生成器網絡的魯棒性,本文用一系列的Resnet 模塊來增加網絡的參數容量。Resnet 模塊不僅能夠保留輸入圖像或特征的細節信息,而且可以有效地避免加深網絡導致的梯度消失問題。Resnet提供了一種非常有效的深度特征融合方式,最大的特點是將輸入的特征圖和輸出的特征圖相加得到最終的輸出。一個Resnet模塊的輸入x和輸出y之間的關系表達如式(4):

其中:F表示整個Resnet 模塊的運算映射;x和Wx代表輸入和對應輸入的卷積操作;σ表示Resnet 模塊中的激活函數。因此在加入了Resnet 連接的反向傳播中,如果對式(4)求x的偏導數可以得到如式(5)所示的結果:

所以當網絡很深時,dF/dx有可能等于0,此時dy/dx恒等于1,對于整個網絡的前向傳播仍然有效。

為了方便反向傳播求梯度,EPScGAN 生成器中的激活函數均使用線性整流單元(Rectified Linear Unit,ReLU)函數,ReLU函數的計算表達式如式(6):

從式(6)可以看出,ReLU 函數只輸出大于0 的特征,因此在反向求梯度的過程中,該激活函數對輸入x的偏導數恒等于1,所以使用ReLU激活函數可以加快網絡的訓練。

并且為了增加網絡訓練的穩定性,一般深度網絡中的卷積操作后會用一個標準化層對卷積的輸出進行標準化操作。標準化層的主要作用是將網絡的輸出一直保持在一個相同的分布區間,同時可以避免梯度消失,正則化網絡和提高網絡的泛化能力。常用的標準化方式為批量標準化(Batch Normalization,BN)[25],該標準化方式的計算表達式如式(7):

其中:x代表卷積層輸出的特征張量B×C×H×W,B代表特征張量中批量樣本的數量,C代表特征張量的通道數,H×W代表特征張量中的特征圖譜;xi表示特征張量中的每個具體值;μ(x)和σ(x)為輸出特征張量的均值和標準差。批量樣本的數量會對批量標準化的效果產生重要的影響,但是批量樣本的數量會受限于GPU 的顯存大小。所以EPScGAN 中的所有標準化方式都采用了組標準化(Group Normalization,GN)[26]來替代BN。GN和BN的主要區別是GN首先將特征張量的通道分為許多組,然后對每一組做歸一化,即將特征張量矩陣的維度由[B,C,H,W]改變為[B,C/G,H,W],然后歸一化的維度(求均值和方差的維度)為[C/G,H,W],所以GN 的效果不會受到批量樣本數量B的影響。生成器各層的詳細結構如圖3所示。

圖3 EPScGAN生成器模塊結構Fig.3 Module structure of EPScGAN generator

輸入層的作用是用大卷積核的卷積操作將輸入圖像快速轉化為稀疏多通道的特征映射,而輸出層的作用是將特征反稀疏化,從而快速得到分割結果。EPScGAN 生成器的輸出層末尾使用了雙曲正切(hyperbolic Tangent,Tanh)激活函數對卷積輸出進行激活。因為和生成器的深層卷積輸出特征相比,輸出層的卷積輸出特征圖中目標和背景的特征差異已經足夠明顯,并且Tanh激活函數是0均值輸出,可以增大分割結果中背景和目標的差異性,使分割結果更加明顯。

卷積下采樣層的作用為下采樣并融合特征,同時提升輸出通道,增強特征的可表達性。EPScGAN 生成器的編碼器使用了3 個相同結構的卷積下采樣層,每個下采樣層中的卷積都使用了3×3 的小卷積核,2×2 的卷積步長提取特征,并且對卷積運算前的輸入特征進行了大小為1 的零擴充操作,從而保證了每個下采樣層的下采樣倍數都為2。反卷積上采樣層的作用為上采樣并解碼深度特征,同時減少輸出通道,融合解碼后的特征來得到分割結果。類似于EPScGAN 生成器的編碼器,EPScGAN 生成器的解碼器使用了3 個相同結構的反卷積上采樣層,每個上采樣層中的反卷積都使用了3×3 的小卷積,2×2 的卷積步長提取特征,并且對反卷積運算輸入特征和輸出特征都進行了大小為1 的零擴充操作,從而保證了每個上采樣層的上采樣倍數都為2。

Resnet模塊的作用為融合深度特征,增加網絡容量,提升網絡的魯棒性,同時可以避免梯度消失。在EPScGAN 的生成器中用6 個相同結構的Resnet 模塊串聯融合特征,并且連接編碼器和解碼器。每個Resnet 模塊的每個卷積中都使用了3×3 的小卷積核,同時為了保證輸入和輸出特征圖的大小相等,每個卷積步長的步長都為1×1,并且對卷積輸出的特征進行了大小為1的零擴充操作。

1.2 判別器結構

判別器的主要作用是判別生成器的生成圖像和真實的標記圖像。在GAN 中:生成器的優化目標是最小化生成損失,使得判別器很難判別生成圖像和真實圖像的差異,而判別器的優化目標是最小化判別損失,要盡可能地找出生成圖像和真實圖像的差異;在GAN 的訓練過程中,判別器會逐漸地提升判別能力,生成器也會提升生成能力,并且指導生成器訓練的反向傳播誤差損失來源于判別器。因此判別器相當于一個可訓練的損失函數,它可以從深層的數據分布上計算生成器生成的結果和真實數據之間的差異,所以它可以很好地監督生成器的訓練。判別器網絡是一個編碼器結構,因此判別器比生成器更容易訓練。所以為了避免判別器判別能力過強而導致生成器訓練崩潰的問題,同時為了防止判別器過擬合,EPScGAN 的判別器由2 個下采樣層和3 個卷積過渡層構成。EPScGAN的判別器結構如圖4所示。

圖4 EPScGAN判別器結構Fig.4 Structure of EPScGAN discriminator

EPScGAN 判別器的輸入為原始病理圖像級聯生成圖像或真實標記圖像構成的圖像對,原始病理圖像的作用是判別輸入條件。在深度圖像分類網絡中,編碼器的輸出特征會被扁平化為特征向量,然后連接全連接層輸出分類結果,因此分類網絡的輸入圖像尺寸是固定的。但在分割模型訓練的過程中,反向傳播計算會消耗很大的GPU 內存,所以輸入圖像的尺寸一般都比較小,但是在測試過程中可以用更大尺寸的圖像進行測試,所以分割網絡的輸入圖像尺寸大小可以不固定。端到端的分割模型可以適應不同尺度的輸入,但是GAN 中的判別器結構為一個二分類網絡,所以為了能夠分割多尺寸的圖像,同時也為了穩定生成器的訓練,EPScGAN 的判別器采用了Pix2pix中的patch-GAN技術。該技術是去掉了判別器中的特征扁平化操作和全連接層,直接讓判別器輸出一個單通道的特征圖,然后用生成數據的判別特征和真實數據的判別特征進行特征匹配[27],這樣就可以通過判別器輸出特征的傳遞來更好地訓練生成器,增強生成器的生成能力。常用的特征匹配損失函數為正則化損失函數l1 函數和l2 函數[28]。相對于l2損失函數,l1損失函數由于內置特征選擇,所以有很多不確定解,因此魯棒性更高。因此,EPScGAN 的判別器中使用了l1損失函數對兩種判別特征進行特征匹配。

EPScGAN 判別器中使用了2 個相同結構的卷積下采樣層,每個下采樣層中的卷積都使用了4×4 的小卷積核,2×2 的卷積步長提取特征,并且對卷積運算前的輸入特征進行了大小為2 的零擴充操作,從而有效地融合并下采樣特征,同時稀疏化輸出特征,并且避免了過多的下采樣操作造成的細節特征丟失和過擬合問題。同時EPScGAN 判別器還使用了3 個相同結構的卷積過渡層,每個過渡層中的卷積都使用了4×4的小卷積,用1×1的卷積步長提取特征,并且對卷積運算前的輸入特征進行了大小為2 的零擴充操作。因此過渡層不改變特征的尺寸大小,并且可以有效地融合特征,并通過零填充操作有效地稀疏化特征。EPScGAN 判別器的特征輸出層為1個卷積層,該卷積層的卷積核大小為3×3,卷積步長為1×1,卷積輸入零擴充的尺寸大小為1,這樣就保證了不會對輸出特征層進行下采樣,同時輸出的系數特征可以用l2 損失函數更好地進行特征匹配。

EPScGAN 的判別器中所使用的激活函數均為LeakyReLU。當輸入的特征值小于零時,ReLU 函數的輸出始終為零,所以其一階導數也始終為零,這樣就會導致神經元參數不再更新,出現“死神經元”現象。和ReLU 函數不同,當輸入特征張量中的值小于零時,LeakyReLU 會有一個泄露值輸出,因此使用LeakyReLU 函數可以避免判別器中出現“死神經元”現象。LeakyReLU函數的表達式如式(8)所示。

EPScGAN 判別器中所有的LeakyReLU 激活函數泄露值ε均設置為0.2。

1.3 損失函數

EPScGAN 使用了和Pix2pix相同的損失函數。式(3)計算的是cGAN 損失,主要的優化目標是生成器和判別器,為了增強生成器的生成能力以及穩定生成器的訓練,損失函數部分還包括特征匹配l1 損失。l1 特征匹配的損失函數如式(9)所示:

所以EPScGAN 的最終優化目標損失函數的表達式如式(10)所示:

其中:λ為l1 損失的懲罰系數,通過多次實驗發現,最終確定λ=10時訓練最穩定。

2 實驗與結果分析

2.1 實驗數據

本文的實驗數據集是由文獻[29]中荷蘭癌癥研究所(Netherlands Cancer Institute,NKI)和溫哥華綜合醫院(Vancouver General Hospital,VGH)兩個單位提供的總共576張像素尺寸為1 128×720 的H&E 染色乳腺癌病理圖像構成。其中NKI 提供了248 張,VGH 提供了328 張,每張圖像都有病理專家手動標記的乳腺組織上皮和間質區域。本文在原始576 張1 128×720 大小的圖像中隨機裁剪出了1 286 張像素尺寸為512×512的圖像作為最終的實驗數據集。

2.2 實驗結果

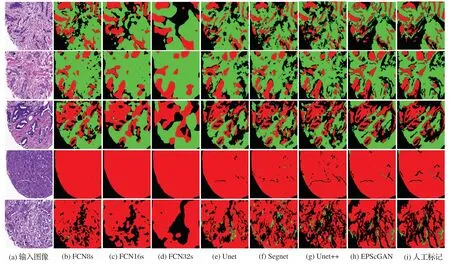

本文將1 286 張512×512 尺寸大小的H&E 染色病理圖像按照7∶3 的比例隨機地劃分為訓練集(900 張)和測試集(386張)對EPScGAN 模型和目前流行的醫學圖像分割網絡進行訓練和測試。本文使用的實驗平臺為Ubuntu 16.04 操作系統,Nvidia GTX 1080Ti 的GPU。網絡固定的超參數為:優化器選用自適應的Adam[30],初始化學習率為0.000 2,訓練的總迭代次數為200,深度學習框架采用Pytorch1.0。不同模型在測試集上的分割結果對比如圖5所示。

圖5 不同模型的分割結果對比Fig.5 Segmentation results comparison of different models

從圖5 所示的分割結果對比圖中可以發現:FCN 的解碼器比較弱而且和編碼器不對稱,所以很難準確地分割出上皮和間質組織區域;而其他4 種模型結構都采用了對稱的編碼解碼結構,因此整體分割的效果比較好。本文對比了4 種對稱結構的分割結果細節,如圖6 所示,從分割結果的細節展示中可以發現:Segnet 和Unet++會把淋巴細胞區域誤分割為間質組織區域(圓圈內所示),Unet、Segnet 和Unet++都容易把一些細小的間質區域漏掉(三角形所指和方框內所示)。

3 結果評估分析

3.1 多類像素準確率評估

為了定量的說明模型對不同區域的分割性能,使用了像素準確率(Pixel Accuracy,PA)[31]對背景,上皮組織和間質組織區域進行了評估,計算表達式如式(11):

其中:TP表示分割網絡正確分為正樣例的像素點數量(True Positive);TN表示分割網絡正確分為負樣本的像素點數量(True Negative);FP表示分割網絡錯誤分為正樣例的像素點數量(False Positive);FN表示分割網絡錯誤分為負樣本的像素點數量(False Negative)。像素準確率是評估語義分割結果的常用指標,反映了分割正確的像素點數量占所有分割像素的比例。對于每一類區域的類像素準確率(Class Pixel Accuracy,CPA)的計算公式如式(12)所示,最終的評估結果如表1所示。

表1 不同模型的CPA評估結果Tab.1 CPA evaluation results of different models

從評估結果中可以看出,FCN 對上皮組織區域的分割準確率要高于對間質組織區域的分割準確率,同時對背景區域的分割準確率要遠低于上皮區域。主要是因為FCN 的網絡結構中解碼器較弱,因此無法對一些細小的敏感區域進行精準分割。而Unet 對背景區域和間質區域的分割準確率較低,因為語義代溝的問題,所以無法很好地區分上皮和間質區域,Segnet和Unet++則對三類的分割都比較均衡。對比其他端到端的深度學習分割模型,EPScGAN 可以在保證三類分割比較均衡的前提下,每一類的分割像素準確率都達到最高。

3.2 平均交并比評估

平均交并比(mean Intersection over Union,mIoU)在深度學習圖像分割領域中是一個衡量圖像分割精度的重要指標。交并比(Intersection over Union,IoU)的計算公式如式(13)所示:

所以IoU 計算了分割結果和真實標記交集和并集的比例。先求出分割結果在每一類上的IoU 值,然后計算平均值就可以得到mIoU 值。不同模型在測試集上的mIoU 對比結果如表2所示。

表2 不同模型的mIoU評估結果 單位:%Tab.2 mIoU evaluation results of different models unit:%

從表2可以看出,本文提出的EPScGAN 模型在H&E 染色的上皮和間質組織區域病理圖像分割任務中比其他的流行醫學圖像分割模型具有更高的分割精度。

圖6 對稱結構分割模型的分割結果細節展示Fig.6 Detailed display of segmentation results of symmetric structure segmentation models

4 結語

為了有效地分割出H&E 染色病理組織圖像中的上皮和間質區域,本文提出了基于cGAN 的分割模型EPScGAN。該模型中使用了Resnet 模塊增加網絡容量來提升網絡的魯棒性,同時使用了cGAN 中的判別機制來為生成器的訓練提供了可訓練的損失函數,使得網絡得到了充分的訓練。對比實驗結果表明,與一般的深度分割模型相對比,EPScGAN 模型能夠更加有效地提取上皮和間質組織區域的語義特征,并且對兩種區域的多樣性識別具有更高的魯棒性。目前我們只使用了乳腺組織病理圖像中的上皮和間質區域區域數據集進行了實驗,因此下一步工作是把EPScGAN 模型用到其他的醫學圖像分割任務中,并和一般的深度分割模型作比較。