基于學生人體檢測的無感知課堂考勤方法

方書雅,劉守印

(華中師范大學物理科學與技術學院,武漢 430079)

0 引言

文獻[1-3]中提出高校學生上課率是影響其學習成績的重要因素之一。近年來,文獻[4-8]研究基于人臉識別的課堂考勤系統,用來確認學生是否到課堂聽課,減少教師人工點名的時間開銷。目前單一人臉識別技術比較成熟。但由于課堂環境特殊,人臉識別技術在應用到課堂考勤系統中存在許多難點。首先由于學生數目較多,教室的面積很大;其次因為教室采光和通風的要求,導致教室的窗戶比較多,教室內光強分布極度不均勻;最后學生在上課時的姿態千變萬化。這些問題都給課堂考勤中人臉檢測和人臉識別的應用帶來挑戰。

基于人臉識別的課堂考勤系統依賴于人臉檢測的性能。從一張包含眾多學生、學生姿勢各異、光線不均勻的視頻圖片中檢測出所有學生的人臉,是一項技術挑戰。如果不能檢測出所有學生的人臉,勢必會遺漏上課的學生。為了避免漏檢,Balcoh 等[4]使用皮膚分類技術輔助Voila-Jones 人臉檢測算法[9],提高了檢測過程的效率和準確性。Fu 等[5]采用基于深度學習方法的MTCNN(Multi-Task Convolutional Neural Network)算法[10]進行人臉檢測,該算法具有良好的魯棒性,可以檢測出不同姿態的人臉,但是仍然會存在漏檢。劉宇明等[11]優化了MTCNN 算法[10]并引入時空特征實現對參會人員跟蹤檢測和人數統計的功能。Sarkar 等[6]使用tiny-face 算法[12]用于檢測不同尺度、不同姿態的人臉,極大地提高了小尺度人臉的檢測率。雖然上述這些系統使用的人臉檢測方法在準確率方面有大幅度提升,但是這些方法[4-8]在檢測過程中仍需要學生主動面向攝像機且保證自己不被其他同學遮擋。這不僅會干擾學生和老師的正常上課,同時也不利于后續在自然狀態下對學生的課堂行為和表情進行研究。

通過人臉檢測方法在檢測到學生人臉后,需要將人臉區域的圖像裁剪出來,用于人臉識別。人臉識別的性能受人臉姿勢多樣性(低頭、傾斜角度、遮擋等)的影響。龔銳等[13]提出建立多姿態人臉數據集的方法用于人臉識別。Surekha 等[8]將多姿態人臉數據集的方法應用到課堂領域,在注冊時采集每個學生不同姿態、表情、光照下的多張圖片。但這種方法的弊端是注冊時需要學生配合,對每個學生拍攝視頻并選擇合適的多張圖片。這不僅增加了額外的人工開銷,而且沒有在識別過程中考慮人臉姿態多樣性的影響。

同時,人臉圖像質量也是對人臉識別的準確性造成影響的因素之一。如果學生人臉在拍攝的視頻圖片中尺寸較小,被裁剪出的人臉圖像再被放縮到統一尺寸時,會出現圖像模糊、圖像質量變差的問題,從而影響識別的準確率。目前,針對低分辨率圖像的人臉識別技術[14-15]尚未應用到課堂識別領域。對此方冠男[16]采用PTZ(Pan/Tilt/Zoom)攝像機對教室進行分區定點拍攝的方法提高圖像質量,但是識別性能有待提高。

為解決上述問題,在基于人臉識別的課堂考勤系統的基礎上,本文提出一種聯合學生人體檢測和人臉角度篩選的方法,首先有效降低了漏檢率,其次簡化了學生人臉注冊數據集的采集過程,在降低注冊需要的人臉圖片數量的同時提高了識別的準確率,實現無感知、低漏檢、高準確的課堂學生識別功能。該方法為解決課堂學生漏檢問題提供了新的思路。

1 相關技術

1.1 Mask R-CNN目標檢測算法

Mask R-CNN 算法[17]將目標檢測中的Faster R-CNN 算法[18]和語義分割領域的FCN(Fully Convolutional Network)算法[19]相結合,形成一個可同時進行目標檢測和實例分割的多任務模型。Faster R-CNN 對每個候選對象有兩個輸出,一個類標簽和一個邊界框;Mask R-CNN 在其基礎上添加了輸出對象掩碼的第三個分支,對每個感興趣區域(Region of Interest,RoI)上采用一個小的FCN 實現逐像素點的方法預測分割掩碼。Mask R-CNN 算法的創新之處在于提出RoIAlign 方法代替了RoIPool[20]方法,采用雙線性插值實現了像素級別的對齊。

Mask R-CNN 算法的優點是訓練速度快,僅比Faster RCNN 增加少量開銷,運算速度為5幀每秒(Frames Per Second,FPS)。使用ResNeXt-101-FPN 作為骨架的Mask R-CNN 在COCO 實例分割任務上獲得2016 年MS COCO 比賽的冠軍,在目標檢測任務上取得了很好的效果。權衡運算速度和檢測準確率,選擇Mask R-CNN算法檢測學生人體。

1.2 MTCNN 人臉檢測算法

MTCNN 算法[10]提出了一個深度級聯多任務框架,利用人臉檢測與對齊的內在相關性來提高性能。該模型采用了3 個深度卷積神經網絡,并通過由粗糙到細致的方式來預測臉部整體和特征點的坐標。這3 個級聯的網絡分別是快速生成候選窗口的P-Net(Proposal Network)、進行高精度候選窗口過濾選擇的R-Net(Refine Network)和生成最終邊界框與人臉關鍵點的O-Net(Output Network)。該模型也用到了圖像金字塔、邊框回歸、非極大值抑制等技術。MTCNN 算法準確率高、檢測速度快,被廣泛應用在人臉檢測領域[21-22]。

1.3 FSA-Net 頭部姿態識別算法

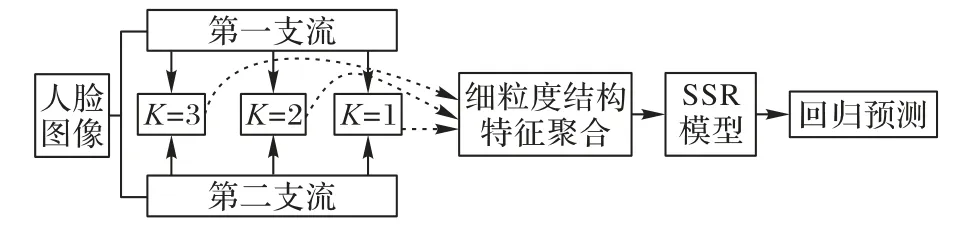

FSA(Fine-grained Structure Aggregation)-Net 算法[23]提出一種直接使用回歸方法的、無標志的姿態估計模型,用于單張圖像的頭部姿態估計。模型的核心思想是將特征圖在像素級別上的特征組合成一組空間信息編碼的特征,作為聚合的候選特征。該方法的目的是學習尋找細粒度的結構映射,以便將像素級別的特征在空間上進行分組以形成更多的冪域級特征。

FSA-Net 算法框架如圖1 所示。輸入的圖像通過兩個支流、三個階段進行提取特征。每個支流在每個階段提取一個特征圖。在每個階段,將兩個支流提取的特征圖融合在一起。對每個階段融合的特征先計算它的注意力圖,然后將特征圖和注意力圖一起被輸入到細粒度結構特征聚合模塊中。該模塊通過對特征圖中的像素級別特征進行空間加權的方式來編碼特征,然后將這些特征聚合以生成用于回歸的最終代表特征集。最后將這些輸出代入軟階段回歸網絡(Soft Stagewise Regression network,SSR)函數以獲得姿態估計。

圖1 FSA-Net框架Fig.1 FSA-Net framework

FSA-Net 算 法 在AFLW2000(Annotated Facial Landmarks in the Wild 2000)數 據 集 和BIWI(Biwi Kinect Head Pose Database)數據集上的結果優于現有的方法(基于地標的方法和無地標的方法),而其模型尺寸是以前方法的1/100 左右。因此本文選用FSA-Net算法進行頭部姿態識別。

2 無感知課堂考勤系統及方法

本系統增加學生人體檢測模塊和人臉角度篩選模塊,采用主、從雙攝像機設備,分別實現教室全景圖的拍攝和定點圖像縮放拍攝的功能。主攝像機拍攝的全景圖像作為學生人體檢測模塊的輸入,計算分析課堂實到學生的數量和位置信息。根據學生位置信息,系統控制從攝像機對每個學生定點縮放拍攝,以獲取高清人臉圖像。最后對獲取的人臉圖像先通過人臉角度篩選,選出合格的正面人臉圖像后再進行識別。

相較于其他人臉考勤系統,本系統有如下4個優點:

1)解決了在單次或有限次數的人臉識別過程中,因人臉信息缺失造成的漏檢問題。

2)可以獲取到每位學生高清放大的人臉圖像。

3)在學生無感知的情況下獲取學生高清的正面人臉圖像用于注冊,極大簡化了傳統的注冊過程。

4)在提高識別率的同時,減少了每個學生注冊時需要的圖像數量。

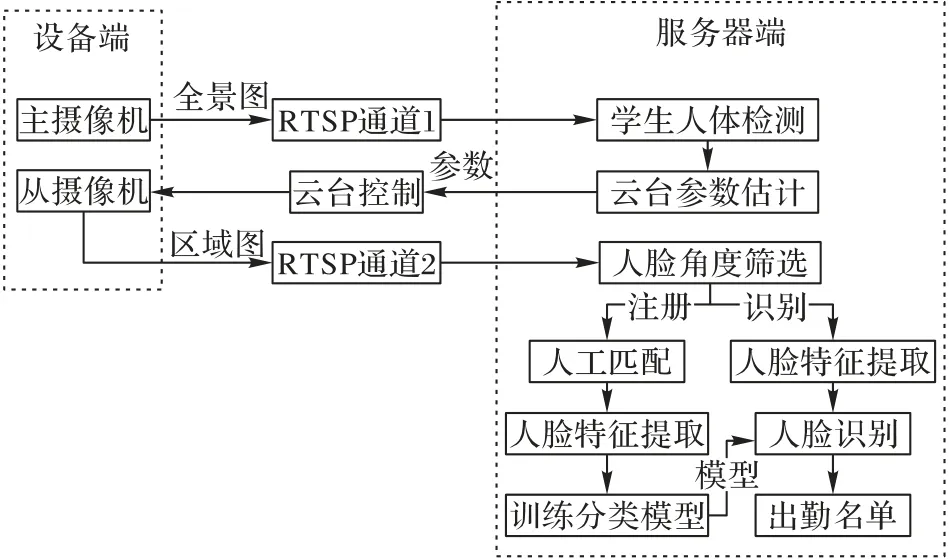

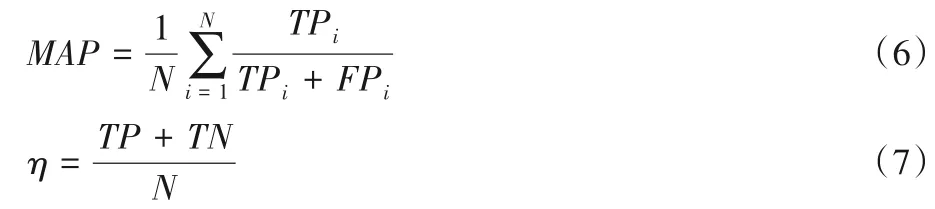

2.1 系統框架

系統在學生無感知、不影響學生正常上課的情況下實現學生注冊和出勤記錄功能。注冊階段不需要額外的設備,也不需要課下逐個采集學生圖像信息。具體框架如圖2 所示,系統在注冊和識別階段采用相同的處理方式,都經過學生人體檢測、云臺參數估計和人臉角度篩選的步驟。不同點在于,注冊過程在初次課程教學時完成;識別階段則在后續課程教學時實時進行。下面對圖2中的硬件和軟件進行詳細介紹。

系統的硬件部分由設備端和服務器端組成。設備采用主、從雙攝像機實現圖像和視頻的采集。其中主攝像機是定焦廣角攝像機,負責拍攝教室全景圖;從攝像機是PTZ 攝像機,可通過參數控制從攝像機對感興趣的區域定點拍攝,并能對區域的圖像進行縮放處理。系統通過控制主、從雙攝像機,可以獲取教室內每位學生高清放大的人臉圖像。

軟件功能在服務器端實現,包括學生人體檢測、云臺參數估計、人臉角度篩選、注冊和識別部分。首先,采用Mask RCNN 算法對主攝像機拍攝的教室全景圖進行學生人體檢測,確定實到學生數量和每個學生的位置;然后將學生位置信息輸入到多元線性回歸模型中,估計出云臺在垂直方向和水平方向上的轉動角度和變焦度數這3 個參數。通過參數控制云臺轉動,使從攝像機對準目標學生。接著對從攝像機拍攝的區域圖進行基于FSA-Net 算法的人臉角度篩選,篩選出清晰、無遮擋的正面人臉。最后根據情況選擇進入注冊或者識別階段。兩個階段均采用FaceNet 算法[24]對篩選的人臉圖像進行特征提取,在注冊階段使用提取的特征訓練支持向量機(Support Vector Machine,SVM)的分類器;在識別階段將提取的特征輸入到訓練好的SVM 模型中進行預測以確定學生身份。當每個學生位置依次進行識別后,系統輸出本節課出勤學生名單。

圖2 系統框架Fig.2 System framework

2.2 無感知課堂考勤方法

2.2.1 學生人體檢測

現有課堂考勤系統均采用基于人臉的檢測方法,其缺點是檢測過程中完全依賴人臉信息。一旦出現學生人臉信息缺失的情況(如學生低頭看書或者記筆記、學生側臉、回頭或者被其他學生遮擋等情況),學生即使出現在課堂上也會被判為缺勤。而相較于人臉,人體面積更大,包含的信息更多,被全部遮擋住的概率更小。故本系統在人臉檢測的基礎上增加學生人體檢測模塊,目的是先確定整個課堂實到學生的數量和位置信息,避免因人臉信息缺失造成的漏檢。

學生人體檢測采用目標檢測中的Mask R-CNN 算法。輸入圖片Ij,Mask R-CNN算法的標準輸出為{(bj,maskj,cj,scorej)}j,j是檢測到的目標索引,向量bj是邊界框,maskj是掩碼,cj是類標簽,scorej是得分。其中,bj=[y1j,x1j,y2j,x2j]分別代表邊界框的左上頂點和右下頂點在y軸和x軸方向上的圖像坐標。Mask R-CNN 算法可以檢測80 種不同類別的物體實例。學生人體檢測方法將教室全景圖作為輸入,篩選Mask R-CNN輸出中類標簽為“person”的邊界框集合B={b1,b2,…,bi,…,bN}作為學生人體檢測的結果,N表示檢測到的學生個數。

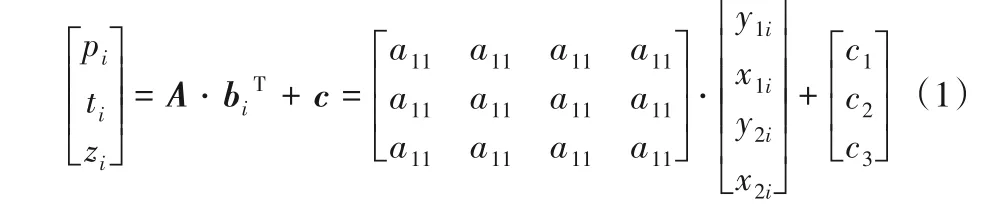

2.2.2 從攝像機控制

通過學生人體檢測確定到課學生的數量和位置后,需要對學生身份進行識別。為獲取學生的高質量圖像以提高識別的準確率,系統根據學生位置信息控制從攝像機,依次定位到每個學生,并對學生圖像進行縮放,獲取高清的視頻圖片。

通過設置垂直和水平方向上的轉動角度以及變焦倍數這三個參數,系統可以控制從攝像機轉動到指定位置并對圖像進行縮放處理。為了根據學生的位置信息得到控制從攝像機運動的三個參數,本文建立了多元線性回歸模型,其表達式和展開形式如式(1)所示。其中i是學生的索引號,每個學生的人體邊界框記為向量bi,矩陣A為回歸系數項,向量c為隨機誤差項,模型輸出為從攝像機在垂直方向和水平方向上的轉動角度pi和ti,以及變焦倍數zi。

通過這3 個參數控制云臺轉動,使從攝像機對準本張全景圖中的第i個學生,并在后續過程中識別該學生。

2.2.3 人臉角度篩選

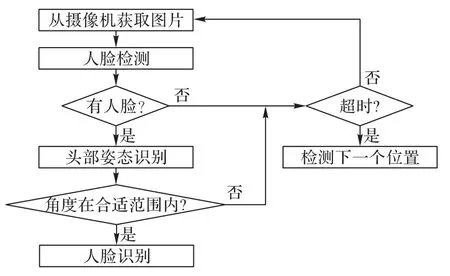

本文通過實驗發現上課時學生不會一直抬頭看向黑板或者教師(面朝攝像機),會出現側臉、低頭或前后排學生遮擋。在對每個學生進行識別的過程中,若采取實時檢測,則會造成嚴重的系統負擔;若隨機選擇一張或者多張圖像進行人臉檢測,則無法保證圖像包含有效的人臉信息。因此,在人臉識別前,系統會對檢測到的人臉進行角度識別篩選出正面人臉圖像。具體流程如圖3所示。

圖3 人臉角度篩選的流程Fig.3 Flowchart of face angle filtering

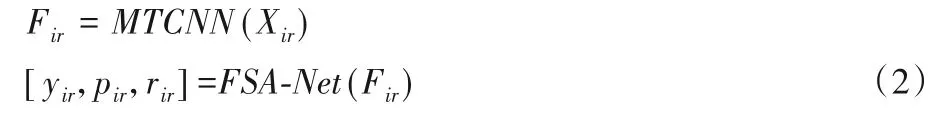

系統對從攝像機獲取的第i個學生的圖像依次進行人臉檢測和人臉角度篩選,將獲取到的第i個學生的第r圖像記為Xir。先采用MTCNN 算法對圖像Xir進行人臉檢測,輸出160×160維的人臉圖像Fir;再通過FSA-Net頭部姿態識別算法對人臉圖像Fir進行角度值的預測,輸出偏航角yir、俯仰角pir、翻滾角rir。如式(2):

如果3 個角度的取值范圍滿足式(3)或(4)的條件,則認為第i個學生的第r人臉圖像Fir是合適的正面人臉圖像,可被用于后續的訓練或者識別:

3 實驗及分析

為驗證學生人體檢測方法性能優于主流的人臉檢測算法,設計了學生人體檢測實驗。針對人臉角度篩選方法能夠降低注冊數據量、提高識別準確率的說法,設計了人臉角度篩選實驗。最后對系統進行整體測試。三個實驗采用不同的評價指標,驗證基于學生人體檢測的無感知課堂考勤方法在不同評價指標上的性能表現和提升。

3.1 評價指標

學生人體檢測實驗將比較人臉檢測算法和Mask R-CNN算法的性能。因二者都屬于目標檢測領域,故該實驗采用目標檢測算法最常用的指標:檢測速度和MS COCO 目標檢測挑戰中使用的、評估精度。分別表示IOU 設置的閾值為0.5 和0.75 時的平均精度(Average Precision,AP)。APcoco是IOU 設置的閾值從0.5~0.95,以0.05 的步長,分別計算AP 最后將所有結果取的均值。重疊比(Intersection Over Union,IOU)的計算公式如下:

設學生人體檢測或人臉檢測預測的任意一個邊界框為向量b,其對應的真實邊界框為向量bg。

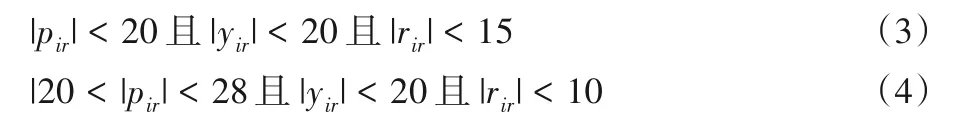

人臉角度篩選實驗和系統驗證實驗分別采用平均精度均值(Mean Average Precision,MAP)和準確率η作為評價指標,如式(6)和(7)所示:

其中:N表示學生個數,TP(True Positive)是正確檢測到的出勤學生數量,FP(False Positive)是檢測錯誤的學生,TN(True Negative)是正確檢測到的缺席學生數量。

3.2 學生人體檢測實驗

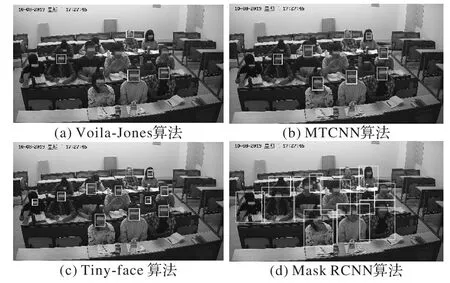

實驗對比了本文采用的Mask R-CNN 算法和課堂考勤系統中常用的三種人臉檢測算(Voila-Jones[9]、MTCNN[10]、Tinyface[12])在平均精度和檢測速度上的差異。數據采集了同一間教室12個課堂的200張全景圖片。采集方式為在學生正常上課的情況下,每2 min 保存一張全景圖片,并對每一張全景圖內的學生人臉和人體分別進行人工標注作為驗證集。實驗結果如圖4和表1所示。

圖4 針對某圖的4種算法檢測結果Fig.4 Detection results of four algorithms of a certain photograph

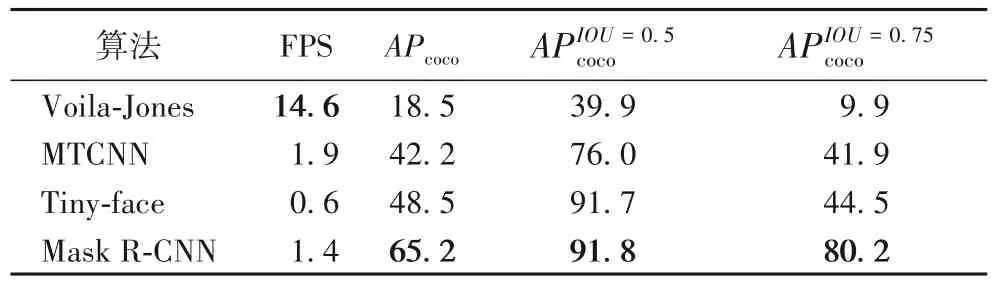

表1 是4 種算法根據評價指標在200 張數據集上的實驗結果。除Voila-Jones 算法,其他3 種深度學習的算法均使用GPU 進行加速。從檢測速度上看,傳統的Voila-Jones 算法在不適用GPU 加速時的速度明顯比深度學習算法檢測速度上高一個數量級。但是在檢測精度上,深度學習算法要明顯優于Voila-Jones算法。

表1 四種算法結果Tab.1 Results of four algorithms

在3 種人臉檢測算法中,Tiny-face 算法在APcoco、三個指標上都明顯高于其他2 種人臉檢測算法。與MTCNN 人臉檢測算法相比,Tiny-face 算法在指標上具有明顯優勢,高出約15 個百分點。雖然Tiny-face 算法在指標上與Mask R-CNN 算法效果相同,但是Mask R-CNN 算法能夠兼顧在不同IOU 閾值下的AP值、APcoco、指標上分別提升了約17個百分點和36個百分點。這是由于人體比人臉面積更大,在一定程度上降低了檢測難度。與Tiny-face算法相比,Mask R-CNN 算法耗時減少了57%。

圖4 是對同一張教室全景圖采用不同算法的檢測結果,其中的矩形框是檢測到的人臉或人體的邊界框。為保護學生的隱私權,對結果圖片進行了人工打碼。圖4(a)、(b)、(c)三種人臉檢測算中,檢測效果最好的是Tiny-face算法,只漏檢了最后一排低頭和被遮擋的兩個學生。Voila-Jones 算法和MTCNN 算法分別漏檢了8 個和5 個學生。圖4(d)采用Mask R-CNN 人臉檢測算法的檢測結果優于Tiny-face 算法,所有學生都被檢測到。

因此Mask R-CNN 算法在精度和檢測速度上都優于Tinyface 人臉檢測算法。從實驗結果可知,本文提出的學生人體檢測方法可以減少因為人臉信息缺失造成的學生漏檢。

3.3 人臉角度篩選實驗

人臉角度篩選方法可以用在注冊階段和識別階段。本實驗的目的是驗證在兩個階段均采用人臉角度篩選方法會提高最終識別的準確率,并減小注冊時的數據量。本實驗的對象為某課堂的14 名學生。以該課堂第一次上課時采集的數據作為訓練集,后續三周的數據作為人臉識別的測試集。

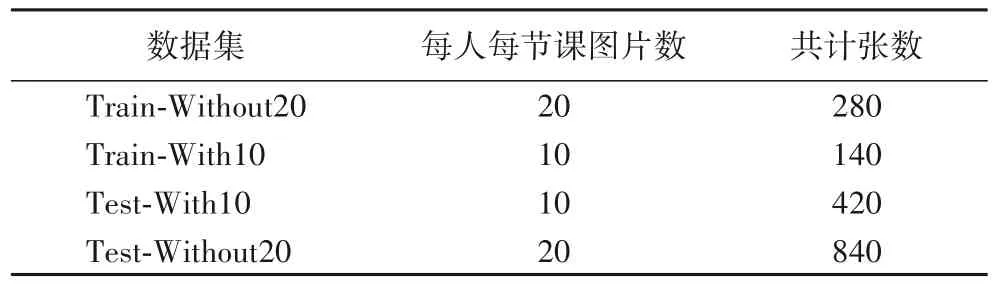

在注冊階段,采用人臉角度篩選方法為14 名學生每人篩選出10 張正面人臉圖像,共計140 張,制作成篩選訓練集Train-With10。在后續三周的課堂上,使用同樣的方式采集每名學生正面人臉圖像共計420 張,制作成篩選測試集Test-With10。為進行對照實驗,在注冊和識別階段,通過MTCNN檢測算法對每名學生的視頻流進行裁剪,再由人工為每名學生篩選出20 張不同角度的人臉圖像,制作成多姿態人臉數據集Train-Without20 和Test-Without20。數據集的詳細介紹如表2 所示。因為經過人臉角度篩選后的人臉圖片比多姿態人臉圖片少,所以兩種類型的數據集的大小不同。

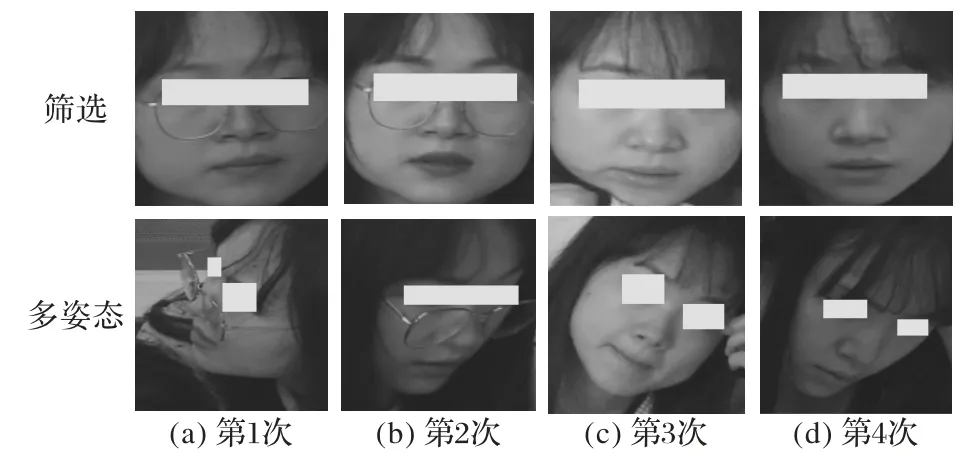

圖5 為某學生的8 張人臉圖片:第一行的4 張圖片來自于篩選數據集;第二行的4 張圖片來自于多姿態人臉數據集。由圖可知,篩選數據集中的圖像為正面人臉圖像,不同圖像中的人臉角度差別較小;而在多姿態人臉數據集中,有回頭、側臉和低頭的人臉圖像,人臉角度差異較大。

表2 數據集介紹Tab.2 Introduction of datasets

圖5 兩種數據集圖片樣例Fig.5 Sample images of two datasets

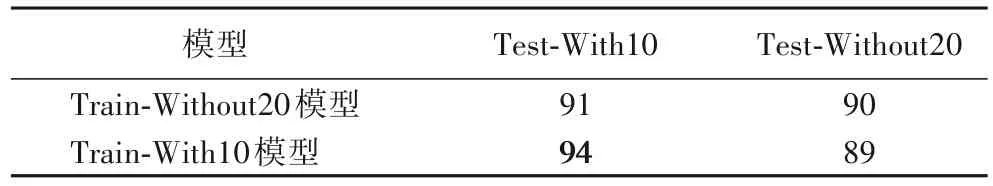

實驗使用訓練集Train-With10 和Train-Without20 分別采用Facenet算法[24]訓練對應的人臉分類模型,并在Test-With10和Test-Without20 這兩個測試集上測試其性能。實驗結果如表3 所示,兩個模型在篩選過的Test-With10 測試集上的MAP值均高于不篩選的Test-Without20 測試集,分別提高了1 個百分點和5 個百分點。在篩選過的測試集上,使用篩選過的訓練模型(Train-With10 模型)的MAP 值比不篩選的模型(Train-Without20模型)提高了3個百分點。

表3 模型測試結果 單位:%Tab.3 Model test results unit:%

在表3 中,Train-Without20 模型在Test-Without20 測試集上的準確率為90%,其物理含義是在注冊和識別時均采用多姿態人臉方法的準確率為90%;同理,Train-With10 模型在Test-With10測試集上的準確率表示在注冊和識別時均采用人臉角度篩選方法的準確率為94%。由此可知,在注冊和識別過程中均采用人臉角度篩選方法,與多姿態人臉注冊和識別的方法相比,可以將識別準確率提高4個百分點。

為證實采用人臉角度篩選的方法可以減少學生注冊時的數據量,將訓練集Train-With10 中每個人的圖片從10 張減少至5 張,記為訓練集Train-With5。訓練集Train-With10 和Train-With5 分別用于模型訓練并在Test-With10 測試集上進行測試。兩個模型在測試集上的MAP 值均為94%。因此在保證識別率的同時,可以減少數據量,對每個同學只采集5 張圖片制作訓練集。

3.4 系統驗證實驗

為測試整個系統的性能,對3.3 節的同一實驗對象進行實時課堂識別。一共檢測了6 節課,每次上課時間相隔一周。6 次識別中5 次識別的準確率為100%;1 次為92.8%,即一位同學被誤判。從系統實驗結果分析,本系統識別的準確率較高。

4 結語

本文提出一種聯合學生人體檢測和人臉角度篩選的方法,改進現有系統的整體框架和學生注冊方案。研究表明人體檢測方法能夠有效緩解因人臉信息缺失造成的人臉漏檢問題;在注冊和識別階段均采用人臉角度篩選方法可以減少注冊需要的數據量,提高識別準確率,在課堂應用場景下優于建立多姿態人臉數據集的方法。本文為課堂學生出勤率檢測提供了一種新的解決思路,具有一定的實踐意義。在后續課堂人臉識別的研究中,可以考慮使用超分辨率圖像重建技術提高人臉識別的準確率、降低硬件成本。