融合無人機高分辨率DOM和DSM數據語義的崩崗識別

沈盛彧,張 彤,程冬兵,王志剛,趙元凌,鄧羽松,錢 峰

(1. 長江水利委員會長江科學院,武漢 430010;2. 水利部山洪地質災害防治工程技術研究中心,武漢 430010;3. 武漢大學測繪遙感信息工程國家重點實驗室,武漢 430079;4. 廣西大學林學院,南寧 530004)

0 引 言

崩崗是華南廣大風化殼坡地上發育著的各種形狀的深切山坡崩陷凹地形,其沖溝溝頭部分經不斷地崩塌和陷蝕作用而形成一種圍椅狀侵蝕地貌[1]。崩崗的顯著特點是侵蝕量大、爆發性強,并且發展速度快、突發性強[2],具有破壞土地資源、毀壞基本農田、惡化生態環境等危害,直接威脅著國土、糧食和生態安全。

自1960年曾昭璇提出“崩崗”概念[1],至今已有60年,國內學者從地貌學、地質學、生態學、土壤學等不同專業角度對崩崗的發生、發育機理、監測和防控治理等方面已經開展了豐富的研究[3]。研究或治理崩崗,首要問題是識別研究對象崩崗。傳統的崩崗識別方法,大多為在當地詢問、現場尋找,不僅人力、物力成本高而且效率低,難以滿足大范圍崩崗調查的需要。如2005年12月,水利部組織長江水利委員會水土保持局與珠委、太湖流域管理局水保處組織流域崩崗侵蝕區內各級水保部門,歷時16個月才完成了中國南方崩崗侵蝕現狀調查[4]。

隨著21世紀信息技術的飛速發展,3S技術等高精度空間手段被應用到崩崗研究中[5-7]。崩崗發現和調查在實際操作中改進為根據專家經驗在高分辨率衛星遙感影像上進行人工解譯搜索[8-9]。但由于在平面遙感影像上崩崗內部與平地裸土極為相似,且崩崗發育到中后期有植被恢復,邊界并不明顯,因此識別非常困難。近年來,無人機航測技術的爆發和普及,使得高分辨率(厘米、分米級)數字正射影像圖Digital Orthophoto Map(DOM)和數字表面模型Digital Surface Model(DSM)等對地觀測數據的獲取日益容易,這種高精度空間信息采集手段也被越來越多地應用到崩崗調查和監測的定量研究[10-12]。而此類研究大都基于已知崩崗位置前提條件,崩崗發現還是前期通過人工完成,效率低,并未充分挖掘利用無人機所采集的高精度DOM和DSM的潛在價值。如何借助相關分析識別與挖掘技術,進一步結合崩崗自身特點,有效利用高分辨率DOM與DSM進行高效自動的崩崗識別,對于大規模低成本的崩崗調查和崩崗侵蝕機理的研究都具有非常重要的意義。

在遙感影像場景和對象的分類識別領域,為了提高識別精度、解決底層視覺特征與高層語義信息的關聯問題即“語義鴻溝”[13],研究者借鑒自然語言處理中的語義分析方法,將詞袋模型和概率主題模型[14]引入研究,并取得了不錯的效果[13,15-19]。在水土保持應用方面,Cheng等[20]提出了一種基于BoVW(Bag of Visual Words)和PLSA(Probabilistic Latent Semantic Analysis)的場景分類方法從平面遙感影像中自動識別滑坡,較好地區分滑坡和非滑坡遙感影像。但總體來看,當前方法僅使用正射或平面遙感影像,較適合于僅針對角點、邊緣、紋理特征明顯的地物地貌(如道路、房屋、滑坡等),而對于地形特征明顯,邊界、紋理特征并不明顯的崩崗識別效果并不好。DSM,即高程維度的信息,能很好地描述崩崗地形起伏復雜零碎,崩壁邊緣陡變、傾角較大的特征,能有效地區分平坦或平緩地形。將DSM作為DOM的信息補充,融合DOM和DSM就如同給算法輸入了三維模型,理論上將極大地提高崩崗識別率。

本文提出了一種利用無人機航測所獲得的高分辨率DOM和DSM自動識別崩崗的方法。本文提出視覺-地形詞袋模型(BoV-TW),并基于此對DOM和DSM所提取的局部特征進行混合描述,并通過LDA[21]進行潛在語義分析融合,最后使用支持向量機SVM[22]進行監督學習訓練分類器,實現了崩崗的高精度自動識別。

1 材料與方法

1.1 研究區概況

研究區在湖北省通城縣大坪鄉坪山村,位于通城縣西北角的半山區丘陵地帶,113°48'E,29°18'N,亞熱帶季風氣候,光照適中,氣候溫和,雨水充足,四季分明。根據2018通城年鑒記錄,年平均日照時數1 706 h,年平均氣溫 17.1 ℃,歷史最高氣溫 40.7 ℃,歷史最低氣溫-15.2 ℃,年平均降雨量1 556 mm[23]。該區域土壤大多為由花崗巖母質發育的紅壤,土壤結構松散,水土流失情況嚴重,崩崗侵蝕廣泛分布。試驗對象為該村附近的 3處發育晚期的崩崗,如圖1所示。灌木、草木群落交錯,伴有部分次生喬木,如圖2所示,平均海拔110 m左右。

圖1 研究區3處崩崗(2015年谷歌地球影像)Fig.1 Three Benggang in research area(Google Earth images in 2015)

圖2 崩崗現場照片Fig.2 Benggang scene photos

1.2 數據采集

本試驗數據采集于2016年9月,使用大疆精靈3P微型無人機,3個架次航線均設計為長500 m、寬200 m、航高150 m,來回2次航向重疊率70%,旁向重疊率60%。無人機航拍影像通過Photoscan v1.4.1進行拼接、空三、糾正、建模處理后獲得 3塊崩崗區域的 0.07 m分辨率DOM和0.15 m分辨率DSM,如圖3所示。本文以1、2號崩崗數據為訓練集,3號崩崗數據為測試集進行試驗。

圖3 3處崩崗的數字正射影像圖DOM和數字表面模型DSMFig.3 Digital Orthophoto Map (DOM) and Digital Surface Model(DSM) of three Benggang

1.3 研究方法

1.3.1 關鍵理論

1)視覺-地形詞袋表達

在自然語言處理中,文檔集合的處理主要涉及 3個層次的實體,即“詞項”“文檔”和“文檔集”,并定義如下:

① 一個詞項是最基本的離散單元,通過特定詞匯表定義為索引{1,2,3,…,V}中的一項,其中V為詞項的總數量,即詞匯表容量;

② 一個文檔是一個由N個詞項組成的序列,表示為W=(w1,w2,w3, …,wN),其中wN是此序列中的第N個詞項;

③ 一個文檔集是M個文檔的集合,可表示為D=(W1,W2,W3, …,WM)。

Bag of Words(BoW)模型,即詞袋模型,忽略文檔中詞項的詞序、語法、句法和段落間聯系,假設每個詞項的出現是獨立事件,將文檔看作一系列詞項的集合,只統計詞項在文檔中出現的次數。類似 BoW,Bag of Features(Keypoints)和 Bag of Visual Words相繼被圖像和計算機視覺領域的研究者提出[24-25]。他們將圖像看作文檔,將圖像的底層視覺特征聚類后的中心看作詞匯表用來描述圖像。

本文方法在Bag of Visual Words基礎上,進一步融入DSM局部特征,將地形局部特征聚類后的中心作為描述地形的詞匯表,聯合DOM局部特征形成視覺-地形詞袋模型(BoV-TW),實現對崩崗區域的視覺-地形詞袋表達。

2)局部特征

① DOM局部特征

按照計算機視覺領域的相關研究,Affine Covariant Regions(仿射協變區域)[26],如Harris-Affine[27]、Maximally Stable Extremal Regions(MSER)[28]等等,具有以下優點:多尺度視點描述不變性;對指定區域有較好的描述穩定性;對輻射變化具有較好的容錯性,是描述高分辨率遙感影像是較好的選擇。因此,本文方法采用Harris-Affine和 MSER兩種視覺特征,再使用公認最好的 SIFT(Scale-Invariant Feature Transform)特征描述器[29]來描述特征。

② DSM局部特征

遵循地學原理,為保留主要地貌形態,并在局部抑制破碎的微地貌特征,本文方法采用三維Douglas-Peucker算法[30]提取地形特征點。為了保證特征描述的方向不變性和泛化性,本文方法設計的DSM特征描述是取特征關鍵點鄰域范圍的圓形窗口,計算出每個像素的梯度大小和梯度方向,并對各點的梯度采用反向距離加權,然后使用多個梯度方向來統計直方圖,最后將主方向旋轉至第一維度,實現描述向量的標準化。

3)LDA模型

LDA(Latent Dirichlet Allocation)是一種文檔集的概率生成模型,通過基于概率的有限混合將詞項、主題和文檔 3個層次組織起來。每個文檔可以表示為多個主題的有限概率混合,而每個主題對應于詞匯表上的一個多項式分布,主題被文檔集中的所有文檔所共享。

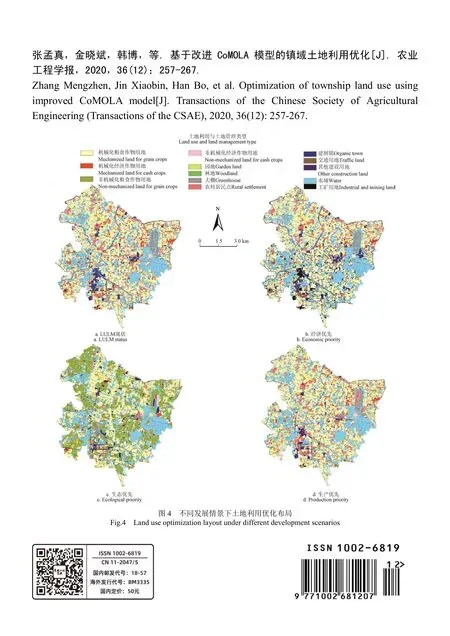

將生成過程按模型描述,LDA的圖模型如圖4所示。其中,空心圓表示潛在變量,而實心圓表示觀察變量;2個矩形框表示重復過程。內矩形表示文檔中的N個詞項從以β為參數的多項式分布生成的過程,外矩形表示文檔集中的M個文檔中的主題從以α為參數的狄利克雷分布生成的過程。

圖4 LDA圖模型[21]Fig.4 The graphic model of Latent Dirichlet Allocation

一個K維的以α為參數的狄利克雷隨機變量θ的概率如下式所示:

給定參數α和β,主題混合變量θ、N個主題的集合z和N個詞項的集合w的聯合概率可定義為

式中p(z|θ)代表使得= 1 的i所對應的θi。然后,對nθ積分,并對主題z求和,便可以獲得文檔的邊緣概率:

最后,通過連乘獨立文檔的邊緣概率,就可以獲得文檔集D的概率:

通過LDA的圖模型不難看出,參數α和β是文檔集級的參數,它們在生成一個文檔集過程中只需要采樣一次;變量θd是文檔級的變量,每個文檔需采樣一次;最后,變量wdn和zdn是詞項級的變量,對每個文檔中的每個詞項都要采樣一次。

1.3.2 總體流程

本文方法流程共分為五大部分:1)DOM和DSM數據預處理;2)局部特征提取與描述,視覺-地形詞匯表生成;3)崩崗訓練集特征提取和詞頻統計,形成視覺-地形詞袋表達,通過潛在語義分析建立 LDA模型;4)崩崗測試集特征提取和詞頻統計,形成視覺-地形詞袋表達,基于已有 LDA模型生成概率主題分布表達;5)崩崗標記,SVM分類器訓練,對崩崗測試集進行預測,完成崩崗自動識別,如圖5所示。

圖5 崩崗自動識別總體流程Fig.5 Overall workflow of automatic Benggnang recognition

1.3.3 具體流程

1)預處理

本部分以圖1中3號崩崗數據作測試集為例介紹數據的劃分。本文方法采用均勻網格劃分法將整個崩崗區域的DOM和DSM,統一以DSM的XY方向水平分辨率0.15 m劃分為兩兩相對應的256×256像素瓦片,即每塊區域約38 m×38 m。測試集DOM和DSM劃分后的拼接圖,如圖 6所示。去除掉各種邊緣拉伸形變過大和高程變化異常的瓦片后,1、2、3號崩崗數據分別得到240、291和208塊區域。

2)視覺-地形詞匯表生成

為了將每塊崩崗瓦片區域表達成有限等長的向量能進行后期的潛在語義分析,就必須建立視覺-地形詞袋模型的詞匯表。

圖6 測試集DOM和DSM的劃分圖Fig.6 Partition of DOM and DSM of test set

本文方法 DOM 局部特征采用了牛津大學 Visual Geometry Group(VGG)的Harris-Affine特征、MSER特征提取算法以及72維的SIFT描述器。本文方法設計的DSM局部特征,在提取3DDP地形特征點時,使用了2倍于水平分辨率的高程閾值,特征描述中鄰域半徑為 16個像素,梯度統計方向設定為24個。

對訓練集DOM和DSM各531塊,分別提取獲得Harris-Affine特征描述25萬個、MSER特征描述34萬個以及3DDP特征描述10萬個,再分別對它們做一定簇數(如500個)的K-means聚類,最后順序連接形成(1500維的)視覺-地形詞匯表。

3)LDA模型訓練

通過視覺-地形詞匯表,531個訓練集區域可以使用kNN(k-Nearest Neighbor)算法表達為1500行×531列的共現矩陣p(W|Rtraining)。然后通過設定不同的主題個數,進行LDA訓練實現潛在語義分析和降維,獲得p(W|Z)和p(Z|Rtraining)。

4)測試集融合表達

對208個測試集區域進行DOM和DSM特征提取和表達,通過 kNN和視覺-地形詞匯表,表達成詞匯表達1500行×208列p(W|Rtest),再基于LDA模型訓練生成的p(W|Z)通過Gibbs-resample重采樣生成測試集的DOM和DSM融合表達p(Z|Rtest)。

5)崩崗與非崩崗場景分類

① 崩崗與非崩崗標記。為了獲得最真實的分類標記作為驗證本文方法精度和準確度的標準,本文采用了人工解譯判讀和現場復核相結合的方式對訓練集和測試集進行崩崗與非崩崗標記。首先,通過從多視角和多尺度查看photoscan中利用無人機航拍影像生成的高分辨率崩崗三維模型,如圖7a所示,根據地形、巖石/土壤、植被等的顏色、形態、紋理信息對照規劃格網劃分的DOM瓦片逐一進行目視判讀。如果單塊網格區域超過 50%以上面積是崩崗,才會被標記為崩崗,否則標記為非崩崗。然后,開展了現場復核,實地使用手持GPS定位,查勘了崩崗的集水坡面、崩壁、崩積體、溝道、沖積扇以及積水區等部分形態特征,并從細節上調查了基巖性質和土壤、植被類型,對照內業人工解譯判讀的崩崗區域進行定位核實,重點排查了被植被覆蓋而無法從 DOM 和DSM中目視判讀的崩崗區域,獲得了測試集崩崗和非崩崗標記的最終結果,如圖7b所示。訓練集與測試集數據及分類標記情況如下表1所示。

圖7 測試集崩崗三維模型和標記Fig.7 3D model and labels of Benggang of test set

表1 訓練集與測試集分類標記統計Table 1 Statistic of training set, testing set and labels

② SVM訓練。利用LDA模型訓練生成的p(Z|Rtraining)和訓練集區域崩崗與非崩崗標識,matlab R2018a的SVM工具,以RBF徑向基函數為核,進行2000次迭代訓練,生成SVM分類器。

③ 測試集分類。將p(Z|Rtest)輸入2)中生成的SVM分類器,獲得測試集的崩崗與非崩崗預測值及標記。

2 試驗結果與分析

為了證明結合DSM特征和使用潛在語義分析LDA進行融合能較好的提升識別精度和效果,進行3組對比試驗。第1組為本文方法與僅基于DOM局部特征融合的方法[16]進行崩崗識別對比。第2組為本文方法與僅基于BoV-TW模型而不進行潛在語義分析的方法進行崩崗識別對比。第3組為本文方法與基于 ResNet50網絡[31]的 DOM 及DOM+DSM兩種數據源的崩崗識別對比。

本試驗主要指標包括總精度(Total Accuracy,TA)、崩崗查全率(Benggang Recall,BR)和崩崗查準率(Benggang Precision,BP)3 個。其中,TP(True Positives)代表崩崗識別正確個數,TN(True Negatives)代表非崩崗識別正確個數,FP(False Positives)代表崩崗識別錯誤個數,FN(False Negatives)代表非崩崗識別錯誤個數。

2.1 與僅基于DOM局部特征融合的方法對比

本組試驗中僅基于 DOM 局部特征融合的方法同樣采用Harris-Affine和MSER兩種局部特征。保持3種特征的提取方法、詞匯表大小(每類詞匯各500個)、SVM分類器參數不變,依次計算LDA潛在語義分析主題個數2~50個時2種方法的崩崗識別結果,如圖8所示。

圖8 基于DOM局部特征融合方法與融合DOM和DSM局部特征方法的崩崗識別Fig.8 Benggang recognition result of method based on fusion of DOM local features vs. the method based on fusion of DOM and DSM local features

僅使用DOM特征的方法,總精度在4個主題后就一直保持在85%左右,崩崗查全率保持在70%~85%之間,崩崗查準率在50%左右波動。而本文方法總精度在4個主題后就一直保持在95%左右;崩崗查全率在80%以上,在34、46、48個主題時獲得最高的崩崗查全率97.22%;崩崗查準率在80%以上,在主題12個時獲得最高崩崗查準率94.44%。最優識別效果出現在38個主題時,查全率為94.44%,查準率為85.00%,如圖9所示。

圖9 融合DOM和DSM局部特征方法的崩崗識別Fig.9 Benggang recognition of the method based on fusion of DOM and DSM local features

與基于DOM局部特征融合的方法相比,總精度、崩崗查全率和查準率 3項指標分別提高了約 12%、11%和32%。本文方法的崩崗識別效果整體較優。

2.2 與僅基于BoV-TW模型的方法對比

本組試驗中僅基于 BoV-TW 模型的方法,在采用BoV-TW 模型生成視覺-地形詞袋表達共現矩陣p(W|Rtraining)后,對各個區域的表達進行歸一化處理,使每個區域的表達之和為1,符合概率分布要求,再進行SVM訓練和分類。保持3種特征的提取方法,LDA潛在語義分析主題數為40個,SVM分類器參數不變,依次計算詞匯表大小分別為300、600、900、1 200、1 500、1 800個時2種方法的崩崗識別結果(3類局部特征分別為100、200、300、400、500和600個)。

圖10 基于BoV-TW方法與BoV-TW和LDA融合方法Fig.10 Benggang recognition result of method based on only BoV-TW vs. method based on BoV-TW and LDA

僅基于 BoV-TW 方法總精度在 80%左右,雖然崩崗查全率能達保持在80%左右,但崩崗查準率平均在50%以下。而本文方法總精度一直在90%以上,最高為 96.10%,崩崗查全率也基本在 90%以上,最高為100%,并且崩崗查準率隨著詞匯表大小的增加逐漸提升,到1 500個時達到最高的85.00%。與僅基于BoV-TW模型的方法相比,3項指標分別提高約13%、12%和30%。6種詞匯量大小時的識別效果如圖11、圖12所示。證明運用LDA進行潛在語義分析實現多特征融合能大幅提高識別效果。

2.3 與基于ResNet50網絡的方法對比

在崩崗研究領域,目前還沒有基于遙感數據進行崩崗自動發現的相關研究,故選擇當前計算機視覺領域圖像識別公認效果最好的 ResNet50網絡進行崩崗識別對比。具體測試分為2個:1)以DOM為數據源,RGB三層數據,使用pytorch的ResNet50網絡預訓練數據微調后進行崩崗識別;2)以DOM+DSM為數據源,RGB+DSM高程4層數據,并擴展 ResNet50網絡輸入使用 pytorch的ResNet50網絡預訓練數據微調后進行崩崗識別。

測試結果表明:基于ResNet50網絡和DOM的方法前期迭代訓練中總精度和崩崗精度波動較大,迭代至第 28次時收斂,如圖 13a所示;基于 ResNet50網絡和DOM+DSM的方法崩崗查全率波動較大,迭代至第54次時收斂,如圖13b如所;本文方法的總精度、崩崗查全率和查準率都優于基于ResNet50網絡的2種方法,詳見表2。

圖11 不同詞匯表大小時基于BoV-TW方法的崩崗識別Fig.11 Benggang recognition of the method based on BoV-TW with different size of vocabulary

圖12 不同詞匯表大小時基于BoV-TW和LDA融合方法崩崗識別效果Fig.12 Benggang recognition result of the method based on BoV-TW and LDA with different size of vocabulary

圖13 基于ResNet50網絡DOM和DOM+DSM兩種數據源的崩崗識別效果Fig.13 Benggang recognition results based on ResNet50 with DOM and DOM+DSM two kind of data source

表2 3種方法崩崗識別結果對比Table 2 Comparison of Benggang recognition results of three methods

3 討 論

3.1 創新性與先進性

崩崗作為一種自然地貌特征,很難僅通過人工解譯DOM平面信息準確識別,因此基于DOM局部特征融合的方法查全率和查全率都不高。本文創新性提出結合DOM和DSM來識別崩崗,相當于為識別算法輸入了三維模型信息。通過增加高程維度的信息,能有效利用崩崗區域高程差異顯著的特點進而增強識別效果,因此總精度、查全率和查準率都有大幅度提升。圖14展示了使用本文方法識別崩崗中LDA主題變化時,被識別為崩崗的DOM與DSM(圖14a、14c、14e、14g)和非崩崗的DOM與DSM(圖14b、14d、14f、15h)頻次最高的各4個樣例。其中,DOM上標注了DSM局部特征點,不難看出DSM局部特征點主要分布為高程變化復雜劇烈的區域。崩崗區域普遍分布著DSM局部特征點,再基于其梯度統計特征,就能較好的描述崩崗地形。非崩崗區中,圖14b為喬木區域,圖14d為喬木和建筑混合區域,圖14f為水域與耕地混合區域,圖14h為耕地區域,說明本文方法能將其他多種類型的區域都與崩崗區分開。但也會存在誤判,如圖15所示。

圖14 崩崗與非崩崗區域樣例Fig.14 Samples of Benggang and non-Benggang

圖15 誤判為崩崗頻次最高的4個區域Fig.15 The top 4 misclassifications to Benggang

傳統的崩崗研究專注于其發生、發育機理、監測和防控治理等方面,并沒有將崩崗識別作為一個獨立的科學問題進行研究,僅作為研究之前的一個操作步驟,往往采用當地詢問、現場尋找等群策群力的方式開展[4]。隨著亞米級高分辨率遙感影像和無人航測技術的普及,通過遙感影像進行崩崗的發現和調查成為了當前崩崗研究的熱點[8-12],但崩崗發現本質上依然靠人工完成。本文方法提出通過機器學習的方式高效完成崩崗自動識別。

在遙感領域,當前遙感影像檢索、分類以及識別等研究,多以高分辨率遙感平面影像為基礎,主要研究人工地物對象的識別,如本文試驗中使用的基于DOM局部特征融合的方法[16]和基于BoVW的方法、以及基于全局特征融合的方法等[15-19]。此類方法對自然地貌識別遷移效果不佳,對崩崗識別效果較差,不能直接使用。本文針對崩崗高程差異顯著的特點,提出結合DSM高程信息擴展遙感影像識別的方法,獲得了較好的崩崗識別效果,實現了遙感與崩崗學科研究的深度交叉。

同時,針對深度學習,本文也進行了以ResNet50網絡[31]為例的對比試驗。試驗結果表明無論是以DOM作為輸入還是以DOM+DSM簡單疊加作為輸入,ResNet50網絡都無法實現令人滿意的崩崗識別效果。前者印證了僅使用DOM無法較好的識別崩崗這種地貌特征,后者則說明即使有DOM和DSM的充分信息,沒有有效的融合策略,崩崗識別效果仍然較差,甚至可能產生負影響。還可能原因是ResNet50網絡預訓練參數是以海量自然圖像為基礎,對遙感影像具備一定適用性,但對于DSM不適合。因此,一方面是需要海量的崩崗遙感數據作為訓練樣本,另一方面是研究更好的DOM和DSM融合策略,是后期基于深度學習研究崩崗識別的2個關鍵點。

3.2 局限性與復雜性

雖然本文方法識別崩崗的查全率和查準率已比較高,但仍存在一些的誤判。圖15a~15d是被誤判為崩崗頻次非常高的 4個區域,誤判率分別為 92.53%、80.05%、62.69%、52.23%。它們的共同原因是在DOM上都有與崩崗相似的裸土和植被紋理結構,并且在DSM上都有植被或房屋產生的明顯高程變化特征。

本文方法流程較為復雜,各處理環節的參數多,都對結果有一定影響,比如視覺和地形特征的選擇和描述、各類特征詞匯表大小、LDA主題個數以及 SVM參數設置等等。本文試驗是在限定了大部分環節和參數后實施,僅針對詞匯表大小和LDA主題個數變化進行,已獲得較好的識別效果,如基于本框架,通過進一步優化調整各環節參數,將能獲得更好的效果。

試驗計算機配置為CPU i9 9900k,RAM 32GB,SSD 512GB,軟件環境為Matlab R2018a。本框架下詞匯表為1 500個、主題為40個時,各階段的運算時間統計如下:訓練集531個區域DOM的Harris-Affine和MSER提取和描述時間為187s,DSM的3DDP特征提取與描述為3 970 s,LDA訓練時間為13.25 s,SVM訓練時間為 1.24 s,測試集 208個區域 DOM 的Harris-Affine和MSER提取和描述時間為 68 s,DSM的3DDP特征提取與描述為1 536 s,LDA預測時間為0.27 s,SVM 預測時間為 0.05 s。其中,3DDP特征提取最為費時,主要因為算法中要迭代反復計算高程點到三角平面的距離,無法節省計算次數。

4 結 論

為了給大規模的崩崗調查、治理和崩崗侵蝕機理等研究提供研究對象和高效手段,本文提出了基于高分辨率數字正射影像圖(Digital Orthophoto Map,DOM)與數字表面模型(Digital Surface Model,DSM)局部特征潛在語義融合的崩崗自動識別方法。借鑒遙感影像場景分類識別思路,本文提出建立視覺-地形詞袋模型(BoV-TW)進行崩崗區域DOM和DSM局部特征的混合描述,再通過潛在狄利克雷分配(Latent Dirichlet Allocation,LDA)潛在語義分析融合形成低維度高層次語義表達,最后以支持向量機作為監督學習訓練分類器,實現崩崗的高精度快速自動識別。主要結論如下:

1)LDA主題個數變化時,本文方法總精度可保持在95%左右,崩崗查全率和查準率保持在80%以上,最高分別為97.22%和94.44%,與基于DOM局部特征融合的方法相比,總精度、崩崗查全率和查準率 3項指標分別提高了約12%、11%和32%,證明結合DSM局部特征后識別效果明顯提高。

2)視覺-地形詞袋詞匯表大小變化時,本文方法總精度一直在90%以上,最高為96.10%,崩崗查全率也基本在90%以上,最高為100%,崩崗查準率隨詞匯表大小的增加逐漸提升,最高為85.00%,與僅基于BoV-TW模型的方法相比,3項指標分別提高了約13%、12%和30%,證明運用LDA進行潛在語義分析實現多特征融合能大幅提高識別效果。

3)本文方法優于基于 ResNet50網絡以 DOM 和DOM+DSM 為數據源的 2種識別方法,印證了僅使用DOM無法較好的識別崩崗這種地貌特征,同時還說明沒有合適的特征提取和融合策略,DOM和DSM結合也無法提高崩崗識別效果。同時,該方法時間花費少,效率高,可行性強。

下一步工作將嘗試融合全局特征對DSM特征進行優化,并結合深度學習自編碼方法對更多類型和發育階段的崩崗自動識別進行研究。