基于深度學習目標檢測的可行駛區域分割

徐征宇 朱宗曉 周康 田微

摘 ?要:目前大多數的可行駛區域分割算法,是以網絡結構復雜化為代價換取像素級的精確分割。為了降低訓練出的網絡結構的復雜度,較為輕量、快速地實現可行駛區域分割,對基于目標檢測的可行駛區域分割方法進行了研究。該方法把可行駛區域的像素級標注轉換為目標檢測框標注,用目標檢測算法實現可行駛區域分割。實驗結果表明,目標檢測方法也能較為準確地對可行駛區域進行分割。

關鍵詞:目標檢測;可行駛區域分割;矩形覆蓋多邊形

中圖分類號:TP391.41 ? ? ?文獻標識碼:A 文章編號:2096-4706(2020)23-0106-03

Drivable Area Segmentation Based on Deep Learning Object Detection

XU Zhengyu,ZHU Zongxiao,ZHOU Kang,TIAN Wei

(Computer Science College of South-central University for Nationalities,Wuhan ?430074,China)

Abstract:At present,most of segmentation algorithms for drivable area are pixel level accurate segmentation at the cost of complex network structure. In order to reduce the complexity of the trained network structure,and realize the segmentation of the drivable area quickly and with a little calculation,this paper studies the segmentation ways of drivable area based on object detection. In this method,the pixel level labeling of the drivable area is transformed into the target detection box labeling,and the drivable area is segmented through the target detection algorithm. The experimental results show that the target detection method can also segment the drivable area more accurately.

Keywords:target detection;drivable area segmentation;rectangle overlay polygon

0 ?引 ?言

隨著計算機算力的不斷增強和深度學習的快速發展,基于深度學習的圖像分割可以達到像素級別的精確分割,即把每個像素點進行分類。但面向無人駕駛的行駛區域分割時,像素級的精確分割,本文認為是沒有必要的。人類在駕駛汽車時,不可能關注到每一個點,絕大多數進入視野的細節會被忽略,除非這個細節能在可行駛區域和非可行駛區域的相互轉換中發揮作用。基于人類在駕駛的過程中不可能關注到每一個點的特點,本文提出用目標檢測的方法去實現可行駛區域分割,即用若干目標檢測框去框出大致的可行駛區域,這樣就不需要對每一個像素點進行分類,既能降低網絡的復雜度,又能較快地實現可行駛區域的分割。

本文所研究的內容,其面向場景是無人駕駛的可靠環境感知。其感知內容主要包括兩個方面:一方面是行駛道路上的目標檢測,其包含車輛、行人及其他障礙物和交通燈、交通標志等檢測;另一方面是可行駛區域分割。本文主要針對可行駛區域分割進行研究,采用基于深度學習目標檢測的可行駛區域分割的設計思路,該研究是在田微老師和朱宗曉老師的指導下進行的,目前只是一個算法理論的實現,還沒有應用到實際的場景中。本文采用的可行駛區域分割方法是用目標檢測算法實現的,本人根據該思路,先實現像素級標注轉換為目標檢測框標注,該過程是一系列矩形框逼近覆蓋不規則多邊形的數學問題,需要編寫相關代碼,實現其轉換,為了較為準確地轉換標注,還根據BDD100K數據集的其他目標物的矩形框標注的長寬面積進行了統計分析,設計了兩種標注轉換方案。最后采用深度學習的目標檢測算法,進行訓練,得到訓練模型,然后進行測試,保存相關的測試結果數據,再編寫代碼,對這些數據進行處理,從而合成我們所需要的可行駛區域。

1 ?相關理論

本文采用了兩種基于深度學習的目標檢測算法:Faster R-CNN和YOLOv5。Faster R-CNN是兩階段目標檢測的代表算法。第一階段,產生region proposal,第二階段,對region proposal進行分類和位置修正。從最初的R-CNN,再到Fast R-CNN[1]的改進,最后發展為將特征抽取、候選區域提取、位置精修、分類都整合在一個網絡中的Faster R-CNN[2],其綜合性能有很大的提升。YOLOv5有四個網絡模型,本文采用的是YOLOv5s,其網絡結構分成了四個部分。輸入端:采用了Mosaic數據增強和自適應錨框計算,前者豐富了檢測目標物的背景,后者針對不同數據集,自動計算最合適的初始設定長寬的錨框;Backbone:使用CSPDarknet,從輸入圖像中提取豐富的信息特征;Neck:主要用于生成特征金字塔;Prediction:YOLOv5采用GIOU_Loss做Bounding box的損失函數,其對常用的目標檢測算法都具體有相當的提升作用。

圖像分割指根據灰度、彩色、空間紋理、幾何形狀等特征把圖像劃分成若干個互不相交的區域,使得這些特征在同一區域內表現出一致性或相似性,而在不同區域間表現出明顯的不同[3]。傳統的圖像分割方法有基于閾值的分割方法、基于區域的圖像分割方法[4]、基于邊緣檢測的分割方法等[5]。隨著計算力的不斷增強以及深度學習的快速發展,基于深度學習的分割方法取得了較于傳統的分割方法更好的效果。He等在2017年提出的Mask R-CNN算法,實現了目標物的像素級分割[6]。

2 ?實驗方案

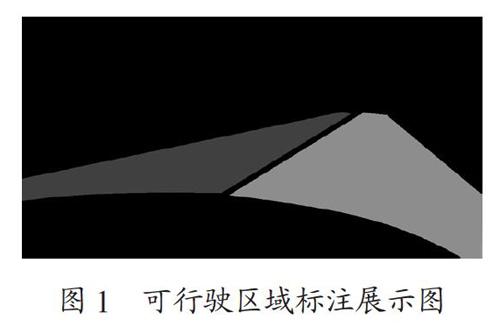

可行駛區域分割的研究,大多采用的是像素級的語義分割,本文使用的BDD100K數據集的標簽文件亦是如此,如圖1所示。其標簽文件把可行駛區域分為了兩類:直接可行駛區域和間接可行駛區域。直接可行駛區域標為紅色,表示此路段是當前車輛駕駛時的優先選擇,是行駛時最合理的路段區域。間接可行駛區域標為藍色,表明當前車輛可以在此路段內行駛,但必須謹慎,因為此路段的優先級可能屬于其他車輛。

為了用目標檢測的方法實現可行駛區域的分割,首要的問題是如何把像素級標注轉換為目標檢測框的標注。對于該問題,采用微積分的思想,用若干小方框框住像素級的可行駛區域,盡可能地把可行駛區域的像素點框進來,使其標注準確。當轉換成功后,投入到深度學習網絡中訓練測試,然后得到的也將會是一系列小方框框住的可行駛區域,再把這一系列小方框進行合并,重新合成我們需要的可行駛區域。

本文采用Faster R-CNN和YOLOv5兩種目標檢測算法,實現可行駛區域的分割。

2.1 ?區域像素級標注轉換為目標檢測框標注的方法

區域像素級標注轉換為目標檢測框標注,其基本思想就是用一系列的小矩形框去逼近覆蓋不規則多邊形區域,如圖2所示。

首先確定所采矩形框為56。在多邊形區域邊界處找一些點,向周圍的領域空間擴展到56的長度,然后以此為寬,再畫此矩形的長,其長沒有限制長度,只要不超過多邊形另一邊的邊界即可。如此橫向畫一個矩形框,再縱向畫一個矩形框,直到完全覆蓋可行駛區域多邊形。最后把所有畫出來的矩形框坐標記錄下來。再按照Faster R-CNN的數據集格式和YOLOv5的數據集格式進行相應的數據格式轉換。

轉換好的數據標簽投入到神經網絡訓練之前,我們需要把這些轉換好的數據標簽與原始標簽比較,判斷是否準確。因此,我們還需要把這些轉換好的目標檢測框的數據集標簽重新再合成區域,如圖3所示。

再用mIOU的指標進行打分,分數越高,表明轉換的目標檢測框的標注越準確。只有轉換的標注越準確,我們之后用目標檢測方法實現的可行駛區域分割才能越準確。

為了提高可行駛區域分割的精確度,本文除了以上的第一種以寬為56,長不作限制的矩形框覆蓋多邊形的方案外,還設計了第二種多個小矩形框去覆蓋多邊形的方案,其基本思想與第一種方案一樣,只是矩形框寬限制為32,長限制為512。第二種方案,因為劃分得更加細致,其與原始標注的比較會更為準確,其具體的數據會在下文的實驗結果中展示。

2.2 ?訓練檢測得到的一系列矩形框進行區域合成

可行駛區域原始像素級標注全部成功地轉換成目標檢測框標注后,再把這些目標檢測框標注按照兩類目標物:直接可行駛區域和間接可行駛區域,轉換成Faster R-CNN的數據集格式和YOLOv5的數據集格式。分別投入兩種深度學習的目標檢測神經網絡中進行訓練測試,無論哪一種目標檢測方法,最后的測試結果都會在直接可行駛區域和間接可行駛區域得到一系列檢測的矩形方框,如圖4所示。

再把這一系列小方框分別按照直接可行駛區域矩形框和間接可行駛區域矩形框進行紅色和藍色的填充,從而實現可行駛區域的合成,如圖5所示。

3 ?實驗結果與分析

3.1 ?實驗設置

本實驗采用兩種基于深度學習的目標檢測方法:Faster R-CNN和YOLOv5。分別對兩種方案的原始區域像素級標注轉換為目標檢測框的標注進行訓練測試。

兩種標注轉換方案分別是:第一種,大多數寬為56,長不作限制的矩形框區域標注;第二種,大多數寬為32,長為512的矩形框區域標注。

首先,對轉換好的這兩種方案的區域目標檢測框的標注與原始標注進行比較,對比mIOU得分,看其標注得準不準,轉換后的標注越準確,越有利于后續的訓練檢測。我們需要根據轉換好的矩形框的坐標位置數據,按照區域合成的方法,進行區域合成,然后與原始標注比較并打分。對這兩種區域標注轉換的方案進行實驗數據結果的對比分析。

再把這兩種方案轉換的區域標注,每一種也都分別用Faster R-CNN和YOLOv5進行訓練測試,也就是總共進行四個實驗。

最后再把這四個實驗結果的一系列小方框的坐標位置數據,分別按照區域合成的方法進行合成,得到四個不同實驗的區域合成結果,再與原始區域標注進行比較打分,使用的指標是IOU,然后對每個實驗結果進行分析,兩兩進行比較。

3.2 ?實驗結果與分析

本實驗先對兩種方案轉化的目標檢測框標注,與原始標注進行比較;再對四個實驗的區域合成的結果,與原始標注進行比較,其評價指標為mIOU,如下所示:

(1)兩種方案的原始區域像素級標注轉換為目標檢測框標注的準確性以及對比,如表1所示。

第一種方案相對于原始標注的準確度,使用mIOU進行評價,其值為82.9%,從數值看來準確度還是較為準確的。此種方案只限定了矩形框的寬為56,沒限定矩形框的長,覆蓋的多邊形區域相對來說面積較大,總體數量也就較少,覆蓋的精確度也就較低。第二種方案的矩形框的寬限定為32,長限定為512,與第一種方案相比,大多數矩形框面積較小,數量增多,總共多了2 258 230個矩形框,覆蓋的精確度也相對較高,該方案的mIOU值為87.4%,相比第一種方案提升了4.5%。

(2)將這四種實驗得到的一系列小方框進行區域合成,再把這四個結果按照mIOU指標,與原始像素級標注進行比較,其結果如表2所示。

表2展示了Faster R-CNN和YOLOv5兩種目標檢測算中分別在兩種方案下的實驗測試結果。在第一種方案下,可以看出Faster R-CNN的精確度更好,在Faster R-CNN中的mIOU值比YOLOv5的mIOU值高3.6%。但在第二種方案下,YOLOv5的效果更好一點,其mIOU值比Faster R-CNN高1.3%。Faster R-CNN在兩種方案下的實驗結果對比下,第二種方案確實能夠提高可行駛區域分割評價指標mIOU值,提高了2.2%,可見第二種方案更有利于可行駛區域的分割。YOLOv5在兩種方案下的實驗結果對比下,也證明了第二種方案確實有效的提高了可行駛區域分割的準確率,其mIOU值相比第一種方案提高了7.1%,相比Faster R-CNN提升更明顯。

4 ?結 ?論

本文提出了一種基于深度學習目標檢測的可行駛區域分割方法。首先把BDD100K像素級區域標注轉換為目標檢測框標注。為了提高可行駛區域分割的精確度,設計了兩種不同方案的標注轉換。每一種方案再分別用Faster R-CNN和YOLOv5訓練模型,將得到結果進行區域合成,并進行測試。結果表明,本文該出的第二種方案的標注轉換,確實有效的提高了可行駛區域分割的精確度,文中四個實驗的結果也表明了目標檢測的方法能夠較為準確地對可行駛區域進行識別分割。

參考文獻:

[1] GIRSHICK R. Fast R-CNN [C]//2015 IEEE International Conference on Computer Vision(ICCV).Santiago:IEEE,2015:1440-1448.

[2] REN S Q,HE K M,GIRSHICK R,et al. Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[3] 黃鵬,鄭淇,梁超.圖像分割方法綜述 [J].武漢大學學報(理學版),2020,66(6):519-531.

[4] 王媛媛.圖像區域分割算法綜述及比較 [J].產業與科技論壇,2019,18(13):54-55.

[5] 龐明明,安建成.融合模糊LBP和Canny邊緣的圖像分割 [J].計算機工程與設計,2019,40(12):3533-3537.

[6] HE K M,GKIOXARI G,PIOTR D,et al. Mask R-CNN [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,42(2):386-397.

作者簡介:徐征宇(1995—),男,漢族,重慶人,碩士研究生在讀,研究方向:計算機視覺;通訊作者:田微(1979—),男,漢族,湖北荊州人,教授,博士,研究方向:計算機系統集成。