深度遷移學習在紫莖澤蘭檢測中的應用①

蔣 毅,耿宇鵬,張俊華,王嘉慶,宋穎超

1(云南大學 信息學院,昆明 650500)

2(云南大學 生態學與環境學院,昆明 650091)

紫莖澤蘭作為一種世界性惡性雜草,在20世紀40年代從中緬邊境傳入中國[1],大約以每年10-30 公里的速度向北和東擴散.紫莖澤蘭的入侵性和生態適應性極其強大,能通過化感物質的釋放抑制周圍其它植物的生長,快速發展成為單優群落[2].排斥群落里其它植物生長與演替,破壞生物多樣性,影響林業景觀,危害畜牧業發展,造成巨大的經濟損失[3].紫莖澤蘭入侵牧地3年便能夠使牧草喪失放牧能力,家畜誤食容易導致其中毒死亡[4].紫莖澤蘭在我國的入侵形式十分嚴峻,需采取有效的防治措施來減緩甚至消除紫莖澤蘭的入侵.現在常用的防治方法有人工防除、化學防除和生物防除,紫莖澤蘭檢測作為這些防治方法的重要階段,而紫莖澤蘭檢測作為防治效果反饋的重要階段,紫莖澤蘭檢測的有效性顯得至關重要.

復雜背景下的紫莖澤蘭檢測屬于目標檢測問題,傳統目標檢測方法的滑動窗口區域選擇策略沒有針對性,時間復雜度高,魯棒性差,精度低.基于深度學習的目標檢測方法能夠自動提取特征從而有效解決特征提取模板針對性不強的問題[5],已經獲得越來越多學者的青睞.第一個基于深度學習的目標檢測算法R-CNN[6]被Girshick 等提出,在VOC07 數據集上平均精度的均值(mean Average Precision,mAP)由原來的34.3%提升到66%.Girshick 和Ren 等分別提出了Fast R-CNN[7]和Faster R-CNN[8]算法,mAP 值提高大約6%,檢測系統的運行速度高達5 fps,相較于R-CNN 提高了10 倍之多.隨后,Liu 等提出了SSD[9]檢測算法,Redmon 等提出了YOLO 的一系列算法:YOLOv1[10]、YOLOv2[11]、YOLOv3[12].其中,YOLOv3 檢測效果更好,在COCO數據集上mAP 為57.9%,時間為51 ms,相較于其它目標檢測算法,在保證精度的同時具有更快的速度.

YOLOv3 的高效性,得到越來越多學者的喜愛,并將其應用到各個領域.如李睿等[13]將其用于手腕骨骨齡評價;李斌等[14]將其用于無人機檢測;林俊等[15]將其用于安全帽檢測等,由此可見YOLOv3 算法的受關注程度.

遷移學習是一種運用已有知識對不同但相似的領域問題進行求解的機器學習方法[16],與傳統的機器學習方法相比,遷移學習能解決訓練樣本不足問題、滿足數據集測試集服從不同分布情況、將訓練得到的模型在不同的任務之間進行遷移和共享[17].遷移學習與深度學習的結合,保證了深度學習模型精度,同時還發揮了遷移學習快速分類的優勢,且降低了訓練樣本和硬件設備的要求.近年來深度遷移學習方法已經應用到自然語言和圖像處理等方面,并取得了不錯的成果.

本文采用基于YOLOv3 的遷移學習方法將深度學習模型YOLOv3 遷移到紫莖澤蘭數據上,對遷移的YOLOv3 模型微調,并更新損失函數中各類損失的權重.實驗結果表明,在紫莖澤蘭檢測任務中,測試的平均精度(Average precision,AP)相較于YOLOv3 提高了17%,能夠滿足復雜條件下的紫莖澤蘭檢測任務.

1 YOLOv3 模型

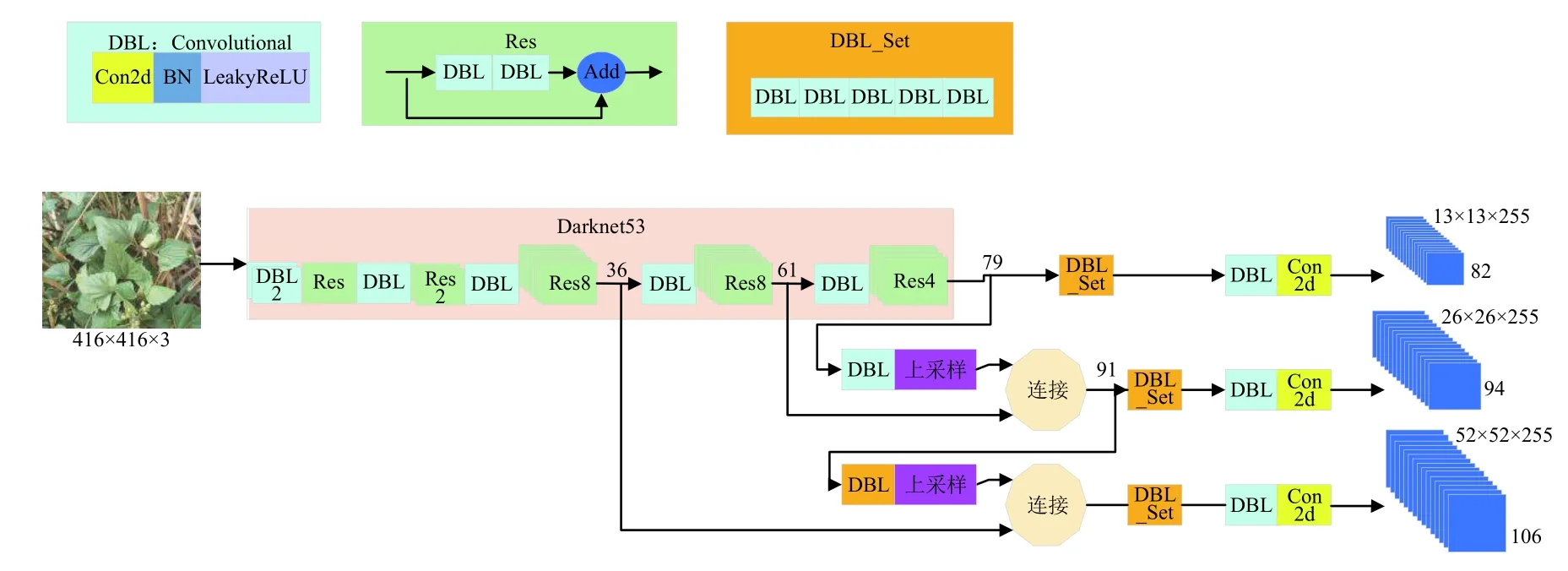

YOLOv3 使用的網絡結構為Darknet53,一共有53 個卷積層.YOLOv3 的網絡結構如圖1所示.

圖1 YOLOv3 網絡結構圖

Darknet53 網絡中包含大量3×3 和1×1 的卷積層,這些卷積層通過取代原來的池化層的方式來避免特征信息的丟失.除此外,YOLOv3 根據殘差學習的思想,在網絡中加入了大量的殘差塊,避免網絡層數加深帶來的在訓練過程中產生的梯度爆炸現象.YOLOv3 網絡最后一層采用多個獨立的邏輯斯諦回歸分類器進行分類,實現多目標分類問題.

在卷積神經網絡中,淺層的特征具有豐富的細節和定位信息,如紋理、顏色、形狀等,深層的特征具有豐富的語義信息.對于位置預測需要淺層特征信息,而類別預測需要深層特征信息,YOLOv3 采用多個尺度特征融合的思想來進行預測,對特征圖進行降采樣和上采樣操作,實現多尺度特征圖的位置和類別預測,提高目標檢測準確率.多尺度特征預測過程為:輸入一張圖片,經過一系列卷積操作,卷積網絡在79 層后,經過卷積操作得到一種尺度的預測結果,用于檢測相對輸入圖像32 倍下采樣的特征圖.為了實現細粒度的預測,第79 層的特征圖通過卷積作上采樣,然后與61 層特征圖融合,得到第91 層較細粒度的特征圖,同樣經過幾次卷積操作后得到相對輸入圖像16 倍下采樣的特征圖.最后,第91 層特征圖通過卷積作上采樣,并與第36 層特征圖融合,得到相對輸入圖像8 倍下采樣的特征圖.這3 種融合得到的特征圖進行卷積操作后用于位置和類別的預測.

YOLOv3 算法通過K 均值聚類方法對數據集中的目標框進行聚類,得到9 種不同大小的錨點框,然后將他們均分到3 種尺度的特征圖上,用于不同尺度的特征圖的提取.

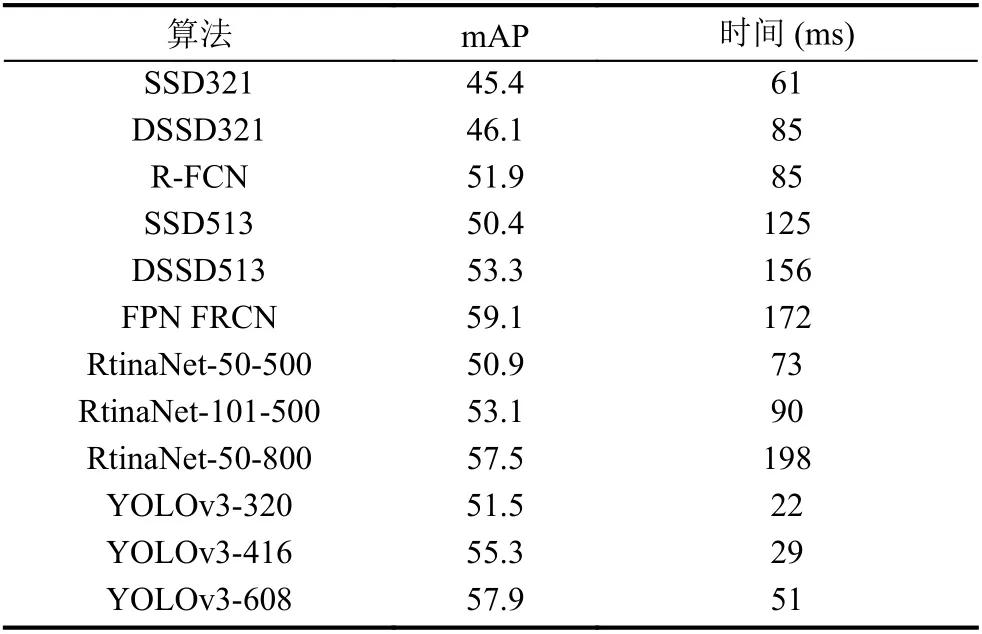

YOLOv3 的網絡結構、聚類方法以及多尺度特征預測使其在檢測準確度和檢測速度上取得較好的效果,且相較于其他的目標檢測方法效果更佳,在COCO 數據集下與其他網絡的性能對比如表1所示.

表1 YOLOv3 與其他網絡性能對比

2 基于YOLOv3 的改進

2.1 基于YOLOv3 的模型遷移

遷移學習方法能夠實現相似或相關領域間的復用和遷移,使傳統的零基礎學習變成有積累學習,能夠降低模型訓練開銷,提高深度學習效果.本文提出的基于YOLOv3 的遷移學習方法屬于基于網絡的深度遷移學習方法,將深度學習模型YOLOv3 遷移到紫莖澤蘭數據集上,對遷移學習訓練模型微調,采用K 均值聚類算法進行維度聚類,確定目標框參數.通過維度聚類獲得的9 組先驗框維度分別為(100,108),(144,141),(162,209),(212,164),(242,237),(260,335),(338,271),(373,378),(399,413).將這9 組先驗框維度分別均分到3 種尺度的特征圖上,分配上,13×13 特征圖上有最大的感受野,應用較大的先驗框,中等特征圖應用中等先驗框,較大的52×52 特征圖上應用較小的先驗框,此分配能夠獲取更多的目標邊緣信息.

2.2 損失函數改進

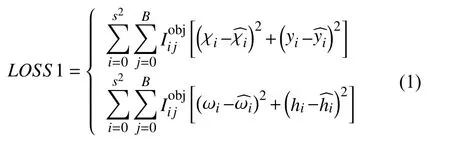

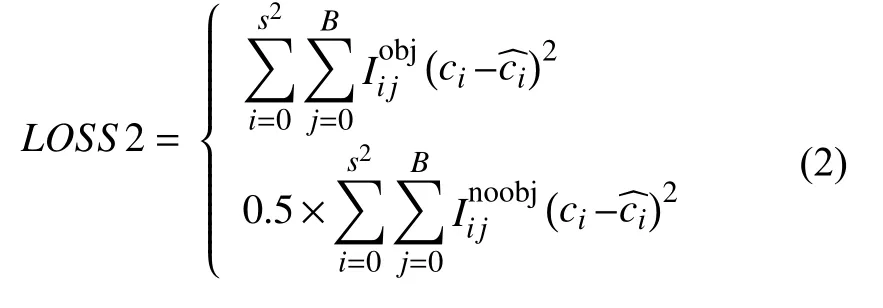

損失函數是模型預測值與真實值之間的誤差,是決定網絡效果的重要參數之一.YOLOv3 的損失函數包括邊界框損失、置信度損失和分類損失,損失值越小說明模型的魯棒性越好,損失函數如式(1)~式(3).

(1)目標框損失

(2)置信度損失

(3)分類損失

式中,s為圖像的劃分系數,n為每個網絡中所預測的邊界框個數,C為總分類數,p為類別概率,c=0,1,···,C為類別序號,xi、yi分別為第i個格中的邊界框中心點橫、縱坐標,wi、hi分別為第i個格中的邊界框的寬度和高度.

YOLOv3 損失函數中的3 類損失每一類損失對網絡的影響均不同,為尋求最優的損失函數來增強YOLOv3 遷移學習方法在紫莖澤蘭數據集上的適應性,在訓練過程中需要不斷改變損失函數中各類損失的權重,并通過測試的AP 值來驗證邊界框損失、置信度損失和分類損失對紫莖澤蘭數據集的影響,從而找到最佳的損失函數.

3 實驗

3.1 實驗數據

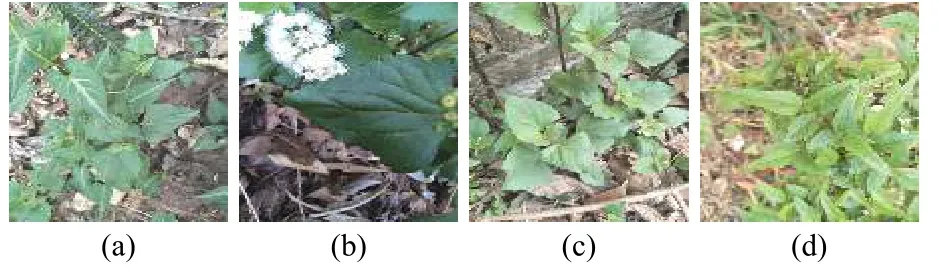

實驗數據采集地在云南,圖片因拍攝角度、時間、地點不同而具有不同的角度、不同的曝光率和背景,屬于一類復雜背景的圖像數據集,這樣的數據集用來訓練模型更具有代表性,魯棒性更強.為避免錯誤、重復和模糊圖片,對數據集進行篩選,根據VOC 和COCO 數據集的圖像標注方法使用Lableimg 工具對圖像進行人工標注,產生訓練所需要的XML 文件.本實驗訓練集有11 931 張,按照9:1 的比例分成訓練集和驗證集;測試集有670 張,為了驗證方法的有效性,測試集里邊除了復雜背景的紫莖澤蘭圖片外,還有一些其它的植物圖片.部分訓練集和測試集圖片如圖2、圖3.

圖2 部分訓練集樣本

圖3 部分測試集樣本

圖2中4 幅子圖均為紫莖澤蘭圖像,圖3(b)、圖3(c)為紫莖澤蘭圖像,圖3(a)和圖3(d)為其它種類的植物葉片圖像.

3.2 評價指標

紫莖澤蘭的檢測精度越高,誤檢和漏檢的可能性越小,且檢測精度能夠直觀地看出網絡檢測結果的有效性,紫莖澤蘭屬于單目標檢測,AP 作為單類目標檢測算法的標準評價指標,能夠驗證改進的YOLOv3 模型的有效性和可靠性.AP 的定義為:以紫莖澤蘭的召回率為橫坐標,準確率為縱坐標,繪制出一條P-R 曲線,曲線下的面積即為AP.準確率和召回率的定義如下:

準確率:

召回率:

在式(4)和式(5)中,TP代表識別出紫莖澤蘭的數量,FP代表將其它植物識別成紫莖澤蘭的數量,FN則代表沒有識別出紫莖澤蘭的數量.

3.3 實驗結果分析

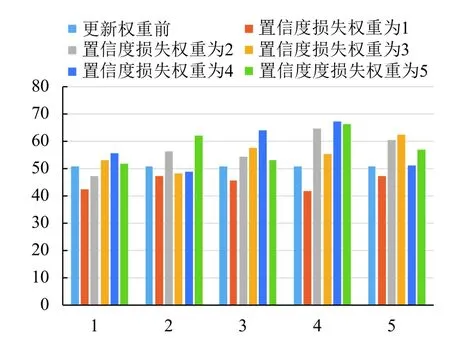

損失函數作為網絡模型的重要組成部分,對網絡的性能具有巨大的影響,本文為了增強基于YOLOv3的遷移模型的適應性,對YOLOv3 網絡的損失函數做出調整,主要對損失函數的各類損失權重進行更新,更新各類損失權重得到的測試精度如圖4所示.

圖4 更新權重后的測試精度

圖4中,圖中橫坐標中的5 個值分別代表分類損失的權重,縱坐標表示AP.橫坐標數字1 所在的第一個縱列表示固定置信度損失權重和分類損失權重,不斷增大坐標框損失權重,從中可以看出,增大坐標框損失權重對測試精度的影響較小,最高增長量不到5%;從整體上看,當逐漸增大置信度損失權重和分類損失權重時,測試精度呈現出上升趨勢,當置信度損失權重和分類損失權重均為均為4 時測試精度達到了最大值67.22%,當兩者權重繼續增大時測試精度開始呈現出下降趨勢.通過對比分析可得坐標框損失、置信度損失、分類損失的權重分別為1、4、4 倍.

以誤檢率(FP)和識別出的紫莖澤蘭個數(TP)作為評價指標,實驗結果如表2所示.

紫莖澤蘭測試集圖片標注目標一共有2033 個,由表2可以看出,本文所提出的基于YOLOv3 的遷移學習方法相較于Faster R-CNN,無論是誤檢個數還是正確識別個數都要比Faster R-CNN 算法好得多,更新損失權重后的誤檢個數雖然略有提高,但是正確識別出的個數大大增加,說明了基于YOLOv3 的遷移學習算法以及權重更新在紫莖澤蘭數據集檢測上的有效性.

表2 TP、FP對比

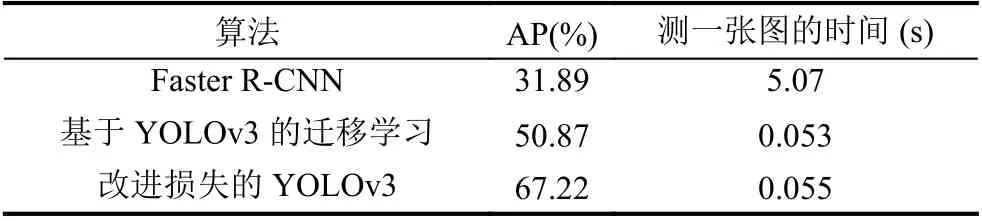

以AP 和檢測一張圖片的時間作為檢測效果評價指標,結果如表3所示.

表3 檢測精度對比

從實驗結果可以看出,YOLOv3 目標檢測算法的魯棒性更好,使用范圍更廣.改進的YOLOv3 算法的AP 值最高,且檢測速度比Faster R-CNN 算法快約90 倍.張帥等[18]使用分層卷積深度學習系統對植物葉片進行識別,其單一背景下的圖片識別率高達91.11%,但復雜背景下的圖片識別率為34.38%.由此可見,在紫莖澤蘭這一類復雜背景下的數據集下,基于YOLOv3的遷移模型能夠同時兼顧檢測準確率和檢測速度,能夠較好的完成紫莖澤蘭的檢測任務.

4 結論與展望

紫莖澤蘭入侵已嚴重影響我國生態環境的多樣性以及農林業畜牧業的發展,現已采取了很多防治措施,紫莖澤蘭檢測作為防治措施的關鍵步驟,實現紫莖澤蘭的有效檢測至關重要.而本文提出的基于YOLOv3模型的遷移學習方法的紫莖澤蘭檢測,是目標檢測算法的一種拓展應用,在復雜背景下AP 值相比原YOLOv3模型提高了17%,已基本能夠滿足紫莖澤蘭檢測任務.