基于兩層BiLSTM的問題回答技術研究

滕柯

摘要:針對答案選擇任務,在基于注意力機制的雙向長短時記憶(BiLSTM)的基礎上,探索了兩層BiLSTM網絡的應用。我們在2016NLPCC DBQA任務數據集上進行實驗,此模型MRR可以達到75.51%。兩層網絡的效果優于單層網絡,證明了兩層網絡的有效性。

關鍵詞:答案選擇;注意力機制;多層網絡;雙向長短時記憶網絡

中圖分類號:TP311 文獻標識碼:A 文章編號:1007-9416(2020)03-0095-02

0 引言

互聯網時代的快速發展,每天都有大量的互聯網數據產生與傳遞。怎么高效且精準地從大量且雜亂無章的數據中查找到回答用戶所提出問題的信息成為如今研究的熱點。自動問答系統的便利之處在于根據用戶所提出的問題從大量數據中反饋最為匹配的答案。答案選擇任務是自動問答系統中的重要組成部分。近年來,深度學習技術發展迅速,其在自然語言處理領域的運用也十分廣泛。神經網絡的出現簡化了答案選擇任務初始階段的特征抽取環節,使得答案選擇任務不再需要人工抽取特征。循環神經網絡(RNN)是一種專門用來處理序列的神經網絡,因此其非常適合用于文本任務。不過因為可能會導致梯度消失和梯度爆炸等問題,研究人員對其結構進行改進提出了長短時記憶網絡(LSTM)[1]。同時,Melamud[2]發現高層的LSTM的輸出可以更好的表示單詞的含義,綜合多層的信息效果可能會很好。

面對中文答案選擇任務,此前很多研究都是基于單層BiLSTM網絡的答案選擇模型,使用單層BiLSTM提取到的都是表層的特征,為了能夠到提取更深層的特征,我們探索使用兩層神經網絡來進行特征提取。本文搭建了基于注意力機制的兩層雙向長短時記憶網絡的答案選擇模型,探索了兩層BiLSTM對于特征提取的優勢,并取得了較好的實驗效果。

1 模型構建

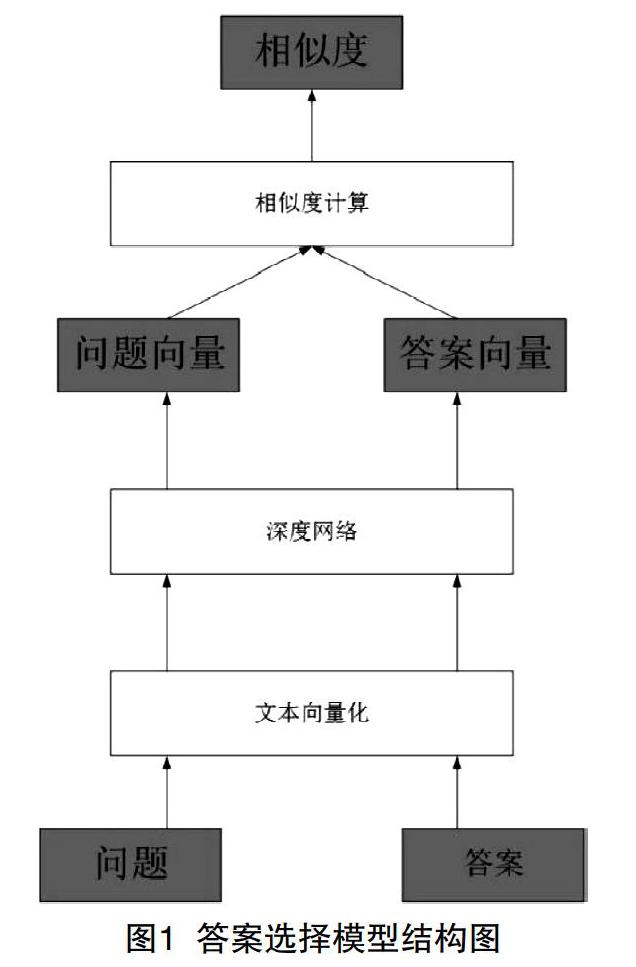

本模型一共分為三個模塊:向量化模塊、深度網絡模塊以及相似度評分模塊。模型結構圖如圖1所示。

向量化模塊:本任務的源數據都是文本形式,而深度網絡是處理不了文本的,在把源數據送入神經網絡之前,我們需要把問題和答案文本轉化為向量形式,且意思相近的詞需要被映射到向量空間相近的位置。在本模型中,我們所用的向量是用Word2Vec模型下的Skip-Gram模式訓練得到的,訓練語料使用的是中文維基百科。

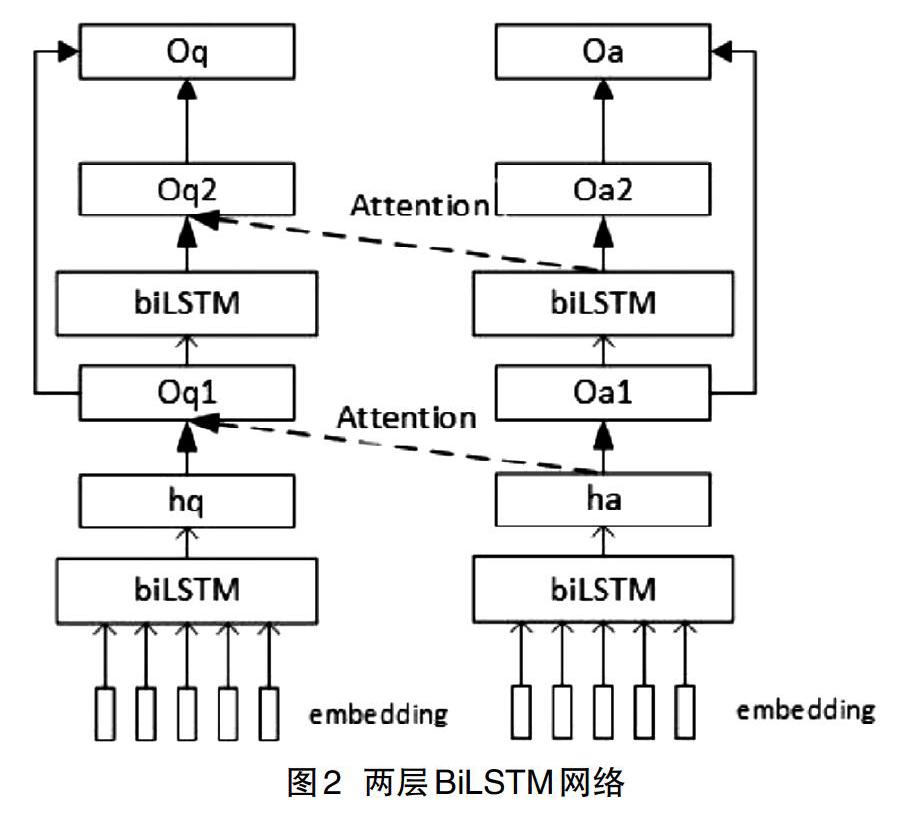

深度網絡模塊:此模塊的輸入時向量化模塊的輸出也就是文本的向量表示。我們將文本向量送入深度網絡中,通過網絡提取深層語義信息,得到問題和答案的突出特征,獲得特征向量。在本模型中,深度網絡模塊指的是兩層雙向長短時記憶網絡的組合,具體結構如圖2所示。

特征向量的公式如下:

Oq=Oq1*0.8+Oq2*0.2

Oa=Oa1*0.8+Oa2*0.2

相似度評分模塊:本模塊的輸入是深度網絡模塊的輸出,我們將深度網絡輸出的特征向量Oq和Oa進行相似度匹配,衡量兩個文本之間的相似性。本論文采用的相似度度量算法是余弦相似度。公式如下:

score(q,a)=cosine(Oq,Oa)=

socre(q,a)是問題和答案的語義相似度評分,Oq和Oa代表的是問題和答案的特征向量。

在模型進行訓練的時候我們還需要選擇損失函數,在本模型中我們選擇鉸鏈損失函數來進行訓練優化,具體公式如下:

L=max(0,M-cosine(Oq,Oa+)+cosine(Oq,Oa-))

其中,Oq表示問題向量,Oa+表示正確答案的向量,Oa-表示錯誤答案的向量。M是一個是為了優化目標函數而設定的常數。

2 模型參數

經過實驗,損失函數中的常數M我們設為0.1。雙向長短時記憶網絡中的隱藏層單元數我們選擇的是300。詞向量的維度我們設為50,句子長度設為100。深度學習網絡的學習率決定著損失函數能否收斂到局部最小值以及何時收斂到最小值。當學習率過小時,模型收斂的非常慢。當學習率過大時,可能無法收斂。因此,一個合適的學習率可以使得模型可以在合適的時間內收斂到局部最小值。我們發現設置學習率設置為0.2實驗效果最好。

3 實驗

在2016 NLPCC DBQA數據集上,我們對改進的答案選擇模型進行了評估,選用評測指標MRR。單層BiLSTM模型ACC為75.12%,而使用我們改進的兩層BiLSTM模型效果可以達到75.51%,驗證了模型改進的可行性和有效性。

4 結語

我們在本文中探索了兩層biLSTM網絡在答案選擇任務中的應用。實驗采用公開數據集以及常用評價標準,加強了實驗的說服力。通過實驗效果對比,驗證了兩層網絡在特征提取時的有效性。

參考文獻

[1] Hochreiter S,Schmidhuber J.Long Short-Term Memory[J]. Neural Computation,1997,9(8):1735-1780.

[2] Melamud O,Goldberger J,Dagan I.context2vec:Learning generic context embedding with bidirectional lstm[C].Proceedings of The 20th SIGNLL Conference on Computational Natural Language Learning,2016:51-61.

Abstract:For the answer selection task, the application of multi-layer network is explored on the basis of BiLSTM. We conducted experiments on the 2016NLPCC DBQA task data set, and the MRR of this model can reach 75.51%. The effect of multi-layer network is better than that of single-layer network, which proves the effectiveness of multi-layer network.

Key words:answer slection; attention; two layer network; BiLSTM