一種基于多尺度卷積神經網絡和分類統計的圖像去霧霾方法

齊永鋒,李占華

(西北師范大學 計算機科學與工程學院,甘肅 蘭州730070)

0 引言

霧霾中的懸浮顆粒具有散射和吸收的作用,使得室外圖像呈現出較低的對比度和有限的可見性,從而導致在霧霾天采集到的圖像質量較低,限制了圖像在智能識別、目標監控、目標追蹤等方面的應用。為使計算機系統能更好地識別和提取相關的圖像特征,去霧霾技術成為計算機視覺領域的研究熱點[1-5]。

目前圖像去霧霾的方法大致分為兩種:基于自適應對比度增強的方法[6-7]和基于透射率估計的方法[8-13]。前一種方法又分為全局增強的方法和局部化增強的方法,其中全局化增強的方法包括全局直方圖均衡化[14]、Retinex[15]等。而局部化增強的方法包括局部直方圖均衡化[16]、局部對比度增強方法[17]等。自適應對比度增強的方法雖然可以排除圖像中的部分干擾信息,但未對霧霾天圖像的成像原理進行分析,只是通過增強對比度去除霧霾,因而對霧霾嚴重的區域無法特殊處理。透射率估計的方法依據大氣散射模型,從光學成像的本質上去除霧霾,通過圖像退化基理和先驗知識恢復無霧霾圖像,去霧霾效果較好,因而得到了廣泛的研究和應用。根據圖像先驗知識估計大氣透射率,例如暗通道先驗(dark channel prior,DCP)方法[8],利用先驗知識初步估計大氣透射率,再用軟摳圖細化透射率,最終根據大氣光物理散射模型恢復無霧霾的圖像。該方法假設在清晰圖像中的暗通道值接近于零,然而當場景中的物體與大氣光相似時該假設并不成立,同時由于軟摳圖計算復雜,因此該算法復雜度高、耗時大。

基于大氣散射模型的方法由于估計透射率成本較高,Tang等人[18]將機器學習算法應用到去霧霾算法中,以各種先驗特征為輸入,通過隨機森林模型估計透射率,從而降低透射率的估計成本,但該方法對霧度分布不均勻的圖像去霧霾效果并不是很理想,且存在明亮區域內去除霧霾時顏色被過度增強的問題。Meng等人[19]應用透射函數固有的邊界約束,將該約束與加權L1范數的上下文正則化相結合,估計圖像的透射率,該方法往往產生銳利的邊緣和高度對比的顏色。Cai等人[20]以卷積神經網絡(convolutional neural networks,CNN)架構為基礎,提出可訓練的端到端系統進行透射率的估計,根據大氣散射模型從清晰圖像生成霧霾圖像的數據庫,該方法通過大氣散射模型的逆運算計算清晰圖像,去霧霾效果會受到模型其它參數的影響。

Ren等人[21]提出了多尺度卷積神經網絡(multi-scale convolutional neural network,MSCNN)估計大氣透射率,該方法在真實霧霾圖像中的主觀評估結果較好,但合成室內圖像的峰值信噪比(peak signal to noise ratio,PSNR)和結構相似性(structural similarity index,SSIM)結果較低,其在場景識別中對天空、白云和明亮區域的識別性能也較低。針對以上算法的不足,本文提出了一種新的改進算法。在多尺度卷積神經網絡模型中將粗尺度網絡估計的透射率的輸出作為附加特征圖傳遞到精細尺度網絡后,通過分類統計的方式確定明亮區域的像素值,該統計方法實現了像素的運算,不僅減弱了陰影的影響而且避免了明亮區域被過度增強的現象,并進一步采用高斯濾波器提高圖像質量,通過平滑所求的場景輻射度得到最終無霧霾圖像。

1 基本理論

1.1 大氣散射模型

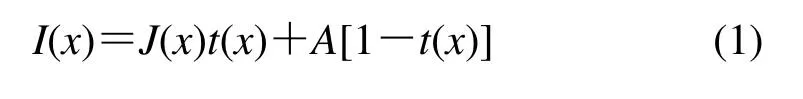

圖像去霧霾算法中廣泛使用的退化模型是McCartney等人[22]提出的大氣散射模型,其表達如式(1)所示:

式中:I(x)和J(x)分別表示為觀察到的霧霾圖像和無霧霾圖像的場景輻射度;A表示全球大氣光;t(x)是場景的透射率,即光線透過媒介透射到視覺系統沒有被散射的部分,t(x)表示為:

式中:β是大氣中的介質消光系數;d(x)是場景深度。由于給定的霧霾圖像存在多種解決方案,顯然這個問題是病態的。若能直接得到圖像大氣透射率t(x)和全球大氣光A,那么在霧霾圖像已知的情況下,根據式(1)恢復原始無霧霾圖像。為獲得大氣透射率t(x),本文結合多尺度卷積神經網絡和分類統計的方法估計大氣透射率t(x),先用多尺度卷積神經網絡進行t(x)值的初步計算,再對所計算的t(x)值進行分類統計。

1.2 多尺度卷積神經網絡的模型體系結構

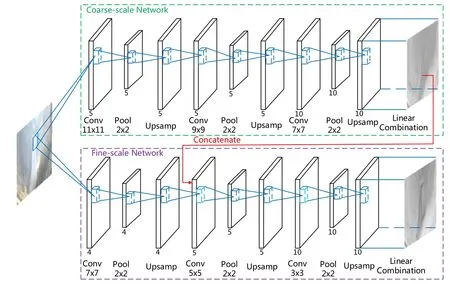

為實現圖像透射率t(x)的初步估計,采用了多尺度卷積神經網絡模型[23],該模型分為2部分:粗尺度網絡和精細尺度網絡。

多尺度卷積神經網絡模型如圖1所示。一個粗尺度的網絡首先對透射率進行整體的估計,然后通過一個精細的網絡在局部區域內對其進行修改。這兩個組成部分都運用原始霧霾圖像作為輸入。此外,粗尺度網絡的輸出作為附加特征圖傳遞到精細尺度網絡,通過這種方式,精細尺度網絡能夠細化粗尺度網絡。

1.2.1 粗尺度網絡

粗尺度網絡的目標是用場景的全局視圖預測圖像的整體透射率,粗尺度網絡由4部分組成:卷積,最大池化,上采樣,線性組合。

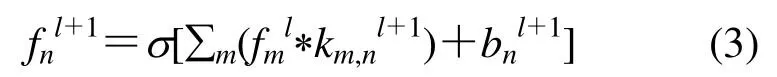

卷積:該模型將RGB圖像作為輸入,卷積層由與輸入特征圖卷積的濾波器組組成,每個卷積層表示為:

式中:fml和fnl+1分別表示為當前層l的特征圖到下一層l+1的特征圖;k表示卷積核,索引(m,n)表示從當前層第m個特征映射到下一層第n個特征的映射;*表示卷積;函數σ(·)表示濾波器上的修正線性單元,所有隱藏層都使用修正線性單元進行激活;b表示的是偏置單元。

最大池化:在每個卷積層之后使用降采樣因子為2的最大池化層,保留了更多的紋理信息。

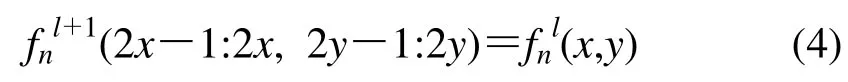

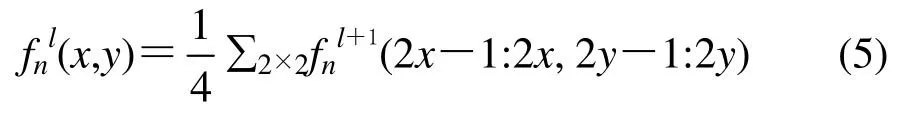

上采樣:在卷積中由于輸入霧霾圖像與輸出透射率的大小是一樣的,而特征圖的大小在最大池化層之后將會減小。因此,在最大池化層后增加了一個上采樣層[24],以確保輸入霧霾圖像和輸出透射率的大小相等。上采樣層緊隨池化層之后將恢復子采樣特征的大小,同時保持網絡的非線性。每個上采樣層被定義為:

該函數將位置(x,y)處的像素值從最大池化特征復制到緊隨其后的上采樣層中大小為2×2的塊上,因為上采樣層中的每個塊由同樣大小的值組成,這個層的反向傳播規則就是反向的平均池化層,其尺度因子為2。每個上采樣層中2×2的塊函數被定義為:

線性組合:在粗尺度卷積網絡中輸出層通過線性組合[23]將來自最后一個卷積塊的特征通道組合在一起。然后用sigmoid激活函數產生最終輸出。sigmoid函數表示為:

用sigmoid激活函數產生最終的輸出:

式中:tc在粗尺度網絡中表示場景透射率的輸出;n是特征映射通道的索引;s(·)是sigmoid激活函數;fnp表示輸出透射率前的倒數第二個特征映射;ω和b分別是線性組合的權重和偏置單元。

1.2.2 局部精細網絡

考慮了整個圖像預測粗場景透射率之后,用一個精細的網絡進行細化,除了第一和第二個卷積層之外,精細尺度網絡堆棧的架構與粗尺度網絡相似。精細尺度網絡的結構如圖1的下半部分所示,粗輸出透射率用作附加特征圖。根據設計,粗尺度預測的大小與第一個上采樣層的輸出大小相同,將這兩者連接在一起,并使用預測的粗透射率與精細尺度網絡中的學習特征圖相結合來重新修正透射率。

為進一步確定天空、白云和明亮區域等特定區域內的像素值,對多尺度網絡估計的透射率t(x)進行分類統計。

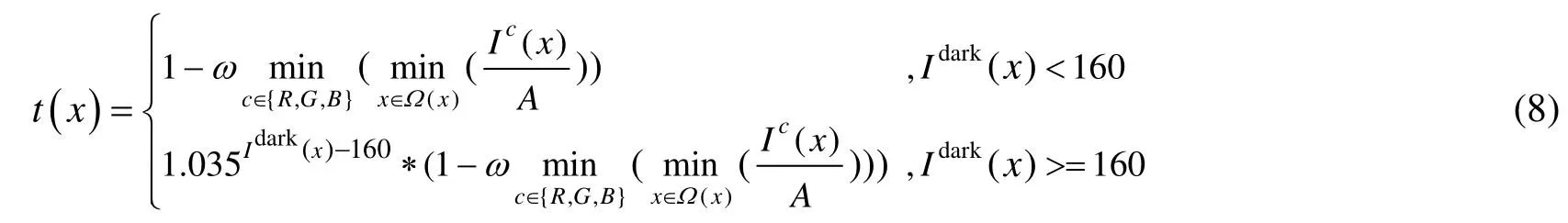

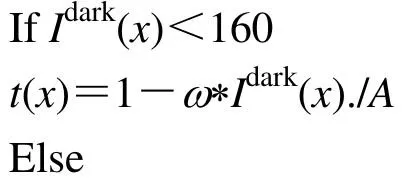

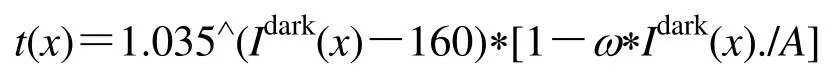

1.3 透射率的分類統計

在估計大氣透射率t(x)后,為了準確地分類統計確定天空、白云和明亮區域的像素值,在此用了Huang等人[25]分類統計的方法,該方法表明天空、白云和明亮區域的暗通道先驗值幾乎都必須大于160像素。

根據公式(8)精確估計特定區域內霧霾圖像的大氣透射率t(x):

式中:ω取值為0.75。

圖1 多尺度卷積神經網絡模型Fig.1 Model diagram of multi-scale convolution neural network

1.4 大氣光的估計

為了恢復清晰的圖像除了需要估計透射率t(x)外還需要估計大氣光A,由(1)式可知,當t(x)→0時I(x)=A。由于在室外圖像中出現的物體可能遠離觀察者,所以深度d(x)的范圍為[0,+∞),并且當d(x)→∞時有t(x)=0。因此在透射率t(x)中通過選擇0.1%暗像素來估計大氣光A。現已得到圖像大氣透射率t(x)和全球大氣光A,那么在霧霾圖像已知的情況下,根據式(1)恢復原始無霧霾圖像,得到無霧霾圖像場景的輻射度J(x)。

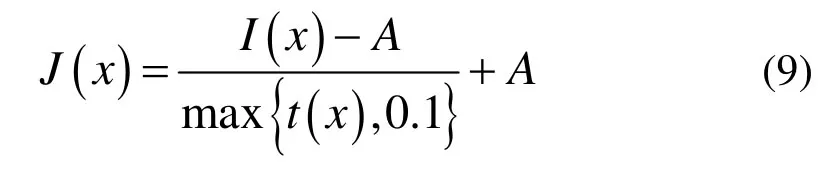

1.5 無霧霾圖像場景的輻射度

在估計t(x)和A后,用式(1)恢復無霧霾圖像,為了避免更多噪聲的影響,對t設置一個下限t0為0.1,這樣處理后圖像較自然,因此最終的無霧霾圖像場景的輻射度為:

得到無霧圖像場景的輻射度J(x)后,然后采用高斯濾波器進行平滑處理。

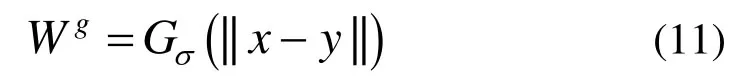

1.6 高斯濾波平滑無霧霾圖像場景的輻射度

利用低通高斯濾波器平滑上述得到的無霧霾圖像場景的輻射度,精化輻射輪廓V(x)表示為:

式中:Wg是以像素x為中心的鄰域區塊的整體權重。

式中:G是高斯函數,并且參數σ表示用于平滑像素的區域的大小,高斯傳播的標準偏差確定為標量或正值的3分量矢量。根據低通高斯濾波器精化場景輻射度,使靠近聚焦像素x的像素將獲得相當大的權重。

圖像去霧霾算法流程如下所示:

輸入:霧霾圖像I(x)

輸出:無霧霾圖像場景的輻射度J(x)

Step 1:用11×11×5的三維卷積核對原始輸入層進行卷積,通過最大池化和上采樣實現色差、紋理和對比度特征的提取,輸出霧霾圖像的整體透射率t(x)。

Step 2:將Step 1的輸出作為附加特征圖傳遞給精細網絡進行細化,估計透射率t(x)。

Step 3:分類統計特定區域內霧霾圖像的大氣透射率t(x)。

Step 4:估計全球大氣光A。

Step 5:根據式(1)得無霧霾圖像的場景輻射度J(x)=[I(x)-A]/max[t(x),0.1]+A。

Step 6:用高斯濾波器平滑Step 5所得的結果J(x)。

2 實驗

2.1 實驗數據

訓練集:通常情況下不可能捕捉到同樣視覺場景下有霧霾和無霧霾而其它所有環境條件都相同的的圖像。所以只能用無霧霾圖像合成霧霾圖像得到訓練集。用公開的indoor training set(ITS)和outdoor training set(OTS)[26]數據集,ITS室內合成訓練集中包含110000張圖片,OTS室外合成訓練集中包含313950張圖片。為了控制訓練的數據量同時保證訓練模型的泛化能力,本文分別從ITS和OTS中選取1100張和3100張圖片組成混合訓練集。為了適應多尺度網絡模型的尺度,所有的訓練圖像都被調整為320×240像素的標準尺寸。

測試集:為了驗證本文模型的實際性能表現,從synthetic objective testing set(SOTS)和hybrid subjective testing set(HSTS)數據集[26]的50幅圖像生成霧天圖像測試集。利用峰值信噪比和結構相似性作為評價結果的量化標準。

2.2 實驗設置

實驗中粗尺度網絡和精細網絡均由3個卷積層構成,在粗尺度網絡中前兩層分別用了5個大小為11×11和9×9的卷積層,最后一層是由大小為7×7的10個濾波器組成。在精細網絡中,第一個卷積層是由大小為7×7的4個濾波器組成,最后兩層分別由大小為5×5的5個濾波器和3×3的10個濾波器組成,粗尺度網絡和精細尺度網絡都是用具有0.9動量的隨機梯度下降法訓練,實驗使用了100幅圖像(320×240個像素)的批量大小,初始學習速率設置為0.001,每迭代20次初始學習速率為原來的0.1倍,迭代次數設置為70次。如圖2(a)第一、第二和第三個尺度網絡之間的比較表示更大規模的網絡不會帶來更好的效果。圖2(b)更多層的CNN和提出的多尺度CNN之間的比較表示多尺度CNN訓練效果比多層的CNN好。

3 實驗結果與分析

3.1 定量分析

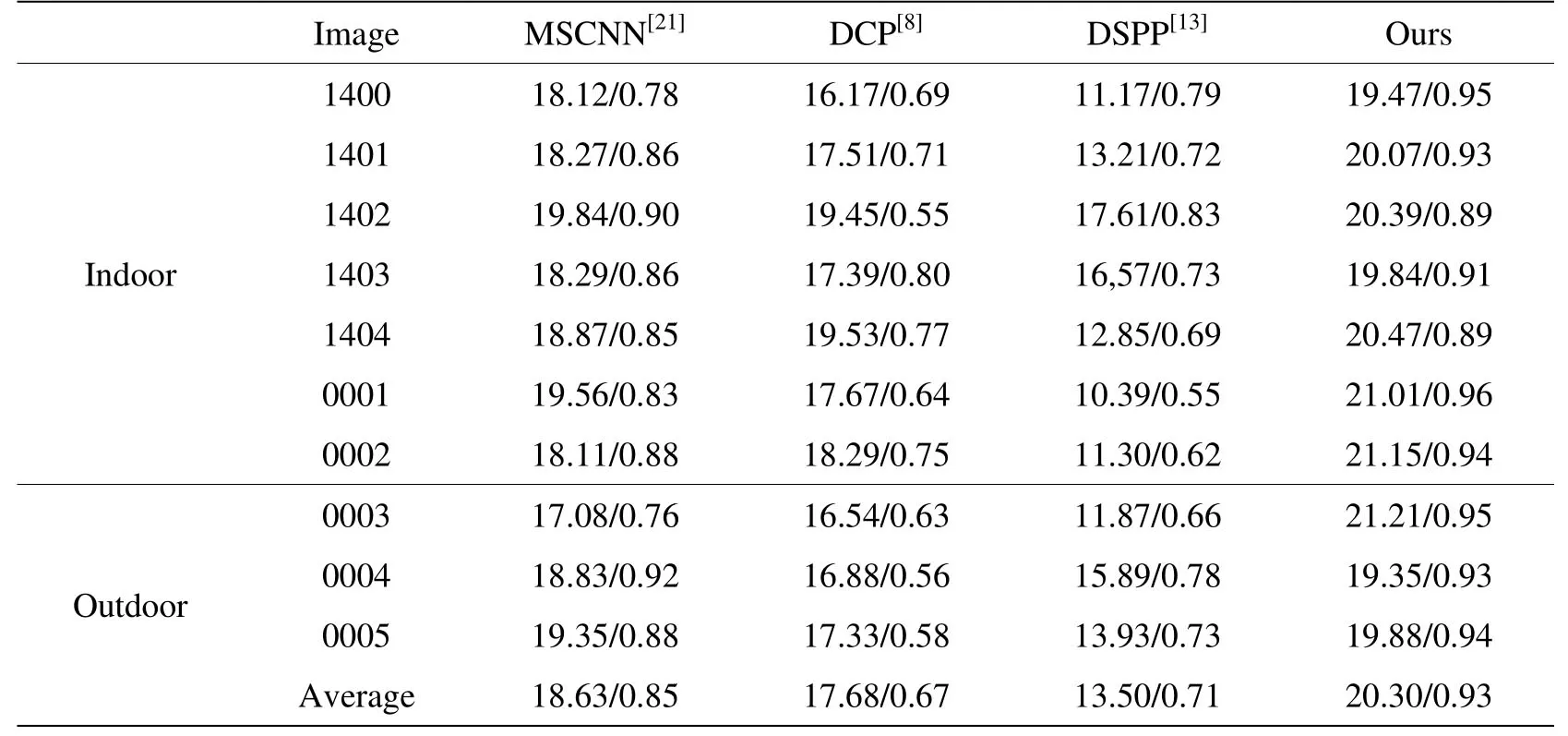

為了更加客觀地評價方法的有效性,首先在合成數據集上定量評估所提出的透射率估計性能的方法。利用峰值信噪比和結構相似性將所提出的算法與其他的去霧霾方法[8,13,21]進行了比較。表1給出了本文的方法和其他方法的比較結果。

3.2直觀效果分析

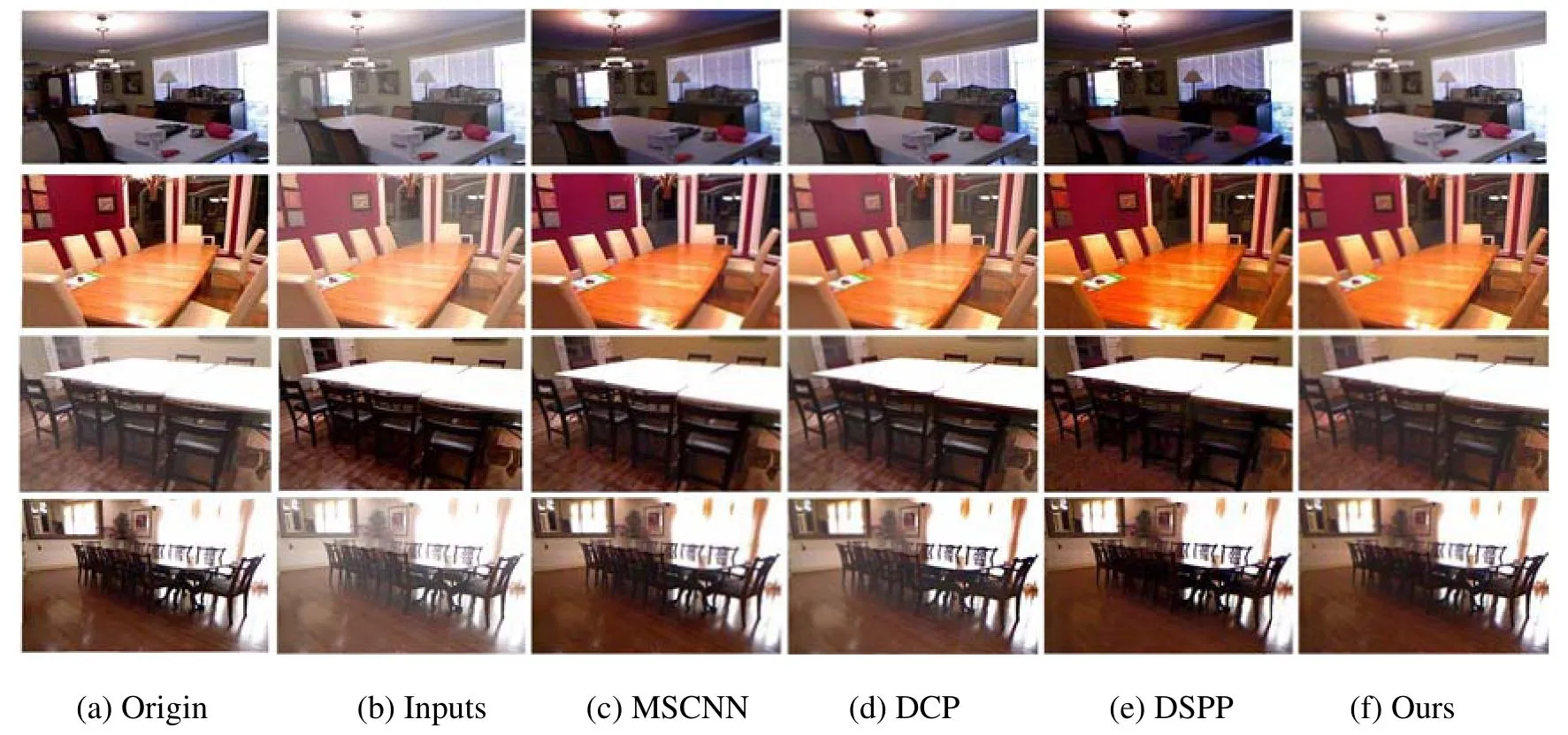

為了直觀驗證提出的方法去霧霾的有效性,分別在室內合成圖像和室外真實圖像上對所提方法和目前常用的去霧霾方法進行直觀效果分析對比。首先用室內合成的霧霾圖像比較各算法的去霧霾效果。如圖3所示,DSPP[13]的算法能夠增加圖像細節并增強圖像的可見性。但是,恢復的圖像中仍有顏色扭曲,如第2幅圖像的桌面部分。而DCP[8]的方法高估了霧的厚度并產生較暗的結果,如第3幅圖的桌面部分和第4幅圖的地面部分。MSCNN[21]的方法總體去霧霾效果較好,但會顯著增強圖像明亮區域。相比之下,圖3(f)的去霧霾效果基本接近于真實無霧圖像,這表明本文的方法去霧霾效果較好。圖4中DSPP[13]提出的方法存在圖像丟失細節、過度

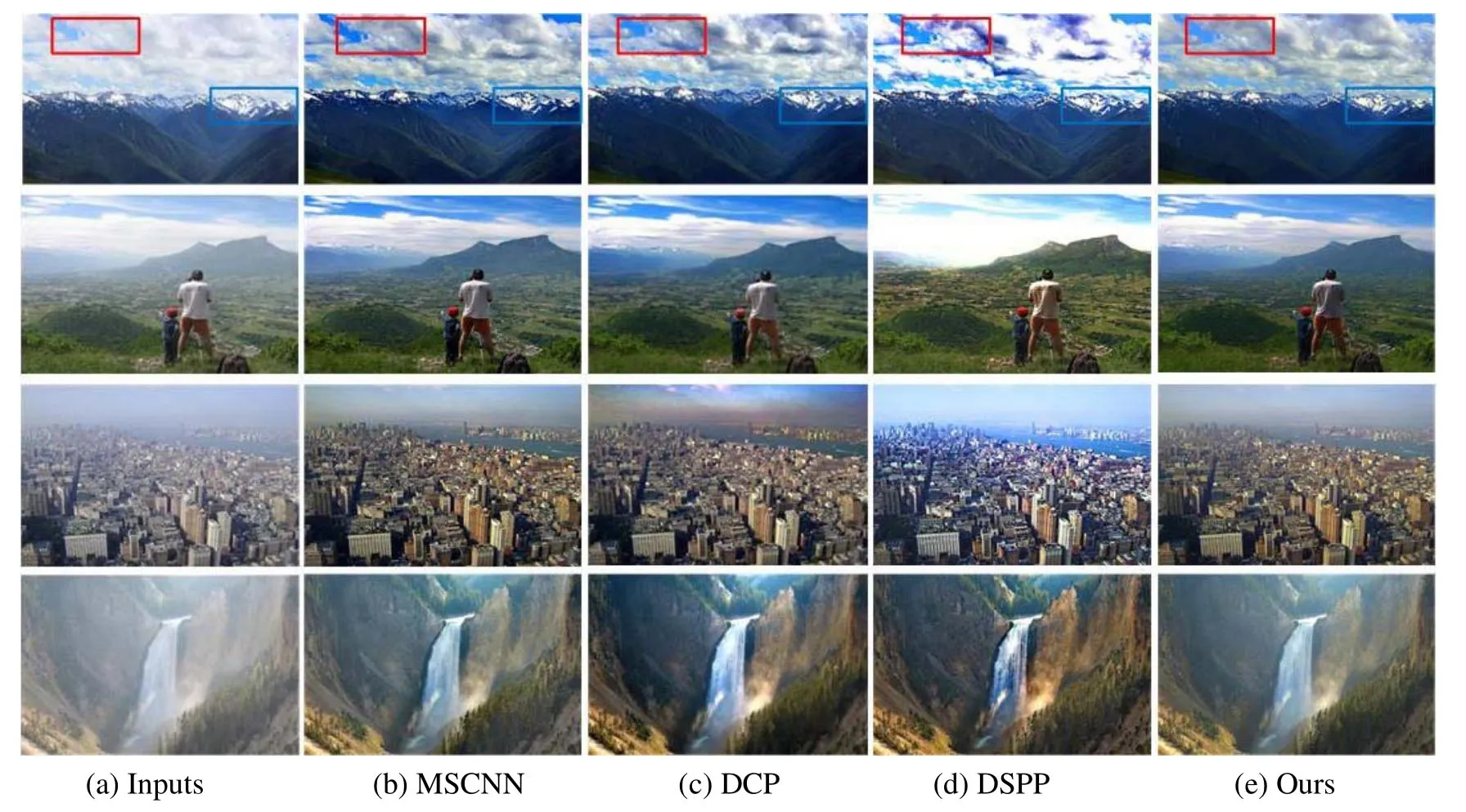

其次比較各算法在室外真實霧霾場景中的效果。增強圖像明亮區域的問題。如第1、2幅圖的白云部分。此外,第3幅中也增強了藍天、白云的亮度。DCP[8]去霧霾效果較好,但顏色仍然比實際情況更暗。相比之下,MSCNN[21]的方法和本文所提出的方法在真實霧霾場景中關于天空、白云和明亮區域的主觀評估結果差異不大,因而本文將在3.3節用場景的識別做進一步對比分析。

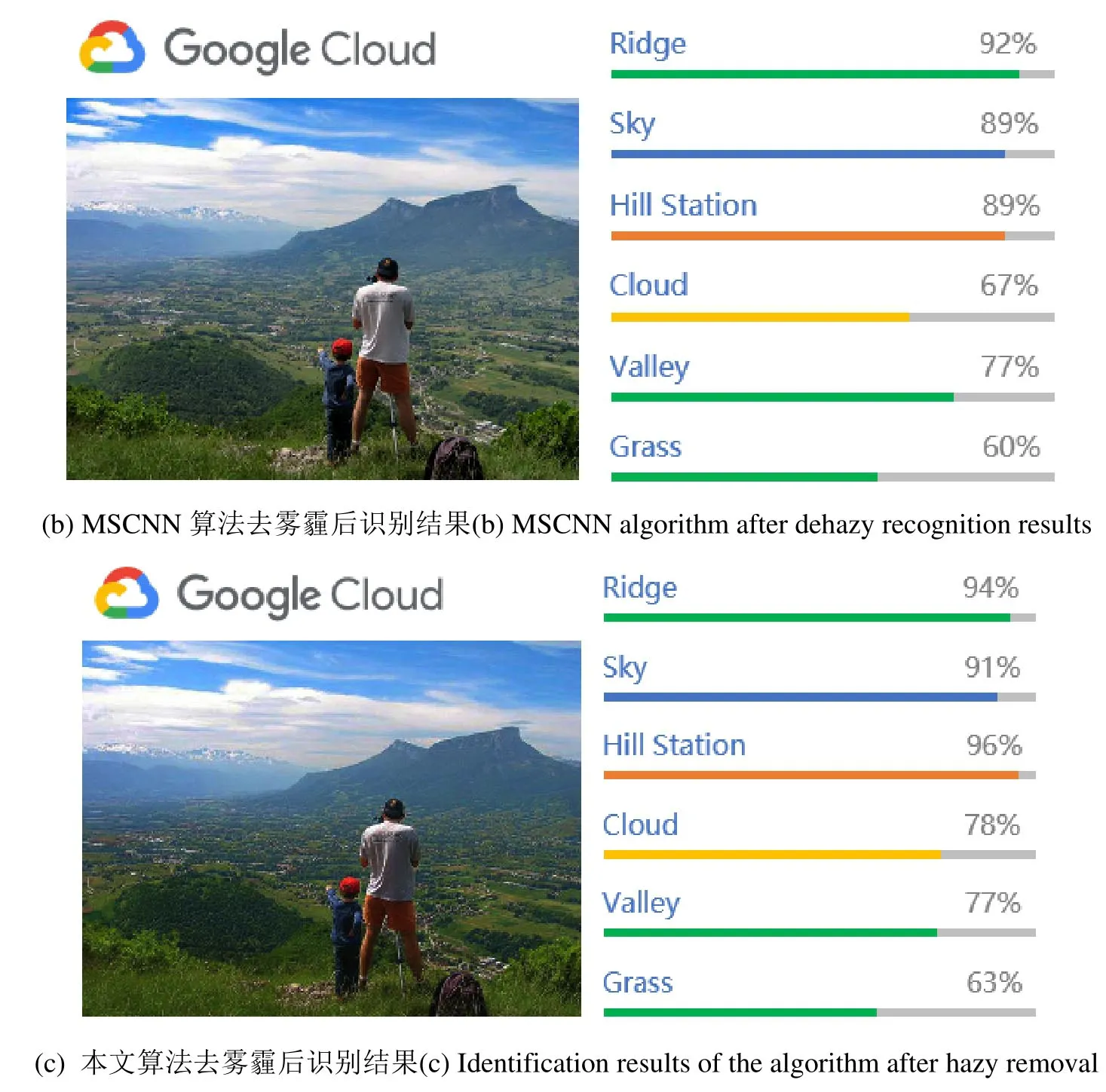

3.3 場景識別中結果分析

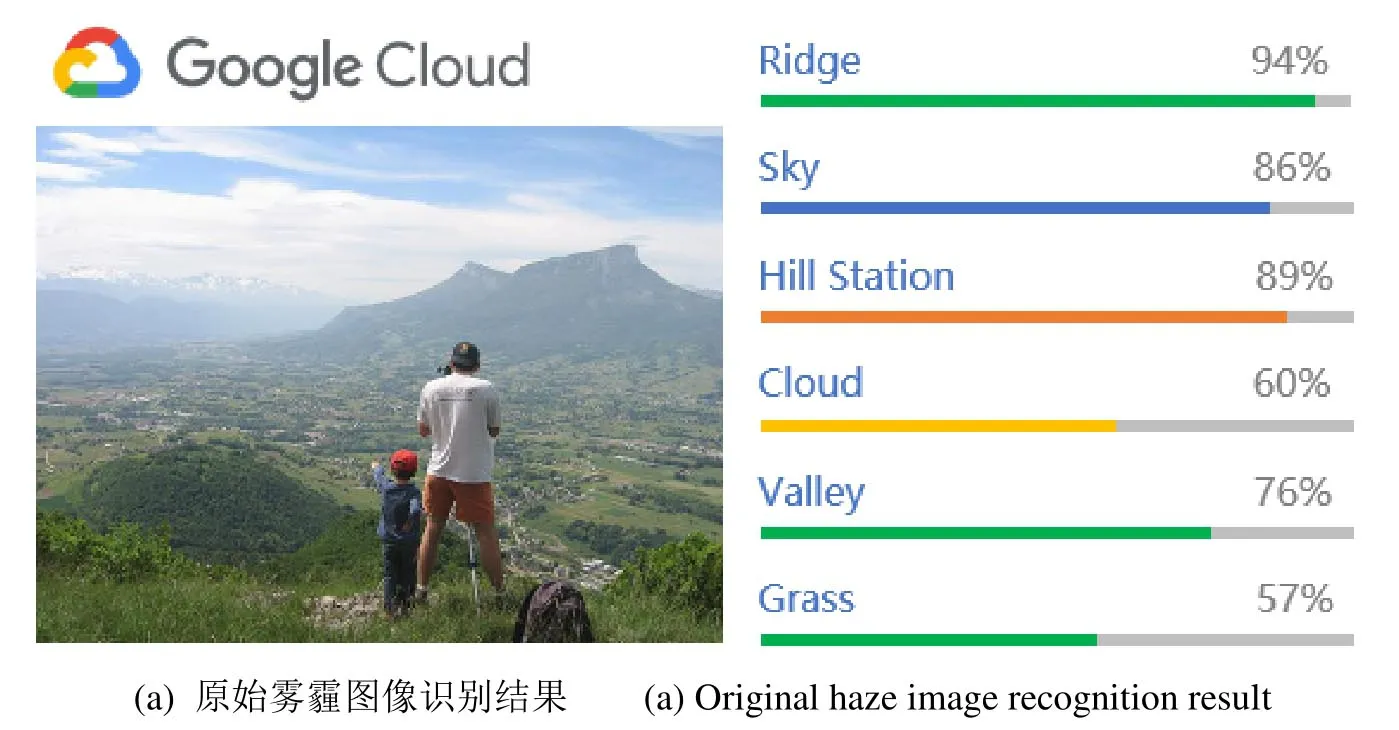

在3.2節室外真實霧霾場景直觀效果分析中MSCNN算法和本文算法直觀效果難以區分。為了進一步證明本文提出的算法去霧霾結果在場景識別中的性能,用GoogleVisionAPI(https://cloud.google.com/vision)測試真實霧霾圖像增強之后是否提高場景識別能力。對比MSCNN和本文算法在場景識別性能上的表現,結果如圖5所示。可以看出,本文算法在霧霾圖像增強之后的場景識別中比MSCN N算法識別效果更好,尤其是在天空、白云和明亮區域表現更佳。如圖5GoogleVision API識別結果示例中顯示,本文方法在霧霾圖像增強之后會增加主要對象檢測的分數。如(c)中天空和白云的分數較(a)和(b)都有較大提升。

圖2 各尺度網絡以及多層網絡之間的比較Fig.2 Comparis ons between sc ale networksa nd multi-layer networks

表1 合成數據集的平均PSNR 和SSIMTable 1 Average PSNR and SSIMof thesy nthesized data set

圖3 室內合成成圖像去霧霾結結果對比Fig.3 Comparrisons of indoorr synthetic imagges dehazy resuults

圖4 真真實圖像去霧霾霾結果對比Fig.4 Commparisons of reaal image dehazyy results

圖5 MSCNN算法和本文算法識別結果對比Fig.5 Comparisonsbetween MSCNNalgorithm and the recognition result of the algorithm

4 結論

本文結合多尺度卷積神經網絡和分類統計的方法改善原有算法在透射率計算上的問題,通過調整算法中參數并且給出相應參數的合適范圍,確保最終的去霧霾效果。通過定量和直觀效果分析的結果對比,本文算法能夠有效地解決特定區域內顏色失真、顏色扭曲及過度增強等問題,且在合成的霧霾圖像和真實的霧霾圖像中都有較好的效果。在接下來的研究中,如何提高去霧霾圖像的分辨率將是一個重點,以期進一步提高去霧霾圖像的分辨率。