面向低維工控網數據集的對抗樣本攻擊分析

周 文 張世琨 丁 勇 陳 曦

1(北京大學軟件與微電子學院 北京 100871) 2(北京大學軟件工程國家工程研究中心 北京 100871) 3(中國航空油料集團有限公司 北京 100088) 4(鵬城實驗室 廣東深圳 518000) 5(中國軟件測評中心 北京 100048)

云-邊計算、人工智能、物聯網等新一代信息技術與工業制造技術的加速融合,促使工業控制系統由封閉走向開放、由單機走向互聯、由自動化走向智能化;拓展了工業控制系統發展空間但同時擴大了工業控制系統攻擊面,工業控制網絡面臨的傳統安全威脅和工控網絡特有的安全威脅日益增多.近10年里,工業控制網絡經歷了各種網絡攻擊,造成巨大損失.臺灣積體電路制造股份有限公司(中文簡稱:臺積電,英文簡稱:TSMC)2018年8月遭網絡攻擊,損失1.7億美元[1];全球知名鋁生產商挪威海德魯公司(Norsk Hydro A.S.)2019年3月遭網絡攻擊,損失4 000萬美元[2];全球知名汽車零部件制造商豐田集團旗下子公司——日本豐田紡織株式會社(TOYOTA BOSHOKU),2019年9月遭遇攻擊,損失3 700萬美元[3].工業系統的網絡攻擊正成為一種日趨嚴重的安全威脅.

入侵檢測是一種主動防御措施,能夠及時發現目標系統潛在的入侵行為[4].機器學習算法,特別是深度神經網絡(deep neural networks, DNNs)學習算法在工控網絡系統入侵檢測方面展示了卓越的檢測能力[5-6].與信息網絡不同,工業控制領域常用的監視控制與數據采集系統(supervisory control and data acquisition, SCADA),網絡拓撲結構固定,節點之間的事務重復并有規則,這種相對固定的工作模式更加有利于入侵檢測系統(intrusion detection system, IDS)檢測異常活動.

然而機器學習算法由于本身存在一些缺陷,導致其容易受到由對抗樣本引起的白盒或黑盒攻擊[7-17].對抗樣本是導致學習算法錯誤分類的數據集,攻擊者通過對正常數據集進行不明顯的修改來迫使機器學習算法在面對這些對抗樣本時表現出不魯棒行為,對修改過的數據集產生錯誤分類.對抗樣本攻擊根據攻擊者是否完全掌握機器學習模型(包括模型的結構及參數值、特征集合、訓練方法,在某些情況下還包括其訓練數據),可以分為白盒和黑盒攻擊.攻擊者在完全了解機器學習模型的前提下,產生對抗樣本,該樣本對于該機器學習模型的攻擊就稱為對抗樣本白盒攻擊.具有不同架構的2個機器學習算法,其中一個機器學習算法A產生的對抗樣本能導致另一個機器學習算法B對該對抗樣本以高置信度做出誤判,就稱機器學習算法B遭受了對抗樣本黑盒攻擊.

目前關于對抗樣本攻擊的研究集中在非結構化數據集或者是特征豐富(高維)的結構化數據集.本文的研究對象是工控網絡數據集,選取了密西西比大學公開的結構化的低維(特征少)天然氣數據集[18],旨在通過構建實驗來分析4個常見優化算法SGD[19],RMSProp[20],AdaDelta[21]和Adam[22]與對抗樣本攻擊力的關系,分析對抗樣本對典型機器學習算法的攻擊力,并研究對抗訓練是否能有效提高深度學習算法抗白盒攻擊的能力.

本文的主要貢獻有4個方面:

1) 基于DNN模型生成了對抗樣本,并調查了典型優化算法(SGD,RMSProp,AdaDelta和Adam)對對抗性樣本的生成能力的影響.實驗結果顯示基于Adam優化算法的DNN模型在對抗樣本生成方面,具有高收斂速度和高生成率.

2) 提出了一個新指標來評估典型優化算法與對抗樣本白盒攻擊能力的關系,并與文獻[17]提出的指標進行對比.實驗結果顯示,基于Adam優化算法的DNN模型產生的對抗樣本白盒攻擊力最強,可以最大程度地提高結構化數據集的錯誤分類.

3) 比較典型機器學習算法(決策樹、隨機森林、支持向量機、AdaBoost、邏輯回歸、CNN和RNN)的抗對抗樣本黑盒攻擊的能力,以及評估不同優化算法產生的對抗樣本對各個機器學習算法的攻擊能力.實驗結果顯示,對抗樣本對各個典型機器學習算法都具有黑盒攻擊能力,RNN對黑盒攻擊的防御能力最好,使用Adam優化算法的DNN模型產生的對抗樣本的黑盒攻擊能力最強,使用AdaDelta優化算法的DNN模型產生的對抗樣本的黑盒攻擊能力最弱.

4) 通過對抗樣本訓練,提高深度學習模型對對抗樣本白盒攻擊的防御能力.

公開文獻調研結果顯示:這是首次在工控網數據集上調查優化算法對對抗樣本的白盒攻擊和黑盒攻擊能力的影響,也是首次調查典型機器學習算法抗對抗樣本黑盒攻擊的能力.

1 基礎知識和相關工作

本節首先介紹本文涉及到的一些概念知識,然后討論相關工作.

1.1 基礎知識

機器學習模型旨在學習其輸入和輸出之間的映射.通常,給定輸入input由x個特征組成,模型會產生輸出output,該輸出是y維向量,表示input被分類為每個類別的概率.本文探索典型機器學習模型,包括決策樹[23]、隨機森林[24]、支持向量機[25]、AdaBoost[26]、邏輯回歸[27]、卷積神經網絡(convo-lutional neural network, CNN)[28]和循環神經網絡(recurrent neural network, RNN)[28].

深度學習過程實則為一個優化算法進行最優化求解的過程,首先求解最小化目標函數(又稱為損失函數)ξ(θ)的梯度ξ(θ),然后向負梯度方向更新參數θ,即θt=θt-1-ηξ(θ),其中η為學習率.根據深度學習優化算法梯度與學習率關系,深度學習優化算法可分為2個大類:1)學習率η不受梯度ξ(θ)影響,即η全程不變或者按照一定規則隨時間變化,隨機梯度下降法(SGD)、帶Momentum的SGD和帶Nesterov的SGD都屬于這一類;2)優化過程中,學習率隨著梯度自適應地改變,并盡可能去消除給定的全局學習率的影響,這一類優化器有很多,包括AdaDelta,RMSProp和Adam等.本文考慮4種已經應用于各種深度學習任務并取得出色效果的算法:SGD,RMSProp,AdaDelta和Adam.

1.2 相關工作

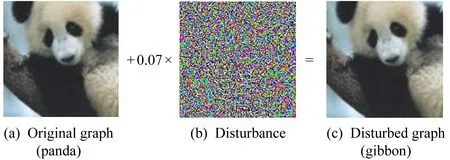

Szegedy等人[7]中發現了DNN存在對抗樣本,并提出了一種通過盒約束優化方法來可靠檢測這些擾動的方法,該方法的有效性取決于內部網絡狀態.文獻[8]中引入了另一種對抗樣本生成技術,也就是快速梯度符號方法(fast gradient sign method, FGSM),該方法核心思想是通過梯度來生成攻擊噪聲,即通過模型的損失函數對樣本求導、取符號函數、乘上擾動強度來產生對抗樣本.文獻[8]給的實例如圖1所示,圖1(a)是原圖,一般的分類模型都會將其分類為熊貓(panda),但是通過添加由神經網絡梯度生成的攻擊噪聲圖1(b)后,得到圖1(c)的攻擊圖像,雖然看起來還是熊貓,但是模型卻將其分類為長臂猿(gibbon).

Fig. 1 Generating adversarial examples by using FGSM[8]圖1 FGSM產生對抗樣本[8]

基于FGSM和原始損耗梯度,Rozsa等人[9]提出了一種新的對抗樣本生成方法,即熱/冷(HC)方法,該方法能夠為每個輸入有效地生成多個對抗樣本.Papernot等人[10]介紹了一種通過利用模型輸入和輸出之間的映射關系來產生擾動的方法,他們使用前向導數評估模型輸出對每個輸入的敏感度.此外,Papernot等人[11]提出了面向RNN的對抗性輸入序列的方法.以上這些工作都是討論對抗樣本的白盒攻擊.與這些產生對抗樣本工作不同的是,本文旨在驗證優化算法是否會對對抗樣本的白盒攻擊能力造成影響.

除白盒攻擊外,Papernot等人[12]引入了具有替代數據集的黑盒攻擊,并提出DNN架構對對抗性樣本的可傳遞性影響是有限的.Gao等人[13]引入了替代訓練和線性增強來增強對抗樣本黑盒攻擊.Shi等人[14]介紹了一種使用Curls迭代和Whey優化的新型對抗樣本黑盒攻擊,可以使軌跡多樣化并壓縮噪聲.Grosse等人[15]采用基于網絡的入侵檢測系統數據集NSL-KDD和Android惡意軟件檢測數據集DREBIN來分析對抗樣本.Wang等人[16]研究了對抗樣本的黑盒攻擊能力.以上這些工作都是針對某一特定優化算法開展的.Wang等人[17]研究了不同優化算法對對抗樣本白盒和黑盒攻擊能力的影響.文獻[17]與本文工作相似,二者之間的區別有4方面:

1) 數據集特征數目不一樣,即數據集維數不一樣.本文考慮的數據集的特征數目不到20,而文獻[17]研究的各個數據集至少有100個特征.

2) 對抗樣本生成方法不一樣.本文使用FGSM[8],而文獻[17]利用JSMA(jacobian-based saliency map approach)[10]來生成對抗樣本.

3) 評估對抗樣本白盒攻擊能力的指標不一樣.本文提出用同比損失率,而文獻[17]用的是Dvalue,具體定義見2.3節.

4) 本文在對抗樣本黑盒攻擊能力方面調研了更多機器學習算法的防御能力.

對抗樣本生成的基本思路是:在訓練模型的過程中,把輸入固定,然后調整參數,使得最后結果能對應到相應的輸入;生成對抗樣本時,將模型固定,通過調整輸入,觀察在哪個特征方向上只需要微小的擾動即可使得模型給出想要的錯分的分類結果.

在關于檢測和防御對抗樣本的機制方面,Papernot等人[11]介紹了一種防御機制,以減少對抗樣本對DNN的影響.Li等人[29]提出了一種通過使用卷積層輸出的統計信息來檢測對抗樣本的方法.Tramèr等人[30]介紹了集成對抗訓練方法,通過從其他模型傳遞的擾動來增加訓練數據;實驗結果表明,該技術對黑盒攻擊具有強大魯棒性.

生成對抗樣本的主要方法有FGSM和JSMA.Szegedy等人[7]首次提出針對深度學習場景下的對抗樣本生成算法—BFGS,提出深度神經網絡所具有的強大的非線性表達能力和模型的過擬合可能是產生對抗樣本原因之一.Goodfellow等人[8]對該問題進行了更深層次的研究,認為高維空間下深度神經網絡的線性行為是導致該問題的根本原因,并設計出一種快速有效的對抗樣本生成算法—FGSM;該方法通過求出模型對輸入的導數,然后用符號函數得到其具體的梯度方向,接著乘以一個步長,把得到的“擾動”加在原來的輸入,從而得到FGSM對抗樣本.JSMA是由Papernot等人[10]在2016年提出的一種對抗樣本生成算法,通過對數據集部分特征進行擾動來生成對抗樣本,不僅可以誤導神經網絡輸出錯誤的分類結果,還可以預設一個目標,讓神經網絡輸出指定的(錯誤)分類結果.由于本文考慮的數據集的特征少,很難用JSMA生成對抗樣本,因此采用FGSM方法通過對每個特征進行擾動來生成對抗樣本.

2 對抗樣本攻擊的分析方法

本節介紹了數據預處理方法,給出了白盒和黑盒攻擊實驗的設計,描述了評估指標.

2.1 數據集預處理

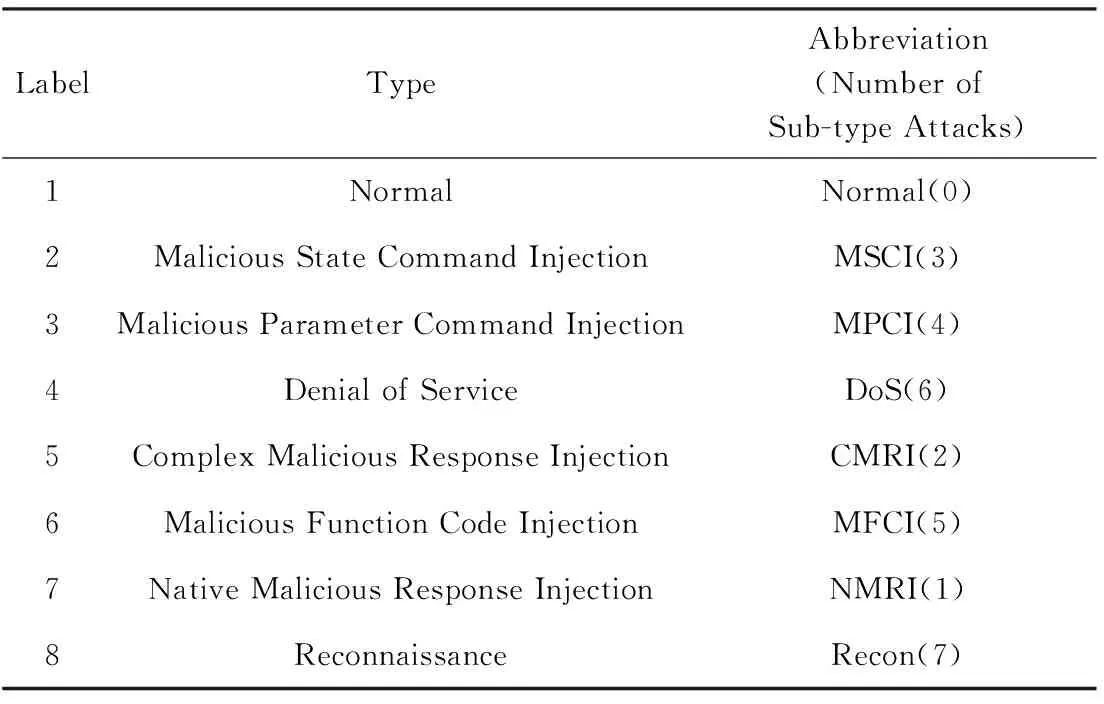

原始數據通常會出現數據不完整或數據無用問題,數據預處理目的就是糾正這些錯誤,或者刪除存在問題的數據,因此需要對原始數據進行數據預處理.對于本文使用的天然氣數據集,一共有274 628條記錄,其中有210 528條記錄特征并不完整,也就是說76.7%的記錄不完整.如果利用少量的23.3%的完整數據記錄,通過平均值或其他方法來填充76.7%缺失數據,很難使修補的數據記錄能有效表述數據記錄真實特點;鑒于此考慮,本文去掉了特征缺失記錄.最終獲得了64 100條完整的數據記錄,這也導致特征更少,原始數據的特征不到30,該數據集一共有七大類攻擊類型,即label 2~label 8,每類中還包含了子類,例如MSCI(3)表示該類攻擊具體包含3個子類.表1給出了原始數據的特征,其中前4行是預處理后的數據包含的特征.

Table 1 Attack Types表1 攻擊類型

在天然氣數據集中,針對離散特征,我們采用One-hot編碼,針對連續特征采用Standard Scaler編碼方法.這2種編碼方法具體內容為:

1) One-hot編碼.回歸、分類、聚類等機器學習算法的特征之間距離計算或相似度計算都是在歐氏空間進行.One-hot編碼將離散特征的取值擴展到了歐氏空間,離散特征的某個取值對應歐氏空間的某個點.離散型特征使用One-hot編碼,能讓特征之間的距離計算更加合理.例如,本文采用的天然氣數據集中的system mode,統計結果顯示該特征一共有3個特征值,分別是0,1,2,那么其One-hot編碼分別是:0用[0,0,1]表示,1用[0,1,0]表示,2用[1,0,0]表示.

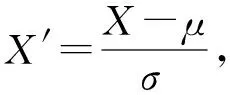

2) Standard Scaler編碼.數據集的標準化是許多機器學習估計器的共同要求:如果單個特征看起來不太像標準正態分布數據(例如均值和單位方差為0的高斯),那么它們可能表現得很差.例如,學習算法的目標函數中使用的許多元素(例如支持向量機的RBF核或線性模型的L1和L2正則化)假設所有特征都以0為中心并且具有相同順序的方差.如果一個特征具有比其他特征大幾個數量級的方差,則它可能主導目標函數,并使估計者無法像預期那樣正確地從其他特征中學習.Standard Scaler編碼通過計算訓練集中樣本的相關統計數據,在每個特征上獨立地進行居中和縮放,然后存儲均值和標準差,以便使用變換方法在以后的數據上使用.具體為

(1)

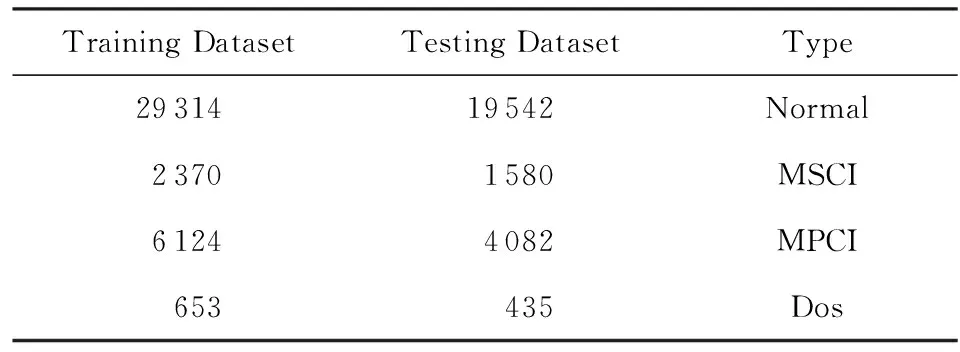

其中,μ是某一特征的均值,σ是該特征的標準差.最終我們得到了四分類的數據集,如表2所示:

Table 2 Training and Testing Dataset After Pre-processing表2 預處理生成的訓練集和測試集

2.2 攻擊模型

本文考慮的對抗攻擊是通過構造對抗性數據來實現,之后該對抗性數據就如正常數據一樣輸入機器學習模型并得到欺騙的識別結果.在構造對抗性數據的過程中,根據攻擊者是否掌握機器學習模型,可以分為白盒和黑盒攻擊.

2.2.1 對抗樣本的生成

FGSM和JSMA都可以用來生成對抗樣本.FGSM通過將損失函數的導數應用于輸入來生成擾動.目前針對結構化數據集產生的對抗樣本,都是采用JSMA,這些數據集特征豐富,但是對于特征少的數據集,JSMA很難生成對抗樣本,所以我們采用FGSM來合成對抗樣本.圖2給出了天然氣數據集的對抗樣本生成流程.

Fig. 2 Generating adversarial sample of Gas dataset圖2 天然氣數據集的對抗樣本生成

本文采用SGD,RMSProp,AdaDelta和Adam這4種優化算法具有3個隱藏層的深度神經網絡DNN模型來生成對抗樣本.分別用SGD模型、RMSProp模型、AdaDelta模型和Adam模型來表示這4種優化算法下的DNN模型,相應的對抗樣本分別表示成SGD對抗樣本、RMSProp對抗樣本、AdaDelta對抗樣本和Adam對抗樣本.這些模型除了要使用的優化算法和學習率不同外,其他超參數都相同.學習率是優化算法的一部分,并且不同的優化算法具有不同的最優學習率,以幫助其快速更新模型的參數.因此,我們為每個優化算法調整最佳學習率,以便基于該優化算法的模型可以最快收斂并達到最佳性能.

4個模型中的3個隱藏層依次是256,512,128個節點,選擇ReLU作為激活函數,以確保模型的非線性;采用比率0.5法對模型進行正則化并防止過擬合.輸入維和輸出維對應于每個預處理數據集.實驗將epoch設置為15,以調查在不同優化算法下每種輪數下的對抗性樣本生成指標的變化,從而獲得最適合對抗性樣本生成的模型.

2.2.2 白盒攻擊

白盒攻擊要求攻擊者能夠獲知目標模型使用的算法,以及算法所使用的參數.在白盒攻擊中,首先利用原樣本訓練集對2.2.1節提到的4個模型(SGD模型、RMSProp模型、AdaDelta模型和Adam模型)進行訓練,從而獲得各自最適合原樣本測試集的模型,然后利用這些模型去測試2.2.1節生成的相應的對抗樣本,從而評估優化算法與對抗樣本白盒攻擊能力的關系.

2.2.3 黑盒攻擊

黑盒攻擊指攻擊者利用對抗性樣本的可傳遞性對目標模型實施攻擊,攻擊者并不知道目標模型所使用的算法和參數.本文選擇決策樹、隨機森林和線性支持向量機、AdaBoost、邏輯回歸、CNN和RNN來評估對抗樣本針對典型機器學習模型和深度學習模型的跨模型攻擊能力.構建的CNN層是conv16-conv32-full32,convN表示具有N個過濾器的卷積層,而fullN表示具有N個節點的完全連接層.RNN層為LSTM30-LSTM60-full32,其中LSTMN表示具有N個單位的LSTM層.這7個機器學習模型都先在原樣本訓練集經過調試,能夠對原樣本測試集有效進行分類;然后對這些目標模型分別注入對抗樣本,來評估對抗樣本黑盒攻擊能力以及評估各機器學習模型的抗黑盒攻擊能力.

2.3 評估指標

在評估優化算法對對抗樣本生成的影響方面,采用對抗性樣本的生成率來評估對抗性樣本生成的有效性:

(2)

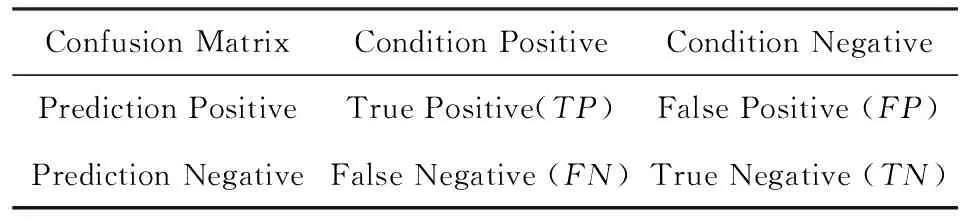

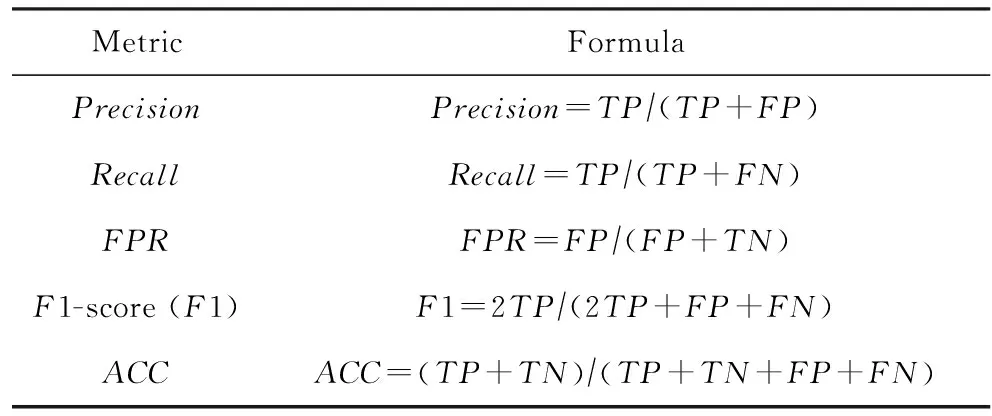

如2.2節所述,本文將所有判別分為目標判別和非目標判別,這是一個二分類問題,可以采用混淆矩陣及其派生指標來評估黑盒攻擊的性能.表3給出了混淆矩陣的定義.表4給出了分類模型的評估指標計算公式,精準率(Precision)表示模型預測為正類的數據中,正樣本所占的比例;召回率(Recall)表示真實結果為正類的數據中,正樣本所占的比例;假正例率(FPR)是指真實結果為負類的數據中,被錯誤分到正樣本類別中真實的負樣本所占的比例;F1-score綜合考慮了精準率和召回率兩個指標;準確率(ACC)是指真實結果占所有樣本的比例.

Table 3 The Confusion Matrix表3 混淆矩陣

Table 4 The Calculation Formula for Evaluation Index of Binary Classification Model

在白盒攻擊方面,采用同比損失率來評估對抗樣本的白盒攻擊能力,同比損失率可計算為

(3)

其中,ACC原樣本表示在原樣本測試集的ACC值,ACC惡意樣本代表對抗樣本數據集下的測試的ACC值.同比損失率大,則白盒攻擊能力強.需要指出文獻[17]定義了Dvalue=ACC原樣本-ACC惡意樣本來評估對抗樣本的白盒攻擊能力,文獻[17]認為Dvalue大,則白盒攻擊能力強.

3 實驗結果與分析

本節首先介紹生成的對抗樣本的結果以及對抗樣本白盒攻擊結果;然后給出對抗性樣本黑盒攻擊實驗結果;最后給出對抗訓練的實驗結果.

實驗測試環境為:Intel CoreTMi7-6700 CPU核心頻率3.4 GHz、內存16 GB、實驗用的軟件為Tenserflow 2.0版.

3.1 白盒攻擊結果分析

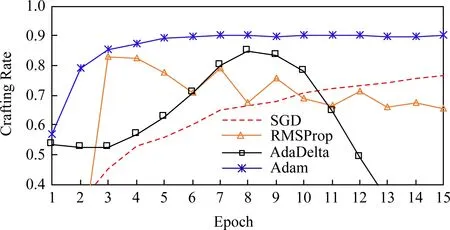

Fig. 3 Crafting rate of Gas dataset圖3 天然氣數據集的對抗樣本生成率

本節介紹了DNN模型分別在4個優化算法下生成對抗性樣本的結果,分別用SGD樣本、RMSProp樣本、Adam樣本和AdaDelta樣本表示由SGD模型、RMSProp模型、AdaDelta模型和Adam模型生成的對抗樣本.圖3給出了各模型對抗性樣本的生成率,可以觀測到Adam樣本收斂速度最快,RMSProp樣本和AdaDelta樣本的曲線波動很大;AdaDelta樣本生成率先增加后降低,而其他樣本生成率曲線趨向穩定.總之,生成率結果與文獻[17]結果截然相反.

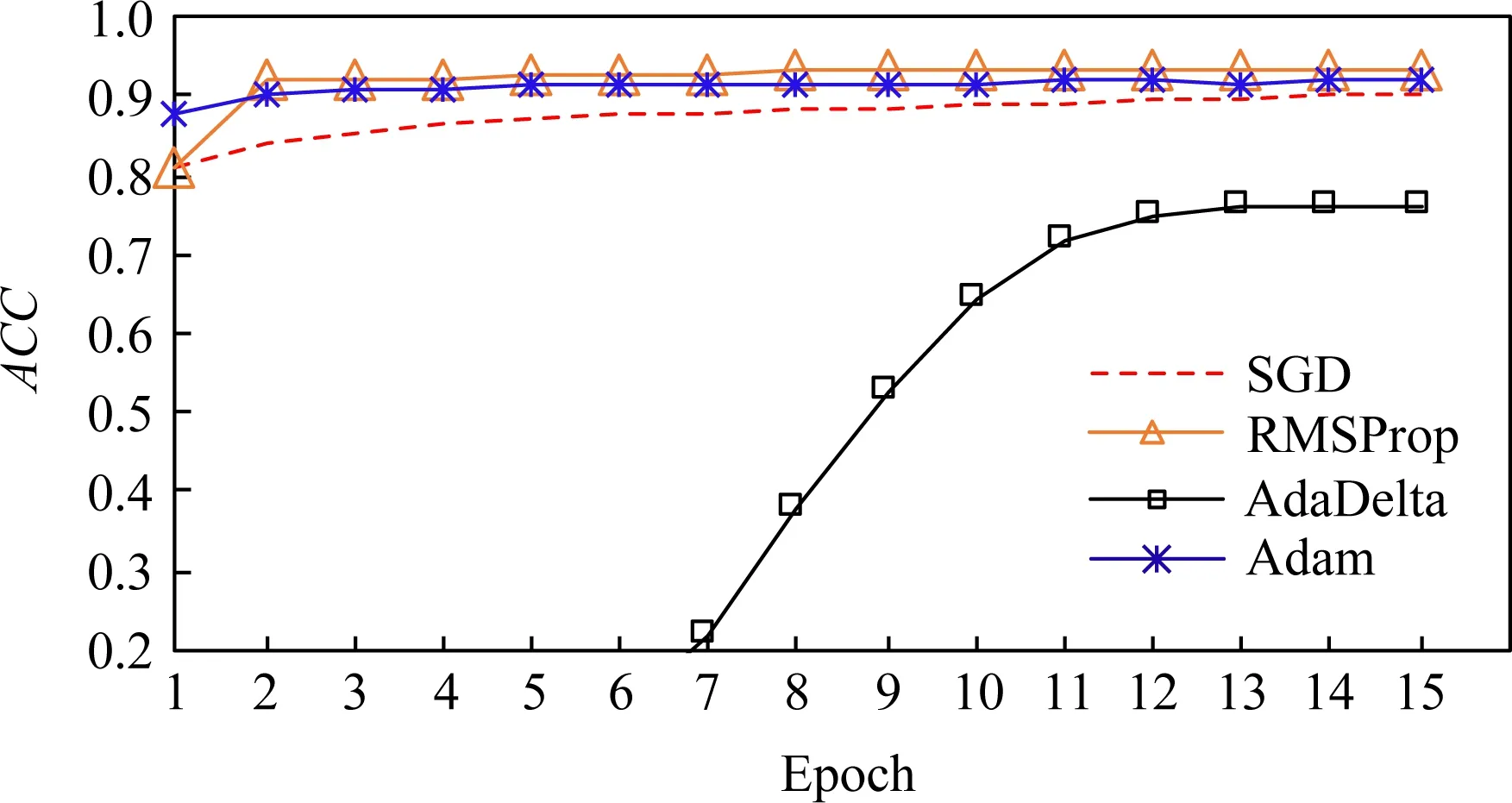

圖4給出了原樣本訓練集的DNN在原樣本測試集的ACC值.我們觀測到Adam模型收斂速度與RMSProp最接近,RMSProp比Adam略好,比其他模型都收斂快,而且ACC結果最好;收斂速度最慢的是AdaDelta模型,而且ACC最差.

Fig. 4 ACC of Gas dataset圖4 天然氣數據集的原樣本的ACC

Fig. 5 Normalized Dvalue of Gas dataset圖5 天然氣數據集的同比損失率

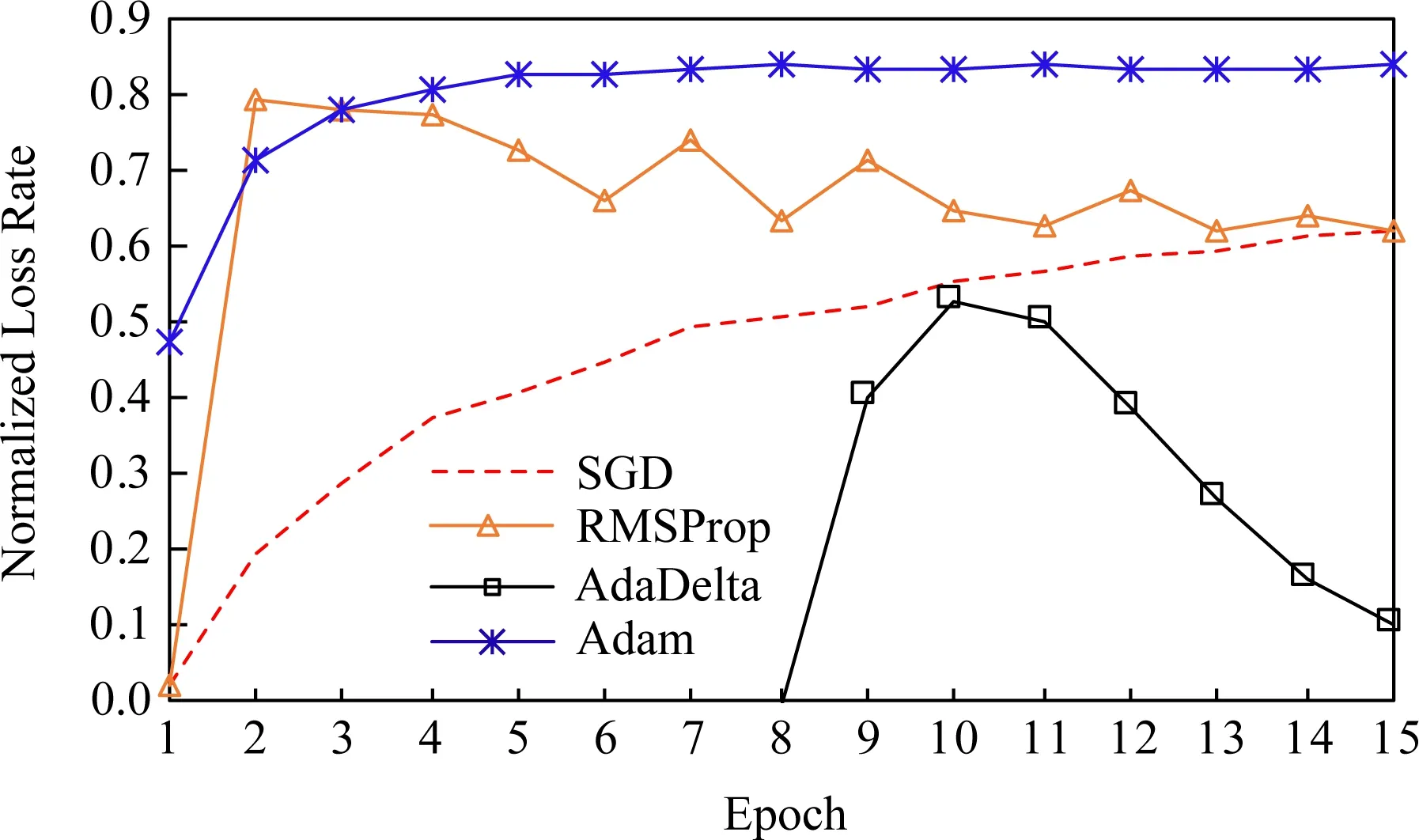

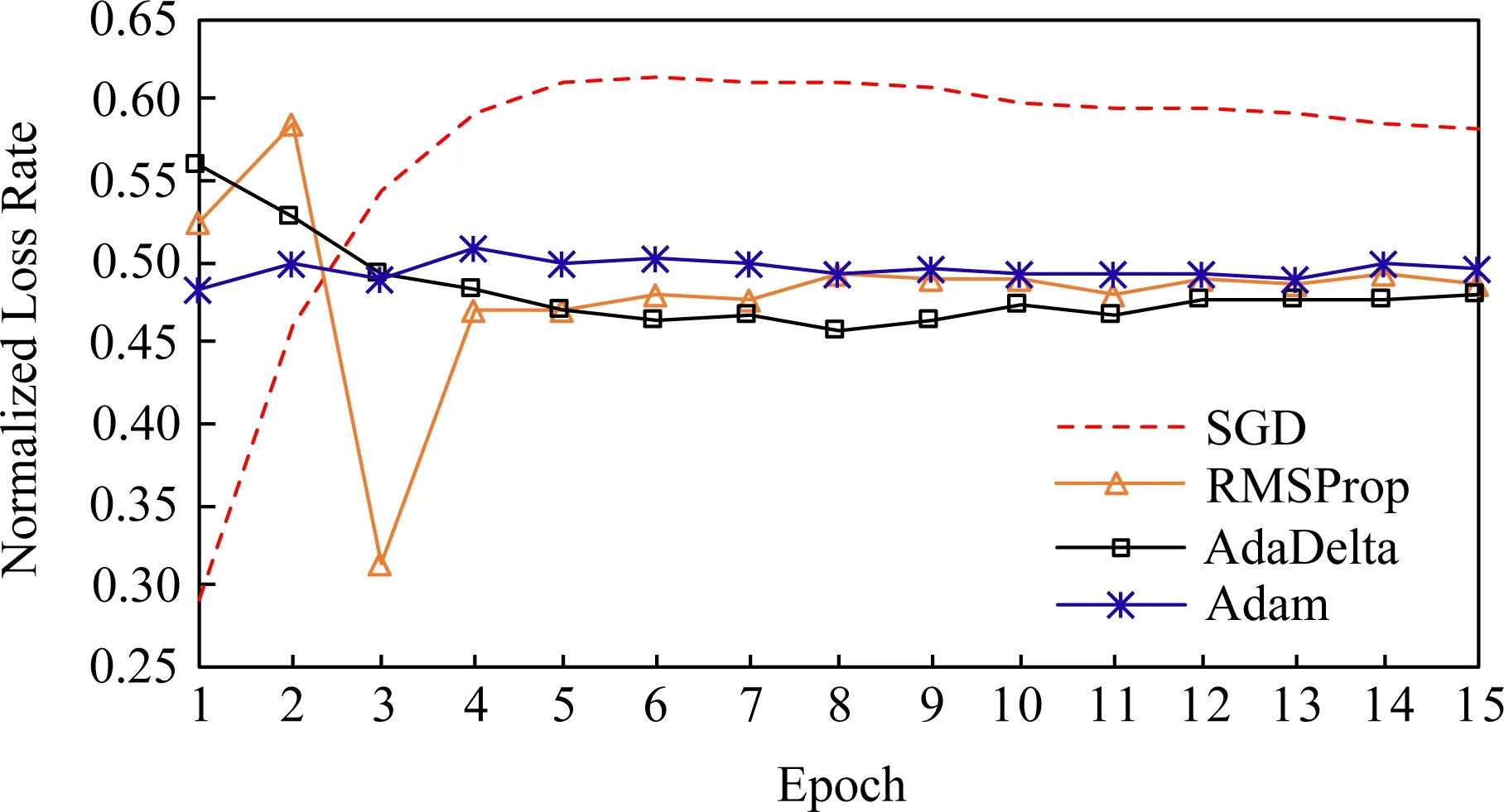

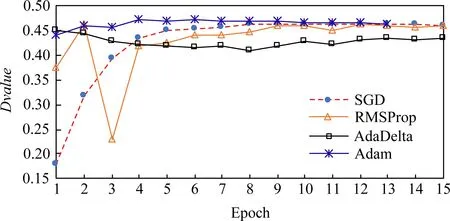

圖5和圖6分別給出了天然氣數據集的同比損失率和Dvalue.這2個指標旨在反映對抗樣本白盒攻擊力,我們可以觀測到,無論哪個指標都顯示Adam樣本的白盒攻擊能力最強,隨后分別是RMSProp樣本、SGD樣本和AdaDelta樣本.因此,僅考慮Dvalue,Adam優化算法是在結構化數據集上生成對抗性樣本的最佳選擇.同時我們也發現如果使用同比損失率,SGD樣本的白盒攻擊能力比RMSProp樣本攻擊能力弱;但是如果使用Dvalue,當輪數大于12以后,SGD樣本的白盒攻擊能力比RMSProp樣本攻擊能力強.需要指出的是,在本文數據集里,這2個指標的結果差別不大,但是其他數據集卻得出不同結論.例如DREBIN[15 ],圖7給出了采用同比損失率計算的結果,我們觀察到SGD樣本白盒攻擊力最強,而且遠遠超出其他樣本;圖8給出了文獻[17]在DREBIN數據集的Dvalue,結果顯示Adam樣本的白盒攻擊力在各種迭代輪數下最強或者和其他樣本一樣.其實同比損失率可以看作是歸一化的Dvalue,用于對比對抗樣本白盒攻擊能力更有意義.

Fig. 6 Dvalue of Gas dataset圖6 天然氣數據集的Dvalue

Fig. 7 Normalized Dvalue of DREBIN dataset圖7 DREBIN數據集的同比損失率

Fig. 8 Dvalue of DREBIN dataset圖8 DREBIN數據集的Dvalue

3.2 黑盒攻擊結果分析

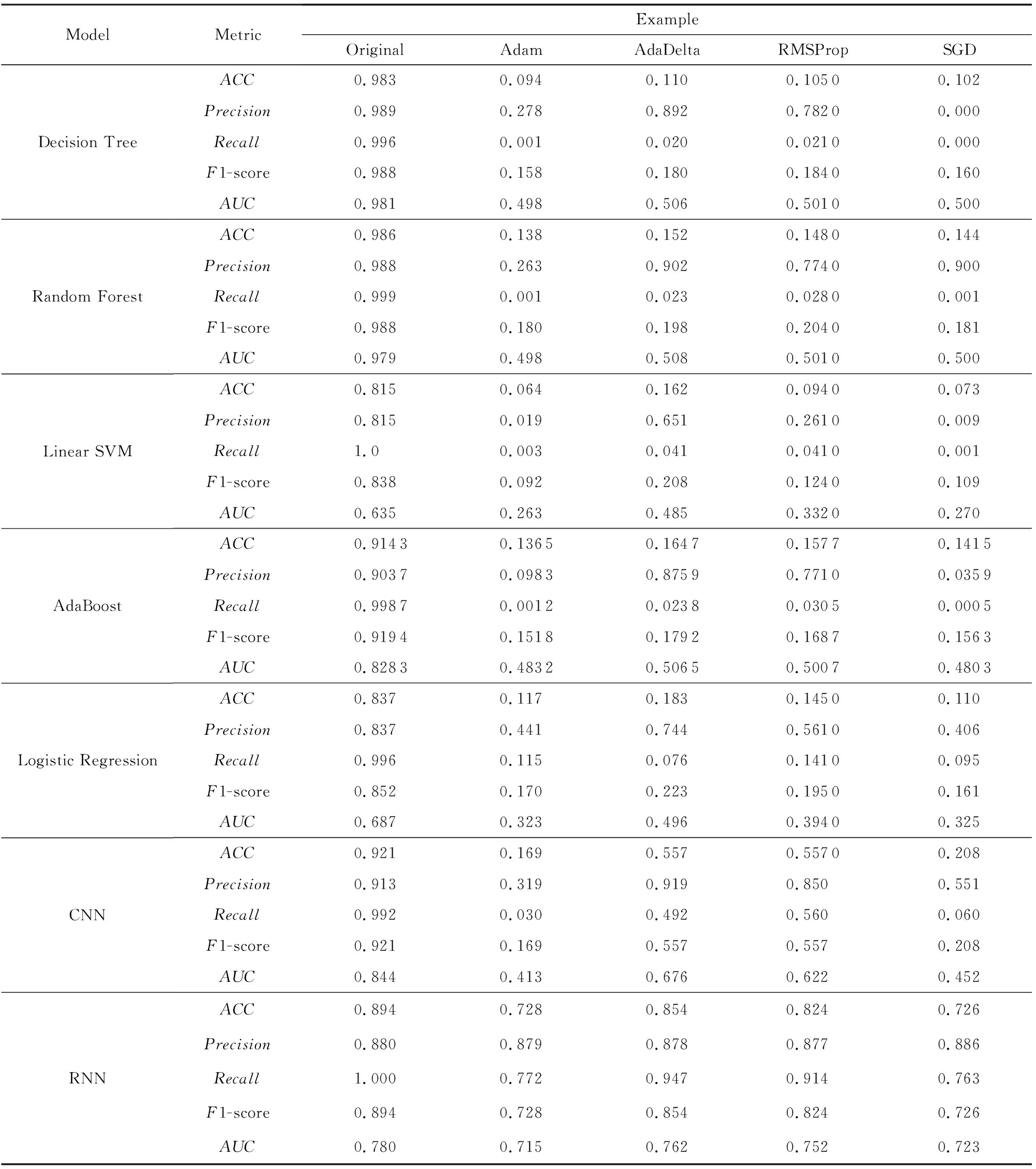

表5給出了各個機器學習算法在原樣本、SGD樣本、RMSProp樣本、Adam樣本和AdaDelta樣本下進行測試而產生的各個指標值的結果,包括準確率、精準率、召回率、F1-score和AUC(ROC曲線的面積).我們觀察到:

1) 所有對抗樣本對典型機器學習算法和卷積神經網絡學習算法都具有攻擊性;相比之下,循環神經網絡學習算法卻表現出很好的抗各類對抗樣本黑盒攻擊的能力.

Table 5 Comparison of Machine Learning Algorithms in Resisting Adversarial Example Black-Box Attacks表5 機器學習算法抗對抗樣本黑盒攻擊的能力比較

2) AdaDelta樣本在4種對抗樣本中的黑盒攻擊能力最弱,Adam樣本的黑盒攻擊能力最強,這2點與在白盒攻擊實驗中的結果一致.

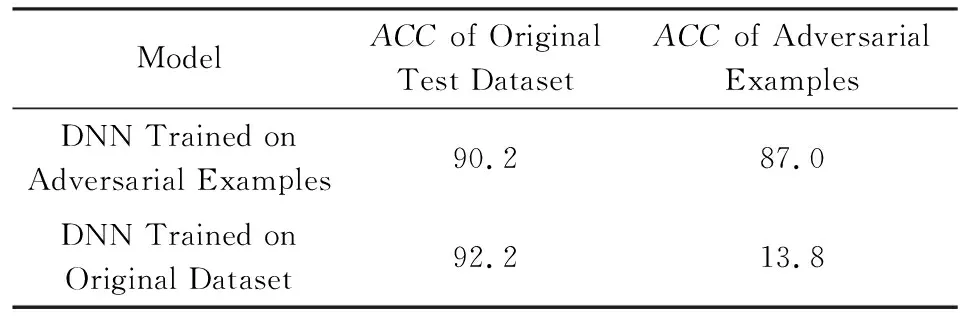

3.3 對抗樣本訓練

表6給出了對抗樣本訓練對DNN防御對抗樣本白盒攻擊的能力的影響,采用了Adam優化算法.原樣本訓練的DNN模型對原樣本測試集進行測試的結果為92.2%,而在對抗樣本測試集的結果為13.8%.對抗樣本訓練的DNN模型對原樣本測試集進行測試的結果為90.2%,比原樣本訓練的DNN模型的ACC結果小;而在對抗樣本測試集的結果為87%,比原樣本訓練的DNN模型的ACC結果有巨大提升,說明對抗訓練確實提高深度學習模型的抗攻擊能力.

Table 6 Effect of Adversarial Example Training on the DNN Capability in Resisting White-Box Attacks

表6 對抗樣本訓練對對抗白盒攻擊能力的影響 %

4 總結與未來工作

工業控制系統是關系國家安全的重要基礎設施的組成部分,入侵檢測機制可以降低或消除各種威脅給工控系統帶來的危害.隨著機器學習算法在工控系統入侵檢測中的日益推廣,機器學習算法自身的安全問題也越來越受到關注.本文針對一個公開的低維天然氣工控網數據集,通過構建實驗來研究對抗樣本的白盒攻擊和黑盒攻擊力.實驗結果顯示低維工控網絡數據集下的對抗樣本攻擊特點與其他非工控網絡數據集的實驗結果有差別.實驗結論為:

1) Adam模型能夠高效并快速生成對抗樣本;

2) Adam模型生成的對抗樣本白盒攻擊能力最強,AdaDelta模型生成的對抗樣本白盒攻擊能力最弱;

3) 對抗樣本對各個典型機器學習算法具有黑盒攻擊能力,其中RNN對黑盒攻擊的抗擊能力最好;

4) 對抗樣本訓練能夠提高深度學習模型防御對抗樣本白盒攻擊的能力.

需要指出的是,本文只探討了提高深度學習模型的抗白盒攻擊的能力,未來工作之一是研究如何提高深度學習算法抗黑盒攻擊的能力.此外,我們將在更多的工控網數據集上檢測我們的實驗結論,并分析這些實驗現象的潛在機理.