基于卷積神經(jīng)網(wǎng)絡(luò)的隧道掌子面圖像質(zhì)量評(píng)價(jià)方法研究

鮮晴羽,仇文革,王泓穎,許煒萍,孫克國

基于卷積神經(jīng)網(wǎng)絡(luò)的隧道掌子面圖像質(zhì)量評(píng)價(jià)方法研究

鮮晴羽,仇文革,王泓穎,許煒萍,孫克國

(西南交通大學(xué) 交通隧道工程教育部重點(diǎn)實(shí)驗(yàn)室,四川 成都 610000)

鑒于隧道掌子面圖像的多樣性和復(fù)雜性,提出一種基于深度卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)的圖像質(zhì)量評(píng)價(jià)方法,以篩選出滿足工程需求的掌子面圖像。基于多條隧道創(chuàng)建掌子面圖像數(shù)據(jù)集,采用Keras深度學(xué)習(xí)框架,應(yīng)用多種主流的CNN進(jìn)行對(duì)比試驗(yàn),并結(jié)合傳統(tǒng)的圖像評(píng)價(jià)指標(biāo),分別從清晰度、分類和相似度3個(gè)方面對(duì)掌子面圖像質(zhì)量進(jìn)行評(píng)價(jià)。其中基于DenseNet169的多分類模型可達(dá)到88.7%的準(zhǔn)確率。研究結(jié)果表明:跟傳統(tǒng)的圖像處理技術(shù)相比,深度學(xué)習(xí)方法在隧道掌子面圖像識(shí)別上具有精度高、效率高的顯著優(yōu)勢(shì)。該方法可為實(shí)現(xiàn)隧道掌子面的自動(dòng)素描提供技術(shù)支持,具有良好的工程應(yīng)用前景。

隧道;圖像質(zhì)量評(píng)價(jià);卷積神經(jīng)網(wǎng)絡(luò);掌子面;深度學(xué)習(xí)

隧道建設(shè)受控于工程地質(zhì)條件,準(zhǔn)確地掌握掌子面地質(zhì)條件對(duì)安全、快速的隧道建設(shè)至關(guān)重要。掌子面是工程地質(zhì)條件最準(zhǔn)確和直觀的反映,地質(zhì)工程師須進(jìn)行實(shí)時(shí)、快速的地質(zhì)素描。基于獲取的掌子面節(jié)理信息、巖體完整程度和地下水發(fā)育狀態(tài)等,結(jié)合相關(guān)規(guī)范進(jìn)行地質(zhì)編錄、圍巖分級(jí),從而指導(dǎo)支護(hù)選型和實(shí)現(xiàn)信息化施工。但人工地質(zhì)素描存在強(qiáng)度大、效率低、危險(xiǎn)系數(shù)高、數(shù)據(jù)共享率低等問題。在此背景下,掌子面自動(dòng)素描技術(shù)應(yīng)運(yùn)而生:通過對(duì)隧道掌子面照相,采用圖像處理技術(shù),自動(dòng)提取掌子面節(jié)理等信息,據(jù)此定量計(jì)算巖體完整程度,以便圍巖分級(jí)。該技術(shù)有益于降低地質(zhì)工程師的工作強(qiáng)度、保障人身安全,大幅推動(dòng)隧道信息化和智能化施工進(jìn)程。獲取質(zhì)量合格的掌子面圖像是掌子面自動(dòng)素描技術(shù)的基本前提。然而受施工環(huán)境、現(xiàn)場設(shè)備和技術(shù)人員拍照技術(shù)水平的限制,拍攝的掌子面圖像時(shí)常“不合格”,出現(xiàn)諸如模糊、光線太暗、明暗不均、有遮擋、沒有拍全等情況。同一個(gè)掌子面的多張圖像質(zhì)量往往參差不齊,此時(shí)須甄別出合格的圖像,并進(jìn)行實(shí)時(shí)反饋,篩選出真實(shí)反映當(dāng)前掌子面情況的圖像。隧道掌子面圖像具有多樣性和復(fù)雜性的特點(diǎn),傳統(tǒng)處理技術(shù)在圖像質(zhì)量判別上的表現(xiàn)差強(qiáng)人意。近年來,深度學(xué)習(xí)的快速發(fā)展給計(jì)算機(jī)視覺領(lǐng)域提供了一條全新的思路:采用深度學(xué)習(xí)技術(shù)進(jìn)行圖像識(shí)別,從而評(píng)價(jià)圖像質(zhì)量的好壞,彌補(bǔ)了傳統(tǒng)技術(shù)的不足,使掌子面自動(dòng)素描成為可能。深度學(xué)習(xí)在計(jì)算機(jī)視覺、語音識(shí)別和自然語言處理等方面已取得重大突破。卷積神經(jīng)網(wǎng)絡(luò)是一種常見的深度學(xué)習(xí)架構(gòu),廣泛應(yīng)用于圖像分類、檢測和分割等方面。對(duì)于圖像分類問題,合理提取圖像特征是決定分類正確與否的關(guān)鍵。傳統(tǒng)的圖像處理技術(shù)通常是采用人為設(shè)計(jì)手工提取圖像特征,準(zhǔn)確率和效率均較為低下。卷積神經(jīng)網(wǎng)絡(luò)可以從訓(xùn)練數(shù)據(jù)中學(xué)習(xí)到更高層次、更加抽象的特征,在圖像分類中表現(xiàn)超強(qiáng),遠(yuǎn)勝傳統(tǒng)方法。層出不窮的CNN模型不斷刷新記錄,也展示著該領(lǐng)域的研究熱度,具有代表性的如AlexNet[1],VGG[2],ResNet[3],Xception[4]和DenseNet[5]等。圖像質(zhì)量評(píng)價(jià)分為有參考和無參考2種模式,本文屬于后者。在無參考圖像質(zhì)量評(píng)價(jià)中,圖像的清晰度是衡量圖像質(zhì)量優(yōu)劣的重要指標(biāo)。徐貴力等[6]提出了一種基于圖像邊緣灰度變化率的算法用以評(píng)價(jià)圖像的清晰度。李郁峰等[7]提出了灰度方差乘積法,該方法計(jì)算性能較好,但其靈敏度在焦點(diǎn)附近不高。Horita 等[8]在WANG等[9]的研究基礎(chǔ)上針對(duì)JPEG壓縮圖片定義了全新的質(zhì)量指標(biāo)。李祚林等[10]基于面向無參考圖像質(zhì)量評(píng)價(jià),介紹了多種具有代表性的清晰度評(píng)價(jià)算法,并將對(duì)它們各種性能進(jìn)行了對(duì)比和分析。圖像相似度算法的關(guān)鍵在于提取具有高穩(wěn)定性、高匹配度的局部特征。傳統(tǒng)算法中,尺度不變特征(SIFT)算法[11]由加拿大英屬哥倫比亞大學(xué)的David Lowe教授于1999年首次提出并于2004年總結(jié)完善,常應(yīng)用于特征提取和匹配算法。吳偉交[12]基于SIFT特征點(diǎn)進(jìn)行了圖像匹配試驗(yàn),取得了較好的結(jié)果。圖像哈希算法[13]也稱為圖像感知哈希或魯棒哈希,在圖像認(rèn)證和識(shí)別領(lǐng)域應(yīng)用廣泛。劉兆慶等[14]則提出了一種基于SIFT的圖像哈希算法。近年來隨著深度學(xué)習(xí)技術(shù)的發(fā)展,基于CNN的相似度算法在人臉識(shí)別等方面引起諸多研究者的關(guān)注[15?17]。CNN在圖像識(shí)別領(lǐng)域應(yīng)用廣泛,但是在特定場景下的研究尚為欠缺,隧道掌子面處的環(huán)境復(fù)雜,尤以光線差、空氣污濁為代表。本文針對(duì)隧道掌子面圖像,對(duì)當(dāng)下幾種主流的CNN網(wǎng)絡(luò)模型展開了對(duì)比研究,以選取合適的圖像分類模型,并結(jié)合清晰度和相似度算法,提出了一種基于卷積神經(jīng)網(wǎng)絡(luò)的掌子面圖像質(zhì)量評(píng)價(jià)方法,從而為掌子面的自動(dòng)素描提供技術(shù)支持。

1 掌子面圖像質(zhì)量評(píng)價(jià)算法

1.1 總體思路

圖像質(zhì)量評(píng)價(jià)方法依次包括清晰度判定、圖像分類和相似度判定3個(gè)方面。首先對(duì)掌子面圖像進(jìn)行清晰度判定,再將篩選出來的清晰圖像進(jìn)行分類,最后通過相似度判別降低重復(fù)率。其中,清晰度判定是基礎(chǔ),圖像分類是核心,相似度判別是進(jìn)一步保障。具體算法和流程如圖1所示。

1.2 圖像清晰度算法

對(duì)于無參考模式的隧道掌子面圖像,通過多種清晰度算法的對(duì)比分析,從而確定科學(xué)的清晰度算法。基于 Python實(shí)現(xiàn)Brenner梯度函數(shù)、Tenengrad梯度函數(shù)和Laplacian梯度函數(shù)等6種算法。

圖1 隧道掌子面圖像質(zhì)量評(píng)價(jià)算法

對(duì)于二分類問題(本文指掌子面圖像清晰或模糊),根據(jù)混淆矩陣(Confusion Matrix),分類器預(yù)測結(jié)果分為4種情況:真正例(TP)、假正例(FP)、真反例(TN)及假反例(FN)。準(zhǔn)確率(Accuracy)是指分類正確的樣本個(gè)數(shù)占總樣本個(gè)數(shù)的比例,表達(dá)式如下:

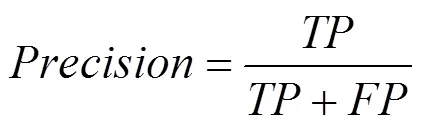

查準(zhǔn)率(Precision)是指分類正確的正樣本個(gè)數(shù)占分類器判定為正樣本的樣本個(gè)數(shù)的比例,表達(dá)式如下:

查全率(Recall)是指分類正確的正樣本個(gè)數(shù)占真正的正樣本個(gè)數(shù)的比例,表達(dá)式如下:

1值是查準(zhǔn)率和召回率的調(diào)和平均值,表達(dá)式如下:

準(zhǔn)確率是分類中最簡單和直觀的評(píng)價(jià)指標(biāo),但當(dāng)不同類別下的樣本比例十分不均衡時(shí),占比大的那類易主導(dǎo)準(zhǔn)確率。P-R曲線刻畫的是查準(zhǔn)率和查全率之間的關(guān)系,對(duì)比不同分類器即6種算法所對(duì)應(yīng)的P-R曲線,選擇性能較優(yōu)的那一個(gè)。再通過計(jì)算查準(zhǔn)率和查全率的調(diào)和平均1值尋找該分類器較優(yōu)的閾值。

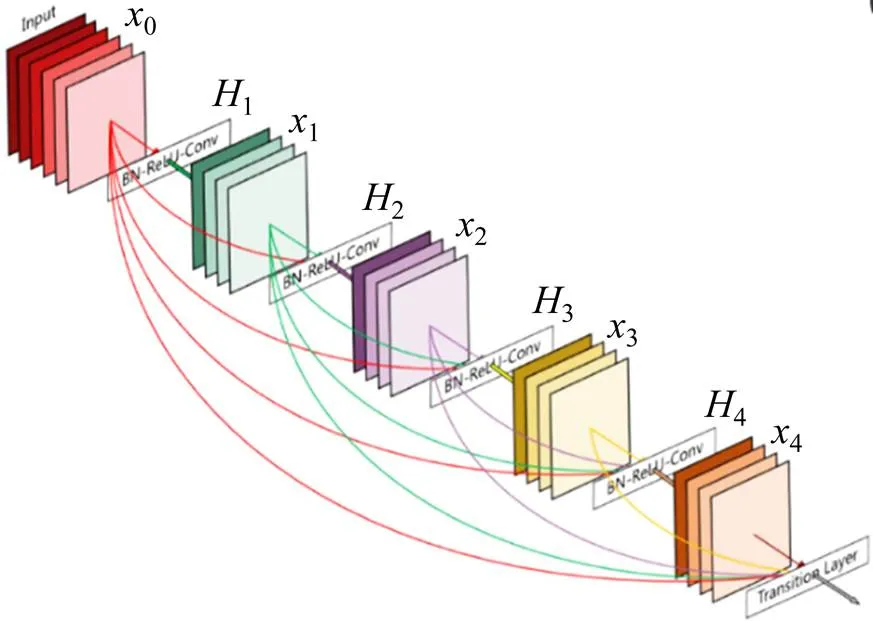

1.3 圖像分類算法

1.3.1 隧道掌子面數(shù)據(jù)集的建立

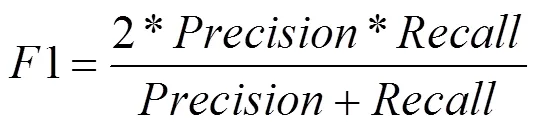

通過采集多條隧道不同里程和不同地質(zhì)條件下的掌子面照片,經(jīng)過人工清洗和標(biāo)注,生成一個(gè)符合深度學(xué)習(xí)多分類模型訓(xùn)練的數(shù)據(jù)集。考慮到施工現(xiàn)場諸多干擾因素(人、機(jī)、光線等)和拍攝條件限制,結(jié)合拍攝呈現(xiàn)出來內(nèi)容和特征,掌子面圖像可分和不合格2類。其中,合格細(xì)分為3類:明顯輪廓線、模糊輪廓線和臺(tái)階;不合格細(xì)分為7類:局部帶拱、局部不帶拱、有人/人影遮擋、有機(jī)械/機(jī)影遮擋、有巖渣遮擋、光線不好和有集中光源。每種分類對(duì)應(yīng)的標(biāo)簽及備注見表1。建立的數(shù)據(jù)集包含 4 014 張圖像,其中3 607 張作為訓(xùn)練集,407張作為驗(yàn)證集,劃分比例為9:1,具體的數(shù)據(jù)集分布見表2。10類掌子面圖像的典型代表如圖2所示。

表1 數(shù)據(jù)標(biāo)注

表2 數(shù)據(jù)集分布

1.3.2 網(wǎng)絡(luò)結(jié)構(gòu)

作為深度學(xué)習(xí)的代表算法之一,CNN是一類包含卷積結(jié)構(gòu)的深度前饋神經(jīng)網(wǎng)絡(luò),通常由輸入層、隱含層和輸出層3部分組成。

圖2 1~10類掌子面圖像

1) 輸入層是模型的入口,在計(jì)算機(jī)視覺領(lǐng)域,通常一個(gè)樣本對(duì)應(yīng)一個(gè)三維數(shù)據(jù),即平面上的二維像素點(diǎn)(0~255)和RGB三通道。

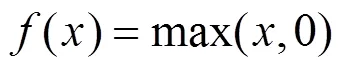

2) 隱含層包含卷積層、池化層及全連接層,其中,卷積層和池化層是CNN特有結(jié)構(gòu), 基本順序一般為:輸入?卷積層?池化層?全連接層?輸出。卷積層中常用的非線性激活函數(shù)有:Sigmoid函數(shù)、雙曲正切函數(shù)、ReLu函數(shù)及其變體Leaky ReLu函數(shù)等。其中,ReLu函數(shù)具有收斂速度快、梯度求解簡單等特點(diǎn),在CNN中應(yīng)用廣泛,表達(dá)式如下:

3) CNN輸出層的結(jié)構(gòu)和工作原理與傳統(tǒng)的前饋神經(jīng)網(wǎng)絡(luò)中相同,其上一層通常為全連接層,這里便不再贅述。對(duì)于圖像多分類問題,輸出層一般采用歸一化指數(shù)函數(shù)(Softmax Function)作為分類器輸出分類結(jié)果,表達(dá)式如下:

Softmax將多個(gè)神經(jīng)元的輸出,映射到(0,1)區(qū)間內(nèi),可理解為概率值,所有概率值之和為1,最大概率值對(duì)應(yīng)的分類即為正解,從而實(shí)現(xiàn)多分類。Softmax層的交叉熵?fù)p失函數(shù)表達(dá)式如下:

式中:y表示該樣本對(duì)應(yīng)第類的真值。

將10類圖像和對(duì)應(yīng)標(biāo)簽作為輸入數(shù)據(jù)對(duì)網(wǎng)絡(luò)進(jìn)行訓(xùn)練,采用梯度下降法不斷優(yōu)化損失函數(shù),表達(dá)式如下:

式中:θ表示網(wǎng)絡(luò)中的權(quán)重參數(shù);()為待優(yōu)化的損失函數(shù)。

1.3.3 模型訓(xùn)練與測試

使用Keras深度學(xué)習(xí)框架進(jìn)行模型的訓(xùn)練與測試,模型訓(xùn)練采用基于ImageNet數(shù)據(jù)集的預(yù)訓(xùn)練模型進(jìn)行遷移學(xué)習(xí)。初始學(xué)習(xí)率設(shè)置為 0.001,并使用學(xué)習(xí)率衰減策略,即每一輪進(jìn)行一次衰減,衰減率為0.8。圖片批數(shù)量為4,訓(xùn)練100次全數(shù)據(jù),圖片進(jìn)入網(wǎng)絡(luò)前統(tǒng)一縮放至 299×299 像素大小。

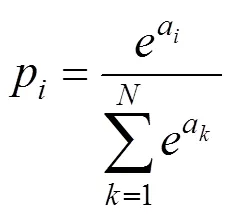

模型訓(xùn)練對(duì)輸入圖像應(yīng)用了多種預(yù)處理方案:旋轉(zhuǎn)、平移、錯(cuò)切變換、放大、改變顏色和水平翻轉(zhuǎn)。通過這些圖像預(yù)處理手段,在一定程度上實(shí)現(xiàn)了數(shù)據(jù)集的擴(kuò)充,能更好地提升模型的準(zhǔn)確率。測試時(shí),輸入新圖像,利用訓(xùn)練完成的模型可直接給出圖像分類結(jié)果。分類模型框架如圖3所示。

圖3 分類模型框架

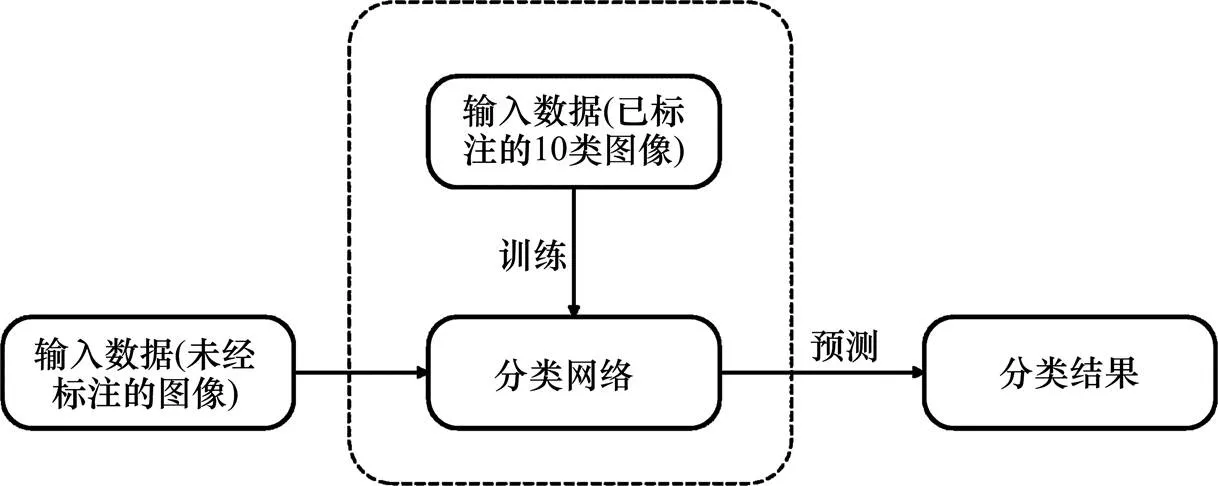

DenseNet網(wǎng)絡(luò)借鑒ResNet網(wǎng)絡(luò)中“抄近路”思想,在不同層之間建立了全新的連接關(guān)系(通道上的疊加),如圖4所示。

圖4 Dense Block結(jié)構(gòu)示意圖

將DenseNet169,Xception,ResNet50以及VGG16模型分別應(yīng)用于掌子面圖像分類中,基于Keras(用Python 編寫的高級(jí)神經(jīng)網(wǎng)絡(luò)API,以 TensorFlow或 Theano 作為后端運(yùn)行)實(shí)現(xiàn),模型訓(xùn)練工作在GPU(1050 Ti)上完成。

1.3.4 可視化分析

深度學(xué)習(xí)因其內(nèi)部算法不可見被人們稱為“黑盒子”,但是CNN能夠?qū)崿F(xiàn)可視化。ZFNet[18]為CNN可視化的開山之作,其通過對(duì)AlexNet進(jìn)行可視化,并根據(jù)可視化結(jié)果進(jìn)行優(yōu)化研發(fā)而成。利用反卷積實(shí)現(xiàn)可視化,可深入了解識(shí)別圖像的過程:CNN是從底層到高層,從抽象到具體來學(xué)習(xí)特征的,同時(shí)該可視化為我們改進(jìn)網(wǎng)絡(luò)結(jié)構(gòu)提供了可能。

可視化主要有4種模式:1) 卷積核輸出的可視化;2) 卷積核的可視化;3) 類激活圖可視化; 4) 特征可視化。本文采用第3種可視化模式,通過熱度圖,了解對(duì)圖像分類起關(guān)鍵作用的具體部位,同時(shí)可以定位圖像中物體的具體位置,以對(duì)分類結(jié)果進(jìn)行輔助驗(yàn)證。

1.4 圖像相似度算法

將第2步分類中訓(xùn)練好的CNN模型作為特征提取器以獲取圖像特征,生成唯一特征向量,將待判別圖像與數(shù)據(jù)庫里既有圖像進(jìn)行對(duì)比,根據(jù)特征向量計(jì)算相似度,選擇合適閾值,滿足閾值要求的圖片即為相似圖片。常用的相似度指標(biāo)有:余弦相似度、歐式距離和漢明距離等。在文本、圖像和視頻等領(lǐng)域,研究對(duì)象的特征維度往往很高,余弦相似度在高維情況下仍然保持:相同時(shí)為1,正交時(shí)為0,相反時(shí)為?1,這體現(xiàn)了方向上的相似性。受拍攝角度、距離、光線等的影響,同一個(gè)掌子面拍攝的照片可能在亮度、尺寸、長寬比等方面存在波動(dòng),計(jì)算圖像特征在方向上的差異相較于計(jì)算數(shù)值上的差異更能反映真實(shí)情況,故這里采用余弦相似度作為相似度指標(biāo),表達(dá)式如下:

其中:A,B分別代表特征向量,的各分量。

給出的相似性范圍是從?1到1,?1意味著2個(gè)向量的方向截然相反,1表示它們的方向完全相同的,0通常表示它們是相對(duì)獨(dú)立的,而在?1,0或0,1之間的值則表示不同程度的相似性或相異性。本文研究的相似度判別是指:將新輸入的掌子面圖片和數(shù)據(jù)庫里既有的圖像進(jìn)行對(duì)比,若判定相似,則說明該掌子面的圖像已存在從而駁回,否則,則將其視為新的掌子面圖像而接收。

2 試驗(yàn)結(jié)果與分析

2.1 圖像清晰度試驗(yàn)

經(jīng)過大量試驗(yàn),Laplacian算法的計(jì)算速度、區(qū)分度以及在P-R曲線上的表現(xiàn),都較其他算法有明顯優(yōu)勢(shì),且與人眼判定基本相符。其梯度函數(shù)采用Laplacian算子提取梯度值,因此基于Laplacian梯度函數(shù)的圖像清晰度可定義如下:

式中:是給定的邊緣檢測閾值;(,)是像素點(diǎn)(,)處Laplacian算子的卷積。

這里展示3組測試數(shù)據(jù)在6種清晰度算法下各自的得分。為方便對(duì)比,每組中的4張圖像均采集于同一或相鄰掌子面,它們處于不同的清晰級(jí)別,且根據(jù)人眼判定從模糊到清晰依次排列,以第一組為例,清晰度排序:1?1<1?2<1?3<1?4,其它組同理,具體如表3所示。圖5展示了第2組測試圖像。分析數(shù)據(jù)得出,6種算法對(duì)每組圖像的評(píng)分和人眼判定順序基本一致,評(píng)分越高,圖像越清晰。

表3 清晰度評(píng)分

(a) 2-1模糊(6.0);(b) 2-2模糊(15.0);(c) 2-3模糊(19.0);(d) 2-4清晰(21.1)

結(jié)合相關(guān)文獻(xiàn),Laplacian算法的初始化閾值為10,上限為30,以1為步長遞增,試驗(yàn)結(jié)果表明,當(dāng)閾值取21時(shí),1值可取到最大,此時(shí)準(zhǔn)確率也達(dá)到98%,故設(shè)定閾值為21。得分小于21,則判定模糊,大于21,則判定清晰。實(shí)際運(yùn)用中,大部分圖像在清晰度的表現(xiàn)上基本合格,此階段過濾掉的圖像較少,但此步驟仍然不可或缺。

2.2 圖像分類試驗(yàn)

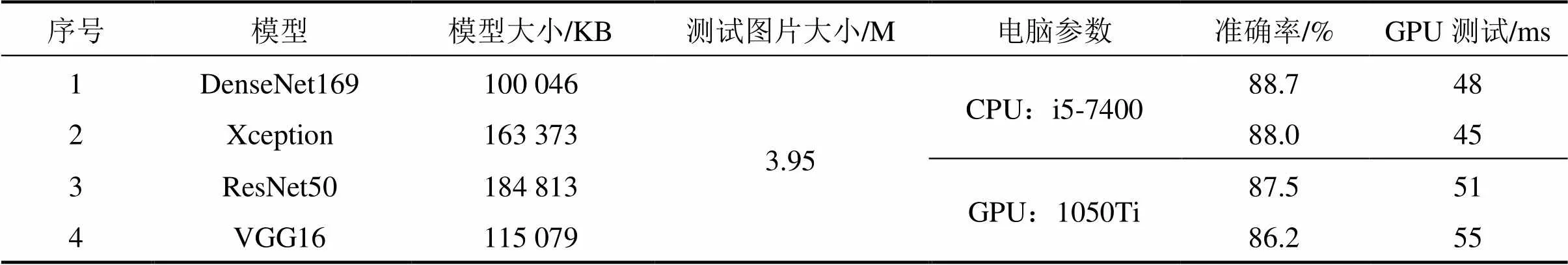

構(gòu)建的模型中最后1層使用的是Softmax分類器,預(yù)測時(shí),對(duì)提取的深層卷積特征進(jìn)行分類,輸出為每一類的概率值(見式(6)),取概率最大值為預(yù)測結(jié)果,和真實(shí)標(biāo)簽比較,統(tǒng)計(jì)結(jié)果得到在驗(yàn)證集上的準(zhǔn)確率.分別訓(xùn)練了4個(gè)模型(DenseNet169,Xception,ResNet50和VGG16),經(jīng)過大量的調(diào)參訓(xùn)練,結(jié)果如表4所示,保存的模型為訓(xùn)練過程中驗(yàn)證集損失最小時(shí)的模型,準(zhǔn)確率即為此時(shí)該模型在驗(yàn)證集上的準(zhǔn)確率。以DenseNet169為例,圖6展示了DenseNet169模型在100輪的訓(xùn)練過程中準(zhǔn)確率(見式(1))和損失函數(shù)(見式(7))的變化曲線。

表4 不同模型的訓(xùn)練結(jié)果

(a) 模型準(zhǔn)確率;(b) 模型損失量

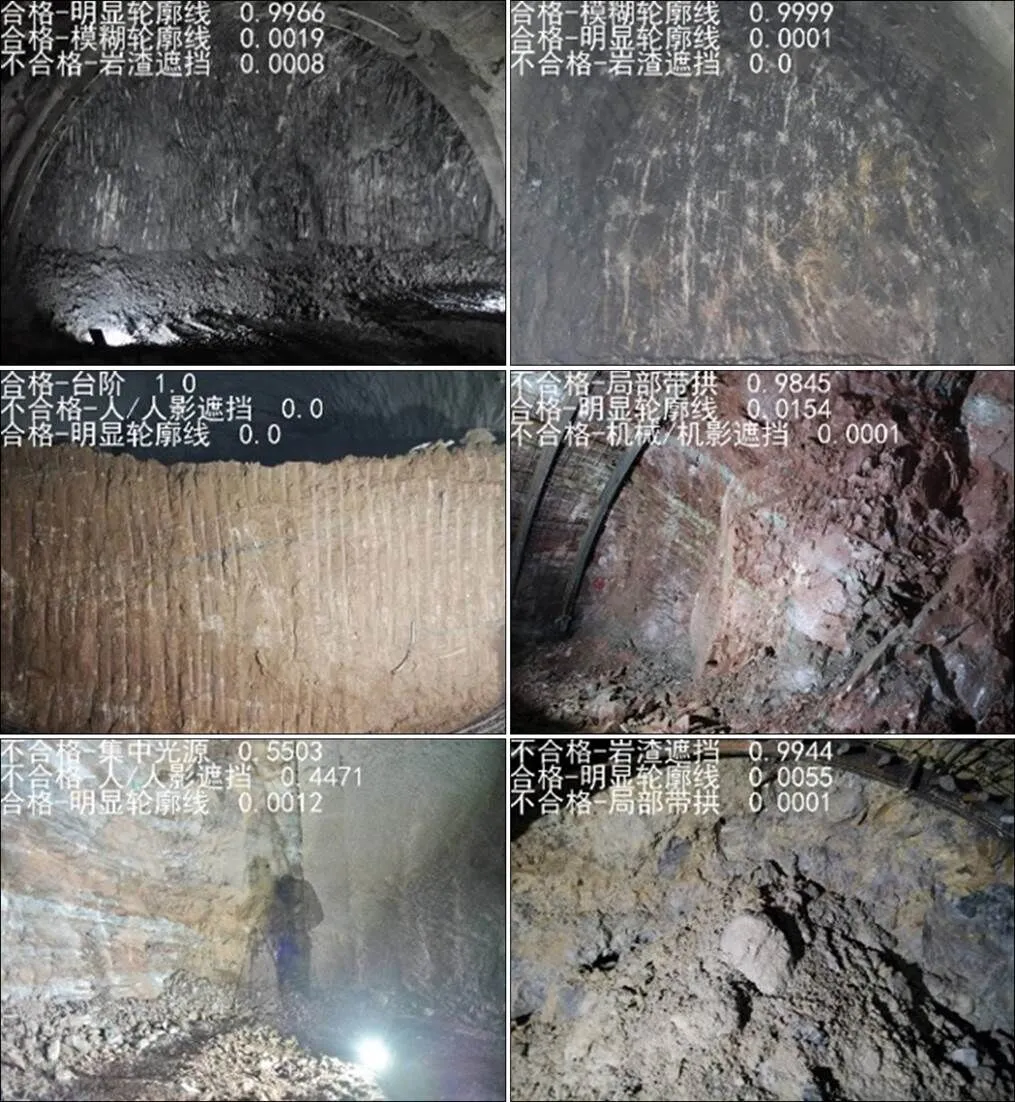

綜合考慮模型的準(zhǔn)確率和在GPU上的實(shí)測時(shí)間,選定DenseNet169模型作為掌子面圖像分類網(wǎng)絡(luò)。部分預(yù)測結(jié)果如圖7所示。

圖中展示了概率前3的預(yù)測結(jié)果及其對(duì)應(yīng)的概率值,結(jié)果基本和人眼判定相符。實(shí)際上,分類正誤取決于數(shù)據(jù)集的“好壞”,數(shù)據(jù)集越大、標(biāo)注越客觀、分布越均衡,越易得到好的訓(xùn)練結(jié)果。

圖7 DenseNet169部分預(yù)測結(jié)果

(a) 原圖;(b) 熱度圖;(c) 疊加圖

以DenseNet169為例,從測試集中選取4張掌子面圖像進(jìn)行基于Keras的CNN類激活圖可視化,將熱度圖疊加到原圖像,獲得對(duì)圖像分類起到關(guān)鍵作用的部分,即熱度圖中的高亮部分,與實(shí)際情況相符,也驗(yàn)證了本文方法的正確性。如圖8所示。

2.3 圖像相似度試驗(yàn)

由于該階段樣本數(shù)量較少,試驗(yàn)中采用了K折交叉驗(yàn)證(=10)以得到可靠穩(wěn)定的模型,相似度閾值初始化為0.800,上限為0.999,以0.001為步長遞增,分別計(jì)算10次試驗(yàn)中準(zhǔn)確率取得最大值時(shí)對(duì)應(yīng)的閾值,再將10次結(jié)果求平均,得到最終的閾值,根據(jù)試驗(yàn)結(jié)果設(shè)定閾值為0.955。

通過清晰度判定和圖像分類后,系統(tǒng)可篩選出基本合格的掌子面圖像。在圖像相似度測試階段,余弦相似度大于0.955,則判定攝于同一個(gè)掌子面,否則,則判定攝于不同掌子面。限于篇幅,僅展示一組測試圖像,具體如圖9所示。

(a) 原圖;(b) 1相同(0.967 7);(c) 2相同(0.958 6);(d) 3不同(0.940 4);(e) 4不同(0.931 6)

3 工程應(yīng)用

以成都天府國際機(jī)場高速公路龍泉山隧道為例,其“兩進(jìn)兩出”龍泉山,設(shè)計(jì)采用了全國首創(chuàng)的“雙向四洞十車道”。4座隧道的長度約4 651 m,車道布置為2+3+3+2,以實(shí)行客貨分流。

通過人工拍攝采集了龍泉山隧道10個(gè)里程處的掌子面圖像300張,每個(gè)掌子面均對(duì)應(yīng)在不同距離、角度、光照等因素影響下的30張圖像,部分圖像展示如圖10所示。

圖10 龍泉山隧道掌子面圖像

經(jīng)過人工標(biāo)記,將該300張圖像輸入本文研發(fā)的掌子面圖像質(zhì)量評(píng)價(jià)方法體系中,依次通過清晰度判定、圖像分類和相似度判別,測試結(jié)果如下:

首先通過清晰度判定模塊,基于閾值21,篩選出了7張模糊圖像,該階段的準(zhǔn)確率、查準(zhǔn)率、查全率和1值分別為94.0%,94.8%,98.9%和96.8%,基本滿足工程要求。將剩下293張滿足清晰度要求的圖像傳入下一模塊即圖像分類。

在圖像分類階段,評(píng)價(jià)方法篩選出92張不合格的圖像,其中大多存在沒拍全、有人影遮擋、有巖渣遮擋和有集中光源的情況,該階段的準(zhǔn)確率為86.3%,接近模型在驗(yàn)證集上的準(zhǔn)確率,說明該模型的泛化能力較好。

最后將剩余的201張掌子面圖像進(jìn)行相似度判別,基于閾值0.955,該階段的準(zhǔn)確率穩(wěn)定在92%左右,基本符合預(yù)期。

通過以上工作完成對(duì)掌子面圖像的質(zhì)量評(píng)價(jià),篩選出滿足工程需求的掌子面圖像,部分如圖11所示。可以看出,經(jīng)本文方法挑選出來的掌子面圖像具備清晰高、完整度好、光線均勻和遮擋物較少等特點(diǎn),為下一步掌子面節(jié)理識(shí)別與自動(dòng)素描提供優(yōu)秀素材。與傳統(tǒng)人工地質(zhì)素描相比,節(jié)省了人力物力,降低了人員要求和施工風(fēng)險(xiǎn),且耗時(shí)更短:以一次性對(duì)同一掌子面拍攝10張圖像為例,傳入本文提出的評(píng)價(jià)體系中,歷經(jīng)清晰度判定?圖像分類?相似度判別3個(gè)階段,基于GPU計(jì)算總耗時(shí)可控制在毫秒級(jí)。此外,借助人工智能和大數(shù)據(jù)技術(shù),實(shí)現(xiàn)了數(shù)據(jù)共享,推動(dòng)隧道施工信息化和智能化進(jìn)程。

圖11 龍泉山隧道合格掌子面圖像

4 結(jié)論

1) 提出一種基于深度卷積神經(jīng)網(wǎng)絡(luò)的隧道掌子面圖像質(zhì)量評(píng)價(jià)方法:從清晰度、分類和相似度3個(gè)方面依次對(duì)掌子面圖像質(zhì)量進(jìn)行評(píng)價(jià),過濾掉不合格的圖像,最后成功篩選出能滿足要求的掌子面圖像。具有耗時(shí)短、反饋及時(shí)的優(yōu)點(diǎn),是隧道掌子面自動(dòng)素描技術(shù)里最基礎(chǔ)且不可或缺的一步,具備較高的工程應(yīng)用價(jià)值。

2) 基于DenseNet169網(wǎng)絡(luò)的分類模型與掌子面圖像數(shù)據(jù)集的適應(yīng)性最好,準(zhǔn)確率可達(dá)88.7%。

3) 以Laplacian梯度函數(shù)為指標(biāo)的清晰度判定和基于CNN圖像特征提取以余弦相似度為指標(biāo)的相似度判定,可用于隧道掌子面照片質(zhì)量評(píng)價(jià)體系,且效果優(yōu)良。

受時(shí)間、人力和物力所限,數(shù)據(jù)集的數(shù)量和質(zhì)量尚存較大的提升空間,將來應(yīng)注重?cái)?shù)據(jù)集的擴(kuò)充,改善人工標(biāo)注,解決分布不平衡問題,完善和健全數(shù)據(jù)集。此外,探究不同的深度學(xué)習(xí)框架對(duì)訓(xùn)練結(jié)果的影響以尋找最優(yōu)方案、進(jìn)一步調(diào)整和改進(jìn)CNN網(wǎng)絡(luò)結(jié)構(gòu)也可作為未來的研究方向。

[1] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv:1409.1556, 2014.

[2] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, America, 2016: 770?778.

[3] Chollet F. Xception: Deep learning with depthwise separable convolutions[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Hawaii, America, 2017: 1251?1258.

[4] Szegedy C, LIU W, JIA Y, et al. Going deeper with convolutions[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Boston America, 2015: 1?9.

[5] HUANG G, LIU Z, Van Der Maaten L, et al. Densely connected convolutional networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Hawaii, America, S 2017: 4700?4708.

[6] 徐貴力, 劉小霞, 田裕鵬, 等. 一種圖像清晰度評(píng)價(jià)方法[J]. 紅外與激光工程, 2009, 38(1): 180?184. XU Guili, LIU Xiaoxia, TIAN Yupeng, et al.Image clarity-evaluation-function method[J].Infrared and Laser Engineering, 2009, 38(1): 180?184.

[7] 李郁峰, 陳念年, 張佳成. 一種快速高靈敏度聚焦評(píng)價(jià)函數(shù)[J]. 計(jì)算機(jī)應(yīng)用研究, 2010, 27(4): 1534?1536. LI Yufeng, CHEN Niannian, ZHANG Jiacheng.Fast and high sensitivity focusing evaluation function[J].Application Research of Computers, 2010, 27(4): 1534? 1536.

[8] Horita Y, Arata S, Murai T. No-reference image quality assessment for JPEG/JPEG2000 coding[C]// 2004 12th European Signal Processing Conference. IEEE, 2004: 1301?1304.

[9] WANG Z, Sheikh H R, Bovik A C. No-reference perceptual quality assessment of JPEG compressed images[C]// Proceedings of the International Conference on Image Processing. IEEE, 2002, 1: I-I.

[10] 李祚林, 李曉輝, 馬靈玲, 等. 面向無參考圖像的清晰度評(píng)價(jià)方法研究[J]. 遙感技術(shù)與應(yīng)用, 2011, 26(2): 239?246. LI Zuolin, LI Xiaohui, MA Lingling, et al.Research on clarity assessment method for no-reference images[J]. Remote Sensing Technology and Application, 2011, 26(2): 239?246.

[11] Lowe D G. Distinctive image features from scale- invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91?110.

[12] 吳偉交. 基于SIFT特征點(diǎn)的圖像匹配算法[D].武漢:華中科技大學(xué), 2013. WU Weijiao. Image matching algorithm based on SIFT feature points[D]. Wuhan:Huazhong University of Science and Technology, 2013.

[13] Swaminathan A, MAO Y, WU M. Robust and secure image hashing[J]. IEEE Transactions on Information Forensics and Security, 2006, 1(2): 215?230.

[14] 劉兆慶, 李瓊, 劉景瑞, 等. 一種基于SIFT的圖像哈希算法[J]. 儀器儀表學(xué)報(bào), 2011, 32(9): 2024?2028. LIU Zhaoqing, LI Qiong, LIU Jingrui, et al.An image hashing algorithm based on SIFT[J]. Chinese Journal of Scientific Instrument, 2011, 32(9): 2024?2028.

[15] Chopra S, Hadsell R, LeCun Y. Learning a similarity metric discriminatively, with application to face verification[C]// CVPR (1), 2005: 539?546.

[16] Zagoruyko S, Komodakis N. Learning to compare image patches via convolutional neural networks[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 4353?4361.

[17] Bell S, Bala K. Learning visual similarity for product design with convolutional neural networks[J]. ACM Transactions on Graphics, 2015, 34(4): 98: 1?98: 10.

[18] Zeiler M D, Fergus R. Visualizing and understanding convolutional networks[C]// European Conference on Computer Vision. Springer, Cham, 2014: 818?833.

Research on image quality assessment method of tunnel face based on convolutional neural network

XIAN Qingyu, QIU Wenge, WANG Hongying, XU Weiping, SUN Keguo

(Key Laboratory of Transportation Tunnel Engineering, Ministry of Education, Southwest Jiaotong University, Chengdu 610000, China)

In view of the diversity and complexity of tunnel face images, an image quality assessment method based on deep convolution neural network was proposed to select tunnel face images to meet engineering needs. A tunnel face image dataset based on several tunnels was created. The Keras deep learning framework was adopted. Various mainstream convolutional neural networks (CNN) were applied to carry out comparative experiments. Combining with traditional image evaluation indexes, the tunnel face image quality was evaluated from three aspects: clarity, classification and similarity. The multi-classification model based on DenseNet169 achieved 88.7% accuracy. The results show that, compared with the traditional image processing technologies, the deep learning method has the remarkable advantages of high accuracy and high efficiency in tunnel face image recognition. This method can provide technical support for realizing automatic sketch of tunnel face, and it has a good prospect in engineering application.

tunnel; image quality assessment; convolutional neural network; tunnel face; deep learning

U45

A

1672 ? 7029(2020)03 ? 0563 ? 10

10.19713/j.cnki.43?1423/u.T20190586

2019?06?29

國家自然科學(xué)基金資助項(xiàng)目(51678495,51578463)

許煒萍(1981?),女,山東德州人,副教授,從事地下工程施工過程力學(xué)與動(dòng)力學(xué)效應(yīng)研究;E?mail:xwp1981@126.com

(編輯 涂鵬)