無監(jiān)督遷移學(xué)習(xí)紅外行為識別

黑鴻中,肖兒良,簡獻(xiàn)忠

(上海理工大學(xué) 光電信息與計算機(jī)工程學(xué)院,上海 200093)

1 引 言

紅外熱成像對光照變化具有較強(qiáng)的魯棒性,在光照條件較差的情況下,可見光視頻中幾乎看不到人,而紅外視頻可以很好的捕捉到人體,因此可用于24小時監(jiān)控[1].此外,紅外熱成像可以很好的抑制陰影、背景雜波和遮擋等比人體或者運(yùn)動物體溫度低的干擾.由于這些特性,紅外行為識別可以應(yīng)用到可見光行為識別難以勝任的一些應(yīng)用場景,并必將成為未來計算機(jī)視覺研究的一個熱點.然而現(xiàn)在利用深度學(xué)習(xí)和機(jī)器學(xué)習(xí)對紅外行為識別的研究,需要大量的紅外動作數(shù)據(jù)集支撐,目前可供研究的紅外數(shù)據(jù)集有限,造成紅外行為識別的識別率較低[2],迫切需要開發(fā)大量的紅外數(shù)據(jù)集,據(jù)了解目前需要通過人工繁瑣標(biāo)注大量的數(shù)據(jù)構(gòu)建紅外行為識別數(shù)據(jù)集;在大數(shù)據(jù)的當(dāng)下,每天都有上萬數(shù)據(jù)產(chǎn)生,人工標(biāo)注紅外視頻是一項費(fèi)時費(fèi)力的工作,而且速度得不到保證.相比于紅外行為識別,基于可見光的行為識別已經(jīng)有很多公開的數(shù)據(jù)集,例如KTH[3],HMD51[4],和UCF101[5]等,但是由于可見光和紅外視頻來源于不同的傳感器,數(shù)據(jù)存在于不同的特征空間中,二者之間既有關(guān)聯(lián),也有很大的模態(tài)差異.差異性決定了現(xiàn)有的可見光行為識別模型不能直接用于紅外行為識別,但如果重新開發(fā)與可見光數(shù)據(jù)集具有相同動作的紅外數(shù)據(jù)集就會造成可見光數(shù)據(jù)資源的浪費(fèi),而且增加大量繁瑣的數(shù)據(jù)集建造工作.而二者之間具有的關(guān)聯(lián)性,是否可以將現(xiàn)有的可見光數(shù)據(jù)集應(yīng)用到紅外行為識別中來,還沒有引起足夠的重視.本文對此工作進(jìn)行了探索.

利用可見光動作識別紅外動作要縮小二者之間的模態(tài)差異,因此本文基于遷移學(xué)習(xí)的思想,從已標(biāo)注的源域(可見光數(shù)據(jù))中學(xué)習(xí)到大量領(lǐng)域知識,遷移到目標(biāo)域(紅外數(shù)據(jù))中,縮小可見光和紅外之間的模態(tài)差異,完成目標(biāo)域紅外動作的識別.目前遷移學(xué)習(xí)主要集中在半監(jiān)督域適應(yīng)[6,7],需要加入帶標(biāo)簽的目標(biāo)域訓(xùn)練,或者要求源域和目標(biāo)域具有相同的數(shù)據(jù)結(jié)構(gòu)[8,12],而現(xiàn)實中可能沒有足夠多的帶標(biāo)簽的紅外數(shù)據(jù)可供訓(xùn)練,同時可見光行為動作和紅外動作是異構(gòu)的,二者之間有很大的模態(tài)差異.針對這些問題,本文提出一種用可見光動作(源域)來識別紅外動作(目標(biāo)域)的無監(jiān)督異構(gòu)行為識別算法(UHDIAR),為了將原始目標(biāo)域和源域引入到同一個特征空間中,遷移更多的知識,本文使用了兩個不同的投影,分別將源域和目標(biāo)域投影到同一個對齊的特征空間中,通過這種方式減少了兩個數(shù)據(jù)集之間的模態(tài)差異,同時利用源域和目標(biāo)域數(shù)據(jù)的余弦相似度,引入權(quán)重支持向量機(jī)(W-SVM)重新加權(quán)源域樣本,增加源域中和目標(biāo)域相似度高的樣本權(quán)重,降低異常值的樣本權(quán)重,這樣可以減少負(fù)遷移,提高識別率.

2 相關(guān)工作

目前有許多遷移學(xué)習(xí)算法被提出,根據(jù)在特征遷移過程中目標(biāo)域加標(biāo)簽的情況,特征遷移的文獻(xiàn)大致可分為三類適應(yīng)問題:監(jiān)督學(xué)習(xí)、半監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)[22].監(jiān)督學(xué)習(xí)又稱主動學(xué)習(xí),指源域和目標(biāo)域都被大量標(biāo)記,例如常用的監(jiān)督方法流形對齊,通常使用拉普拉斯矩陣,其目的是在保持每個輸入域拓?fù)涞耐瑫r并發(fā)地匹配相應(yīng)的實例[10,11],但是實際情況沒有大量的有標(biāo)簽源域和目標(biāo)域數(shù)據(jù)供訓(xùn)練.半監(jiān)督域?qū)W習(xí)使用較少的目標(biāo)域標(biāo)簽,減少了對有標(biāo)簽?zāi)繕?biāo)域數(shù)據(jù)的依賴,文獻(xiàn)[12]提出一種新的傳輸弗雷德霍姆多核學(xué)習(xí)(TFMKL)算法來抑制復(fù)雜數(shù)據(jù)中分布的噪聲.在圖像遷移學(xué)習(xí)獲得了較好的效果,但算法需要標(biāo)記少量的目標(biāo)域樣本進(jìn)行訓(xùn)練,且需要源域和目標(biāo)域有相同的數(shù)據(jù)結(jié)構(gòu).無監(jiān)督域自適應(yīng)不需要標(biāo)記目標(biāo)域進(jìn)行訓(xùn)練,例如文獻(xiàn)[9]提出學(xué)習(xí)多個轉(zhuǎn)換,每個域?qū)?yīng)一個轉(zhuǎn)換(TIT),以便將數(shù)據(jù)映射到共享的潛在空間,在這個潛在空間中,域可以很好地對齊,算法將特征向量抽象為圖的頂點,只采用一種模擬的快速整數(shù)算法,而不采用已有的浮點算法進(jìn)行矩陣運(yùn)算.通過對圖像分類、文本分類和文本到圖像識別等多個標(biāo)準(zhǔn)基準(zhǔn)和大規(guī)模數(shù)據(jù)集的廣泛評價,驗證了該方法的優(yōu)越性.然而,TIT方法還沒有應(yīng)用到跨領(lǐng)域的紅外人體動作識別中.因此,本文研究了源域和目標(biāo)域獨(dú)立轉(zhuǎn)移的有效性,將其應(yīng)用于挑戰(zhàn)性更大的可見光到紅外的視頻動作識別中,以獲得跨數(shù)據(jù)集的對齊特征表示.本文工作的主要重點是利用TIT在可見光到紅外的行為識別中進(jìn)行特征對齊,這在相關(guān)文獻(xiàn)及文獻(xiàn)[9]中均沒有涉及.

近年來,一些遷移學(xué)習(xí)方法應(yīng)用到行為識別當(dāng)中,例如,文獻(xiàn)[13]提出同時從不同視角拍攝的視頻對中學(xué)習(xí)一對可轉(zhuǎn)移字典,目的是使每個視頻對具有相同的稀疏表示.利用稀疏表示作為特征,在源視圖中構(gòu)建的分類器可以直接傳輸?shù)侥繕?biāo)視圖.文獻(xiàn)[14]提出異構(gòu)轉(zhuǎn)移判別分析的典型相關(guān)法(HTDCC)來發(fā)現(xiàn)一個有區(qū)別的公共空間,在這個空間中源視角和目標(biāo)視角相互連接,領(lǐng)域知識可以在二者之間相互傳遞.通過同時最小化樣本的類間正則相關(guān)和最大化類內(nèi)正則相關(guān),優(yōu)化了將源視圖和目標(biāo)視圖數(shù)據(jù)映射到公共空間的兩個投影矩陣.不同的源視圖有不同的聯(lián)合權(quán)重分配,每個權(quán)重表示對應(yīng)的源視圖對目標(biāo)視圖的貢獻(xiàn)程度.文獻(xiàn)[15]針對跨視圖動作有不同維度的特征,引入一個判別公共特征空間來連接源視圖和目標(biāo)視圖.學(xué)習(xí)了兩種不同的投影矩陣,將來自兩個不同視角的動作數(shù)據(jù)映射到具有低類內(nèi)多樣性和高類間方差的公共空間中,減少了它們之間的不匹配,分別將來自兩個不同視圖的動作數(shù)據(jù)映射到公共空間.文獻(xiàn)[23]提出跨視點人體動作識別算法,通過捕獲多視點的共同知識實現(xiàn)了對不同視點的人體動作識別.將特定的視圖作為目標(biāo)域,其余視圖作為源域,從而將跨視圖的動作識別組織到跨域的學(xué)習(xí)框架中.算法學(xué)習(xí)了兩個變換矩陣,將不同視圖的原始動作特征轉(zhuǎn)化為一個共同的特征空間,并將原始特征與變換特征相結(jié)合,分別為目標(biāo)域和源域?qū)W習(xí)不同的特征映射函數(shù).文獻(xiàn)[24]為了解決觀察同一行為動作會因視角的不同而發(fā)生很大變化的問題,提出一種基于動作時間結(jié)構(gòu)模型的層次轉(zhuǎn)移的深度學(xué)習(xí)算法,將不同視圖的原始特征空間轉(zhuǎn)換為視圖共享的低維特征空間,并在該空間中共同學(xué)習(xí)這些視圖的字典.可以在無監(jiān)督和有監(jiān)督的跨視圖場景中運(yùn)行.文獻(xiàn)[16]針對正則相關(guān)分析(CCA)在特征提取中沒有考慮結(jié)構(gòu)和跨視圖信息的問題,引入了一種稱為正則稀疏交叉視圖相關(guān)分析(CSCCA)的方法來解決多視圖特征提取問題,通過類內(nèi)樣本之間執(zhí)行稀疏表示來構(gòu)造相似矩陣,將局部流形信息和跨視圖關(guān)聯(lián)引入CCA,在包括多個特征的人臉數(shù)據(jù)集上得到較好的效果.文獻(xiàn)[17]提出利用內(nèi)核流行對齊(KEMA)和對準(zhǔn)廣義編碼器(AGE)的方法將可見光數(shù)據(jù)作為輔助數(shù)據(jù)來提高紅外行為識別的識別率,取得了較好的效果,但是其方法是半監(jiān)督的,可見光數(shù)據(jù)只是作為輔助數(shù)據(jù),且需要大量的目標(biāo)域紅外數(shù)據(jù)來訓(xùn)練.據(jù)了解目前還沒有人實現(xiàn)挑戰(zhàn)性更大的直接利用可見光(源域)視頻動作來識別紅外(目標(biāo)域)視頻動作的跨數(shù)據(jù)集無監(jiān)督行為識別.基于以上研究本文提出了一種新的無監(jiān)督異構(gòu)行為識別方法(UHDIAR),利用可見光動作(源域)來識別紅外動作(目標(biāo)域),不需要標(biāo)記目標(biāo)域進(jìn)行訓(xùn)練.

3 提出的方法

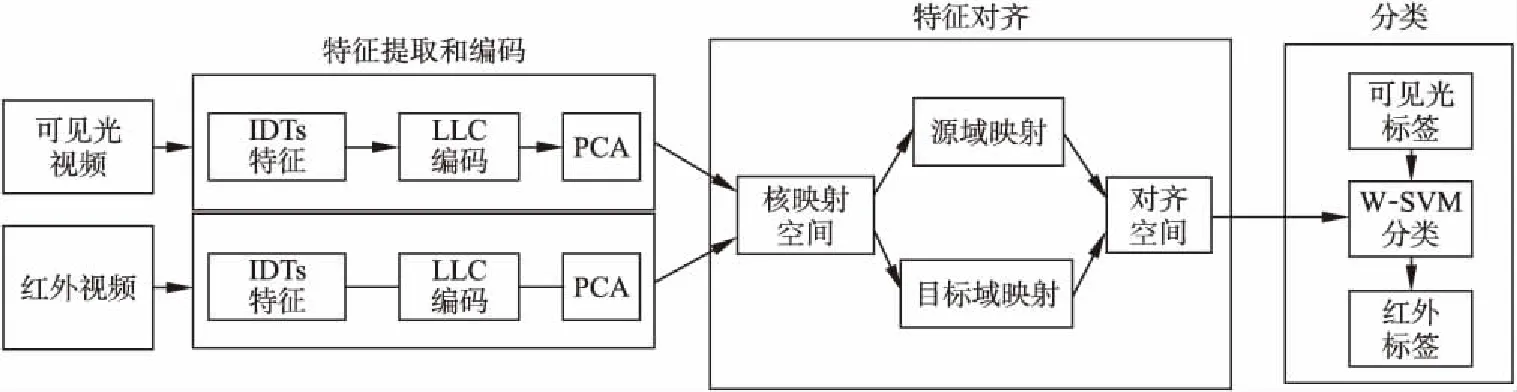

本文提出的無監(jiān)督異構(gòu)紅外行為識別算法(UHDIAR)如圖1所示,算法包括三個階段.在第一階段,對源數(shù)據(jù)集和目標(biāo)數(shù)據(jù)集進(jìn)行特征提取和編碼,在此階段中,用改進(jìn)密集軌跡(IDTs)[18]對可見光視頻和紅外視頻進(jìn)行特征提取,提取的特征作為視頻的底層特征表示,采用LLC[19]將IDTs提取出的特征進(jìn)行編碼,編碼后的特征經(jīng)PCA[25]簡化為低維子空間.在第二階段,將編碼后的低維特征映射到再生核希爾伯特空間(RKHS),在RKHS中學(xué)習(xí)兩個投影,分別將源域和目標(biāo)域投影到一個公共的對齊子空間中.最后,在源數(shù)據(jù)集和目標(biāo)數(shù)據(jù)集提取的對齊特征的基礎(chǔ)上,利用經(jīng)過余弦相似度調(diào)整權(quán)重的有標(biāo)簽源域數(shù)據(jù)訓(xùn)練支持向量機(jī)W-SVM,進(jìn)而輸出目標(biāo)域的標(biāo)簽.

圖1 無監(jiān)督異構(gòu)紅外行為識別框架(UHDIAR)Fig.1 Unsupervised heterogeneous infrared action recognition framework(UHDIAR)

3.1 特征表示

3.1.1 特征提取和編碼

改進(jìn)稠密軌跡IDTs[18]由于其對視頻特征的提取更加有針對性,消除了由于相機(jī)抖動造成識別率下降的影響,因此本文選用IDTs對視頻中的人體進(jìn)行稠密采樣得到運(yùn)動軌跡點,參數(shù)選用默認(rèn)設(shè)置.IDTs通過SURF特征和光流計算當(dāng)前幀與上一幀的投影變換矩陣得到運(yùn)動軌跡,提取的軌跡帶有方向性;然后對軌跡點提取特征,提取的特征信息包括光流方向直方圖HOF、軌跡點的方向梯度直方圖HOG以及運(yùn)動邊界直方圖MBH.

對于IDTs,因為其對人體運(yùn)動軌跡的密集采樣而得到大量的局部軌跡描述符,所以采樣得到的興趣點數(shù)目較大,這樣會導(dǎo)致較高的計算復(fù)雜度和內(nèi)存消耗.為了解決這一問題,本文采用基于位置約束的線性編碼(LLC,Locality-constrained Linear Coding)[19]方案,LLC利用位置約束將每個局部描述符投射到其局部坐標(biāo)系中,并通過最大池求得最終的投影坐標(biāo).為了加快逼近速度,首先進(jìn)行k鄰近搜索,然后求解一個約束最小二乘擬合問題.LLC用多個基來表示IDTs,在保持局部光滑稀疏性的同時,可以帶來更少的量化誤差.在兼顧效率和構(gòu)造誤差的前提下,將LLC編碼方案應(yīng)用于具有5個局部基的IDTs,并將所有訓(xùn)練測試的碼本大小設(shè)置為4000.因此,編碼的IDTs特征的維數(shù)為4000.為了降低碼本構(gòu)建的復(fù)雜度,在每個視頻序列中隨機(jī)選取200個局部IDTs.

3.1.2 主成分分析(PCA)

在LLC編碼后,特征表示仍然是高維的、有些冗余的特征.為了獲得更緊湊的特征表示,本文利用常用的線性降維方法主成分分析(PCA,principal component analysis)[25]對這些高維特征進(jìn)行預(yù)處理.PCA通過最大化樣本方差,保證新的特征維度互不相關(guān),先通過消除特征之間的相關(guān)性,然后調(diào)整縮放因子使新特征具有相同的方差,可以保留超過99%的原特征表達(dá)的特征,但是特征維數(shù)可以從4000降到不超過600維.

3.2 特征對齊

由于可見光動作視頻和紅外動作視頻采集于不同的傳感器,所以可見光視頻和紅外視頻之間有很大的模態(tài)差異,造成二者之間有不同的數(shù)據(jù)結(jié)構(gòu),這就需要進(jìn)行數(shù)據(jù)對齊,本文學(xué)習(xí)了兩個不同的映射As和At,利用最大平均差異MMD[20]來計算二者之間的分布距離,ns和nt是源域和目標(biāo)域中的樣本數(shù),Xs和Xt分別表示源域和目標(biāo)域的數(shù)據(jù).為了簡化計算,將原始數(shù)據(jù)矩陣和兩個投影矩陣合并為同成一個矩陣(1),但對于局部的數(shù)據(jù)和映射任然具有獨(dú)立性.

(1)

其中ds和dt分別是源域和目標(biāo)域的原始維數(shù).這樣源域和目標(biāo)域的MMD可以通過式(2)計算得到.

(2)

矩陣M可以通過式(3)計算:

(3)

為了將源域和目標(biāo)域的數(shù)據(jù)對齊,本文引入了再生核希爾伯特空間RKHS,將數(shù)據(jù)映射到RKHS中進(jìn)行對齊.由

x→ψ(x),ψ(X)=[ψ(x1),ψ(x2),…,ψ(x3)],令核空間K=ψ(X)Tψ(X),A=ψ(X)P,可以將式(2)變化為式(4).

MMD(Xs,Xt)H=tr(PTXMXTP)

(4)

3.3 W-SVM樣本權(quán)重調(diào)整

在跨域遷移學(xué)習(xí)的過程中,源域和目標(biāo)域有很大的模態(tài)差異,而且并不是每個源域樣本對目標(biāo)域的作用是相同的,基于以上考慮,本文引入了樣本權(quán)重,通過判斷源域樣本和目標(biāo)域樣本的相似度來改變源域的樣本權(quán)重,增加主樣本的權(quán)重,降低異常值樣本的權(quán)重,來減少負(fù)遷移.對此引入k鄰近,源域樣本和目標(biāo)域樣本k鄰近則具有相同的標(biāo)簽,同一類樣本的距離較近,不同類樣本遠(yuǎn)離.在式(5)中用Zj表示對齊后特征空間,Xj表示新特征.為了保持結(jié)構(gòu)的一致性,將式(5)最小化.

(5)

其中Z=PTK,L=D-W,L為拉普拉斯矩陣,D是一個對角矩陣,它的第i個對角元素計算為W的第i行和,W為表征樣本關(guān)系的對稱鄰接矩陣,通過余弦相似度式(6)得到.

(6)

Nk(xi)是Xi的k近鄰,它們與Xi同屬一類。對于W的第i行和第j列,如果樣本Xj是Xi的k近鄰,且與Xi具有相同的標(biāo)簽,則將Wji設(shè)為兩個樣本之間的余弦距離,否則將Wji設(shè)為0,這樣就可以保證具有相同的類接近,不同類遠(yuǎn)離.

本文學(xué)習(xí)TIT將特征向量抽象為圖頂點式(7),v為頂點的度數(shù).

(7)

這樣就可以通過式(7)得到的頂點度數(shù)更新源域樣本權(quán)重α式(8),源域經(jīng)過訓(xùn)練W-SVM得到模型,然后使用這個模型分類目標(biāo)域.

(8)

最后,對式(9)的分解優(yōu)化P映射,其中參數(shù)λ、β和γ均大于0.

(9)

其中矩陣G通過式(10)計算得到,Pi為P矩陣的第I行.

(10)

3.4 算法流程

a)輸入可見光和紅外視頻,計算IDTs特征,使用LLC編碼,PCA降維,得到底層特征表示.

b)設(shè)定迭代次數(shù)T,λ、β和γ,領(lǐng)域數(shù)k和子空間維數(shù).

c)計算核函數(shù)K,初始化矩陣G,構(gòu)造拉普拉斯矩陣L.

d)利用式(4)構(gòu)造M矩陣.

e)分解式(9)計算映射矩陣Ps和Pt.

f)將RKHS中的源域和目標(biāo)域使用不同的映射Ps和Pt投影到對齊的特征空間中.

g)權(quán)重SVM引入可見光標(biāo)簽對紅外數(shù)據(jù)分類,輸出紅外動作標(biāo)簽.

h)余弦相似度式(6)利用輸出的紅外標(biāo)簽判定可見光樣本的權(quán)重α.

i)判定迭代次數(shù)T是否達(dá)到最大值,沒有達(dá)到最大值則返回d步開始執(zhí)行下一次迭代,達(dá)到最大值則輸出紅外標(biāo)簽.

4 實驗結(jié)果與分析

4.1 實驗采用的數(shù)據(jù)集

無監(jiān)督異構(gòu)紅外行為識別UHDIAR使用XD145數(shù)據(jù)集和InfAR數(shù)據(jù)集進(jìn)行實驗,其中XD145數(shù)據(jù)集作為源域,InfAR數(shù)據(jù)集作為目標(biāo)域.

1)InfAR

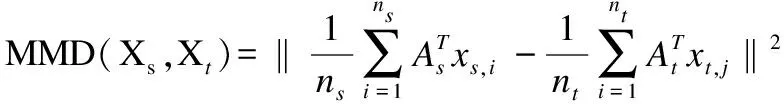

InfAR數(shù)據(jù)集[21]有600個由紅外熱成像攝像機(jī)拍攝的人體動作視頻組成.數(shù)據(jù)集中包含了fight、handclapping、handshake、hug、jog、jump、punch、push、skip、walk、wave 1(單手揮)和wave 2(雙手揮)12類動作,所有的動作都由40名志愿者完成.其中每個動作類包括50個視頻,每個視頻平均持續(xù)4秒.幀速率為25幀/s,分辨率為293×256.視頻的拍攝場景貼合實際情況,包括單人和多人的動作,體現(xiàn)出了背景的復(fù)雜度、季節(jié)差異、行為的類間差異、有無遮擋、以及視角的變化等,數(shù)據(jù)總體的挑戰(zhàn)性很大.

2)XD145

XD145[17]數(shù)據(jù)集和InfAR數(shù)據(jù)集具有12種相同的動作類別.XD145動作數(shù)據(jù)集由可見光攝像機(jī)拍攝的600個視頻組成,每個動作類有50個視頻.所有的動作都由30名志愿者完成.每個視頻平均持續(xù)5秒.視頻幀速率為25幀/s,分辨率為320×240.如圖2所示,在構(gòu)建數(shù)據(jù)集時考慮了背景、姿態(tài)和視角的變化.圖2為可見光和紅外動作的比較,每一個動作左邊為紅外動作,右邊為可見光動作.從圖中可以看出,這些動作視頻是在兩種不同的光譜下拍攝的,表現(xiàn)出明顯的類內(nèi)方差和模態(tài)差異,而且相比于可見光數(shù)據(jù)集,紅外數(shù)據(jù)集的背景、遮擋等更復(fù)雜.

圖2 可見光和紅外動作的比較Fig.2 Comparison of visible and infrared action

4.2 實驗設(shè)置

4.2.1 參數(shù)設(shè)置

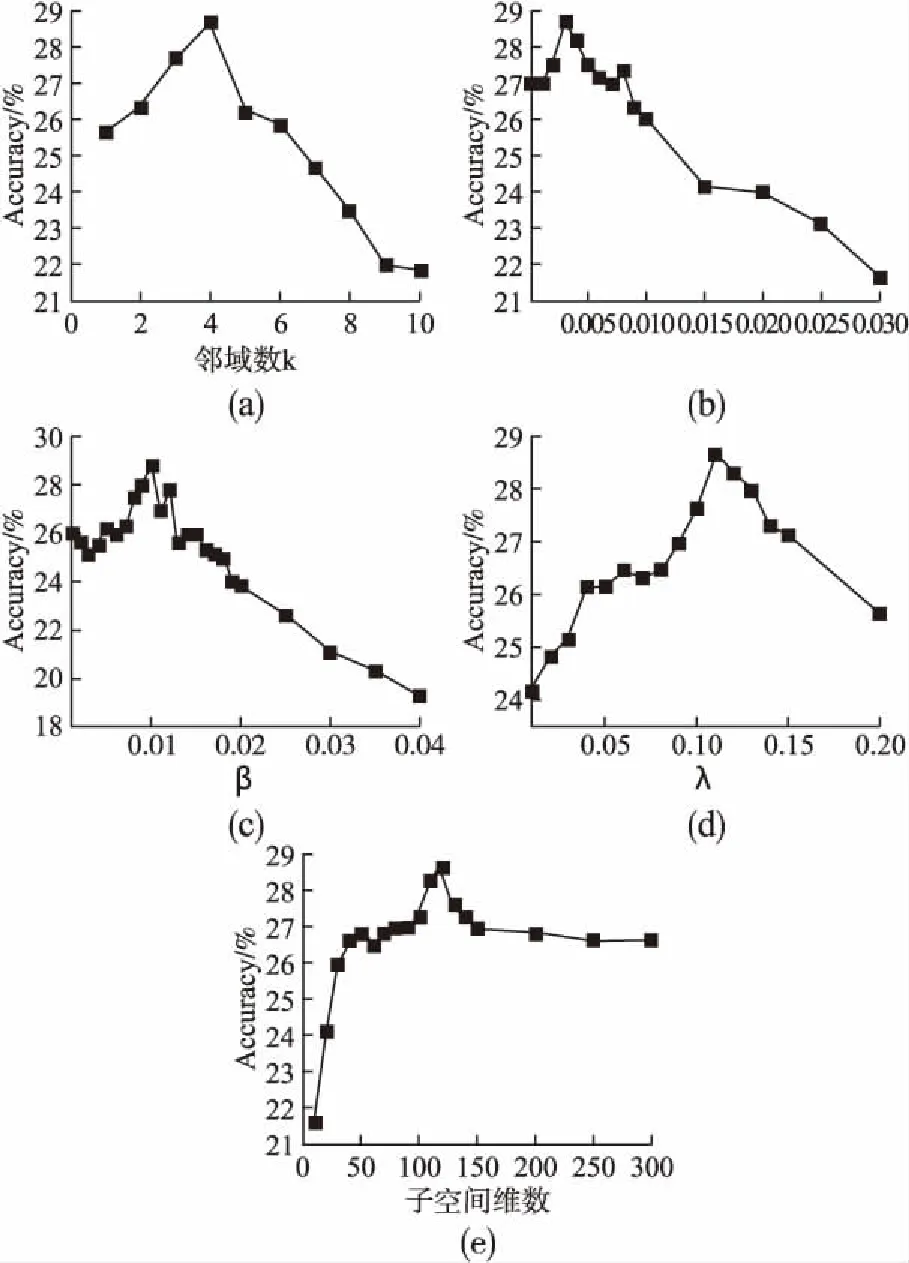

在源域和目標(biāo)域每類樣本數(shù)均為50的情況下,圖3給出了UHDIAR的參數(shù)設(shè)置.圖3(a)~圖3(e)分別表示為鄰域數(shù)k、γ、β、λ和子空間維數(shù),Accuracy表示12種動作的平均識別率.從圖中可以看出它們分別取4、0.002、0.01、0.11和120時,12類動作的平均識別率取得最高28.67%.可以看出相比于其它參數(shù)的取值變化β的值最敏感,取值變化0.01,準(zhǔn)確率就會發(fā)生很大變化,因為β決定源域樣本的權(quán)重,這也反映了調(diào)整源域樣本權(quán)重的重要性.

4.2.2 源域樣本數(shù)對準(zhǔn)確率影響分析

將可見光動作作為訓(xùn)練集源域,紅外動作作為訓(xùn)練集目標(biāo)域,源域每種動作的樣本數(shù)量隨機(jī)選擇為[5,10,15,20,25,30,40,45,50],目標(biāo)域每種動作的樣本數(shù)量選擇為50,將UHDIAR與標(biāo)準(zhǔn)的SVM比較,SVM采用效率較好的線性核.圖4為源域樣本數(shù)對準(zhǔn)確率的影響,從圖中可以看到源域樣本數(shù)越多UHDIAR的總體識別率越高,可以利用XD145數(shù)據(jù)集的全部數(shù)據(jù),說明UHDIAR可以很好的利用帶標(biāo)簽的源域樣本,這也符合當(dāng)前帶標(biāo)簽的可見光動作數(shù)據(jù)比帶標(biāo)簽的紅外數(shù)據(jù)多的現(xiàn)實.帶標(biāo)簽的源域樣本數(shù)量增加對標(biāo)準(zhǔn)SVM的準(zhǔn)確率幾乎沒有影響,這也反映了UHDIAR 的有效性.

圖3 a-e為UHDIAR優(yōu)化參數(shù)設(shè)置Fig.3 a-e optimizes parameter settings for UHDIAR

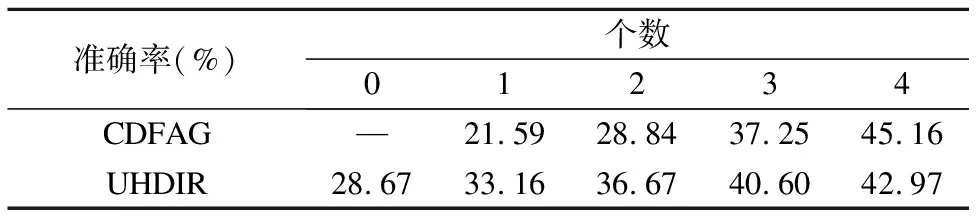

4.2.3 UHDIAR與 CDFAG的比較分析

Liu等最近提出CDFAG[17]算法用于紅外行為識別,將可見光動作作為輔助源域的同時加入了紅外動作數(shù)據(jù),其算法為半監(jiān)督的,為了公平對比,本文也引入少量帶標(biāo)簽的紅外數(shù)據(jù)同CDFAG比較,其結(jié)果如表1所示.從表中可以看出,加入的紅外訓(xùn)練個數(shù)不超過3個時UHDIR的識別率相比CDFAG有明顯的提高.在紅外訓(xùn)練個數(shù)超過3個后,UHDIR相比CDFAG精度有一定的下降,主要因為CDFAG特征對齊和泛化的過程中也加入了紅外數(shù)據(jù)進(jìn)行訓(xùn)練,為有目的的對齊和泛化,而UHDIR為無監(jiān)督遷移,在特征對齊中并沒有加入紅外數(shù)據(jù)進(jìn)行訓(xùn)練,紅外數(shù)據(jù)只是用來訓(xùn)練SVM.在紅外動作數(shù)據(jù)稀缺的當(dāng)下,基本沒有可以使用的帶標(biāo)簽的紅外數(shù)據(jù),而UHDIR可以直接用可見光動作識別紅外動作,CDFAG算法只有存在標(biāo)記好的紅外數(shù)據(jù)時才可以使用.

表1 CDFAG和UHDIR加入紅外訓(xùn)練個數(shù)最高識別率對比

Table 1 Comparison of the highest recognition rate of

CDFAG and UHDIR added to infrared training

準(zhǔn)確率(%)個數(shù)01234CDFAG—21.5928.8437.2545.16UHDIR28.6733.1636.6740.6042.97

4.2.4 實驗結(jié)果分析

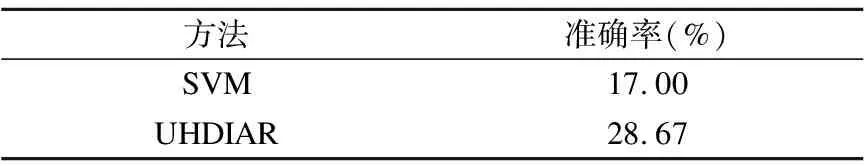

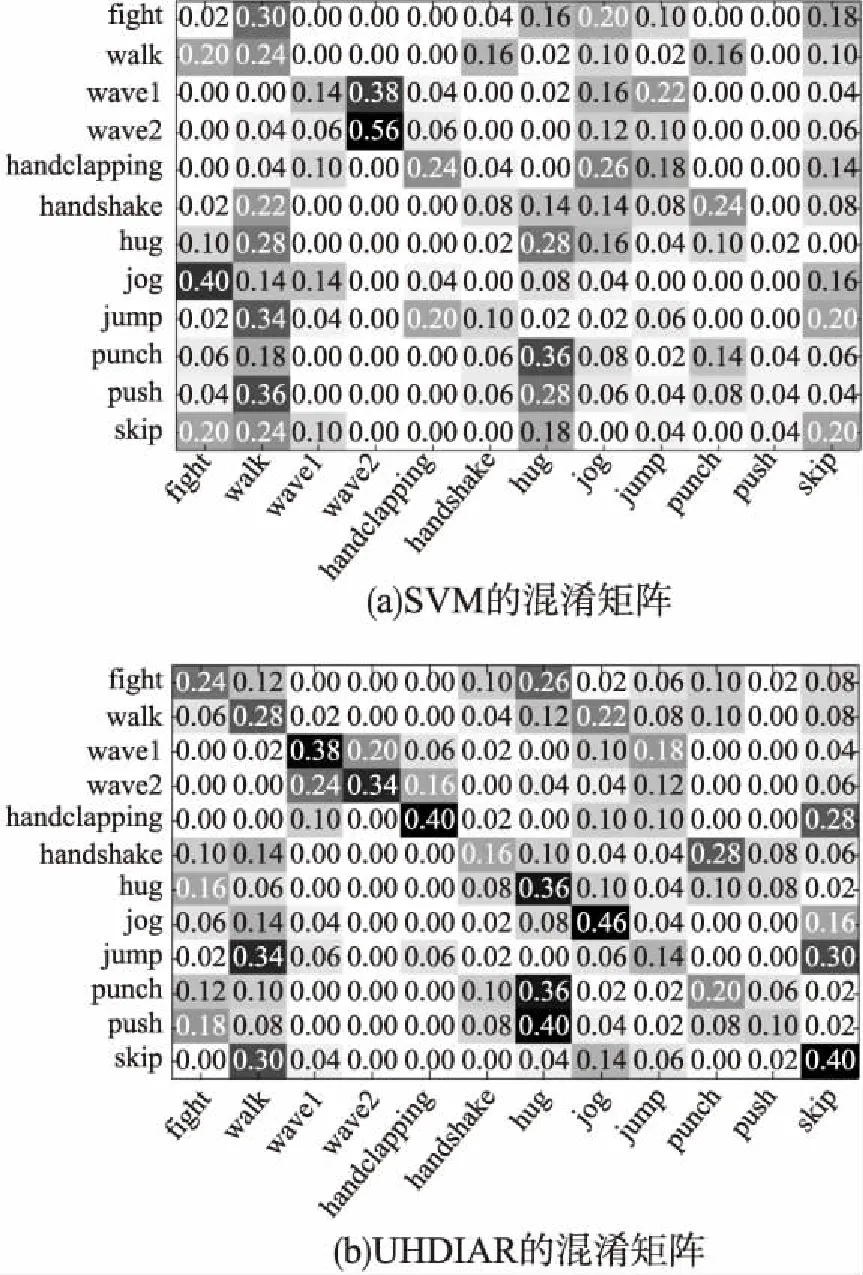

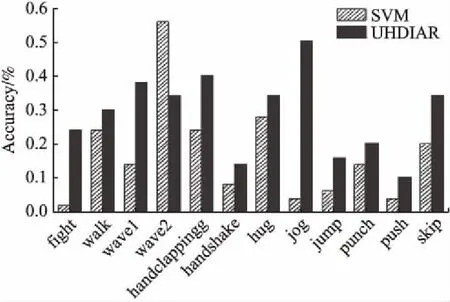

表2為SVM和UHDIAR的平均識別率,SVM平均識別率為17.00%,而UHDIAR的平均識別率為28.67,比SVM相對提高了68.65%,達(dá)到了較好的效果.圖5(a)和圖5(b)分別為標(biāo)準(zhǔn)SVM和UHDIAR的混淆矩陣結(jié)果,主對角線為每種動作的識別率.為了有更直觀的區(qū)別,圖6利用每種動作的識別率做成柱狀圖,從圖6可以看到,除了wave2(雙手揮)SVM識別率為56%,而UHDIAR的識別率為34%,比SVM低;其它11種動作UHDIAR的識別率均比SVM高,說明UHDIAR幾乎對所有的動作都有效.從圖2的wave2動作可以看出相比于其它動作雙手揮的動作更容易辨識,提取的有效特征更有針對性,所以SVM直接用可見光數(shù)據(jù)識別紅外數(shù)據(jù)可以得到較好的效果,相反如果進(jìn)行遷移學(xué)習(xí),由于數(shù)據(jù)對齊的過程中,會丟失一部分有效特征而造成識別率低,但其它動作提取的有效特征有限,對齊的過程中丟失的有效特征較少.

表2 SVM和UHDIAR的平均識別率

Table 2 Average recognition rate of SVM and UHDIAR

方法準(zhǔn)確率(%)SVM17.00UHDIAR28.67

圖5 SVM和UHDIAR的混淆矩陣Fig.5 Confusion matrices of SVM and UHDIAR

圖6 SVM和UHDIAR的每種動作識別率對比Fig.6 Comparison of each action recognition ratebetween SVM and UHDIAR

5 結(jié) 論

本文首次提出基于遷移學(xué)習(xí)的無監(jiān)督異構(gòu)紅外行為識別算法,利用帶標(biāo)簽的可見光動作數(shù)據(jù)識別不帶標(biāo)簽的紅外動作.通過引入W-SVM增加源域有效樣本的權(quán)重,降低異常樣本權(quán)重,緩解負(fù)遷移,實驗結(jié)果表明UHDIAR的平均識別率與標(biāo)準(zhǔn)的SVM相比相對提高68.65%,縮小了可見光和紅外的模態(tài)差異,識別率有了明顯的提高,證明可見光動作樣本權(quán)重對紅外行為識別的有效性.算法不需要標(biāo)記目標(biāo)域進(jìn)行訓(xùn)練,提高了源域樣本的利用率,可以有效的利用現(xiàn)有的可見光數(shù)據(jù)集,為利用可見光輔助紅外行為識別提供了一種新的思路.本文雖然在縮小可見光和紅外的模態(tài)差異取得了較好的效果,但由于可見光和紅外的模態(tài)存在差異,目前提出的UHDIAR算法識別率有待進(jìn)一步提高.課題組下一步工作考慮多源域遷移學(xué)習(xí),構(gòu)成圖片和視頻的多源域減少模態(tài)差異進(jìn)一步提高識別率.