基于深度學(xué)習(xí)的遙感圖像新增建筑物語義分割?

陳一鳴 彭艷兵 高劍飛,3

(1.武漢郵電科學(xué)研究院 武漢 430074)(2.烽火通信科技股份有限公司南京研發(fā)部 南京 210019)(3.東南大學(xué) 南京 211189)

1 引言

衛(wèi)星遙感圖像作為空間地理信息的一種數(shù)據(jù)源為人類科技的發(fā)展解決了許多實際問題。多時相遙感圖像是指在不同時刻對某區(qū)域同一位置獲得的遙感影像,其中,對多時相遙感圖像的變化檢測具有十分重要的研究意義[1],通過對多時相遙感圖像進(jìn)行處理,分析,挖掘,可以獲取地面及地物有價值的變化信息。遙感圖像源的發(fā)展也使得對遙感圖像的應(yīng)用更多元化,實用化,同時隨著計算機視覺的不斷發(fā)展,對遙感圖像的變化檢測已經(jīng)成為環(huán)境監(jiān)測、農(nóng)作物監(jiān)視、土地監(jiān)管等方面的有效手段,有著非常廣泛的應(yīng)用前景。根據(jù)遙感衛(wèi)星運行規(guī)律的周期性,可以獲得大量這種不同時刻同一區(qū)域位置的遙感圖像,并基于獲得的圖像信息數(shù)據(jù)進(jìn)行差異檢測。本文課題將基于衛(wèi)星遙感圖像數(shù)據(jù)采用深度學(xué)習(xí)方法對新增建筑物進(jìn)行識別并分割其目標(biāo)區(qū)域。深度學(xué)習(xí)作為人工智能算法在計算機視覺領(lǐng)域效果顯著,尤其以卷積神經(jīng)網(wǎng)絡(luò)為代表的多層神經(jīng)網(wǎng)絡(luò)算法在圖像識別方面效果取得明顯提升,2012年Hinton等構(gòu)建的深度神經(jīng)網(wǎng)絡(luò)更取得驚人的成果,其在算法的改進(jìn)中的網(wǎng)絡(luò)訓(xùn)練過程中引入了權(quán)重衰減的概念,使神經(jīng)網(wǎng)絡(luò)可以有效地縮小權(quán)重幅度,從而實現(xiàn)逐層學(xué)習(xí)特征。如今隨著計算機計算能力的提升以及GPU加速技術(shù)的發(fā)展,使得在訓(xùn)練過程中可以更快地學(xué)習(xí)更多數(shù)據(jù),使網(wǎng)絡(luò)模型能夠更好地擬合訓(xùn)練數(shù)據(jù)特征[2]。深度學(xué)習(xí)方法的應(yīng)用不僅提高了對圖像識別的準(zhǔn)確率,同時也避免了消耗大量時間對圖像進(jìn)行特征提取,提升了工作效率。

目前由于遙感圖像獲得的地理圖像信息變化復(fù)雜,常規(guī)的基于圖像處理與機器學(xué)習(xí)學(xué)習(xí)特征的差異檢測方法并不能廣泛有效地解決問題,基于深度學(xué)習(xí)的方法在遙感圖像差異識別領(lǐng)域探索還比較少[3],本文通過改進(jìn)的基于U-net網(wǎng)絡(luò)的方法在新增建筑物識別并分割其目標(biāo)區(qū)域方面可以取得良好效果。

2 深度學(xué)習(xí)與圖像語義分割

近年來深度學(xué)習(xí)在人工智能領(lǐng)域高速發(fā)展,自卷積神經(jīng)網(wǎng)絡(luò)提出以來,以卷積神經(jīng)網(wǎng)絡(luò)為代表的深度學(xué)習(xí)在圖像學(xué)習(xí)領(lǐng)域效果驚人。深度學(xué)習(xí)作為一個新興的研究熱點,在語音識別、計算機視覺,自然語言處理等領(lǐng)域都取得良好效果,與傳統(tǒng)的神經(jīng)網(wǎng)絡(luò)相比,深度神經(jīng)網(wǎng)絡(luò)做出了重大的改進(jìn),其通過“逐層學(xué)習(xí)”的方法來有效降低了數(shù)據(jù)訓(xùn)練上的問題難度,并通過學(xué)習(xí)深層非線性網(wǎng)絡(luò)結(jié)構(gòu),可實現(xiàn)對眾多復(fù)雜函數(shù)的逼近,其方法可以對大量標(biāo)注數(shù)據(jù)的逐層挖掘數(shù)據(jù)特征并學(xué)習(xí)其特征本質(zhì),并在無標(biāo)注數(shù)據(jù)集中展現(xiàn)相當(dāng)?shù)膶W(xué)習(xí)能力[4~5]。深度學(xué)習(xí)之所以能夠更多更好抓取并表現(xiàn)數(shù)據(jù)的特征,主要因為其擁有更深的網(wǎng)絡(luò)層次與豐富的網(wǎng)絡(luò)結(jié)構(gòu),其通過多層的神經(jīng)元將提取的特征逐層傳遞,每一層又對之前層傳遞的特征進(jìn)一步挖掘提取并學(xué)習(xí),進(jìn)而可以有很強的特征表達(dá),又通過反復(fù)迭代初始化權(quán)重系數(shù)達(dá)到全局最優(yōu)點,因此有能力學(xué)習(xí)表示大規(guī)模數(shù)據(jù)并解決問題。同時,深度神經(jīng)網(wǎng)絡(luò)的逐層訓(xùn)練架構(gòu)可以有效解決多層反向傳遞之后梯度彌散的問題,從而實現(xiàn)真正意義上的深度學(xué)習(xí)。即使對于圖像、語音這種難以從表面直觀地挖掘特征的問題[6],深度學(xué)習(xí)模型也可以通過對大量訓(xùn)練數(shù)據(jù)學(xué)習(xí)后取得更好的效果。

在圖像識別領(lǐng)域中主要有物體識別,目標(biāo)檢測與語義分割三種類型問題,物體識別僅需要識別出圖像中的物體是什么或是哪種,目標(biāo)檢測需要識別出圖像里多種不同類別物體并將其粗略框出物體區(qū)域,語義分割是對圖像中物體像素級別識別,要將待識別目標(biāo)的區(qū)域像素表示或標(biāo)記。2014年Jonathan Long等提出了全卷積神經(jīng)網(wǎng)絡(luò),卷積網(wǎng)不僅全圖式的分類上有所提高,也在結(jié)構(gòu)化輸出的局部任務(wù)上取得了進(jìn)步。包括在目標(biāo)檢測邊界框、部分和關(guān)鍵點預(yù)測,全卷積神經(jīng)網(wǎng)絡(luò)實現(xiàn)了對圖像進(jìn)行像素級的分類[8~10],從而解決了語義級別的圖像分割問題。其網(wǎng)絡(luò)結(jié)構(gòu)摒棄了經(jīng)典的卷積神經(jīng)網(wǎng)絡(luò)在卷積層之后的全連接層,采用上采樣方法對最后的輸出特征進(jìn)行處理并使其恢復(fù)輸入數(shù)據(jù)的原始尺寸,從而可以在保留輸入圖像原始空間信息的條件下對每個像素進(jìn)行預(yù)測實現(xiàn)圖像語義級別分割。在圖像語義分割問題上,全卷積神經(jīng)網(wǎng)絡(luò)可以接受任意尺寸的輸入圖像,并在識別領(lǐng)域表現(xiàn)出巨大的潛力。隨著遙感數(shù)據(jù)分辨率的提高,深度學(xué)習(xí)可以更好地學(xué)習(xí)高空間分辨率的數(shù)據(jù)特征,對其進(jìn)行有效識別與分類,因此深度學(xué)習(xí)方法可作為處理遙感大數(shù)據(jù)分析問題的有效手段。

3 一種改進(jìn)的Unet網(wǎng)絡(luò)的模型

3.1 數(shù)據(jù)說明

本文所采用的遙感圖像數(shù)據(jù)為兩時相的quickbird遙感圖像,圖像進(jìn)行過配準(zhǔn)等預(yù)處理。數(shù)據(jù)格式為tif格式4通道圖像,第四通道為遠(yuǎn)紅外通道,由于原衛(wèi)星遙感圖像的尺寸過于巨大,所以首先將圖片數(shù)據(jù)進(jìn)行切片,根據(jù)切片后的數(shù)據(jù)設(shè)定bach_size供深度學(xué)習(xí)模型學(xué)習(xí),切片后輸入模型的數(shù)據(jù)為320×320大小的RGB三通道png圖像,切片中將全圖各通道數(shù)據(jù)歸一化,歸一化后按其百分位數(shù)均衡化數(shù)據(jù),使圖片的對比度增強且均衡從而避免由于局部光照不均衡導(dǎo)致像素上的數(shù)據(jù)分布不均衡。

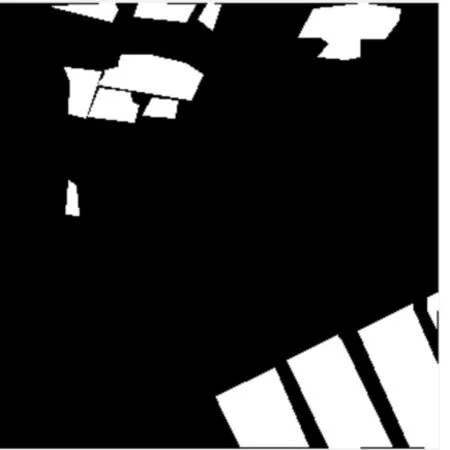

數(shù)據(jù)源于某地區(qū)2015與2017年的衛(wèi)星遙感圖像,待識別分割目標(biāo)為2017年相比2015年新增的建筑物。在數(shù)據(jù)標(biāo)注方面:由于圖像尺寸過于巨大,首先將遙感圖像切片并均衡化,分別對兩時相遙感圖像的所有地上建筑物進(jìn)行人工標(biāo)注,標(biāo)注標(biāo)準(zhǔn)為必須高于地面的人造建筑物,包括高架橋,但不包括汽車等非建筑物。

如圖1、2所示,圖1為切片后的廣東省某局部地區(qū)的遙感圖像,圖2為其標(biāo)注其所有人工建筑物后的標(biāo)記圖像。

圖1 某地區(qū)遙感圖像

圖2 標(biāo)注后圖像

將原圖像與標(biāo)記圖像作為訓(xùn)練數(shù)據(jù)輸入到網(wǎng)絡(luò)模型中。根據(jù)網(wǎng)絡(luò)結(jié)構(gòu)不同其學(xué)習(xí)后的特征表示方式也會不同,在全卷積神經(jīng)網(wǎng)絡(luò)中由于最后池化后有全卷積層,可以通過對其上采樣方式達(dá)到端對端的輸入輸出。

3.2 深度學(xué)習(xí)模型流程

模型流程圖如圖3所示。

圖3 模型流程圖

首先對全區(qū)域的遙感圖像進(jìn)行分割配準(zhǔn)等預(yù)處理,將原圖與標(biāo)記圖分別輸入模型,然后對標(biāo)注好的圖像用基于U-net的全卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行學(xué)習(xí),這里的卷積可以理解為對卷積核與圖像區(qū)域像素進(jìn)行內(nèi)積運算,通過卷積提取特征通過反卷積擴大感知野,通過殘差反饋調(diào)節(jié),反復(fù)迭代最終得到網(wǎng)絡(luò)結(jié)構(gòu)網(wǎng)絡(luò)參數(shù)及網(wǎng)絡(luò)權(quán)重系數(shù)。

3.3 網(wǎng)絡(luò)結(jié)構(gòu)

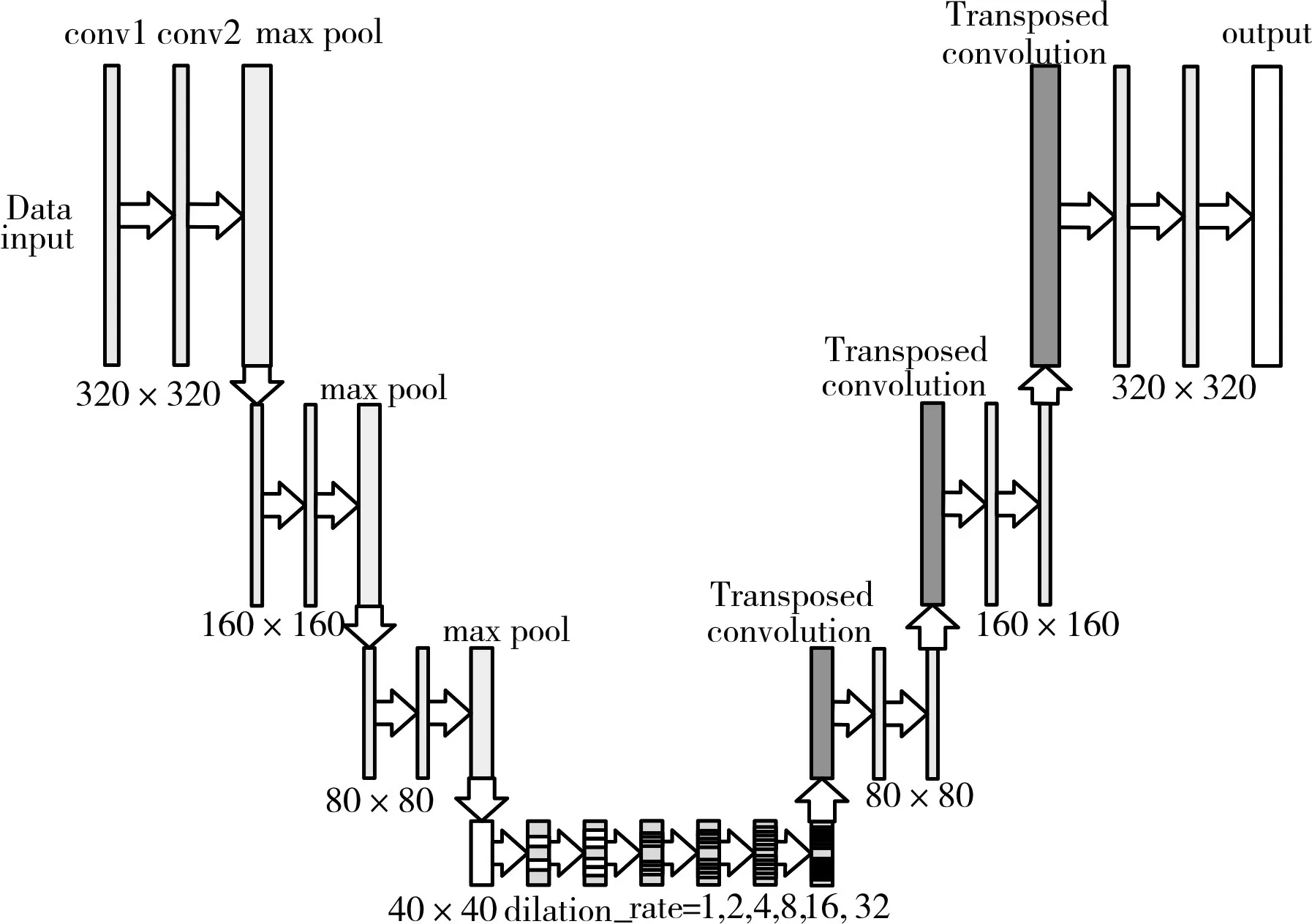

本文采用的網(wǎng)絡(luò)結(jié)構(gòu)如圖4所示。

圖4 改進(jìn)的網(wǎng)絡(luò)結(jié)構(gòu)

整個神經(jīng)網(wǎng)絡(luò)的前半部分由6個卷積層,3個最大池化層組成,每兩層卷積后接一個池化層,在最后一層下采樣后,采用反卷積層對最后層的特征映射進(jìn)行上采樣,使它恢復(fù)到輸入圖像相同的尺寸,從而可以對每個像素都產(chǎn)生了一個預(yù)測,同時保留了原始輸入圖像中的空間信息,最后在上采樣的特征圖上進(jìn)行逐像素分類,即實現(xiàn)語義分割。

本文設(shè)計的神經(jīng)網(wǎng)絡(luò)有12個需要訓(xùn)練參數(shù)的層,這里不包括池化層,卷積層與池化層相互組合,其中每兩次卷積后進(jìn)入最大池化層,本文的模型輸入的圖片尺寸為320×320,第一個卷積層使用的卷積核尺寸3×3,步長1,有64個卷積核;緊接著是第二個卷積層,其卷積核尺寸與步長與上一層完全一致,卷積方式為SAME卷積,此時圖像大小不變?nèi)匀粸?20×320,然后是一個2×2的最大池化層,步長為1。此時圖像大小為160×160。池化的作用為了減小圖像尺寸增大感受野,接下來的卷積層與池化層的結(jié)構(gòu)與上文的結(jié)構(gòu)一致,按照上面的組合重復(fù)兩次,圖像尺寸降至為40×40的特征映射。本文在反卷積前加入六層空洞卷積層,卷積核大小均為為3×3,空洞尺寸依次為 1,2,4,8,16,32同樣采用SAME卷積使圖像尺寸不發(fā)生變化,然后進(jìn)入上采樣層,上采樣層采用反卷積技術(shù),通過步長為2的3x3卷積核使圖像尺寸擴大為80×80,然后進(jìn)入兩層步長為1的3×3 SAME卷積層,依次重復(fù)兩次同樣組合結(jié)構(gòu)的上采樣層與卷積層使尺寸恢復(fù)為320×320。

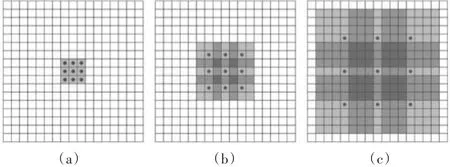

其中在進(jìn)入反卷積層前引入空洞卷積層,其空洞卷積作用原理結(jié)合圖5如下。

如圖5(a)所示為引入的第一層空洞卷積層的卷積核,其卷積方式作用和普通的3×3卷積核卷積相同,圖5(b)為第二層空洞卷積核結(jié)構(gòu),其在第一層卷積核的基礎(chǔ)上增加了權(quán)重為0的點,實際的卷積核大小還是3×3,但是空洞為1,也就是對于一個7×7的圖像區(qū)域作用時,僅有9個黑色的點和卷積核發(fā)生卷積操作,其余的像素點都略過。也可以理解為卷積核尺寸為7×7,但是只有圖中的9個點的權(quán)重不為0,其余都為0。雖然空洞卷積層的卷積核大小只有3×3,但是通過空洞卷積的方式其作用區(qū)域也就是感受野已經(jīng)增加到了7×7的像素范圍,具體來說,在第二層空洞卷積中每個紅點像素正是上一層卷積后的結(jié)果像素位置,圖像數(shù)據(jù)從第一層到第二層卷積其感受野擴大為7×7范圍。圖5(c)圖是第三層的卷積核結(jié)構(gòu),同理跟在前兩層空洞卷積后面可以達(dá)到15×15的感受野。如果使用傳統(tǒng)的卷積操作,3層3×3的卷積加起來,步長為1的話,只能達(dá)到(卷積核-1)×層數(shù)+1=7的感受野,也就是和層數(shù)成線性關(guān)系,而采用空洞卷積的方式其感受野是指數(shù)級別的增長。

圖5 空洞卷積示意圖

引入空洞卷積層對特征映射后的數(shù)據(jù)卷積可以在不通過池化損失信息的情況下,擴大感受野,讓每個卷積輸出都包含較大范圍的信息。本文引入6層空洞卷積層,在效果上可以使最后分割出的建筑物邊界更加清晰。

3.4 優(yōu)化

本文模型所采用的優(yōu)化器為隨機梯度下降與Momentum組合的方法。

隨機梯度下降的原理是在模型訓(xùn)練過程中,每一次迭代都在訓(xùn)練集隨機抽取一批樣本。對這批樣本使用模型中現(xiàn)有的參數(shù)生成一個估計輸出?,與樣本的實際輸出y比較,計算所有誤差,取其平均值為平均誤差,并根據(jù)平均誤差更新模型參數(shù)。隨機梯度下降的優(yōu)點是每次迭代值抽取數(shù)據(jù)集中的一部分進(jìn)行計算所以速度很快,但是它的缺點也是因為訓(xùn)練只用了其中的部分?jǐn)?shù)據(jù)的誤差更新參數(shù),梯度求解也存在誤差,所以學(xué)習(xí)速率需要逐漸減小,否則模型無法趨于收斂,并且同樣因為每次訓(xùn)練只抽取部分樣本,每次抽樣數(shù)據(jù)對迭代梯度有比較大的影響,即求解的梯度不夠準(zhǔn)確,不能準(zhǔn)確地反映真實梯度。

為了盡量緩解這個問題,本文采用與Momen?tum組合的方法,Momentum方法在面對含有噪聲但小而連續(xù)的梯度的時候,能夠很好地加速學(xué)習(xí)。Momentum來自物理中的動量概念,其方法會將之前計算的梯度值傳入后面的運算。這里引入了一個新的變量v表示動量。v是前面計算的梯度的累加,但是每回合都有一定的衰減。其特點是:前后計算的梯度方向一致時,可以加速學(xué)習(xí)效率,當(dāng)前后梯度方向不一致時,能夠抑制震蕩。

本文模型設(shè)置的學(xué)習(xí)率為0.0005,Batch_size為5,每個epoch中樣本數(shù)量為300,損失函數(shù)采用常見的交叉熵?fù)p失函數(shù),分別迭代9000次,12000次,15000次得到模型對比三個模型,其12000次的模型效果最好。

3.5 實驗

由于深度學(xué)習(xí)需要大量數(shù)據(jù)作為支撐,本文也采用了數(shù)據(jù)增強的方法,在切片后為340×340的原始圖像中隨機地截取320×320大小的區(qū)域(以及水平翻轉(zhuǎn)的鏡像),相當(dāng)于增加了(340-320)×(340-320)×2=800倍的數(shù)據(jù)量。增強后的數(shù)據(jù)可以避免參數(shù)眾多的網(wǎng)絡(luò)陷入過擬合,使用數(shù)據(jù)增強后進(jìn)行訓(xùn)練模型可以有效減弱過擬合,提升泛化能力。

圖6 測試圖像1

圖7 結(jié)果圖1

圖8 測試圖像2

圖9 結(jié)果2

3.6 結(jié)果

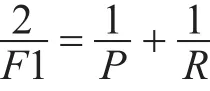

本文采用f1值作為評測指標(biāo)對分割后的結(jié)果進(jìn)行評測,其f1值的定義為:精確率和召回率的調(diào)和均值,也就是

其中精確率的公式為

它計算的是所有“正確被檢索的個數(shù)(TP)”占所有“實際被檢索到的(TP+FP)”的比例。

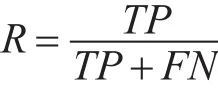

召回率的公式為

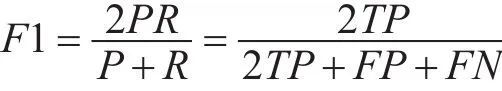

它計算的是所有“正確被檢索的個數(shù)(TP)”占所有“應(yīng)該檢索到的(TP+FN)”的比例。整合一下,可表示為

本文分別使用迭代9000次,12000次,15000次訓(xùn)練后的模型進(jìn)行測試,得到結(jié)果分別為0.72,0.78;0.765,迭代次數(shù)過多可能導(dǎo)致對訓(xùn)練數(shù)據(jù)過擬合,因此12000次的效果相比最佳。

4 結(jié)語

本論文基于全卷積神經(jīng)網(wǎng)絡(luò)U-net網(wǎng)絡(luò)結(jié)構(gòu)自行設(shè)計了一種新的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),與U-net網(wǎng)絡(luò)結(jié)構(gòu)相比比較大的改動在于上采樣前,引入多層空洞卷積并采用新的優(yōu)化方法,可以增強對不規(guī)則的目標(biāo)區(qū)域的邊界的識別與劃分能力。通過深度學(xué)習(xí)的遙感圖像差異檢測,可以有效地檢測出新增建筑物區(qū)域,并標(biāo)識出區(qū)域形狀及位置。其訓(xùn)練的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)可應(yīng)用于其他新的測試數(shù)據(jù),其理論上應(yīng)達(dá)到誤差范圍相同的查準(zhǔn)率與查全率以及綜合其查準(zhǔn)率與查全率的F1值。

基于遙感圖像與深度學(xué)習(xí)相結(jié)合的方法可以自動化智能化提取地面信息及變化情況,有利于使用遙感圖像工作的相關(guān)部門工作,以優(yōu)化其工作方式或發(fā)展相關(guān)技術(shù)。