一種基于Kinect的二維三維混合面部表情識別方法

鄭少陽 林曉斌

摘 ?要: 目前面部表情識別的研究和應用大多基于二維圖像。文章提出一種基于Kinect設備的二維三維混合面部表情識別方法。通過結合Kinect設備捕捉到的面部特征點位置及動畫單元的特征,來確定由面部表情產生的三維網格的形變。應用基于支持向量機的分類方法及基于表情分析和最大置信度的融合算法對表情進行識別。實驗表明,該方法比基于二維圖像的識別方法性能更好。

關鍵詞: Kinect; 面部表情識別; 二維三維混合; 融合算法; 支持向量機

中圖分類號:TP391.4 ? ? ? ? ?文獻標志碼:A ? ? 文章編號:1006-8228(2019)11-70-04

Abstract: Most of the research and application on facial expression recognition are based on 2D images. This paper presents a 2D and 3D hybrid facial expression recognition method using Kinect, which determines the deformation of facial expression 3D mesh according to the feature point positions and features of the animation units captured by Kinect. The facial expression classification is then realized by using support vector machine (SVM) and fusion algorithm based on maximum confidence and emotional profiles. The experimental results indicate that this method has better performance than those recognition methods purely based on 2D images.

Key words: Kinect; facial expression recognition; 2D and 3D hybrid; fusion algorithm; support vector machine (SVM)

0 引言

隨著人工智能和模式識別技術的快速發展,人類面部表情的識別引起了人們的研究興趣,其研究成果在醫學、安全、人機交互等領域都有廣泛的應用。人類面部表情包含了人類的大部分情感信息,并且構成了傳達情緒的主要通道。因此,針對面部表情識別的研究對經濟和社會發展具有重要意義。

傳統的面部表情識別技術主要通過基于處理分析普通RGB傳感器采集的二維圖像來實現。由于人類顏面屬于三維物體,僅依賴于二維圖像的識別必然失去關鍵的幾何特征,從而很大程度上影響識別的精度。

本文提出一種基于Kinect的二維三維混合面部表情識別方法。其中,二維信息來自于動畫單元,而三維信息則取自于特征點位置。采用30幀連續畫面為研究對象,并將表情分為7類:憤怒、厭惡、恐懼、快樂、悲傷、驚訝和平靜。在對每一幀畫面提取特征后,使用支持向量機分別根據動畫單元及特征點位置進行表情分類。用基于改進型情緒分析的融合算法對30個連續幀的識別結果進行融合, 用基于最大置信度的融合算法將不同特征的分類結果進行融合。

1 相關研究

由于在人機交互方面的優勢,面部表情識別一直受到計算機視覺研究人員的廣泛關注。對比其他的人機交互方式如動作或姿勢識別、語言識別等,其具備更好的表現力和更廣泛的應用空間[1]。

早期的研究將人類面部基本表情分為6類:憤怒、厭惡、恐懼、快樂、悲傷、驚訝[2]。后來又加入了平靜這一表情子類,形成了面部表情7大類。初期的表情識別研究僅局限于對典型或故意展示出的表情進行的分類[3-5],且極大受限于攝像的角度及照明條件等外部因素的影響。隨著三維測量技術的發展,這一問題得到了很好的解決。對比二維圖像,三維測量能夠捕捉到更多的幾何數據,而且可以不受角度、光照等變化的影響,能夠很好地補充幾何形狀信息并修正由角度等條件變化引起的誤差。而二維圖像傳感器可以在速度、分辨率及成本等方面具備優勢。因此以二維三維結合的方式進行面部表情識別是十分必要的。

Kinect是一種同時具備二維彩色圖像拍攝和三維掃描能力的高速傳感器。其面部識別系統結合彩色二維圖像及深度數據來定位三維空間中的特征點。比較起其他的三維測量設備,其具備掃描速度快、價格低廉、尺寸小巧等優點。Kinect設備雖然也存在掃描精度低和噪點較多的問題,但由于其在價格方面的優勢,常被應用于各種研究,如Huynh[6]等人將Kinect用于性別的識別;Kadambi[7]等人將偏振光成像技術結合Kinect的深度圖以提高三維測量的精度;Silverstein[8]等人則將Kinect用于放療中對患者的識別和登記。

2 二維三維混合面部表情識別

本研究以Kinect捕捉到的視頻序列作為輸入,對連續捕捉的30幀畫面中的每幀畫面進行面部檢測及特征提取。動畫單元及特征點位置分別作為提取面部表情二維及三維特征的兩個通道,利用美國微軟公司提供的面部追蹤SDK引擎進行提取,這些提取出的二維和三維特征隨后用于模型訓練及識別測試。由動畫單元及特征點位置通道所獲得的表情特征首先由支持向量機分類器分別分類后,再進行融合計算并得出表情識別的最終結果。

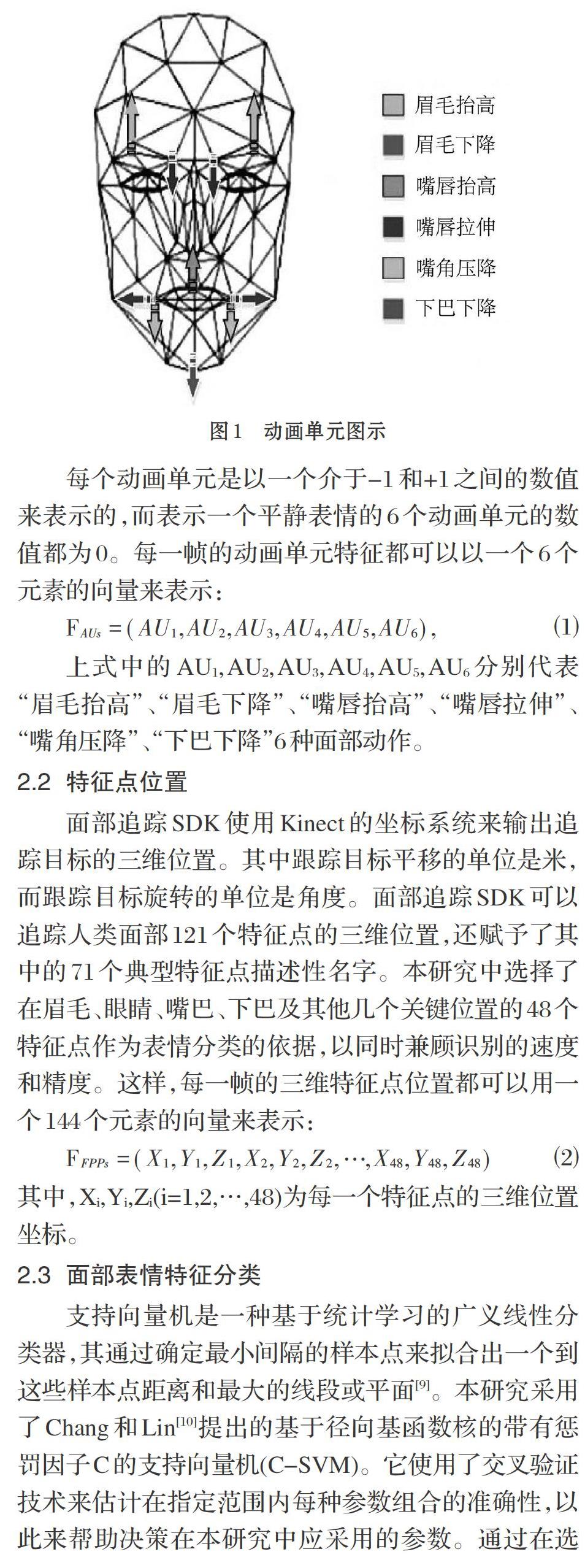

2.1 動畫單元

面部追蹤SDK的結果可以以6個動畫單元的權重組合來表示。這些動畫單元是平靜面部表情的二維變化量,用以調節虛擬人物的面部表情以模擬捕捉到的用戶的表情。

2.2 特征點位置

2.3 面部表情特征分類

支持向量機是一種基于統計學習的廣義線性分類器,其通過確定最小間隔的樣本點來擬合出一個到這些樣本點距離和最大的線段或平面[9]。本研究采用了Chang和Lin[10]提出的基于徑向基函數核的帶有懲罰因子C的支持向量機(C-SVM)。它使用了交叉驗證技術來估計在指定范圍內每種參數組合的準確性,以此來幫助決策在本研究中應采用的參數。通過在選擇的訓練集中使用5折交叉驗證后,我們獲得了支持向量機每個子分類器訓練模型的最優c和g參數。

2.4 面部表情特征融合

根據每個通道中采用的30幀畫面所得到的表情識別結果,通過表情分析的置信度進行融合。表情分析用于確定對7種表情分類的置信度,其中每個子分類器以該表情特定的特征集進行訓練。

3 實驗及結果

本研究用Kinect設備采集了12位參與人員以-20[°]、-10[°]、0[°]、10[°]、20[°]等5種角度展示的7種面部表情,并使用一臺配置為Intel i7-4770K 3.5GHz CPU 、8GB內存的計算機作為實驗運算平臺。由以上實驗重復5次所得到的2100組面部表情中,有2091組表情得到了正確分類,準確率高達99.6%,平均每組表情的識別時間為0.052s。

4 結語

本文所提出的二維三維混合面部表情識別方法,其核心是基于表情分析的分類和基于置信度的二維三維特征通道分類結果的融合。在使用價格低廉的Kinect作為傳感設備的情況下,能夠快速并且準確地實現對面部表情的識別,具有良好的性能表現,可應用在預算較低并且對識別實時性要求高的應用環境中。但由于時間所限,實驗中采用了自行采集的表情數據作為訓練集,其結果具有一定的局限性。下一步,計劃采用標準面部表情庫作為訓練集,以進一步測試本方法的識別準確率。同時開發獨立的面部跟蹤引擎,以減少對微軟面部跟蹤SDK的依賴性。

參考文獻(References):

[1] Keltner D, Tracy J, Sauter D A, et al. Expression of emotion[J]. Handbook of emotions,2016:467-482

[2] Ekman P. Facial expression and emotion[J]. American psychologist,1993.48(4):384.

[3] Zeng Z,Pantic M,Roisman G I,et al. A survey of affect recognition methods: Audio,visual, and spontaneous expressions[J]. IEEE transactions on pattern analysis and machine intelligence,2009.31(1):39-58

[4] Nicolaou M A,Gunes H,Pantic M. Continuous prediction of spontaneous affect from multiple cues and modalities in valence-arousal space[J]. IEEE Transactions on Affective Computing,2011.2(2):92-105

[5] Vinciarelli A,Pantic M,Heylen D,et al.Bridging the gap between social animal and unsocial machine: A survey of social signal processing[J]. IEEE Transactions on Affective Computing,2012.3(1):69-87

[6] Huynh T,Min R,Dugelay J L.An efficient LBP-based descriptor for facial depth images applied to gender recognition using RGB-D face data[C]//Asian Conference on Computer Vision.Springer,Berlin,Heidelberg,2012:133-145

[7] Kadambi A,Taamazyan V,Shi B,et al. Polarized 3d: High-quality depth sensing with polarization cues[C]//Proceedings of the IEEE International Conference on Computer Vision.2015:3370-3378

[8] Silverstein E,Snyder M.Implementation of facial recognition with Microsoft Kinect v2 sensor for patient verification[J]. Medical physics,2017.44(6):2391-2399

[9] Vapnik V N.An overview of statistical learning theory[J].IEEE transactions on neural networks,1999.10(5): 988-999

[10] Chang C C,Lin C J.LIBSVM:A library for support vector machines[J]. ACM transactions on intelligent systems and technology (TIST),2011.2(3):27