基于LReLU-Softplus激活函數(shù)的深度卷積神經(jīng)網(wǎng)絡(luò)

林長(zhǎng)方,黃毓珍,陳定柱,黃仲開(kāi)

(1.漳州衛(wèi)生職業(yè)學(xué)院健康與保健系,福建 漳州 363000;2.福建醫(yī)科大學(xué)附屬漳州市醫(yī)院病理科,福建 漳州 363000;3.福建醫(yī)科大學(xué)附屬漳州市醫(yī)院胸心外科,福建 漳州 363000;4.漳州衛(wèi)生職業(yè)學(xué)院現(xiàn)代教育技術(shù)中心,福建 漳州 363000)

1 研究背景

近十幾年來(lái),深度卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,CNNs)在圖像處理和語(yǔ)音識(shí)別等領(lǐng)域得到廣泛的應(yīng)用,取得令人矚目的成績(jī)[1-3]。激活函數(shù)作為CNNs的基本單元,可有效抑制網(wǎng)絡(luò)反向傳播過(guò)程中的殘差衰減,并縮短模型訓(xùn)練時(shí)間,提高收斂速度,是CNNs取得成功的主要因素[4]。常見(jiàn)的激活函數(shù)包含飽和非線性函數(shù)(Sigmoid、Tanh)和不飽和非線性函數(shù)(Softplus、ReLU)。飽和非線性激活函數(shù)在傳統(tǒng)神經(jīng)網(wǎng)絡(luò)中曾得到廣泛的應(yīng)用,但因其不能有效地解決函數(shù)由于飽和性而產(chǎn)生的梯度消失問(wèn)題而最終被舍棄[5]。不飽和非線性函數(shù)可有效抑制算法運(yùn)行過(guò)程中的梯度消失問(wèn)題,且網(wǎng)絡(luò)收斂速度快,是當(dāng)前廣為流行的激活函數(shù)[6]。然而,修正線性單元(rectified linear unit,ReLU)可能導(dǎo)致網(wǎng)絡(luò)出現(xiàn)“壞死”現(xiàn)象,網(wǎng)絡(luò)非常脆弱[7]。LReLU(ReLU-Leaky)、PReLU(Parametric ReLU)[8]等ReLU變形函數(shù)因帶有稀疏性解決了ReLU的“壞死”現(xiàn)象,但它們同ReLU一樣都是對(duì)模型的線性修正,因此都存在對(duì)模型表達(dá)能力弱的缺陷。Softplus函數(shù)為ReLU的非線性表達(dá),但不具備稀疏性[9-11]。本文分析了兩類激活函數(shù)的優(yōu)缺點(diǎn),并基于Softplus和LReLU函數(shù)提出了一種新的激活函數(shù)LReLU-Softplus,該函數(shù)兼具較強(qiáng)的稀疏能力與表達(dá)能力,且收斂能力強(qiáng),識(shí)別率高。

2 常見(jiàn)激活函數(shù)及特征

激活函數(shù)的主要功能是對(duì)CNNs卷積操作的非線性建模,影響模型訓(xùn)練中的前向與反向傳播兩個(gè)過(guò)程。常見(jiàn)激活函數(shù)的公式及函數(shù)曲線如下所示。

2.1 飽和非線性函數(shù)

Sigmoid函數(shù):f(x)=1/(1+e-x)。

Tanh函數(shù):f(x)=(ex-e-x)/(ex+e-x)。

從Sigmoid函數(shù)表達(dá)式和圖1可發(fā)現(xiàn),函數(shù)f(x)的值域在(0,1)間,輸入量x取值在0附近時(shí),激活函數(shù)對(duì)信號(hào)的增益效果較明顯。但當(dāng)x越來(lái)越大或越來(lái)越小時(shí),曲線越來(lái)越平緩,斜率越趨近于0,說(shuō)明函數(shù)對(duì)信號(hào)的增益趨近于0,此特性將導(dǎo)致在反向傳遞過(guò)程中梯度的消失,最終致使網(wǎng)絡(luò)參數(shù)難于得到有效的訓(xùn)練。另外Sigmoid函數(shù)非中心原點(diǎn)對(duì)稱、均值偏移(即{?x,y=f(x)≥0}),將致使函數(shù)在面對(duì)較深網(wǎng)絡(luò)時(shí)訓(xùn)練無(wú)法收斂。

Tanh函數(shù)為Sigmoid函數(shù)的改進(jìn)函數(shù),從圖1可見(jiàn)Tanh曲線以0為中心,f(x)的值域在(-1,1)間,因此,它緩解了均值偏移、訓(xùn)練收斂的速度加快。但它與Sigmoid函數(shù)一樣具有軟飽和性,同樣存在梯度消失的缺陷。

圖1 飽和非線性函數(shù)曲線

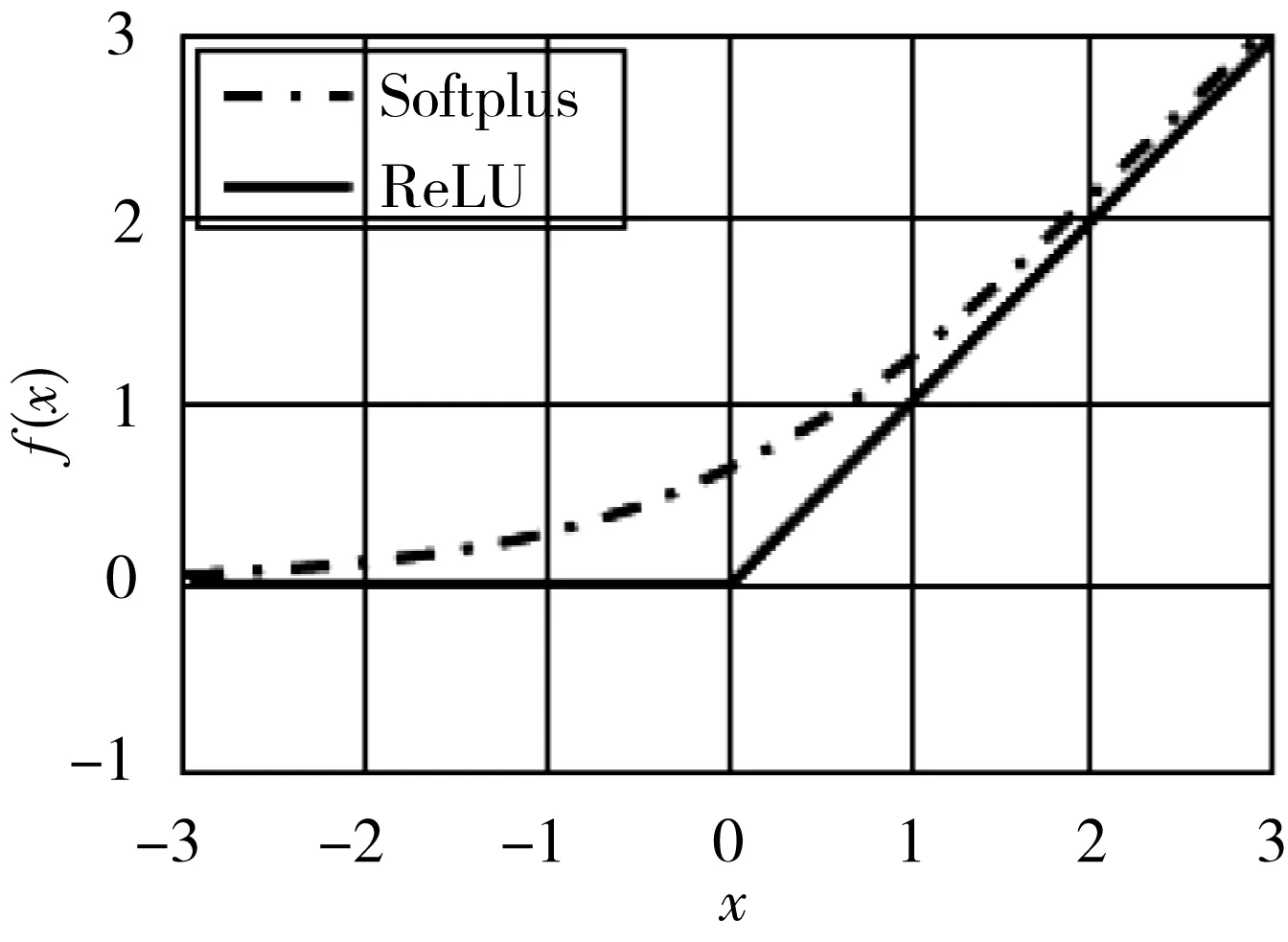

圖2 不飽和非線性函數(shù)曲線

2.2 不飽和非線性函數(shù)

Softplus函數(shù):f(x)=ln(ex+1)。

ReLU函數(shù):f(x)=max(0,x)。

LReLU、PReLU、RReLU函數(shù):f(x)=max(ax,x)。

圖3 LReLU、PReLU、RReLU函數(shù)曲線

圖4 LReLU-Softplus函數(shù)曲線

不飽和非線性函數(shù)已成為當(dāng)前構(gòu)建深度卷積神經(jīng)網(wǎng)絡(luò)首選的激活函數(shù),從圖2、圖3可發(fā)現(xiàn)Softplus、ReLU、LReLU等均有效解決了飽和非線性函數(shù)梯度消失的問(wèn)題,但從函數(shù)表達(dá)式及曲線圖可以看出它們各自都存在缺陷。ReLU及變形函數(shù)LReLU、PReLU、RReLU均為分段函數(shù),ReLUs函數(shù)強(qiáng)制將輸入值x小于0的輸出結(jié)果置為0,從而使網(wǎng)絡(luò)具有稀疏表達(dá)能力,可有效緩解過(guò)擬合的發(fā)生。但稀疏性會(huì)致使模型的有效容量降低,可能產(chǎn)生“壞死”現(xiàn)象。LReLU等變形函數(shù)是對(duì)ReLU函數(shù)的變形,當(dāng)輸入值x小于0時(shí)不再?gòu)?qiáng)制置輸出為0,而是輸出ax(a為一個(gè)很小的常數(shù)),這樣使得負(fù)激活可在CNNs中得到傳播,提高特征學(xué)習(xí)的效率。然而變形函數(shù)與ReLUs一樣存在一個(gè)缺陷,即在x大于0時(shí)只能對(duì)數(shù)據(jù)進(jìn)行線性映射,所以此類激活函數(shù)對(duì)CNNs的表達(dá)能力有欠缺。Softplus函數(shù)是對(duì)ReLU函數(shù)近似光滑、非線性的表示,可對(duì)所有數(shù)據(jù)進(jìn)行非線性的映射,但稀疏表達(dá)能力欠缺。

3 LReLU-Softplus激活函數(shù)

結(jié)合LReLU和Softplus函數(shù)自身的優(yōu)勢(shì),本文提出了一種新的不飽和非線性激勵(lì)函數(shù)LReLU-Softplus,基本原理為:先將Softplus函數(shù)曲線向下平移ln2個(gè)單位,然后將輸入值x小于0的輸出置換為L(zhǎng)ReLU函數(shù)的ax,LReLU-Softplus函數(shù)公式及曲線為:

由圖3可見(jiàn),LReLU-Softplus函數(shù)保留了部分負(fù)軸數(shù)據(jù),修正了數(shù)據(jù)的分布,繼承了ReLU函數(shù)收斂速度快的優(yōu)點(diǎn),同時(shí)緩解了出現(xiàn)“壞死”的概率。更重要的是實(shí)現(xiàn)了函數(shù)的非線性、光滑映射。因此,LReLU-Softplus函數(shù)兼具稀疏表達(dá)能力和廣泛、非線性映射性。

4 實(shí)驗(yàn)及結(jié)果分析

為了驗(yàn)證基于LReLU-Softplus函數(shù)的CNNs模型的執(zhí)行效率,本文以MNIST和CIFAR-10為實(shí)驗(yàn)數(shù)據(jù)庫(kù),將卷積層分別使用LReLU-Softplus函數(shù)和常見(jiàn)激活函數(shù)的CNNS模型進(jìn)行對(duì)比實(shí)驗(yàn)。實(shí)驗(yàn)在Matlab 2014a開(kāi)發(fā)工具,基于Caffe框架的CNN環(huán)境下完成。硬件配置:Intel 酷睿i7 6700@3.4GHz 四核CPU,16G DDR4 2133MHz內(nèi)存,4G AMD Radeon R9 370性能級(jí)獨(dú)立顯卡;64 bit windows 10 OS。

4.1 MNIST實(shí)驗(yàn)與結(jié)果分析

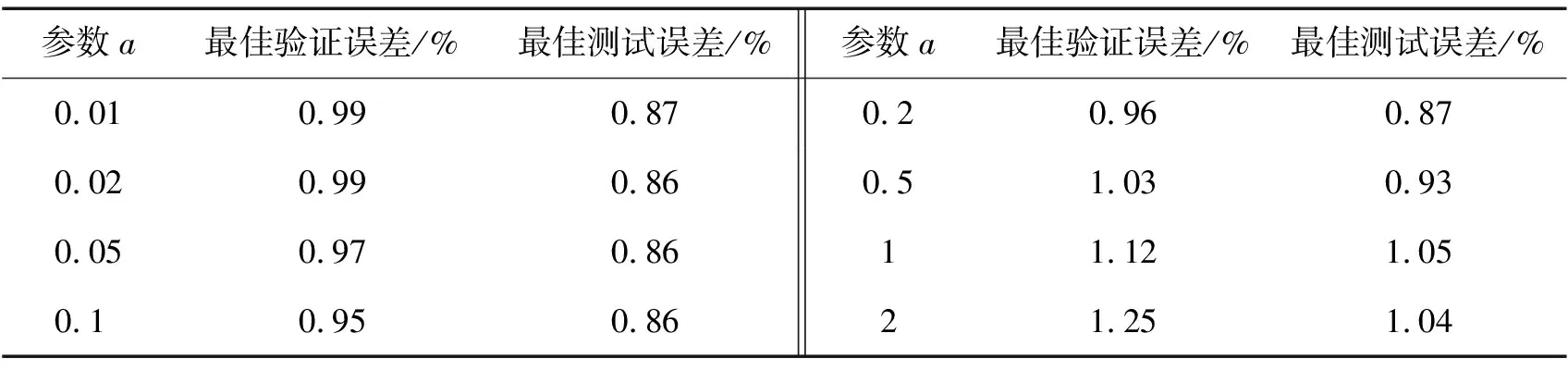

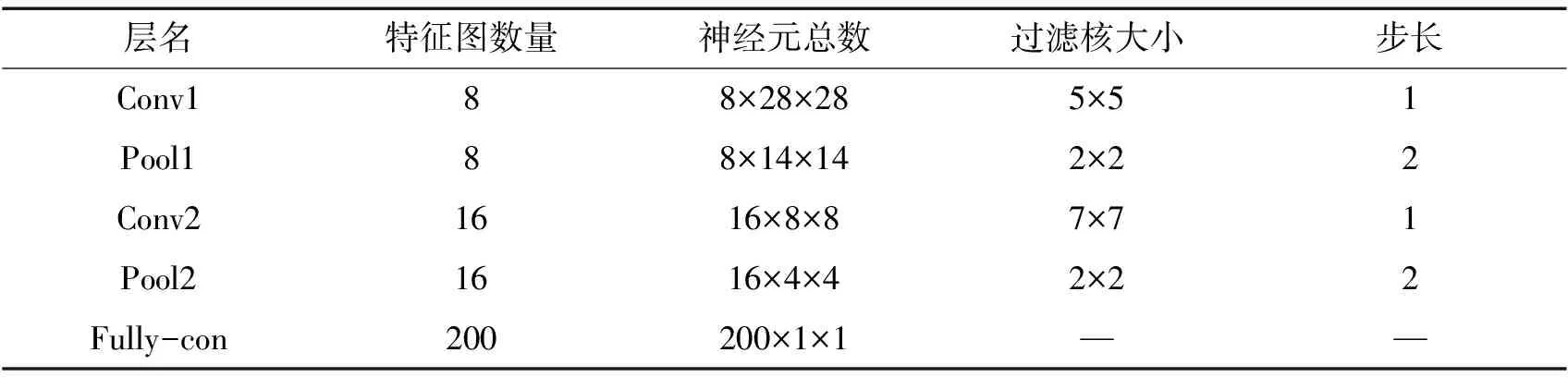

手寫羅馬數(shù)字?jǐn)?shù)據(jù)集(MNIST)由訓(xùn)練圖片(60 000幅)和測(cè)試圖片(10 000幅)構(gòu)成,圖片均為28×28的灰度圖像。實(shí)驗(yàn)所構(gòu)建的CNNs模型架構(gòu)及參數(shù)如表1所示,采樣層的池化固定采用max-pooling方法,卷積層分別采用Sigmoid、Tanh、Softplus、ReLU和LReLU-Softplus作為激活函數(shù)。對(duì)LReLU-Softplus函數(shù)中的常量a分別選取0.01、0.02、0.05、0.1、0.2、0.5、1、2八個(gè)常量進(jìn)行測(cè)試,測(cè)試結(jié)果如表2所示,從表2可見(jiàn)a=0.1時(shí)測(cè)試取得最好的性能。選取最合適的常量a,基于不同激活函數(shù)的CNNs在MNIST上的實(shí)驗(yàn)結(jié)果如表3、圖5所示。

表1 MNIST實(shí)驗(yàn)CNNs架構(gòu)

表2 LReLU-Softplus函數(shù)常量a測(cè)試結(jié)果

表3 不同激活函數(shù)實(shí)驗(yàn)結(jié)果

圖5 不同激活函數(shù)識(shí)別正確率

觀察表3、圖5可發(fā)現(xiàn),基于Sigmoid函數(shù)的網(wǎng)絡(luò)不僅收斂速度緩慢且識(shí)別正確率只有98.40%;Tanh函數(shù)雖能使網(wǎng)絡(luò)的收斂速度提高,但識(shí)別正確率也僅為98.51%;基于Softplus函數(shù)的網(wǎng)絡(luò)較Sigmoid、Tanh函數(shù)收斂速度有所提升,識(shí)別正確率達(dá)到98.90%;使用ReLU函數(shù)的網(wǎng)絡(luò)收斂速度進(jìn)一步提高,識(shí)別正確率最高達(dá)到99.25%。而基于LReLU-Softplus函數(shù)的CNNs網(wǎng)絡(luò)識(shí)別正確率、最佳驗(yàn)證誤差、最佳測(cè)試誤差分別達(dá)到99.51%、0.95%、0.86%,各項(xiàng)均為最佳值。

4.2 CIFAR-10實(shí)驗(yàn)結(jié)果與分析

CIFAR-10數(shù)據(jù)庫(kù)由10個(gè)不同類型的彩色圖像構(gòu)成,分為訓(xùn)練圖片集(50 000幅)和測(cè)試圖片集(10 000幅),圖片大小均為32×32,每個(gè)像素點(diǎn)包含R、G、B三個(gè)數(shù)值。本實(shí)驗(yàn)利用Y=0.3R+0.59G+0.11B(Y為YUV彩色空間中的亮度)對(duì)圖像進(jìn)行灰度級(jí)的轉(zhuǎn)換,然后對(duì)圖像進(jìn)行ZCA白化處理,以降低圖像特征之間的相關(guān)性,并利用Matlab對(duì)圖像進(jìn)行歸一化處理。實(shí)驗(yàn)所構(gòu)建的CNNs模型架構(gòu)及參數(shù)如表4所示,采樣層池化分別采用mean-pooling、max-pooling方法,卷積層使用不同的激活函數(shù),CNNs對(duì)CIFAR-10數(shù)據(jù)集的分類識(shí)別最佳驗(yàn)證誤差和測(cè)試誤差如表5所示。

表4 CIFAR-10實(shí)驗(yàn)CNNs架構(gòu)

表5 CIFAR-10實(shí)驗(yàn)結(jié)果

觀察表5可發(fā)現(xiàn),不論采用最大值或平均值池化,相較于其他常見(jiàn)激活函數(shù),基于LReLU-Softplus激活函數(shù)的CNNs對(duì)CIFAR-10數(shù)據(jù)集的分類識(shí)別最佳驗(yàn)證誤差和最佳測(cè)試誤差均為最低。

實(shí)驗(yàn)結(jié)果表明,基于LReLU-Softplus函數(shù)的卷積神經(jīng)網(wǎng)絡(luò)在MNIST和CIFAR-10數(shù)據(jù)集上均取得較其他常見(jiàn)激活函數(shù)更低的誤差率。其中,在MNIST數(shù)據(jù)集上的最佳驗(yàn)證誤差達(dá)到0.95%;而在CIFAR-10數(shù)據(jù)集上,不論選擇哪種池化方法,最佳驗(yàn)證誤差和最佳測(cè)試誤差均較其他常見(jiàn)激活函數(shù)降低了1%~2%。

5 結(jié)語(yǔ)

本文針對(duì)深度卷積神經(jīng)網(wǎng)絡(luò)卷積層中常使用的激活函數(shù)可能存在“壞死”現(xiàn)象、表達(dá)能力不足、欠缺稀疏能力或不易收斂等缺陷,設(shè)計(jì)了一種新的不飽和非線性激勵(lì)函數(shù)LReLU-Softplus。通過(guò)在MNIST和CIFAR-10數(shù)據(jù)集上的實(shí)驗(yàn)表明,基于LReLU-Softplus函數(shù)的深度卷積神經(jīng)網(wǎng)絡(luò)不僅收斂速度快,而且識(shí)別效率更高,誤差率更低。

長(zhǎng)春師范大學(xué)學(xué)報(bào)2019年10期

長(zhǎng)春師范大學(xué)學(xué)報(bào)2019年10期

- 長(zhǎng)春師范大學(xué)學(xué)報(bào)的其它文章

- 校企協(xié)同育人機(jī)制下體育產(chǎn)業(yè)人才培養(yǎng)模塊化實(shí)訓(xùn)模式研究

- 基于可持續(xù)發(fā)展視角的現(xiàn)代服務(wù)業(yè)發(fā)展能力評(píng)價(jià)研究

- 音樂(lè)治療團(tuán)體輔導(dǎo)對(duì)大學(xué)生社交焦慮的干預(yù)研究

- 幼師生職業(yè)自我效能來(lái)源問(wèn)卷的編制及信效度檢驗(yàn)

- 基于SPOC的線上線下混合教學(xué)模式探究與實(shí)踐

- 基于遙感技術(shù)的環(huán)巢湖區(qū)域濕地景觀格局及可持續(xù)設(shè)計(jì)