基于級聯(lián)Vnet-S網(wǎng)絡(luò)的CT影像單一器官自動(dòng)分割算法

徐寶泉 凌彤輝

摘 要:為了快速準(zhǔn)確地對計(jì)算機(jī)斷層掃描(CT)影像中的器官進(jìn)行分割,提出基于級聯(lián)Vnet-S網(wǎng)絡(luò)的單一器官自動(dòng)分割算法。首先,使用第一個(gè)Vnet-S網(wǎng)絡(luò)對CT影像中的器官進(jìn)行粗分割;然后,選擇分割結(jié)果中的最大連接通量做兩次膨脹,根據(jù)膨脹后的最大連接通量確定器官邊界并提取器官區(qū)域;最后,使用第二個(gè)Vnet-S網(wǎng)絡(luò)對器官進(jìn)行細(xì)分割。為了驗(yàn)證算法的性能,采用MICCAI 2017 Liver Tumor Segmentation Challenge (LiTS)數(shù)據(jù)集進(jìn)行肝臟分割實(shí)驗(yàn),采用ISBI LUng Nodule Analysis 2016 (LUNA16)數(shù)據(jù)集進(jìn)行肺分割實(shí)驗(yàn)。級聯(lián)Vnet-S算法在LiTS的70例線上測試數(shù)據(jù)上的Dice系數(shù)為0.9600,在LUNA16的288例測試數(shù)據(jù)上的Dice系數(shù)為0.9810,均高于Vnet-S網(wǎng)絡(luò)和Vnet網(wǎng)絡(luò)。實(shí)驗(yàn)結(jié)果表明,基于級聯(lián)Vnet-S網(wǎng)絡(luò)的單一器官分割算法可以準(zhǔn)確地對器官進(jìn)行分割,而且級聯(lián)Vnet-S算法的計(jì)算量小于Unet網(wǎng)絡(luò)和Vnet網(wǎng)絡(luò)。

關(guān)鍵詞:器官分割;Vnet-S;深度學(xué)習(xí);分割網(wǎng)絡(luò);級聯(lián)網(wǎng)絡(luò)結(jié)構(gòu)

中圖分類號(hào):?TP391.4

文獻(xiàn)標(biāo)志碼:A

Automatic segmentation algorithm for single organ of CT images based on cascaded Vnet-S network

XU Baoquan1,2, LING Tonghui1*

1.Shanghai Institute of Technical Physics,Chinese Academy of Sciences, Shanghai 200083, China?;

2.University of Chinese Academy of Sciences, Beijing 100049, China

Abstract:?In order to realize fast and accurate segmentation of organs in Computed Tomography (CT) images, a automatic segmentation algorithm for single organ based on cascaded Vnet-S network was proposed. Firstly, the organ in the CT image was coarsely segmented by using the first Vnet-S network. Then, the maximum connection flux in the segmentation result was selected and expanded twice, and the organ boundary was determined and the organ area was extracted according to the maximum connection flux after expansion. Finally, the organ was finely segmented by using the second Vnet-S network. In order to verify the performance of the proposed algorithm, a liver segmentation experiment was carried out on the MICCAI 2017 Liver Tumor Segmentation Challenge (LiTS) dataset, and a lung segmentation experiment was carried out on the ISBI LUng Nodule Analysis 2016 (LUNA16) dataset. The cascaded Vnet-S algorithm has a Dice coefficient of 0.9600 on the online test data of 70 cases in LiTS and a Dice coefficient of 0.9810 on the 288 cases in LUNA16, which are higher than those of Vnet-S network and Vnet network. Experimental results show that the single organ segmentation algorithm based on cascaded Vnet-S network can accurately segment organs with lower computational complexity compared with Vnet and Unet networks.

Key words:?organ segmentation; Vnet-S; deep learning; segmentation network; cascaded network structure

0 引言

醫(yī)學(xué)圖像的器官自動(dòng)分割技術(shù)是對人體器官進(jìn)行定性和定量分析的基礎(chǔ),可以幫助醫(yī)生診斷和制定患者的治療計(jì)劃,也是圖像引導(dǎo)手術(shù)、腫瘤放療和臨床治療評價(jià)的主要前提,是介入消融和磁感應(yīng)熱療等技術(shù)中必不可缺的一環(huán),對醫(yī)生的臨床工作有極大的價(jià)值。計(jì)算機(jī)斷層掃描(Computed Tomography, CT)是獲取人體內(nèi)部信息的主要手段。但是針對CT影像中的器官實(shí)現(xiàn)快速準(zhǔn)確的自動(dòng)化分割是非常困難的任務(wù),因?yàn)镃T影像非常復(fù)雜,存在偽影、灰度不均勻、不同組織間灰度相似等問題,而且在圖像特征方面也缺少簡單的線性特征,這些都增加了算法的設(shè)計(jì)難度。另一方面CT影像屬于三維圖像,數(shù)據(jù)規(guī)模大,要完成一例CT影像的分割計(jì)算,容易出現(xiàn)計(jì)算量大、耗時(shí)長的問題。在器官分割領(lǐng)域,研究者們采用的圖像分割算法主要分為傳統(tǒng)圖像算法和深度學(xué)習(xí)的方法。傳統(tǒng)圖像分割算法主要有三種:基于圖像灰度的算法[1-4]、基于統(tǒng)計(jì)形狀模型的算法[5-7]和基于紋理特征的算法[8-10]。而深度學(xué)習(xí)的方法主要分為二維分割網(wǎng)絡(luò)和三維分割網(wǎng)絡(luò):二維分割網(wǎng)絡(luò)包括全卷積神經(jīng)網(wǎng)絡(luò)(Fully Convolutional Network, FCN)網(wǎng)絡(luò)[11]和2D Unet網(wǎng)絡(luò)[12]等;三維分割網(wǎng)絡(luò)包括3D Unet網(wǎng)絡(luò)[13]和Vnet網(wǎng)絡(luò)[14]等。

傳統(tǒng)器官分割算法都存在不足之處: 基于灰度的算法需要器官和背景有較大的差異,當(dāng)差異較小時(shí),分割的準(zhǔn)確度會(huì)大幅下降;基于統(tǒng)計(jì)形狀模型的算法對形狀不規(guī)則的器官無法準(zhǔn)確分割;基于紋理特征的算法依賴于特征分類器和人工提取的特征,人工提取特征費(fèi)時(shí)費(fèi)力,無法保證泛化能力,分類器的性能也會(huì)大大影響算法的性能。

深度學(xué)習(xí)的方法也存在一定的問題。針對CT影像,二維分割網(wǎng)絡(luò)比三維分割網(wǎng)絡(luò)分割準(zhǔn)確度低,原因在于CT影像作為三維圖像,圖像中的三維空間信息非常豐富,但是二維分割網(wǎng)絡(luò)無法利用這些信息。通過將多層CT軸切片圖像作為二維分割網(wǎng)絡(luò)的輸入可以緩解這個(gè)問題,但是對三維空間信息的利用仍不夠充分。三維分割網(wǎng)絡(luò)的問題在于運(yùn)行時(shí)需要占用大量顯存,而目前圖形處理器(Graphics Processing Unit, GPU)顯存較小,這個(gè)硬件的限制導(dǎo)致三維分割網(wǎng)絡(luò)需要大尺度縮小輸入圖像尺寸,從而導(dǎo)致圖像特征丟失,影響分割精度。同時(shí)三維分割網(wǎng)絡(luò)的深度相比二維分割網(wǎng)絡(luò)也需要縮減,感受野隨之減小。圖像的大尺度縮小和小感受野導(dǎo)致三維分割網(wǎng)絡(luò)在器官分割的準(zhǔn)確度仍然不夠理想。

為解決器官的快速準(zhǔn)確分割問題,本文提出一種基于級聯(lián)Vnet-S網(wǎng)絡(luò)的單一器官自動(dòng)分割算法。該算法屬于有監(jiān)督學(xué)習(xí)算法,需要采用不同器官的數(shù)據(jù)集對算法進(jìn)行訓(xùn)練,得到對應(yīng)的器官分割算法,適用于CT影像中多種大型器官。該算法為端到端的結(jié)構(gòu),只需要輸入圖像,通過計(jì)算便可直接得到器官的分割結(jié)果。該算法的核心是采用級聯(lián)Vnet-S網(wǎng)絡(luò)結(jié)構(gòu),由兩個(gè)Vnet-S網(wǎng)絡(luò)搭建而成,分別用于器官的定位和分割。該算法的特點(diǎn)是準(zhǔn)確度高、計(jì)算量小。本文針對肝臟和肺這兩個(gè)器官進(jìn)行了實(shí)驗(yàn),利用公開數(shù)據(jù)集驗(yàn)證了算法的分割準(zhǔn)確度,并評估了算法的計(jì)算量,驗(yàn)證了算法低計(jì)算量的特點(diǎn)。

1 相關(guān)工作

文獻(xiàn)[11]中提出了全卷積神經(jīng)網(wǎng)絡(luò)(FCN),實(shí)現(xiàn)了對圖像的端到端語義分割。FCN由卷積層、下采樣層、上采樣層和激活函數(shù)組成,它本質(zhì)上是對圖像進(jìn)行像素級的分類。2D Unet網(wǎng)絡(luò)則在FCN基礎(chǔ)上進(jìn)行了優(yōu)化,采用了對稱級聯(lián)結(jié)構(gòu),中間的級聯(lián)層彌補(bǔ)了細(xì)顆粒度圖像特征和位置信息。3D Unet網(wǎng)絡(luò)則將Unet網(wǎng)絡(luò)從2D擴(kuò)展到3D,即網(wǎng)絡(luò)輸入從二維圖像變?yōu)槿S圖像。Vnet網(wǎng)絡(luò)同樣也是三維網(wǎng)絡(luò),但是在結(jié)構(gòu)上對3D Unet網(wǎng)絡(luò)進(jìn)行了優(yōu)化,改變了卷積層結(jié)構(gòu)和池化的方式,增加了網(wǎng)絡(luò)的深度。

在器官分割領(lǐng)域,研究者們基于深度學(xué)習(xí)的方法取得了很多研究成果。例如:文獻(xiàn)[15]中的方法采用了改進(jìn)的全卷積神經(jīng)網(wǎng)絡(luò)對肝臟進(jìn)行分割;文獻(xiàn)[16]中提出了一種肺分割算法,先利用閾值對肺進(jìn)行定位,然后利用Vnet網(wǎng)絡(luò)對肺進(jìn)行分割;文獻(xiàn)[17]中的方法針對肝臟分割問題采用三維分割網(wǎng)絡(luò)結(jié)合條件隨機(jī)場的方式,取得了較高的準(zhǔn)確率。

針對CT影像中的器官分割,三維分割網(wǎng)絡(luò)是目前主要采用的方法之一,因?yàn)槿S分割網(wǎng)絡(luò)可以充分利用CT影像中的空間信息;但是三維分割網(wǎng)絡(luò)存在因縮小圖像尺寸導(dǎo)致分割精度不高的問題,為此可以采用級聯(lián)網(wǎng)絡(luò)結(jié)構(gòu)來緩解這個(gè)問題。級聯(lián)網(wǎng)絡(luò)結(jié)構(gòu)的主要思想是通過一個(gè)前置網(wǎng)絡(luò)縮小分割網(wǎng)絡(luò)需要計(jì)算的區(qū)域范圍,從而減小圖像需要縮小的比例,緩解了三維分割網(wǎng)絡(luò)的問題。例如:文獻(xiàn)[18]中的方法使用了一個(gè)三維卷積神經(jīng)網(wǎng)絡(luò)對脊椎的邊界位置進(jìn)行回歸,得到脊椎的定位框,然后將定位切割出的脊椎圖像放入三維分割網(wǎng)絡(luò)中進(jìn)行分割;文獻(xiàn)[19]中的方法是使用了兩個(gè)3D Unet網(wǎng)絡(luò),第一個(gè)3D Unet網(wǎng)絡(luò)采用掃描的方式對圖像進(jìn)行粗分割,第二個(gè)3D Unet網(wǎng)絡(luò)再對粗分割的結(jié)果進(jìn)行細(xì)分割。級聯(lián)網(wǎng)絡(luò)結(jié)構(gòu)在縮小計(jì)算區(qū)域的同時(shí)還提高了目標(biāo)在圖像數(shù)據(jù)中的比例,能緩解類別不平衡問題,提高分割準(zhǔn)確度。

考慮到三維分割網(wǎng)絡(luò)在器官分割上的優(yōu)勢,并借鑒級聯(lián)網(wǎng)絡(luò)結(jié)構(gòu)的思想,本文提出了基于級聯(lián)Vnet-S網(wǎng)絡(luò)的單一器官自動(dòng)分割算法。Vnet-S網(wǎng)絡(luò)作為三維分割網(wǎng)絡(luò),是基于Vnet網(wǎng)絡(luò)設(shè)計(jì)和改進(jìn)的,感受野較大,有著和Vnet網(wǎng)絡(luò)相似的性能;但是它的參數(shù)量和計(jì)算量大大減少,更適合部署。而整個(gè)算法框架是由兩個(gè)Vnet-S網(wǎng)絡(luò)搭建而成:第一個(gè)Vnet-S網(wǎng)絡(luò)用于對器官進(jìn)行定位,定位的方式是利用Vnet-S網(wǎng)絡(luò)的粗分割結(jié)果再結(jié)合一定的后處理;第二個(gè)Vnet-S網(wǎng)絡(luò)對定位的器官進(jìn)行準(zhǔn)確分割。

2 Vnet-S網(wǎng)絡(luò)

Vnet網(wǎng)絡(luò)是三維分割網(wǎng)絡(luò),在三維圖像分割方面有著廣泛的應(yīng)用。Vnet網(wǎng)絡(luò)成對稱結(jié)構(gòu):左半部分為特征提取過程,由卷積層和池化層組成;右半部分為特征重構(gòu)過程,由卷積層和反卷積層組成。特征提取和特征重構(gòu)中間為級聯(lián)層。Vnet網(wǎng)絡(luò)有著優(yōu)秀的擬合能力,但是用于肝臟和肺這類器官分割時(shí),其網(wǎng)絡(luò)結(jié)構(gòu)過大,網(wǎng)絡(luò)的擬合能力溢出,容易過擬合,而且網(wǎng)絡(luò)過大會(huì)增加硬件的負(fù)擔(dān)。因此在Vnet網(wǎng)絡(luò)結(jié)構(gòu)的基礎(chǔ)上,本文提出Vnet-S網(wǎng)絡(luò)結(jié)構(gòu)。

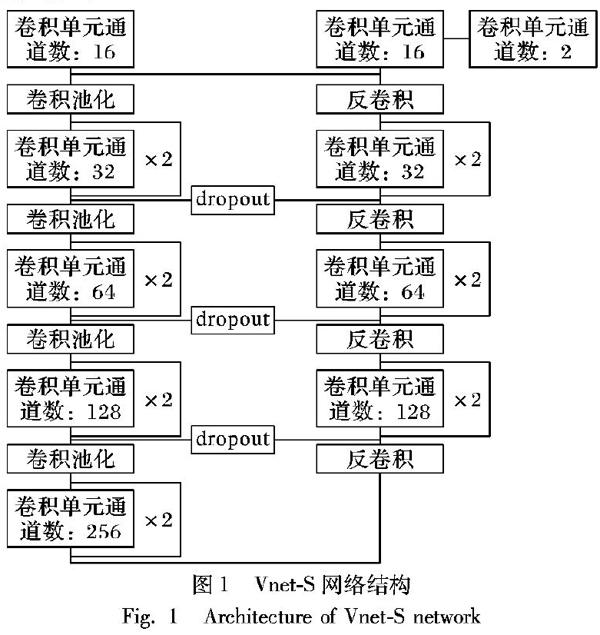

Vnet-S網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。Vnet-S網(wǎng)絡(luò)相比Vnet網(wǎng)絡(luò)改進(jìn)的地方主要是網(wǎng)絡(luò)結(jié)構(gòu)和卷積單元:Vnet-S網(wǎng)絡(luò)每個(gè)卷積層都只包含2個(gè)卷積單元,而Vnet網(wǎng)絡(luò)除了在左2卷積層和右2卷積層包含2個(gè)卷積單元外,其余卷積層都包含3個(gè)卷積單元;Vnet-S網(wǎng)絡(luò)的卷積單元由卷積核大小為3×3×3的卷積、批歸一化(Batch Normalization, BN)[20]和PReLU激活函數(shù)組成,而Vnet網(wǎng)絡(luò)中卷積單元由卷積核大小為5×5×5的卷積和PReLU激活函數(shù)組成。BN的加入可以加快模型收斂,緩解過擬合。Vnet-S網(wǎng)絡(luò)另一處改進(jìn)是在級聯(lián)過程中加入了Dropout[21],Dropout提供了正則化效果,可以緩解模型的過擬合問題。

Vnet-S網(wǎng)絡(luò)其他結(jié)構(gòu)和Vnet網(wǎng)絡(luò)保持一致,包括加入級聯(lián)層、采用卷積池化和采用殘差學(xué)習(xí)結(jié)構(gòu)。級聯(lián)層的作用是將特征重構(gòu)的特征圖與特征提取中等大小的特征圖進(jìn)行拼接,再進(jìn)行卷積,從而彌補(bǔ)了細(xì)顆粒度圖像特征和目標(biāo)的位置信息。卷積池化,即使用2×2×2 的卷積核對特征圖進(jìn)行卷積,步伐大小為2,從而達(dá)到池化的效果。卷積池化的好處在于訓(xùn)練網(wǎng)絡(luò)時(shí)占用更小的內(nèi)存。殘差學(xué)習(xí)結(jié)構(gòu)是在文獻(xiàn)[22]中提出的結(jié)構(gòu),即將卷積層的輸入與卷積層最后的輸出進(jìn)行加和,緩解了梯度消失的問題。

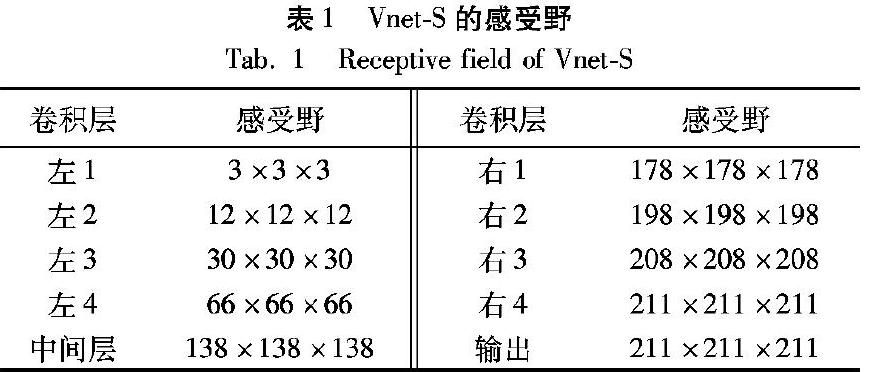

Vnet-S網(wǎng)絡(luò)最后輸出兩個(gè)和原圖像尺寸大小相同的體素塊,通過softmax函數(shù)得到每個(gè)體素屬于前景和背景的概率,

如果前景概率大于背景概率,則預(yù)測為前景目標(biāo),標(biāo)記為1,反之標(biāo)記為0。訓(xùn)練Vnet-S網(wǎng)絡(luò)的損失函數(shù)采用Dice損失函數(shù),Dice損失函數(shù)的公式和Dice系數(shù)的公式相同。Dice系數(shù)是衡量分割準(zhǔn)確度的重要指標(biāo),它的值越大,則分割準(zhǔn)確度越高。Dice系數(shù)計(jì)算公式如下:

D=2∑ N i=1 pigi / ?( ∑ N i=1 p2i+∑ N i=1 g2i )

(1)

其中:N代表體素塊的體素?cái)?shù)量;pi代表網(wǎng)絡(luò)的預(yù)測結(jié)果;gi代表對應(yīng)體素真實(shí)標(biāo)記。Dice損失函數(shù)相比交叉熵?fù)p失函數(shù)的優(yōu)勢在于:對類別不平衡問題沒有那么敏感,更適合訓(xùn)練類別不平衡的分割問題。

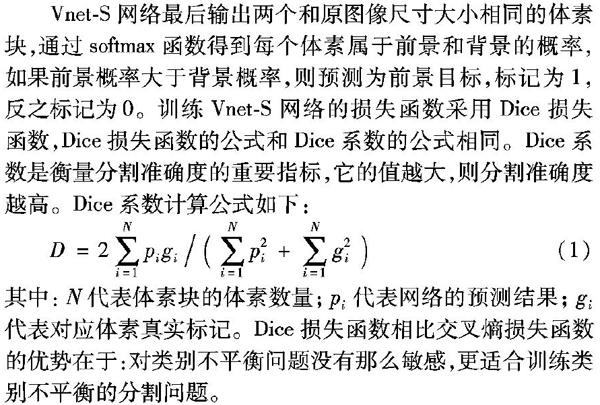

Vnet-S網(wǎng)絡(luò)在網(wǎng)絡(luò)深度上和2D Unet網(wǎng)絡(luò)是相同的,比3D Unet網(wǎng)絡(luò)多一層,有著比3D Unet網(wǎng)絡(luò)更大的感受野。大的感受野可以讓網(wǎng)絡(luò)對輸入體數(shù)據(jù)中的全局內(nèi)容進(jìn)行感知,Vnet-S網(wǎng)絡(luò)各層感受野如表1所示。

3 器官分割算法

器官分割算法是在Vnet-S網(wǎng)絡(luò)基礎(chǔ)上搭建而成,采用兩個(gè)Vnet-S網(wǎng)絡(luò)分別用于器官的定位和分割。整個(gè)算法流程如圖2所示:先讀入CT影像,提取圖像數(shù)據(jù),對數(shù)據(jù)進(jìn)行預(yù)處理;然后進(jìn)行器官定位,根據(jù)定位結(jié)果對數(shù)據(jù)進(jìn)行提取;最后進(jìn)行器官分割,并返回分割結(jié)果。

3.1 預(yù)處理

預(yù)處理主要包括:分辨率標(biāo)準(zhǔn)化、調(diào)窗處理和灰度值標(biāo)準(zhǔn)化。CT影像由于機(jī)器的差別或者參數(shù)設(shè)置的差異,分辨率大相徑庭,因此需要對醫(yī)學(xué)圖像進(jìn)行分辨率的標(biāo)準(zhǔn)化。對于肝臟分割實(shí)驗(yàn),選擇分辨率0.69mm×0.69mm×1.0mm對圖像進(jìn)行標(biāo)準(zhǔn)化;而對于肺分割實(shí)驗(yàn),選擇1.0mm×1.0mm×1.0mm進(jìn)行標(biāo)準(zhǔn)化。然后是針對不同的器官選擇合適的灰度值窗口,該操作可以過濾不相關(guān)的組織器官,提高分割準(zhǔn)確率。肝臟分割實(shí)驗(yàn)選擇灰度窗口范圍為[-250,250],肺分割實(shí)驗(yàn)因?yàn)榉尾颗c其他組織灰度值差異較大,不需要截取灰度值窗口。最后分別統(tǒng)計(jì)肝臟和肺訓(xùn)練數(shù)據(jù)所有圖像數(shù)據(jù)的灰度值均值和標(biāo)準(zhǔn)差,利用這個(gè)均值和標(biāo)準(zhǔn)差對圖像灰度值進(jìn)行標(biāo)準(zhǔn)化。

3.2 器官定位

本文采用圖像分割的方法來進(jìn)行定位,具體步驟如下:1)通過分割網(wǎng)絡(luò)計(jì)算得到分割結(jié)果;2)選擇分割結(jié)果中的最大連接通量(對于肺分割,則選擇最大的兩個(gè)連接通量);3)對最大連接通量做兩次膨脹;4)根據(jù)最大連接通量的范圍確定器官的邊界。定位算法最后得到6個(gè)值,分別是器官在x軸、y軸和z軸邊界的最大最小值。

選擇最大連接通量是為了過濾圖像分割結(jié)果中的假陽性。選擇最大連接通量的方式是先標(biāo)記分割結(jié)果中的連接通量,然后選擇體素點(diǎn)最多的連接通量。兩次膨脹操作是為了保證定位的區(qū)域邊界能夠包含全部器官體素點(diǎn)。因?yàn)楹罄m(xù)的器官分割是根據(jù)器官定位的結(jié)果提取目標(biāo)區(qū)域再進(jìn)行分割,當(dāng)定位出現(xiàn)偏差,會(huì)導(dǎo)致提取的器官不完整,將嚴(yán)重影響分割結(jié)果,因此做了兩次膨脹,放寬了邊界的大小。器官定位的Vnet-S網(wǎng)絡(luò)在計(jì)算前需要將圖像縮小到原來的1/4。

3.3 器官分割

根據(jù)器官定位提供的區(qū)域邊界,從預(yù)處理后的圖像數(shù)據(jù)中將該區(qū)域切割出來;然后使用Vnet-S網(wǎng)絡(luò)對其進(jìn)行分割計(jì)算,網(wǎng)絡(luò)計(jì)算前先將提取的圖像數(shù)據(jù)縮小到原來的1/2;再對分割結(jié)果進(jìn)行還原得到最后的分割結(jié)果。

還原操作如下:先采用最近鄰插值算法將分割結(jié)果放大2倍;然后利用區(qū)域邊界對分割結(jié)果進(jìn)行填補(bǔ)還原為切割前的圖像大小;最后根據(jù)原始分辨率對分割結(jié)果進(jìn)行縮放得到最終的分割結(jié)果。

4 評價(jià)指標(biāo)

為了更全面地衡量圖像分割的準(zhǔn)確度,除了采用Dice系數(shù)指標(biāo)外,還采用以下指標(biāo)對器官分割結(jié)果進(jìn)行評估,這四個(gè)評價(jià)指標(biāo)都是數(shù)值越小,代表分割精度越高。

1)體積重疊誤差(Volume Overlap Error, VOE):

VOE(A,B)=1- | A∩B | ?/ ?| A∪B |

(2)

2)相對體積偏差(Relative Volume Difference, RVD):

RVD(A,B)= (| B | - | A |)/ ?| A |

(3)

3)平均對稱面距(Average Symmetric Surface Distance, ASSD):

ASSD(A,B)= 1 ?| S(A) | + | S(B) | ?·

( ∑ sA∈S(A) d(sA,S(B))+∑ sB∈S(B) d(sB,S(A)) )

(4)

其中:d(v, S(A))表示像素v到表面體素S(A)的最短歐氏距離。

4)最大對稱面距(Maximum Symmetric Surface Distance, MSSD):

MSSD=

max{max sA∈S(A) d2(sA,S(B)),max sB∈S(B) d2(sB,S(A))}

(5)

其中:A代表真實(shí)標(biāo)記的器官區(qū)域,B代表預(yù)測的器官區(qū)域;S代表表面體素點(diǎn),S(A)和S(B)代表A和B的表面體素點(diǎn)。

5 實(shí)驗(yàn)結(jié)果與討論

實(shí)驗(yàn)所用的硬件配置如下:GTX 1080GPU兩塊,GPU顯存大小為8GB;開發(fā)工具為python和pytorch。

5.1 數(shù)據(jù)

為了驗(yàn)證所提算法模型的性能,本文針對肝臟和肺這兩個(gè)器官,利用公開數(shù)據(jù)集進(jìn)行了分割實(shí)驗(yàn),對于肝臟分割實(shí)驗(yàn)采用了MICCAI 2017 Liver Tumor Segmentation Challenge(LiTS)的數(shù)據(jù)集進(jìn)行實(shí)驗(yàn)。LiTS數(shù)據(jù)集包含了200例腹部CT影像,其中130例作為訓(xùn)練集,70例作為線上測試集。這些CT影像軸向分辨率在0.55~1.0mm,層厚在0.45~6.0mm。對于肺分割實(shí)驗(yàn)采用了ISBI LUng Nodule Analysis 2016(LUNA16)的數(shù)據(jù)進(jìn)行實(shí)驗(yàn),LUNA16的數(shù)據(jù)來自LIDC-IDRI數(shù)據(jù)集,剔除了層厚大于2.5mm的CT影像,總共包含888例胸部CT影像。這兩個(gè)數(shù)據(jù)集分別提供了肝臟和肺的分割結(jié)果圖,可用于算法的訓(xùn)練和測試。

訓(xùn)練網(wǎng)絡(luò)時(shí)需要?jiǎng)澐殖霾糠钟?xùn)練數(shù)據(jù)作為驗(yàn)證集,防止模型過擬合。本文采用15%的比例從訓(xùn)練數(shù)據(jù)中隨機(jī)抽取數(shù)據(jù)作為驗(yàn)證集。因此對于LiTS數(shù)據(jù)集的130例訓(xùn)練集,抽取了20例圖像作為驗(yàn)證集;而對于LUNA16數(shù)據(jù)集,先是隨機(jī)抽取了288例數(shù)據(jù)作為測試集,然后在剩余數(shù)據(jù)中隨機(jī)選擇了510例數(shù)據(jù)作為訓(xùn)練集,90例數(shù)據(jù)作為驗(yàn)證集。

5.2 網(wǎng)絡(luò)的訓(xùn)練和測試

本文使用LiTS數(shù)據(jù)集和LUNA16數(shù)據(jù)集分別進(jìn)行了肝臟分割和肺分割實(shí)驗(yàn),實(shí)驗(yàn)步驟為:先處理數(shù)據(jù),然后使用訓(xùn)練數(shù)據(jù)進(jìn)行模型的訓(xùn)練,再使用訓(xùn)練好的模型搭建算法,最后使用測試集驗(yàn)證算法的性能。肝臟分割和肺分割實(shí)驗(yàn)的步驟一致,模型訓(xùn)練的方法和參數(shù)設(shè)置也基本一致。

數(shù)據(jù)的處理主要是對數(shù)據(jù)進(jìn)行分辨率標(biāo)準(zhǔn)化和裁剪切割。數(shù)據(jù)的調(diào)窗處理和灰度值標(biāo)準(zhǔn)化是在訓(xùn)練和測試過程中動(dòng)態(tài)進(jìn)行的。器官定位的Vnet-S網(wǎng)絡(luò)的訓(xùn)練數(shù)據(jù)需要將原始數(shù)據(jù)裁剪到相同大小;器官分割的Vnet-S網(wǎng)絡(luò)的訓(xùn)練數(shù)據(jù)則需要根據(jù)真實(shí)標(biāo)記從原始數(shù)據(jù)中將器官區(qū)域切割出來作為訓(xùn)練數(shù)據(jù),該數(shù)據(jù)也需要進(jìn)行處理保證大小相同。

訓(xùn)練器官定位和器官分割的Vnet-S網(wǎng)絡(luò)設(shè)置的超參數(shù)相同:Batch size設(shè)置為4,損失函數(shù)設(shè)置為Dice損失函數(shù),采用Adam算法[23]進(jìn)行自適應(yīng)梯度下降來擬合網(wǎng)絡(luò)參數(shù),學(xué)習(xí)率設(shè)置為0.001,梯度和平方梯度的系數(shù)設(shè)置為0.9和0999,權(quán)重衰減系數(shù)設(shè)置為1×10-8。訓(xùn)練網(wǎng)絡(luò)中需要加入數(shù)據(jù)增強(qiáng)來提高模型的泛化能力,本文采用的數(shù)據(jù)增強(qiáng)包括在制作訓(xùn)練數(shù)據(jù)時(shí)加入隨機(jī)平移,模型訓(xùn)練中加入動(dòng)態(tài)的隨機(jī)旋轉(zhuǎn),以及借鑒3D Unet加入動(dòng)態(tài)B樣條插值[13]。訓(xùn)練迭代次數(shù)設(shè)置為200,在出現(xiàn)過擬合時(shí),提前停止訓(xùn)練。

通過上述操作,完成器官定位和器官分割中的Vnet-S網(wǎng)絡(luò)訓(xùn)練,然后完成對網(wǎng)絡(luò)模型的算法集成,最后使用測試集驗(yàn)證算法性能。為了進(jìn)行對比,還訓(xùn)練了單一的Vnet網(wǎng)絡(luò)和單一的Vnet-S網(wǎng)絡(luò)進(jìn)行測試。

肝臟分割實(shí)驗(yàn)的線上測試集共有70例,表2統(tǒng)計(jì)了級聯(lián)Vnet-S算法、Vnet網(wǎng)絡(luò)和Vnet-S網(wǎng)絡(luò)的線上測試結(jié)果。為了對比算法的準(zhǔn)確度,本文羅列了其他肝臟分割算法的線上測試結(jié)果。肺分割實(shí)驗(yàn)采用線下測試,測試集有288例,表3統(tǒng)計(jì)了級聯(lián)Vnet-S、Vnet和Vnet-S的線下測試結(jié)果。

通過表2、3可以看出,在肝臟分割和肺分割的測試集上,級聯(lián)Vnet-S算法的各項(xiàng)指標(biāo)都比單一Vnet網(wǎng)絡(luò)和單一Vnet-S網(wǎng)絡(luò)取得了更好的結(jié)果,說明它的性能明顯優(yōu)于單一Vnet網(wǎng)絡(luò)和Vnet-S網(wǎng)絡(luò);同時(shí)也可以發(fā)現(xiàn)Vnet網(wǎng)絡(luò)和Vnet-S網(wǎng)絡(luò)各項(xiàng)指標(biāo)基本相同,說明二者的性能基本相同。

表2統(tǒng)計(jì)了各種肝臟分割方法的LiTS線上測試結(jié)果。文獻(xiàn)[24]方法采用一個(gè)改進(jìn)的2D FCN進(jìn)行肝臟分割,加入了簡單的后處理去除假陽性。通過表2可以看出,該方法分割準(zhǔn)確度遠(yuǎn)低于Vnet-S網(wǎng)絡(luò)和級聯(lián)Vnet-S算法,其原因在于2D FCN無法利用CT影像中的空間信息。文獻(xiàn)[25]方法也是采用2D FCN進(jìn)行分割,在網(wǎng)絡(luò)結(jié)構(gòu)和特征利用上進(jìn)行了改進(jìn),分割Dice系數(shù)達(dá)到0.9510,但依然低于級聯(lián)Vnet-S算法,不足之處依然是沒有利用三維空間信息。文獻(xiàn)[26]方法是采用兩個(gè)2D FCN分別進(jìn)行粗分割和細(xì)分割,再利用一個(gè)3D FCN進(jìn)行后處理,3D FCN可以組合三維空間信息,分割Dice系數(shù)達(dá)到0.9610。文獻(xiàn)[27]方法同樣是采用兩個(gè)FCN分別粗分割和細(xì)分割,但是采用將多層CT影像切片作為輸入的方式,彌補(bǔ)了三維空間信息,分割Dice系數(shù)達(dá)到0.9630。文獻(xiàn)[26]方法和文獻(xiàn)[27]方法在分割準(zhǔn)確度上都略微高于級聯(lián)Vnet-S算法,但是這兩個(gè)方法的計(jì)算量都較大。相比這兩個(gè)方法,級聯(lián)Vnet-S算法的計(jì)算量控制在較低的水準(zhǔn),更適合臨床應(yīng)用。關(guān)于Vnet-S網(wǎng)絡(luò)的計(jì)算量將在后續(xù)討論。

最后使用可視化工具對級聯(lián)Vnet-S算法的分割結(jié)果進(jìn)行可視化。可視化采用多平面重建、生成橫斷面、矢狀圖和冠狀圖,并和真實(shí)標(biāo)記的多平面重建結(jié)果進(jìn)行對比,觀察級聯(lián)Vnet-S算法的分割結(jié)果和真實(shí)標(biāo)記之間的吻合度。對比結(jié)果如圖3所示,可以看出, 級聯(lián)Vnet-S算法的分割結(jié)果和真實(shí)標(biāo)記基本相同,說明級聯(lián)Vnet-S算法分割器官有著較高的準(zhǔn)確度,符合臨床應(yīng)用的要求。

5.3 Vnet-S網(wǎng)絡(luò)討論

Vnet-S網(wǎng)絡(luò)是在Vnet網(wǎng)絡(luò)基礎(chǔ)上進(jìn)行了改進(jìn), Vnet網(wǎng)絡(luò)的問題在于網(wǎng)絡(luò)過大,對于肝臟和肺這類器官分割,Vnet網(wǎng)絡(luò)的擬合能力溢出,容易過擬合,同時(shí)網(wǎng)絡(luò)過大會(huì)增加硬件的負(fù)擔(dān)。Vnet-S 改進(jìn)的地方主要是網(wǎng)絡(luò)結(jié)構(gòu)和卷積單元。網(wǎng)絡(luò)結(jié)構(gòu)和卷積單元的調(diào)整大大縮減了參數(shù)量和計(jì)算量,與之對應(yīng)的是網(wǎng)絡(luò)的感受野也隨之縮減,但是Vnet-S網(wǎng)絡(luò)的感受野足夠大,能夠滿足網(wǎng)絡(luò)學(xué)習(xí)全局的特征。使用LiTS數(shù)據(jù)集訓(xùn)練Vnet網(wǎng)絡(luò)和Vnet-S網(wǎng)絡(luò)(未加入BN和Dropout),在模型訓(xùn)練過程中,Vnet網(wǎng)絡(luò)驗(yàn)證集Dice最高可以達(dá)到0.9412,Vnet-S網(wǎng)絡(luò)驗(yàn)證集Dice最高可以達(dá)到0.9405,說明兩個(gè)網(wǎng)絡(luò)在肝臟分割上性能差別很小。為了加快模型收斂,增強(qiáng)模型的泛化能力,在Vnet-S網(wǎng)絡(luò)中加入了BN和Dropout。通過表2~3可以發(fā)現(xiàn):Vnet-S網(wǎng)絡(luò)在肝臟分割和肺分割測試集上的平均Dice系數(shù)分別比Vnet網(wǎng)絡(luò)高0.001和0.0007,說明BN和Dropout的加入提升了模型泛化能力。Vnet-S網(wǎng)絡(luò)和Vnet網(wǎng)絡(luò)性能基本接近,但是Vnet-S網(wǎng)絡(luò)規(guī)模更小、參數(shù)量更少,因此更具優(yōu)勢。

為了更準(zhǔn)確地對比和評估Vnet-S網(wǎng)絡(luò)大小和計(jì)算量,本文統(tǒng)計(jì)了2D Unet網(wǎng)絡(luò)、Vnet-S網(wǎng)絡(luò)和Vnet網(wǎng)絡(luò)的參數(shù)量和計(jì)算量,如表4所示,相同輸入大小,Vnet網(wǎng)絡(luò)的參數(shù)量是Vnet-S網(wǎng)絡(luò)的6.42倍,計(jì)算量是Vnet-S網(wǎng)絡(luò)的4.67倍, Vnet網(wǎng)絡(luò)的參數(shù)量和計(jì)算量都遠(yuǎn)大于Vnet-S網(wǎng)絡(luò)。級聯(lián)Vnet-S網(wǎng)絡(luò)結(jié)構(gòu)由兩個(gè)Vnet-S網(wǎng)絡(luò)搭建而成,因此參數(shù)量為Vnet-S網(wǎng)絡(luò)的2倍;而計(jì)算量方面,考慮到選擇最大連接通量和膨脹操作的計(jì)算量遠(yuǎn)小于模型的計(jì)算量,因此級聯(lián)Vnet-S網(wǎng)絡(luò)的計(jì)算量約等于Vnet-S計(jì)算量的2倍。所以級聯(lián)Vnet-S網(wǎng)絡(luò)的參數(shù)量為20.30×106,計(jì)算量約為215.66×109,都小于Vnet網(wǎng)絡(luò)參數(shù)量和計(jì)算量,但級聯(lián)Vnet-S分割準(zhǔn)確度遠(yuǎn)高于Vnet網(wǎng)絡(luò)。Vnet-S網(wǎng)絡(luò)相比二維分割網(wǎng)絡(luò)在網(wǎng)絡(luò)大小和計(jì)算量上仍然具有優(yōu)勢。可以發(fā)現(xiàn)輸入大小為572×572的2D Unet網(wǎng)絡(luò)在計(jì)算量和參數(shù)量上都大于Vnet-S網(wǎng)絡(luò),如果采用256×256大小的輸入,2D Unet網(wǎng)絡(luò)的計(jì)算量會(huì)小于Vnet-S網(wǎng)絡(luò),但是二維分割網(wǎng)絡(luò)需要對醫(yī)學(xué)圖像中的每層切片進(jìn)行計(jì)算,而三維分割網(wǎng)絡(luò)是對醫(yī)學(xué)圖像進(jìn)行三維計(jì)算,一般只需要計(jì)算一次或者數(shù)次就可以得到分割結(jié)果,因此整體計(jì)算量二維分割網(wǎng)絡(luò)一般是遠(yuǎn)大于三維分割網(wǎng)絡(luò)的。同理,2D Unet網(wǎng)絡(luò)的計(jì)算量也大于級聯(lián)Vnet-S算法。文獻(xiàn)[26]和文獻(xiàn)[27]的方法不光采用了二維分割網(wǎng)絡(luò),還采用了級聯(lián)結(jié)構(gòu),在計(jì)算量上是遠(yuǎn)大于級聯(lián)Vnet-S算法,在準(zhǔn)確度接近的情況下,級聯(lián)Vnet-S算法在臨床應(yīng)用方面具有更大的優(yōu)勢。

5.4 定位算法討論

本文的器官定位采用了圖像分割的方式,但直接利用圖像分割結(jié)果無法對器官進(jìn)行準(zhǔn)確定位,因?yàn)閂net-S網(wǎng)絡(luò)給出的分割結(jié)果存在假陽性,部分假陽性體素點(diǎn)和器官?zèng)]有連接,對這部分假陽性點(diǎn)直接采用選擇最大連接通量的方式進(jìn)行過濾,過濾之后的分割結(jié)果仍然無法進(jìn)行合適的定位。 本文隨機(jī)抽取了20例肝臟CT影像數(shù)據(jù)進(jìn)行測試,直接使用過濾后的分割結(jié)果進(jìn)行定位,平均查全率(區(qū)域邊界包含的器官體素點(diǎn)占器官所有體素點(diǎn)的比例)為0.9978,即在一些測試用例中,定位的器官邊界沒有包含全部屬于器官的體素點(diǎn),這將會(huì)導(dǎo)致后續(xù)的器官分割算法無法對完整的器官進(jìn)行分割。沒有準(zhǔn)確定位的原因在于圖像尺寸縮小到原來的1/4,丟失了邊緣細(xì)節(jié),導(dǎo)致器官邊緣的分割精度不高,從而出現(xiàn)定位不準(zhǔn)的問題。因此對過濾后的分割結(jié)果進(jìn)行膨脹操作,放寬定位邊界,以保證定位邊界可以包含全部器官體素點(diǎn)。膨脹一次后查全率達(dá)到0.9999,膨脹兩次后查全率為1.0000,因此本文采用膨脹兩次再進(jìn)行定位的方式。

5.5 級聯(lián)Vnet-S討論

與單一Vnet-S網(wǎng)絡(luò)分割相比,先定位再分割的級聯(lián)Vnet-S算法的分割準(zhǔn)確度有明顯提升。從表2、3可以看出,級聯(lián)Vnet-S算法的分割準(zhǔn)確度明顯高于單一Vnet-S網(wǎng)絡(luò)。

經(jīng)過分析,提升的原因主要為以下兩點(diǎn):1)定位操作減小了背景的比例,緩解了類別不平衡問題,因?yàn)閳D像分割本質(zhì)上是像素級的分類問題,類別不平衡會(huì)影響分割的準(zhǔn)確度。本文對肝臟和肺數(shù)據(jù)集隨機(jī)抽取了部分?jǐn)?shù)據(jù),統(tǒng)計(jì)定位前后器官體素和背景體素的比例,肝臟抽取了20例圖像,肺抽取了100例圖像,定位前后肝臟數(shù)據(jù)平均目標(biāo)背景比值由0.022提高到0.160,肺平均目標(biāo)背景比值由0.161提高到0.501,可以看出定位操作大大減小了背景的比例。

2)減小了縮小的比例,使用單一的Vnet-S網(wǎng)絡(luò)時(shí)需要將圖像數(shù)據(jù)縮小到原來的1/4,而級聯(lián)Vnet-S網(wǎng)絡(luò)結(jié)構(gòu)在切割出器官區(qū)域后,只需縮小到原來的1/2,這樣可以讓分割的邊緣細(xì)節(jié)準(zhǔn)確度更高,因?yàn)檫^分縮小會(huì)丟失過多的圖像特征,在將分割結(jié)果上采樣還原的過程中,會(huì)出現(xiàn)較大的誤差。

5.6 算法的不足

本文算法只適用于較大的器官,例如肺、肝臟、腎臟等,而人體中還存在像胰腺這類較小的器官,這類小型器官的分割對定位算法有更高的要求。本文提出的定位算法對小型器官無法進(jìn)行準(zhǔn)確的定位,原因在于:本文提出的圖像分割式定位算法是先將圖像縮小到原來的1/4,再對圖像整體進(jìn)行分割,因縮小圖像而丟失的圖像特征對于小型器官來說是過多的,導(dǎo)致分割結(jié)果會(huì)存在大量的假陽性,無法準(zhǔn)確定位小型器官。對應(yīng)的解決方案是采用較小的縮小系數(shù)進(jìn)行掃描計(jì)算,并結(jié)合器官的位置信息作為先驗(yàn),減少掃描范圍。

本文提出的算法為有監(jiān)督學(xué)習(xí)算法,在搭建器官的分割算法時(shí),需要采用對應(yīng)器官的數(shù)據(jù)集對模型進(jìn)行訓(xùn)練,模型的訓(xùn)練依賴于數(shù)據(jù)的數(shù)量和質(zhì)量,數(shù)量影響模型的泛化能力,質(zhì)量決定模型的質(zhì)量,對數(shù)據(jù)的依賴是該算法的一個(gè)弊端。

有效的后處理可以提高分割的準(zhǔn)確度,例如條件隨機(jī)場,因?yàn)閂net-S模型的輸出是一個(gè)高質(zhì)量的概率圖譜,可以使用條件隨機(jī)場來優(yōu)化分割結(jié)果。本文算法由于對整體計(jì)算量的考慮,沒有采用后處理來優(yōu)化分割結(jié)果,如果在某些應(yīng)用場景中對分割準(zhǔn)確度有更高的需求,可以加入后處理來繼續(xù)提高分割的準(zhǔn)確度。

6 結(jié)語

本文提出了Vnet-S網(wǎng)絡(luò)和基于級聯(lián)Vnet-S網(wǎng)絡(luò)的單一器官自動(dòng)分割算法。Vnet-S網(wǎng)絡(luò)是在Vnet網(wǎng)絡(luò)基礎(chǔ)上改進(jìn)得到的,相比Vnet網(wǎng)絡(luò),它需要的參數(shù)量和計(jì)算量更少。器官分割算法采用級聯(lián)結(jié)構(gòu),由兩個(gè)Vnet-S網(wǎng)絡(luò)級聯(lián)而成,分別用于器官定位和器官分割,通過先定位再分割的方式有效提高了分割準(zhǔn)確率。肝臟分割和肺分割實(shí)驗(yàn)的結(jié)果驗(yàn)證了本文算法能夠準(zhǔn)確快速地對器官進(jìn)行分割。但該算法也存在不足之處,如只適用于較大的器官、依賴準(zhǔn)確的真實(shí)標(biāo)記數(shù)據(jù)來訓(xùn)練模型、缺少后處理等,后續(xù)將針對這些不足作進(jìn)一步研究。

參考文獻(xiàn)

[1]? MORTEL K J, CANTISANI V, TROISI R, et al. Preoperative liver donor evaluation: imaging and pitfalls [J]. Liver Transplantation, 2003, 9(9): S6-S14.

[2]?SUZUKI K, KOHLBRENNER R, EPSTEIN M L, et al. Computer-aided measurement of liver volumes in CT by means of geodesic active contour segmentation coupled with level-set algorithms[J]. Medical Physics, 2010, 37(5): 2159-2166.

[3]?ARMATO S G 3rd, SENSAKOVIC W F. Automated lung segmentation for thoracic CT: impact on computer-aided diagnosis [J]. Academic Radiology, 2004, 11(9): 1011-1021.

[4]?UKIL S, REINHARDT J M. Smoothing lung segmentation surfaces in three-dimensional x-ray CT images using anatomic guidance [J]. Academic Radiology, 2005, 12(12): 1502-1511.

[5]?ZHANG X, TIAN J, DENG K, et al. Automatic liver segmentation using a statistical shape model with optimal surface detection [J]. IEEE Transactions on Biomedical Engineering, 2010, 57(10): 2622-2626.

[6]??BADAKHSHANNOORY H, SAEEDI P. A model-based validation? scheme for organ segmentation in CT scan volumes [J]. IEEE Transactions on Biomedical Engineering, 2011, 58(9): 2681-2693.

[7]?SUN SH, BAUER C, BEICHEL R. Automated 3-D segmentation of lungs with lung cancer in CT data using a novel robust active shape model approach [J]. IEEE Transactions on Medical Imaging, 2012, 31(2): 449-460.

[8]?JI H, HE J, YANG X, et al. ACM-based automatic liver segmentation from 3-D CT images by combining multiple atlases and improved mean-shift techniques [J]. IEEE Journal of Biomedical and Health Informatics, 2013, 17(3): 690-698.

[9]?ZHANG X, TIAN J, XIANG D, et al. Interactive liver tumor segmentation from CT scans using support vector classification with watershed [C]// Proceedings of the 2011 Annual International Conference of the IEEE Engineering in Medicine and Biology Society. Piscataway, NJ: IEEE, 2011: 6005-6008.

[10]?KORFIATIS P, KALOGEROPOULOU C, KARAHALIOU A, et al. Texture classification-based segmentation of lung affected by interstitial pneumonia in high-resolution CT [J]. Medical Physics, 2008, 35(12): 5290-5302.

[11]?SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651.

[12]?RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation [C]// Proceedings of the 2015 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9351. Cham: Springer, 2015: 234-241.

[13]?IEK , ABDULKADIR A, LIENKAMP S S, et al. 3D U-Net: learning dense volumetric segmentation from sparse annotation [C]// Proceedings of the 2016 International Conference on Medical Image Computing and Computer-Assisted Intervention, LNCS 9901. Cham: Springer, 2016: 424-432.

[14]?MILLETARI F, NAVAB N, AHMADI S. V-Net: fully convolutional neural networks for volumetric medical image segmentation [C]// Proceedings of the 4th International Conference on 3D Vision. Piscataway, NJ: IEEE, 2016: 565-571.

[15]?郭樹旭, 馬樹志, 李晶,等. 基于全卷積神經(jīng)網(wǎng)絡(luò)的肝臟CT影像分割研究[J]. 計(jì)算機(jī)工程與應(yīng)用, 2017, 53(18): 126-131. (GUO S X, MA S Z, LI J, et al. Fully convolutional neural network for liver segmentation in CT image [J]. Computer Engineering and Applications, 2017, 53(18): 126-131.)

[16]?NEGAHDAR M, BEYMER D, SYEDA-MAHMOOD T. Automated volumetric lung segmentation of thoracic CT images using fully convolutional neural network [C]// Proceedings of the Medical Imaging 2018: Computer-Aided Diagnosis, SPIE 10575. Bellingham, WA: SPIE, 2018: 1-6.

[17]?孫明建, 徐軍, 馬偉,等. 基于新型深度全卷積網(wǎng)絡(luò)的肝臟CT影像三維區(qū)域自動(dòng)分割[J]. 中國生物醫(yī)學(xué)工程學(xué)報(bào), 2018, 37(4): 385-393. (SUN M J, XU J, MA W, et al. A new fully convolutional network for 3D liver region segmentation on CT images [J]. Chinese Journal of Biomedical Engineering, 2018, 37(4): 385-393.)

[18]?JANSSENS R, ZENG G, ZHENG G. Fully automatic segmentation of lumbar vertebrae from CT images using cascaded 3D fully convolutional networks [C]// Proceedings of the 2018 IEEE 15th International Symposium on Biomedical Imaging. Piscataway, NJ: IEEE, 2018: 893-897.

[19]?ROTH H R, ODA H, HAYASHI Y, et al. Hierarchical 3D fully convolutional networks for multi-organ segmentation [J]. arXiv E-print, 2017: arXiv:1704.06382.?[EB/OL]. [2017-04-21]. http://arxiv.org/abs/1704.06382.pdf.

[20]?IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift [C]// Proceedings of the 32nd International Conference on International Conference on Machine Learning. [S.l.]: JMLR, 2015: 448-456.

http://de.arxiv.org/pdf/1502.03167

[21]?HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 770-778.

[22]??SRIVASTAVA N, HINTON G, KRIZHEVSKY A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. The Journal of Machine Learning Research, 2014, 15(1): 1929-1958.

[23]?KINGMA D P, BA J L. Adam: a method for stochastic optimization [J]. arXiv E-print, 2017: arXiv:1412.6980.?[EB/OL]. [2017-01-30]. https://arxiv.org/abs/1412.6980.pdf.

[24]?KALUVA K C, KHENED M, KORI A,et al. 2D-densely connected convolution neural networks for automatic liver and tumor segmentation [J]. arXiv E-print, 2018: arXiv:1802.02182.?[EB/OL]. [2018-01-05]. http://arxiv.org/abs/1802.02182.pdf.

[25]?VORONTSOV E, TANG A, PAL C, et al. Liver lesion segmentation informed by joint liver segmentation [C]// Proceedings of the IEEE 15th International Symposium on Biomedical Imaging. Piscataway, NJ: IEEE, 2018: 1332-1335.

[26]?LI X, CHEN, QI X, et al. H-DenseUNet: hybrid densely connected UNet for liver and tumor segmentation from CT volumes [J]. IEEE Transactions on Medical Imaging, 2018, 37(12): 2663-2674.

[27]?YUAN Y, BUCKSTEIN M, LO Y. Automatic liver and tumor segmentation using hierarchical convolutional-deconvolutional neural networks with jaccard distance [J]. Medical Physics, 2018, 45(6): E516.