基于注意力機制的卷積 雙向長短期記憶模型跨領(lǐng)域情感分類方法

龔琴 雷曼 王紀超 王保群

摘 要:針對現(xiàn)有跨領(lǐng)域情感分類方法中文本表示特征忽略了重要單詞的情感信息,且在遷移過程中存在負遷移的問題,提出一種基于注意力機制的卷積 雙向長短期記憶(AC-BiLSTM)模型的知識遷移方法。首先,利用低維稠密的詞向量對文本進行向量表示;其次,采用卷積操作獲取局部上下文特征之后,通過雙向長短期記憶(BiLSTM)網(wǎng)絡(luò)充分考慮特征之間的長期依賴關(guān)系;然后,通過引入注意力機制考慮不同詞匯對文本的貢獻程度,同時為了避免遷移過程中出現(xiàn)負遷移現(xiàn)象,在目標函數(shù)中引入正則項約束;最后,將在源領(lǐng)域產(chǎn)品評論訓練得到的模型參數(shù)遷移到目標領(lǐng)域產(chǎn)品評論中,并在少量目標領(lǐng)域有標注數(shù)據(jù)上進行微調(diào)。實驗結(jié)果表明,與AE-SCL-SR方法和對抗記憶網(wǎng)絡(luò)(AMN)方法相比,AC-BiLSTM方法的平均準確率分別提高了6.5%和2.2%,AC-BiLSTM方法可以有效地提高跨領(lǐng)域情感分類性能。

關(guān)鍵詞:情感分類;跨領(lǐng)域;遷移學習;注意力機制;長短期記憶網(wǎng)絡(luò)

中圖分類號:?TP181; TP389.1

文獻標志碼:A

Cross-domain sentiment classification method of convolution-bi-directional long short-term memory based on attention mechanism

AC-BiLSTM model

GONG Qin*, LEI Man, WANG Jichao, WANG Baoqun

School of Communication and Information Engineering, Chongqing University of Posts and Telecommunications, Chongqing 400065, China

Abstract:?Concerning the problems that the text representation features in the existing cross-domain sentiment classification method ignore the sentiment information of important words and there is negative transfer during transfer process, a Convolution-Bi-directional Long Short-Term Memory based on Attention mechanism (AC-BiLSTM) model was proposed to realize knowledge transfer. Firstly, the vector representation of text was obtained by low-dimensional dense word vectors. Secondly, after local context features being obtained by convolution operation, the long dependence relationship between the features was fully considered by Bi-directional Long Short-Term Memory (BiLSTM) network. Then, the contribution degrees of different words to the text were considered by introducing attention mechanism, and a regular term constraint was introduced into the objective function in order to avoid the negative transfer phenomenon in transfer process. Finally, the model parameters trained on source domain product reviews were transferred to target domain product reviews, and the labeled data in a small number of target domains were fine-tuned. Experimental results show that compared with AE-SCL-SR (AutoEncoder Structural Correspondence Learning with Similarity Regularization) method and Adversarial Memory Network (AMN) method, AC-BiLSTM method has average accuracy increased by 6.5% and 2.2% respectively, which demonstrates that AC-BiLSTM method can effectively improve cross-domain sentiment classification performance.

Key words:?sentiment classification; cross-domain; transfer learning; attention mechanism; Long Short-Term Memory (LSTM) network

0 引言

隨著互聯(lián)網(wǎng)的蓬勃發(fā)展,互聯(lián)網(wǎng)信息呈現(xiàn)爆炸式增長,京東、天貓、淘寶、亞馬遜等大型電子商務(wù)網(wǎng)站迅速發(fā)展,網(wǎng)上購物也因此受到了越來越多人的青睞。為了提高用戶滿意度,網(wǎng)絡(luò)商家通常允許用戶對其所購買的商品進行評價,這導致商品評價數(shù)量與日俱增。挖掘并分析評論文本中的情感傾向,不僅可以優(yōu)化用戶的購買決策,而且能夠幫助生產(chǎn)商和銷售商通過反饋信息來改進產(chǎn)品,從而提高市場競爭力,因此,情感分析(Sentiment Analysis, SA)[1]應(yīng)運而生。

情感分析,又稱為意見挖掘,它是利用自然語言處理(Natural Language Processing, NLP)、文本分析、機器學習等技術(shù)自動分析商品評論的文本內(nèi)容,挖掘出消費者對該商品的褒貶態(tài)度和意見[2]。然而,當訓練集和測試集不屬于同一領(lǐng)域時,典型的有監(jiān)督情感分類方法的效果就變得很差。這是由于訓練集里有強烈情感傾向性的詞語在測試集里呈現(xiàn)微弱的情感傾向性,由此產(chǎn)生了跨領(lǐng)域情感分類(Cross-Domain Sentiment Classification, CDSC)問題。隨著評論文本的不斷增加、新興領(lǐng)域的不斷涌現(xiàn),需要大量的人力來標注訓練集,這是費時費力的,因此研究跨領(lǐng)域的情感分類具有十分重要的研究價值。

跨領(lǐng)域情感分類的研究主要集中于從一個或多個源領(lǐng)域訓練得到分類器并且應(yīng)用在不同的目標領(lǐng)域進行訓練。當前存在的技術(shù)主要包含兩類:1)通過目標領(lǐng)域中少量標注數(shù)據(jù)來輔助訓練;2)目標領(lǐng)域均是未標注數(shù)據(jù)。本文主要針對第一類進行研究。

近年來,遷移學習已經(jīng)在學術(shù)界和工業(yè)界引起了廣泛的關(guān)注和研究。其中,領(lǐng)域自適應(yīng)(Domain Adaptation, DA)是遷移學習中的一種代表性方法,通過利用信息豐富的源領(lǐng)域樣本來提升目標領(lǐng)域模型的性能。然而在領(lǐng)域自適應(yīng)實際應(yīng)用中常常存在概念漂移[3]和特征漂移[4]的問題。比如,不同領(lǐng)域特征分布差異太大將會導致情感分類模型在跨領(lǐng)域應(yīng)用中分類效果下降,同時在不同領(lǐng)域下相同的特征可能代表相反的情感。

為了解決跨領(lǐng)域所存在的概念漂移(特征漂移)問題,本文選擇亞馬遜網(wǎng)站中4個領(lǐng)域產(chǎn)品評論作為實驗數(shù)據(jù),以情感分析作為研究任務(wù),提出一種基于注意力機制的卷積 雙向長短期記憶模型(Convolution-Bi-directional Long Short-Term Memory based on Attention mechanism, AC-BiLSTM)以實現(xiàn)不同領(lǐng)域環(huán)境下的知識遷移。

1 相關(guān)工作

情感分類是自然語言處理領(lǐng)域的一個研究熱點,受到了學術(shù)界和工業(yè)界的高度關(guān)注。文獻[5-6]總結(jié)了以往的情感分類研究技術(shù)及其所使用的數(shù)據(jù)集。然而這些研究主要集中在單一領(lǐng)域,隨著數(shù)據(jù)量的快速增長,要想在跨領(lǐng)域環(huán)境下構(gòu)建一個具有魯棒性和普遍性的情感分類器變得十分困難,這激勵研究者去分析跨領(lǐng)域數(shù)據(jù)的情感極性,即跨領(lǐng)域情感分類。

以往展開的大多數(shù)研究都是采用特征遷移[7]來實現(xiàn),它致力于解決源領(lǐng)域與目標領(lǐng)域特征空間存在差異的問題,主要通過把各個領(lǐng)域的數(shù)據(jù)映射到同一空間下,使源領(lǐng)域與目標領(lǐng)域具有相同的分布,并利用源領(lǐng)域中的訓練數(shù)據(jù)來解決目標領(lǐng)域的學習問題[8]。其中,Blitzer等[9]提出的結(jié)構(gòu)對應(yīng)學習(Structural Correspondence Learning, SCL)模型是經(jīng)典的方法,該模型利用源領(lǐng)域和目標領(lǐng)域部分樞紐特征,構(gòu)造樞紐特征與非樞紐特征的關(guān)聯(lián)模型,在此基礎(chǔ)上,構(gòu)造基于樞紐特征和非樞紐特征的特征空間,用于情感分類任務(wù);Pan等[10]提出譜特征對齊(Spectral Feature Alignment, SFA),首先構(gòu)造領(lǐng)域樞紐特征與非樞紐特征的二分圖,然后在二分圖上利用譜聚類獲取新的特征表達,最后在新的特征上構(gòu)造分類器;文獻[11]使用主成分分析法(Principal Component Analysis, PCA)進行特征選擇,然后用樸素貝葉斯(Naive Bayes, NB)進行情感分類;文獻[12]采用半監(jiān)督方式,結(jié)合改進的最大熵(Maximum Entropy, ME)模型與二分圖聚類模型,針對情感詞分類取得了相對較好的準確率;文獻[13]中提出一種基于短文本特征擴展的遷移學習模型——CATL-PCO(Correlation Analysis Transfer Learning-Probability Co-Occurrence)以解決古代詩歌這類短文本的情感分析問題。然而這些方法使用專家設(shè)計的規(guī)則或者n-gram進行句子的特征提取,通常未考慮到上下文之間的關(guān)系和重要單詞的情感信息,因此不能較好地表示跨領(lǐng)域大規(guī)模數(shù)據(jù)。

隨著深度學習研究工作的開展,深度學習被廣泛應(yīng)用于圖像分類、語音識別和自然語言處理等領(lǐng)域[14-15]。近年來,有研究者提出將深度學習用來學習跨領(lǐng)域場景下情感分類的公有特征和共享參數(shù)的方法,這些方法取得了顯著的成就。Glorot等[16]利用堆疊降噪自編碼器(Stacked Denoising Autoencoder, SDA)對多個領(lǐng)域的未標注數(shù)據(jù)進行預訓練,結(jié)合源領(lǐng)域的標注數(shù)據(jù)和預訓練模型來訓練情感分類模型;Chen等[17]提出邊緣降噪自動編碼器(marginalized SDA, mSDA),它保留了強大的特征學習能力并且解決了高昂的計算成本和SDA的可擴展性問題;隨后,許多SDA的擴展方法被提出以提高跨領(lǐng)域情感分類的性能[18-19]。然而這些方法缺乏可解釋性,即無法證明網(wǎng)絡(luò)是否充分學習到了樞紐特征。

為了提高深度學習的可解釋能力,Ganin等[20]提出域?qū)股窠?jīng)網(wǎng)絡(luò)(Domain Adversarial Neural Network, DANN)來解決跨領(lǐng)域情感分類問題;文獻[21]中提出AE-SCL-SR(AutoEncoder Structural Correspondence Learning with Similarity Regularization)算法,結(jié)合自編碼和結(jié)構(gòu)對應(yīng)學習的優(yōu)勢來提高跨領(lǐng)域情感分類的性能;Li等[22]提出對抗記憶網(wǎng)絡(luò)(Adversarial Memory Network, AMN)模型,利用注意力機制來自動捕獲樞紐特征從而實現(xiàn)跨領(lǐng)域情感分類。

2 AC-BiLSTM模型跨領(lǐng)域情感分類方法

2.1 問題定義

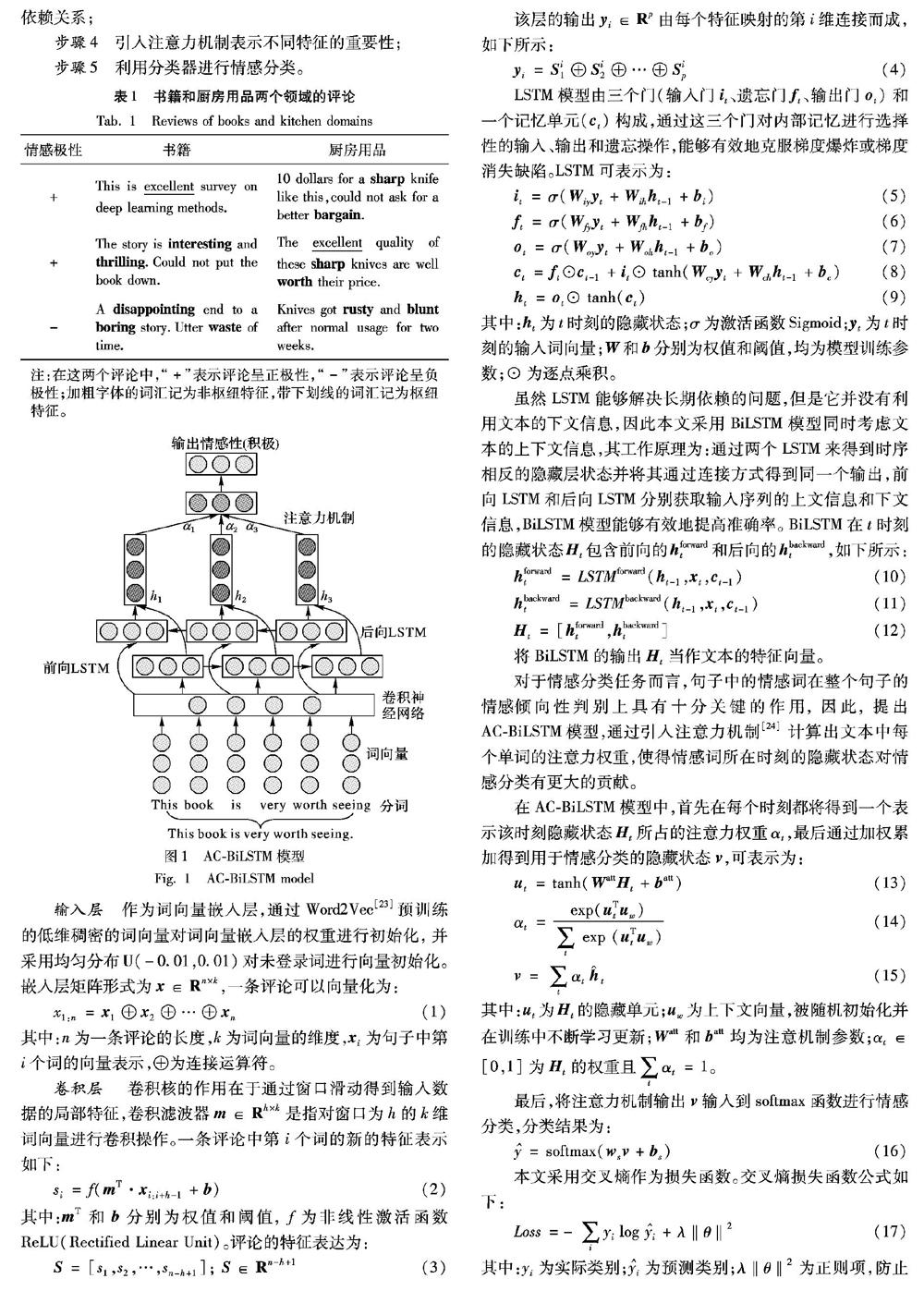

為了解決跨領(lǐng)域情感分類問題,本文給出問題定義:給定已標記情感的源領(lǐng)域DS={(XSi,γSi)}nS n的下標是小寫s,還是大寫S?應(yīng)該為大寫S吧?與其他處的書寫保持一致。 i=1和無標記情感的目標領(lǐng)域DT={(XTj)}nTj=1。其中,nS和nT分別表示源領(lǐng)域DS 此處的s,應(yīng)為大寫S吧? 和目標領(lǐng)域DT的評論數(shù)量,XSi和XTj分別表示源領(lǐng)域DS和目標領(lǐng)域DT的第i和j條評論,γSi為XSi對應(yīng)的情感標簽,γSi∈{+1,-1},+1和-1分別為正向情感標簽和負向情感標簽。本文研究的目標是利用源領(lǐng)域DS的有標簽評論XSi訓練一個分類器來預測目標領(lǐng)域DT的無標簽評論XTj的情感標簽γTj。

2.2 相關(guān)概念

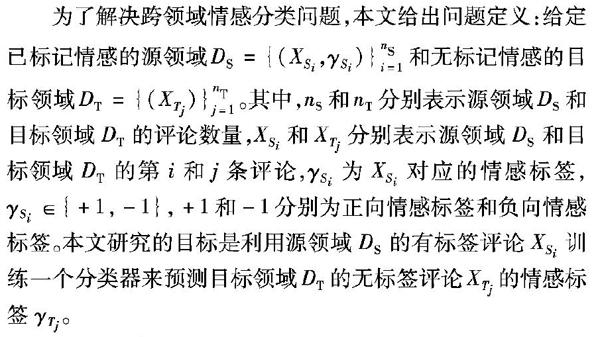

互聯(lián)網(wǎng)上商品評論文本中的特征可分為兩類:1)樞紐特征。源領(lǐng)域和目標領(lǐng)域中的公共特征,表示兩個領(lǐng)域的一些公共知識。2)非樞紐特征。在某一領(lǐng)域多次出現(xiàn)而在另一個領(lǐng)域很少出現(xiàn)或不出現(xiàn)的特征。例如,“great”或“terrible”等特征在不同領(lǐng)域中表達的情感相似,在亞馬遜網(wǎng)站的商品評論中,在源領(lǐng)域和目標領(lǐng)域都高頻出現(xiàn),這些特征被稱為樞紐特征。表1給出了亞馬遜網(wǎng)站商品評論中,Books和Kitchen兩個領(lǐng)域的評論。

2.3 AC-BiLSTM模型

AC-BiLSTM模型如圖1所示。該模型主要包含5個步驟:

步驟1? 采用詞向量進行文本表示;

步驟2? 利用卷積操作獲取局部特征;

步驟3? 利用BiLSTM模型充分考慮到特征之間的長期依賴關(guān)系;

步驟4? 引入注意力機制表示不同特征的重要性;

步驟5? 利用分類器進行情感分類。

作為詞向量嵌入層,通過Word2Vec[23]預訓練的低維稠密的詞向量對詞向量嵌入層的權(quán)重進行初始化,并采用均勻分布U(-0.01,0.01)對未登錄詞進行向量初始化。嵌入層矩陣形式為 x ∈ R n×k,一條評論可以向量化為:

x1:n= x 1⊕ x 2⊕…⊕ x n (1)

其中:n為一條評論的長度,k為詞向量的維度, x i為句子中第i個詞的向量表示,⊕為連接運算符。

卷積層? 卷積核的作用在于通過窗口滑動得到輸入數(shù)據(jù)的局部特征,卷積濾波器 m ∈ R h×k是指對窗口為h的k維詞向量進行卷積操作。一條評論中第i個詞的新的特征表示如下:

si=f( m T· x i:i+h-1+ b ) (2)

其中: m T和 b 分別為權(quán)值和閾值, f為非線性激活函數(shù)ReLU(Rectified Linear Unit)。評論的特征表達為:

S =[s1,s2,…,sn-h+1];? S ∈ R n-h+1 (3)

該層的輸出 y i∈ R p由每個特征映射的第i維連接而成,如下所示:

y i= S i1⊕ S i2⊕…⊕ S ip (4)

LSTM模型由三個門(輸入門 i t、遺忘門 f t、輸出門 o t)和一個記憶單元( c t)構(gòu)成,通過這三個門對內(nèi)部記憶進行選擇性的輸入、輸出和遺忘操作,能夠有效地克服梯度爆炸或梯度消失缺陷。LSTM可表示為:

i t=σ( W iy y t+ W ih h t-1+ b i) (5)

f t=σ( W fy y t+ W fh h t-1+ b f) (6)

o t=σ( W oy y t+ W oh h t-1+ b o) (7)

c t= f t⊙ c t-1+ i t⊙ tanh( W cy y t+ W ch h t-1+ b c) (8)

h t= o t⊙ tanh( c t) (9)

其中: h t為t時刻的隱藏狀態(tài);σ為激活函數(shù)Sigmoid; y t為t時刻的輸入詞向量; W 和 b 分別為權(quán)值和閾值,均為模型訓練參數(shù);⊙為逐點乘積。

雖然LSTM能夠解決長期依賴的問題,但是它并沒有利用文本的下文信息,因此本文采用BiLSTM模型同時考慮文本的上下文信息,其工作原理為:通過兩個LSTM來得到時序相反的隱藏層狀態(tài)并將其通過連接方式得到同一個輸出,前向LSTM和后向LSTM分別獲取輸入序列的上文信息和下文信息,BiLSTM模型能夠有效地提高準確率。BiLSTM在t時刻的隱藏狀態(tài) H t包含前向的 h forwardt和后向的 h backwardt,如下所示:

h forwardt=LSTMforward( h t-1, x t, c t-1) (10)

h backwardt=LSTMbackward( h t-1, x t, c t-1) (11)

H t=[ h forwardt, h backwardt] (12)

將BiLSTM的輸出 H t當作文本的特征向量。

對于情感分類任務(wù)而言,句子中的情感詞在整個句子的情感傾向性判別上具有十分關(guān)鍵的作用,因此,提出AC-BiLSTM模型,通過引入注意力機制[24]計算出文本中每個單詞的注意力權(quán)重,使得情感詞所在時刻的隱藏狀態(tài)對情感分類有更大的貢獻。

在AC-BiLSTM模型中,首先在每個時刻都將得到一個表示該時刻隱藏狀態(tài) H t所占的注意力權(quán)重αt,最后通過加權(quán)累加得到用于情感分類的隱藏狀態(tài) v ,可表示為:

u t=tanh( W att H t+ b att) (13)

αt= exp( u Tt u w) ∑ t? exp ( u Tt u w)

(14)

v =∑ t αt h??? ^?? t (15)

其中: u t為 H t的隱藏單元; u w為上下文向量,被隨機初始化并在訓練中不斷學習更新; W att和 b att均為注意機制參數(shù);αt∈[0,1]為 H t的權(quán)重且∑ t αt=1。

最后,將注意力機制輸出 v 輸入到softmax函數(shù)進行情感分類,分類結(jié)果為:

=softmax( w s v + b s) (16)

本文采用交叉熵作為損失函數(shù)。交叉熵損失函數(shù)公式如下:

Loss=-∑ i yi log? i+λ‖θ‖2 (17)

其中:yi為實際類別; i為預測類別;λ‖θ‖2為正則項,防止發(fā)生過擬合現(xiàn)象同時避免負遷移。

AC-BiLSTM模型在源領(lǐng)域數(shù)據(jù)進行訓練,訓練好的模型表示為NS。為了實現(xiàn)遷移,本文還構(gòu)造了另一個模型NT,這兩個模型神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)一致。首先將在NS訓練好的參數(shù)對NT對應(yīng)層進行初始化;然后凍結(jié)NT的詞向量層,NT其余層的參數(shù)在目標領(lǐng)域含有少量標注的數(shù)據(jù)上進行微調(diào);最后將訓練好的NT模型用來對目標領(lǐng)域進行預測。跨領(lǐng)域情感分類框架如圖2所示。

3 實驗結(jié)果及分析

3.1 數(shù)據(jù)集及參數(shù)設(shè)置

本文進行仿真實驗所采用的數(shù)據(jù)集是賓夕法尼亞大學Blitzer等[9]收集的多領(lǐng)域情感數(shù)據(jù)集,具體包括:Books(B)、DVD(D)、Electronics(E)和Kitchen(K)4個領(lǐng)域。其中,每個領(lǐng)域包含正、負評論各1000條,另外還包含大量的未標注數(shù)據(jù)。分別將各領(lǐng)域正負評論通過五折交叉驗證劃分為訓練集和驗證集。多領(lǐng)域情感數(shù)據(jù)集的統(tǒng)計信息如表2所示。

為了訓練一個較好的模型,模型參數(shù)的設(shè)置十分重要,表3是本文方法的參數(shù)設(shè)置。

3.2 評價指標

本文主要通過準確率(Accuracy)來評估情感分類的性能。計算公式如下所示:

Accuracy= 1 N ∑ N i=1 ?| yi= i |

(18)

其中: i表示xi的預測標簽,yi則表示xi的實際標簽,N表示測試集的大小。

3.3 實驗分析

將本文提出的AC-BiLSTM模型的跨領(lǐng)域情感分類方法與以下8種方法進行比較來驗證所提方法的有效性。

1)NoTransf(No Transfer):源領(lǐng)域訓練的分類器直接用于目標領(lǐng)域。

2)SCL-MI(Structural Correspondence Learning Mutual Information)[7]:首先采用互信息(Mutual Information, MI)構(gòu)造出樞紐特征,最后分別計算源領(lǐng)域、目標領(lǐng)域樞紐特征與非樞紐特征之間的相關(guān)性。

3)SFA(Spectral Feature Alignment)[10]:首先基于共現(xiàn)關(guān)系構(gòu)建領(lǐng)域特定詞匯和通用詞匯的二分圖,然后在二分圖上進行譜聚類獲取新的特征表示,最后在新的特征上構(gòu)造分類器。

4)SS-FE(Feature Ensemble Sample Selection)[11]:使用主成分分析法進行特征選擇,然后用樸素貝葉斯算法進行情感分類。

5)DANN(Domain Adversarial Neural Network)[20]:利用域?qū)股窠?jīng)網(wǎng)絡(luò)來實現(xiàn)跨領(lǐng)域情感分類。

6)DAmSDA(Domain Adversarial Stacked Denoising Autoencoders)[20]:它是DANN的一種改進方法,從邊緣堆疊去噪自編碼中獲得特征表達。

7)AE-SCL-SR(AutoEncoder SCL with Similarity Regularization)[21]:結(jié)合自編碼和結(jié)構(gòu)對應(yīng)學習的優(yōu)勢來提高跨領(lǐng)域情感分類的性能。

8)AMN(Adversarial Memory Network)[22]:利用對抗記憶網(wǎng)絡(luò)實現(xiàn)跨領(lǐng)域情感分類。

表4是上述各種方法的分類準確率對比結(jié)果。可以看出,本文提出的AC-BiLSTM模型在各個情感分析任務(wù)中的準確率均是最高的,平均準確率達到了83.3%。與NoTransf方法相比,AC-BiLSTM模型的平均分類準確率提升了13.6%,原因在于NoTransf方法容易受到文本稀疏性的影響,所以平均分類準確率相對較低;

與SCL-MI、SFA和SS-FE方法相比,AC-BiLSTM模型的平均分類準確率分別提升了12.1%、6%和7.3%,因為SCL-MI、SFA和SS-FE的性能取決于樞紐的特征選擇方式,這將不能準確地捕獲樞紐特征,因此它們的平均分類準確率相對很低;

與DANN、DAmSDA和AE-SCL-SR方法相比,AC-BiLSTM模型的平均準確率分別提高了11.4%、9.3%和6.5%;

與分類效果較佳的AMN方法相比,AC-BiLSTM的平均分類準確率提升了2.2%。

從表4的對比結(jié)果可以看出,在跨領(lǐng)域情感分類中,Kitchen和Electronics領(lǐng)域之間的準確率相對其他領(lǐng)域來說較高,這說明Kitchen和Electronics特征分布最相似,領(lǐng)域自適應(yīng)效果最佳。同時,從各個方法的平均分類準確率可以看出遷移學習的效果均優(yōu)于沒有進行遷移的情況,這說明遷移學習能夠有效地提高分類準確率。

由表4還可以看出,與NoTransf方法相比,AC-BiLSTM模型在12個跨領(lǐng)域情感分類任務(wù)中分別提升了15.2%、16%、15.6%、10.3%、12.5%、12.8%、17%、17.1%、6.4%、13.7%、16.7%、11.7%,特別是D → E這個分類任務(wù)中,提升了17.1%。

本文方法優(yōu)于其他對比方法的原因在于:NS模型能夠自動學習有助于情感分類任務(wù)的特征表示,并且源領(lǐng)域和目標領(lǐng)域可以共享該特征;將NS中遷移過來的參數(shù)在少量目標領(lǐng)域數(shù)據(jù)上進行微調(diào)能夠強化NT模型去學習對目標領(lǐng)域分類任務(wù)有利的特征,從而提高預測精度;卷積操作能夠有效捕獲局部上下文特征,BiLSTM能夠考慮特征之間的語義長短期依賴關(guān)系;通過引入注意力機制,充分考慮到不同詞匯對文本的貢獻程度,這將進一步提高分類精度。

圖3表示準確率和交叉熵損失值隨著迭代次數(shù)增加而變化的曲線。可以看出,本文提出的模型具有對領(lǐng)域自適應(yīng)的充分性,同時在交叉熵損失值和分類準確率之間存在較強的相關(guān)性,隨著迭代次數(shù)的增加,準確率整體呈現(xiàn)上升趨勢,而交叉熵損失值整體呈現(xiàn)下降趨勢。

4 結(jié)語

本文提出了一種AC-BiLSTM模型來進行跨領(lǐng)域情感分析研究。該模型通過引入注意力機制充分考慮到重要單詞的情感信息,同時為了避免發(fā)生負遷移現(xiàn)象,在目標函數(shù)中加入了正則項約束。在公開的大規(guī)模產(chǎn)品評價數(shù)據(jù)集上的實驗結(jié)果表明,所提出的AC-BiLSTM模型可以有效地提高跨領(lǐng)域情感分類的性能。從整體上來看,本文方法在各個領(lǐng)域下的準確率均優(yōu)于對比方法。

本文方法的局限性在于語料庫的選擇主要局限于英文。在后續(xù)研究中,將利用中文語料庫來驗證模型,并在領(lǐng)域跨度更大的環(huán)境(例如電子產(chǎn)品與餐飲類評論)中進一步驗證模型的效果;同時,下一步還需要將該模型應(yīng)用到實際工程中。

參考文獻 (References)

[1]?AGARWAL B, MITTAL N, BANSAL P, et al. Sentiment analysis using common-sense and context information [J]. Computational Intelligence and Neuroscience, 2015, 2015(78): Article No. 30.

[2]?陳龍,管子玉,何金紅,等.情感分類研究進展[J].計算機研究與發(fā)展,2017,54(6):1150-1170. (CHEN L, GUAN Z Y, HE J H, et al. A survey on sentiment classification [J]. Journal of Computer Research and Development, 2017, 54(6): 1150-1170.)

[3]?GAMA J, LIOBAITE I, BIFET A, et al. A survey on concept drift adaptation [J]. ACM Computing Surveys, 2014, 46(4): Article No. 44.

[4]?BARDDAL J P, GOMES H M, ENEMBRECK F, et al. A survey on feature drift adaptation: definition, benchmark, challenges and future directions [J]. Journal of Systems and Software, 2017, 127(52): 278-294.

[5]?MOHAMED HUSSEIN D M E D. A survey on sentiment analysis challenges [J]. Journal of King Saud University — Engineering Sciences, 2018, 30(4): 330-338.

[6]?RAVI K, RAVI V. A survey on opinion mining and sentiment analysis: tasks, approaches and applications [J]. Knowledge-Based Systems, 2015, 89(17): 14-46.

[7]??BLIZER J, DREDZE M, PEREIRA F. Biographies, bollywood, ?boom-boxes and blenders: domain adaptation for sentiment classification [C]// Proceedings of the 45th Annual Meeting of the Association of Computational Linguistics. Stroudsburg, PA: ACL, 2007: 440-447.

[8]?莊福振,羅平,何清,等.遷移學習研究進展[J].軟件學報,2015,26(1):26-39. (ZHUANG F Z, LUO P, HE Q, et al. Survey on transfer learning research [J]. Journal of Software, 2015, 26(1): 26-39.)

[9]?BLITZER J, McDONALD R, PEREIRA F. Domain adaptation with structural correspondence learning [C]// Proceedings of the 2006 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2006: 120-128.

[10]?PAN S J, NI X, SUN J T, et al. Cross-domain sentiment classification via spectral feature alignment [C]// Proceedings of the 19th International Conference on World Wide Web. New York: ACM, 2010: 751-760.

[11]?XIA R, ZONG C, HU X, et al. Feature ensemble plus sample selection: domain adaptation for sentiment classification [J]. IEEE Intelligent Systems, 2013, 28(3): 10-18.

[12]?DESHMUKH J S, TRIPATHY A K. Entropy based classifier for cross-domain opinion mining [J]. Applied Computing and Informatics, 2018, 14(1): 55-64.

[13]?吳斌,吉佳,孟琳,等.基于遷移學習的唐詩宋詞情感分析[J].電子學報,2016,44(11):2780-2787. (WU B, JI J, MENG L, et al. Transfer learning based sentiment analysis for poetry of the Tang dynasty and Song dynasty [J]. Acta Electronica Sinica, 2016, 44(11): 2780-2787.

[14]?QIN B, LIU T, TANG D. Deep learning for sentiment analysis: successful approaches and future challenges [J]. Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery, 2015, 5(6): 292-303.

[15]?SCHMIDHUBER J. Deep learning in neural networks: an overview [J]. Neural Networks, 2015, 61(27): 85-117.

[16]??GLOROT X, BORDES A, BENGIO Y. Domain adaptation for? large-scale sentiment classification: a deep learning approach [C]// Proceedings of the 28th International Conference on Machine Learning. New York: ACM, 2011: 513-520.

[17]?CHEN M, XU Z, WEINBERGER K Q, et al. Marginalized denoising autoencoders for domain adaptation [C]// Proceedings of the 29th International Conference on Machine Learning. New York: ACM, 2012: 1627-1634.

[18]?CLINCHANT S, CSURKA G, CHIDLOVSKII B. A domain adaptation regularization for denoising autoencoders [C]// Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2016: 26-31.

[19]?PENG Y, WANG S, LU B L. Marginalized denoising autoencoder via graph regularization for domain adaptation [C]// Proceedings of the 2013 International Conference on Neural Information Processing, LNCS 8227. Berlin: Springer, 2013: 156-163.

[20]?GANIN Y, USTINOVA E, AJAKAN H, et al. Domain-adversarial training of neural networks [J]. Journal of Machine Learning Research, 2015, 17(1): 2096-2030.

[21]?ZISER Y, REICHART R. Neural structural correspondence learning for domain adaptation [C]// Proceedings of the 21st Conference on Computational Natural Language Learning. Stroudsburg, PA: ACL, 2017: 400-410.

[22]?LI Z, ZHANG Y, WEI Y, et al. End-to-end adversarial memory network for cross-domain sentiment classification [C]// Proceedings of the 2017 International Joint Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2017: 2237-2243.

[23]?MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space [C]// Proceedings of the 2013 International Conference on Learning Representations. Stroudsburg, PA: ACL, 2013: 1-12.

[24]?BAHDANA D, CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate [C]// Proceedings of the 3rd International Conference on Learning Representations. San Diego, CA: [s.n.], 2015: 1-15.