基于雙重注意力孿生網絡的實時視覺跟蹤

楊康 宋慧慧 張開華

摘 要:為了解決全卷積孿生網絡(SiamFC)跟蹤算法在跟蹤目標經歷劇烈的外觀變化時容易發生模型漂移從而導致跟蹤失敗的問題,提出了一種雙重注意力機制孿生網絡(DASiam)去調整網絡模型并且不需要在線更新。首先,主干網絡使用修改后表達能力更強的并適用于目標跟蹤任務的VGG網絡;然后,在網絡的中間層加入一個新的雙重注意力機制去動態地提取特征,這種機制由通道注意機制和空間注意機制組成,分別對特征圖的通道維度和空間維度進行變換得到雙重注意特征圖;最后,通過融合兩個注意機制的特征圖進一步提升模型的表征能力。在三個具有挑戰性的跟蹤基準庫即OTB2013、OTB100和2017年視覺目標跟蹤庫(VOT2017)實時挑戰上進行實驗,實驗結果表明,以40frame/s的速度運行時,所提算法在OTB2013和OTB100上的成功率指標比基準SiamFC分別高出3.5個百分點和3個百分點,并且在VOT2017實時挑戰上面超過了2017年的冠軍SiamFC,驗證了所提出算法的有效性。

關鍵詞:卷積神經網絡;視覺跟蹤; 注意力機制; 孿生網絡

中圖分類號: TP391.4

文獻標志碼:A

Abstract: In order to solve the problem that Fully-Convolutional Siamese network (SiamFC) tracking algorithm is prone to model drift and results in tracking failure when the tracking target suffers from dramatic appearance changes, a new Dual Attention Siamese network (DASiam) was proposed to adapt the network model without online updating. Firstly, a modified Visual Geometry Group (VGG) network which was more expressive and suitable for the target tracking task was used as the backbone network. Then, a novel dual attention mechanism was added to the middle layer of the network to dynamically extract features. This mechanism was consisted of a channel attention mechanism and a spatial attention mechanism. The channel dimension and the spatial dimension of the feature maps were transformed to obtain the double attention feature maps. Finally, the feature representation of the model was further improved by fusing the feature maps of the two attention mechanisms. The experiments were conducted on three challenging tracking benchmarks: OTB2013, OTB100 and 2017 Visual-Object-Tracking challenge (VOT2017) real-time challenges. The experimental results show that, running at the speed of 40frame/s, the proposed algorithm has higher success rates on OTB2013 and OTB100 than the baseline SiamFC by the margin of 3.5 percentage points and 3 percentage points respectively, and surpass the 2017 champion SiamFC in the VOT2017 real-time challenge, verifying the effectiveness of the proposed algorithm.

Key words: convolutional neural network; visual tracking; attention mechanism; siamese network

0 引言

視覺目標跟蹤在計算機視覺領域是一個基礎性但充滿挑戰的研究方向,被應用于各種視覺領域,比如無人駕駛、人機交互和視頻監控等。由于存在目標發生劇烈的外觀變化、目標遮擋、光照變換等干擾因素,除此之外,還要考慮實時的因素,所以盡管最近幾年目標跟蹤算法研究取得了顯著性的提升,但到目前為止仍然是一個極具挑戰性的任務。

基于相關濾波的跟蹤器可以通過一個循環矩陣在傅里葉域快速求解來實現快速目標跟蹤,出現了很多速度快且簡單的跟蹤器[1-5]。最近幾年,深度卷積神經網絡在計算機視覺領域取得了顯著的成功,比如分類任務、目標檢測等任務。所以也有很多研究者將深度學習應用到目標跟蹤任務上去,其中取得突破性的且能夠達到實時要求的算法就是全卷積孿生網絡(Fully-Convolutional Siamese network, SiamFC)[5],SiamFC把目標跟蹤任務當作相似性匹配任務,即利用外部訓練數據訓練一個修改后的AlexNet[6]卷積網絡作為通用的匹配函數,再把匹配函數作為目標跟蹤的圖像特征提取器,如果匹配函數能夠學習更好的特征表達能力,那么對于提升跟蹤器的性能是有幫助的。孿生實例搜索跟蹤(Siamese Instance Search Tracking, SINT)[7]將跟蹤任務看作是一個驗證任務并利用光流進一步提升性能表現,但是速度只有4frame/s,很難應用到現實場景中;提前停止跟蹤(Early-Stopping Tracker, EAST)[8]主要判斷低級的特征,如果能夠跟蹤到目標時就停止特征提取進行加速;相關濾波網絡(Correlation Filter Network, CFNet)跟蹤[9]將相關濾波作為一個可微的層加入低層的網絡特征中去學習目標變換,大大降低了網絡參數量的同時仍然保持很好的跟蹤性能。動態孿生網跟蹤(Dynamic Siamese Network,DSiam)[10]嘗試在線學習目標的外觀變化去進一步提升孿生網絡的表征能力。

盡管基于孿生網絡的跟蹤算法取得了顯著的進步,但是這種孿生網絡框架仍然有一些問題沒有解決。首先,用于孿生網絡的框架一般都是比較淺層的AlexNet網絡,在深度學習任務中,已經證明了更深的網絡具有更強的信息表征能力[11];其次,在目標發生劇烈的變化時,由于孿生網絡缺少動態的調節模型機制,只能等價地對待每一個特征圖和特征空間,沒有重點關注的目標區域,這樣限制了模型豐富的表征能力。

針對基于孿生網絡的跟蹤器出現的上述問題,本文在SiamFC的跟蹤算法框架之下,把特征提取網絡換成了修改過的且適用于目標跟蹤任務的VGG(Visual Geometry Group)[12]網絡,在此基礎之上,為了進一步增強網絡模型的判別能力,提出了一種新的雙重注意力機制去調節模型。最后為了驗證該算法的有效性,在三個具有挑戰性的視頻庫上進行詳盡的實驗,并與幾個經典的跟蹤算法進行比較,實驗結果表明所提方法得到了很有競爭力的結果。

1 雙重注意力孿生網絡算法

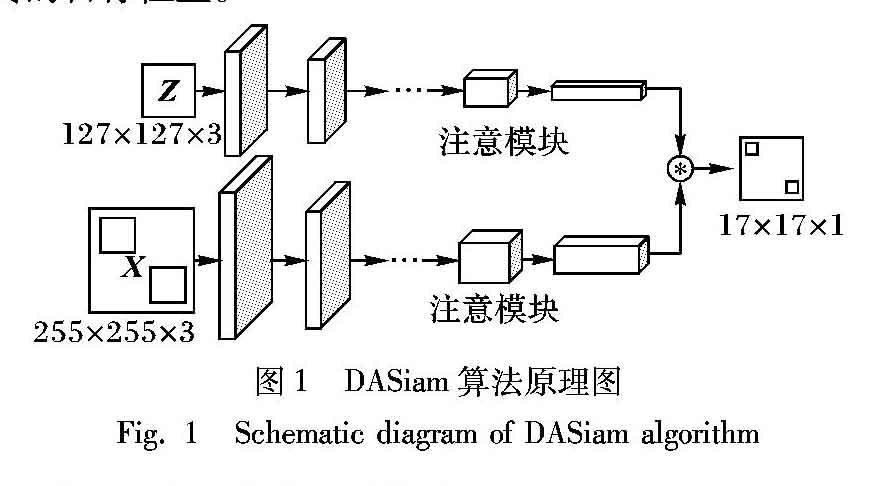

為了實現高效的視覺跟蹤任務,本文提出了一種新的基于雙重注意孿生(Dual Attention Siamese network, DASiam)網絡的視覺跟蹤算法,如圖1所示。該算法由一個修改后的深度卷積神經網絡VGG和一個雙重注意模塊組成,其中雙重注意模塊包括通道注意模塊和空間注意模塊,最后將提取到的模板圖像和搜索圖像的高維語義信息特征進行相關操作得到最終的目標位置。

1.1 基于孿生網絡的跟蹤算法

最近幾年在目標跟蹤領域的開創性工作是全卷積孿生網絡(SiamFC)目標跟蹤算法,如圖1所示,孿生網絡的輸入是從視頻第一幀(目標)和后續幀進行裁剪的一堆圖像,分別用Z和X表示,其中Z∈RWt×Ht×3且X∈RWs×Hs×3,然后通過一個離線訓練的匹配函數F(Z,X)在模板圖像Z和搜索圖像X進行相關運算得到一個相似性響應得分圖,響應得分最大的位置就是新的目標位置,其中用于特征提取的卷積網絡關于搜索圖像X是全卷積的,這樣就可以輸入不同尺度大小的搜索圖像以便選擇合適的尺度作為新的預測框。相似性響應得分圖可以由式(1)得到:

雖然SiamFC取得了很好的結果,但是與現有的相關濾波跟蹤器的結果有著很大的差距,這是因為SiamFC用于特征提取的全卷積網絡是使用修改后的AlexNet,由于AlexNet層數較淺,學到的特征表征能力有限,當跟蹤目標發生劇烈形變時模型容易發生漂移,導致跟蹤失敗。本文采用更深的修改后的適用于目標跟蹤任務的VGG網絡模型作為新的特征提取網絡,并在網絡中加入雙重注意力機制調整模型的特征提取過程,進而選擇性地強調有用的信息而抑制不太有用的信息,而不是等價地對待所有的特征信息。

1.2 雙重注意力孿生網絡框架

圖1展示了本文算法的基礎框架,由修改后的VGG網絡作為主干網絡,除了最后一個卷積(Convolutional, Conv)層,每一層卷積之后立即加入批歸一化(Batch Normalization, BN)層,然后再經過非線性激活函數(Rectified Linear Unit, ReLU)層,沒有填充,并且在網絡的第10層后面加入一個注意力調節機制,具體的網絡參數如表1所示。由于深度卷積網絡中高語義信息對于目標的外觀變化具有很強的魯棒性,但是當出現相似性目標時,由于高級語義信息缺少判別性,就容易導致模型出現漂移。所以為了增強網絡的判別能力,在網絡的中間層加入一個動態的特征調節機制,這個機制由雙重注意力機制實現,包括通道注意機制和空間注意機制,在后面將詳細介紹雙重注意力機制算法,所有的網絡參數在訓練完成后都是固定的,不需要在線微調從而滿足實時性的要求。

1.3 雙重注意力機制算法

注意力機制在圖像領域取得了很大的成功,因為它參考了人類的一個習慣:當我們看到一張圖片的時候并不是一次性能看到所有的信息,而是僅僅關注某個被選定的位置,然后再向四周蔓延。神經網絡在處理圖像的時候,每次網絡的關注點可能只是圖像中的某個小部分,因此如果能在網絡模型關注圖像某個部分時都能夠強調這個部分的話,這樣對于模型的特征表達能力是有提升的。為此,本文設計了一種適用于目標跟蹤任務的雙重注意力機制,當目標發生劇烈形變的時候,網絡能夠通過注意力機制關注目標的主要部分,從而提升模型的魯棒性。

1.4 數據集和網絡訓練細節

本文的網絡是在視頻目標檢測數據集ILSVRC上使用彩色圖像離線訓練的,其中包含了4500個視頻序列且有大約有130萬個人工標注的邊界框,最近被廣泛應用在跟蹤領域。采用動量為0.9的隨機梯度下降最優化網絡并設置權重衰減為0.0005,學習率以指數衰減方式從10-2到10-5,訓練周期大約為65個周期且每次小批量訓練樣本數為16。最后為了解決尺度變換問題,在搜索圖像上采用三個不同的尺度縮放因子{qs|q=1.025,s=-1,0,1}去搜索圖像,通過一個因子為0.35的線性插值去更新當前目標的尺度。

本文所提出的網絡模型是在TensorFlow 1.4.1框架[14]上訓練的,且實驗評估是在一臺配置為英特爾i7-8700K CPU 和顯卡GTX1080Ti電腦上進行的,平均幀率是40frame/s。

2 實驗結果及分析

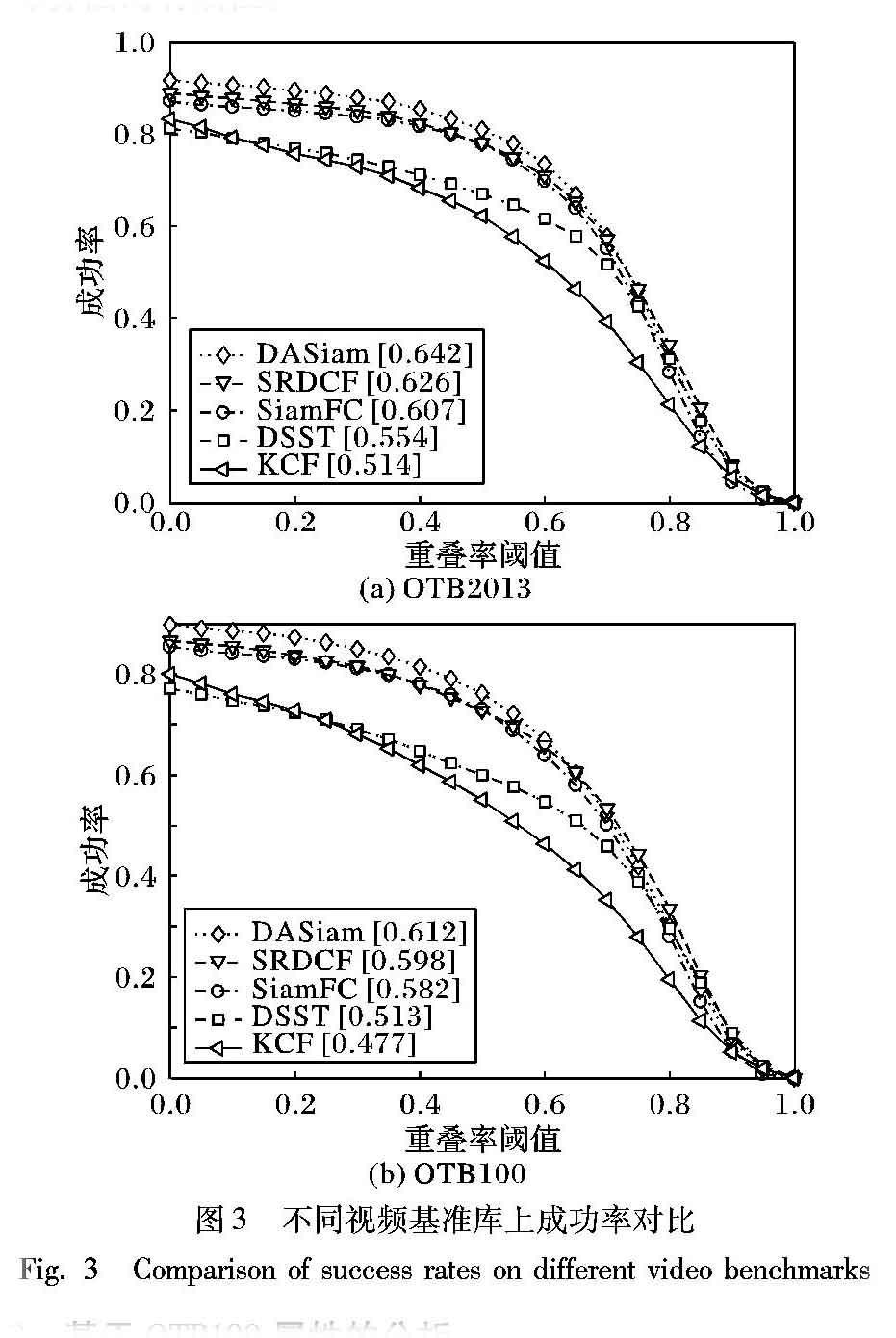

為了評估本文所提算法的有效性,在三個具有挑戰性并且被廣泛使用的視頻基準庫上進行實驗,分別是:OTB2013[15]、OTB100[16]、2017年視覺目標跟蹤庫(2017 Visual-Object-Tracking challenge, VOT2017)[17]實時挑戰,并且與基準算法SiamFC和幾個經典的算法進行對比實驗,實驗結果表明了本文算法能夠取得很有競爭性的性能表現。

在本文實驗中,選擇了三個具有代表性的跟蹤器進行對比,包括本文算法基準SiamFC和經典的相關濾波算法判別尺度空間跟蹤器(Discriminative Scale Space Tracker, DSST)[18]、核化相關濾波跟蹤(Kernelized Correlation Filter, KCF)[1]、空間正則判別相關濾波跟蹤(Spatially Regularized Discriminative Correlation Filter, SRDCF)[19]。

2.1 在OTB2013和OTB100上的評估

OTB2013和OTB100是視覺跟蹤領域廣泛使用的基準庫,分別包含了51個和100個人工標注的視頻幀,并且包含了11個不同的屬性,例如尺度變換、光照變化、平面內旋轉、快速運動等。算法的性能由兩個性能指標衡量:成功率和精確率。成功率表明重合率得分超過某個閾值的幀的個數占視頻總幀數的百分比,精確率表明了中心位置誤差在一個特定閾值內的視頻幀數占總幀數的百分比。重合率計算如下:

2.2 基于OTB100屬性的分析

本文在OTB100上對所提出的跟蹤器進行了11種不同屬性的對比分析實驗。圖4(a)、4(b)分別展示了當目標經歷了運動模糊和平面內旋轉兩種屬性的成功率,這兩種屬性表明了跟蹤的目標經歷了比較大的外觀變化,與給定的第一幀的目標外觀變化差別較大。由圖4可以看出,在運動模糊的屬性下本文算法取得了62.4%的得分,比基準算法SiamFC高出7.4個百分點;同時,本文算法在平面內旋轉的屬性下也取得了較好的表現。在目標經歷了運動模糊或者旋轉導致目標外觀發生變化的時候,SiamFC的跟蹤成功率得分比較低,表明該算法的魯棒性較低;而本文的DASiam加入了雙重注意力機制能夠很好地建立通道和空間的聯系,充分利用目標的有用信息而抑制周圍的干擾因素,從而提升了算法的魯棒性,并且充分利用深度網絡的優勢進一步提取表達能力更強的特征。

2.3 在VOT2017實時挑戰上的結果

在VOT2017數據庫中包含了60個更精細的人工標注的視頻序列并且更具有挑戰性,最近幾年在跟蹤領域中也被廣泛采用,除此之外,VOT2017還包含了一項新的實時實驗,要求所有的跟蹤器必須以超過實時的25frame/s的速度處理視頻流,這就意味著跟蹤器如果達不到實時,評估器將以上一幀的預測結果作為當前幀的跟蹤結果,這就很容易導致跟蹤器跟蹤失敗。圖5給出了本文算法DASiam和其他5個實時的跟蹤器在VOT2017實時實驗上的排名,其中基準SiamFC是2017年實時挑戰賽上的冠軍。

3 結語

本文在全卷積孿生網絡(SiamFC)跟蹤的基礎上改進了用于特征提取的卷積神經網絡,提出了雙重注意力機制孿生網絡跟蹤器(DASiam),通過在修改后的VGG網絡中嵌入了通道注意模塊和空間注意模塊提升網絡模型的判別能力,去解決目標外觀變化等問題。本文方法能夠在跟蹤標準測試集OTB2013和OTB100上取得很有競爭力的實驗結果,在VOT2017實時挑戰上的性能表現甚至超過了2017年實時的冠軍SiamFC,表明本文方法能夠在實際場景中,如無人駕駛、智能安防等,可以實現更好的跟蹤效果以滿足實際要求。但是,本文方法對于強烈光照變化、尺度變化較大等其他干擾因素出現時,跟蹤結果不太理想,接下來將針對強烈光照變化、尺度變化較大等問題進行進一步研究改進。

參考文獻 (References)

[1] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[2] 熊昌鎮,車滿強,王潤玲.基于稀疏卷積特征和相關濾波的實時視覺跟蹤算法[J].計算機應用,2018,38(8):2175-2179,2223.(XIONG C Z, CHE M Q, WANG R L. Real-time visual tracking algorithm based on correlation filters and sparse convolutional features [J]. Journal of Computer Applications, 2018, 38(8): 2175-2179, 2223.)

[3] 樊佳慶,宋慧慧,張開華.通道穩定性加權補充學習的實時視覺跟蹤算法[J].計算機應用,2018,38(6):1751-1754.(FAN J Q, SONG H H, ZHANG K H. Real-time visual tracking algorithm via channel stability weighted complementary learning [J]. Journal of Computer Applications, 2018, 38(6): 1751-1754.)

[4] 朱明敏,胡茂海.基于相關濾波器的長時視覺目標跟蹤方法[J].計算機應用,2017,37(5):1466-1470.(ZHU M M, HU M H. Long-term visual object tracking algorithm based on correlation filter [J]. Journal of Computer Applications, 2017, 37(5): 1466-1470.)

[5] BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking [C]// ECCV 2016: Proceedings of the 2016 European Conference on Computer Vision, LNCS 9914. Cham: Springer, 2016: 850-865.

[6] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks [C]// NIPS 2012: Proceedings of the 25th International Conference on Neural Information Processing Systems. North Miami Beach, FL: Curran Associates Inc., 2012: 1097-1105.

[7] TAO R, GAVVES E, SMEULDERS A W M. Siamese instance search for tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 1420-1429.

[8] HUANG C, LUCEY S, RAMANAN D. Learning policies for adaptive tracking with deep feature cascades [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 105-114.

[9] VALMADRE J, BERTINETTO L, HENRIQUES J, et al. End-to-end representation learning for correlation filter based tracking [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 5000-5008.

[10] GUO Q, FENG W, ZHOU C, et al. Learning dynamic Siamese network for visual object tracking [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2017: 1781-1789.

[11] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 770-778.

[12] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. [2019-10-16]. http://www.cs.cmu.edu/~jeanoh/16-785/papers/simonyan-iclr2015-vgg.pdf.

[13] RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge [J]. International Journal of Computer Vision, 2015, 115(3): 211-252.

[14] ABADI M, BARHAM P, CHEN J M, et al. TensorFlow: a system for large-scale machine learning [C]// OSDI 2016: Proceedings of the 12th USENIX Conference on Operating Systems Design and Implementation. Berkeley, CA: USENIX Association, 2016: 265-283.

[15] WU Y, LIM J, YANG M H. Online object tracking: a benchmark [C]// CVPR 2013: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013: 2411-2418.

[16] WU Y, LIM J, YANG M H. Object tracking benchmark [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848.

[17] KRISTAN M, LEONARDIS A, MATAS J, et al. The visual object tracking VOT2017 challenge results [C]// ICCVW 2017: Proceedings of the 2017 IEEE International Conference on Computer Vision Workshop. Piscataway, NJ: IEEE, 2017: 1949-1972.

[18] DANELLJAN M, HGER G, KHAN F, et al. Accurate scale estimation for robust visual tracking [C]// Proceedings of the 2014 British Machine Vision Conference. Durham, UK: BMVA Press, 2014: 65.1-65.11.

[19] DANELLJAN M, HAGER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking [C]// ICCV 2015: Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 4310-4318.