基于多特征融合的顯著性目標檢測算法*

張守東,楊 明,胡 太

南京師范大學 計算機科學與技術學院,南京 210023

1 引言

計算機視覺分析利用相關算法來模擬人類視覺系統中大腦感知的工作原理,對數字圖像進行特定任務的處理。顯著性目標檢測屬于計算機視覺領域下的一個重要分支,在這幾年已經成為熱門的研究話題,它是指人類能夠通過視覺系統從場景中提取出與其他區域相比更為顯著的區域,這有助于剔除后續視覺任務中圖像內無價值的區域。早期對這種情境感知和處理能力的研究主要來自認知科學家,而在最近一段時間里,計算機視覺領域的研究者同樣對該領域產生極大的興趣,并通過研究提出了大量的顯著性目標檢測算法。顯著性目標檢測能夠從復雜的場景中快速準確地定位圖像中最顯著的目標或區域,識別后的顯著性結果在視頻目標跟蹤[1]、交通控制[2]、圖像檢索[3]、圖像質量評估[4-5]、場景理解[6]等諸多計算機視覺領域中都有著廣泛的應用。

顯著性目標檢測算法的性能在過去的一段時間里實現了較大的提升,特別是得益于近幾年興起的深度學習,利用多層神經網絡能夠模擬大腦皮層感知神經元處理信息的特性,顯著性目標檢測算法的性能得到了進一步的提升。但是在復雜場景下檢測目標的準確性和完整性仍然存在著諸多問題,本文針對提高復雜場景下顯著性目標檢測算法的準確性展開深入研究,挖掘與利用更具有辨別性的深度特征,提出了一種新的基于多特征融合的顯著性目標檢測算法。

概括來說,本文有以下兩點貢獻:

(1)提出了一個基于多特征融合的全卷積神經網絡用于顯著性目標檢測。在全卷積神經網絡的深層,以預測顯著圖作為特征,融合圖像的全局深度特征和顯著性目標的位置特征,得到更具判別力的特征表示。

(2)提出了利用顯著性提名獲取候選目標的位置信息和置信值,并在各候選目標中添加中心先驗。為每個候選目標添加中心先驗可以有效地避免中心偏好,使得模型對位于圖像非中心區域的顯著性目標同樣具有檢測作用。

2 相關工作

顯著性目標檢測是提取圖像在視覺上最顯著的目標或區域。基于計算機視覺的顯著性目標檢測研究起始于20世紀90年代[7],經過多年的研究與發展,顯著性目標檢測算法的性能有了極大的提升。與大多數基于對比差異的經典模型[8]不同,基于CNN(convolutional neural network)的模型消除了對手工特征的高度依賴,避免人為地選擇合適的特征。基于CNN框架的模型通常包含數十萬個可調參數和眾多感受野(receptive field)大小不同的神經元,導致模型的復雜度比傳統方法更高,同時也帶來檢測效果的提升。因此,近幾年來眾多研究者更傾向于利用CNN框架研究和解決顯著性目標檢測的問題,基于CNN的顯著性目標檢測模型逐漸成為當前顯著性目標檢測的主要趨勢。

SuperCNN是He等[9]提出用深度學習的方法學習超像素的特征表示,它是早期將CNN應用于顯著性目標檢測的嘗試。與基于像素級分類的卷積神經網絡相比,He等提出的方法不僅提高了計算效率,還兼顧了全局上下文信息。然而該方法太過依賴超像素分割的結果,且具有內部標記一致性的超像素塊丟失了塊內的一部分語義信息,導致提取不出足夠的信息,因此在復雜場景的數據集下,該方法將不再適用。Wang等[10]同時考慮了圖像的局部和全局信息,提出分別為局部對比和全局搜索設計兩個子網絡。與Wang等類似的思想,Zhao等[11]考慮局部和全局上下文,構造了一個結合多種上下文的深度學習框架,整個圖像通過全局上下文模型提取全局對比信息,通過局部對比模型獲得局部信息。Lee等[12]提出利用兩個子網絡分別提取低級特征和高級特征的方法。Kim等[13]設計了一個雙通道的CNN網絡,兩個通道的CNN分別用于獲取局部上下文和全局上下文信息。Wang等[14]提出利用Fast R-CNN[15]框架解決顯著性目標檢測問題,通過在ROI池化層之后設置多個全連接層獲得每個區域的顯著值。Kim等[16]訓練CNN來預測顯著性目標的形狀。Li等[17]利用CNN提取超像素的高級特征,利用基于對比的方法獲得區域的低級特征。考慮到復雜場景下的自然圖像中可能存在多個尺寸差別較大的顯著性目標,Li等[18]提出將圖像三個不同尺度分割的區域作為CNN的輸入,利用三個子網絡提取圖像每個區域不同尺度的深度特征,隨后將這三個深度特征進行拼接,最后通過訓練一個由兩個全連接層組成的多層感知器(multilayer perceptron,MLP),得到該區域的顯著性分布。

雖然CNN可以有效提取超像素的深度特征,但顯著性目標的檢測效果過于依賴特征提取前的超像素分割結果和特征提取后的分類網絡。空間信息無法在全連接層中傳播,導致CNN提取到深度特征丟失部分語義信息。為了解決該問題,研究者提出了基于像素級分類的全卷積神經網絡(fully convolutional networks,FCN)[19]。由于去除了全連接層,因此FCN具有保持空間信息的特性,大量基于FCN的顯著性目標檢測模型被提出并獲得了更優的檢測性能。

Li等[20]在提出基于CNN提取多尺度深度特征的模型之后,又提出了一種具有兩個互補分支的卷積網絡模型,模型最終通過一個平衡的交叉熵損失函數融合兩個分支的預測結果。Liu等[21]構建一種由前后兩個子網絡連接而成的網絡模型。受Xie等[22]提出的全局嵌套邊緣檢測(holistically-nested edge detection,HED)方法的啟發,Tang等[23]使用循環卷積層替換了HED中的原始卷積層,達到同時獲取局部和全局上下文信息的目的。從多特征融合的動機出發,Li等[24]考慮聯合語義分割和顯著性目標檢測,將VGGNet中的兩個原始全連接層替換為卷積層,實現類似全卷積神經網絡的結構。隨著研究者對網絡架構的研究不斷深入,Zhang等[25]提出使用Deeplab[26]提取的高級特征和采用多級融合機制來檢測顯著性目標。Li等提出的MSRNet[27]考慮了實例級的顯著性目標分割。Hou和Cheng等[28]設計一個基于HED架構[22]的自上而下的模型,該算法提出通過在相鄰層之間建立強關系,有助于模型能夠更準確地確定顯著性目標的位置,從而提升了最終顯著圖的分割性能。這些基于神經網絡的算法在一般場景下的單目標顯著性檢測已經達到了較高的檢測精度,但是在復雜的場景下,復雜背景中的噪聲區域依然會干擾顯著性目標的檢測,導致檢測精度的降低。

3 基于多特征融合的顯著性目標檢測模型

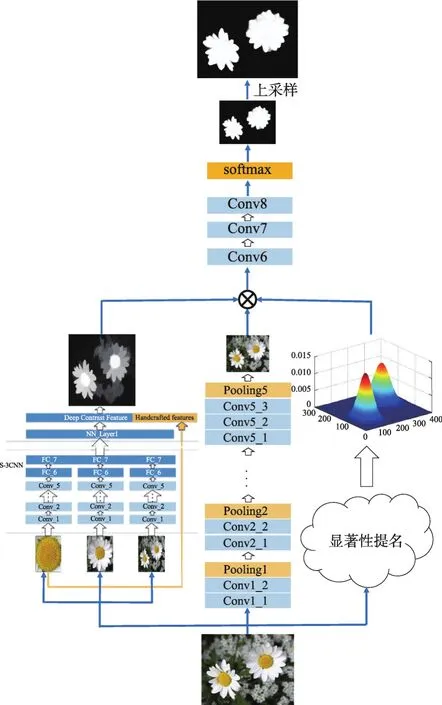

本文提出一種基于多特征融合的顯著性目標檢測算法(salient object detection based on multi-feature fusion,SOD_MFF)。如圖1所示,該算法首先訓練一個顯著性提名網絡,網絡獲取圖像中包含顯著性目標的多個候選區域。利用顯著性目標候選區域的空間信息和類別置信值生成混合高斯分布圖作為顯著性目標位置的先驗分布。將通過該先驗分布得到的顯著性目標空間位置特征與深度神經網絡較深層的特征相融合,同時融合初始顯著圖置信圖的特征表示,通過一個訓練好的網絡最終預測得到像素級的顯著性目標區域。

3.1 特征融合

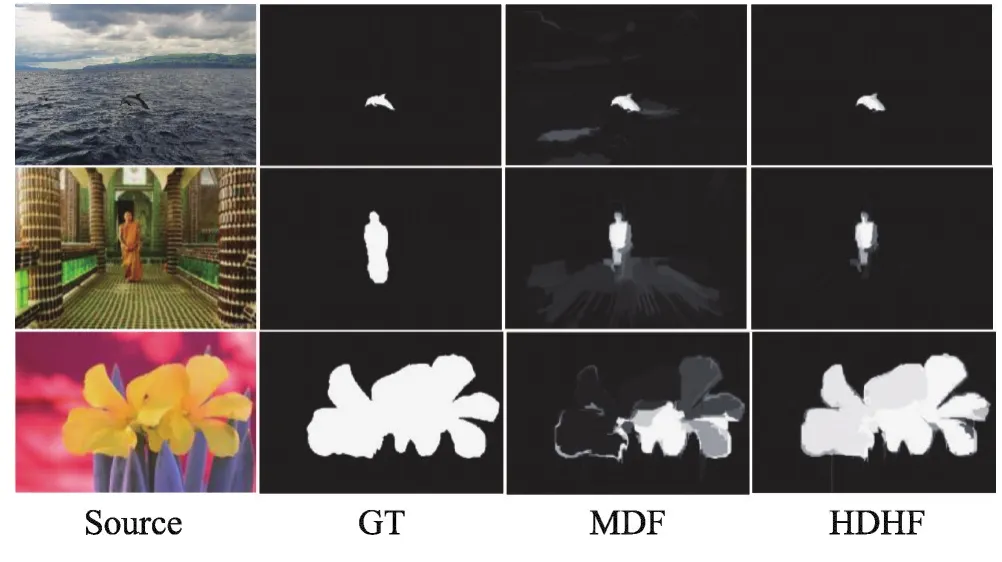

在一般場景下,卷積神經網絡提供了具有較強判別性的深度語義特征,而深度語義特征在較復雜場景下依舊會出現判別性較弱的情況。當顯著性目標的部分區域或背景的部分區域包含強烈的語義信息時,僅依賴深度特征的算法會錯誤地標記這些區域的顯著性,如圖2,第一、二列分別為原圖和真值圖(ground truth,GT),第三列為僅依賴深度特征的檢測算法(multiscale deep feature,MDF)[18]生成的顯著圖,第四列為在第三列方法的基礎上融合傳統手工特征的檢測算法(hybrid deep and handcrafted feature,HDHF)[29]生成的顯著圖。可以明顯看出,傳統的手工特征依然是顯著性目標檢測的重要特征。在這種較復雜的場景下,傳統的特征提取方法能夠根據邊界、紋理等信息提取出有對比度、有判別力的手工特征。深度特征與傳統手工特征實現了特征表示上的互補,融合這兩種特征有利于顯著性目標的高效檢測。

Fig.1 Schematic map of network structure圖1 網絡結構示意圖

Fig.2 Comparison of methods between deep features and fusing traditional features圖2 對比深度特征和融合傳統特征的方法

為了提高融合特征的辨別性,被添加的淺層特征需要通過實驗反復調整。研究者通常需要思考以下兩個問題:神經網絡中哪一層的淺層特征是有效的?融合多少層淺層特征是最佳的?考慮到本文基準算法的優異性能,本文算法將Li等[29]2016年提出的基于超像素塊提取深度和手工特征的顯著性檢測算法(HDHF)生成的顯著圖作為初始化顯著性目標特征,與網絡較深層的特征圖拼接在一起,得到更具有判別性的特征表示。這種思路受益于集成學習中堆疊做法,在訓練時會通過合理劃分數據集的方式避免模型過擬合。

3.2 中心先驗

為了進一步提升算法性能,本文考慮添加中心先驗信息。之前的研究者認為圖像的中心更有可能存在顯著性目標,因此嘗試給圖像的中心特征加上較高的權重或者直接通過中心先驗得到顯著性目標的空間位置特征。然而,如圖3,左側為原圖,中間為中心先驗圖,右側為中心先驗作用下的圖像,相比于遠離圖像中心的顯著性目標仙人掌,此時靠近中心的山體被判別為顯著性目標的概率更大,因此中心先驗失效。

Fig.3 Central priori has no effect圖3 中心先驗失去先驗效果

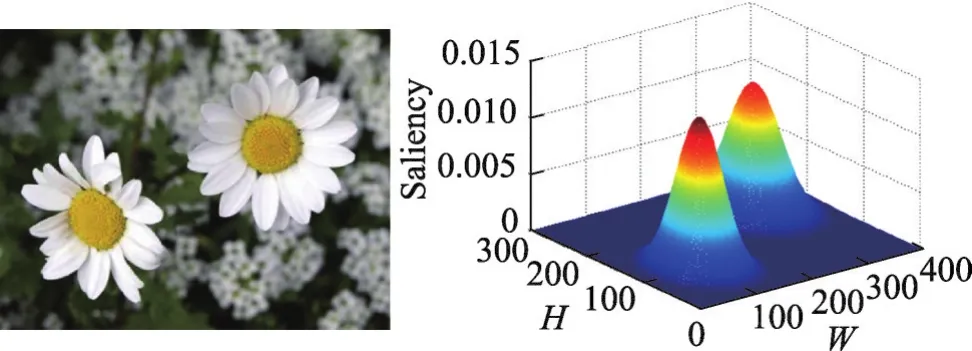

本文提出使用顯著性提名的方法檢測出目標候選區域,如圖4所示,分別以各目標的中心作為二維高斯分布的均值,建立顯著性目標先驗分布圖,以此克服傳統中心先驗的弱點,達到提升顯著性檢測性能的目的。

Fig.4 Priori distribution map of salient objects圖4 顯著性目標先驗分布圖

3.3 模型描述

不同于利用高斯分布直接添加中心先驗的做法,本文采用的是類似于區域提名的做法,如圖5所示,在Faster R-CNN[30]的網絡上進行修改,將原先分類層的20個目標類別設置為顯著性目標和非顯著性目標這兩個目標類別,而相應訓練集的類別標簽也從原先的20種替換成顯著性二元標簽,重新訓練得到顯著性區域提名網絡,修改后的網絡可以獲得顯著性目標的候選區域以及對應的置信值。顯著性區域提名算法通過檢測圖片中所有目標的潛在位置,之后分別以各區域的中心作為高斯分布的中心,構建目標先驗分布。通過先驗分布得到顯著性目標的空間位置特征,該特征將與全局像素從深度神經網絡提取的深度特征融合,得到更具有判別性的特征表示。

Fig.5 Candidate regions for salient objects圖5 顯著性目標的候選區域

Fig.6 Schematic map of network training圖6 網絡訓練示意圖

如圖6所示,在模型的訓練過程中,當SOD_MFF和HDHF采用相同的訓練集時,會導致模型因過擬合而無法收斂到更好的結果,即通過神經網絡生成的顯著圖和HDHF算法生成的顯著圖相似,沒有起到互補的作用。因此將訓練集合理劃分成十等份,隨機挑選三份訓練HDHF模型中的參數,而SOD_MFF模型使用完整的訓練集訓練,提升模型的泛化性能。

顯著性目標檢測過程中,特征來自于全卷積神經網絡提取的深度特征、HDHF算法生成的顯著性置信圖、利用目標檢測方法Faster R-CNN[30]獲得顯著性區域的空間位置特征,通過卷積網絡得到最終的顯著圖。

4 實驗和分析

在本章中,首先簡單介紹本次的數據集及實驗平臺;然后介紹評估模型使用的評價指標;接著對網絡參數設置和模型的訓練過程進行說明,便于后續研究者復現論文的實驗;最后以定性和定量的方式將本文提出的算法與當前主流的顯著性目標檢測技術進行比較并進行結果分析。

4.1 數據集及實驗平臺

在四個常用的公開數據集上評估了本文提出的方法,這些數據集分別是MSRA-B、ECSSD、PASCALS和HKU-IS。其中MSRA-B數據集包含5 000張具有各種顯著性目標類別的圖像,雖然部分圖像的場景比較復雜,但大部分圖像都只有單個顯著性目標。而ECSSD數據集是在CSSD數據集的基礎上擴展而來的,該數據集包含1 000張場景復雜的圖像,其中部分圖像還存在顯著性目標結構復雜和背景目標難以剔除的場景,需要提取圖像更豐富的語義特征才能有效地檢測顯著性目標。PASCAL-S是在PASCALVOC 2010分割挑戰賽的驗證集基礎上發展而來,該數據集包含850張圖像,其中的真值圖是由12個人獨立標注,最終取閾值為0.5而成,該數據集中的大部分圖像都具有較為復雜的場景。HKU-IS是一個包含4 447張極具挑戰性圖像的大型數據集,其中的絕大部分圖像中的目標都具有較低的對比度且單張圖像中存在多個顯著性目標,該數據集的引入增加了顯著性目標檢測算法的檢測難度。這些常用的數據集里都包含訓練集、驗證集、測試集和手工標注的二元真值圖(GT)。為了便于與其他算法進行公平的比較,按照慣例,本文使用MSRA-B數據集中的2 500張圖像訓練SOD_MFF,該2 500張圖像被標記為訓練集,驗證集為500張圖像,剩下的2 000張圖像作為模型性能評估的測試集。為了測試SOD_MFF對存在不同偏好的其他數據集的適用性,本文在MSRA-B的訓練集上訓練SOD_MFF,在MSRA-B中的測試集、HKU-IS、ECSSD和PASCAL-S上比較不同算法的性能。

本次實驗平臺使用的操作系統是Ubuntu 14.04.5,CPU的型號為英特爾至強E5-2650,主頻為2.2 GHz,GPU的型號為Nvidia TITANX Pascal,單張顯卡內存為12 GB,訓練模型時同時使用了5塊該種型號的顯卡。

4.2 評價指標

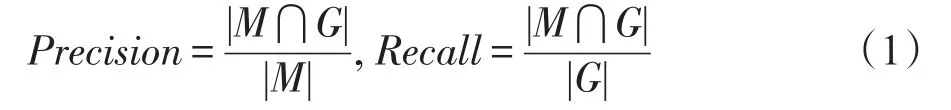

準確率-召回率曲線被廣泛用來驗證顯著性對象檢測算法。通過設置不同的閾值,將一個顯著圖S轉換為一個二元標記M,然后將M與真值圖G進行比較,分別計算出Precision和Recall的值。其中,Precision和Recall的計算公式見式(1)。

F-measure通常無論是精確率或召回率都不可以完全評價一個顯著圖的質量。為此,提出了F-measure利用一個非負的權重β2作為精確率和召回率的加權調和平均,式(2)即為F-measure的計算公式:

正如許多顯著的物體檢測工作[31]所建議的那樣,β2通常被設置為0.3以更多地權衡精確率,因為研究者發現召回率并不像精確度那么重要。例如,通過將整張圖設置為前景,可以容易地實現100%的召回率。

平均絕對誤差(mean absolute error,MAE)對于某些特定的應用,連續顯著圖的質量可能比二元標記更重要。為了進行更加全面的比較,采用評估連續顯著圖S和二元真值G之間的平均絕對誤差,二者均在[0,1]范圍內歸一化。MAE分值定義為式(3):

4.3 網絡參數設置和訓練過程

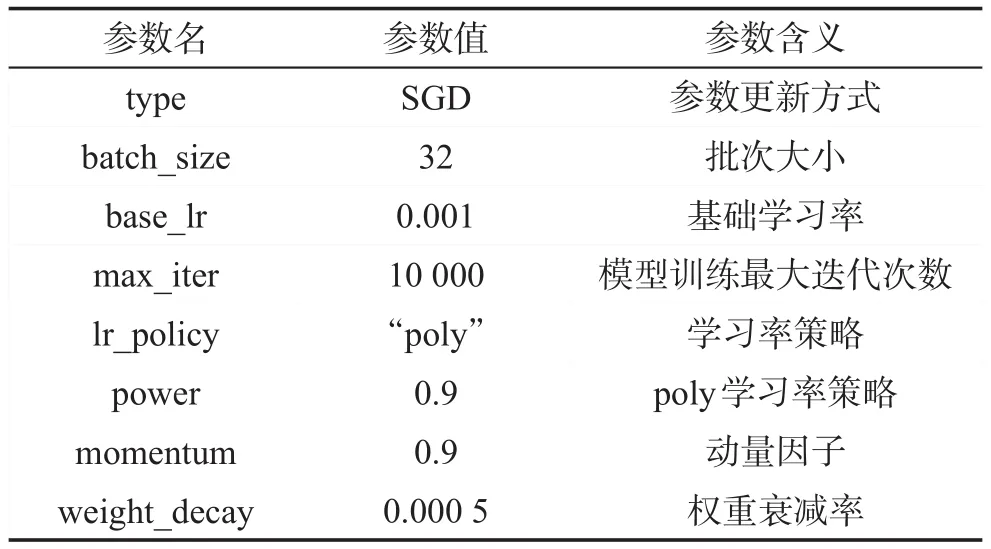

本文提出的算法基于caffe[32]深度學習框架實現,本節將介紹在caffe環境下神經網絡訓練的參數設置及與網絡訓練過程,其中網絡參數設置如表1所示。

Table 1 Parameter settings for SMR_GPF network表1 SMR_GPF網絡參數設置

SOD_MFF的網絡結構主要是基于VGG16網絡而設計的,訓練過程中,通過反向傳播算法統一優化包括特征聯結前后的整個網絡中各層的參數。如圖7所示,本節將主要闡述網絡的訓練過程。

Fig.7 Training diagram of neural network圖7 本文神經網絡訓練流程圖

(1)劃分數據集:對于每個評估數據集,將數據集劃分為訓練集、驗證集和測試集三部分。

(2)制作顯著性邊界框檢測數據集:對于數據集中每個樣本的真實顯著圖(GT),利用洪水填充(flood fill)算法分割每個顯著性目標(即標記連通圖),并根據每個目標得到每個顯著性目標的邊界框,將該樣本下所有的顯著性目標以邊界框的形式保存為xml文件。

(3)根據上一步制作的邊界框檢測數據集,在訓練集上基于Faster R-CNN網絡訓練顯著性邊界框檢測模型。

(4)獲得顯著性候選區域:根據上一步得到的顯著性邊界框檢測模型對所有訓練集和驗證集的樣本進行顯著性邊界框檢測,為了能夠將該信息嵌入到神經網絡中,本文算法依據檢測得到的邊界框和置信值生成多元高斯分布圖,多元高斯分布圖中每一個峰值為顯著性區域的置信值,分布圖中大于0的區域即為顯著性的候選區域。

(5)獲得初始顯著圖:利用訓練集數據對基于超像素塊提取深度和手工特征的顯著性檢測算法(HDHF)中的分類網絡進行訓練,并通過驗證集數據訓練每個超像素粒度下模型結果的權重,最終得到完整的HDHF模型。

(6)根據上一步得到的HDHF模型對所有訓練集和驗證集的樣本進行顯著性檢測得到初始顯著圖。

(7)為了能夠在預訓練模型VGG16上進行微調,對訓練集和驗證集中所有樣本的圖像進行預處理,數據預處理過程包括:圖像均值化、RGB圖像維度轉換為BGR圖像。

(8)利用訓練集和驗證集的樣本訓練本文網絡的模型:對于網絡結構的設計,以預處理后的原始圖像、第4步得到的顯著性多元高斯分布圖和第6步得到的初始顯著圖同時作為網絡的輸入,在經過若干個卷積層之后得到圖像的深度特征圖,將尺度縮放后的多元高斯分布圖、初始顯著圖與深度特征圖按照相同坐標不同通道的方式進行拼接。然后繼續利用多層卷積網絡向前傳播。網絡參數進行合理設置之后,對設計的網絡進行訓練得到最終的顯著性檢測SOD_MFF模型。

(9)對于測試集中的每一幅圖像,與第(7)步同樣的預處理方式對圖像進行預處理,同時結合顯著性多元高斯分布圖和初始顯著圖作為網絡的輸入數據,根據測試網絡的前向計算得到最終尺度較小的顯著圖,利用B樣條插值算法將其上采樣至原始圖像大小一致的顯著圖,這樣的顯著圖即為最終所需要的顯著性檢測結果。

雖然SOD_MFF使用MSRA-B中的2 500個訓練樣本訓練模型需要大約30 h,已經訓練好的模型(SOD_MFF)在400×300大小的測試圖像中僅需2.3 s就可以完成顯著性目標檢測的任務。與當前一些先進的基于深度學習的顯著性目標檢測算法相比,該方法都有較為明顯的優勢。實驗結果證明,SOD_MFF的性能已經優于現有的先進方法。

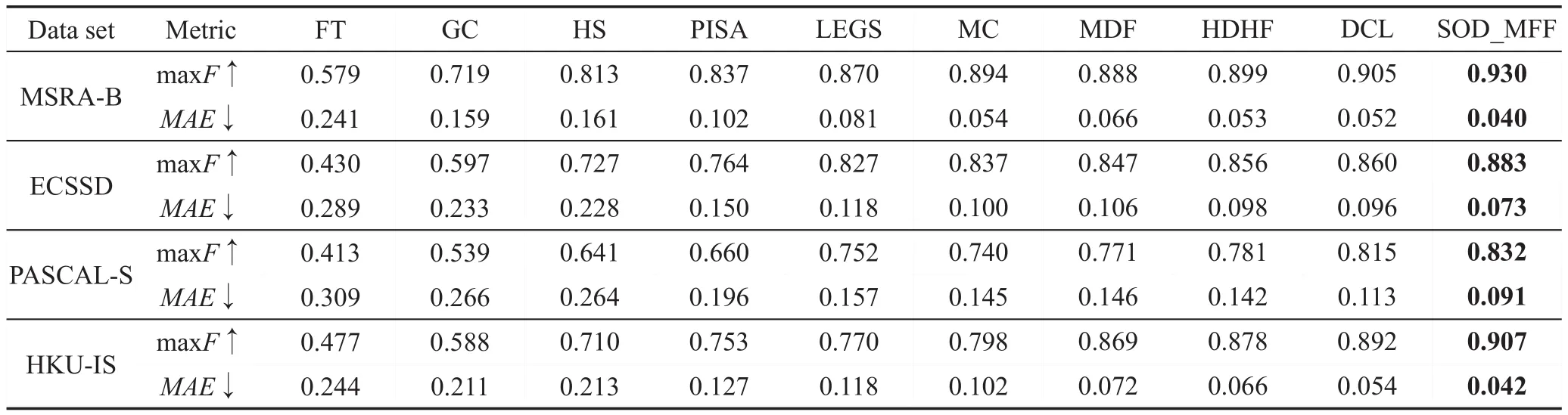

4.4 實驗結果比較與分析

將本文提出的基于多特征融合的顯著性目標檢測算法(SOD_MFF)與當前深度學習應用于顯著性目標檢測領域的先進算法進行比較。同時,一些經典的基于手工特征判別的顯著性目標檢測算法也參與性能的比較。對比算法有:FT(frequency-tuned)、GC(global contrast)、HS(hierarchical saliency)、PISA(pixelwise image saliency by aggregating complementary appearance contrast measures)、LEGS(local estimation and global search)[10]、MC(multi-context)[11]、DCL(deep contrast learning)[20]、MDF(multiscale deep feature)[18]和HDHF[29]。本文使用提供的開源代碼復現實驗結果或者提供的顯著圖進行相關性能比較。

如圖8,給出了本文提出的方法在4個公開的數據集上對比當前顯著性目標檢測先進算法的直觀展示。前兩行是顯著性目標與圖像背景存在對比差異較小的情況,中間兩行是顯著圖中顯著性目標內部組成部分較為復雜的情況,后兩行是顯著性目標與圖像邊緣相接觸的情況。第一列為測試集中的原圖,第二列為手工標記的二元真值圖(GT),第三列為本文提出的SOD_MFF算法生成的顯著圖,后面的9列為當前先進的顯著性目標檢測深度學習算法和經典的基于傳統手工特征的顯著性目標檢測算法生成的顯著圖。為了突出本文提出的SOD_MFF對于復雜場景下的顯著性目標檢測依然非常高效,從4個公開數據集的近11 500張圖像中找到了極具代表性的6張圖像進行對比展示。前兩行圖像選取的背景較為復雜且目標區域與其相鄰的背景區域對比度較小,僅憑手工特征或淺層特征都無法得到令人滿意的結果。中間兩行圖像選取的圖像特點是目標區域由多個對比度較大的小區域組成,如果不借助通過深度語義信息進行判別,很難獲得完整的顯著性目標。最后兩行圖像的顯著性目標不再集中在圖像的中心區域,而都與圖像邊緣有接觸。通過觀察發現,可以直觀地發現本文提出的SOD_MFF效果優于與其進行對比的其他9種算法。具體定量化的算法性能比較見表2所示。

Fig.8 Visual comparison of saliency maps generated by different algorithms圖8 不同算法生成顯著圖的視覺對比

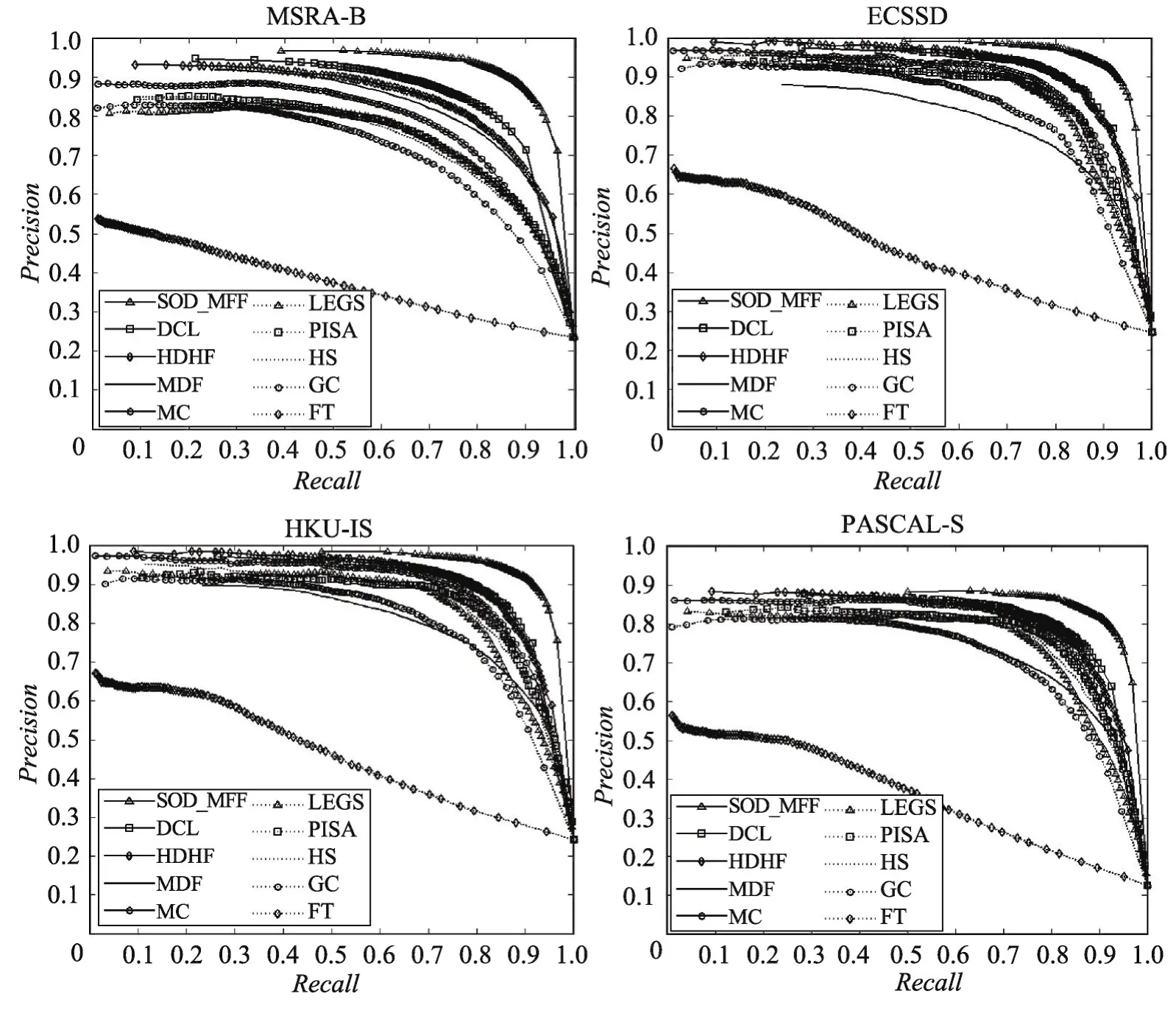

如圖9所示為本文提出的SOD_MFF算法與其他顯著性目標檢測算法在PR曲線上的比較。如圖10所示為SOD_MFF算法與其他對比算法在精確率、召回率和F值的量化比較。從兩張圖可以明顯看出,本文提出的SOD_MFF在上述公開數據集上的性能明顯優于其他所有對比算法的性能。對比之前算法的maxF(maxF-measure,數值越大性能越好),SOD_MFF比HDHF、MDF和DCL在4個數據集上平均分別提高了3.45%、4.43%和2%,maxF-measure指標上優勢明顯;對于評價指標MAE(數值越小性能越好),本文提出來的SOD_MFF比HDHF、MDF和DCL在4個數據集上平均分別減少了2.83%、3.6%和1.73%,使得最終的顯著圖更接近給定的真值圖(GT)。在檢測單幅圖像的顯著性目標時,本文提出的SOD_MFF算法與現有基于深度學習的顯著性目標檢測算法相比,耗時差異不明顯,檢測結果的正確率卻有明顯的提升。

Table 2 Quantitative comparison of experimental results表2 實驗結果的定量化比較

Fig.9 Comparison of PR curves between SOD_MFF and other algorithms圖9 SOD_MFF與對比算法的PR曲線之間的比較

Fig.10 Comparison of Precision,Recalland F-measure between SOD_MFF and other algorithms圖10 SOD_MFF與對比算法Precision,Recall和F值的比較

5 結論

本文提出了一種新穎的顯著性目標檢測算法:基于多特征融合的顯著性目標檢測算法。它訓練一個顯著性目標檢測網絡,并且以HDHF模型的預測顯著圖作為特征,此外通過顯著性提名網絡確定候選區域,在各候選區域添加中心先驗作為特征。經過10種算法在4個極具挑戰性的數據集上測試對比后發現,在背景存在較多噪聲干擾的情況下,本文提出的SOD_MFF性能明顯比其他當前主流算法更具有競爭力。