基于圖像的頭發(fā)建模技術(shù)綜述

包永堂 齊 越

1(山東科技大學(xué)計(jì)算機(jī)科學(xué)與工程學(xué)院 山東青島 266590) 2(虛擬現(xiàn)實(shí)技術(shù)與系統(tǒng)國(guó)家重點(diǎn)實(shí)驗(yàn)室(北京航空航天大學(xué)) 北京 100083) 3(北京航空航天大學(xué)青島研究院 山東青島 266100) (baozi0221@163.com)

頭發(fā)是人類特征的重要組成部分,是判斷一個(gè)人的年齡、背景及身份等的重要依據(jù)[1].因此頭發(fā)建模是虛擬現(xiàn)實(shí)和計(jì)算機(jī)圖形學(xué)需要研究的重要內(nèi)容之一.一個(gè)正常人的頭發(fā)大約10萬(wàn)多根,數(shù)量很大;頭發(fā)直徑微小,形狀、結(jié)構(gòu)非常復(fù)雜,構(gòu)造逼真3D頭發(fā)模型的難度很大.因此開(kāi)展3D頭發(fā)建模研究具有重要的理論意義.在數(shù)字游戲和影視中,虛擬角色具有逼真的頭發(fā)模型,不僅能提供豐富的視覺(jué)特性,而且能以特定的語(yǔ)言描述人物的特征和感情等.此外,在化妝、廣告等領(lǐng)域?qū)︻^發(fā)建模也有大量應(yīng)用需求.因此研究頭發(fā)建模具有重要的應(yīng)用價(jià)值.

早期頭發(fā)建模主要采用參數(shù)化的幾何建模方式[2-3],通過(guò)設(shè)置不同的參數(shù)來(lái)表示頭發(fā)[4-6].這些參數(shù)表示涉及參數(shù)曲面表示頭發(fā)、三棱鏡形式的頭發(fā)縷或廣義圓柱體.一些工作使用2D表面來(lái)表示頭發(fā)組[7-9],這類方法大多使用如非均勻有理B樣條(non-uniform rational B-splines, NURBS)的曲面來(lái)減少用于建立頭發(fā)部分模型的幾何對(duì)象的數(shù)量.發(fā)束、簇、縷和圓柱模型被作為直觀的方法來(lái)控制以組的形式表示的多重頭發(fā)的位置和形狀[10-14].這些方法減少了用于定義發(fā)型的可控參數(shù)的數(shù)量,用戶可以通過(guò)編輯曲線的位置來(lái)控制頭發(fā)的形狀.使用分層次的廣義圓柱可以表示復(fù)雜的頭發(fā)幾何體[15-16],在建模過(guò)程中允許用戶選擇期望的控制水平.較高層次的聚集操作能夠提供快速的全局形狀編輯的有效方式,而較低水平的聚集允許對(duì)詳細(xì)幾何體直接操作.盡管參數(shù)化建模方法可以被用來(lái)快速地生成頭發(fā)發(fā)型并進(jìn)行仿真,但是由于使用頭發(fā)條的表示方式,可以被建模的頭發(fā)發(fā)型受到了限制.

同早期頭發(fā)建模方式不同,當(dāng)前頭發(fā)建模主要有2種方法:1)基于物理的頭發(fā)建模方法[17-19],采用符合物理規(guī)律的頭發(fā)模型,通過(guò)設(shè)置相關(guān)參數(shù)構(gòu)造出不同的頭發(fā),建模過(guò)程不直觀、難以控制,計(jì)算量很大,構(gòu)造的模型逼真度不高;2)基于圖像的頭發(fā)建模方法,利用采集的頭發(fā)數(shù)據(jù)構(gòu)造頭發(fā)模型,具有建模速度快、模型逼真度高等優(yōu)點(diǎn),近幾年受到研究者重視,出現(xiàn)了許多研究成果.

基于圖像的頭發(fā)建模方法大量融合計(jì)算機(jī)視覺(jué)的理論和工作,主要用于解決發(fā)型重建的問(wèn)題,相關(guān)方法側(cè)重于得到與實(shí)際照片近似的頭發(fā)模型.當(dāng)前,基于圖像的頭發(fā)建模方法還是新的研究領(lǐng)域,有許多科學(xué)問(wèn)題急需解決,主要包括:如何得到與采集數(shù)據(jù)在發(fā)絲級(jí)別對(duì)應(yīng)的逼真建模結(jié)果?如何得到發(fā)絲的生長(zhǎng)分布與真實(shí)近似的結(jié)果?如何構(gòu)造動(dòng)態(tài)頭發(fā)模型,有效解決動(dòng)態(tài)頭發(fā)碰撞和遮擋問(wèn)題?如何編輯、重用已有的靜態(tài)或動(dòng)態(tài)頭發(fā)模型?本文以基于圖像的頭發(fā)建模技術(shù)為主要論述對(duì)象,從基于單幅圖像的頭發(fā)建模、基于多幅圖像的靜態(tài)頭發(fā)建模、基于視頻的動(dòng)態(tài)頭發(fā)建模以及頭發(fā)建模結(jié)果的編輯重用等方面,對(duì)當(dāng)前已有的方法分別進(jìn)行分析和總結(jié),提出了該領(lǐng)域當(dāng)前存在的問(wèn)題和挑戰(zhàn),并指出了將來(lái)需要重點(diǎn)關(guān)注的研究方向.

1 基于單幅圖像的頭發(fā)建模方法

近年來(lái),一些基于圖像的頭發(fā)建模方法開(kāi)始探討利用單幅圖像進(jìn)行頭發(fā)建模的可能.根據(jù)重建方式的不同,基于單幅圖像的頭發(fā)建模方法主要有2種方式:1)基于方向場(chǎng)的頭發(fā)建模;2)基于數(shù)據(jù)驅(qū)動(dòng)的頭發(fā)建模.

1.1 基于方向場(chǎng)的單幅圖像的頭發(fā)建模

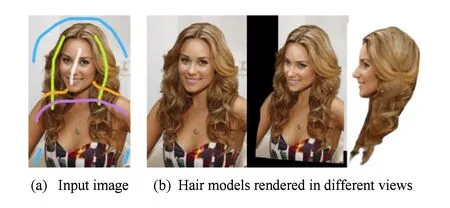

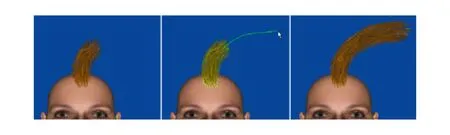

基于方向場(chǎng)的單幅圖像頭發(fā)建模方法從單視點(diǎn)的照片中生成3D方向場(chǎng),從頭皮發(fā)根處生長(zhǎng)出發(fā)絲,構(gòu)造出在單視點(diǎn)下真實(shí)的3D頭發(fā)模型.此類方法的難點(diǎn)在于如何構(gòu)造逼真的3D方向場(chǎng).2012年Chai等人[20]首次基于單幅肖像照片構(gòu)造3D頭發(fā)模型,實(shí)現(xiàn)了對(duì)照片中頭發(fā)的編輯,如圖1所示.他們生成的模型在視覺(jué)上與原圖像形似,同時(shí)他們的頭發(fā)模型是發(fā)絲級(jí)別的表示,因此可以對(duì)頭發(fā)進(jìn)行許多有趣的編輯和操作,例如為不同的人物交換發(fā)型,或者轉(zhuǎn)換觀察視點(diǎn).但是這一方法生成的頭發(fā)模型不具有物理正確性,其頭發(fā)由漂浮在薄殼中的頭發(fā)片段構(gòu)成,而不是一根根從頭皮生長(zhǎng)出的完整頭發(fā).

Fig. 1 Hair modeling from single image[20]圖1 基于單幅圖像的頭發(fā)建模方法[20]

為了得到具有空間連續(xù)性的更加符合物理的頭發(fā)模型,2013年Chai等人[21]繼續(xù)了之前的工作,改進(jìn)了方法中存在的物理不夠真實(shí)的特點(diǎn).他們利用用戶的簡(jiǎn)單交互,為方向場(chǎng)提供了指引方向,生成了完整的物理可靠的方向場(chǎng).從頭皮生長(zhǎng)出頭發(fā),構(gòu)造出物理上更逼真的頭發(fā)模型,從而可以對(duì)發(fā)型進(jìn)行修剪、增加頭發(fā)、進(jìn)行簡(jiǎn)單的頭發(fā)仿真等操作.在這一工作中,他們還展示了從單視點(diǎn)視頻中重建頭發(fā)模型并進(jìn)行編輯的結(jié)果,盡管他們的結(jié)果比較真實(shí),但由于單視點(diǎn)下采集的信息少,他們也僅能保證建模結(jié)果在單視點(diǎn)投影下近似真實(shí).

Fig. 2 Hair modeling result[22]圖2 頭發(fā)建模方法結(jié)果[22]

Echevarria等人[22]使用特征保留的顏色濾波和抽象的幾何細(xì)節(jié)構(gòu)建3D頭發(fā)模型,實(shí)現(xiàn)了表面頭發(fā)模型的3D打印,如圖2所示.他們的方法生成的頭發(fā)模型能夠保留模型結(jié)構(gòu)細(xì)節(jié),適用于傳統(tǒng)的雕像制作,但卻不能生成發(fā)絲級(jí)別的精確頭發(fā)模型.Yeh等人[23]從具有連貫的分層和遮擋關(guān)系的單張卡通圖片中生成頭發(fā)模型,但由于生成的頭發(fā)模型是2.5D的,并不能保證頭發(fā)模型建模和編輯的真實(shí)性.2015年Chai等人[24]提出了一種基于混合方式的高質(zhì)量頭發(fā)建模方法.利用單幅圖像對(duì)應(yīng)一個(gè)參數(shù)化的可變形臉部模型,利用遮擋和輪廓限制重建出基本形狀;利用從陰影計(jì)算形狀(shape-from-shading)的方法,估計(jì)出頭發(fā)表面的法向量;利用3D螺旋線優(yōu)先的方法重建出頭發(fā)的幾何細(xì)節(jié).綜合這3方面信息,通過(guò)求解能量最小化方程構(gòu)建最終頭發(fā)的深度圖.用該方法得到的模型效果較為逼真,可以應(yīng)用于重新渲染和3D打印等,但不具備物理真實(shí)性.2016年Ding等人[25]使用方向場(chǎng)和螺旋線匹配策略構(gòu)建單視點(diǎn)的頭發(fā)模型,結(jié)果如圖3所示.同文獻(xiàn)[20-22]提到的方法相比,該方法能夠生成更為精確的發(fā)絲深度估計(jì),但最終頭發(fā)模型是由漂浮在薄殼中的頭發(fā)片段構(gòu)成,仍然不具有物理正確性.

Fig. 3 Single-view hair modeling by orientation & helix fitting[25]圖3 基于方向場(chǎng)和螺旋線匹配的單視點(diǎn)頭發(fā)建模結(jié)果[25]

1.2 基于數(shù)據(jù)驅(qū)動(dòng)的單幅圖像的頭發(fā)建模

Fig. 4 Single-view hair modeling using a hairstyle database[26]圖4 基于模型數(shù)據(jù)庫(kù)的單幅圖像頭發(fā)建模方法[26]

基于數(shù)據(jù)驅(qū)動(dòng)的方法首先需要構(gòu)建頭發(fā)模型數(shù)據(jù)庫(kù),之后從數(shù)據(jù)庫(kù)中查找生成3D頭發(fā)模型.最近,基于數(shù)據(jù)驅(qū)動(dòng)的單幅圖像建模方法開(kāi)始興起.2015年Hu等人[26]首次提出基于頭發(fā)模型數(shù)據(jù)庫(kù)的單幅圖像頭發(fā)建模方法.用戶在頭發(fā)圖像上交互輸入發(fā)絲引導(dǎo)曲線,他們的方法就能從頭發(fā)模型數(shù)據(jù)庫(kù)中查找出幾類對(duì)應(yīng)的頭發(fā)模型,再根據(jù)頭發(fā)模型融合策略最終生成頭發(fā)模型,如圖4所示.該方法基于單幅照片首次生成了真3D的頭發(fā)模型,但其建模結(jié)果取決于用戶手工所畫(huà)引導(dǎo)發(fā)絲的質(zhì)量,同時(shí)也受限于頭發(fā)模型數(shù)據(jù)庫(kù)的大小.

2016年Chai等人[27]提出了一種基于單幅圖像的完全自動(dòng)的頭發(fā)建模方法.他們將深度卷積神經(jīng)網(wǎng)絡(luò)應(yīng)用到頭發(fā)分割和頭發(fā)生長(zhǎng)方向估計(jì)中,構(gòu)建3D頭發(fā)模型樣例庫(kù),研發(fā)了一種基于數(shù)據(jù)驅(qū)動(dòng)的頭發(fā)匹配和建模方法,如圖5所示.同以往需要用戶交互的頭發(fā)建模方式[20-21,24,26]相比,該方法實(shí)現(xiàn)了自動(dòng)頭發(fā)模型重建.但由于依賴于人臉對(duì)齊技術(shù),該方法并不適用于無(wú)人臉的圖像,建模結(jié)果的好壞也依賴于頭發(fā)模型數(shù)據(jù)庫(kù)的大小.

Fig. 5 Fully automatic hair modeling from a single image[27]圖5 全自動(dòng)的單幅圖像頭發(fā)建模方法[27]

表1給出了基于方向場(chǎng)和基于數(shù)據(jù)驅(qū)動(dòng)的2種單幅圖像的頭發(fā)建模方法在用戶控制程度、時(shí)間消耗、自動(dòng)化程度和建模結(jié)果真實(shí)性等方面的比較,同時(shí)還給出了每種方法對(duì)應(yīng)的典型參考文獻(xiàn).從表1中我們可以看出,基于方向場(chǎng)的方法自動(dòng)化程度較低,需要較多的用戶交互控制,建模速度相對(duì)較快,但建模結(jié)果不是真3D的;而基于數(shù)據(jù)驅(qū)動(dòng)的單幅圖像頭發(fā)建模方法自動(dòng)化程度較高,需要較少的用戶交互控制并且能夠得到3D的頭發(fā)模型,但所需花費(fèi)的時(shí)間較多.

Table 1 Analysis of Two Types of Single-Image Based Hair Modeling Methods表1 基于單幅圖像的2種頭發(fā)建模方法分析

2 基于多幅圖像的靜態(tài)頭發(fā)建模方法

根據(jù)建模方式的不同,基于多幅圖像的靜態(tài)頭發(fā)建模方法可以分為基于方向場(chǎng)的多幅圖像靜態(tài)頭發(fā)建模方法和基于數(shù)據(jù)驅(qū)動(dòng)的多幅圖像靜態(tài)頭發(fā)建模方法這2類.

2.1 基于方向場(chǎng)的多幅圖像靜態(tài)頭發(fā)建模方法

基于方向場(chǎng)的多幅圖像靜態(tài)頭發(fā)建模方法的主要流程包括:采集靜態(tài)頭發(fā)圖像,根據(jù)圖像生成頭發(fā)的方向場(chǎng)、內(nèi)部場(chǎng)、基于樣例頭發(fā)等約束條件,用頭發(fā)追蹤生長(zhǎng)等算法構(gòu)造出3D頭發(fā)模型.

Fig. 6 Filter-based hair modeling from multiple images[30]圖6 使用濾波函數(shù)的多幅圖像頭發(fā)建模方法[30]

1997年Kong等人[28]首次使用真實(shí)的頭發(fā)圖片重建出頭發(fā)模型.他們的方法先通過(guò)從不同視點(diǎn)采集的頭發(fā)照片構(gòu)建3D頭發(fā)體,隨后使用啟發(fā)式方法從頭發(fā)體中生成頭發(fā)模型.該方法只重建頭發(fā)幾何,并且僅適用于簡(jiǎn)單的發(fā)型,并不保證頭發(fā)方向的可靠度.隨后,Grabli等人[29]提出利用頭發(fā)的光照性質(zhì),從圖像中提取頭發(fā)的局部方向場(chǎng).他們的系統(tǒng)通過(guò)學(xué)習(xí)在不同控制光照條件下目標(biāo)頭發(fā)的反射情況而完成重建,系統(tǒng)中獲取照片的視點(diǎn)是始終不變的.通過(guò)一個(gè)固定的視點(diǎn)和單獨(dú)的濾波器來(lái)檢測(cè)頭發(fā)絲的方向,他們的方法僅能重建頭發(fā)的一部分,并且需要嚴(yán)格控制光照條件.2004年P(guān)aris等人[30]通過(guò)多個(gè)濾波函數(shù)和不同的視點(diǎn),把Grabli等人[29]的方法擴(kuò)展為一種更準(zhǔn)確的情況,得到了不錯(cuò)的建模結(jié)果,如圖6所示.他們的策略是將一組待測(cè)試的方向?yàn)V波函數(shù)作用于一個(gè)2D圖像的局部區(qū)域,選取有最大可靠度的結(jié)果作為局部的方向.他們的方法獲取了頭發(fā)可見(jiàn)區(qū)域的方向信息,由此生成出關(guān)于原始發(fā)型可信的結(jié)果.Mao等人[31]基于繪制的草圖建立卡通頭發(fā)模型,但他們的方法僅能建立簡(jiǎn)單的卡通頭發(fā)模型,不能夠構(gòu)建現(xiàn)實(shí)世界中的常見(jiàn)頭發(fā)模型.Wei等人[32]通過(guò)提取多視點(diǎn)下固有的幾何約束,進(jìn)一步提升了Paris等人[30]方法的靈活性.該方法使用單個(gè)相機(jī)在普通光照條件下多視點(diǎn)采集頭發(fā)數(shù)據(jù),用三角化方法生成頭發(fā)3D方向場(chǎng),定義粗糙的視覺(jué)殼作為頭發(fā)生長(zhǎng)邊界,利用方向場(chǎng)構(gòu)造3D頭發(fā)模型,結(jié)果如圖7所示.他們的方法不再需要控制的光照條件,也不再需要復(fù)雜的設(shè)備,但很難構(gòu)造凹凸、卷曲的發(fā)型.

Fig. 7 Triangle-based hair modeling from multi-view images[32]圖7 三角化的多視點(diǎn)頭發(fā)建模方法[32]

隨著圖形學(xué)領(lǐng)域?qū)趫D像的靜態(tài)頭發(fā)建模方法的不斷關(guān)注,越來(lái)越多的研究者開(kāi)始利用復(fù)雜而專門設(shè)計(jì)的采集設(shè)備達(dá)到高質(zhì)量的頭發(fā)建模.2008年P(guān)aris等人[33]引入了一種獨(dú)特的多視點(diǎn)采集系統(tǒng),能夠準(zhǔn)確地得到外圍的發(fā)絲位置,從而得到逼真的建模結(jié)果,如圖8所示.這一工作利用文獻(xiàn)[30]中的方法分析圖像中的頭發(fā)方向,借助Wei等人[32]的多視點(diǎn)思想將方向轉(zhuǎn)化為3D的方向場(chǎng).Paris等人設(shè)計(jì)的采集系統(tǒng),可以直接獲取三角化的表面頭發(fā).該工作把利用方向場(chǎng)從頭皮生長(zhǎng)而來(lái)的頭發(fā)與表面發(fā)絲結(jié)合,得到整個(gè)頭發(fā)模型.

Fig. 8 Geometric and photometric acquisition of real hairstyles[33]圖8 采集幾何和頭發(fā)外觀的真實(shí)發(fā)型頭發(fā)建模方法[33]

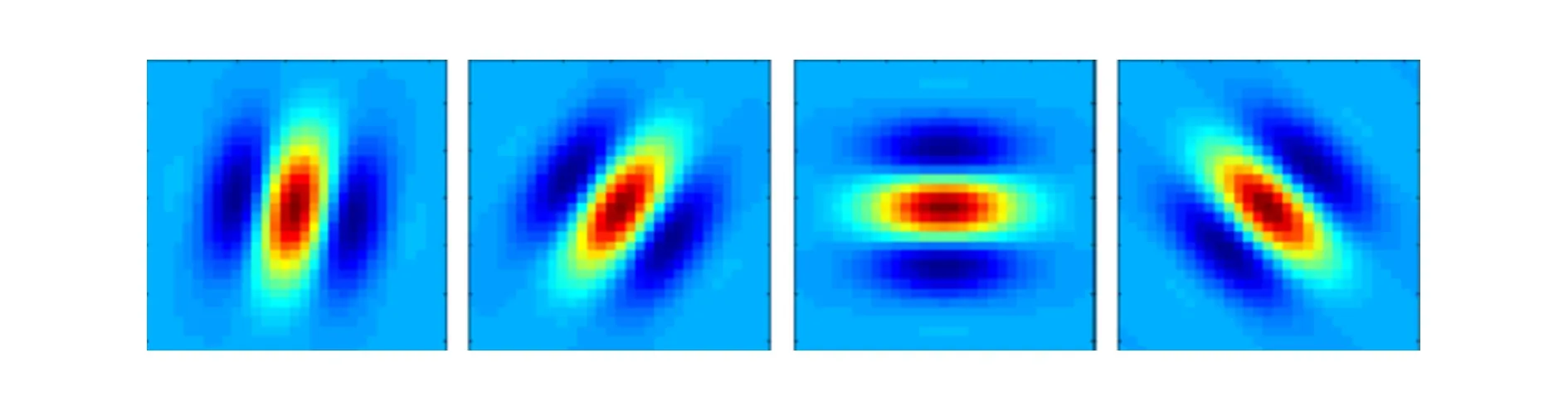

為了生成發(fā)絲級(jí)別的頭發(fā)模型,Jakob等人[34]設(shè)計(jì)了一個(gè)淺焦深的采集系統(tǒng),能夠重建發(fā)絲級(jí)別的頭發(fā)模型.淺焦深的采集系統(tǒng)能夠精確地區(qū)分發(fā)絲并消除遮擋作用.該方法在不同的角度下,通過(guò)推進(jìn)相機(jī),掃描并拍攝整個(gè)頭發(fā)模型.根據(jù)單根發(fā)絲上某點(diǎn)最清晰的照片位置和焦距來(lái)判斷該發(fā)絲在拍攝方向上的位置,由多個(gè)拍攝方向進(jìn)行三角化就可以得到該點(diǎn)在3D空間上的位置.該方法是少有的對(duì)應(yīng)到發(fā)絲級(jí)別的采集頭發(fā)建模的方法.該方法使用了多個(gè)如圖9所示的濾波器在圖像上判斷評(píng)價(jià)最高的方向,得到發(fā)絲方向,以使得發(fā)絲的結(jié)合和生長(zhǎng)更加可靠,這種估計(jì)方向的方法隨后被多次使用.但由于采集設(shè)備也相對(duì)復(fù)雜,該方法很難直接采集真人身上的頭發(fā).2012年Herrera等人[35]使用熱成像數(shù)據(jù)重建頭發(fā)模型,避免了使用RGB圖像建模時(shí)受光照、陰影等因素導(dǎo)致的頭發(fā)生長(zhǎng)方向無(wú)法分析的問(wèn)題.Beeler等人[36]使用多視點(diǎn)立體方法能夠同時(shí)重建稀疏的面部毛發(fā)和皮膚,但是由于發(fā)絲間的遮擋閉合等原因,他們的方法不能重建稠密的發(fā)型.

Fig. 9 Gabor filter in different angles to estimate orientation圖9 確定方向的Gabor濾波器

近年來(lái),基于圖像的頭發(fā)建模方法開(kāi)始向普通的多視點(diǎn)采集方式傾斜.Luo等人提出基于多視點(diǎn)[37]和寬基線[38]的頭發(fā)建模方法,利用多臺(tái)相機(jī)采集數(shù)據(jù),從頭發(fā)方向信息重建頭發(fā)外殼的幾何,結(jié)果如圖10和圖11所示.區(qū)別于傳統(tǒng)的基于顏色的幾何建模方法,該方法利用了在頭發(fā)照片中更具代表性的方向場(chǎng)來(lái)重建頭發(fā)外殼的幾何體.該方法獲取的頭發(fā)幾何具有較好的視覺(jué)效果,但該方法僅重建了頭發(fā)的表面幾何網(wǎng)格,并未重建出發(fā)絲級(jí)別的幾何形態(tài).

Fig. 10 Multi-view hair capture using orientation fields[37]圖10 基于多視點(diǎn)的頭發(fā)表面幾何重建[37]

Fig. 11 Surface construction of hairstyle using wide-baseline[38]圖11 基于寬基線的頭發(fā)表面幾何重建[38]

隨著計(jì)算機(jī)視覺(jué)技術(shù)在點(diǎn)云重建方法上的巨大發(fā)展,2013年Luo等人[39]提出了一種能重建發(fā)絲幾何的多視點(diǎn)的頭發(fā)采集重建方法,能夠得到結(jié)構(gòu)上具有連續(xù)性、發(fā)絲之間局部有序、更接近真實(shí)的頭發(fā)模型,如圖12所示.該方法并不直接從頭皮生長(zhǎng)發(fā)絲,而是利用點(diǎn)云和方向場(chǎng)逐漸在頭發(fā)表面聚類出代表局部頭發(fā)結(jié)構(gòu)的發(fā)束,最后再?gòu)陌l(fā)束重建完整的發(fā)絲.但該方法重建的結(jié)果不能保持頭發(fā)內(nèi)部特性,發(fā)根和發(fā)絲的分布與真實(shí)情況也相差較大.為了生成外部與采集照片近似,內(nèi)部發(fā)根和發(fā)絲的分布接近真實(shí)的頭發(fā)模型,2016年Bao等人[40]提出了一種基于混合方向場(chǎng)的靜態(tài)頭發(fā)建模方法,他們提出的混合方向場(chǎng)是由多個(gè)方向場(chǎng)組合而成,考慮了發(fā)型內(nèi)部頭發(fā)之間的分布和外部頭發(fā)的結(jié)構(gòu)細(xì)節(jié).其建模結(jié)果如圖13所示.同文獻(xiàn)[32,39]相比,該方法能夠生成相對(duì)真實(shí)的頭發(fā)模型.

Fig. 12 Structure-aware hair capture[39]圖12 基于結(jié)構(gòu)的頭發(fā)建模[39]

Fig. 13 Static hair modeling from a hybrid orientation field[40]圖13 基于混合方向場(chǎng)的靜態(tài)頭發(fā)建模[40]

2.2 基于數(shù)據(jù)驅(qū)動(dòng)的多幅圖像靜態(tài)頭發(fā)建模方法

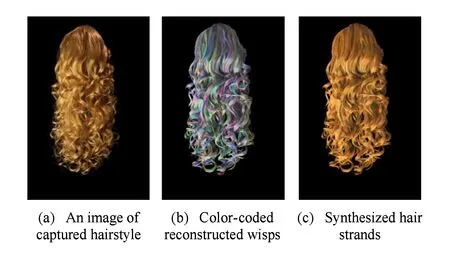

最近,基于數(shù)據(jù)驅(qū)動(dòng)的多幅圖像靜態(tài)頭發(fā)建模方法得到快速發(fā)展.2014年Hu等人[41]提出一種基于數(shù)據(jù)驅(qū)動(dòng)的頭發(fā)采集和重建方法,發(fā)束連接采用基于數(shù)據(jù)樣例匹配的方法,將重建過(guò)程中有用的發(fā)束信息自動(dòng)組織起來(lái),省去了采集圖像背景剔除等繁雜的數(shù)據(jù)預(yù)處理工作,實(shí)現(xiàn)了從采集數(shù)據(jù)到頭發(fā)3D幾何的自動(dòng)建模,所構(gòu)造模型的逼真度與文獻(xiàn)[39]相似,但在視覺(jué)上和模型結(jié)構(gòu)上并沒(méi)有質(zhì)的改變.Yu等人[42]提出了一種基于圖像和CAD操作的混合頭發(fā)重建方法,該方法能夠重建多種復(fù)雜的發(fā)型,但是重建的結(jié)果并不能逼近于真實(shí)的采集頭發(fā)圖像.Hu等人[43]提出了一種基于數(shù)據(jù)驅(qū)動(dòng)的可以自動(dòng)重建辮子發(fā)型的頭發(fā)建模方法,該方法使用深度相機(jī)采集發(fā)型數(shù)據(jù),并使用數(shù)據(jù)庫(kù)中的辮子塊來(lái)匹配數(shù)據(jù),生成結(jié)構(gòu)合理的辮子頭發(fā)模型,結(jié)果如圖14所示.與文獻(xiàn)[39]中方法類似,在建模過(guò)程中該方法也需要提前手動(dòng)將頭發(fā)幾何從采集圖像中分割出來(lái),并且該方法也只能重建辮子頭發(fā)發(fā)型.為了魯棒地重建頭發(fā)模型,2017年Zhang等人[44]提出了一種基于4個(gè)視點(diǎn)圖像的數(shù)據(jù)驅(qū)動(dòng)的頭發(fā)建模方法.該方法使用多源的頭發(fā)紋理合成算法,并不要求所有的輸入圖像必須來(lái)自相同的發(fā)型,能夠重建大部分的長(zhǎng)直發(fā)型,但不能重建發(fā)髻和辮子等受約束的發(fā)型.

Fig. 14 Capturing braided hairstyles[43]圖14 辮子發(fā)型頭發(fā)建模[43]

表2給出了基于方向場(chǎng)和基于數(shù)據(jù)驅(qū)動(dòng)的2種多幅圖像靜態(tài)頭發(fā)建模方法在所需照片數(shù)目、用戶控制程度、時(shí)間消耗和建模結(jié)果真實(shí)性等方面的比較,同時(shí)還給出了每種方法對(duì)應(yīng)的典型參考文獻(xiàn).從表2我們可以看出基于方向場(chǎng)的方法需要更多的輸入圖像,用戶控制程度相對(duì)較小,建模速度較慢,但建模結(jié)果更為真實(shí);而基于數(shù)據(jù)驅(qū)動(dòng)的方法需要較少的輸入圖像,用戶控制程度較大,建模速度較快,但建模質(zhì)量相對(duì)不夠真實(shí).

Table 2 Analysis of Two Types of Multiple-Images Based Static Hair Modeling Methods表2 基于多幅圖像的2類靜態(tài)頭發(fā)建模方法比較

3 基于視頻的動(dòng)態(tài)頭發(fā)建模方法

當(dāng)前基于多幅圖像的頭發(fā)建模研究主要集中于靜態(tài)頭發(fā)幾何建模,對(duì)動(dòng)態(tài)頭發(fā)建模方法涉及不多,動(dòng)態(tài)頭發(fā)建模結(jié)果還不夠理想.

2007年Ishikawa等人[45]首次提出基于采集數(shù)據(jù)的動(dòng)態(tài)頭發(fā)建模方法,利用采集數(shù)據(jù)構(gòu)造頭部和主頭發(fā)的運(yùn)動(dòng)矩陣,計(jì)算每一幀主頭發(fā)的位置,然后插值生成其余頭發(fā)的位置,但由于誤差累積等原因,導(dǎo)致很難準(zhǔn)確計(jì)算每一幀對(duì)應(yīng)的運(yùn)動(dòng)變化矩陣.Yamaguchi等人[46]使用時(shí)間平滑限制生成頭發(fā)序列,由于過(guò)度限制了頭發(fā)生長(zhǎng)方向,該方法僅適用于頭部固定、運(yùn)動(dòng)統(tǒng)一的直發(fā)型.

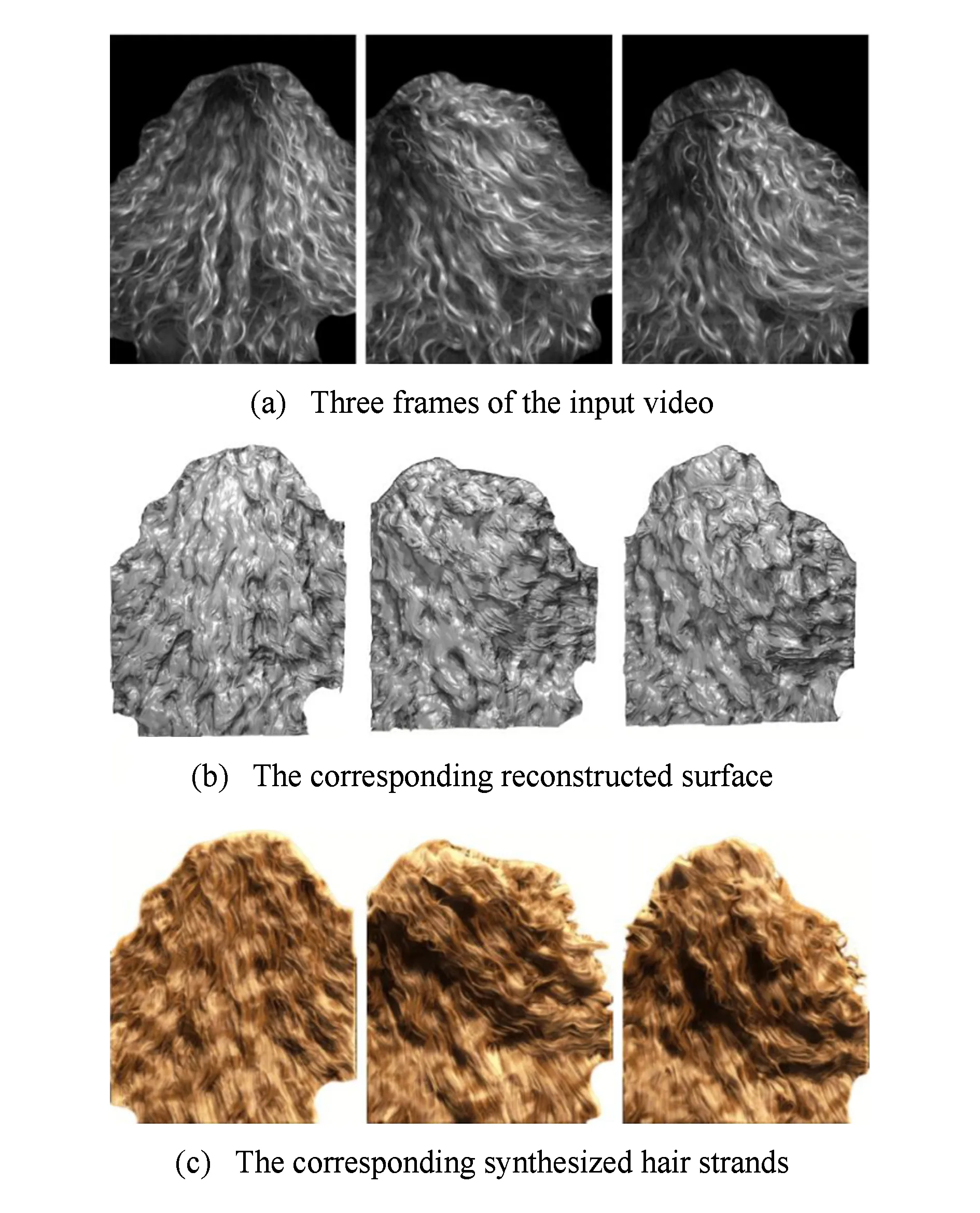

2011年Luo等人[47]根據(jù)采集到的頭發(fā)圖像序列,對(duì)每一幀頭發(fā)模型均按照靜態(tài)頭發(fā)建模方法生成相應(yīng)的3D頭發(fā)模型,隨后在時(shí)間域上對(duì)方向信息進(jìn)行優(yōu)化,重建出各幀對(duì)應(yīng)的表面幾何,最終在頭發(fā)表面生長(zhǎng)出發(fā)絲線段作為最終結(jié)果,如圖15所示.盡管這種方法在每一幀的頭發(fā)建模結(jié)果與采集圖像都近似,但由于其沒(méi)有考慮頭發(fā)在相鄰幀之間的對(duì)應(yīng)問(wèn)題,也沒(méi)有重建出從頭皮生長(zhǎng)的完整發(fā)絲,這一方法構(gòu)造的動(dòng)態(tài)頭發(fā)模型結(jié)果并不理想.

Fig. 15 Surface reconstruction of dynamic hair capture[47]圖15 動(dòng)態(tài)頭發(fā)表面重建結(jié)果[47]

Fig. 16 Dynamic hair modeling from single view[21]圖16 基于單視點(diǎn)的動(dòng)態(tài)頭發(fā)建模[21]

為了便于標(biāo)定和采集頭發(fā)數(shù)據(jù),F(xiàn)ukusato等人[48]提出了基于頭發(fā)束采集頭發(fā)運(yùn)動(dòng)的方法,該方法能夠重建發(fā)束級(jí)別的頭發(fā)運(yùn)動(dòng),但卻無(wú)法應(yīng)用于發(fā)絲級(jí)別的頭發(fā)模型.Chai等人[21]定義了由3D剛性變化矩陣和2D變形場(chǎng)構(gòu)成的頭發(fā)變化矩陣,基于單幅圖像生成了運(yùn)動(dòng)較真實(shí)的結(jié)果,頭發(fā)運(yùn)動(dòng)在單一視點(diǎn)投影下與采集數(shù)據(jù)接近,如圖16所示.由于誤差累積的影響,該方法只適用于局部相鄰幀之間變化較小且頭發(fā)運(yùn)動(dòng)幅度不能過(guò)大的情況.2012年Zhang等人[49]首先構(gòu)造各幀對(duì)應(yīng)的3D頭發(fā)模型,然后提出一種基于粒子的局部最優(yōu)化方案,從相鄰各幀的對(duì)應(yīng)關(guān)系中迭代生成主仿真頭發(fā)的速度場(chǎng),并利用此速度場(chǎng)對(duì)初始的頭發(fā)幾何進(jìn)行迭代優(yōu)化,實(shí)現(xiàn)了動(dòng)態(tài)頭發(fā)建模,圖17展示了其動(dòng)態(tài)建模過(guò)程的4幀結(jié)果.其結(jié)果得到了完整的頭發(fā)幾何,且各幀頭發(fā)的幾何形態(tài)連續(xù),頭發(fā)的運(yùn)動(dòng)較為自然.但該方法只適用于直發(fā),而且由于對(duì)頭發(fā)運(yùn)動(dòng)連續(xù)性的過(guò)度追求,其結(jié)果在各幀的幾何形態(tài)上與采集圖像差距較大.從圖17我們可以看到,各幀頭發(fā)幾何十分平滑,采集數(shù)據(jù)中頭發(fā)的幾何細(xì)節(jié)大部分丟失.

Fig. 17 Dynamic hair modeling by simulating guide hair[49]圖17 仿真主頭發(fā)的動(dòng)態(tài)頭發(fā)建模結(jié)果[49]

早期基于數(shù)據(jù)采集的動(dòng)態(tài)頭發(fā)建模主要從時(shí)間域上保證相鄰幀之間的對(duì)應(yīng)和連貫,而沒(méi)有從空間域上考慮發(fā)絲間的對(duì)應(yīng)關(guān)系.2014年Xu等人[50]提出一種基于時(shí)空優(yōu)化的動(dòng)態(tài)頭發(fā)建模方法,從視頻中提取頭發(fā)運(yùn)動(dòng)路徑,在時(shí)間域和空間域上分別優(yōu)化,利用多視點(diǎn)的運(yùn)動(dòng)路徑和靜態(tài)頭發(fā)建模信息重建動(dòng)態(tài)頭發(fā)模型,結(jié)果如圖18所示.該方法首次較為全面地構(gòu)造了動(dòng)態(tài)頭發(fā)模型,得到了時(shí)間和空間上信息保留較為完整的建模結(jié)果,但是局限于直發(fā)或接近直發(fā)的發(fā)型,未能解決頭發(fā)與物體交互時(shí)出現(xiàn)的穿透問(wèn)題,也不能處理比較復(fù)雜的頭發(fā)運(yùn)動(dòng).2017年Hu等人[51]首次提出了重建動(dòng)態(tài)頭發(fā)模型并估計(jì)運(yùn)動(dòng)發(fā)型的物理參數(shù).但他們的方法計(jì)算所需時(shí)間過(guò)長(zhǎng),并且重建和仿真的運(yùn)動(dòng)結(jié)果并不能與輸入數(shù)據(jù)很好地匹配.

Fig. 18 Dynamic hair capture using space-time optimization[50]圖18 基于時(shí)空優(yōu)化的動(dòng)態(tài)頭發(fā)建模[50]

基于數(shù)據(jù)采集的動(dòng)態(tài)頭發(fā)建模方法,通過(guò)分析真實(shí)的頭發(fā)運(yùn)動(dòng)形態(tài),構(gòu)造逼真的動(dòng)態(tài)頭發(fā)運(yùn)動(dòng)模型,研究人員已經(jīng)從時(shí)間連續(xù)性和空間模型相似性上進(jìn)行了上述大量的研究,但由于發(fā)絲之間的遮擋等原因,動(dòng)態(tài)頭發(fā)建模現(xiàn)在還只能處理相對(duì)簡(jiǎn)單的發(fā)型,無(wú)法精確構(gòu)造復(fù)雜發(fā)型的動(dòng)態(tài)頭發(fā)運(yùn)動(dòng)序列.

表3給出了基于多幅圖像的靜態(tài)頭發(fā)建模方法和基于視頻的動(dòng)態(tài)頭發(fā)建模方法在可建模發(fā)型、困難程度、時(shí)間消耗和建模結(jié)果真實(shí)性等方面的比較.從表3中我們可以看出,基于多幅圖像的靜態(tài)頭發(fā)建模方法可以重建各種發(fā)型,復(fù)雜程度也較低,所需時(shí)間較少并且建模結(jié)果相對(duì)真實(shí),但只能重建單幀靜態(tài)頭發(fā)模型;而基于視頻的動(dòng)態(tài)頭發(fā)建模方法能重建直發(fā)等簡(jiǎn)單的發(fā)型,重建的困難較大,建模所需時(shí)間較多,但動(dòng)態(tài)重建結(jié)果相對(duì)不夠真實(shí).這是因?yàn)閯?dòng)態(tài)頭發(fā)建模方法不僅需要重建每一幀的頭發(fā)模型,而且需要保證各幀頭發(fā)模型在時(shí)間域和空間域上的連貫性.

Table 3 Analysis of Multiple-Images Based Static Hair Modeling Methods and Video-Based Dynamic Hair Modeling Methods

4 頭發(fā)建模結(jié)果的編輯重用方法

根據(jù)編輯方式的不同,對(duì)頭發(fā)建模結(jié)果的編輯重用可以分為基于幾何的頭發(fā)模型編輯重用方法和基于物理仿真的頭發(fā)模型編輯重用方法.基于幾何的編輯方法通過(guò)編輯頭發(fā)模型的外觀生成新的發(fā)型,基于物理的方法則通過(guò)物理仿真的形式對(duì)頭發(fā)模型進(jìn)行編輯.

4.1 基于幾何的頭發(fā)模型編輯重用方法

基于草圖的方式編輯生成發(fā)型是早期常用的頭發(fā)模型編輯方法.Choe等人[52]使用靜態(tài)發(fā)束模型和偽物理的方法交互構(gòu)建頭發(fā)模型.該方法能夠編輯生成發(fā)髻、編織辮子及凌亂的發(fā)型等,但他們的方法不能處理發(fā)束太過(guò)稠密的發(fā)型.Malik等人[53]使用草圖界面構(gòu)建和編輯頭發(fā)模型,用戶使用壓力敏感板即可模擬現(xiàn)實(shí)世界中的剪發(fā)、梳發(fā)、燙發(fā)等各類操作,也可以進(jìn)行頭發(fā)種植、發(fā)型移植等,結(jié)果如圖19所示.從編輯結(jié)果可以看出,該方法生成的編輯結(jié)果相對(duì)不夠真實(shí).

Fig. 19 Sketching interface for modeling and editing hairstyle[53]圖19 基于草圖界面的發(fā)型編輯建模[53]

隨后一些研究人員開(kāi)始從用戶輸入中提取頭發(fā)生長(zhǎng)相關(guān)信息,先構(gòu)建頭發(fā)物理模型或方向場(chǎng),再編輯生成最終頭發(fā)模型.2007年Wither等人[54]使用草圖和物理模型編輯生成頭發(fā)模型,他們的方法從用戶輸入的草圖中提取頭發(fā)物理模型的相關(guān)參數(shù),再基于物理模型生成對(duì)應(yīng)發(fā)型.該方法能夠生成相對(duì)復(fù)雜的發(fā)型,但編輯結(jié)果仍不夠逼真.Fu等人[55]提出了基于草圖界面的交互發(fā)型設(shè)計(jì)方法,結(jié)果如圖20所示.該方法從輸入草圖構(gòu)建頭發(fā)生長(zhǎng)方向場(chǎng),能夠快速構(gòu)建相對(duì)真實(shí)的方向場(chǎng),但該方法只能編輯生成直發(fā)等相對(duì)簡(jiǎn)單的發(fā)型.

Fig. 20 Editing orientation hairstyle by sketching[55]圖20 基于草圖的方向場(chǎng)發(fā)型編輯[55]

直接通過(guò)手工或從圖片中重建3D頭發(fā)模型都是相對(duì)復(fù)雜的過(guò)程.為了從已有發(fā)型中快速生成新的發(fā)型,2009年Wang等人[56]提出了一種基于樣例的頭發(fā)幾何合成方法,使用分層的頭發(fā)合成框架交互地編輯頭發(fā)幾何模型,從粗糙層頭發(fā)模型映射合成新的發(fā)型.如圖21(a)(b)可以編輯合成圖21(c)所示的結(jié)果.該方法能夠?qū)崿F(xiàn)特征保留的梳頭發(fā)以及不同發(fā)型間的細(xì)節(jié)轉(zhuǎn)移,但不適用于披散的長(zhǎng)發(fā)型.Bonneel等人[57]開(kāi)發(fā)了一種頭發(fā)外觀估計(jì)方法,能夠從一張照片中恢復(fù)出一個(gè)近似的3D頭發(fā)模型.他們的照片利用一個(gè)閃光燈和一個(gè)灰度卡在室內(nèi)拍攝,能夠生成一個(gè)與輸入照片在視覺(jué)上相似的發(fā)型結(jié)果,通過(guò)編輯可達(dá)到理想的建模效果.然而,由于在輸入照片上的限制,他們的方法無(wú)法對(duì)一般的日常人物照片進(jìn)行計(jì)算.Chai等人[20]基于單視點(diǎn)照片構(gòu)造頭發(fā)模型,可以替換不同發(fā)型.他們的方法可以實(shí)現(xiàn)在圖像空間編輯頭發(fā)模型,但視角范圍不能太大.隨著頭發(fā)插值技術(shù)的發(fā)展,2013年Weng等人[58]提出了一種頭發(fā)插值肖像操作方法,編輯結(jié)果如圖22所示.該方法使用多尺度聚類的方法,有效計(jì)算2個(gè)或多個(gè)頭發(fā)模型之間多對(duì)多的對(duì)應(yīng)關(guān)系,并根據(jù)給定的2個(gè)3D頭發(fā)模型產(chǎn)生一系列的頭發(fā)幾何模型.該方法能夠生成逼真的建模結(jié)果,但不符合物理規(guī)律.

Fig. 22 Hair interpolation for portrait morphing[58]圖22 頭發(fā)插值肖像編輯[58]

4.2 基于物理仿真的頭發(fā)模型編輯重用方法

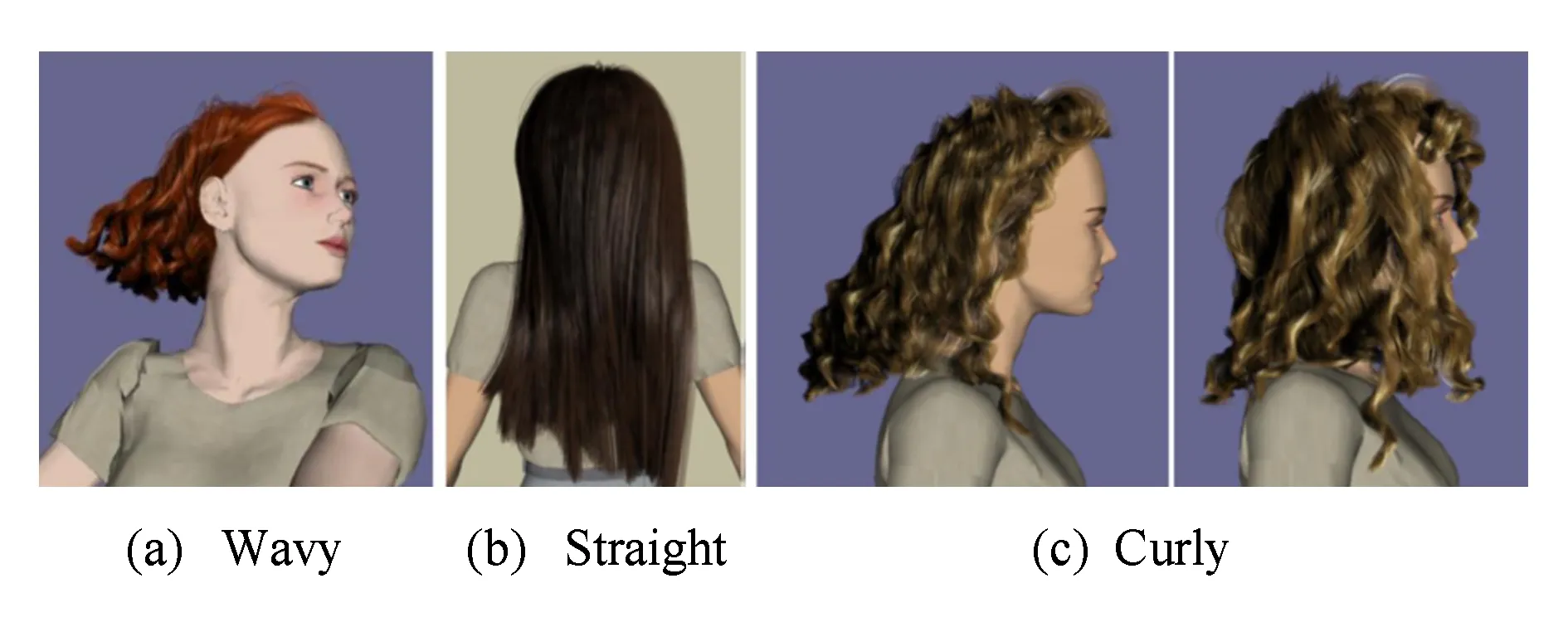

基于物理的編輯方法根據(jù)頭發(fā)物理模型實(shí)現(xiàn)編輯.傳統(tǒng)的頭發(fā)運(yùn)動(dòng)模型是根據(jù)物理模型構(gòu)造的.1991年Rosenblum等人[59]使用質(zhì)點(diǎn)彈簧模型構(gòu)造頭發(fā)運(yùn)動(dòng)模型,實(shí)現(xiàn)頭發(fā)運(yùn)動(dòng)仿真.Baraff等人[60]提出了隱式積分方法,有效求解硬彈簧模型,保證在較大的時(shí)間步長(zhǎng)仍然保持解的穩(wěn)定性.Plante等人[61-62]使用了一個(gè)約束的質(zhì)點(diǎn)彈簧模型來(lái)進(jìn)行仿真.這一工作利用不可分散的成體積的發(fā)束來(lái)表示頭發(fā).該方法中,每一束頭發(fā)都具有3層結(jié)構(gòu):第1層是由質(zhì)點(diǎn)彈簧模型描述的骨骼曲線,定義了大尺度的運(yùn)動(dòng);第2層是一個(gè)可變形的外殼,包裹了骨骼曲線,定義了發(fā)束的形變;第3層是數(shù)目預(yù)定的發(fā)絲,存在于外殼內(nèi)部,不參與仿真計(jì)算,初始造型時(shí)發(fā)絲在發(fā)束內(nèi)部隨機(jī)分布.為了提高仿真速度,2004年Ward等人[63]采取自適應(yīng)的層次結(jié)構(gòu)仿真頭發(fā)運(yùn)動(dòng),該方法放棄了單純的發(fā)束表示,具有層次性、模擬速度快等優(yōu)點(diǎn).Choe等人[17]提出了一種混合模型,保留了質(zhì)點(diǎn)彈簧模型和多剛體鏈模型的優(yōu)點(diǎn),隱式求解動(dòng)力學(xué)方程,魯棒地解決了頭發(fā)和身體間的碰撞問(wèn)題.2008年Selle等人[19]改進(jìn)了質(zhì)點(diǎn)彈簧模型,能夠約束頭發(fā)的扭率,該模型的參數(shù)設(shè)置簡(jiǎn)單,特別適合表示直發(fā)等簡(jiǎn)單發(fā)型,其建模結(jié)果如圖23所示.該成果近期得到了廣泛應(yīng)用[21,49,64].

Fig. 23 A mass-spring model for hair simulation editing[19]圖23 改進(jìn)的質(zhì)點(diǎn)彈簧頭發(fā)模型仿真編輯[19]

為了能夠處理卷發(fā)等更為復(fù)雜的發(fā)型,Bertails等人[18]引入一種新的頭發(fā)參數(shù)化方法,用處理靜態(tài)彈性桿的基爾霍夫模型,自動(dòng)生成頭發(fā)的幾何模型,包括自然頭發(fā)的波浪和發(fā)卷.2006年他們進(jìn)一步研究頭發(fā)運(yùn)動(dòng)模擬[65],將構(gòu)造單根頭發(fā)的物理模型稱作超級(jí)螺旋線模型,用拉格朗日力學(xué)原理仿真頭發(fā)運(yùn)動(dòng),如圖24所示.該方法生成的頭發(fā)運(yùn)動(dòng)序列能表現(xiàn)豐富的頭發(fā)運(yùn)動(dòng)細(xì)節(jié),但運(yùn)算時(shí)間相對(duì)較長(zhǎng).

Fig. 24 Super-helices model for predicting the dynamics of hair[65]圖24 超級(jí)螺旋線模型描述動(dòng)態(tài)頭發(fā)特性[65]

超級(jí)螺旋線模型能表示相對(duì)復(fù)雜的發(fā)型,如卷發(fā)等,近期廣泛應(yīng)用于動(dòng)態(tài)頭發(fā)動(dòng)態(tài)建模[41,66-69].2011年Daviet等人[68]在超級(jí)螺旋線模型基礎(chǔ)上建立優(yōu)化方法,實(shí)現(xiàn)了頭發(fā)之間碰撞摩擦的有效建模,進(jìn)一步提高了頭發(fā)動(dòng)態(tài)仿真的逼真度,但需要求解大量物理參數(shù),無(wú)法實(shí)時(shí).2013年Derouet-Jourdan等人[70]利用超級(jí)螺旋線模型實(shí)現(xiàn)了頭發(fā)之間的碰撞、摩擦,進(jìn)一步提高了頭發(fā)動(dòng)態(tài)模擬的逼真度.該方法先將手工設(shè)計(jì)或采集生成的頭發(fā)模型轉(zhuǎn)換為動(dòng)態(tài)頭發(fā)物理模型,再對(duì)模型施加庫(kù)倫摩擦力并進(jìn)行受力分析,反求物理模型在初始靜止?fàn)顟B(tài)時(shí)的物理參數(shù),生成頭發(fā)運(yùn)動(dòng)序列.該方法在實(shí)施過(guò)程中需要求解大量的物理參數(shù),難以實(shí)時(shí).Ward等人[63,71-72]通過(guò)改變頭發(fā)模型的物理屬性實(shí)現(xiàn)頭發(fā)的加濕、風(fēng)吹、修剪、燙卷等功能.2009年Yuksel等人[73]從頭發(fā)網(wǎng)格構(gòu)建頭發(fā)模型,使得頭發(fā)建模類似于多邊形曲面建模.該方法可以直接控制頭發(fā)模型的整體形態(tài),再經(jīng)樣式操作編輯后得到發(fā)絲細(xì)節(jié).2013年Derouet-Jourdan等人[74]用浮點(diǎn)切線算法將頭發(fā)幾何模型轉(zhuǎn)換為超級(jí)螺旋線模型,解決了仿真運(yùn)動(dòng)開(kāi)始時(shí)頭發(fā)靜止形狀下垂的問(wèn)題.

當(dāng)前,動(dòng)態(tài)頭發(fā)交互仿真技術(shù)得到了進(jìn)一步發(fā)展.Aras等人[75]提出一種基于草圖的動(dòng)態(tài)頭發(fā)建模仿真方法,通過(guò)使用物理屬性和關(guān)鍵幀技術(shù)實(shí)現(xiàn)實(shí)時(shí)動(dòng)態(tài)頭發(fā)仿真.但該方法不能處理發(fā)絲分布稠密的頭發(fā)模型.2014年Chai等人[64]提出一種基于數(shù)據(jù)驅(qū)動(dòng)的實(shí)時(shí)頭發(fā)交互仿真方法,其結(jié)果如圖25所示.該方法從訓(xùn)練中得到驅(qū)動(dòng)運(yùn)動(dòng)信息,用簡(jiǎn)化的主頭發(fā)仿真整個(gè)頭發(fā)交互過(guò)程,并提出基于主頭發(fā)上的粒子插值生成其余頭發(fā)的方法,得到了較好的效果,算法在性能和時(shí)間都有較大改進(jìn).2016年Wu等人[76]使用頭發(fā)網(wǎng)格實(shí)時(shí)仿真頭發(fā)運(yùn)動(dòng).通過(guò)體積力模型和變形最小化方法恰當(dāng)?shù)靥幚砼鲎矄?wèn)題,但他們的方法要求發(fā)絲束在運(yùn)動(dòng)中不能被分開(kāi).Chai等人[77]針對(duì)頭發(fā)和固體之間的交互仿真提出了一種自適應(yīng)的頭發(fā)蒙皮算法,計(jì)算符合條件的主頭發(fā)集合以及基于發(fā)絲的頭發(fā)蒙皮模型間的對(duì)應(yīng)插值關(guān)系.該方法通過(guò)仿真主頭發(fā)和固體之間的碰撞交互即可實(shí)時(shí)求得整個(gè)發(fā)型的仿真運(yùn)動(dòng)形態(tài).除了仿真頭發(fā)和固體之間的交互碰撞,2017年Fei等人[78]提出了一種新穎的多組件仿真框架用于仿真流體和頭發(fā)之間的交互,得到了理想的效果,結(jié)果如圖26所示.為了從靜態(tài)頭發(fā)建模結(jié)果中生成動(dòng)態(tài)頭發(fā)運(yùn)動(dòng)序列,近期Bao等人[79-80]提出了一種自適應(yīng)的浮動(dòng)切線匹配算法,可以將頭發(fā)幾何模型轉(zhuǎn)換為基于物理的頭發(fā)模型,經(jīng)仿真得到動(dòng)態(tài)頭發(fā)運(yùn)動(dòng)序列.

Fig. 25 A reduced model for interactive hair[64]圖25 精簡(jiǎn)頭發(fā)模型的交互仿真編輯[64]

Fig. 26 Multi-scale model for simulating liquid-hair interaction[78]圖26 多尺度模型的流體頭發(fā)交互仿真[78]

基于物理的頭發(fā)模型編輯重用方法,通過(guò)求解復(fù)雜的物理方程實(shí)現(xiàn)頭發(fā)的動(dòng)態(tài)編輯建模,通過(guò)對(duì)邊界條件的控制實(shí)現(xiàn)對(duì)建模結(jié)果的控制,編輯建模過(guò)程不夠直觀,難以直接獲取與真實(shí)發(fā)型對(duì)應(yīng)的頭發(fā)運(yùn)動(dòng)結(jié)果.

5 總結(jié)與展望

如第1~4節(jié)所述,頭發(fā)建模技術(shù)在計(jì)算機(jī)圖形學(xué)和虛擬現(xiàn)實(shí)領(lǐng)域展現(xiàn)出巨大潛力,得到國(guó)內(nèi)外研究人員廣泛的關(guān)注.本文論述了近年來(lái)基于圖像的頭發(fā)建模以及頭發(fā)模型編輯重用等方面的一些研究成果.基于圖像的建模方法主要用于解決發(fā)型重建的問(wèn)題,相關(guān)方法側(cè)重于得到與實(shí)際照片近似的頭發(fā)模型.頭發(fā)模型編輯重用方法則以現(xiàn)有發(fā)型為基礎(chǔ),編輯生成新的頭發(fā)模型,以物理模型為基礎(chǔ)生成動(dòng)態(tài)頭發(fā)運(yùn)動(dòng)序列.這些研究成果在游戲、影視、廣告化妝等領(lǐng)域得到了一定的應(yīng)用.但隨著應(yīng)用需求的不斷提高,現(xiàn)有的技術(shù)逐漸變得不能滿足需求,未來(lái)研究的發(fā)展趨勢(shì)可能有4個(gè)方面:

1) 發(fā)絲級(jí)別的頭發(fā)幾何重建.目前,大多數(shù)基于圖像的頭發(fā)建模方法構(gòu)造的模型在視覺(jué)上都沒(méi)有達(dá)到與采集圖像數(shù)據(jù)在發(fā)絲級(jí)別一致,重建結(jié)果只是在整體形態(tài)和特征上逼近采集數(shù)據(jù),個(gè)別發(fā)絲級(jí)別的頭發(fā)重建方法依賴于復(fù)雜精密的采集設(shè)備.因此,如何在多視點(diǎn)圖像采集的條件下實(shí)現(xiàn)更為逼真的頭發(fā)建模,使重建結(jié)果的外表發(fā)絲與采集圖像基本對(duì)應(yīng),是未來(lái)頭發(fā)建模需解決的主要問(wèn)題之一.

2) 發(fā)絲生長(zhǎng)和分布逼真的頭發(fā)建模.真實(shí)頭發(fā)一般具有3個(gè)特點(diǎn):①發(fā)根在頭皮上均勻分布;②頭發(fā)內(nèi)部的發(fā)絲生長(zhǎng)方向連續(xù),距離接近的發(fā)絲其生長(zhǎng)方向趨于一致,發(fā)絲的曲率過(guò)渡平滑;③頭發(fā)在其占據(jù)空間內(nèi)是密集的,發(fā)絲充滿從頭皮到頭發(fā)表面的所有區(qū)域.目前靜態(tài)建模方法最好的結(jié)果只是外表與采集圖像近似,但發(fā)絲分布并不準(zhǔn)確.未來(lái)需要研究頭發(fā)重建方法,在保證外表頭發(fā)足夠真實(shí)的前提下,使發(fā)絲的生長(zhǎng)和分布更加真實(shí)可靠.

3) 單幅圖像頭發(fā)建模方法.由于信息大量缺失,目前大多數(shù)基于單幅圖像頭發(fā)建模方法只能生成2.5D的深度映射頭發(fā)模型,少數(shù)基于頭發(fā)模型數(shù)據(jù)庫(kù)查找的方法生成的頭發(fā)模型缺乏真實(shí)性.未來(lái)需要研究頭發(fā)模型查找與融合方法,生成真3D的頭發(fā)模型,并保證建模結(jié)果與頭發(fā)圖像基本相似.

4) 頭發(fā)模型編輯重用.當(dāng)獲取頭發(fā)模型之后,如何對(duì)模型數(shù)據(jù)加以編輯重用,現(xiàn)階段研究人員還沒(méi)有想到太多的方法.對(duì)靜態(tài)頭發(fā)建模結(jié)果,絕大部分的研究人員還停留在僅對(duì)建模結(jié)果與采集發(fā)型外觀上的比較.而形態(tài)上編輯或者運(yùn)動(dòng)模擬的方法還比較少.僅有少數(shù)工作嘗試在模型變換和仿真方面進(jìn)行編輯或者重用生成新的數(shù)據(jù).如何將幾何信息表示的靜態(tài)頭發(fā)模型數(shù)據(jù)轉(zhuǎn)換為基于物理的頭發(fā)模型表示是當(dāng)前研究的難點(diǎn)問(wèn)題,研究自適應(yīng)的浮點(diǎn)切線算法、構(gòu)造頭發(fā)物理模型、使頭發(fā)模型的運(yùn)動(dòng)符合物理真實(shí),這些都是未來(lái)需要解決的關(guān)鍵問(wèn)題.此外,如何研究基于頭發(fā)幾何特征的編輯方法、實(shí)現(xiàn)發(fā)型間的對(duì)應(yīng)轉(zhuǎn)換、生成連續(xù)的頭發(fā)模型轉(zhuǎn)化結(jié)果、研究動(dòng)態(tài)頭發(fā)模型時(shí)間編輯和運(yùn)動(dòng)重用方法,這些也是未來(lái)需要解決的科學(xué)問(wèn)題.