基于卷積神經網絡的架空鐵塔護坡提取*

陳城,史芙蓉,許海源,林華盛,江萬壽

?

基于卷積神經網絡的架空鐵塔護坡提取*

陳城1,史芙蓉2,許海源1,林華盛1,江萬壽2

(1.深圳供電局有限公司,廣東 深圳 518000;2.武漢大學測繪遙感信息工程國家重點實驗室,湖北 武漢 430079)

以深圳電力線巡線時所獲得的高分辨率航空影像為例,提出了基于集成卷積神經網絡的架空鐵塔護坡自動提取方法。該方法首先通過Faster R-CNN目標檢測網絡在多幅航空影像中框取護坡目標,然后通過SegNet語義分割網絡進一步分割目標框中的護坡與背景,獲取精確的護坡掩膜信息。與直接應用SegNet模型的“一步式”護坡提取方法相比,“先定位后分割”的方法在2個實驗數據上的虛警率下降超過38.1%;與基于Mask R-CNN卷積神經網絡提取方法相比,該方法在2個數據上的正確率均高于98%,優于Mask R-CNN所達到的95.96%.

架空鐵塔護坡;卷積神經網絡;目標檢測;語義分割

護坡是為防止邊坡受沖刷,在坡面上建設的各種鋪砌和栽植的統稱,被廣泛應用于電力工程中,是電力設施數據庫的一類基本要素,在對輸電線路塔基邊坡狀態進行檢測防護、確保輸電線路安全運行的過程中發揮重要作用[1-2]。極端天氣、工程活動等因素會對護坡的穩定性造成影響,誘發邊坡災害,架空輸電塔基周圍的邊坡災害則危及輸電線路傳輸,傳統的護坡監測方法通過傳感器數據分析護坡狀態[3]。隨著遙感技術手段的發展,通過攝影測量技術手段,能夠恢復電力走廊的三維信息[4],從而對邊坡的面積、坡度和狀態進行探測,為輸電線路塔基邊坡監測提供了新思路,而基于航空影像的架空鐵塔護坡提取是護坡重建和監測的基礎。

遙感領域常用監督式的機器學習方法進行目標提取,葛廣英[5]將幀差法與支持向量機相結合,從視頻圖像序列中檢測和分割運動車輛;Mo G等[6]提出了一種基于SIFT特征和Boosting分類器的車輛檢測方法,來減弱背景差異對目標提取的影響。傳統的監督訓練方法通過多種特征的設計和組合描述對象的結構信息,對簡單場景能取得較好的效果,然而,特征的設計和選擇需要依賴于操作人員,且淺層特征難以準確表達目標的深層結構,難以處理復雜的多場景任務。深度學習突破傳統監督方法的局限,能自動學習不同層次的抽象特征,當前深度學習方法逐漸應用于基于圖像的船只、飛機等目標識別領域,并在多類場景下取得了較好的效果[7-8]。但是,基于航空影像的電力線、塔附近的邊坡提取,由于應用場景和提取目標特殊尚未受到廣泛關注,因此,本文提取出了集成卷積神經網絡的方法,先后建立護坡定位、分割模型,實驗結果表明該方法能夠準確地提取出影像中的護坡,為護坡智能提取問題提供了一種行之有效的解決方案。

1 關鍵技術與流程

1.1 總體技術流程

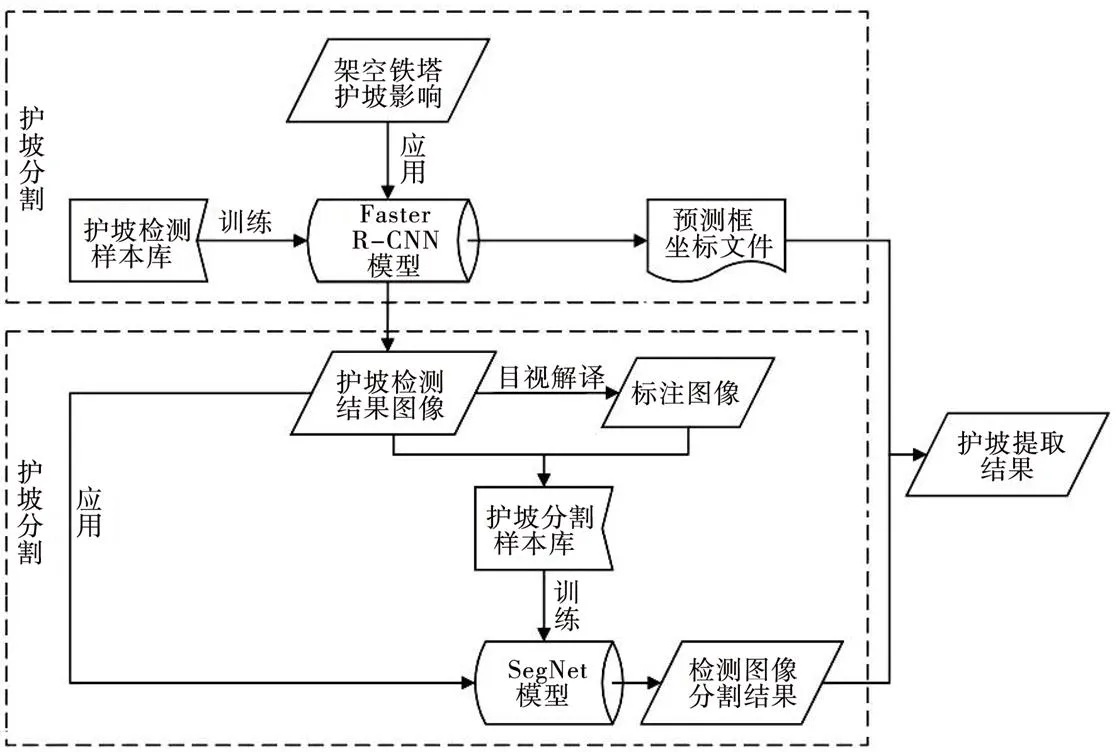

架空鐵塔護坡提取流程如圖1所示。

圖1 架空鐵塔護坡提取流程

本文的架空鐵塔護坡提取總體技術流程如圖1所示,主要包括模型訓練和模型應用兩部分,模型訓練包括護坡檢測模型訓練以及護坡分割模型訓練,模型應用時對航空影像先后加載訓練好的檢測模型和分割模型,精確地提取出架空鐵塔護坡這一目標。

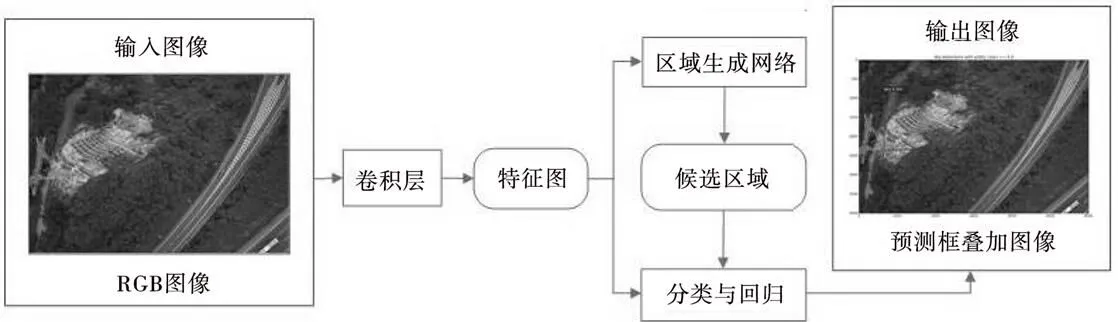

1.2 架空鐵塔護坡檢測模型

本文采用Faster R-CNN卷積網絡[9]訓練護坡檢測模型。Faster R-CNN處理過程如圖2所示,Faster R-CNN由區域生成網絡(Region Proposal Network,RPN)和Fast R-CNN[10]兩個子網絡構成,RPN根據訓練數據集產生可能包含目標的候選框,Fast R-CNN對候選框進行分類和回歸得到目標所在準確位置。

圖2 Faster R-CNN處理過程

1.2.1 特征提取

卷積神經網絡本質上是一種輸入到輸出的映射,能夠學習大量輸入與輸出之間的映射關系,采用局部權值共享的特殊結構降低了網絡的訓練參數,使其布局更接近于實際的生物神經網絡,在圖像處理方面有著獨特的優越性。

本文的Faster R-CNN采用VGG16網絡提取特征,相比于LeNet、AlexNet、ZFNet網絡,VGG16網絡層次更深,能獲取更好的特征。

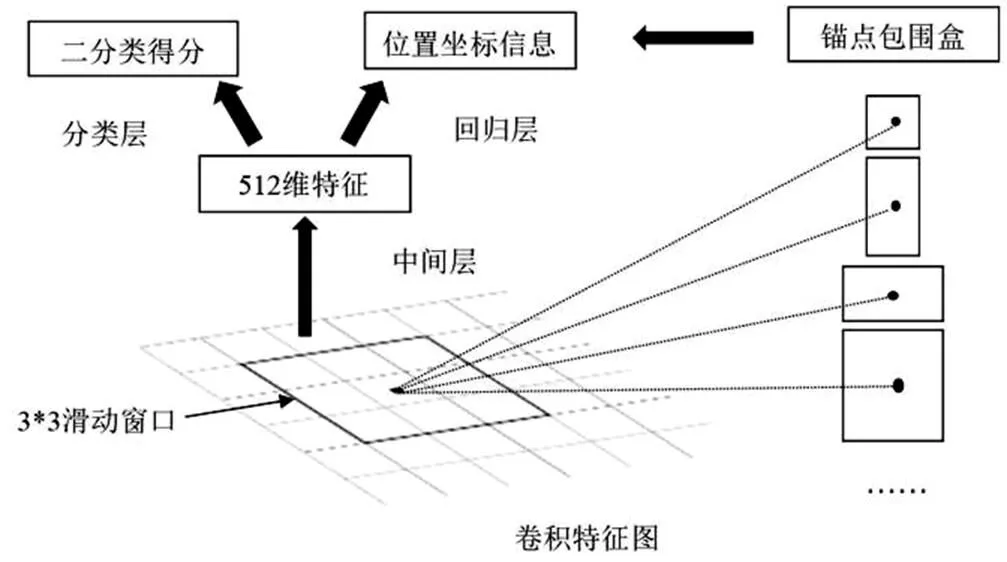

1.2.2 RNP

RNP網絡結構如圖3所示。

圖3 RNP網絡結構

用一個大小為3×3的卷積核作為滑動窗口在特征圖上進行卷積,每個滑動窗口的中心對應9個錨點,每個錨點對應不同的尺度和長寬比,即在每個位置都會預測9個候選框;將卷積后得到的512維特征向量輸入2個全連接層,得到每個候選框的類別(目標或背景)和位置信息,保留與真實目標框重疊度大于0.7(正樣本)和小于0.3(負樣本)的候選框,并用非極大值抑制法將候選框的數量控制在300個。

1.2.3 Fast R-CNN

在RNP階段,產生沒有類別信息的候選框,通過Fast R-CNN中的ROI池化層為每個候選框提取特征,即用每個候選框裁剪卷積特征映射,然后用雙線性插值將裁剪后的映射調整14×14的固定大小,并用最大池得到最終7×7的特征映射;Fast R-CNN最后用全連接輸出每個對象可能的類別的分數,賦予候選框類別信息。

1.2.4 模型訓練

Faster R-CNN包括了RNP和Fast R-CNN兩個網絡,通過共享卷積層減少網絡參數,采用了交替訓練的方式,訓練步驟如下:①利用在ImageNet目標分類數據庫上進行訓練得到的模型初始化RPN參數,在架空鐵塔護坡訓練數據集上獨立訓練RPN,訓練80 000次。②同樣用ImageNet模型初始化Fast R-CNN參數,利用上述得到的候選框作為輸入訓練Fast R-CNN,訓練40 000次。③用上述步驟得到的參數初始化RPN的網絡,把RPN與Fast R-CNN共享的卷積層的學習率設為0,僅更新RPN特有的網絡層,重新訓練,訓練80 000次。④用上述步驟得到的參數初始化Fast R-CNN的網絡,不改變共享層,微調其全連接層,訓練40 000次,建立Faster R-CNN模型。

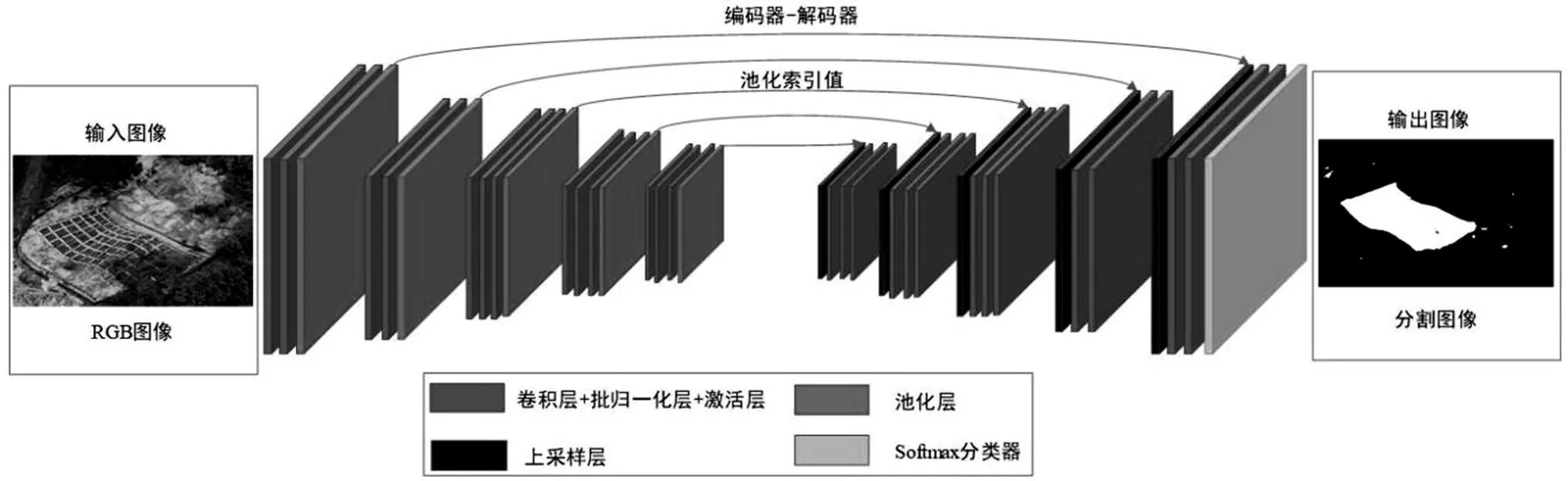

1.3 架空鐵塔護坡語義分割模型

SegNet網絡是一種具有編解碼結構的圖像語義分割深度卷積神經網絡[11],SegNet的總體結構如圖4所示,它擁有一個編碼網絡和與之對應的解碼網絡,將最后一個解碼器的輸出送入像素分類器中,每個像素產生類概率得到分割結果圖。

圖4 SegNet網絡結構

1.3.1 編碼器

SegNet的編碼器包括卷積層、批歸一化層、激活層以及池化層,每組編碼器產生一組特征圖及對應最大池化層的索引值。

1.3.2 解碼器

在解碼器中,根據保存的索引值信息,對輸入的特征圖進行采樣,得到稀疏的特征圖,然后用一組可訓練的解碼濾波器組對這些稀疏的特征圖進行卷積操作,從而得到稠密的特征圖;最后一層解碼器輸出一組與輸入圖像相同維度的特征圖,這些特征圖最終被送進一個為像素點分類而設計的Softmax分類器中,Softmax分類器輸出具有個通道,并輸入圖像尺寸相同的概率圖,值為類別個數,概率值最大的類別即為該像素點的類別,從而實現像素級別的語義分割。

1.3.3 模型訓練

利用在ImageNet模型初始化SegNet中編碼器及解碼器網絡參數,采用隨機梯度下降的參數訓練策略,學習率固定為0.001,卷積核大小為7×7,迭代次數設置40 000次。根據Faster R-CNN模型檢測出的架空鐵塔護坡圖像,制作語義分割樣本庫,語義分割樣本庫由裁剪后的檢測圖像及其對應的標注圖像組成,標注結果為二值化灰度圖像,0為背景,1為護坡。由于檢測圖像較大,為了解決顯卡顯存不足的問題,需要將其及對應的灰度圖像裁剪,將該樣本庫輸入SegNet網絡,建立護坡語義分割模型。

2 實驗結果及分析

2.1 實驗準備

本文實驗在Ubuntu下用GPU進行加速計算,Faster R-CNN和SegNet在Caffe這一主流深度學習框架下運行。實驗中的實驗數據通過無人機低空遙感技術獲取,包括不同光照、不同拍攝角度、不同背景等情況下的護坡無人機高分辨遙感影像,影像地面采樣距離約為0.5 m,影像大小為6 000×4 000或者4 000×6 000,影像中的護坡與架空鐵塔相鄰,周圍地區主要被植被、道路、裸土、田地等覆蓋。

2.2 護坡定位與分割

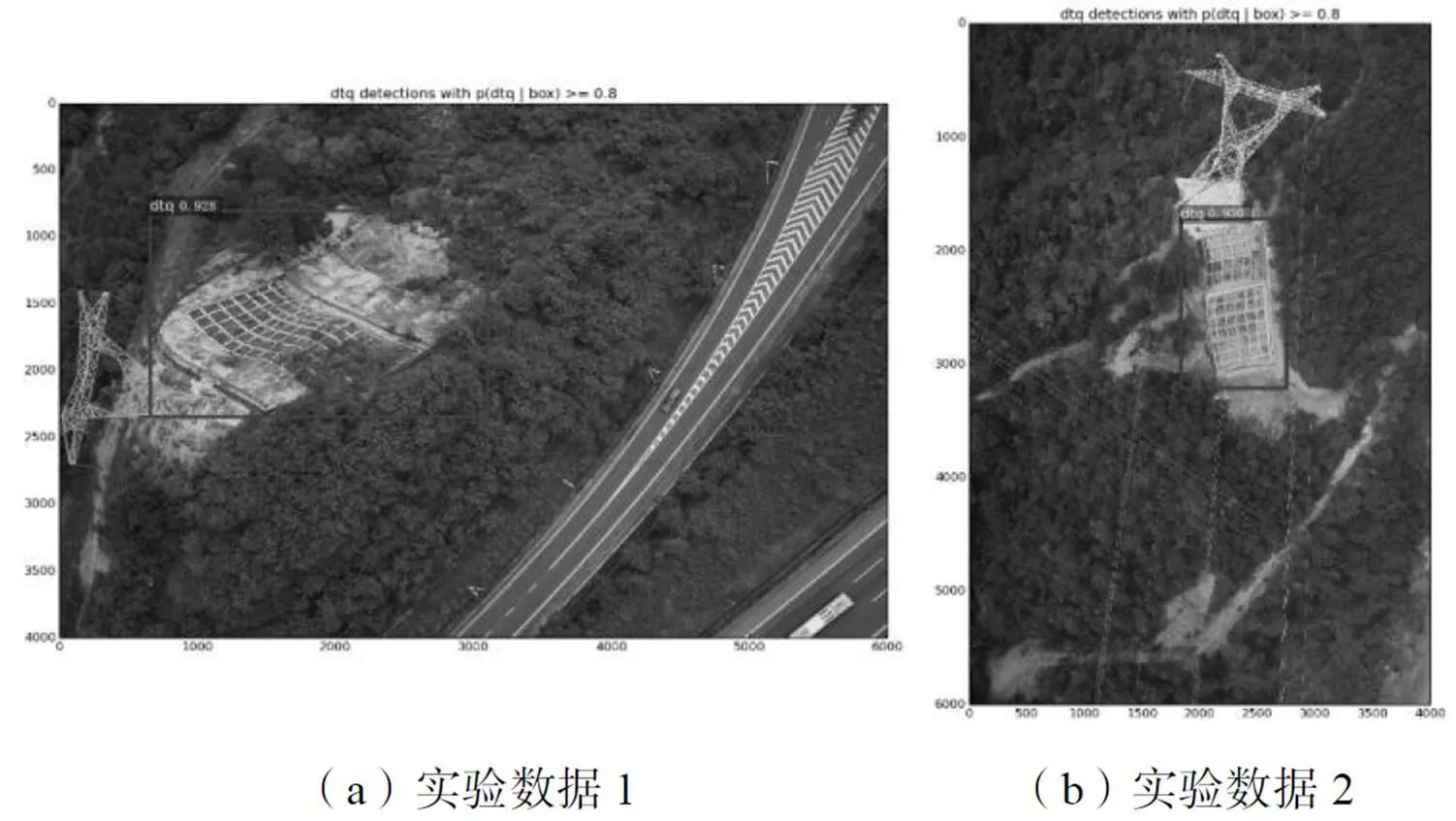

用已完成訓練的Faster R-CNN模型檢測護坡,確定護坡位置,將候選區域集滿足以下2個條件的區域確定為護坡:①分類概率大于0.8;②該區域分類概率比所有有重疊部分取得的分類概率都高,即該區域分類概率是一個局部最大值。護坡檢測結果如圖5所示,黑色框為護坡的檢測框,可以看出該檢測框完整包含了護坡,且大大降低了背景的干擾。

圖5 護坡定位結果

完成檢測后,根據檢測框得到檢測影像,用已完成訓練的SegNet模型對該影像進行分割,并根據檢測框坐標將分割影像定位至原圖像中,分割結果的掩模結果如圖6所示。

圖6 護坡分割掩模結果

2.3 實驗對比與分析

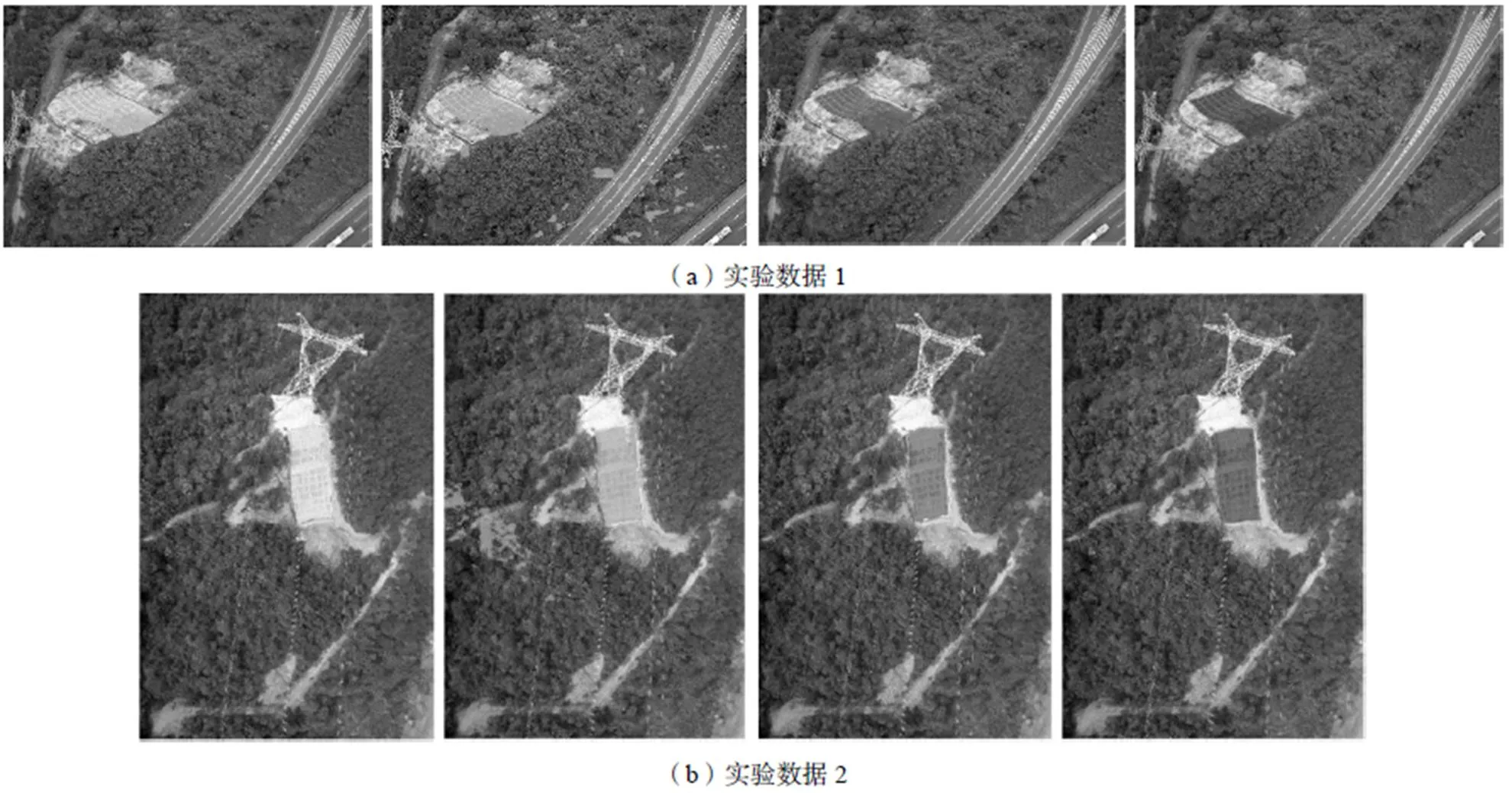

本文與SegNet網絡直接對原始影像分割的方法進行對比,驗證了“先定位后分割”的優越性,并與文獻[12]中的Mask R-CNN方法進行實驗對比,Mask R-CNN方法與本文方法相似之處在于都遵循“先定位后分割”的思路,不同之處在于本文方法采用串聯的卷積神經網絡訓練方法,檢測模型在原始圖像提取的特征上訓練,分割模型在檢測圖像提取的特征上訓練,而Mask R-CNN采用并行的卷積網絡訓練方法,檢測模型和分割模型同時在原始圖像提取的特征進行訓練。護坡提取結果對比如圖7所示。

實驗結果的評價分為定性評價和定量評價。為了度量護坡提取精度,本文采用基于像素數量誤差的定量精度評價方法,將正確率d和虛警率f作為評價標準,定量評價指標計算公式如下[13]:

式(1)(2)中:t為提取的理想護坡像素總數;C為采用深度卷積神經網絡方法被正確提取的護坡像素數量;f為采用深度卷積神經網絡方法被誤分為護坡的像素數量。評價結果如表1所示。

表1的統計數據表明,直接對原始影像進行分割的方法虛警率非常高,而本文提出的方法明顯降低了虛警率,且正確率和虛警率均優于Mask R-CNN的方法,平均正確率比Mask R-CNN的高出3.00%,平均虛警率低了0.38%,說明該方法能更加準確地提取出護坡。

3 結束語

針對無人機影像護坡提取這一需求,本文利用卷積神經網絡能自動學習圖像本質特征的優勢,提出了基于Faster R-CNN+SegNet集成卷積網絡的架空鐵塔護坡提取方法,該方法遵循“先定位后分割”的路線。定位后的護坡圖像降低了護坡背景的復雜度,使護坡在圖像中占據主要地位,有利于進行后續護坡的提取工作。與Mask R-CNN相比,重新訓練定位后的圖像特征,能更加準確地對護坡本質進行表達。實驗表明采用本文提出的方法能準確地從復雜場景中提取出護坡,這為護坡以及其他本身具有一定規律特征而所在背景復雜多樣的地物(比如居民地)的提取提供了一個參照方法。

注:(a)(b)兩組圖中的第一幅圖都為人工標注提取結果,第二幅圖都為只用SegNet提取結果,第三幅圖都為Mask R-CNN提取結果,第四幅圖都為本文采取的Faster R-CNN+SegNet提取結果。

表1 精度對比

實驗數據方法正確率/(%)虛警率/(%) 數據1SegNet98.6659.34 Mask R-CNN95.812.10 Faster R-CNN+SegNet98.431.53 數據2SegNet99.1439.28 Mask R-CNN95.961.30 Faster R-CNN+SegNet99.341.10

[1]裴慧坤,周偉才,周榮林,等.架空鐵塔邊坡狀態監測技術的研究[J].中國新技術新產品,2013(24):37-38.

[2]曾川峰.山區高壓電力鐵塔基礎邊坡治理[J].低碳世界,2015(35):23-24.

[3]辛紅園. 爆破對鄰近高邊坡頂鐵塔的影響研究[D].重慶:重慶交通大學,2016.

[4]裴慧坤,姜三,林國安,等.依托無人機傾斜攝影的電力走廊三維重建[J].測繪科學,2016,41(12):292-296.

[5]葛廣英.基于SVM的車型檢測和識別算法[J].計算機工程,2007(06):6-8,11.

[6]Mo G,Zhang Y,Zhang S,et al. A Method of Vehicle Detection Based on SIFT Features and Boosting Classifier[J].Journal of Convergence Information Technology,2012,7(12):328-334.

[7]歐陽穎卉,林翬,李樹濤.基于卷積神經網絡的光學遙感圖像船只檢測[J].包裝工程,2016,37(15):1-6.

[8]戴陳卡,李毅.基于Faster RCNN以及多部件結合的機場場面靜態飛機檢測[J].計算機應用,2017,37(S2):85-88.

[9]Ren S,He K,Girshick R,et al.Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,39(06):1137-1149.

[10]Girshick,Ross.“Fast r-cnn.”[J].Proceedings of the IEEE International Conference on Computer Vision,2015.

[11]Badrinarayanan V,Handa A,Cipolla R.SegNet:A Deep Convolutional Encoder-Decoder Architecture for Robust Semantic Pixel-Wise Labelling[J].Computer Science,2015.

[12]He K,Gkioxari G,Dollár P,et al.Mask R-CNN[C]//IEEE International Conference on Computer Vision. IEEE,2017:2980-2988.

[13]曹建農,王平祿,董昱威.高分辨率遙感影像上居民地自動提取方法[J].武漢大學學報(信息科學版),2014,39(07):831-837.

〔編輯:張思楠〕

深圳供電局科技項目(編號:090000KK52160017)

2095-6835(2018)19-0038-04

TM753

A

10.15913/j.cnki.kjycx.2018.19.038

陳城(1989—),男,湖南湘潭人,工程師,主要從事架空輸電線路技術研究。