基于詞向量特征擴展的中文短文本分類研究

雷 朔 劉旭敏 徐維祥

1(首都師范大學信息工程學院 北京 100048)2(北京交通大學交通運輸學院 北京 100044)

0 引 言

隨著大數據時代的到來以及移動終端的廣泛應用,人們可以隨時隨地通過智能終端來獲取和發布信息。與此同時,數據結構也發生了數量上的改變,數據由傳統的結構化數據轉變成了非結構化數據,文本逐漸成為了互聯網信息交流和傳播的載體。隨著社交平臺的發展,例如微博、Twitter等,短文本數據也成為了文本數據的主要表現形式[1-2]。短文本數據通常是指文本長度在160字以內,文本長度較短,特征較為稀疏,未登錄詞較多,語句隨意,是噪聲較多的文本數據。由于這些短文本數據代表了大眾的觀點,對短文本數據的挖掘可以更多的獲知用戶的態度,行為趨勢等信息,也逐漸成為了國內外研究學者的熱點。但由于其特征較少,文字長度較短等缺點,不能夠將其當成普通的長文本數據進行相關的數據挖掘,所以有必要提出相應的算法來對短文本數據進行分類。

針對短文本特征稀疏的特點,YANG等[3]用引入外部文檔來進行特征的擴充,通過外部文檔的引入,將更多的特征信息加入到短文本中,達到特征擴展作用。Li等[4]提出了基于領域詞擴展,達到了不錯的效果。Fan[5]也提出了一種有效的基于外部文檔進行特征擴展的方法。范云杰等[6]提出了基于維基百科的中文短文本分類,利用維基百科的信息來擴充短文本,使得其類似于長文本,進而用長文本的分類方法進行分類,達到分類的效果。還有將百度百科作為微博特征擴展的方式,其原理和基于維基百科的原理類似。王東等[7]提出的基于同義詞詞林的特征擴展,還有基于知網,wordnet來進行文本特征擴展。但由于基于外部語料庫的特征擴展并不能很好地發現文檔內部語義特征,并且其對特定的語料數據集效果并不是很好,由于外部語料庫形式的不確定性,容易加入噪聲等信息。

在基于內部語義的短文本特征擴展中,張志飛等[8]提出的基于LDA主題模型,胡勇軍等[9]基于LDA高頻詞擴展的中文短文本分類研究,通過文檔詞頻的統計,概率模型的求解,得出主題詞分布,通過設定閾值,將主題詞概率大于該閾值的特征加入到短文本中,達到文本特征擴展的目的。Enríquez[10]提出了用詞向量進行意見文本方面的分類。江大鵬等[11]提出了加權連續詞袋模型,并結合LDA,提出了主題分布的詞向量生成算法,并將詞向量應用于短文本分類取得了較好的效果。Zhang等[12]將隱含主題和詞匯同時作為詞向量進行學習。但是基于內部語義的短文本特征擴展算法更多地依賴于數據本身,對于新型數據敏感性較差,容易出現過擬合現象。

本文算法不僅利用了外部語料庫豐富的上下文信息,同時將詞向量引入特征擴展,通過內部語義求取關鍵詞信息,很好地解決了上述特征擴展算法的不足。

1 文本表示和詞向量

1.1 詞袋模型

詞袋模型是最先提出的一種文本表示模型,也是能夠容易直觀理解的文本表示模型。詞袋模型將文章中的詞匯映射為一個一維向量,詞匯向量兩兩正交,并占據向量中的唯一維度。向量的長度則為語料集中單詞的總數。詞袋模型的優點是容易理解,使用方便。缺點是缺少語義相關信息,維度較大,尤其是在數據量較大的時候,向量的長度能夠達到萬維甚至十萬維,不易于建模。

1.2 向量空間模型

向量空間模型是基于統計規則的文本表示方法。與詞袋模型類似,向量空間模型同樣需要對詞頻信息做相應的統計,并計算每一個term中相應的權值,不同之處在于向量的維度可以根據需要自由設定,減少了相應的運算量。對于文本相似度的求解,向量空間模型表現出了很好的效果,但是對于詞匯相似度的求解,向量空間模型卻無能為力。

1.3 LDA主題模型

LDA主題模型是將文檔集通過訓練,表示成文檔主題分布和主題詞匯分布[13]。LDA主題模型是一種生成模型,首先是以一定的概率選擇主題文檔分布和主題詞匯分布,在生成文檔的過程中,從文檔主題分布中以一定概率選擇主題,得到主題,并根據主題從主題詞匯分布中以一定概率選擇詞匯,加入到文檔中,完成文本生成。但對于一個已經生成的文本來說,文檔主題分布可以作為一種文本表示形式,可以根據EM算法來推測其隱含主題的概率。LDA主題模型是一種無監督的訓練,在訓練中可以自定義主題的個數,模型可用于文本生成和文本表示。但是LDA在文本表示方面不能充分表達語義信息,對于文本長度敏感性較大,不適用于短文本文本表示。

1.4 詞向量

詞向量的概念首先由Hiton在1986年提出,開創了詞向量的先河[14]。詞向量是通過文本語料的訓練,將單詞映射為一個高維的向量表示,進而將單詞在高維空間中的距離來表示單詞之間的相似度。由于詞向量的維度可以自由設定,所以相比于詞袋模型和向量空間模型來說,能夠清晰地表示詞匯間的語義信息以及單詞之間的相似度信息。對于語句和文檔來說,通過在詞向量訓練時加入句子、段落、文章等信息,可以更進一步地獲取詞語、句子相關信息。基于句型、段落、文章等向量方法也隨之出現,比如代表語句的句向量(sentence2vec)和代表文章的文檔向量(doc2vec)。

本質上來說,詞向量只是語言模型的產物,是在求取自然語言模型的同時得到的詞向量。對于給定的語料和未知的句子來說,希望通過構建判別模型來對未知句子進行‘是否是自然語句’的判別。對于原始語料的數據集,可以得到目標函數為:

(1)

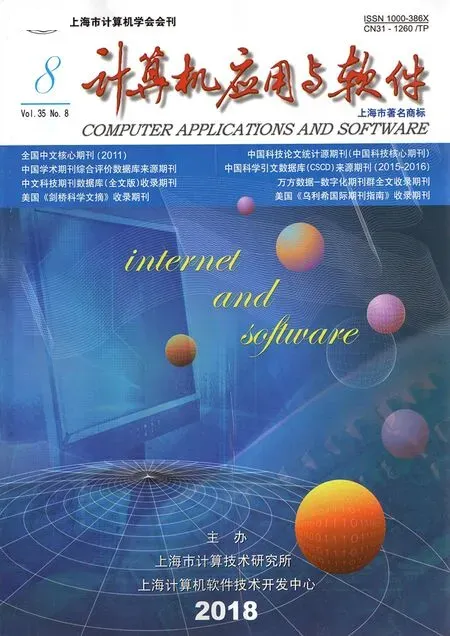

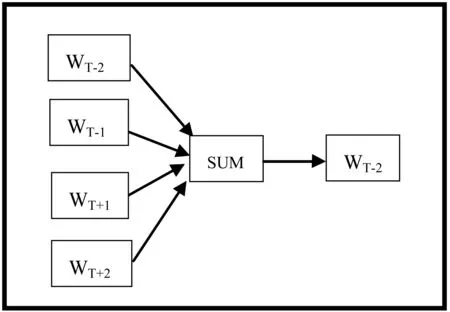

式中:n表示文檔的數量,m表示每篇文檔單詞的數量,p(wij|context_ij)表示在上下文信息為context_ij的情況下wij出現的概率,則對于是否是自然語言模型的判別,需要最大化上述目標函數,進而得到詞向量。有兩種模型可以獲得詞向量,一個是C-BOW模型,另一個是Skip-gram模型。如圖1和圖2所示。

圖1 CBOW模型

圖2 Skip-gram模型

圖1表示的是C-BOW模型,對于C-BOW模型來說,其輸入節點則是上下文詞集中的單詞,中間節點是求和節點,輸出節點是一棵二叉樹,其中葉子節點的個數則是文檔中的單詞集合個數。通過遍歷文檔得到優化的詞向量。其中,上下文詞集的數量可以由一個指定范圍的隨機數來確定,對于給定的上下文詞集,首先進行初始詞向量的加和,得到加和向量,進而通過由加和節點到該單詞的葉子節點的路徑來進行詞向量數值的優化。其中用于C-BOW的優化算法為SGD算法。

圖2表示的是Skip-gram模型的求解圖示,Skip-gram模型同樣是由三層網絡模型組成,但是Skip-gram的輸入節點是當前節點,不同于C-BOW模型,在中間節點中Skip-gram不做任何操作,輸出節點同樣是由文檔詞集單詞為葉子節點的二叉樹。不同于C-BOW的訓練,Skip-gram在每次訓練中需要優化由輸入節點到上下文每個單詞的詞向量信息,經過若干次迭代后得到詞向量。

2 基于詞向量的短文本分類過程

由于基于外部語料和內部語義進行特征擴展的算法各有優劣,所以本文結合兩者的優點。首先獲取維基百科外部語料集,對維基百科語料集進行詞向量的訓練,得到其詞向量表示。同時,通過TF-IDF算法來得到數據集的關鍵詞詞集信息。將每篇文檔中特征詞相似度最高的前k個單詞加入原文本,完成特征擴展。

2.1 框架分析

基于維基百科詞向量的特征擴展算法第一步是要進行維基百科詞向量的獲取,通過Word2vec模型對維基百科詞向量進行求取,得到維基百科詞向量。第二步利用TFIDF算法進行文本關鍵詞的求取。第三步通過算法將相應的特征加入到原短文本中,完成特征擴展。

2.2 維基百科詞向量的獲取

訓練維基百科詞向量,一般獲取方式有兩種。一種可以通過下載維基百科數據集進而通過對語料庫進行訓練進而獲取其詞向量,另一種可以直接通過已有的程序庫來直接獲取維基百科詞向量,本文通過后一種方法來直接獲取其詞向量[15]。

本文維基百科詞向量的獲取是通過C-BOW模型來獲得維基百科詞向量集。對于維基百科數據集的每一篇文檔的每一句話來說,首先進行分詞,對于分好詞的文檔來說,可以將文檔中每一個單詞以及其上下文單詞輸入到模型中進行求解。

由式(1)中的目標函數可以進行如下變換:

l(θ)= -log(L(θ))=

(2)

式中:

p(wij|context_ij)=p(wij|cij)=

dkijlog(1-σ(qkij×Cij))]

(3)

即通過變換將目標函數轉換為損失函數,其中,dkij表示到當前詞路徑的順序,可以假定向左即為0,向右即為1。qkij代表當前內部節點的詞向量。Cij表示該詞上下文詞向量之和。對于損失函數L(θ),可以利用隨機梯度下降的優化方法來對每個詞向量求得最優解。

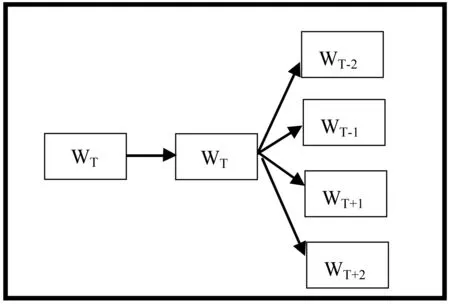

如圖3所示,例如在維基百科中對于‘中國’詞的解釋為‘中國是個愛好和平的國家’,通過分詞以及去除停用詞后可以得到‘中國 愛好 和平 國家’,根據維基百科詞頻統計可以得到原始的哈夫曼樹,圖3為簡化的哈夫曼樹,在實際應用中,哈夫曼樹要比圖3的樹大很多。首先,初始化詞向量,文本采用隨機初始化的方式將單詞集中所有詞映射成維度為300,數值為[0,1]的隨機初始化數值。其次,對于分詞后的句子來說,依次選擇句子中的單詞和其上下文進行求解,假設當前詞為wij=‘愛好’,其上下文單詞為Cij=‘和平 中國 國家’詞向量之和,從根節點到‘愛好’節點對應唯一的路徑。如式(3)所示,dkij表示該路徑向左還是向右,可以假定向左為0,向右為1。qkij與Cij的乘積表示上下文詞向量之和與中間節點的向量積,從而得到最后的目標函數。

圖3 詞向量求解示例圖

通過變化得到新的損失函數L(θ),可以用傳統的隨機梯度下降算法進行求解,由于未知變量為qkij與Cij,所以分別對其進行求導,通過迭代的方法得到最優解。

至此,可以得到維基百科數據集的詞向量集合,對于任意一個單詞來說,可以表示成[0.12,0.31,1.23,…]的形式,詞向量的另一個解釋為高維空間中的點,對于相同維數的詞向量來說,可以利用歐式距離的計算方法求得單詞之間的相似度。

2.3 文本預處理

文本預處理主要包括文本的分詞處理,去停用詞處理,以及無效的字符處理等[16]。分詞處理是文本處理的基礎,也是將文本由非結構化的數據轉化為結構化數據的第一步,分詞的優劣將直接影響到文本后續的處理。由于英文文本可直接通過空格符來直接將文本進行分詞,以至于在分詞處理的階段中文分詞也要比英文分詞更加困難,這也是中文文本語義豐富性要多于英文文本的有效例證之一。正由于中文文本豐富的語義信息,例如未登錄詞、多義詞、同義詞等,分詞的處理也一直成為了眾多學者研究的重點之一。

去停用詞是指去除分詞后無效的特征信息,這些停用詞不具有任何語義的信息,只起到連接,加強語氣的作用,由于其存在的普遍性,并不能作為該文本的有效特征,所以將其去除并不會影響后續分類的處理。

2.4 關鍵詞集的獲取

傳統的特征詞獲取算法有基于詞頻的關鍵詞獲取算法、基于TF-IDF的關鍵詞獲取算法。由于詞頻僅僅根據單詞出現的頻率來作為文本的關鍵詞,并不能有效地代表類別信息,而TF-IDF則考慮了文本關鍵詞的普遍特性,對于所有類別都出現較多的特征進行相應的懲罰,所以本文用TF-IDF來作為關鍵詞的提取算法。

(4)

TFij稱為文檔頻率,表示單詞在文件中出現的頻數與單詞總數的比值,代表了這個單詞在文本中出現的重要程度,值越大,則相應的重要性越大。

IDFij=|D|/|{I(ti∈dj)}|

(5)

IDFij稱為逆文檔頻率,表示文檔總數與包含該單詞的文件數的比值,其與文檔頻率起到了約束的作用。

TFIDFij=TFij×IDFi

(6)

TFIDFij為TFij與IDFij的乘積,值越大表明單詞的重要程度越高,代表性越好。

2.5 短文本特征擴展算法

首先通過TF-IDF算法來獲取語料集的特征詞集,并遍歷語料集,對于存在于文檔中的特征詞,將特征詞相似度最高的k個特征詞加入到文檔中,作為新的文檔集合,具體算法步驟如下:

(1) 根據維基百科語料數據集獲取維基百科單詞的詞向量集合。并根據歐式距離的計算方法得到每個單詞相似性最大的前20個單詞。

(2) 對原始短文本通過TFIDF算法求解關鍵詞的集合keywords。

(3) 依次遍歷每一篇文檔,對文檔中的單詞進行如下判斷:如果單詞在keywords集合中,則將(1)中該單詞相似性最大的前20個單詞加入短文本,否則,跳過該單詞。

(4) 得到特征擴展后的文本。

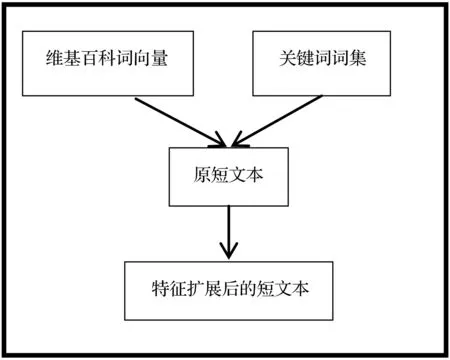

基于詞向量的短文本特征擴展算法如圖4所示。

圖4 算法流程圖

如圖4所示,首先需要構建維基百科詞向量集,用C-BOW算法對維基百科語料庫中的語料進行詞向量的獲取,同時得到每個單詞相似性最大的前k個詞。通過TF-IDF算法來獲取文本中的關鍵詞,將TF-IDF值較大的詞匯作為關鍵詞集的求取標準,通過設定相應的閾值,將大于某一閾值的特征詞加入到關鍵詞集。對于每一個文本,將文本中存在于關鍵詞集的關鍵詞特征擴展詞集加入到原文本中,得到新得特征擴展的語料集。在本文中,可以直接利用單詞詞向量之和的結果作為文本表示。最后通過分類器來訓練新的語料集并對未知短文本語料進行分類預測。

3 實驗結果與分析

3.1 實驗評估指標

常用的文本分類評估指標有3種,分別是精確度、召回率、F1值,分別表示如下:

精確度P:

(7)

召回率R:

(8)

F1值F1:

(9)

式中:a表示被正確分到正類的文檔數,b表示錯分到正類的文檔數,c表示屬于該類但被錯分的文檔數。

3.2 實驗結果分析

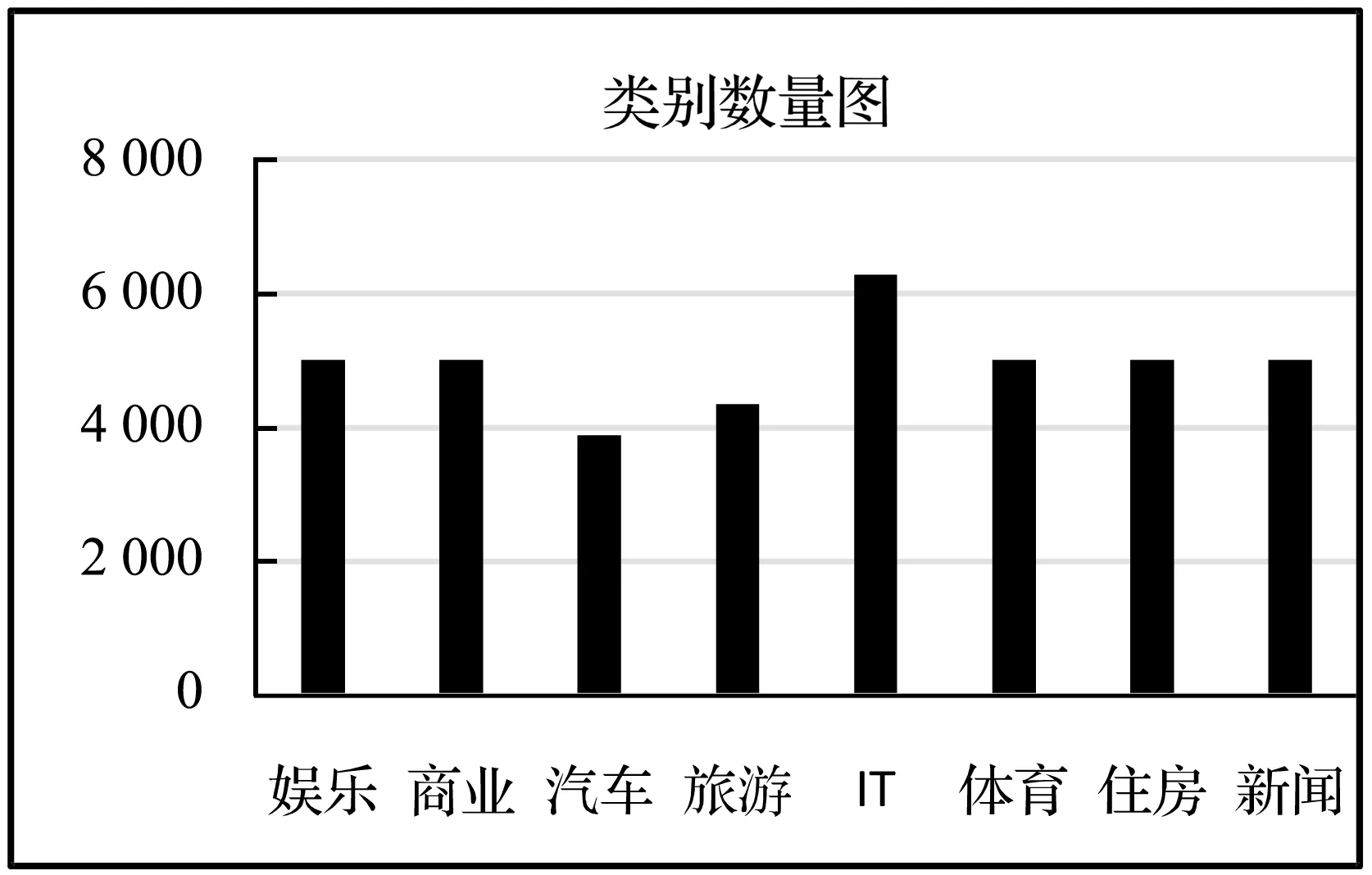

本文實驗處理器是Inter core i5-2450m,CPU為2.5 GHz,操作系統是Windows7 64位,編程語言為Python2.7。本實驗所用到的短文本實驗語料集為搜狗實驗室數據集的標題短文本,搜狗實驗室數據集是公開、免費的文本實驗數據集,主要有標題、URL、類別標簽、正文內容組成,數據內容和類別多樣,既可以提取其中的長文本,用于語義分析等,也可以用于本文的短文本分類。由于實驗語料數據類別數據樣本不均衡,存在數據不完整的類別數據,所以從原始11大類別中抽取8大類別,并在這8類中隨機抽取數量相當的文檔數,對數據進行簡單的預處理,每類文檔數量如圖5所示。

圖5 各類別文檔數量

將每個類別的數據用詞向量的特征擴展算法進行特征擴展后得到新的文本表示數據,其中,每一篇文檔均由相同維度的向量進行表示,從而使數據規范化。

本文進行實驗的比較對象是基于Word2vec特征擴展以及LDA主題模型進行特征擴展。

基于Word2vec特征擴展是首先對原始語料集利用Word2vec模型進行詞向量的求解,對于文章中每一個特征詞,將該特征詞相似度最高的前20個單詞加入到原文本中進行特征擴展,進而用分類器進行分類。

胡勇軍等[9]利用LDA高頻詞進行擴展,并利用搜狗實驗室數據集進行測試。基于LDA主題模型特征擴展是先對文檔求得文檔主題分布、主題詞分布,將每一篇文章的最相關的前5類主題以及每類主題最相關的前10個詞加入到原文本中,總共50個特征詞匯,起到特征擴展的作用。

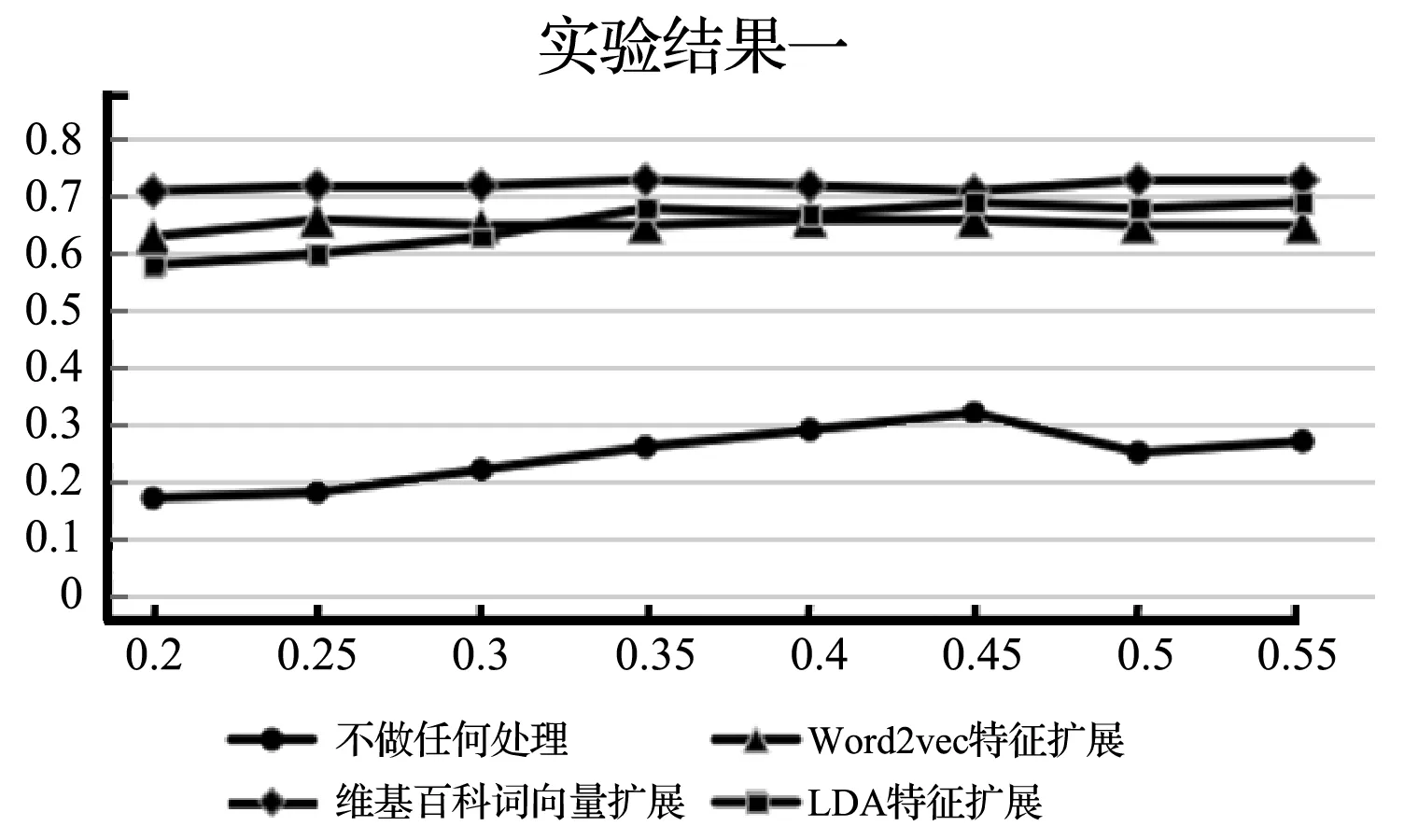

本文利用深度學習中的多層感知機作為實驗算法的分類器,由于深度學習可以學習深層次的語義特征,所以深層分類模型往往優于淺層模型。本實驗選擇每個類別IFIDF最高的前200個關鍵詞來作為關鍵詞詞集。通過分別調整分類器的層數、學習率以及迭代次數,來對不進行處理的短文本進行對比,其中,選擇不進行任何處理的短文本數據集,用Word2vec進行特征擴展的數據集來做對比實驗,實驗結果如圖6所示。

圖6 調整學習速率實驗結果

實驗一中選用層數為3 000-500-500-8的多層感知機分類器,迭代次數為10進行實驗,通過調整學習速率來對本文分類算法進行比較。由圖6中可以看出,在沒有特征擴展的情況下,由于文本數據特征缺失較為嚴重,分類器得到的精確度較差,由于迭代次數的影響,不進行任何處理的短文本分類數據集效果不好,基于Word2vec特征擴展精確度達到了65%左右,基于LDA主題詞特征擴展精確度達到了67%左右,略優于Word2vec特征擴展。本文用基于維基百科詞向量的特征擴展算法實驗結果精確度達到了72%左右。

圖7實驗中選用層數3 000-500-500-8的多層感知機分類器,學習速率為0.35,通過調整迭代次數進行文本分類的實驗。

圖7 調整迭代次數實驗結果

由實驗結果可知,基于Word2vec特征擴展算法的精確度對迭代次數敏感性不高,精確度在65%左右;基于LDA主題特征擴展的特征擴展方式對迭代次數敏感性不高,精確度達到了63%左右;不進行任何處理的數據實驗結果對迭代次數的敏感性較高,隨著迭代次數的增加其預測精確度起初增長較快,隨后趨于平穩;本文算法受迭代次數影響不大,對迭代次數不敏感,但精確度卻高于上述兩者,達到75%左右。

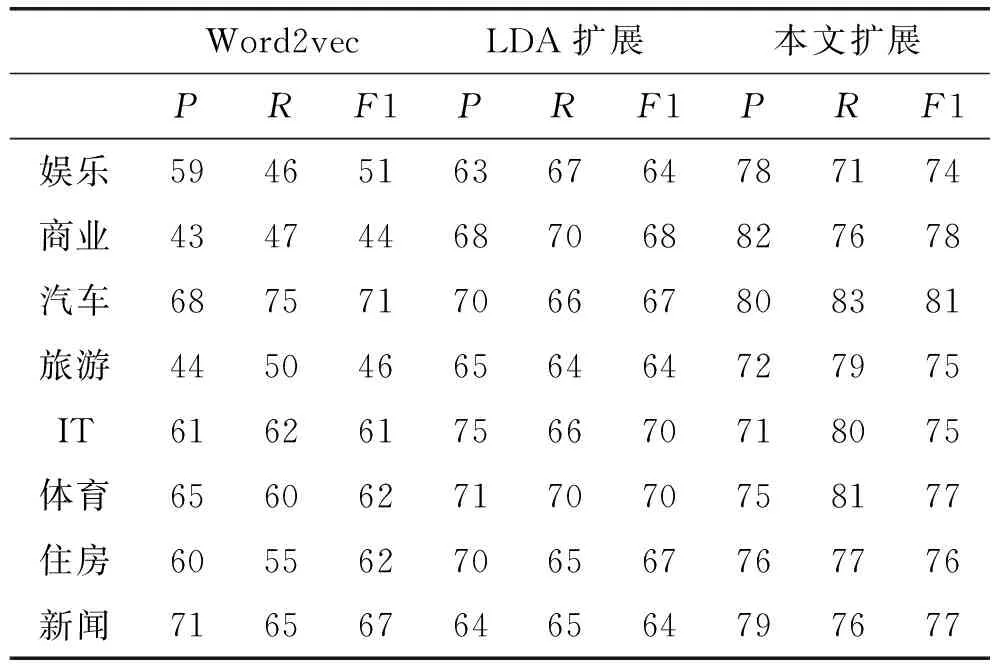

表1是在每個類別下Word2vec特征擴展,LDA高頻詞特征擴展以及本文的精確度、召回率和F1值的結果比較。表1結果是將每個類別的在不同速率下得到的精確度,召回率取平均值后所得,可以看出,本文基于維基百科詞向量特征擴展的算法在以上三個評價指標中多數類別取得了不錯的結果。

表1 實驗結果比較 %

4 結 語

本文提出了基于詞向量特征擴展算法,通過訓練外部語料數據集來獲取外部語料詞向量,通過TF-IDF算法來獲得文檔的關鍵詞集,并將文章中相似度較高的詞集加入到原文本當中,達到特征擴展的效果,使得擴充更多的信息到短文本當中,利用分類器來對文本進行分類,得到實驗結果。由于本文只用了單詞的信息來做文本表示,信息擴展相對來說還是較少,今后可以通過利用句信息,段落信息和文章信息來對短文本特征進行更多的擴展,進而提高文本分類的精確度。